Похожие презентации:

Основы количественной теории информации. Лекция

1.

Основы количественнойтеории информации

1

2.

1.Основные понятия и определениятеории информации

2

3.

34.

45.

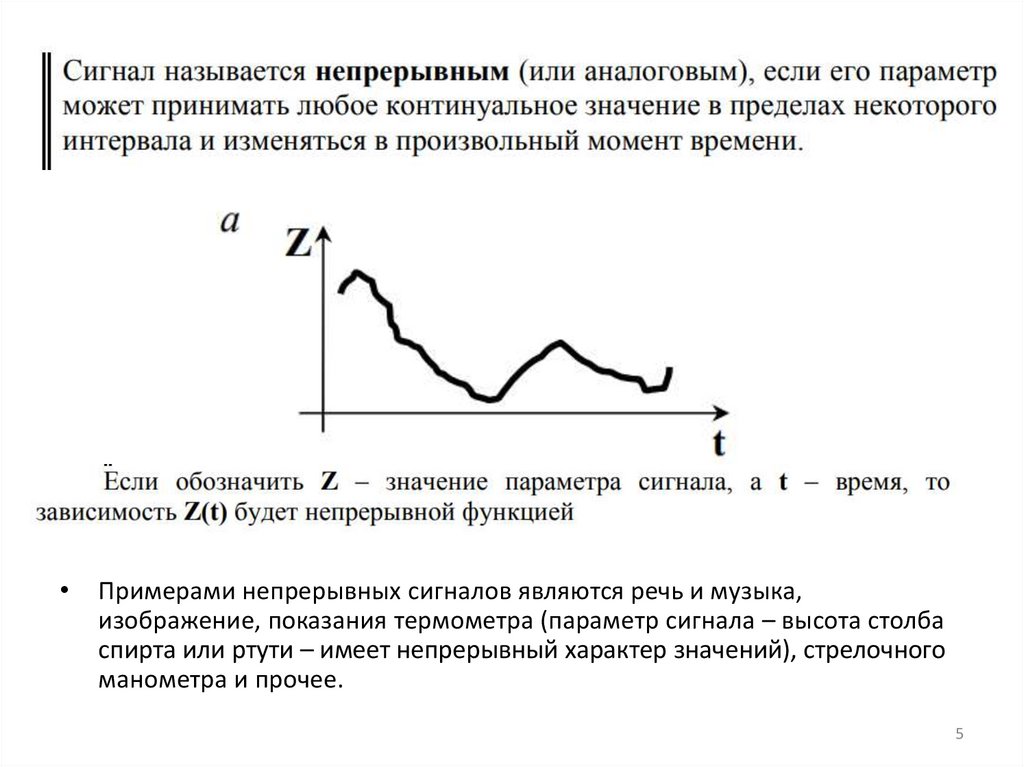

Примерами непрерывных сигналов являются речь и музыка,

изображение, показания термометра (параметр сигнала – высота столба

спирта или ртути – имеет непрерывный характер значений), стрелочного

манометра и прочее.

5

6.

67.

Благодаря порядку между знаками устанавливаются бинарные отношения«больше–меньше»

Количество знаков в алфавите называют мощностью алфавита.

Пример алфавита - совокупность арабских цифр 0,1…9 – с его помощью можно

записать любое целое число в системах счисления от двоичной до десятичной.

1. Если в этот алфавит добавить знаки «+» и «–», то им можно будет записать

любое целое число, как положительное, так и отрицательное.

2. Наконец, если добавить знак разделителя разрядов («.» или «,»), то такой

алфавит позволит записать любое вещественное число.

7

8.

1.Основные понятия и определениятеории информации

• Верность передачи информации – мера

соответствия принятого сообщения

переданному.

• Переработка информации – выполнение

формальных операций над входными

величинами, над параметрами сигнала в

соответствии с заданным алгоритмом.

• Хранение информации – фиксация

параметров носителя информации.

8

9.

1.Основные понятия и определениятеории информации

9

10.

2.Количество информации10

11.

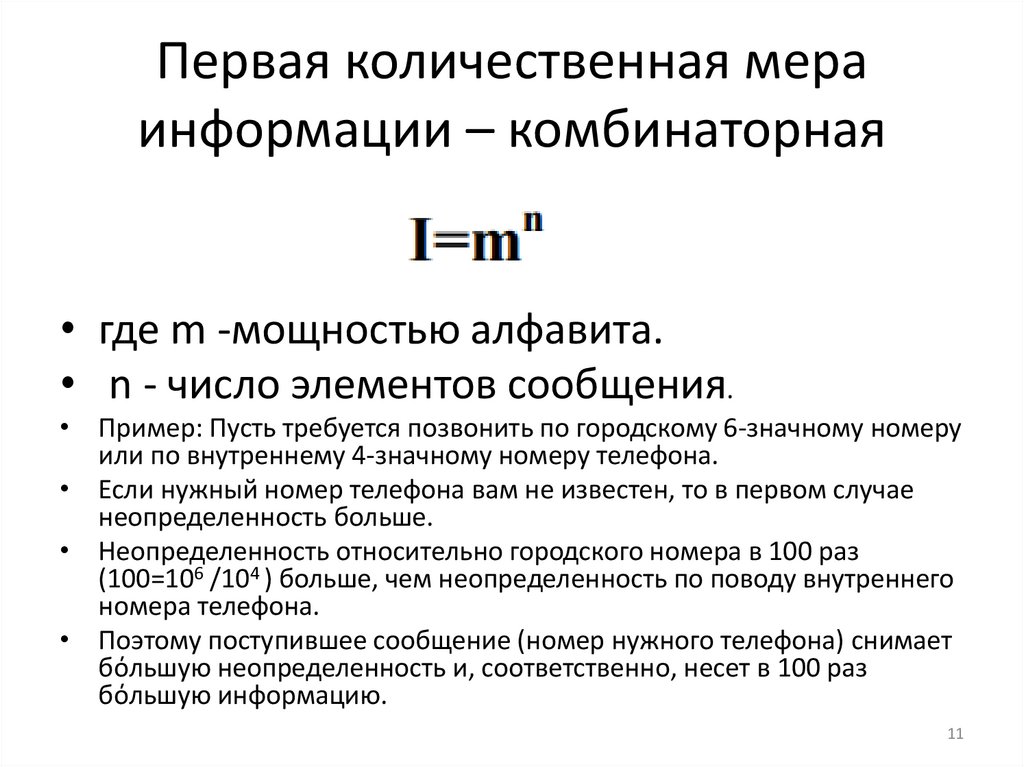

Первая количественная мераинформации – комбинаторная

• где m -мощностью алфавита.

• n - число элементов сообщения.

• Пример: Пусть требуется позвонить по городскому 6-значному номеру

или по внутреннему 4-значному номеру телефона.

• Если нужный номер телефона вам не известен, то в первом случае

неопределенность больше.

• Неопределенность относительно городского номера в 100 раз

(100=106 /104 ) больше, чем неопределенность по поводу внутреннего

номера телефона.

• Поэтому поступившее сообщение (номер нужного телефона) снимает

бόльшую неопределенность и, соответственно, несет в 100 раз

бόльшую информацию.

11

12.

Первая количественная мераинформации – комбинаторная

• Недостаток этой меры – неадитивность

(непропорциональность количества

информации и длины сообщения).

12

13.

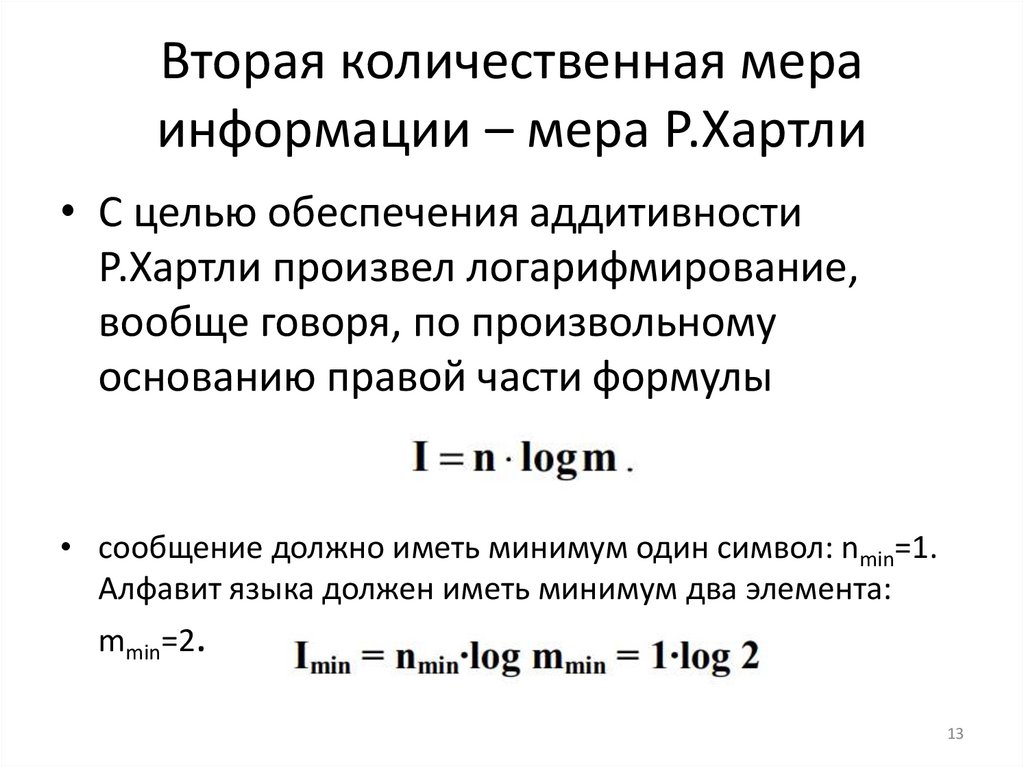

Вторая количественная мераинформации – мера Р.Хартли

• С целью обеспечения аддитивности

Р.Хартли произвел логарифмирование,

вообще говоря, по произвольному

основанию правой части формулы

• сообщение должно иметь минимум один символ: nmin=1.

Алфавит языка должен иметь минимум два элемента:

mmin=2.

13

14.

• Недостаток меры Хартли (логарифмическоймеры)состоит в том, что она не учитывает

вероятностный характер сообщения

(сообщение имеет смысл, когда оно

неизвестно заранее).

14

15.

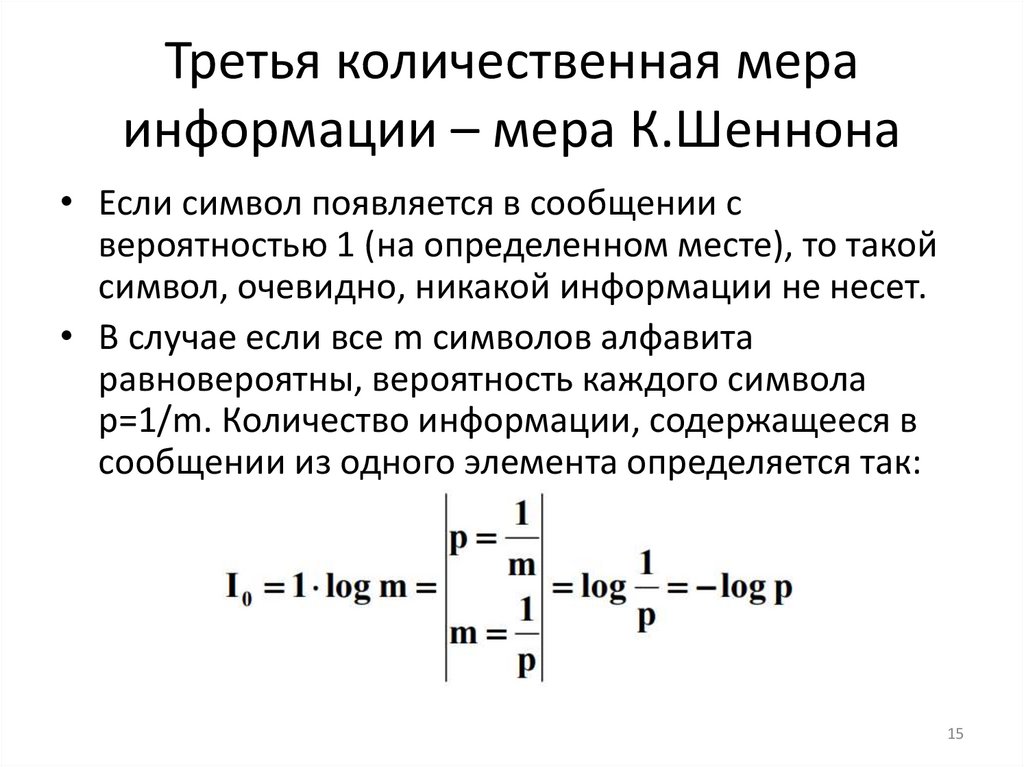

Третья количественная мераинформации – мера К.Шеннона

• Если символ появляется в сообщении с

вероятностью 1 (на определенном месте), то такой

символ, очевидно, никакой информации не несет.

• В случае если все m символов алфавита

равновероятны, вероятность каждого символа

p=1/m. Количество информации, содержащееся в

сообщении из одного элемента определяется так:

15

16.

• Любое сообщение можно интерпретироватькак один символ соответствующего алфавита.

Количество информации не должно зависеть

от способа выбора алфавита. Соответственно,

вышеуказанную

формулу

можно

распространить на произвольные сообщения

(произвольных алфавитов и произвольной

длины), с учетом того, что под

• P будем понимать вероятность сообщения.

16

17.

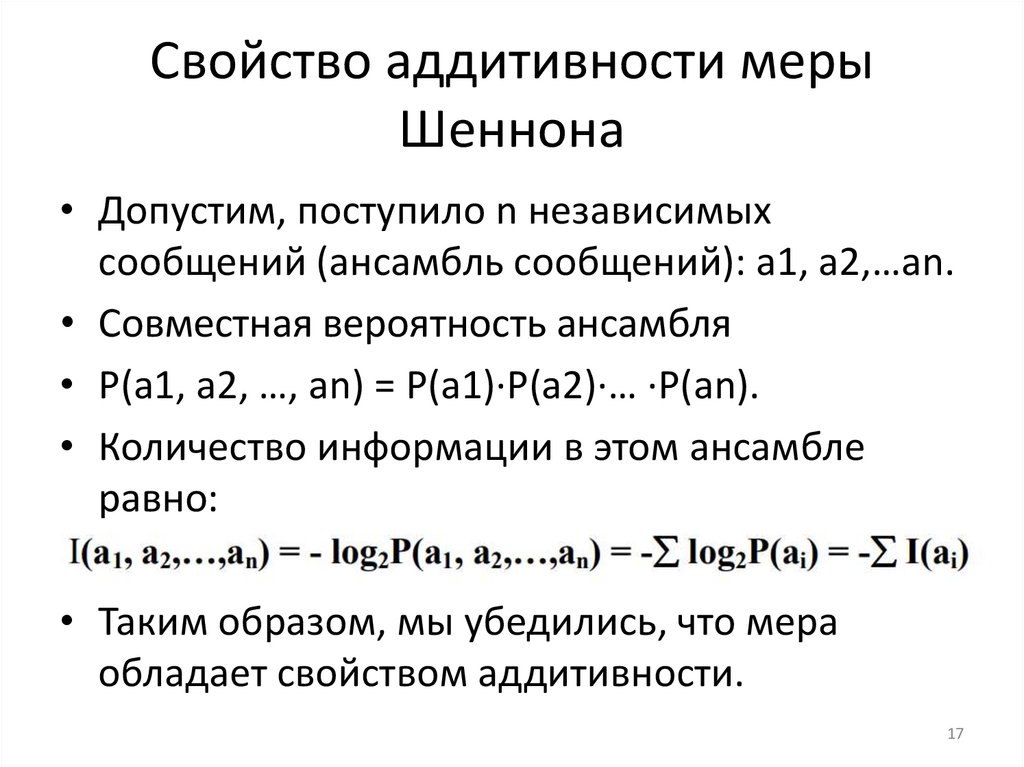

Свойство аддитивности мерыШеннона

• Допустим, поступило n независимых

сообщений (ансамбль сообщений): а1, а2,…аn.

• Совместная вероятность ансамбля

• P(a1, a2, …, an) = P(a1)·P(a2)·… ·P(an).

• Количество информации в этом ансамбле

равно:

• Таким образом, мы убедились, что мера

обладает свойством аддитивности.

17

18.

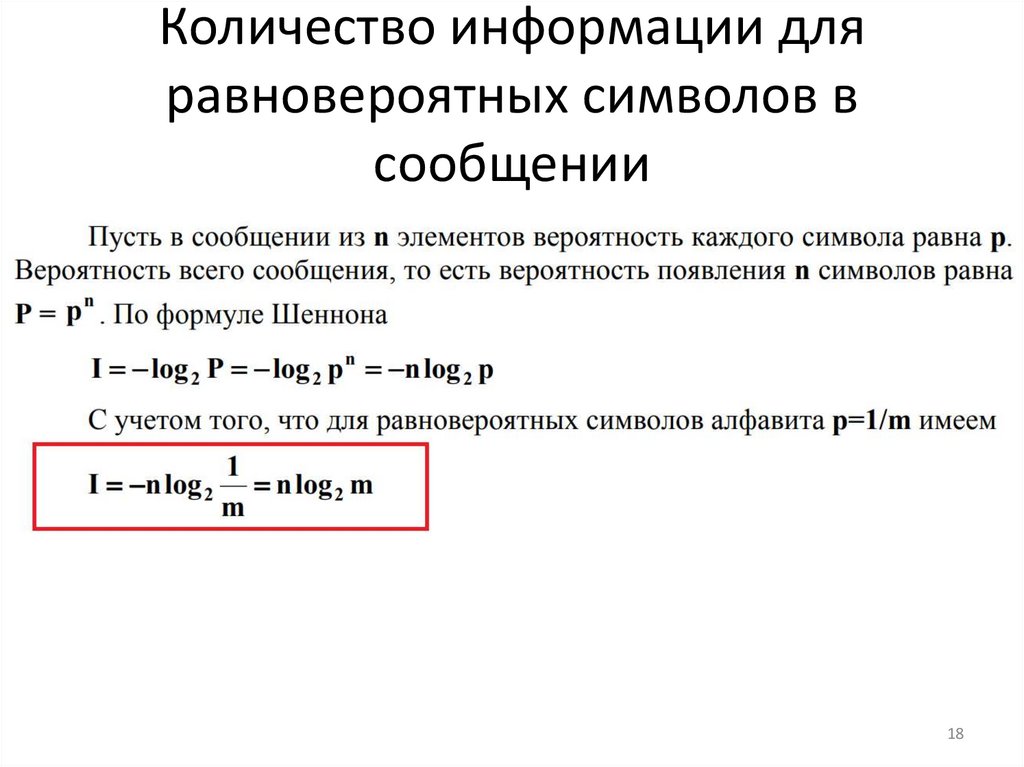

Количество информации дляравновероятных символов в

сообщении

18

19.

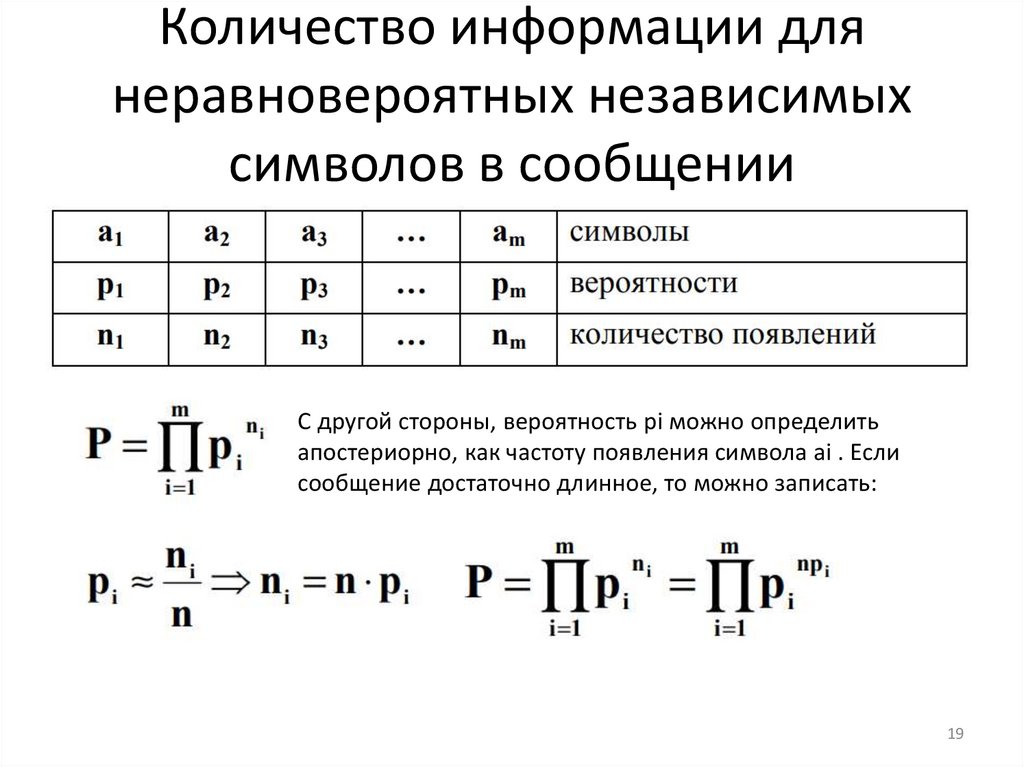

Количество информации длянеравновероятных независимых

символов в сообщении

С другой стороны, вероятность pi можно определить

апостериорно, как частоту появления символа ai . Если

сообщение достаточно длинное, то можно записать:

19

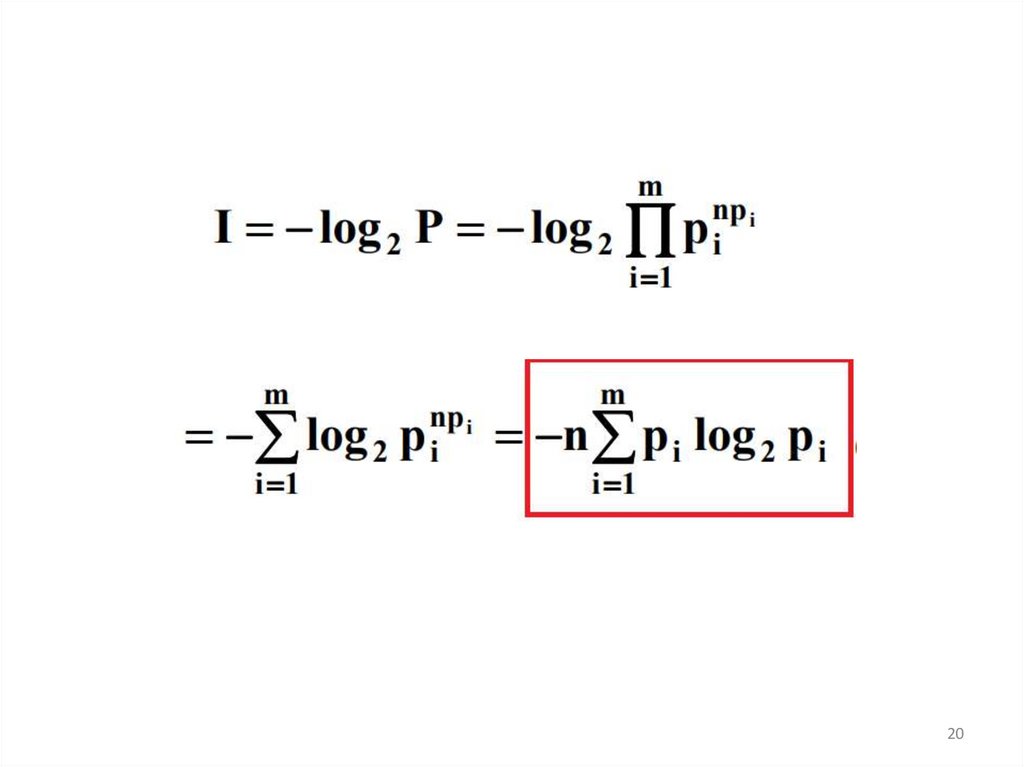

20.

2021.

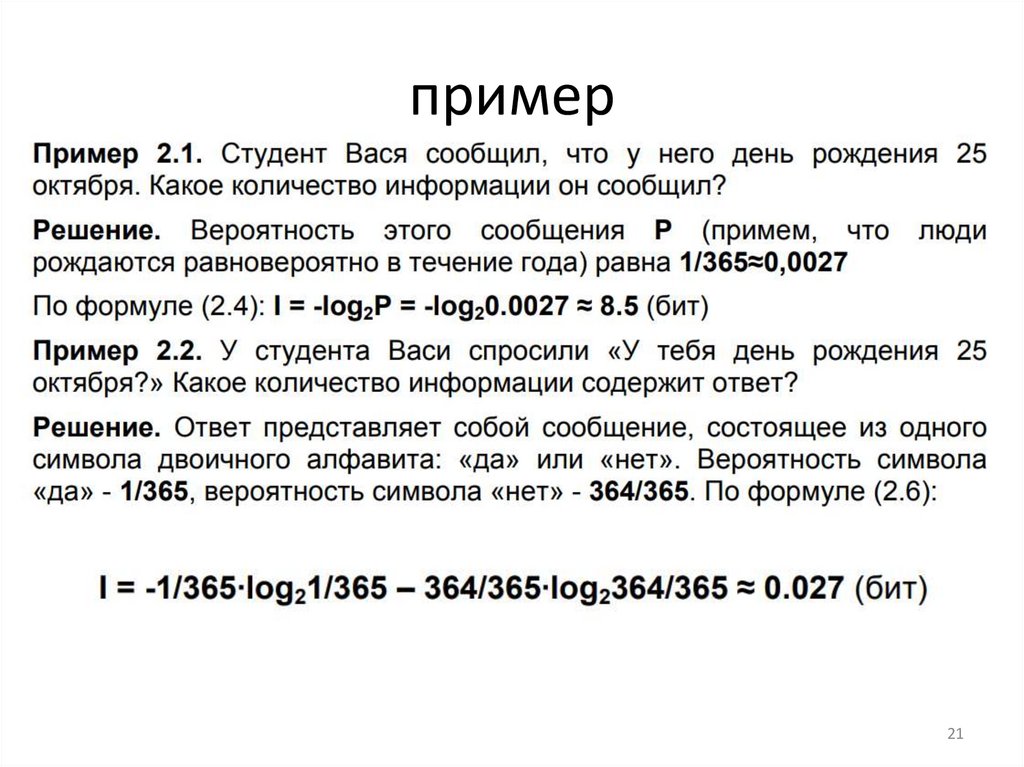

пример21

22.

Количество информации в случаенеравновероятных зависимых

символов в сообщении

• В реальных условиях символы и отсчеты,

образующие сообщения, взаимосвязаны,

например:

• количество заглавных букв в тексте связано

с количеством точек;

22

23.

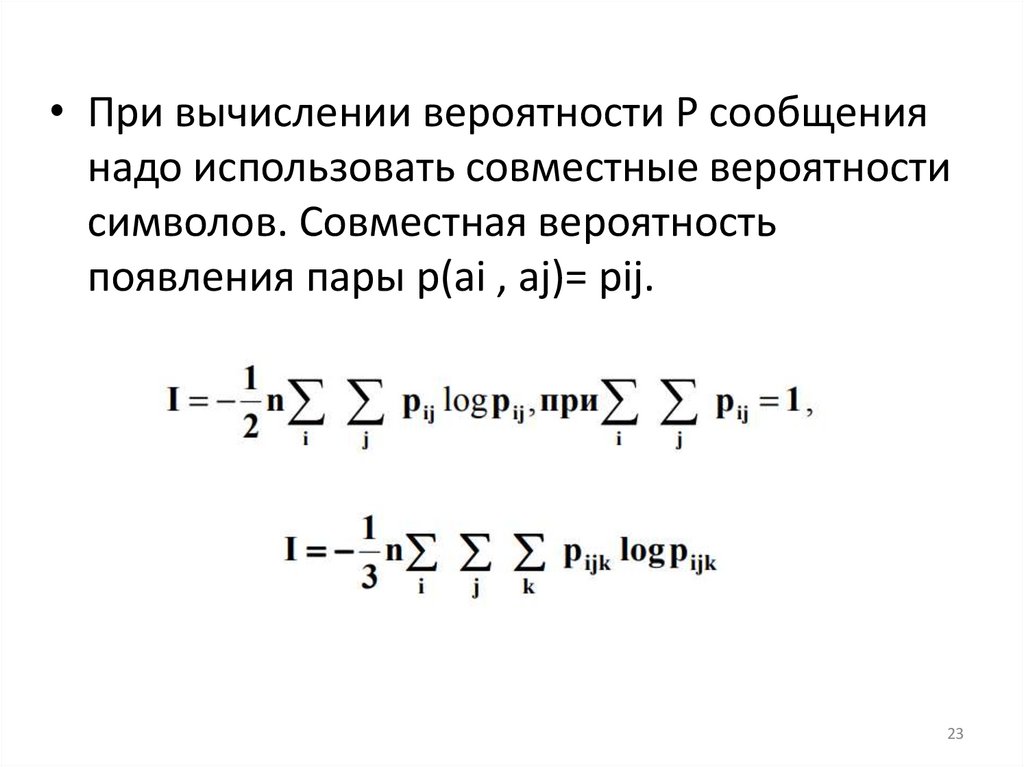

• При вычислении вероятности Р сообщениянадо использовать совместные вероятности

символов. Совместная вероятность

появления пары p(ai , aj)= pij.

23

24.

• Спасибо за внимание24

Информатика

Информатика