Похожие презентации:

Повышение эффективности методов преодоления катастрофического забывания в нейросетях с помощью буфера повторов

1.

Повышение эффективностиметодов преодоления

катастрофического забывания

в нейросетях с помощью буфера

повторов

К. П. Таразанов - студент кафедры аэрокосмических компьютерных и программных систем

В. В. Хон - студент кафедры аэрокосмических компьютерных и программных систем

Р. О. Малашин – кандидат технических наук, доцент – научный руководитель

2.

Непрерывное обучение (Continual learning)• Непрерывное обучение (Continual learning) - процесс

постепенного обновления модели на новых данных.

• Однако, возникает проблема, известная как катастрофическое

забывание – ситуация, когда модель усваивает новые знания

ценой потери ранее изученных.

• Происходит это из-за того, что алгоритмы нейросетей основаны

на математической модели нейронов - связи между ними

представляют прошлые знания, поэтому их изменение этих

связей приведёт к забыванию.

3.

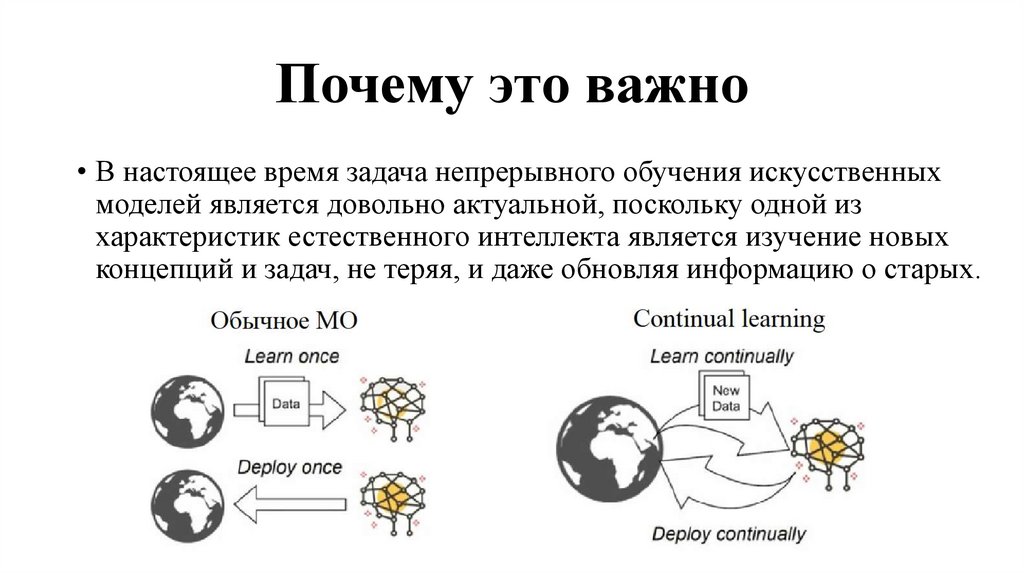

Почему это важно• В настоящее время задача непрерывного обучения искусственных

моделей является довольно актуальной, поскольку одной из

характеристик естественного интеллекта является изучение новых

концепций и задач, не теряя, и даже обновляя информацию о старых.

4.

• Преодолениекатастрофического забывания

становится ключевым шагом

в развитии устойчивых

нейронных сетей, способных

адаптироваться к новым

условиям без потери качества

обучения.

Поэтому было предложено немало подходов, реализующих

алгоритмы CL (Continual Learning), которые в общем случае можно

разделить на три категории:

5.

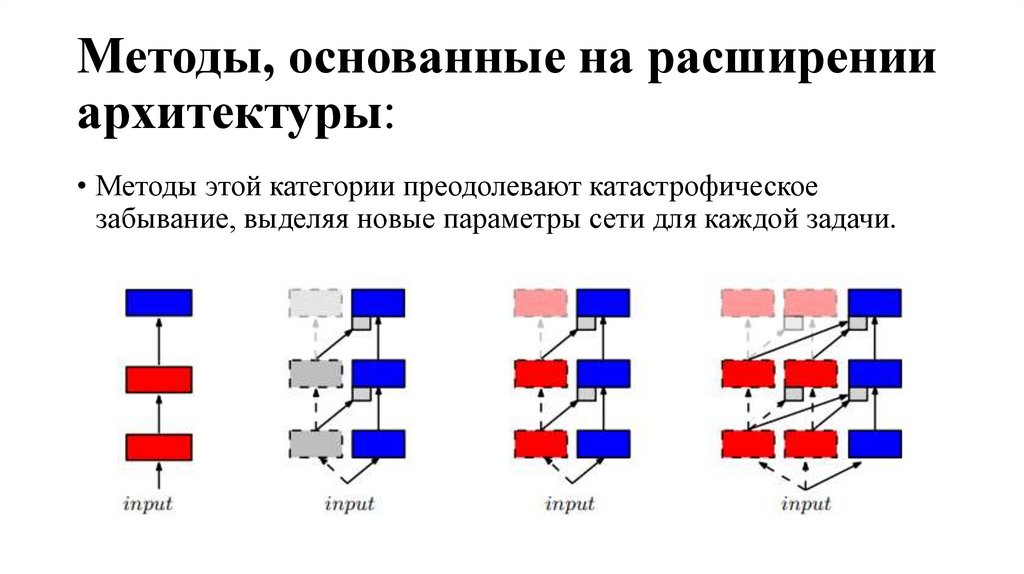

Методы, основанные на расширенииархитектуры:

• Методы этой категории преодолевают катастрофическое

забывание, выделяя новые параметры сети для каждой задачи.

6.

Методы, основанные на регуляризации:• Методы, преодолевающие забывание в моделях с фиксированной

архитектурой, но использующие методы регуляризации –

наказания за значительное изменение параметров, важных для

предыдущих задач.

7.

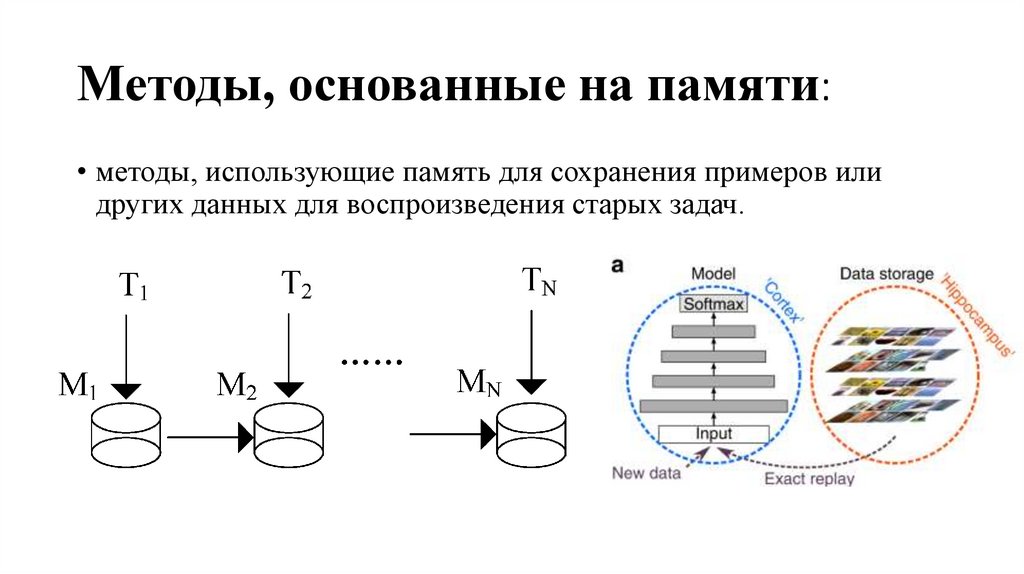

Методы, основанные на памяти:• методы, использующие память для сохранения примеров или

других данных для воспроизведения старых задач.

8.

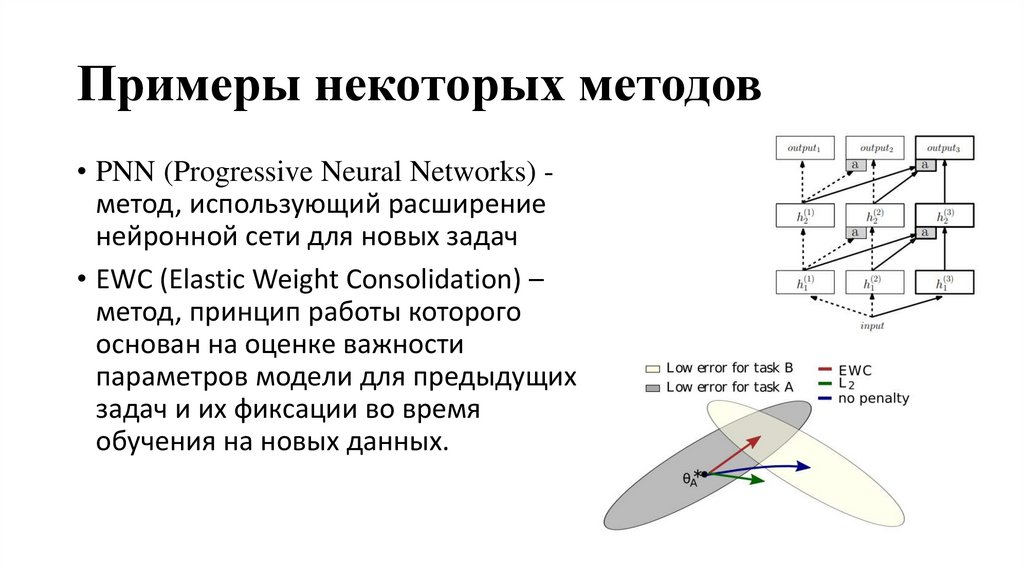

Примеры некоторых методов• PNN (Progressive Neural Networks) метод, использующий расширение

нейронной сети для новых задач

• EWC (Elastic Weight Consolidation) –

метод, принцип работы которого

основан на оценке важности

параметров модели для предыдущих

задач и их фиксации во время

обучения на новых данных.

9.

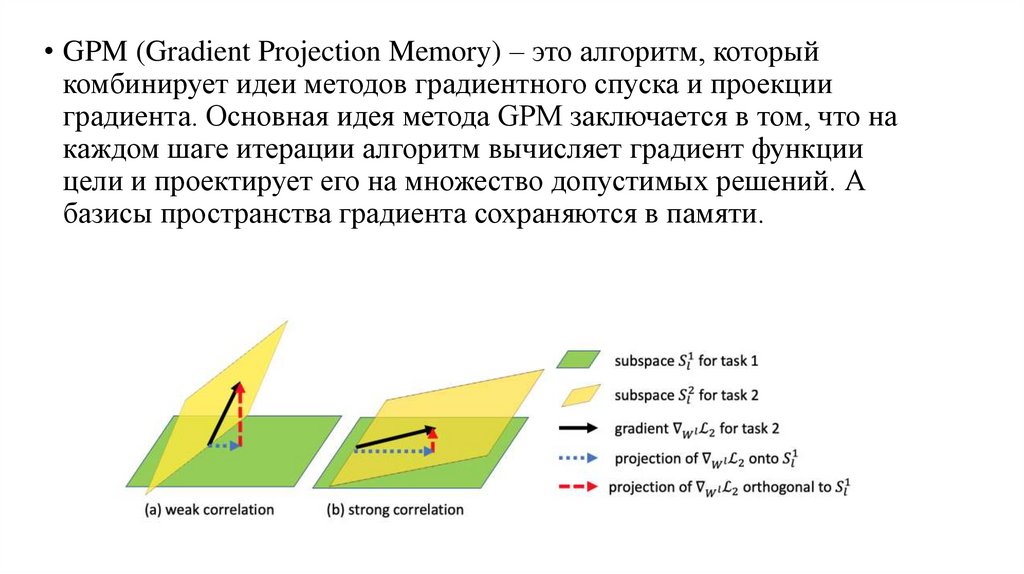

• GPM (Gradient Projection Memory) – это алгоритм, которыйкомбинирует идеи методов градиентного спуска и проекции

градиента. Основная идея метода GPM заключается в том, что на

каждом шаге итерации алгоритм вычисляет градиент функции

цели и проектирует его на множество допустимых решений. А

базисы пространства градиента сохраняются в памяти.

10.

Ограничения и проблемысуществующих методов

• Наложения ограничений на формулировку самой задачи

непрерывного обучения, упрощая или модифицируя условия, в

которых эти алгоритмы будут работать.

• Зависимость некоторых методов от тонкой настройки, что делает

их уязвимыми к изменчивости задач в реальном мире.

• Однако, самым главным недостатком большинства

существующих методов является узкая специализация, что

приводит к потере эффективности при изменении варианта CL.

11.

Буфер повторов• Поэтому недавно был предложен простой подход для задачи

непрерывного обучения, лишенный многих из этих ограничений.

• Метод основан на

связи двух

компонентов –

буфера, хранящего

образцы в памяти и

модели, обучаемой с

нуля по запросу

12.

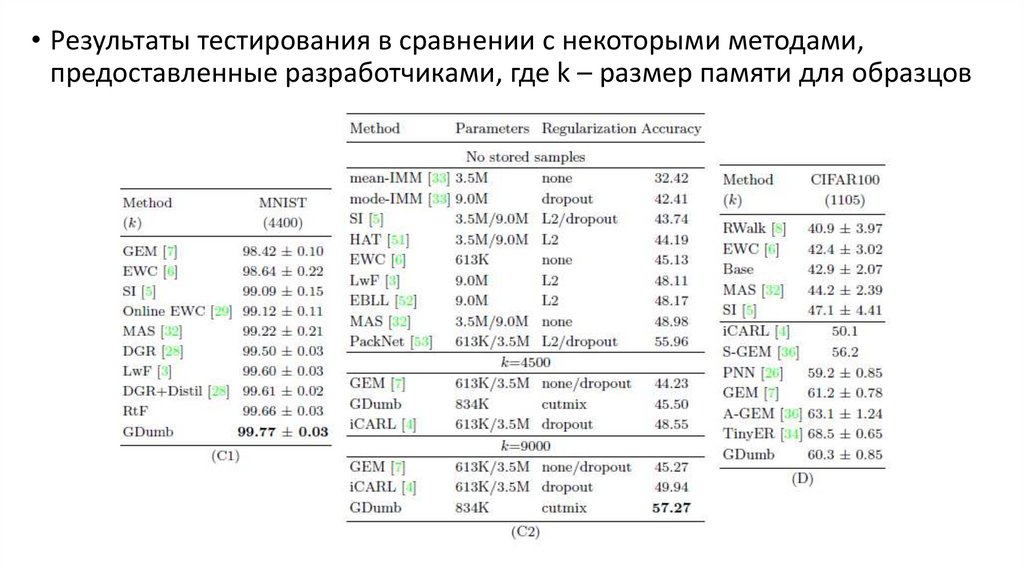

• Результаты тестирования в сравнении с некоторыми методами,предоставленные разработчиками, где k – размер памяти для образцов

13.

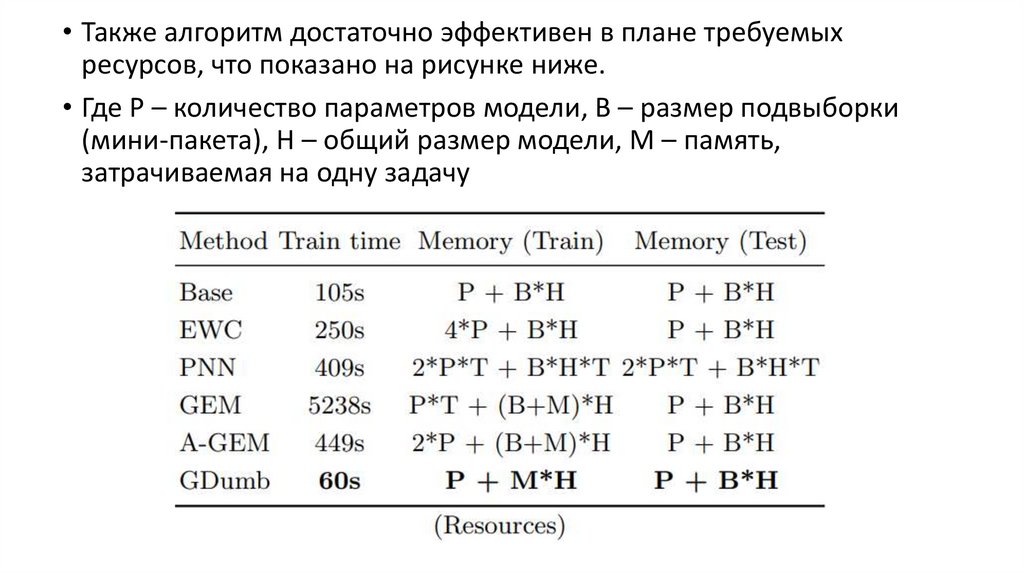

• Также алгоритм достаточно эффективен в плане требуемыхресурсов, что показано на рисунке ниже.

• Где Р – количество параметров модели, В – размер подвыборки

(мини-пакета), Н – общий размер модели, М – память,

затрачиваемая на одну задачу

14.

Возможное использование буфера повторовсовместно с другими методами CL

• Для методов, эффективность которых зависит от порядка

поступления задач, буфер повторов мог бы улучшить точность

работы, изменяя очередность задач при обучении модели.

• Например, обучить нейронную

сеть, используя несколько

вариантов построения очереди,

и выбрать вариант с

наибольшей средней

точностью.

15.

• Для методов, использующих данные о конкретной задаче толькоодин раз, GDumb мог бы предоставить более полные данные для

обучения, поскольку сэмплер хранит образцы, наблюдаемые за все

время существования модели. То есть, решается проблема

устаревания информации с течением времени.

• Так же возможна ситуация использования алгоритмов с

расширением архитектуры, например, PNN, вместе с алгоритмом

GDumb: данные, используя которые подсети достигли заданного

порога точности, могут быть удалены из буфера для освобождения

памяти под более новые или приоритетные образцы.

16.

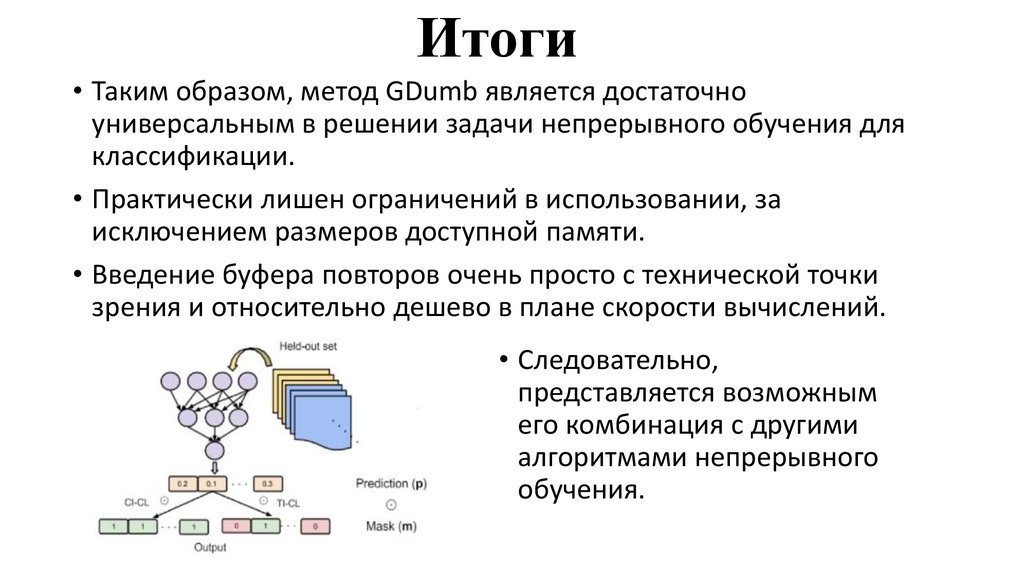

Итоги• Таким образом, метод GDumb является достаточно

универсальным в решении задачи непрерывного обучения для

классификации.

• Практически лишен ограничений в использовании, за

исключением размеров доступной памяти.

• Введение буфера повторов очень просто с технической точки

зрения и относительно дешево в плане скорости вычислений.

• Следовательно,

представляется возможным

его комбинация с другими

алгоритмами непрерывного

обучения.

Интернет

Интернет