Похожие презентации:

Параллельное программирование в стандарте MPI

1. Параллельное программирование в стандарте MPI

М.Л. Цымблер2. Содержание

Модель передачи сообщенийМодели SPMD и MPMD

Стандарт MPI

Основные понятия и функции MPI

Учебный курс "Параллельное программирование в стандарте MPI"

2

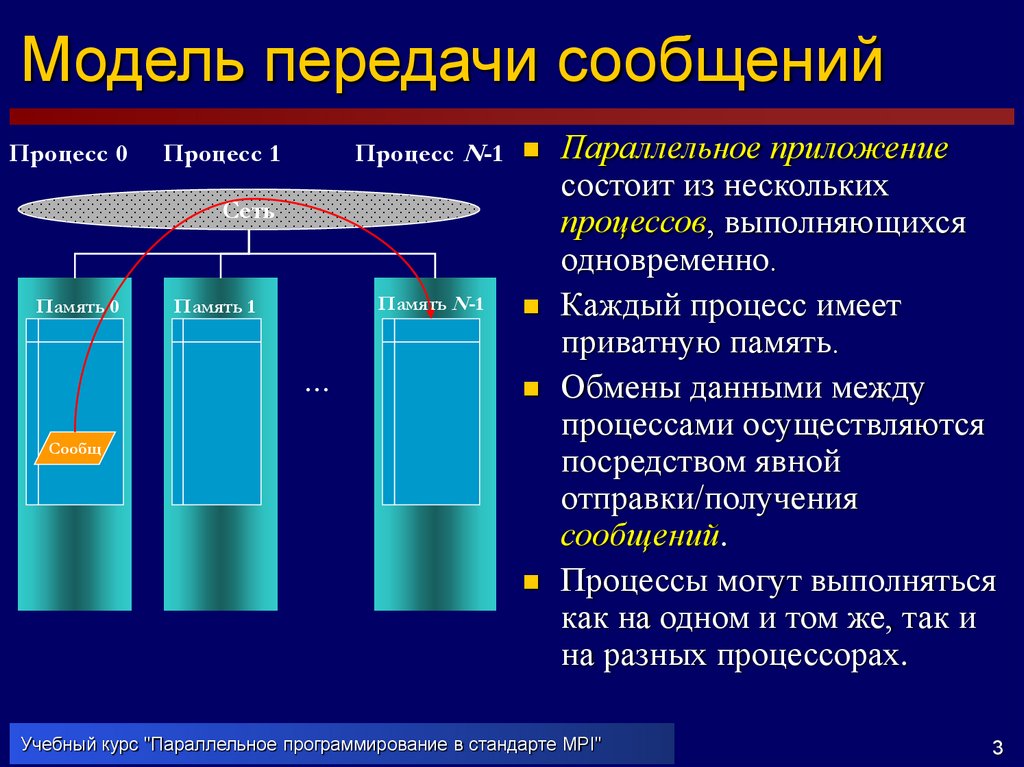

3. Модель передачи сообщений

Процесс 0Процесс N-1

Процесс 1

Сеть

Память 0

Память N-1

Память 1

…

Сообщ

Параллельное приложение

состоит из нескольких

процессов, выполняющихся

одновременно.

Каждый процесс имеет

приватную память.

Обмены данными между

процессами осуществляются

посредством явной

отправки/получения

сообщений.

Процессы могут выполняться

как на одном и том же, так и

на разных процессорах.

Учебный курс "Параллельное программирование в стандарте MPI"

3

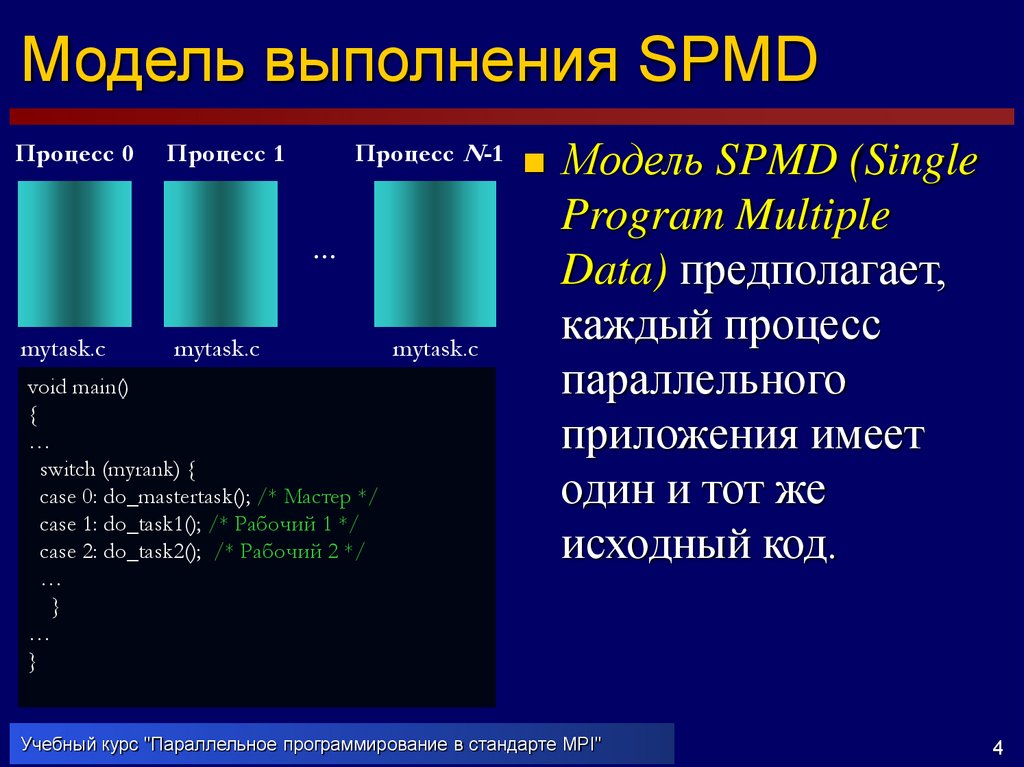

4. Модель выполнения SPMD

Процесс 0Процесс N-1

Процесс 1

…

mytask.c

mytask.c

void main()

{

…

switch (myrank) {

case 0: do_mastertask(); /* Мастер */

case 1: do_task1(); /* Рабочий 1 */

case 2: do_task2(); /* Рабочий 2 */

…

}

…

}

mytask.c

Модель SPMD (Single

Program Multiple

Data) предполагает,

каждый процесс

параллельного

приложения имеет

один и тот же

исходный код.

Учебный курс "Параллельное программирование в стандарте MPI"

4

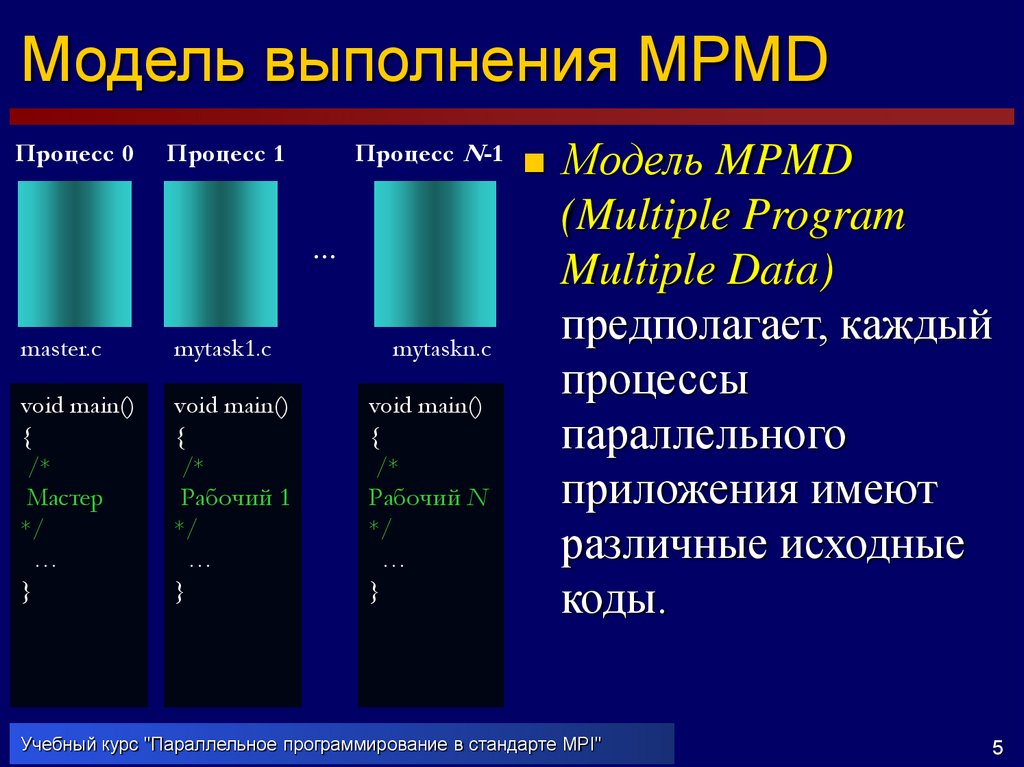

5. Модель выполнения MPMD

Процесс 0Процесс N-1

Процесс 1

…

master.c

mytask1.c

void main()

{

/*

Мастер

*/

…

}

void main()

{

/*

Рабочий 1

*/

…

}

mytaskn.c

void main()

{

/*

Рабочий N

*/

…

}

Модель MPMD

(Multiple Program

Multiple Data)

предполагает, каждый

процессы

параллельного

приложения имеют

различные исходные

коды.

Учебный курс "Параллельное программирование в стандарте MPI"

5

6. Стандарт MPI

MPI (Message Passing Interface) – стандарт,реализующий модель обмена сообщениями между

параллельными процессами. Поддерживает модели

выполнения SPMD и (начиная с версии 2.0) MPMD.

Стандарт представляет собой набор спецификаций

подпрограмм (более 120) на языках C, C++ и

FORTRAN.

Стандарт реализуется разработчиками в виде

библиотек подпрограмм для различных аппаратнопрограммных платформ (кластеры, персональные

компьютеры, …, Windows, Unix/Linux, …).

Учебный курс "Параллельное программирование в стандарте MPI"

6

7. Источники информации

Сервер PARALLEL.RUhttp://parallel.ru/tech/tech_dev/mpi.html

MPI-форум

http://www.mpi-forum.org

Учебный курс "Параллельное программирование в стандарте MPI"

7

8. Цикл разработки MPI-программ

Персональный компьютерПервоначальная разработка и отладка

Отладка по результатам запуска на

суперкомпьютере

Суперкомпьютер

Учебный курс "Параллельное программирование в стандарте MPI"

Тестирование

8

9. MPI-программа

MPI-программа – множество параллельныхвзаимодействующих процессов.

Процессы порождаются один раз, во время

запуска программы*.

Каждый процесс работает в своем адресном

пространстве, каких-либо общих данных нет.

Единственный способ взаимодействия

процессов – явный обмен сообщениями.

* Порождение

дополнительных процессов и уничтожение существующих возможно

только начиная с версии MPI-2.0.

Учебный курс "Параллельное программирование в стандарте MPI"

9

10. Коммуникаторы

Для локализации области взаимодействия процессов можносоздавать специальные программные объекты –

коммуникаторы. Процесс может входить в разные

коммуникаторы.

Взаимодействия процессов проходят в рамках некоторого

коммуникатора. Сообщения, переданные в разных

коммуникаторах, не пересекаются и не мешают друг другу.

Атрибуты процесса MPI-программы:

номер коммуникатора;

номер в коммуникаторе (от 0 до n-1, n – число процессов в

коммуникаторе).

Стандартные коммуникаторы:

MPI_COMM_WORLD – все процессы приложения

MPI_COMM_SELF – текущий процесс приложения

MPI_COMM_NULL – пустой коммуникатор

Учебный курс "Параллельное программирование в стандарте MPI"

10

11. Коммуникаторы

MPI_COMM_WORLD0

1

0

0

1

2

1

2

2

3

4

6

5

3

3

6

4

5

my_comm1

my_comm2

Учебный курс "Параллельное программирование в стандарте MPI"

0

1

2

11

12. Сообщение

Сообщение процесса – набор данныхстандартного (определенного в MPI) или

пользовательского типа.

Основные атрибуты сообщения:

номер процесса-отправителя (получателя)

номер коммуникатора

тег (уникальный идентификатор) сообщения (целое

число)

тип элементов данных в сообщении

количество элементов данных

указатель на буфер с сообщением

Учебный курс "Параллельное программирование в стандарте MPI"

12

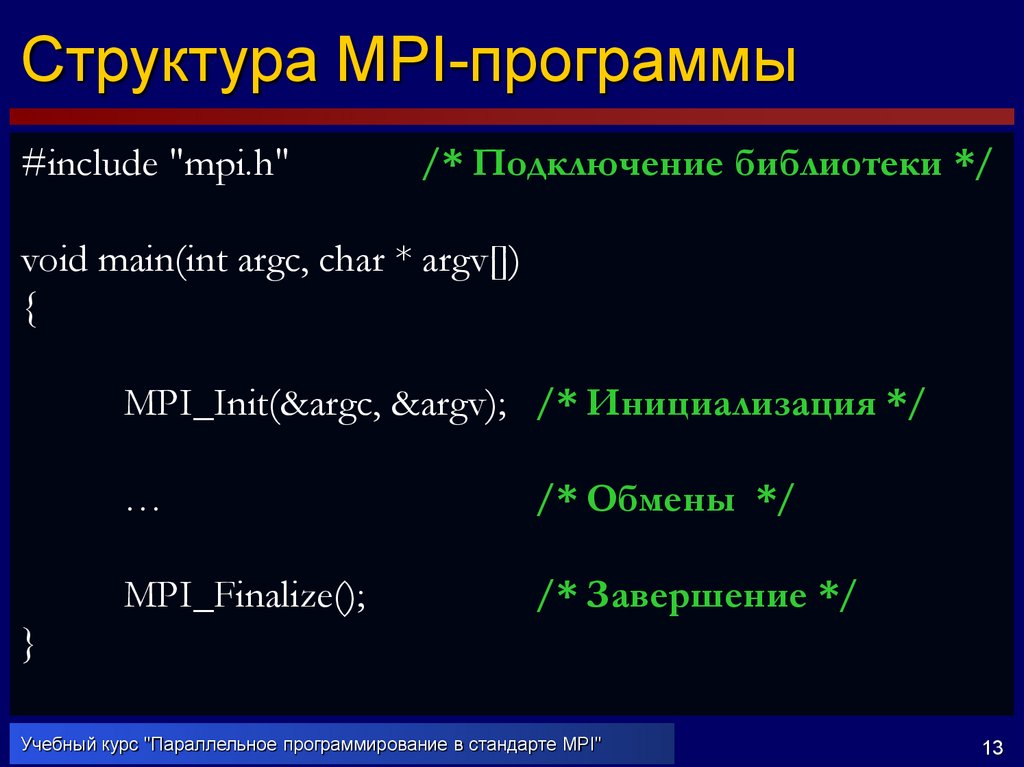

13. Структура MPI-программы

#include "mpi.h"/* Подключение библиотеки */

void main(int argc, char * argv[])

{

MPI_Init(&argc, &argv); /* Инициализация */

…

/* Обмены */

MPI_Finalize();

/* Завершение */

}

Учебный курс "Параллельное программирование в стандарте MPI"

13

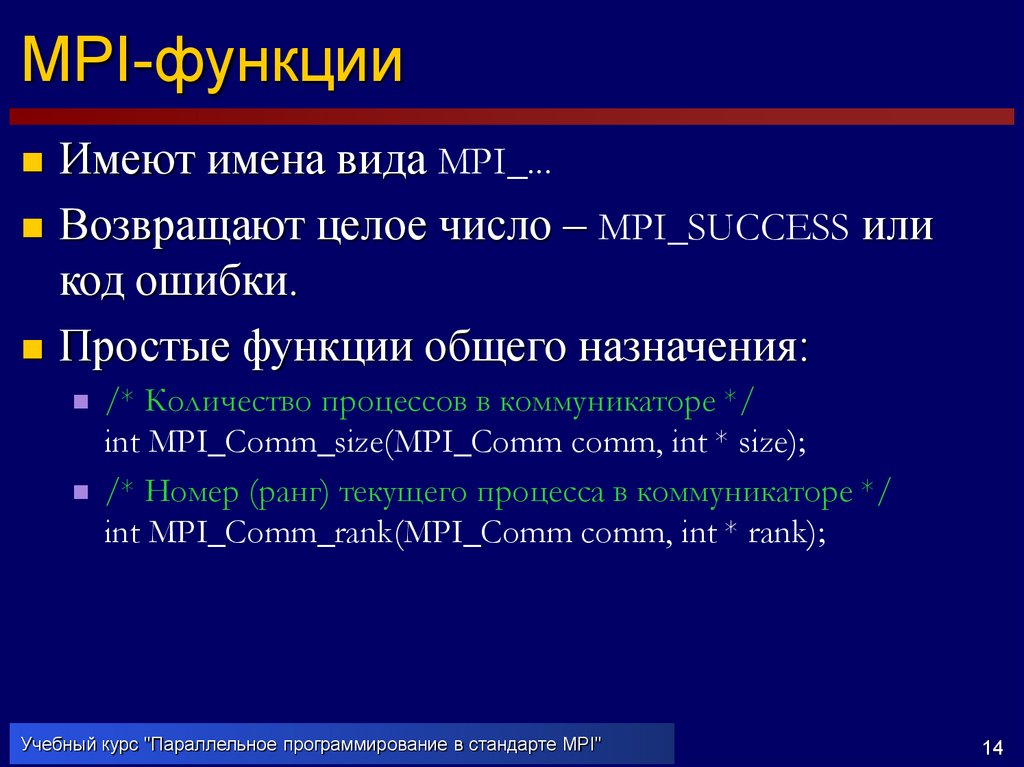

14. MPI-функции

Имеют имена вида MPI_...Возвращают целое число – MPI_SUCCESS или

код ошибки.

Простые функции общего назначения:

/* Количество процессов в коммуникаторе */

int MPI_Comm_size(MPI_Comm comm, int * size);

/* Номер (ранг) текущего процесса в коммуникаторе */

int MPI_Comm_rank(MPI_Comm comm, int * rank);

Учебный курс "Параллельное программирование в стандарте MPI"

14

15. Пример MPI-программы

#include "mpi.h"#include <stdio.h>

int total, iam;

void main(int argc, char * argv[])

{

MPI_Init(&argc, &argv);

MPI_Comm_size(MPI_COMM_WORLD, &total);

MPI_Comm_rank(MPI_COMM_WORLD, &iam);

printf("Привет! Я %d-й процесс из %d.\n", iam,

total);

MPI_Finalize();

}

Учебный курс "Параллельное программирование в стандарте MPI"

15

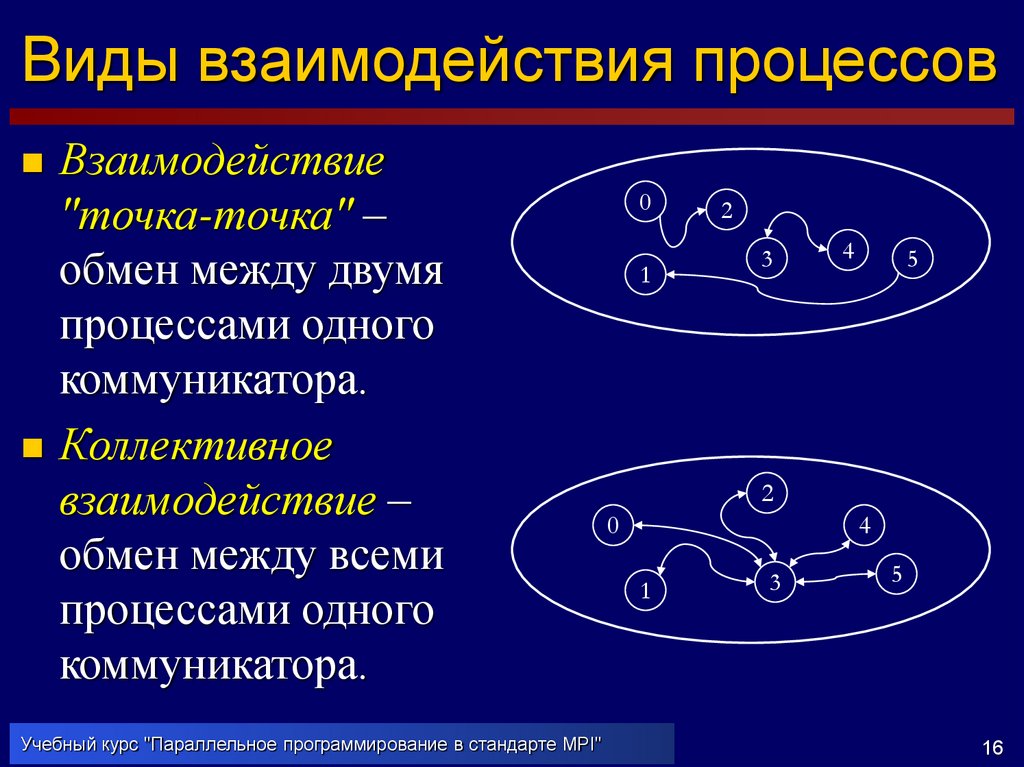

16. Виды взаимодействия процессов

Взаимодействие"точка-точка" –

обмен между двумя

процессами одного

коммуникатора.

Коллективное

взаимодействие –

обмен между всеми

процессами одного

коммуникатора.

Учебный курс "Параллельное программирование в стандарте MPI"

0

1

2

3

4

5

2

0

4

1

3

5

16

17. Взаимодействие "точка-точка"

Взаимодействие "точка-точка"Участвуют два процесса: отправитель сообщения и

получатель сообщения.

Отправитель должен вызвать одну из функций отправки

сообщения и явно указать атрибуты получателя

(коммуникатор и номер в коммуникаторе) и тег сообщения.

Получатель должен вызвать одну из функций получения

сообщения и указать (тот же) коммуникатор отправителя;

получатель может не знать номер отправителя и тег

сообщения.

Свойства:

Сохранение порядка (если P0 передает Р1 сообщения А и

затем В, то Р1 получит А, а затем В).

Гарантированное выполнение обмена (если P0 вызвал

функцию отправки, а Р1 вызвал функцию получения, то P1

получит сообщение от P0).

Учебный курс "Параллельное программирование в стандарте MPI"

17

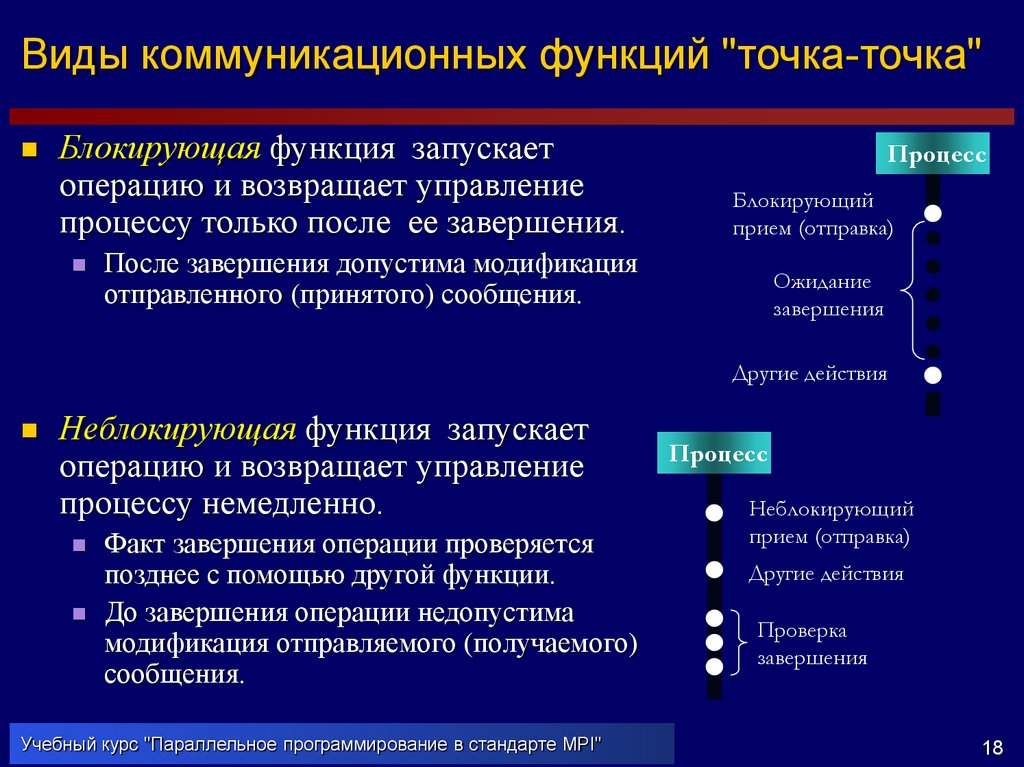

18. Виды коммуникационных функций "точка-точка"

Виды коммуникационных функций "точка-точка"Блокирующая функция запускает

операцию и возвращает управление

процессу только после ее завершения.

Процесс

Блокирующий

прием (отправка)

После завершения допустима модификация

отправленного (принятого) сообщения.

Ожидание

завершения

Другие действия

Неблокирующая функция запускает

операцию и возвращает управление

процессу немедленно.

Факт завершения операции проверяется

позднее с помощью другой функции.

До завершения операции недопустима

модификация отправляемого (получаемого)

сообщения.

Учебный курс "Параллельное программирование в стандарте MPI"

Процесс

Неблокирующий

прием (отправка)

Другие действия

Проверка

завершения

18

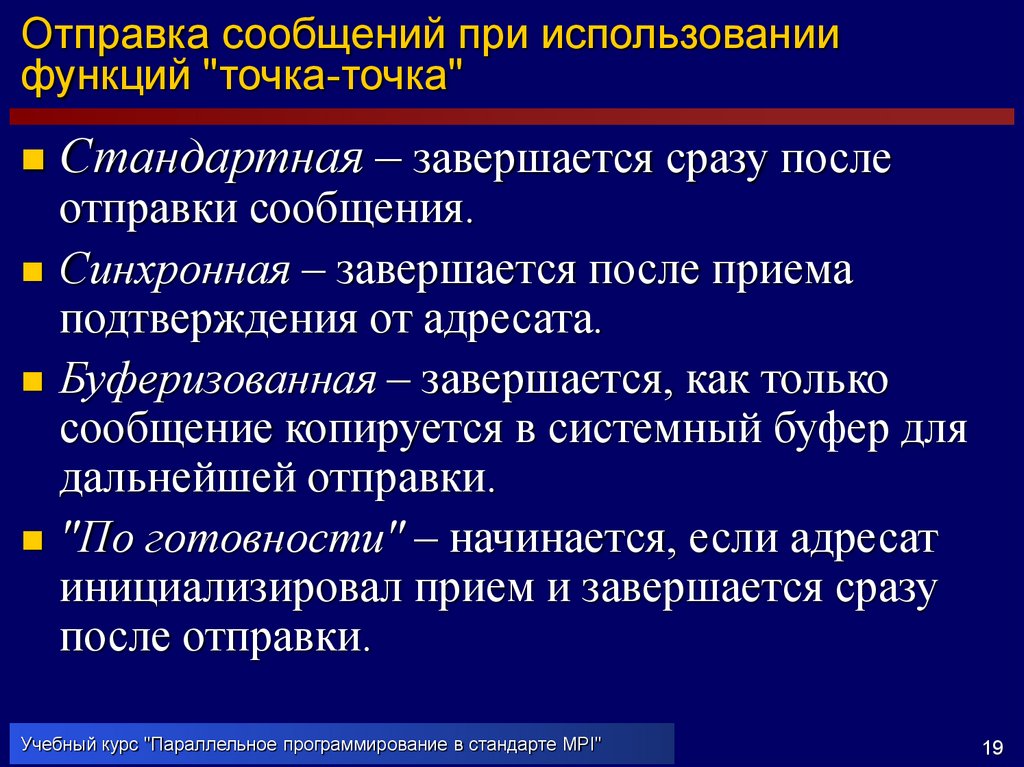

19. Отправка сообщений при использовании функций "точка-точка"

Отправка сообщений при использованиифункций "точка-точка"

Стандартная – завершается сразу после

отправки сообщения.

Синхронная – завершается после приема

подтверждения от адресата.

Буферизованная – завершается, как только

сообщение копируется в системный буфер для

дальнейшей отправки.

"По готовности" – начинается, если адресат

инициализировал прием и завершается сразу

после отправки.

Учебный курс "Параллельное программирование в стандарте MPI"

19

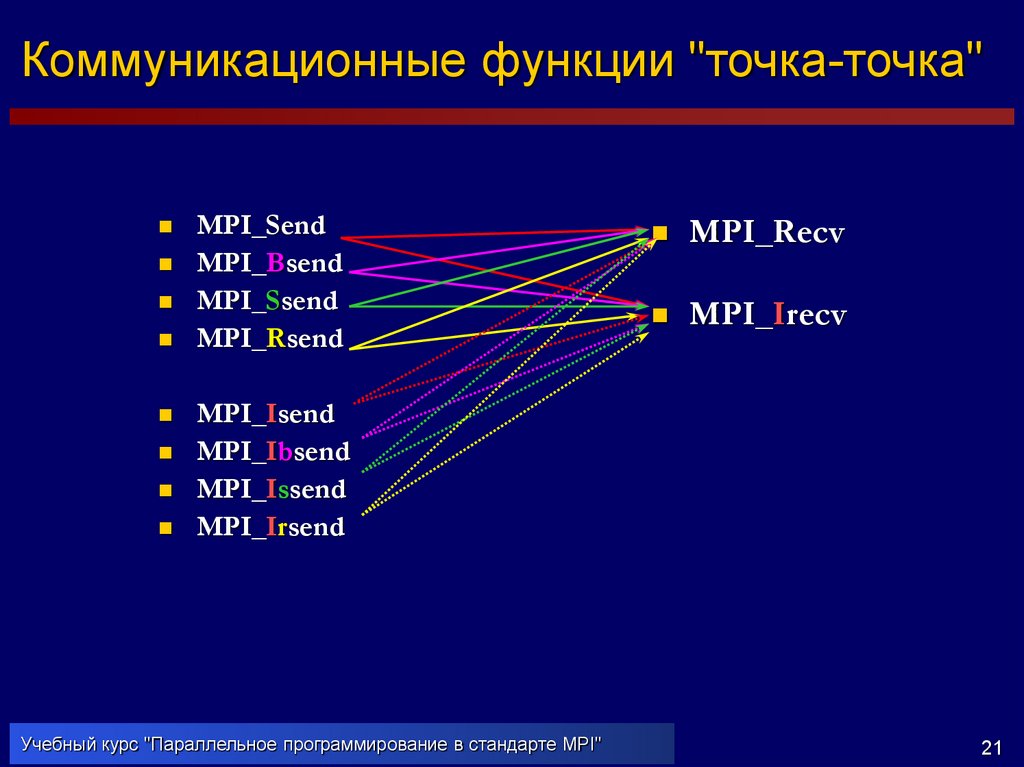

20. Коммуникационные функции "точка-точка"

Коммуникационные функции "точка-точка"Отправка: MPI_[I][R, S, B]Send

Прием: MPI_[I]Recv

Блокирующие

Отправка

Стандартная

MPI_Send

Синхронная

Неблокирующие

Прием

MPI_Recv

Отправка

Стандартная

MPI_Isend

MPI_Ssend

Синхронная

MPI_Issend

Буферизованная

MPI_Bsend

Буферизованная

MPI_Ibsend

По готовности

MPI_Rsend

По готовности

MPI_Irsend

Учебный курс "Параллельное программирование в стандарте MPI"

Прием

MPI_Irecv

20

21. Коммуникационные функции "точка-точка"

Коммуникационные функции "точка-точка"MPI_Send

MPI_Bsend

MPI_Ssend

MPI_Rsend

MPI_Recv

MPI_Irecv

MPI_Isend

MPI_Ibsend

MPI_Issend

MPI_Irsend

Учебный курс "Параллельное программирование в стандарте MPI"

21

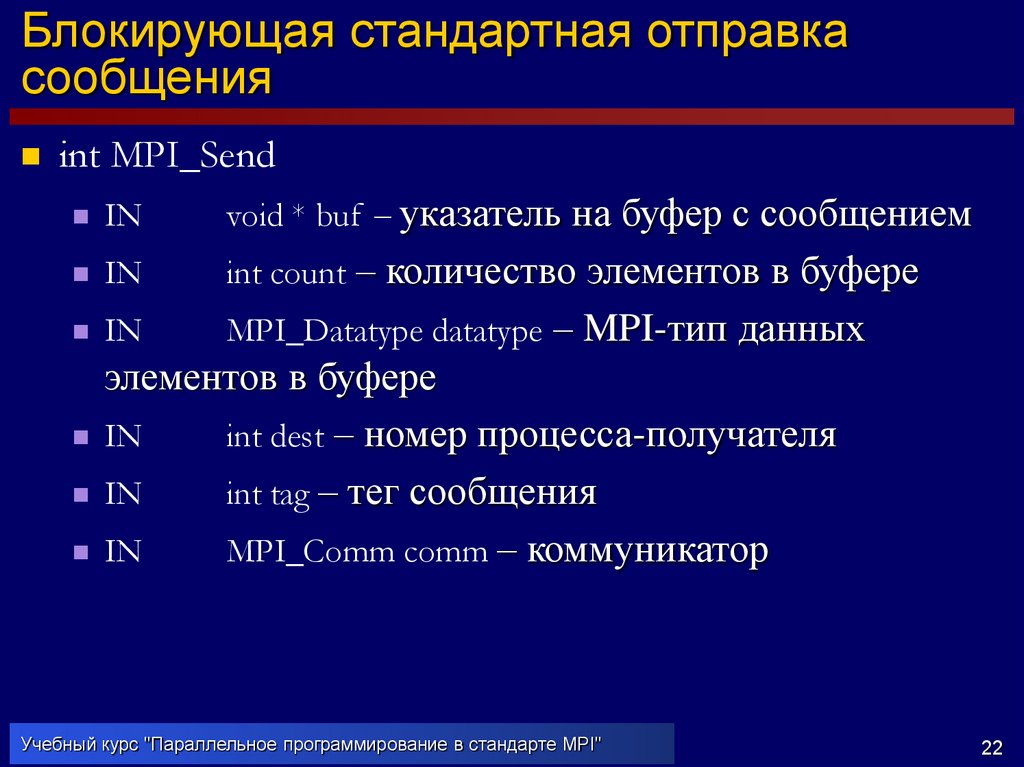

22. Блокирующая стандартная отправка сообщения

int MPI_SendIN

void * buf – указатель на буфер с сообщением

IN

int count – количество элементов в буфере

IN

MPI_Datatype datatype – MPI-тип данных

элементов в буфере

IN

int dest – номер процесса-получателя

IN

int tag – тег сообщения

IN

MPI_Comm comm – коммуникатор

Учебный курс "Параллельное программирование в стандарте MPI"

22

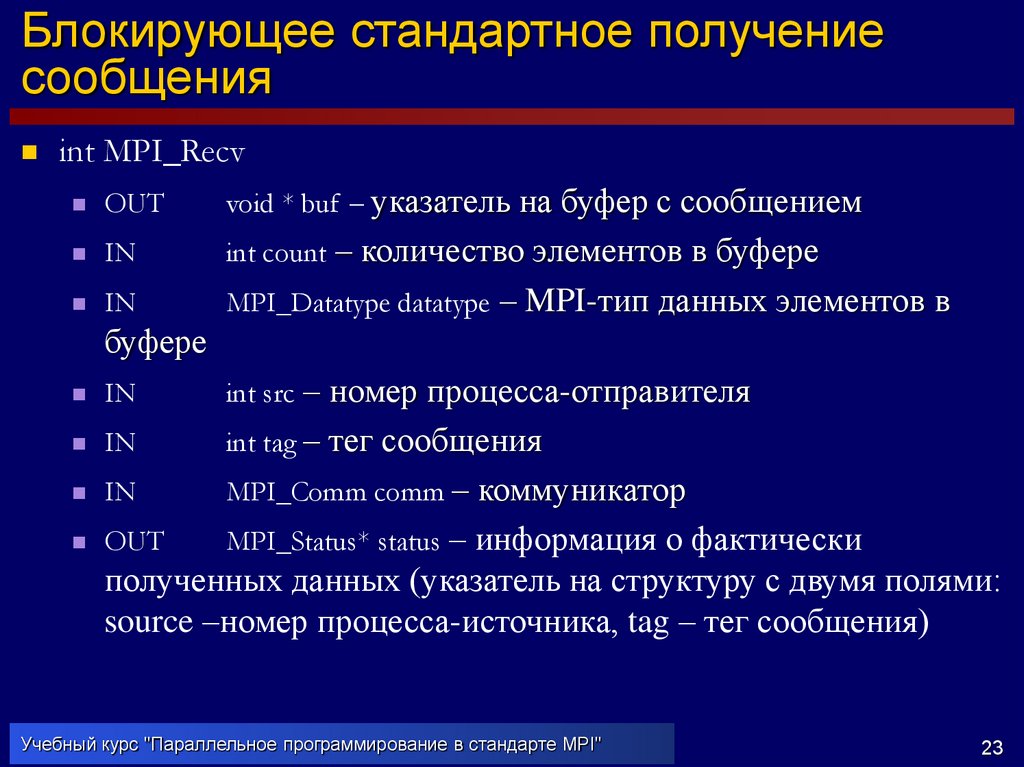

23. Блокирующее стандартное получение сообщения

int MPI_RecvOUT

void * buf – указатель на буфер с сообщением

IN

int count – количество элементов в буфере

IN

MPI_Datatype datatype – MPI-тип данных элементов в

буфере

IN

int src – номер процесса-отправителя

IN

int tag – тег сообщения

IN

MPI_Comm comm – коммуникатор

OUT

MPI_Status* status – информация о фактически

полученных данных (указатель на структуру с двумя полями:

source –номер процесса-источника, tag – тег сообщения)

Учебный курс "Параллельное программирование в стандарте MPI"

23

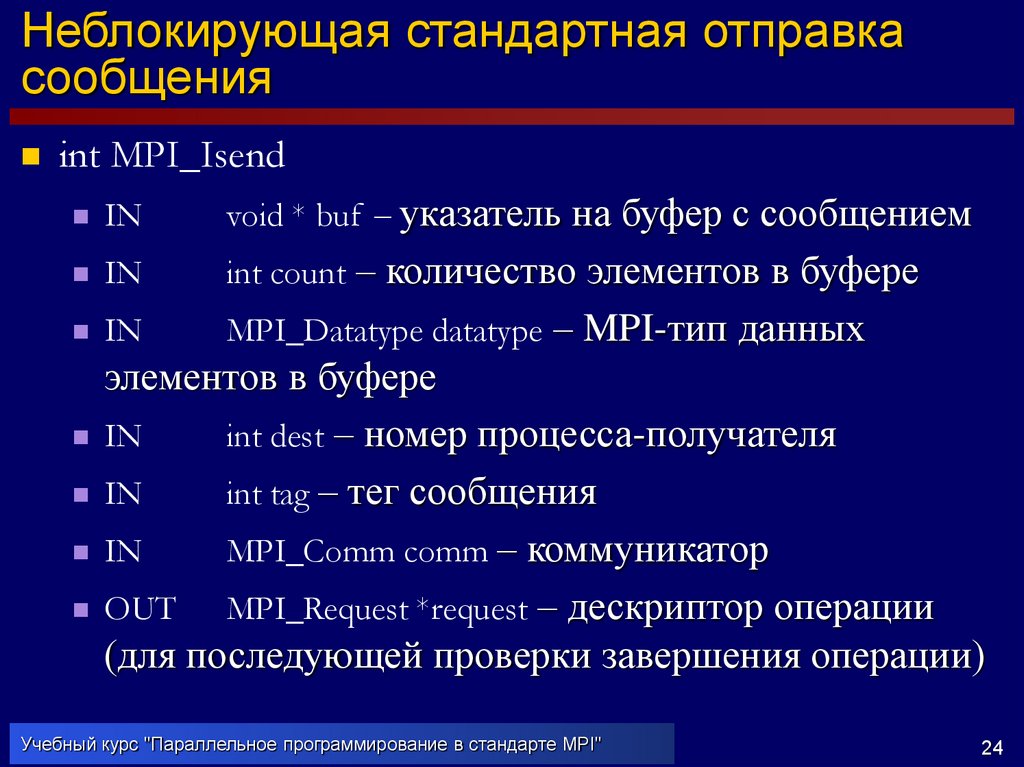

24. Неблокирующая стандартная отправка сообщения

int MPI_IsendIN

void * buf – указатель на буфер с сообщением

IN

int count – количество элементов в буфере

IN

MPI_Datatype datatype – MPI-тип данных

элементов в буфере

IN

int dest – номер процесса-получателя

IN

int tag – тег сообщения

IN

MPI_Comm comm – коммуникатор

OUT MPI_Request *request – дескриптор операции

(для последующей проверки завершения операции)

Учебный курс "Параллельное программирование в стандарте MPI"

24

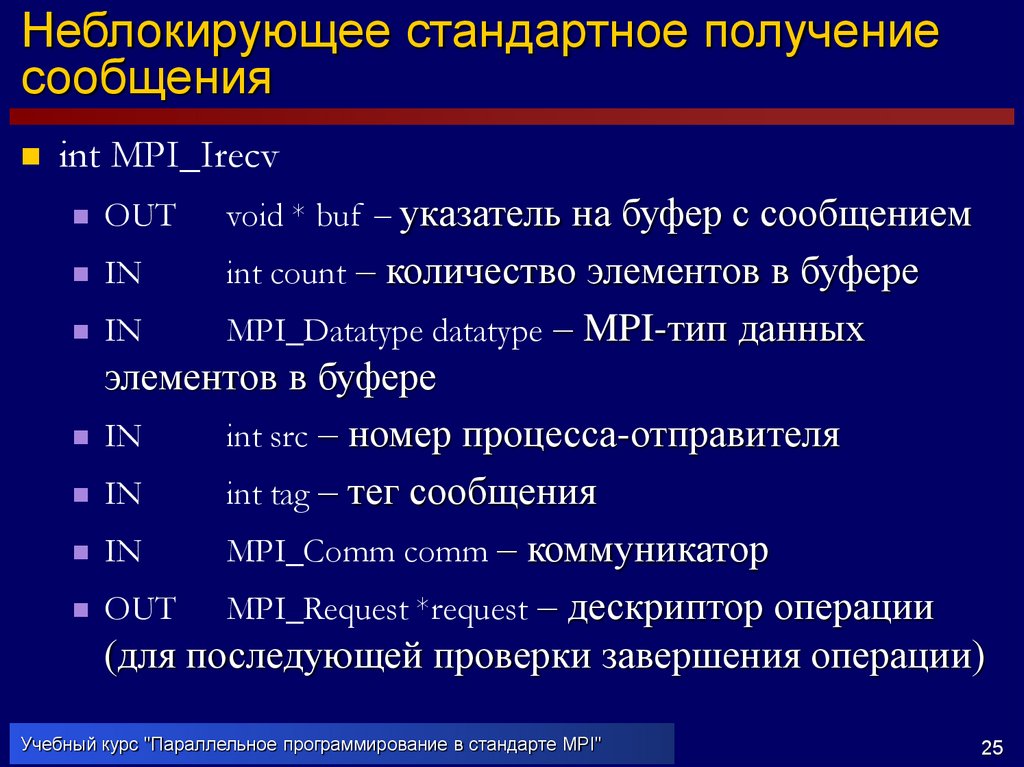

25. Неблокирующее стандартное получение сообщения

int MPI_IrecvOUT

void * buf – указатель на буфер с сообщением

IN

int count – количество элементов в буфере

IN

MPI_Datatype datatype – MPI-тип данных

элементов в буфере

IN

int src – номер процесса-отправителя

IN

int tag – тег сообщения

IN

MPI_Comm comm – коммуникатор

OUT MPI_Request *request – дескриптор операции

(для последующей проверки завершения операции)

Учебный курс "Параллельное программирование в стандарте MPI"

25

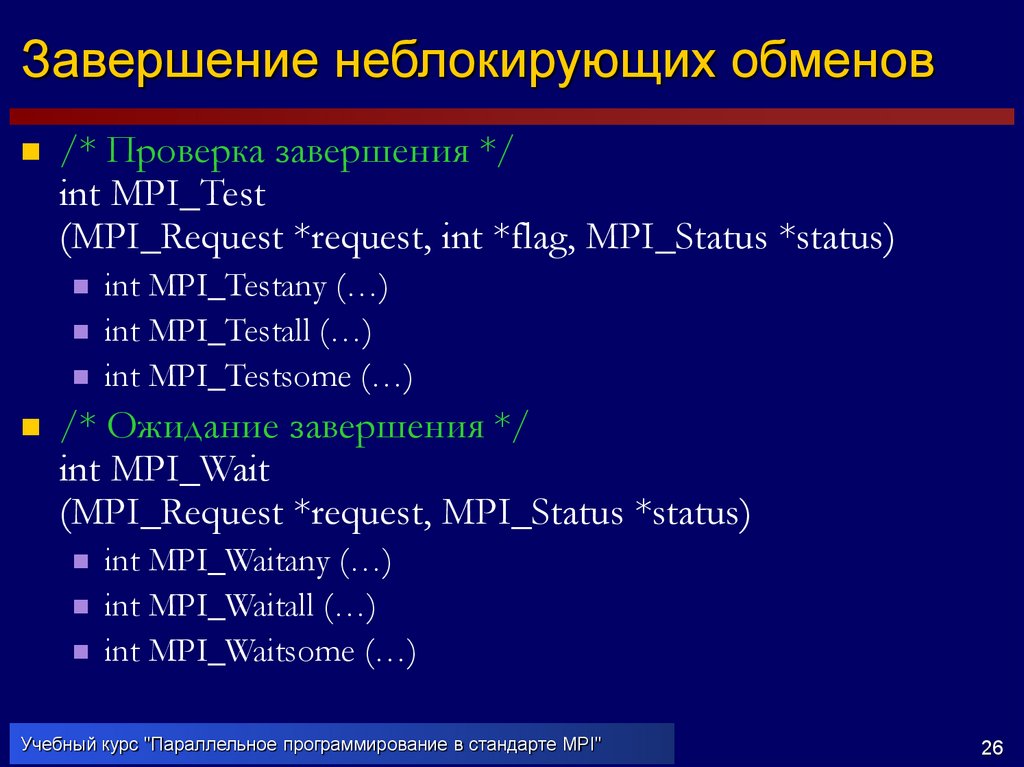

26. Завершение неблокирующих обменов

/* Проверка завершения */int MPI_Test

(MPI_Request *request, int *flag, MPI_Status *status)

int MPI_Testany (…)

int MPI_Testall (…)

int MPI_Testsome (…)

/* Ожидание завершения */

int MPI_Wait

(MPI_Request *request, MPI_Status *status)

int MPI_Waitany (…)

int MPI_Waitall (…)

int MPI_Waitsome (…)

Учебный курс "Параллельное программирование в стандарте MPI"

26

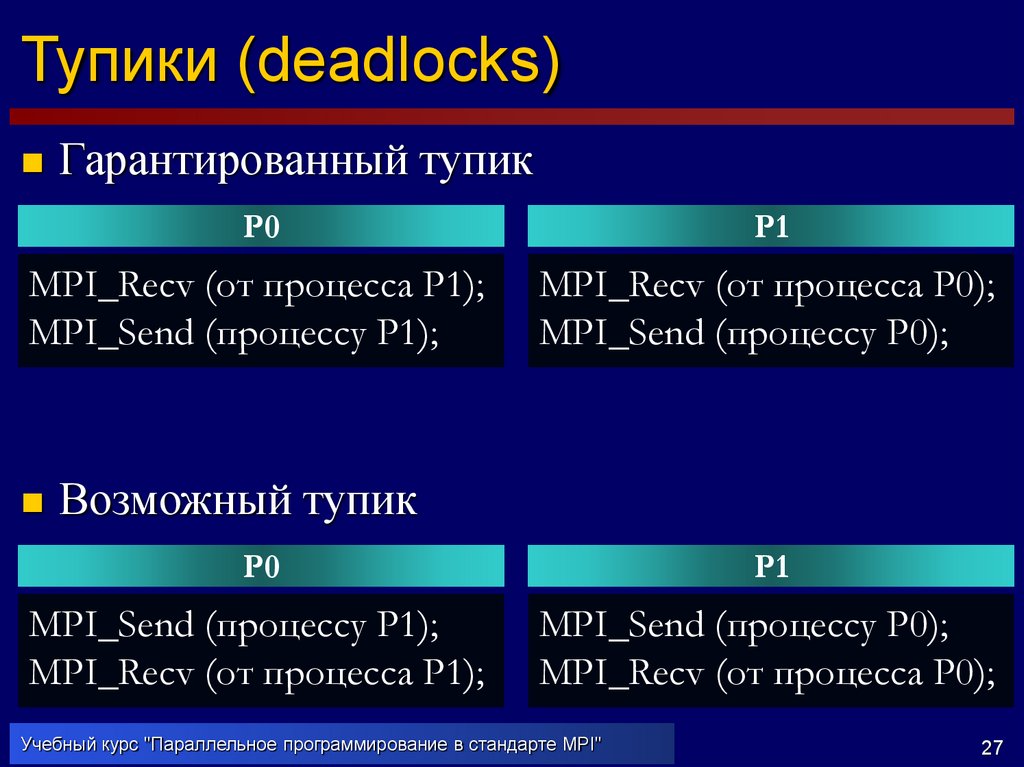

27. Тупики (deadlocks)

Гарантированный тупикP0

P1

MPI_Recv (от процесса P1);

MPI_Send (процессу P1);

MPI_Recv (от процесса P0);

MPI_Send (процессу P0);

Возможный тупик

P0

P1

MPI_Send (процессу P1);

MPI_Recv (от процесса P1);

MPI_Send (процессу P0);

MPI_Recv (от процесса P0);

Учебный курс "Параллельное программирование в стандарте MPI"

27

28. Разрешение тупиков

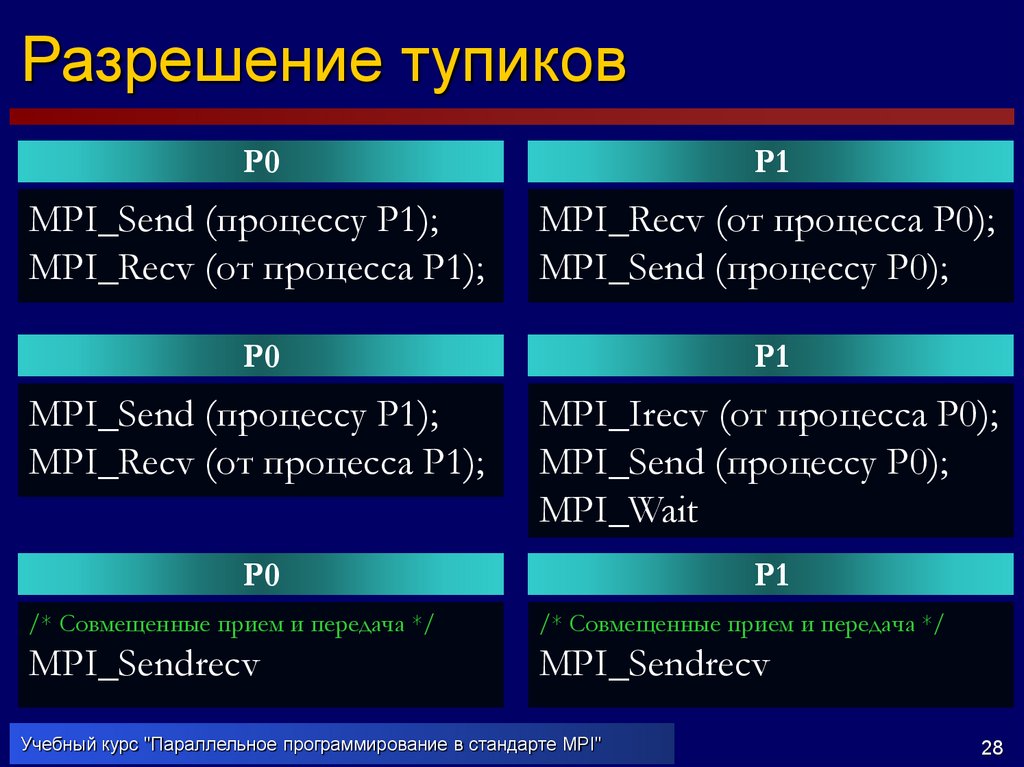

P0P1

MPI_Send (процессу P1);

MPI_Recv (от процесса P1);

MPI_Recv (от процесса P0);

MPI_Send (процессу P0);

P0

P1

MPI_Send (процессу P1);

MPI_Recv (от процесса P1);

MPI_Irecv (от процесса P0);

MPI_Send (процессу P0);

MPI_Wait

P0

P1

/* Совмещенные прием и передача */

/* Совмещенные прием и передача */

MPI_Sendrecv

MPI_Sendrecv

Учебный курс "Параллельное программирование в стандарте MPI"

28

29. Барьерная синхронизация процессов

int MPI_Barrier(MPI_Comm comm)Вызвавший данную функцию процесс

блокируется до тех пор, пока все другие

процессы указанного коммуникатора не

вызовут эту функцию.

Завершение данной функции возможно только

всеми процессами одновременно (все процессы

"преодолевают барьер" одновременно).

Учебный курс "Параллельное программирование в стандарте MPI"

29

30. Получение сообщений

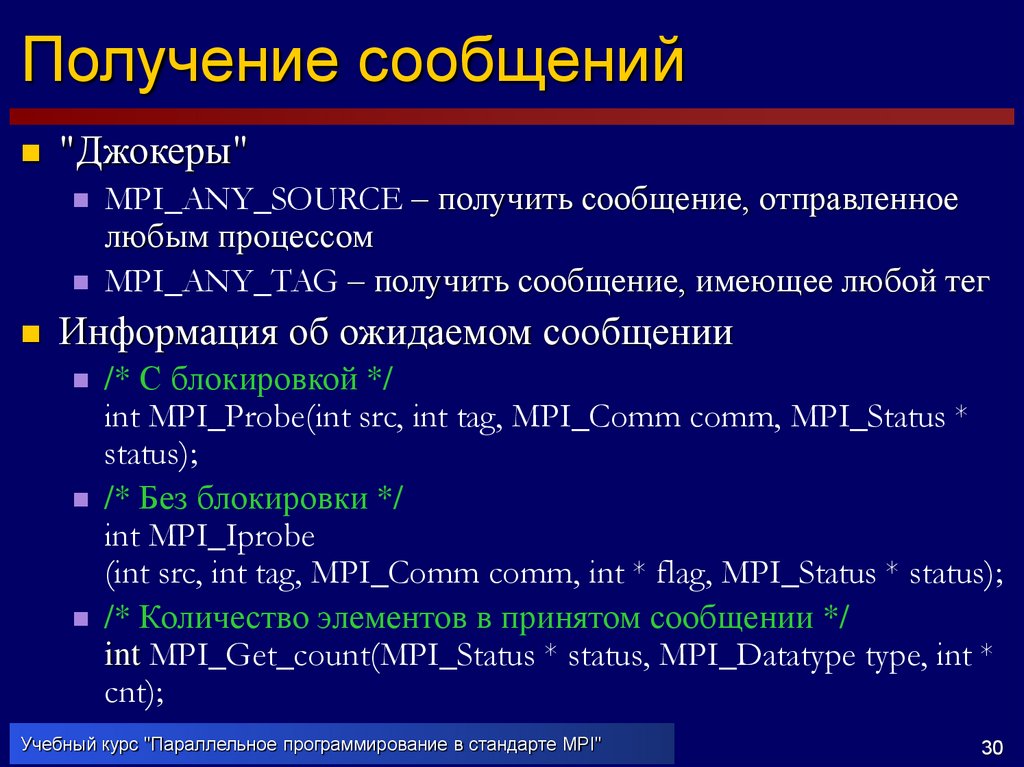

"Джокеры"MPI_ANY_SOURCE – получить сообщение, отправленное

любым процессом

MPI_ANY_TAG – получить сообщение, имеющее любой тег

Информация об ожидаемом сообщении

/* С блокировкой */

int MPI_Probe(int src, int tag, MPI_Comm comm, MPI_Status *

status);

/* Без блокировки */

int MPI_Iprobe

(int src, int tag, MPI_Comm comm, int * flag, MPI_Status * status);

/* Количество элементов в принятом сообщении */

int MPI_Get_count(MPI_Status * status, MPI_Datatype type, int *

cnt);

Учебный курс "Параллельное программирование в стандарте MPI"

30

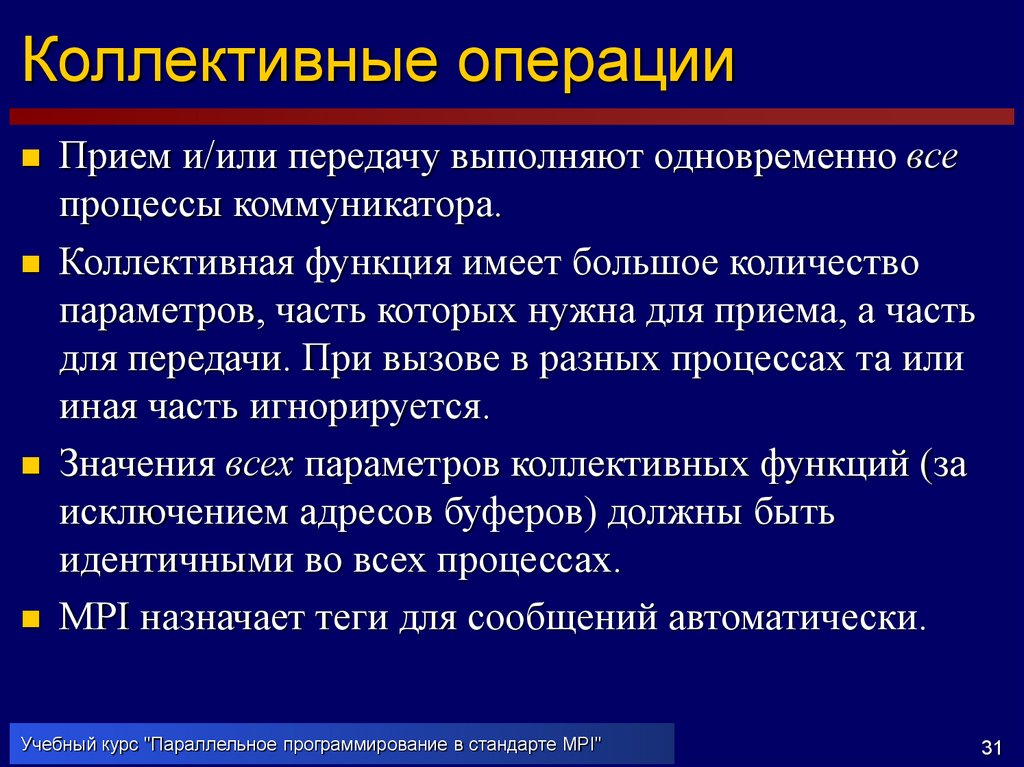

31. Коллективные операции

Прием и/или передачу выполняют одновременно всепроцессы коммуникатора.

Коллективная функция имеет большое количество

параметров, часть которых нужна для приема, а часть

для передачи. При вызове в разных процессах та или

иная часть игнорируется.

Значения всех параметров коллективных функций (за

исключением адресов буферов) должны быть

идентичными во всех процессах.

MPI назначает теги для сообщений автоматически.

Учебный курс "Параллельное программирование в стандарте MPI"

31

32. Коллективная рассылка сообщения

/* Рассылка содержимого буфера из процесса сномером rootRank, во все остальные */

int MPI_Bcast

(void * buf, int count, MPI_Datatype type, int rootRank,

MPI_Comm comm);

A0

A0

A0

Процессы

Процессы

MPI_Bcast

Данные

Учебный курс "Параллельное программирование в стандарте MPI"

A0

A0

Данные

32

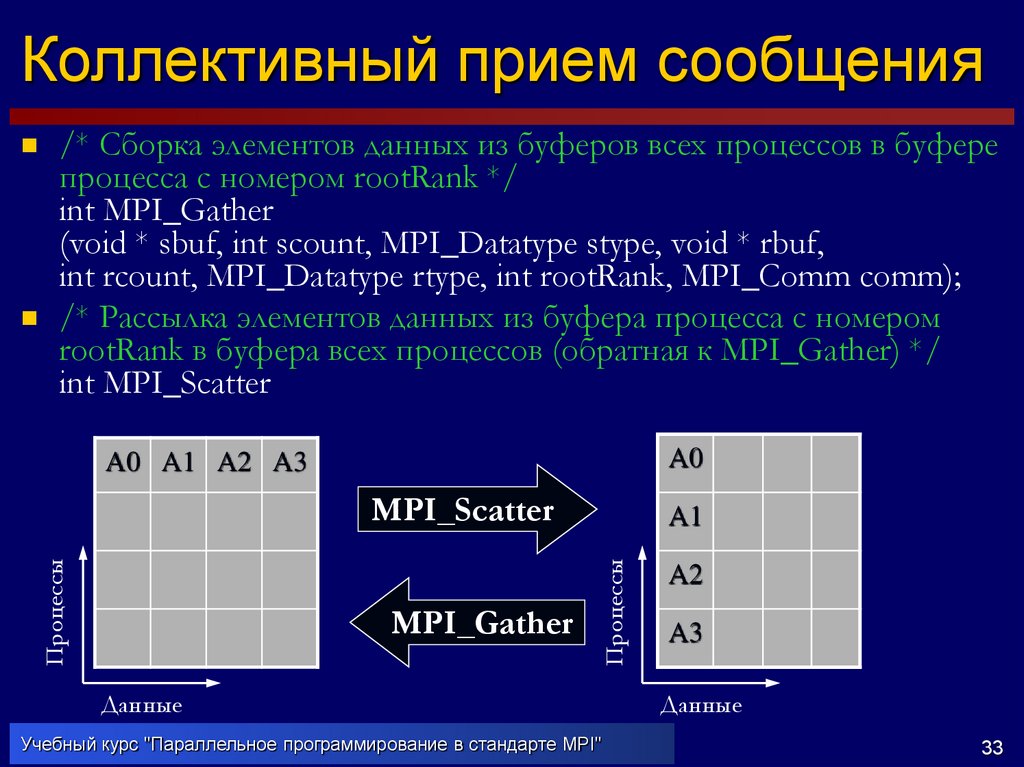

33. Коллективный прием сообщения

/* Сборка элементов данных из буферов всех процессов в буферепроцесса с номером rootRank */

int MPI_Gather

(void * sbuf, int scount, MPI_Datatype stype, void * rbuf,

int rcount, MPI_Datatype rtype, int rootRank, MPI_Comm comm);

/* Рассылка элементов данных из буфера процесса с номером

rootRank в буфера всех процессов (обратная к MPI_Gather) */

int MPI_Scatter

A0

A0 A1 A2 A3

MPI_Gather

A1

Процессы

Процессы

MPI_Scatter

Данные

Учебный курс "Параллельное программирование в стандарте MPI"

A2

A3

Данные

33

34. Широковещательные прием и передача

A0MPI_Allgather

A0 B0 C0 D0

Процессы

Процессы

B0

A0 B0 C0 D0

C0

D0

Данные

A0 B0 C0 D0

MPI_Alltoall

C0 C1 C2 C3

D0 D1 D2 D3

Данные

Учебный курс "Параллельное программирование в стандарте MPI"

A1 B1 C1 D1

Процессы

Процессы

A0 B0 C0 D0

Данные

A0 A1 A2 A3

B0 B1 B2 B3

A0 B0 C0 D0

A2 B2 C2 D2

A3 B3 C3 D3

Данные

34

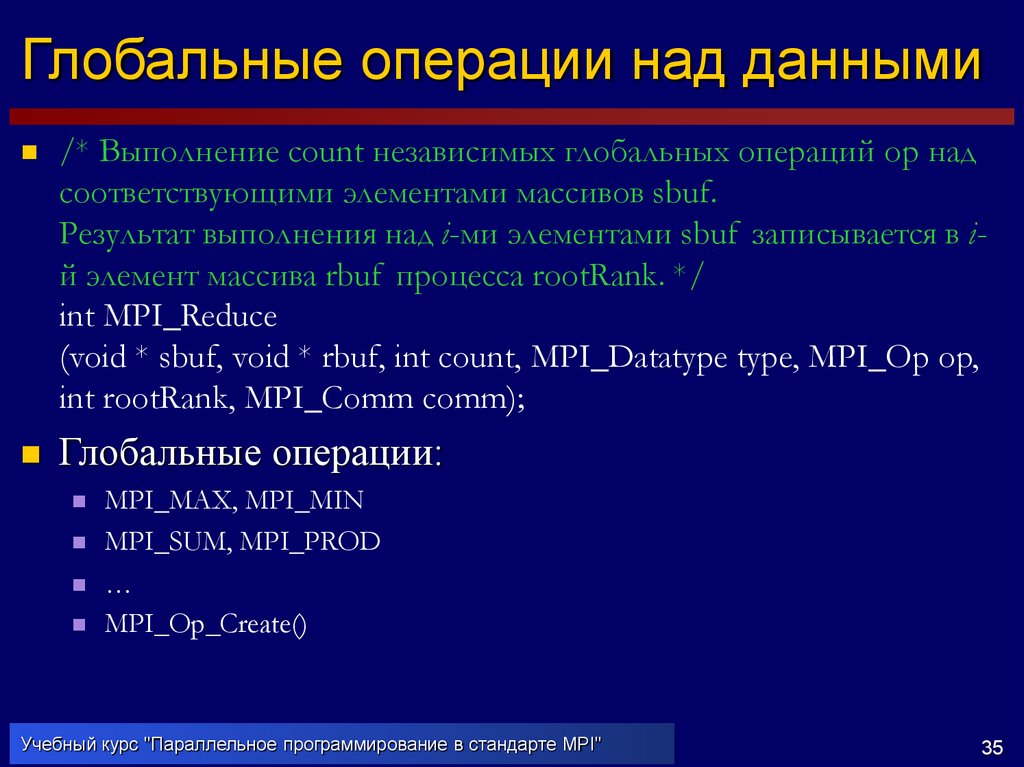

35. Глобальные операции над данными

/* Выполнение count независимых глобальных операций op надсоответствующими элементами массивов sbuf.

Результат выполнения над i-ми элементами sbuf записывается в iй элемент массива rbuf процесса rootRank. */

int MPI_Reduce

(void * sbuf, void * rbuf, int count, MPI_Datatype type, MPI_Op op,

int rootRank, MPI_Comm comm);

Глобальные операции:

MPI_MAX, MPI_MIN

MPI_SUM, MPI_PROD

…

MPI_Op_Create()

Учебный курс "Параллельное программирование в стандарте MPI"

35

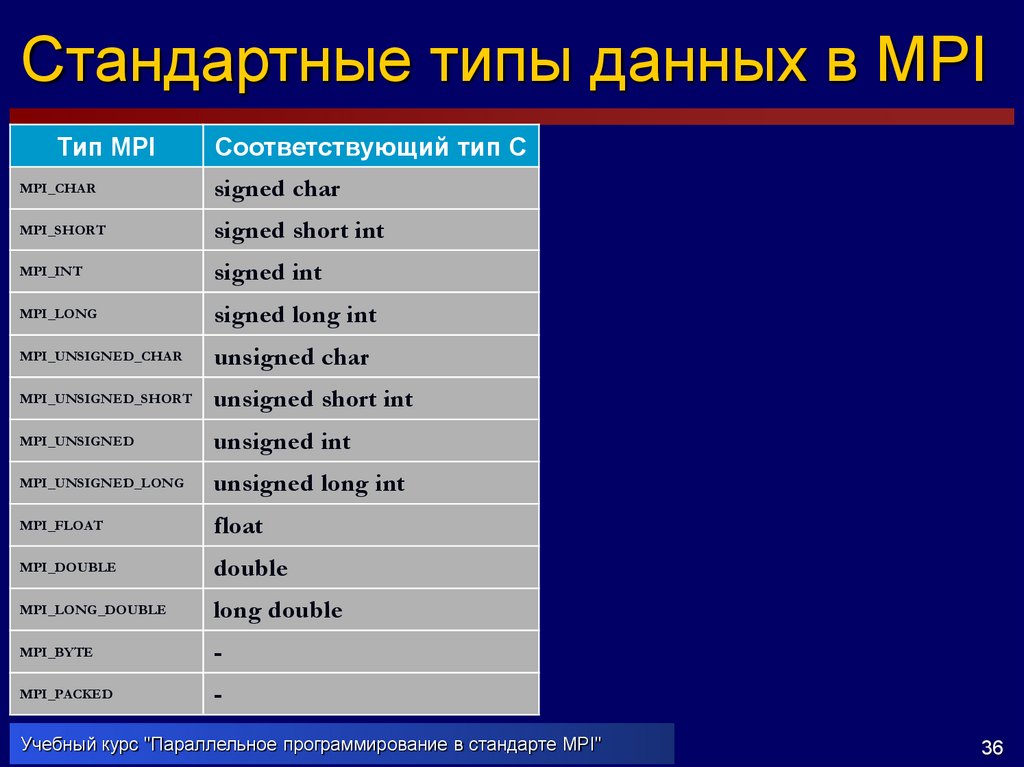

36. Стандартные типы данных в MPI

Тип MPIСоответствующий тип С

MPI_CHAR

signed char

MPI_SHORT

signed short int

MPI_INT

signed int

MPI_LONG

signed long int

MPI_UNSIGNED_CHAR

unsigned char

MPI_UNSIGNED_SHORT

unsigned short int

MPI_UNSIGNED

unsigned int

MPI_UNSIGNED_LONG

unsigned long int

MPI_FLOAT

float

MPI_DOUBLE

double

MPI_LONG_DOUBLE

long double

MPI_BYTE

-

MPI_PACKED

-

Учебный курс "Параллельное программирование в стандарте MPI"

36

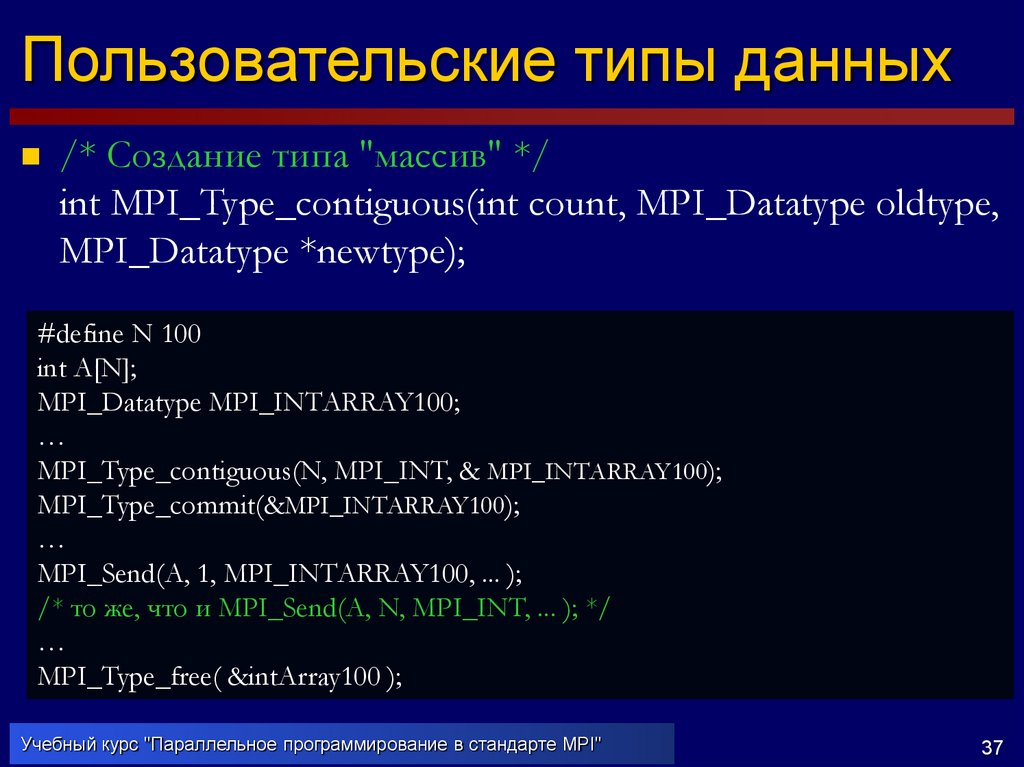

37. Пользовательские типы данных

/* Создание типа "массив" */int MPI_Type_contiguous(int count, MPI_Datatype oldtype,

MPI_Datatype *newtype);

#define N 100

int A[N];

MPI_Datatype MPI_INTARRAY100;

…

MPI_Type_contiguous(N, MPI_INT, & MPI_INTARRAY100);

MPI_Type_commit(&MPI_INTARRAY100);

…

MPI_Send(A, 1, MPI_INTARRAY100, ... );

/* то же, что и MPI_Send(A, N, MPI_INT, ... ); */

…

MPI_Type_free( &intArray100 );

Учебный курс "Параллельное программирование в стандарте MPI"

37

Программирование

Программирование