Похожие презентации:

Основы информатики. Лекция 1

1. Основы информатики

2. ИНФОРМАТИКА

Информатика – наука, изучающая свойстваинформации, а также способы представления,

накопления, обработки и передачи информации с

помощью технических средств.

В информатике выделяют 3 основных направления:

1. Теоретическая информатика – изучает теорию

информации, теорию алгоритмов;

2. Практическая

информатика

–

изучает

программирование и использование прикладных

программ;

3. Техническая

информатика

–

изучает

проектирование, разработку и использование

технических средств.

3. ИНФОРМАЦИЯ

Информация (от лат. Information) - сведения, знанияи сообщения, получаемые человеком из различных

источников.

Понятие информации – одно из фундаментальных в

современной науке. Наряду с такими понятиями, как

вещество, энергия, пространство и время, оно

составляет основу научной картины мира. Однозначно

определить, что же такое информация, также

невозможно, как невозможно это сделать для понятий

«время», «энергия» …

• Под информацией в быту понимают интересующие

нас сведения об окружающем нас мире и протекающих

в нем процессах, воспринимаемые и интерпретируемые

человеком или специальным и устройствами.

4.

• Под информацией в технике понимаютсообщения в форме знаков или сигналов,

хранимые, передаваемые и обрабатываемые с

помощью технических средств.

• Под информацией в теории информации

понимают не любые сведения, а лишь те,

которые снимают полностью или уменьшают

существующую

до

их

получения

неопределенность.

• Под информацией в семантической теории

(смысл

сообщения)

понимают

сведения,

обладающие новизной.

• В информатике информацию рассматривают

как продукт взаимодействия данных и методов

их обработки, адекватных решаемой задаче.

4

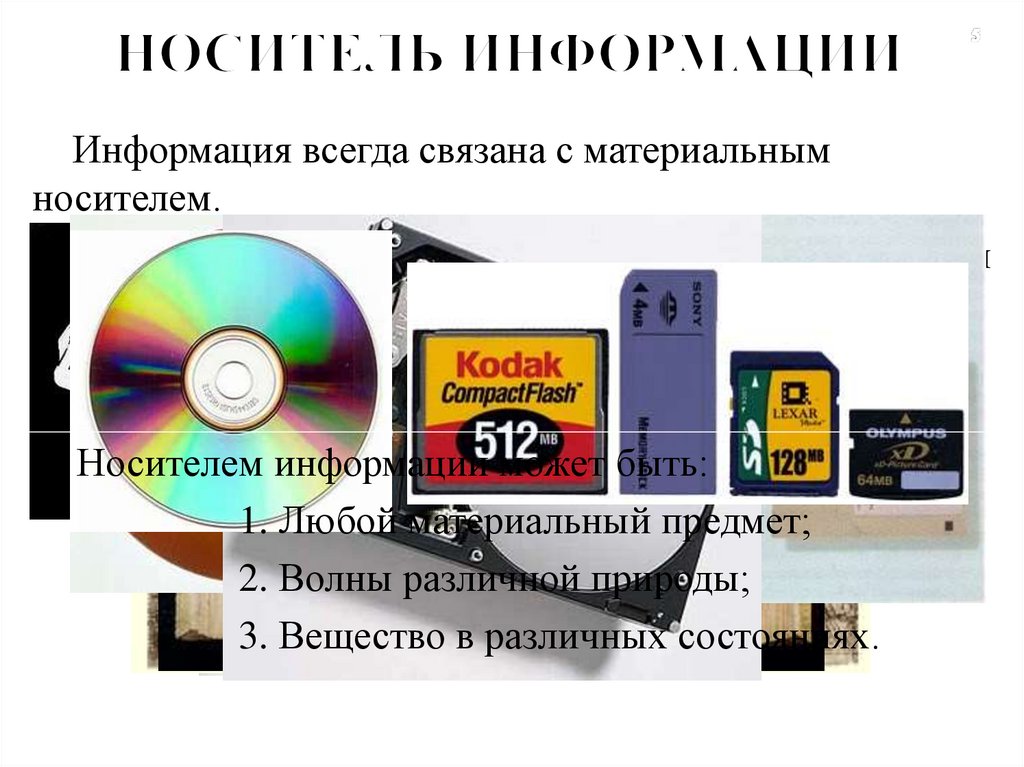

5. НОСИТЕЛЬ ИНФОРМАЦИИ

Информация всегда связана с материальнымносителем.

Носитель информации – среда для записи, хранения

и передачи информации.

Носителем информации может быть:

1. Любой материальный предмет;

2. Волны различной природы;

3. Вещество в различных состояниях.

6.

Способ передачи информации – сигнал (отанг. Sign – знак, символ). Сигнал – это

физический процесс, имеющий информационное

значение. Сигнал может быть аналоговым

(непрерывным) или дискретным (принимающий

конечное число значений в конечное число

моментов времени)

Любой сигнал переносится либо веществом

(текст, наскальный рисунок, гены и т.д.), либо

энергией (звук, свет, радиоволны и т.д.) А значит

информация всегда связана с материальным

носителем.

6

7. ВИДЫ ИНФОРМАЦИИ

По способу восприятия:o визуальная,

o аудиальная,

o тактильная,

o обонятельная,

o вкусовая.

По форме представления:

o текстовая,

o числовая,

o графическая,

o звуковая.

8.

По степени значимости:o Личная (знания, умения, планы, чувства,

интуиция, опыт, наследственная память)

o Специальная (научная, производственная,

техническая, управленческая)

o Общественная (общественнополитическая, научно – популярная,

обыденная, эстетическая)

8

9. СВОЙСТВА ИНФОРМАЦИИ

Объективность – Субъективность (информацияобъективна, если она не зависит от чьего-либо мнения,

суждения)

Достоверность – недостоверность или Ложность

(информация достоверна, если она отражает истинное

положение дел)

Полнота – Неполнота или Недостаточность , а

также Избыточность (Информация полна, если её

достаточно для понимания и принятия решения)

10.

Актуальность – Неактуальность илиУстарение, а также

Преждевременность

(информация актуальна, если она важна,

существенна для настоящего времени)

Полезность или Ценность – Бесполезность

(полезность информации оценивается теми

задачами, которые мы можем решить с её

помощью)

Понятность – Непонятность (информация

понятна, если она выражена на языке,

доступном для получателя)

10

11. ИНФОРМАЦИОННЫЕ ПРОЦЕССЫ

Информационный процесс – совокупностьпоследовательных

действий

(операций),

производимых над информацией для получения

какого-либо результата (достижения цели).

Информация

проявляется

именно

в

информационных процессах.

Информационные процессы всегда протекают в

каких-либо

системах

(социальных,

социотехнических, биологических и пр.)

12.

Наиболееобщими

информационными

процессами являются: сбор, преобразование,

использование информации.

К основным информационным процессам,

изучаемым в курсе информатики, относятся:

поиск,

отбор,

хранение,

передача,

кодирование,

обработка,

защита

информации.

Компьютер

является

универсальным

устройством

для

автоматизированного

выполнения информационных процессов.

12

13. ХРАНЕНИЕ ИНФОРМАЦИИ

Хранениеинформации

необходимо

для

распространения её во времени.

Хранилище информации

- это определенным

образом организованная информация на внешних

носителях, предназначенная для длительного хранения

и постоянного использования.

Хранилище информации зависит от её носителя

(книга – библиотека, картина – музей, фотография –

альбом).

14.

Основные хранилища информации:Для человека – память, в том числе

генетическая.

Для общества – библиотеки, видеотеки,

фонотеки, архивы, музеи и т.п.

Компьютерные хранилища – базы и банки

данных,

информационно-поисковые

системы,

электронные

энциклопедии,

медиатеки и т.п.

Информация, предназначенная для хранения и

передачи, как правило, представлена в форме

документа.

Под

документом

понимается

информация на любом материальном носителе,

предназначенная

для

распространения

в

пространстве и времени.

14

15. Передача информации

В любом процессе передачи или обменеинформацией существует её источник и

получатель, а сама информация передается по

каналу связи с помощью сигналов: механических,

тепловых, электрических и др.

В обычной жизни для человека любой звук,

свет являются сигналами, несущими смысловую

нагрузку. Например, сирена – это звуковой сигнал

тревоги; звонок телефона – сигнал, чтобы взять

трубку; красный свет светофора – сигнал,

запрещающий переход дороги.

В качестве источника информации может

выступать живое существо или техническое

устройство

16.

От источника информация попадает в кодирующееустройство,

которое

предназначено

для

преобразования исходного сообщения в форму,

удобную для передачи. С такими устройствами вы

встречаетесь постоянно: микрофон телефона, лист

бумаги и т.п. По каналу связи информация попадает в

декодирующее устройство получателя, которое

преобразует сообщение в форму, понятную

получателю. Одни из самых сложных декодирующих

устройств – человеческие ухо и глаз.

16

17.

В процессе передачи информация можетутрачиваться, искажаться. Это происходит из-за

различных помех, как на канале связи, так и при

кодировании

и

декодировании

информации

(искажение звука в телефоне, помехи при

телевизионной передаче, и др).

Вопросами, связанными с методами кодирования

и

декодирования

информации,

занимается

специальная наука – криптография.

17

18. ПЕРЕДАЧА ИНФОРМАЦИИ

ИС

Т

О

Ч

Н

И

К

Помехи

Кодирующее

устройство

КАНАЛ

СВЯЗИ

Защита

от помех

Декодирующее

устройство

П

Р

И

Ё

М

Н

И

К

19. ОБРАБОТКА ИНФОРМАЦИИ

Обработкаинформации

–

преобразование

информации из одного вида в другой.

Обычно обработка информации целенаправленный

процесс и для успешного выполнения исполнителю

должен быть известен способ обработки, т.е.

последовательность действий, правило.

20. Содержательный (вероятностный) подход

Измерение информации в теории информации(информация как снятая неопределенность)

Получение информации

одновременно означат

увеличение знания, что, в свою очередь, означает

уменьшение

незнания

или

информационной

неопределенности.

За единицу количества информации принимают

выбор одного из двух равновероятных сообщений

(«да» или «нет», «1» или «0»). Она также названа

битом. Вопрос ценности этой информации для

получателя – это уже из иной области.

20

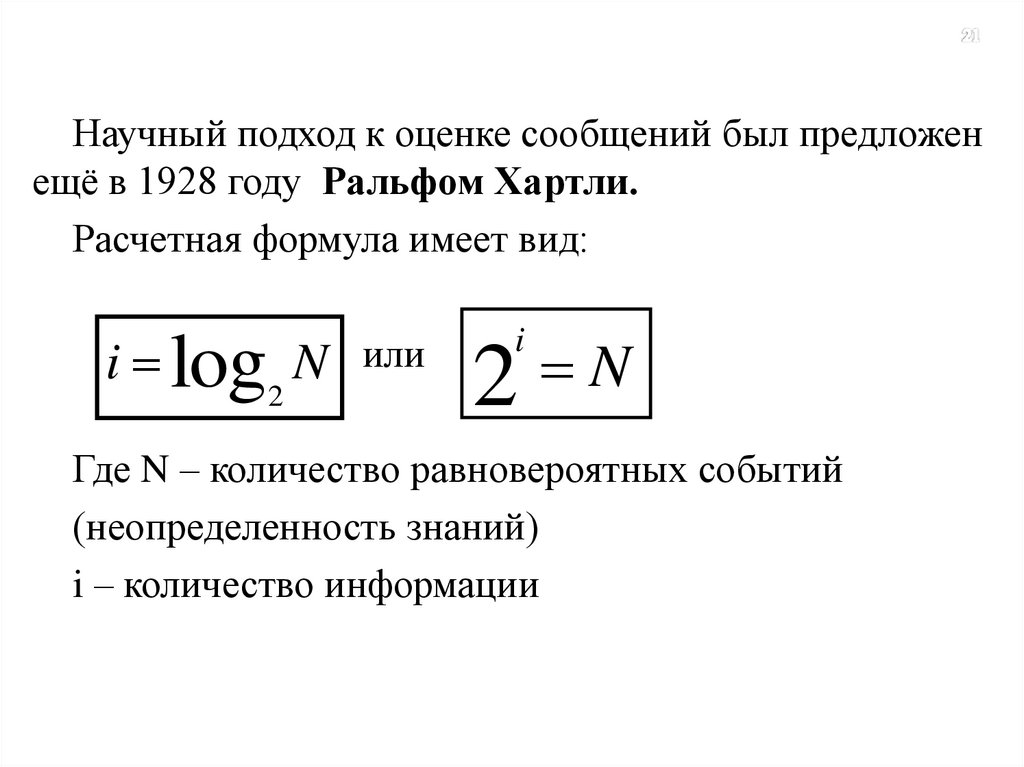

21.

Научный подход к оценке сообщений был предложенещё в 1928 году Ральфом Хартли.

Расчетная формула имеет вид:

i log N

2

или

N

2

i

Где N – количество равновероятных событий

(неопределенность знаний)

i – количество информации

22. Содержательный (вероятностный) подход

В качестве единицы информации условилисьпринять один бит

(англ. bit — binary, digit — двоичная цифра).

Бит в теории информации — количество

информации, необходимое для различения двух

равновероятных сообщений.

Например:

1. при бросании монеты: "выпала решка", "выпал

орел";

2. на странице книги: "количество букв чётное",

"количество букв нечётное".

23. Содержательный (вероятностный) подход

Допустим, нам требуется что-либо найти или определить в той или иной системе. Есть такойспособ поиска как «деление пополам». Например, кто-то загадывает число от 1 до 100, а

другой должен отгадать его, получая лишь ответы «да» или «нет». Задается вопрос: число

меньше? Ответ и «да» и «нет» сократит область поиска вдвое. Далее по той же схеме

диапазон снова делится пополам. В конечном итоге, загаданное число будет найдено.

Посчитаем сколько вопросов надо задать, чтобы найти задуманное число. Допустим загаданное

число 27. Начали:

Больше 50? Нет

Больше 25? Да

Больше 38? Нет

Меньше 32? Да

Меньше 29? Да

Больше 27? Нет

Это число 26? Нет

Если число не 26 и не больше 27, то это явно 27. Чтобы угадать методом «деления пополам»

число от 1 до 100 нам потребовалось 7 вопросов.

Кто-то может задаться вопросом: а почему именно так надо задавать вопросы? Ведь, например,

можно просто спрашивать: это число 1? Это число 2? И т.д. Но тогда вам потребуется

намного больше вопросов (возможность того, что вы телепат, и угадаете с первого раза не

рассматривается). «Деление пополам» самый короткий рациональный способ найти число.

Объем информации заложенный в ответ «да» или «нет» равен одному биту. Действительно,

ведь бит может быть в состоянии 1 или 0. Итак, для угадывания числа от 1 до 100 нам

потребовалось семь бит (семь ответов «да» - «нет»).

24. Содержательный (вероятностный) подход

С точки зрения взгляда на информацию как наснятую

неопределенность

количество

информации зависит от вероятности получения

того или иного сообщения. Причем, чем больше

вероятность события, тем меньшее количество

информации содержится в сообщении о таком

событии.

Иными словами, количество информации

зависит от вероятности свершения данного

события.

24

25. Содержательный (вероятностный) подход

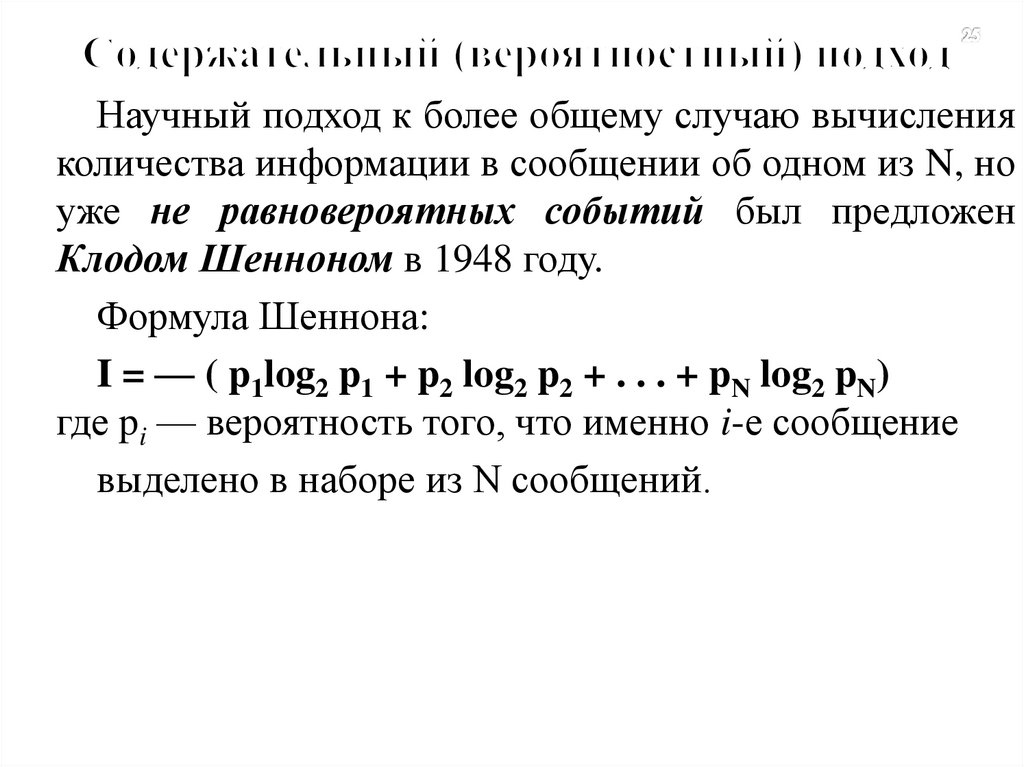

Научный подход к более общему случаю вычисленияколичества информации в сообщении об одном из N, но

уже не равновероятных событий был предложен

Клодом Шенноном в 1948 году.

Формула Шеннона:

I = — ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN)

где pi — вероятность того, что именно i-е сообщение

выделено в наборе из N сообщений.

26. КОДИРОВАНИЕ ТЕКСТОВОЙ ИНФОРМАЦИИ

Для того, что бы в компьютере хранить текстовые данные,необходимо предварительно закодировать все символы, которые

могут использоваться в тексте. Текст может содержать цифры,

прописные и строчные буквы, пробелы, знаки препинания и

специальные символы (например, # & %) , поэтому необходимо,

чтобы мощность алфавита, включающего все кодируемые

символы, была достаточно Большой. Если буквы, входящие в

текст могут быть только латинские или русские, то для

кодирования одного символа достаточно использовать 8

битовых ячеек памяти, т.е. 1 байт памяти (поскольку с помощью

8 ячеек памяти можно закодировать 28=256

различных

символов). При этом надо договориться кокой именно

комбинацией активных и неактивных ячеек будет кодироваться

каждый символ. Например, символ пробела кодируется

комбинацией 00100000, а прописная буква А – комбинацией

1100000.

27. КОДИРОВАНИЕ ТЕКСТОВОЙ ИНФОРМАЦИИ

В настоящее время имеется несколько однобайтовых(8-битных) кодировок символов, включающих русские

буквы: Windows-1251, ASCII, КОИ-8.

С

распространением

Интернета

возникла

необходимость в использовании такого набора символов,

который содержал бы буквы всех существующих языков.

Поэтому было решено использовать для кодирования

каждого символа 2 байта, или 16 битовых ячеек памяти.

Это позволяет закодировать 216=65536 различных

символов.

Подобная

двухбайтовая

(16-битная)

кодировка

получила название Unicode (Юникод)

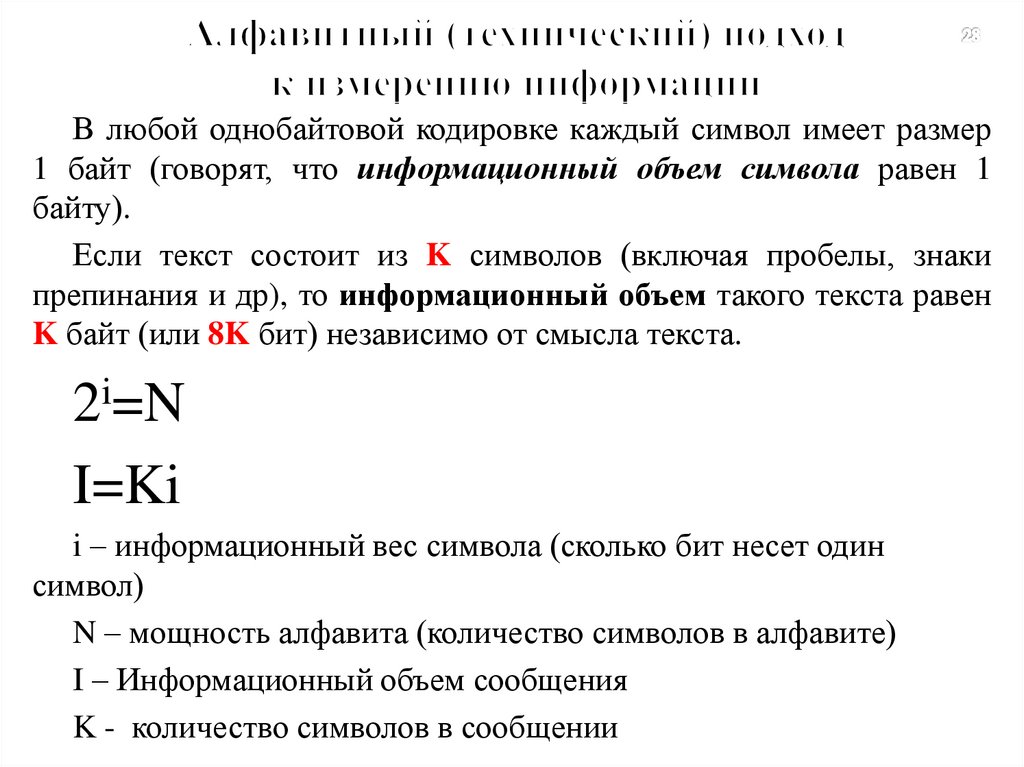

28. Алфавитный (технический) подход к измерению информации

В любой однобайтовой кодировке каждый символ имеет размер1 байт (говорят, что информационный объем символа равен 1

байту).

Если текст состоит из K символов (включая пробелы, знаки

препинания и др), то информационный объем такого текста равен

K байт (или 8K бит) независимо от смысла текста.

2i=N

I=Ki

i – информационный вес символа (сколько бит несет один

символ)

N – мощность алфавита (количество символов в алфавите)

I – Информационный объем сообщения

K - количество символов в сообщении

29.

Бит — слишком мелкая единица измерения. Напрактике чаще применяется более крупная единица

— байт, равная восьми битам. Именно восемь

битов требуется для того, чтобы закодировать

любой из 256 символов алфавита клавиатуры

компьютера (256=28).

Широко используются также ещё более крупные

производные единицы информации:

• 1 Килобайт (Кбайт) = 1024 байт = 210 байт,

• 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт,

• 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт.

30.

В последнее время в связи с увеличениемобъёмов обрабатываемой информации входят в

употребление такие производные единицы, как:

• 1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт,

• 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт.

За единицу информации можно было бы выбрать

количество

информации,

необходимое

для

различения, например, десяти равновероятных

сообщений. Это будет не двоичная (бит), а

десятичная (дит) единица информации.

31. Что понимают под информатизацией общества?

Информатизация общества — организованныйсоциально-экономический и научно-технический

процесс создания оптимальных условий для

удовлетворения информационных потребностей и

реализации прав граждан, органов государственной

власти,

органов

местного

самоуправления

организаций, общественных объединений на основе

формирования и использования информационных

ресурсов.

32.

Цель информатизации — улучшение качестважизни

людей

за

счет

увеличения

производительности и облегчения условий их

труда.

Информатизация — это сложный социальный

процесс, связанный со значительными изменениями

в образе жизни населения. Он требует серьёзных

усилий на многих направлениях, включая

ликвидацию

компьютерной

неграмотности,

формирование культуры использования новых

информационных технологий и др.

33.

Системы счисленияСистемой счисления называется способ представления

числа

символами

некоторого

алфавита,

которые

называются цифрами.

Все системы счисления делятся на две большие группы:

позиционные и непозиционные. Позиционные системы

характеризуются определенным алфавитом цифр и

основанием.

В позиционных системах счисления величина,

обозначаемая цифрой, зависит от позиции цифры в числе.

257, 35, 7024.

В непозиционных системах счисления значение цифры

не зависит от ее положения в числе.

Например, ХХХ (30) цифра Х встречается три раза и

обозначает одну и ту же цифру 10, три раза по 10 в сумме

дают 30.

34.

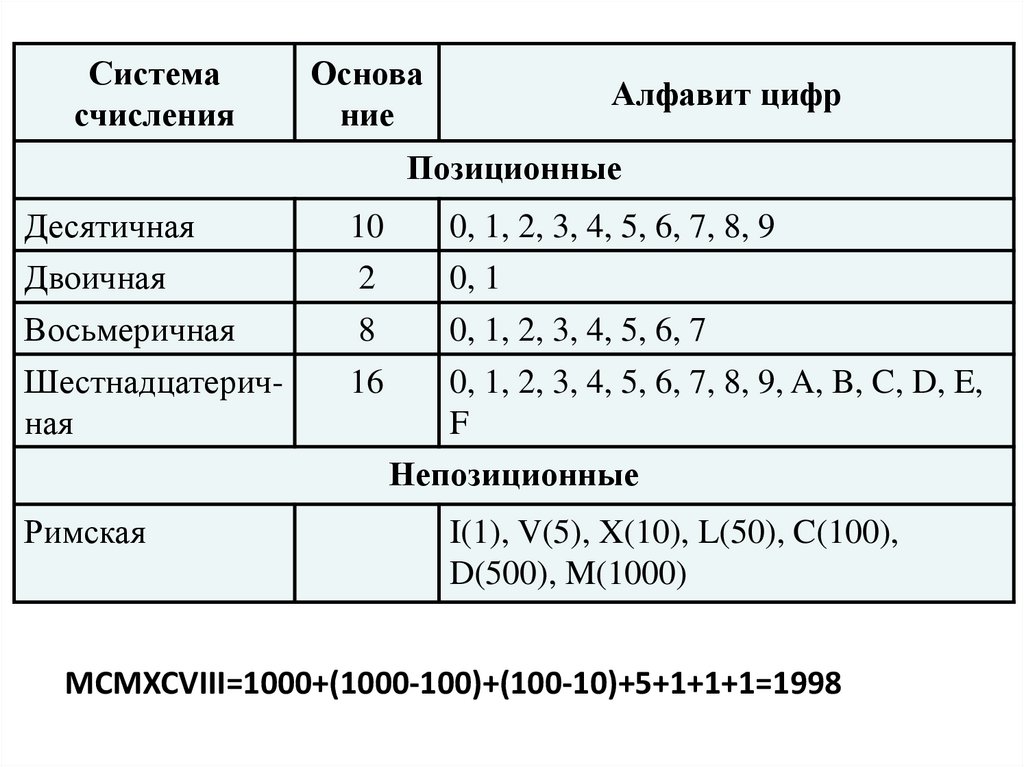

Системасчисления

Основа

ние

Алфавит цифр

Позиционные

Десятичная

10

0, 1, 2, 3, 4, 5, 6, 7, 8, 9

Двоичная

2

0, 1

Восьмеричная

8

0, 1, 2, 3, 4, 5, 6, 7

Шестнадцатеричная

16

Римская

0, 1, 2, 3, 4, 5, 6, 7, 8, 9, A, B, C, D, E,

F

Непозиционные

I(1), V(5), X(10), L(50), C(100),

D(500), M(1000)

MCMXCVIII=1000+(1000-100)+(100-10)+5+1+1+1=1998

35.

Перевод чисел из десятичной системысчисления в двоичную.

1.Десятичное число делится нацело на 2, пока это

возможно.

2. На каждом шаге записывается остаток от деления.

3. Снизу вверх записываем цифры, начиная с

последнего частного и все остатки от деления.

36.

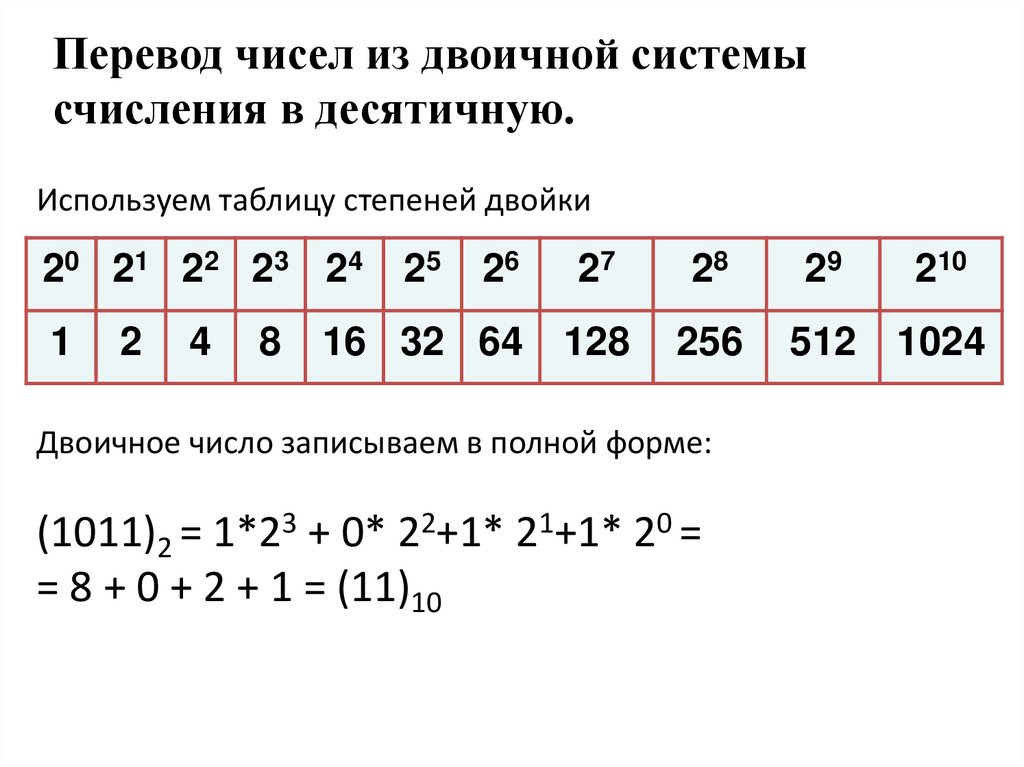

Перевод чисел из двоичной системысчисления в десятичную.

Используем таблицу степеней двойки

20 21 22 23 2 4

1

2

4

8

25

26

27

28

29

16 32 64

128

256

512 1024

Двоичное число записываем в полной форме:

(1011)2 = 1*23 + 0* 22+1* 21+1* 20 =

= 8 + 0 + 2 + 1 = (11)10

210

Информатика

Информатика