Похожие презентации:

Классификация изображений

1. Доклад по результатам работы над алгоритмом классификации изображений

Этап 1. Обзор методовклассификации

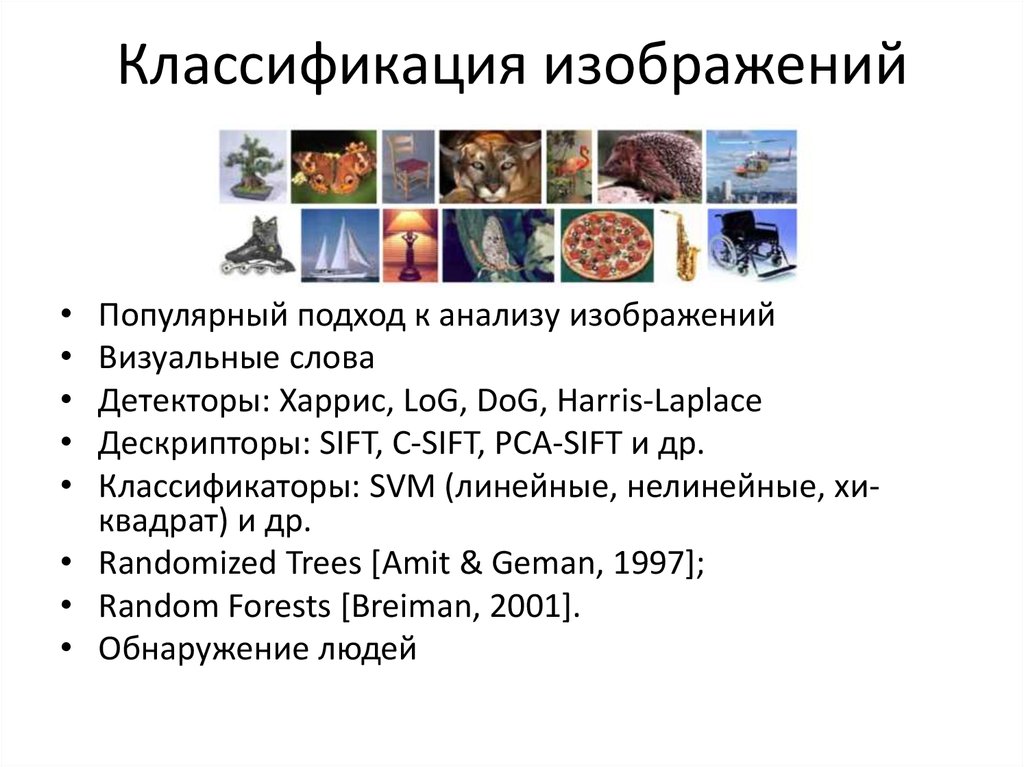

2. Классификация изображений

Популярный подход к анализу изображений

Визуальные слова

Детекторы: Харрис, LoG, DoG, Harris-Laplace

Дескрипторы: SIFT, C-SIFT, PCA-SIFT и др.

Классификаторы: SVM (линейные, нелинейные, хиквадрат) и др.

• Randomized Trees [Amit & Geman, 1997];

• Random Forests [Breiman, 2001].

• Обнаружение людей

3.

4.

5.

6.

7.

8.

9.

10.

11. Детекторы признаков

Эллиптический детектор признаков

Hessian-Affine detector

Maximally stable regions (MSER)

Регионы внимания

12. Инвариантные детекторы

• Characteristic scales (size of region)– Lindeberg and Garding ECCV 1994

– Lowe ICCV 1999

– Mikolajczyk and Schmid ICCV 2001

• Affine covariance (shape of region)

– Baumberg CVPR 2000

– Matas et al BMVC 2002 Maximally

stable regions

– Mikolajczyk and Schmid ECCV 2002

– Schaffalitzky and Zisserman ECCV

2002

– Tuytelaars and Van Gool BMVC 2000

– Mikolajczyk et al., IJCV 2005

• Нормализация формы и поворота

13. Инвариантные детекторы

14.

15. Дескрипторы признаков

SIFT (распределение градиентов в патче)

SURF

HOG – Histogram of Gradients

FERNS

BRIEF [ECCV’10]

STIP (Spatial-Temporal)

Mikolajczyk and Schmid CVPR 2003 сравнений дескрипторов

16.

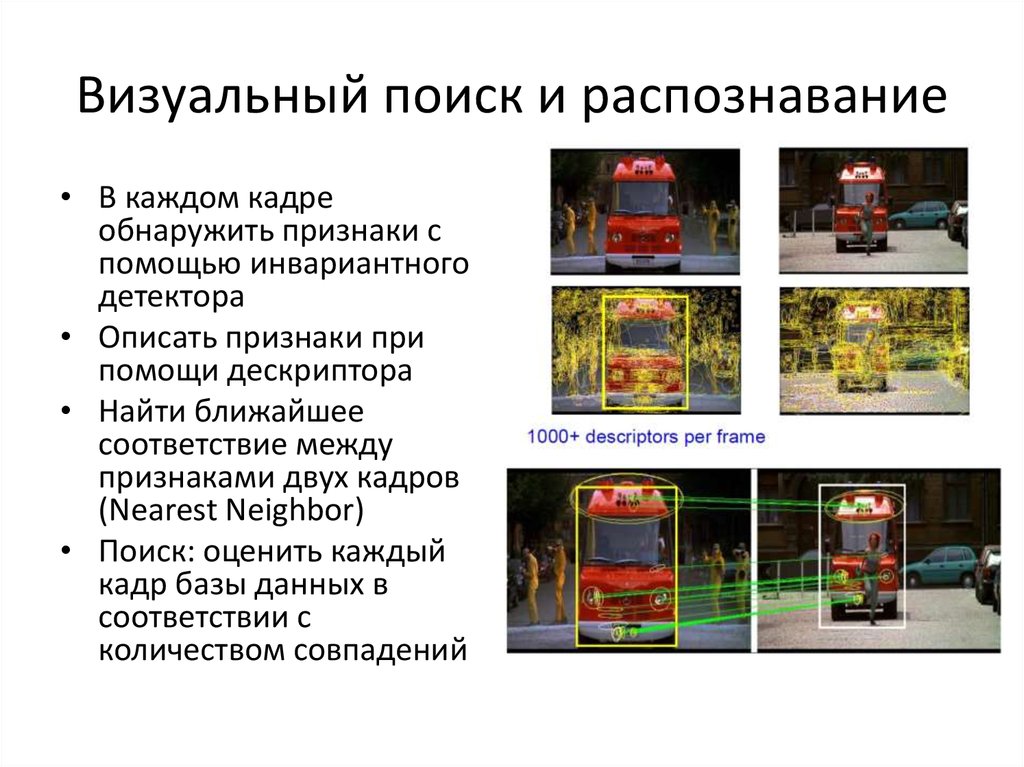

17. Визуальный поиск и распознавание

• В каждом кадреобнаружить признаки с

помощью инвариантного

детектора

• Описать признаки при

помощи дескриптора

• Найти ближайшее

соответствие между

признаками двух кадров

(Nearest Neighbor)

• Поиск: оценить каждый

кадр базы данных в

соответствии с

количеством совпадений

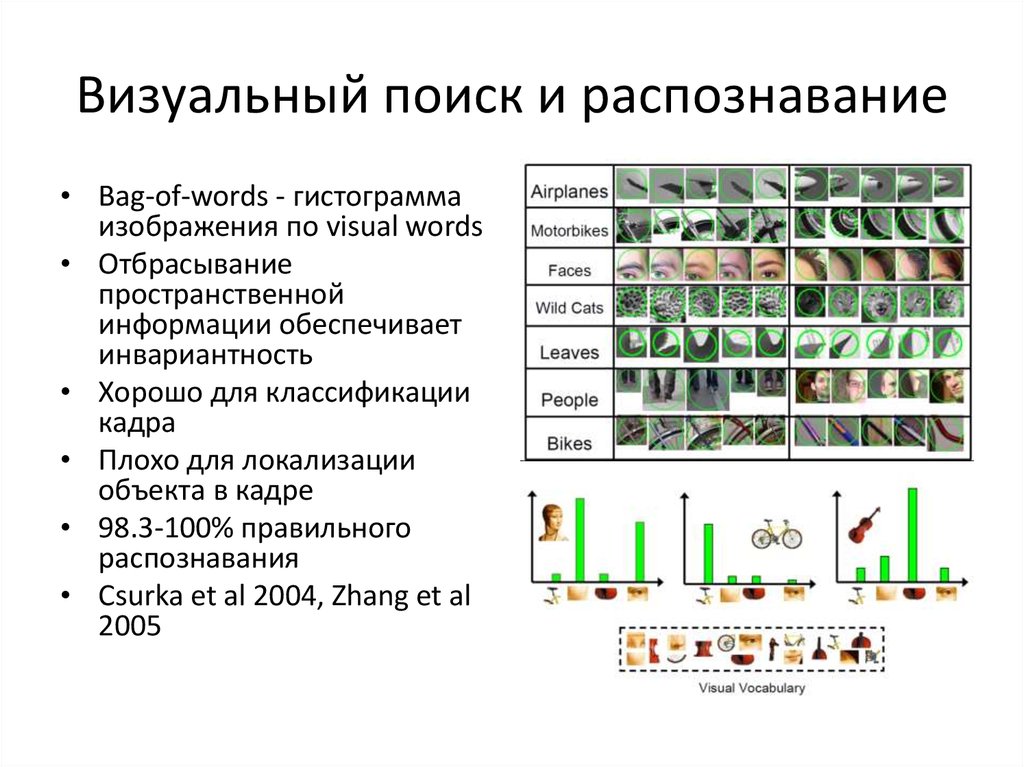

18. Визуальный поиск и распознавание

• Bag-of-words - гистограммаизображения по visual words

• Отбрасывание

пространственной

информации обеспечивает

инвариантность

• Хорошо для классификации

кадра

• Плохо для локализации

объекта в кадре

• 98.3-100% правильного

распознавания

• Csurka et al 2004, Zhang et al

2005

19. Плотные визуальные слова

20. Визуальный поиск и распознавание

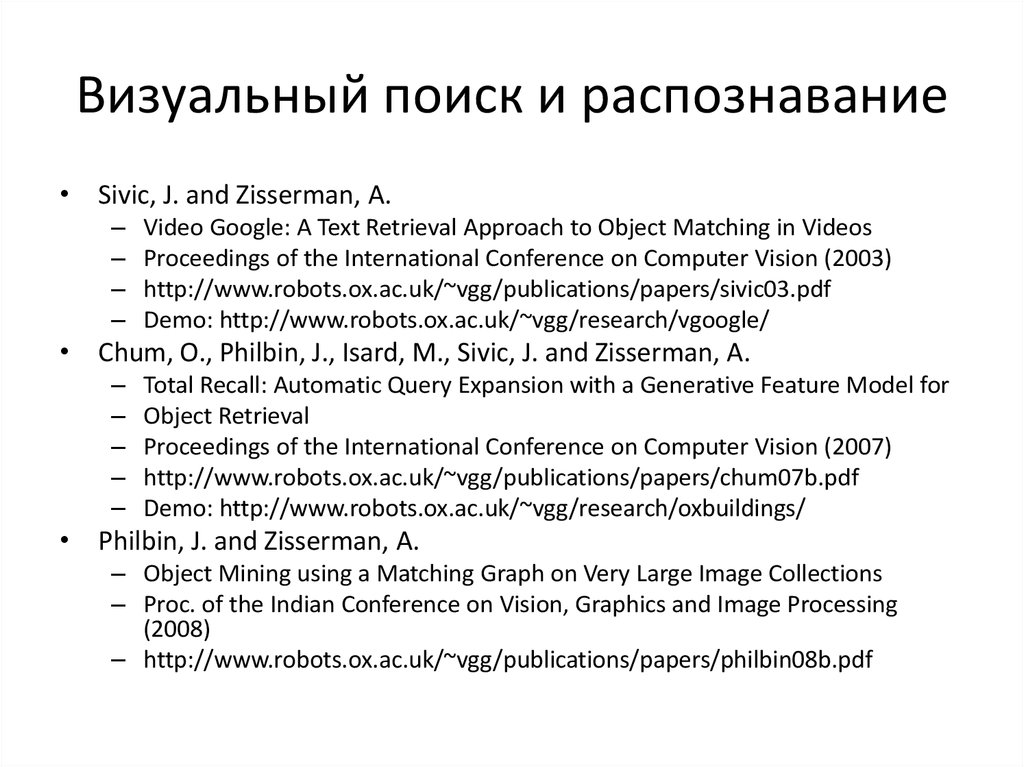

• Sivic, J. and Zisserman, A.–

–

–

–

Video Google: A Text Retrieval Approach to Object Matching in Videos

Proceedings of the International Conference on Computer Vision (2003)

http://www.robots.ox.ac.uk/~vgg/publications/papers/sivic03.pdf

Demo: http://www.robots.ox.ac.uk/~vgg/research/vgoogle/

• Chum, O., Philbin, J., Isard, M., Sivic, J. and Zisserman, A.

–

–

–

–

–

Total Recall: Automatic Query Expansion with a Generative Feature Model for

Object Retrieval

Proceedings of the International Conference on Computer Vision (2007)

http://www.robots.ox.ac.uk/~vgg/publications/papers/chum07b.pdf

Demo: http://www.robots.ox.ac.uk/~vgg/research/oxbuildings/

• Philbin, J. and Zisserman, A.

– Object Mining using a Matching Graph on Very Large Image Collections

– Proc. of the Indian Conference on Vision, Graphics and Image Processing

(2008)

– http://www.robots.ox.ac.uk/~vgg/publications/papers/philbin08b.pdf

21. FERNS

Альтернативный подход: очень

быстрый и в меру точный

классификатор

Бинарный тест, эффективно делящий

классы

Использовать несколько деревьев по

случайным сабсетам исходного

тренировочного набора

Ссылки:

– Jamie Shotton, Andrew FItzgibbon, Mat

Cook, Toby Sharp, Mark Finocchio, Richard

Moore, Alex Kipman, Andrew Blake. Realtime Human Pose Recognition in Parts from

Single Depth Images, CVPR'11

– Gall et Lempitsky, Scalable Multi-class Object

Detection, CVPR'11

– Vincent Lepetit. Random FERNS: a simplified

tree-like classifier

– Vincent Lepetit. Real-Time Computer Vision,

Microsoft Computer Vision School’11

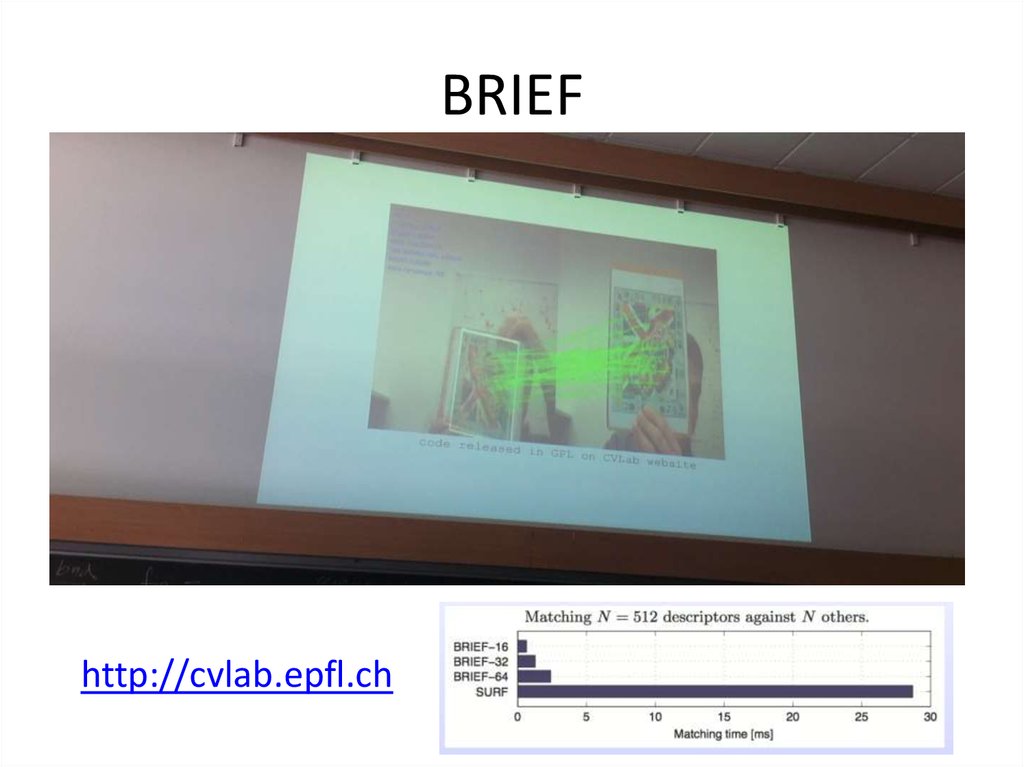

22. BRIEF

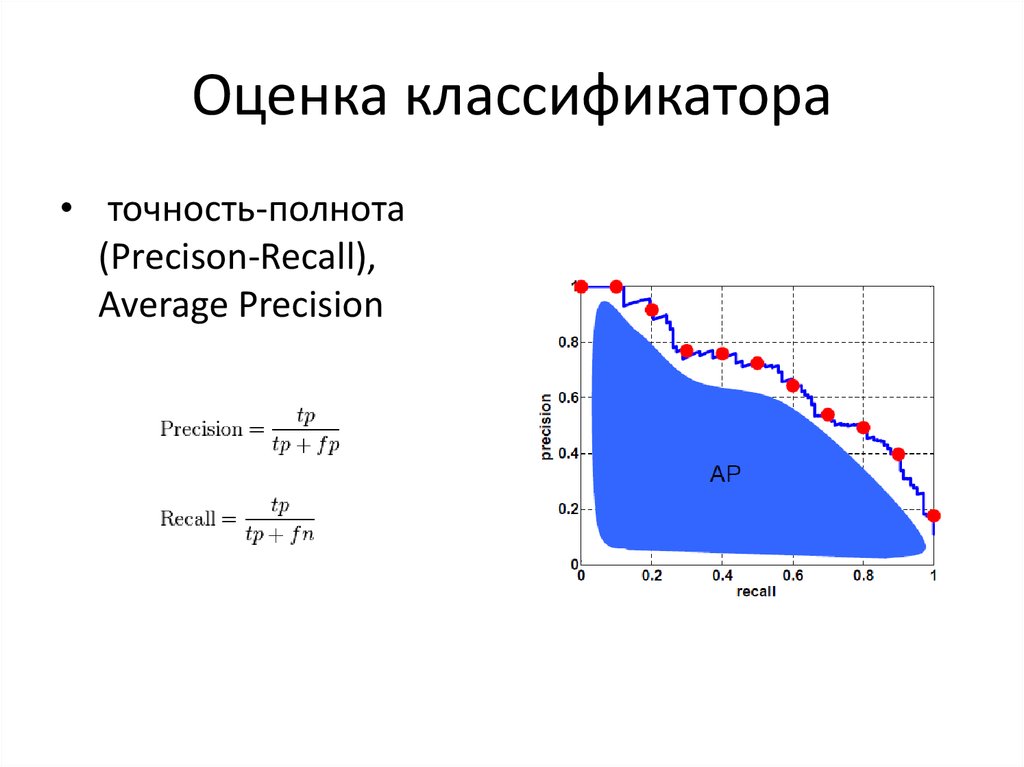

http://cvlab.epfl.ch23. Оценка классификатора

• точность-полнота(Precison-Recall),

Average Precision

24. Дескрипторы

NumberFeature name

15 classes

SUN(397)

GENKI Face

INRIA Horse

Caltech Face

IRI Freestyle Motocross

UIUC car

Dataset

Dataset

Dataset

Dataset

dataset

OT(8)

3 classes

Caltech 101

1

Dense SIFT

81.2

21.5

-

-

-

-

-

-

-

-

2

HOG2x2

81.0

27.2

-

-

-

-

-

-

-

-

3

Texton Histogram

77.8

17.6

-

-

-

-

-

-

-

-

4

SSIM

77.2

22.5

-

-

-

-

-

-

-

-

5

GIST

74.7

16.3

-

-

-

-

-

-

-

-

6

Sparse SIFT Histograms

56.6

11.5

-

-

-

-

-

-

-

-

7

Geometric Classification

55.0

6.0

-

-

-

-

-

-

-

-

8

Straight Line Histograms

50.9

5.7

-

-

-

-

-

-

-

-

9

Geometry Texton

-

23.5

-

-

-

-

-

-

-

-

Map

Histograms

10

LBP

-

18.0

-

-

-

-

-

-

-

-

11

LBPHF

-

12.8

-

-

-

-

-

-

-

-

12

Geometry Color

-

9.1

-

-

-

-

-

-

-

-

13

Color Histograms

-

8.2

-

-

-

-

-

-

-

-

Histograms

14

Tiny Image

-

5.5

-

-

-

-

-

-

-

-

15

All Features(1-14)

88.1

38.0

-

-

-

-

-

-

-

-

16

BB Random FERNS

-

-

83.2

77.0

99.6

89.1

97.9

-

-

-

17

Color SIFT + pLSA model

-

-

-

-

-

-

-

87.1

-

-

18

SURF

-

-

-

-

-

-

-

-

86.19

-

19

PHOG + PHOW

-

-

-

-

-

-

-

-

-

81.3

25. Классификаторы

SVMKNN

M-SVM

Random Forest

Random Ferns

Decisio

ANN

n Tree

Naïve Bayesian

Rule-

classifier

learner

15 classes

72.6

71.0

-

-

-

-

-

-

-

SUN(397)

38.0

13.0

-

-

-

-

-

-

-

Caltech-101

-

-

81.3

80.0

79.2

-

-

-

-

Caltech-256

-

-

-

45.3

44.0

-

-

-

-

OT(8)

87.1

86.6

-

-

-

-

-

-

-

Open vs. Close

-

-

-

-

-

-

-

94%

-

Natural vs. Artificial

-

-

-

-

-

-

-

94%

-

Accuracy in general

****

**

-

-

-

**

***

*

**

Speed of learning with

*

****

-

-

-

***

*

****

**

Speed of classification

****

*

-

-

-

****

****

****

****

Tolerance to missing values

**

*

-

-

-

***

*

****

**

Tolerance to irrelevant

****

**

-

-

-

***

*

**

**

***

**

-

-

-

**

**

*

**

***

*

-

-

-

**

***

*

**

**(not discrete)

***(not directly discrete)

-

-

-

****

***(not

***(not

***( not

discrete)

continuous)

respect to number of

attributes and the number of

instances

attributes

Tolerance to redundant

attributes

Tolerance to highly

interdependent attributes (e.g.

parity problems)

Dealing with

discrete/binary/continuous

directly

continuous)

attributes

Tolerance to noise

**

*

-

-

-

**

**

***

*

Dealing with danger of

**

***

-

-

-

**

*

***

*

**

****

-

-

-

**

***

****

*

*

**

-

-

-

****

*

****

****

*

***

-

-

-

***

*

****

***

overfitting

Attempts for incremental

learning

Explanation

ability/transparency of

knowledge/classifications

Model parameter handling

26. Методы классификации

Methods1

Features

Gabor filters

Vocabular

Additional

Classifie

y

Features

r

Textons

using spatial

Vocabular

information

Databases

In vs.

Natural

13

15

Caltech

Caltech

Open

caltech

xerox

Out

vs.

classe

classes

-101

-256

vs.

6

7

Arti cial

s

graz

pascal

4

-01

classe

Closed

s

SVM

94.5

97.48

84

79.43

-

-

-

-

-

-

-

-

-

-

85.9

83.7

-

-

-

-

-

-

-

-

-

-

-

-

80

45.3

-

-

-

-

-

-

y

2

Dense SIFT

Visual

words

SVM or

or

Vocabular

histogram +

KNN

image patches

y

using pLSA

model with

discriminativ

e learning

3

PHOW and

Visual

using ROI

Random

PHOG

Vocabular

Ferns

y

or

Random

Forest

4

SIFT, SPIN and

Signature

RIFT

or

-

SVM

-

-

-

-

53.9

-

-

97.93

94.7

93.1

93.6

-

-

Bayesian

-

94

-

-

-

-

94

-

-

-

-

89.25

Visual

Vocabular

y

5

Power

Spectrum

-

classi er

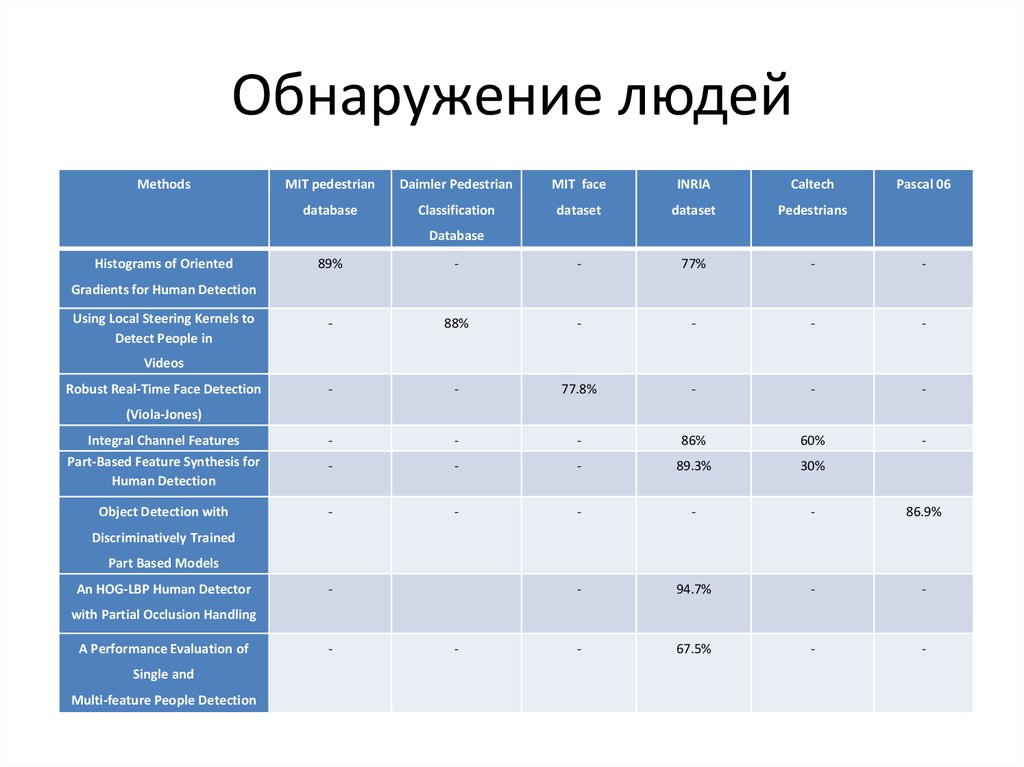

27. Обнаружение людей

• HOG: Histogram ofOriented Gradients +

SVM

• Методы, основанные

на контурах, устарели

• Dalal & Triggs CVPR

2005 Pedestrian

detection

• Работает со многими

другими категориями

28. Обнаружение людей

• Полный поиск скользящим окном – слишком долго• Каскадная классификация: начинать с более простых

классификаторов

29. Обнаружение людей

MethodsMIT pedestrian

Daimler Pedestrian

MIT face

INRIA

Caltech

database

Classification

dataset

dataset

Pedestrians

Pascal 06

Database

Histograms of Oriented

89%

-

-

77%

-

-

-

88%

-

-

-

-

-

-

77.8%

-

-

-

Integral Channel Features

Part-Based Feature Synthesis for

Human Detection

-

-

-

86%

60%

-

-

-

-

89.3%

30%

Object Detection with

-

-

-

-

-

86.9%

-

94.7%

-

-

-

67.5%

-

-

Gradients for Human Detection

Using Local Steering Kernels to

Detect People in

Videos

Robust Real-Time Face Detection

(Viola-Jones)

Discriminatively Trained

Part Based Models

An HOG-LBP Human Detector

-

with Partial Occlusion Handling

A Performance Evaluation of

Single and

Multi-feature People Detection

-

-

30. PASCAL Visual Object Classes (VOC) Challenge

31. PASCAL Challenge

32. Распознавание действий

• STIP – Spatial-TemporalInteresting Points

• Распознавание

различных действий в

видеопоследовательностях

• Ходьба, ползание,

прыжки, курение, еда,

вождение автомобиля

и т.п.

33. Распознавание действий

• Оптический поток – основнойисточник информации о

движении в сцене, один из

базовых инструментов для

компьютерного зрения

• Для распознавания видео мы

можем использовать те же

подходы, что и к изображению,

но переведя их в трёхмерные

пространственно-временной

объём

– Скользящее окно

– Особенности, детекторы и

дескрипторы

– Мешок слов и методы

классификации

34. Распознавание действий

• Базы: Hollywood2, UCF Sports Actions, KTH Actions• Alexei A. Efros, Alexander C. Berg, Greg Mori and Jitendra Malik.

Recognizing Action at a Distance. ICCV 2003

• I. Laptev and T. Lindeberg; "Space-Time Interest Points”,

ICCV’2003

• Ivan Laptev’s code

http://www.irisa.fr/vista/Equipe/People/Laptev/download.html#sti

p

• Piotr's Image & Video Toolbox for Matlab

http://vision.ucsd.edu/~pdollar/toolbox/doc/index.html

• Много полезных функций (k-means, meanshift, PCA, ferns,

RBF, DOG-фильтры и т.д.)

Hessian executables:

http://homes.esat.kuleuven.be/~gwillems/research/Hes-STIP

35. Тестовые базы

Zurich building image database

–

–

Caltech 101, 256

–

–

http://labelme.csail.mit.edu/index.html

Amazon Mechanical Turk (торговая площадка для классификации)

Oxford buildings dataset

Flicr, Bing, Google, Yandex

Middlebury stereo page

–

http://www.image-net.org

~1.2 млн. классифицированных изображений, половина размечена рамками

LabelMe

–

30К+ изображений, 1.3GB

http://www.vision.caltech.edu/Image_Datasets/Caltech101/

ImageNet

–

–

0.5GB

http://www.vision.ee.ethz.ch/showroom/zubud/index.en.html

http://vision.middlebury.edu/stereo/

MRF Minimization

–

http://vision.middlebury.edu/MRF/

Multi-view stereo

Optical flow

–

–

https://netfiles.uiuc.edu/jbhuang1/www/resources/vision/index.html

The Automatic Labeling Environment

–

http://www.alphamatting.com/

Списки наработок (Computer Vision Resources по разделам)

–

http://vision.middlebury.edu/flow/

Матирование изображений

–

http://vision.middlebury.edu/mview/

http://cms.brookes.ac.uk/staff/PhilipTorr/ale.htm

ГрафиКон

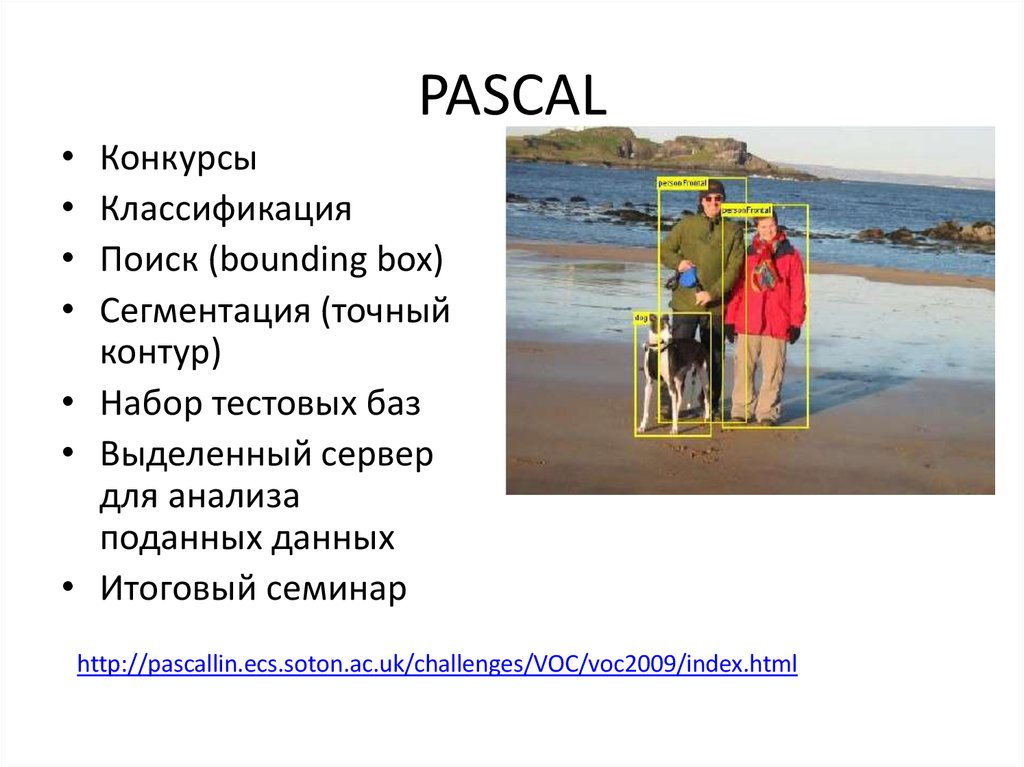

36. PASCAL

Конкурсы

Классификация

Поиск (bounding box)

Сегментация (точный

контур)

• Набор тестовых баз

• Выделенный сервер

для анализа

поданных данных

• Итоговый семинар

http://pascallin.ecs.soton.ac.uk/challenges/VOC/voc2009/index.html

37. PETS

• Performance evaluation of tracking and videosurveillance workshop

• Разные задачи

–

–

–

–

Слежение

Распознавание действий

Определение оставленных предметов

Набор видео для каждой задачи с нескольких

камер

• http://winterpets09.net/

38. 15 classes

39. INRIA

40. Программное обеспечение

• VLFeathttp://www.vlfeat.org/

• STAIR Vision Library

http://ai.stanford.edu/~sgould/svl/

• Infer.NET - фреймворк для решения задач машинного обучения,

оптимизации, чего-то байесовского и т.п., предназначен для

использования с .NET-языками

• OpenCV - динамично развивающаяся библиотека для компьютерного

зрения

• Matlab как основной инструмент лабораторных работ

• Maple - хороший решатель для небольших задач (до 10-й

размерности)

• LibSVM

• Pegasos: Primal Estimated sub-GrAdient SOlver for SVM

• Другие библиотеки – почти НИКТО не может всё сделать сам

41. Патентное исследование

• Наиболее эффективные методы, такие какSVM, SIFT, SURF, Viola-Jones – запатентованы

в США, в РФ эти методы пока могут

использоваться свободно

• Существуют модификации алгоритмов:

Viola-Jones без каскадов, PCA-SIFT, C-SIFT

Информатика

Информатика