Похожие презентации:

Кейс_1._Презентация

1. Кейс 1. Прогнозирование оттока клиентов банка

2. Содержание

3. Цели и задачи

4. Фичи

• Датасет состоит из 165034 и 14 столбцов, из которых:• 1 таргет (Exited)

• 3 неинформативные фичи (id, CustomerId, Surname)

• 2 бинарные фичи (HasCrCard, IsActiveMember)

• 6 числовых фич (CreditScore, Age, Tenure, Balance, EstimatedSalary,

NumOfProducts) 2 категориальные фичи (Geography, Gender)

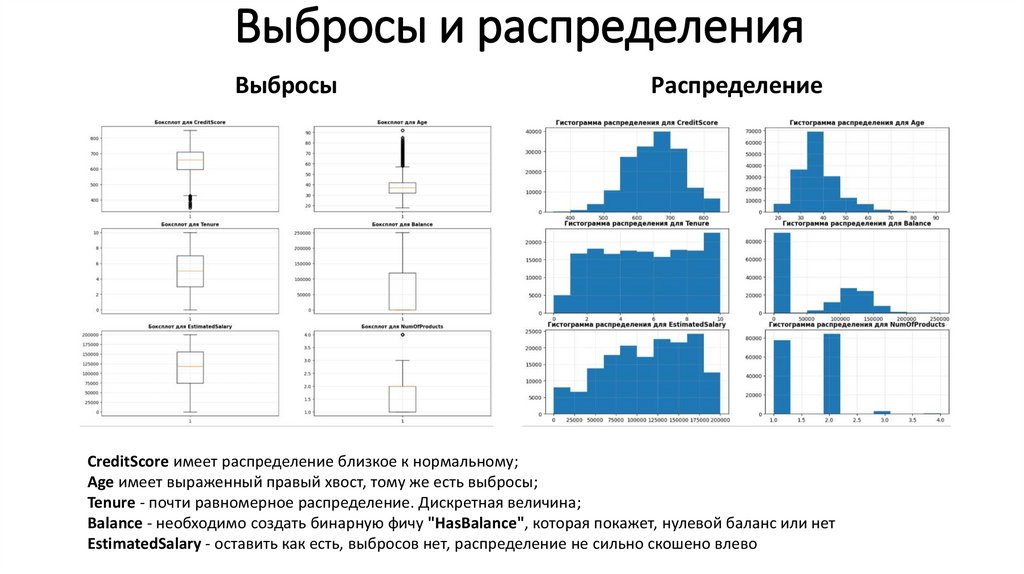

5. Выбросы и распределения

ВыбросыРаспределение

CreditScore имеет распределение близкое к нормальному;

Age имеет выраженный правый хвост, тому же есть выбросы;

Tenure - почти равномерное распределение. Дискретная величина;

Balance - необходимо создать бинарную фичу "HasBalance", которая покажет, нулевой баланс или нет

EstimatedSalary - оставить как есть, выбросов нет, распределение не сильно скошено влево

6. Мультиколлинеарность

• Ярко выраженныхкорреляций межу фичами

нет. Есть умеренная

корреляция между:

• Geography и Balance

• NumOfProducts и Balance

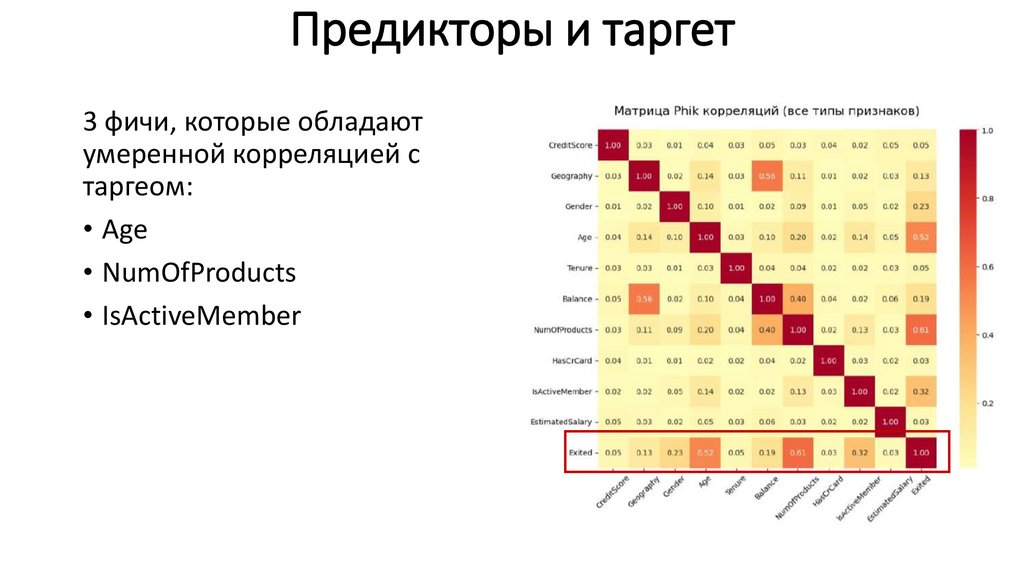

7. Предикторы и таргет

3 фичи, которые обладаютумеренной корреляцией с

таргеом:

• Age

• NumOfProducts

• IsActiveMember

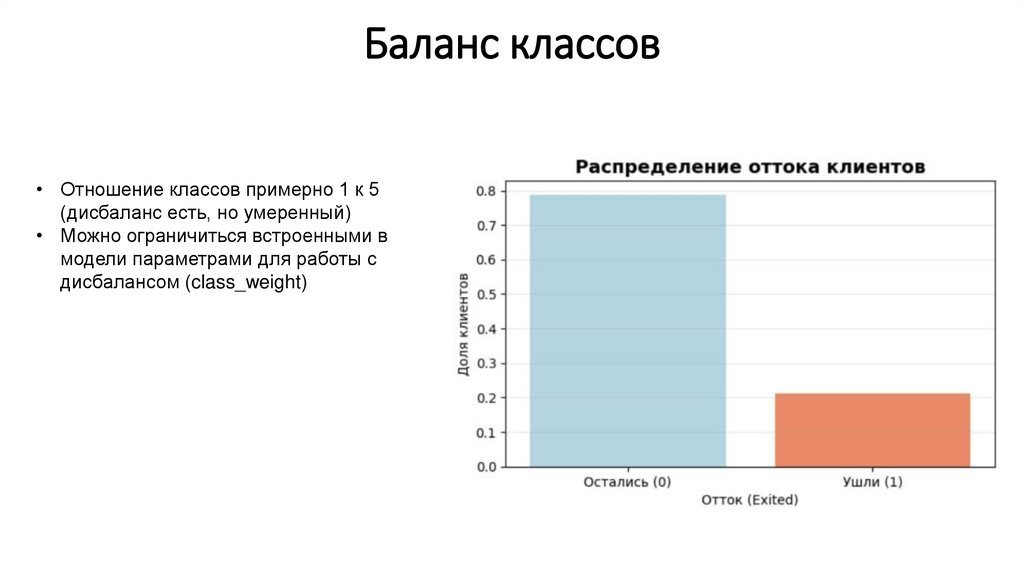

8. Баланс классов

• Отношение классов примерно 1 к 5(дисбаланс есть, но умеренный)

• Можно ограничиться встроенными в

модели параметрами для работы с

дисбалансом (class_weight)

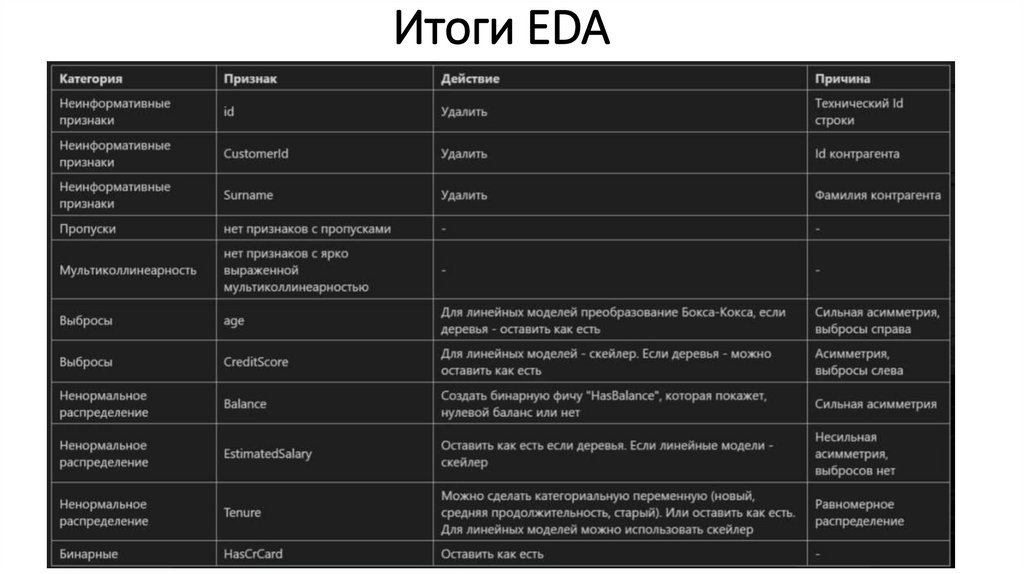

9. Итоги EDA

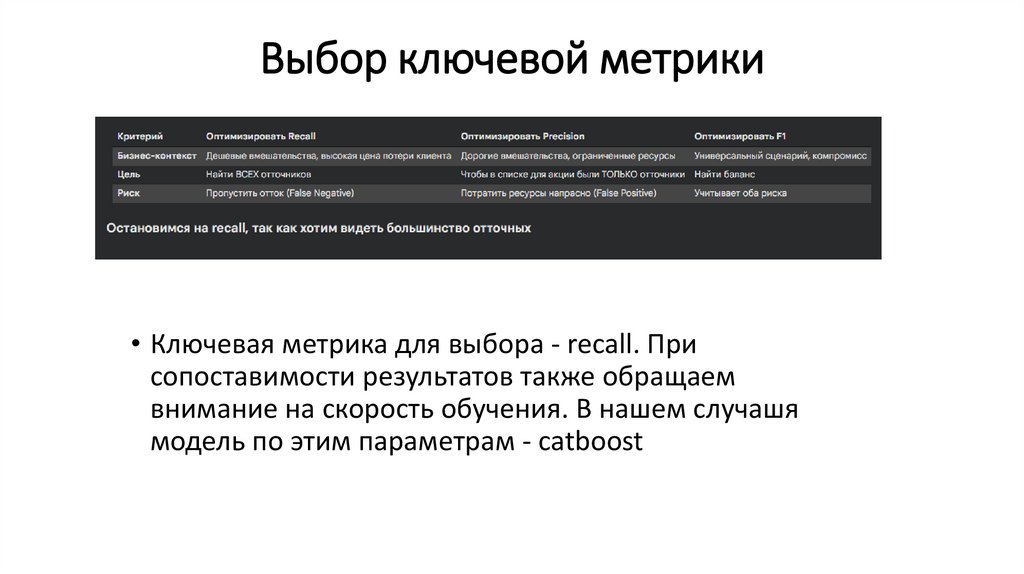

10. Выбор ключевой метрики

• Ключевая метрика для выбора - recall. Присопоставимости результатов также обращаем

внимание на скорость обучения. В нашем случашя

модель по этим параметрам - catboost

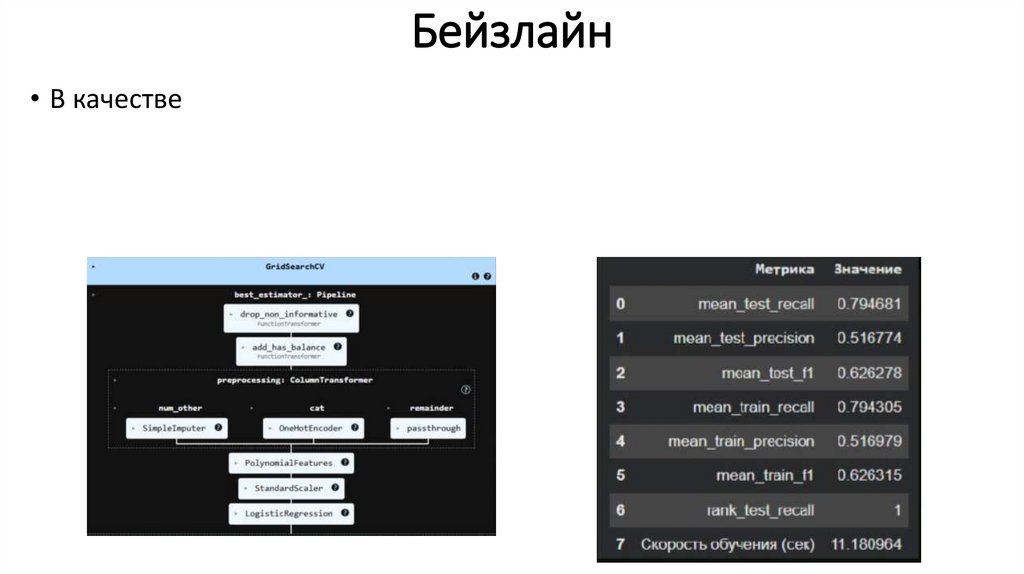

11. Бейзлайн

• В качестве12. Обучение моделей

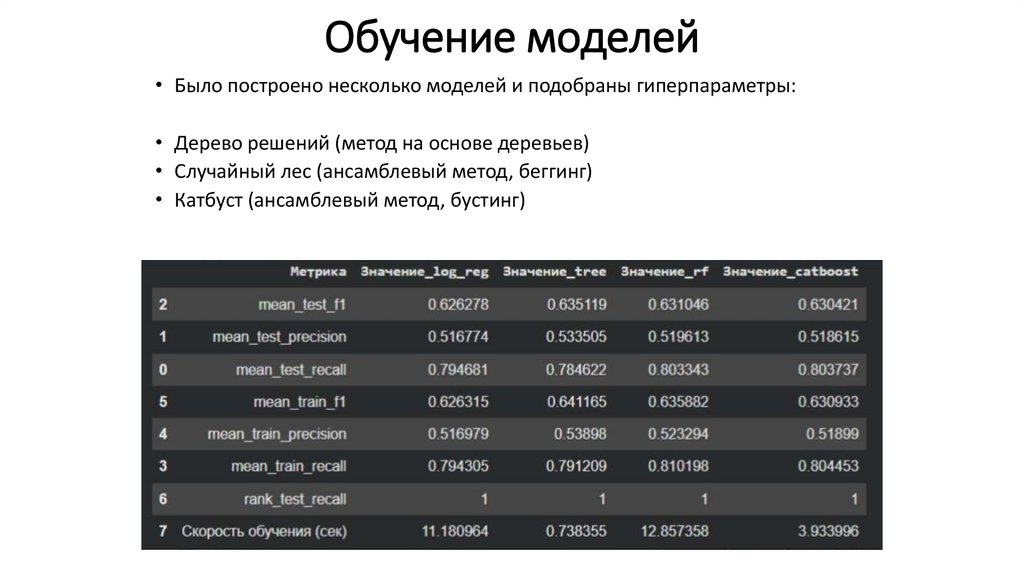

• Было построено несколько моделей и подобраны гиперпараметры:• Дерево решений (метод на основе деревьев)

• Случайный лес (ансамблевый метод, беггинг)

• Катбуст (ансамблевый метод, бустинг)

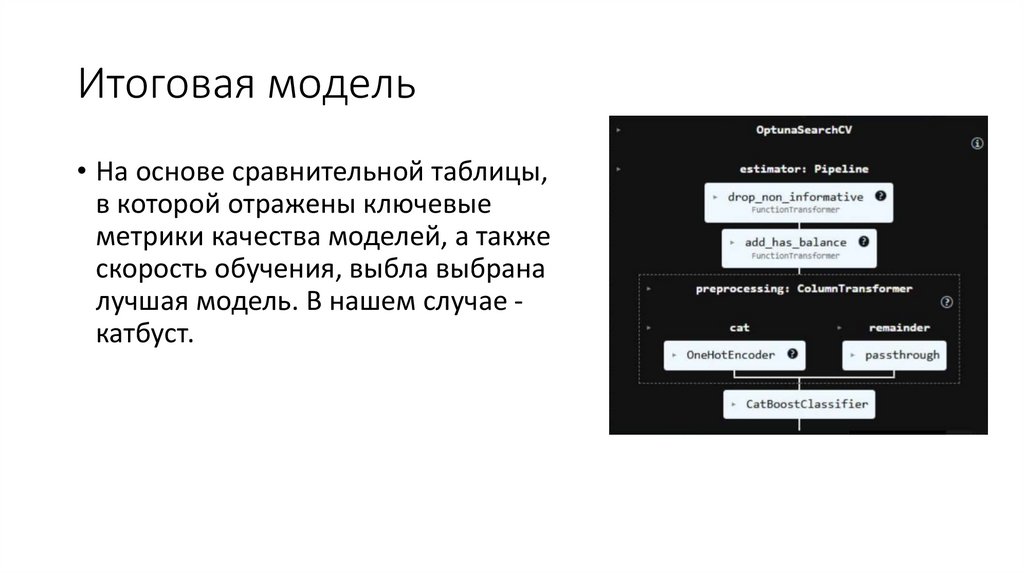

13. Итоговая модель

• На основе сравнительной таблицы,в которой отражены ключевые

метрики качества моделей, а также

скорость обучения, выбла выбрана

лучшая модель. В нашем случае катбуст.

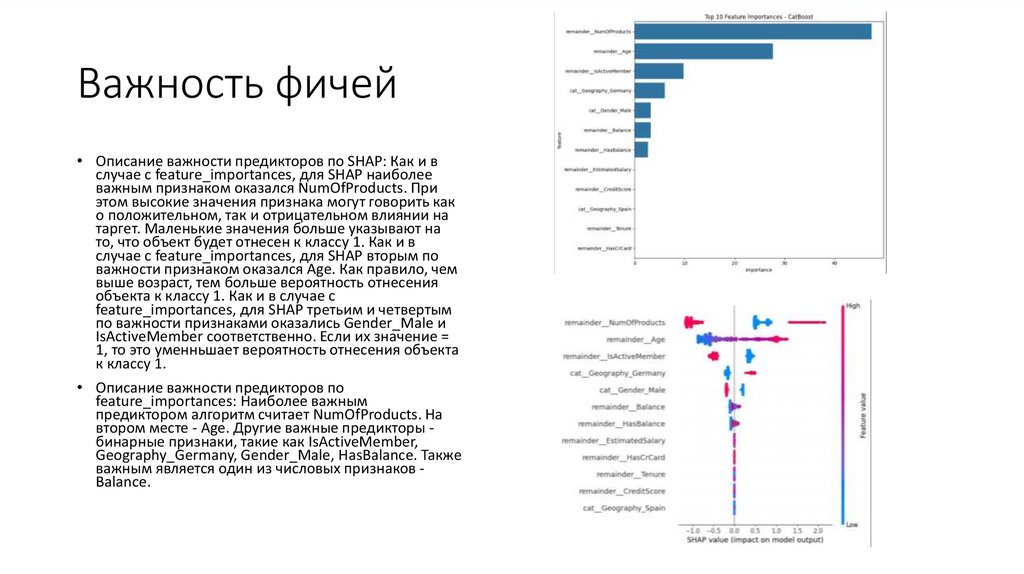

14. Важность фичей

• Описание важности предикторов по SHAP: Как и вслучае с feature_importances, для SHAP наиболее

важным признаком оказался NumOfProducts. При

этом высокие значения признака могут говорить как

о положительном, так и отрицательном влиянии на

таргет. Маленькие значения больше указывают на

то, что объект будет отнесен к классу 1. Как и в

случае с feature_importances, для SHAP вторым по

важности признаком оказался Age. Как правило, чем

выше возраст, тем больше вероятность отнесения

объекта к классу 1. Как и в случае с

feature_importances, для SHAP третьим и четвертым

по важности признаками оказались Gender_Male и

IsActiveMember соответственно. Если их значение =

1, то это уменньшает вероятность отнесения объекта

к классу 1.

• Описание важности предикторов по

feature_importances: Наиболее важным

предиктором алгоритм считает NumOfProducts. На

втором месте - Age. Другие важные предикторы бинарные признаки, такие как IsActiveMember,

Geography_Germany, Gender_Male, HasBalance. Также

важным является один из числовых признаков Balance.

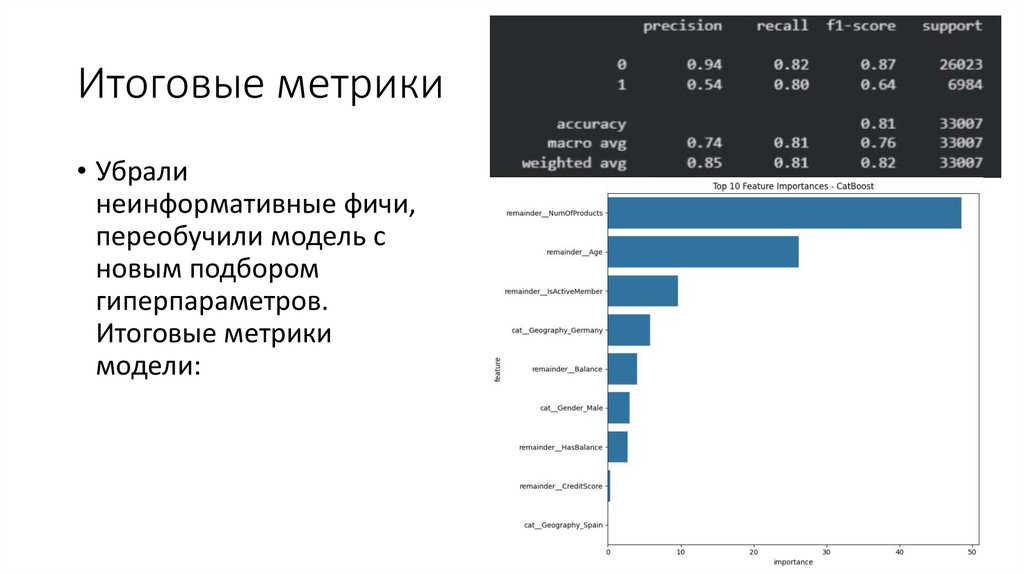

15. Итоговые метрики

• Убралинеинформативные фичи,

переобучили модель с

новым подбором

гиперпараметров.

Итоговые метрики

модели: