Похожие презентации:

Искусственные и нечеткие нейронные сети

1. Искусственные и нечеткие нейронные сети

2. ИНС

• Искус́ ственные нейро́нныесе́ти представляют собой математические

модели, а также их программные или

аппаратные реализации, построенные по

принципу организации и

функционирования биологических

нейронных сетей — сетей нервных клеток

живого организма.

3. Применение

аппроксимация функций на основе ряда данных;

распознавание образов;

кластеризация и классификация данных;

обучение в области статистической обработки

данных;

накопление знаний через обучение на примерах;

предсказание и прогноз;

оптимизация;

ассоциативная память;

нелинейное моделирование и управление.

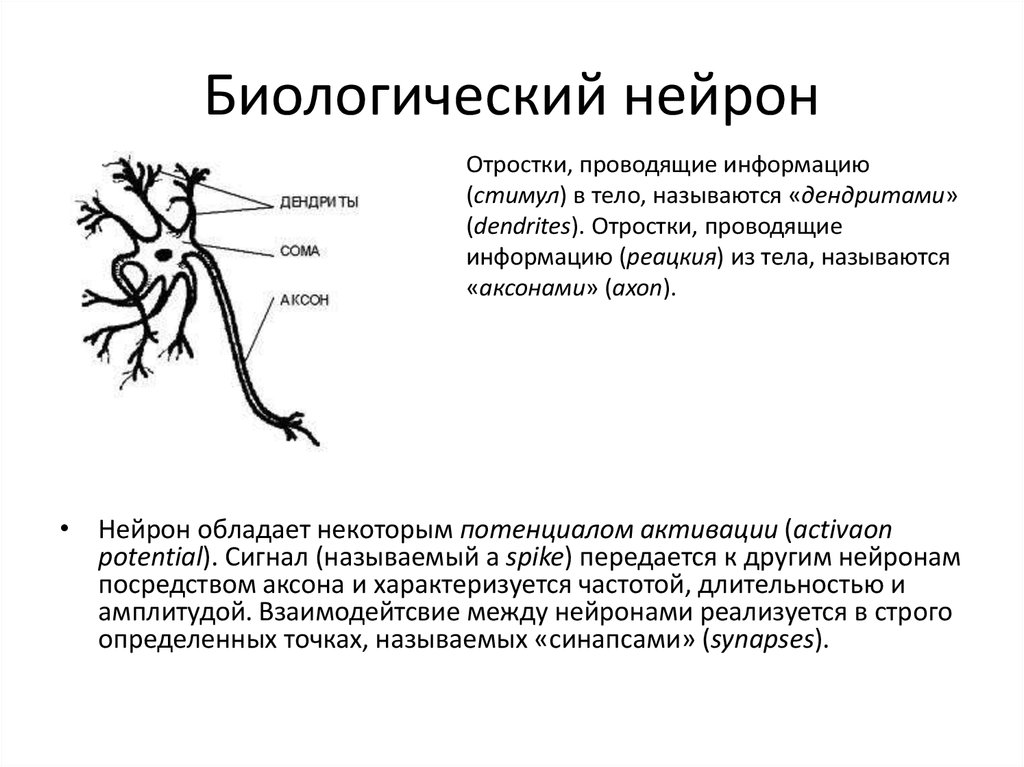

4. Биологический нейрон

Отростки, проводящие информацию(стимул) в тело, называются «дендритами»

(dendrites). Отростки, проводящие

информацию (реацкия) из тела, называются

«аксонами» (axon).

• Нейрон обладает некоторым потенциалом активации (activaon

potential). Сигнал (называемый a spike) передается к другим нейронам

посредством аксона и характеризуется частотой, длительностью и

амплитудой. Взаимодейтсвие между нейронами реализуется в строго

определенных точках, называемых «синапсами» (synapses).

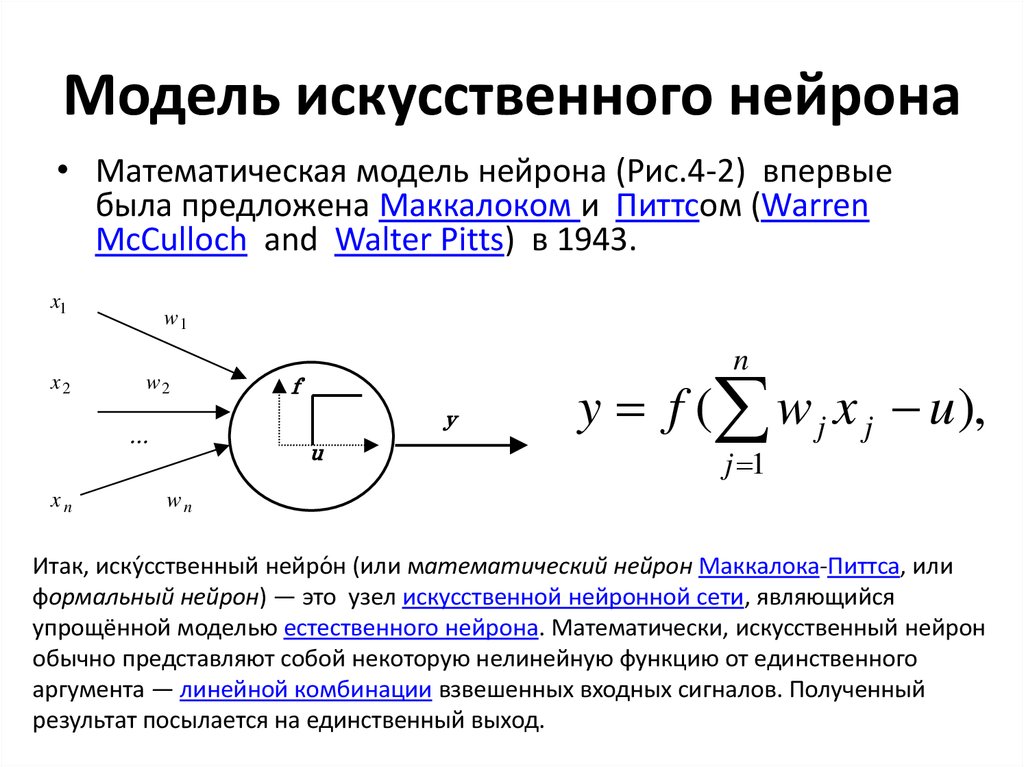

5. Модель искусственного нейрона

• Математическая модель нейрона (Рис.4-2) впервыебыла предложена Маккалоком и Питтсом (Warren

McCulloch and Walter Pitts) в 1943.

x1

x2

w1

w2

f

y

…

xn

n

u

y f ( w j x j u ),

j 1

wn

Итак, иску́сственный нейро́ н (или математический нейрон Маккалока-Питтса, или

формальный нейрон) — это узел искусственной нейронной сети, являющийся

упрощённой моделью естественного нейрона. Математически, искусственный нейрон

обычно представляют собой некоторую нелинейную функцию от единственного

аргумента — линейной комбинации взвешенных входных сигналов. Полученный

результат посылается на единственный выход.

6. От нейрона к системе нейронов

• ИНС может рассматриваться в видевзвешенного направленного графа (weighted

directed graph), вершины которого

представлены нейронами, а направленные

дуги (с весами) описывают связи между

нейронами. ИНС характеризуется тремя

параметрами:

– типом нейронов,

– архитектурой (организацией связей между

нейронами)

– алгоритмом обучения в данной сети.

7. Архитектура

• С учетом архитектуры ИНС могут бытьразделены на два базисных класса:

– сети с прямым распространением сигнала

(Feed-forward network), в структуре которых нет

петель (циклов) и

– сети с обратным распространением сигнала

или рекуррентные сети (Feedback network or

Recurrent), в структуре которых есть циклы

благодаря наличию обратных связей.

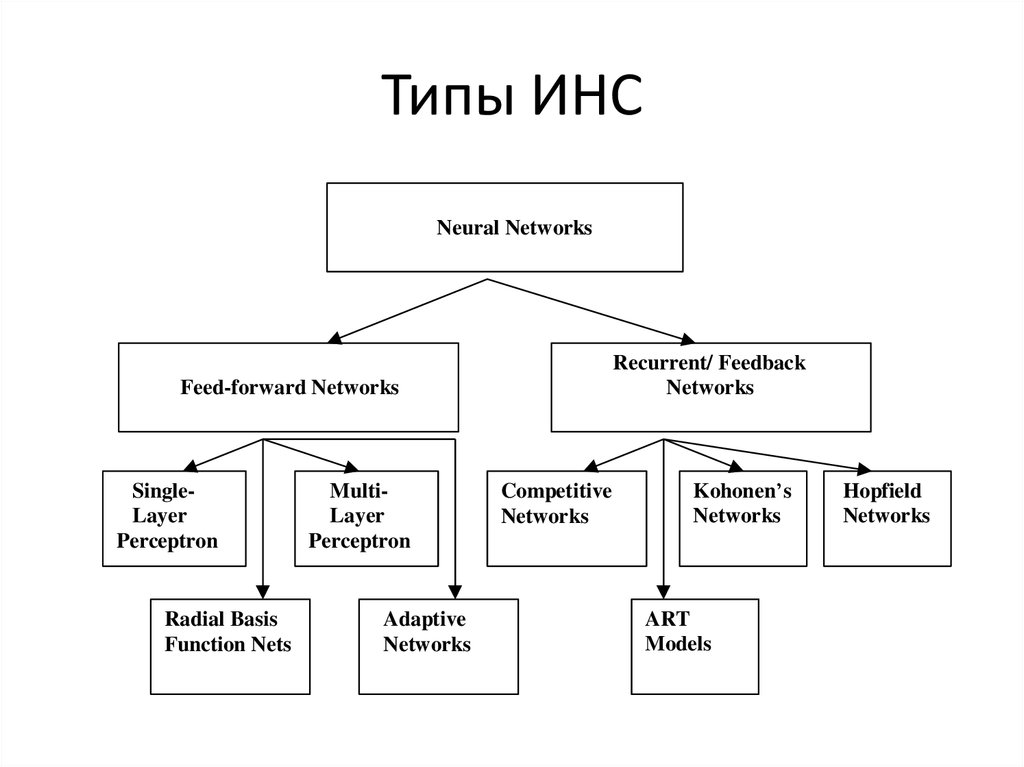

8. Типы ИНС

Neural NetworksRecurrent/ Feedback

Networks

Feed-forward Networks

SingleLayer

Perceptron

Radial Basis

Function Nets

MultiLayer

Perceptron

Adaptive

Networks

Competitive

Networks

Kohonen’s

Networks

ART

Models

Hopfield

Networks

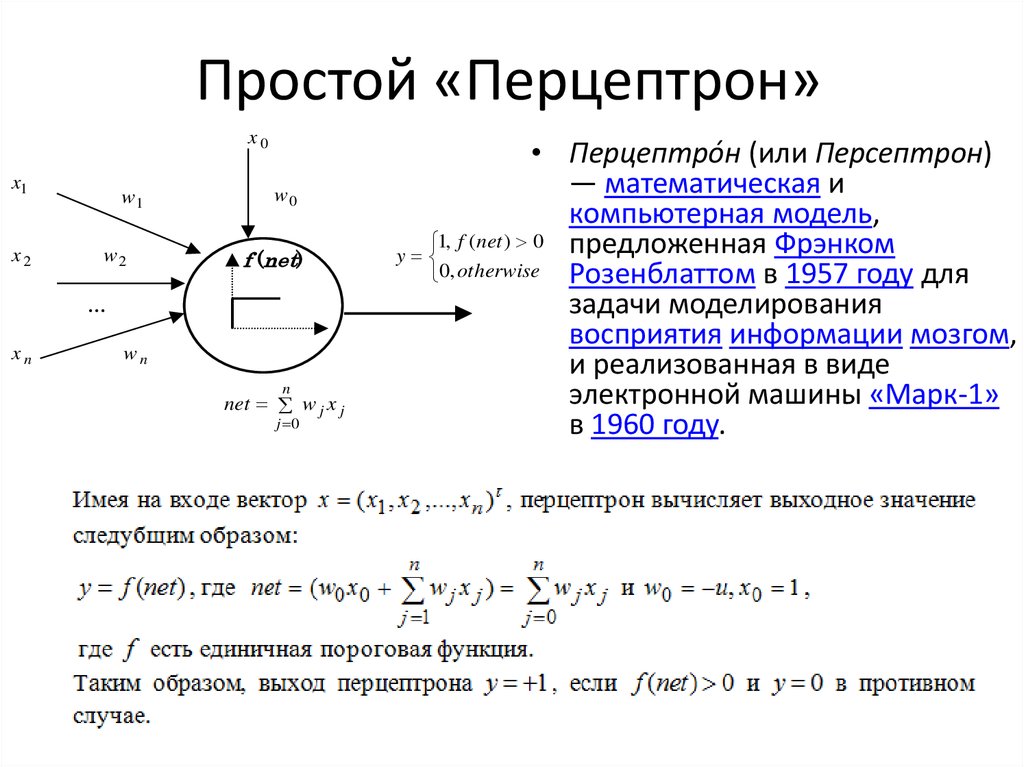

9. Простой «Перцептрон»

x0x1

x2

w1

w2

w0

f (net)

…

xn

wn

n

net w j x j

j 0

• Перцептро́н (или Персептрон)

— математическая и

компьютерная модель,

1, f ( net ) 0 предложенная Фрэнком

y

0, otherwise Розенблаттом в 1957 году для

задачи моделирования

восприятия информации мозгом,

и реализованная в виде

электронной машины «Марк-1»

в 1960 году.

10. Задача кластеризации

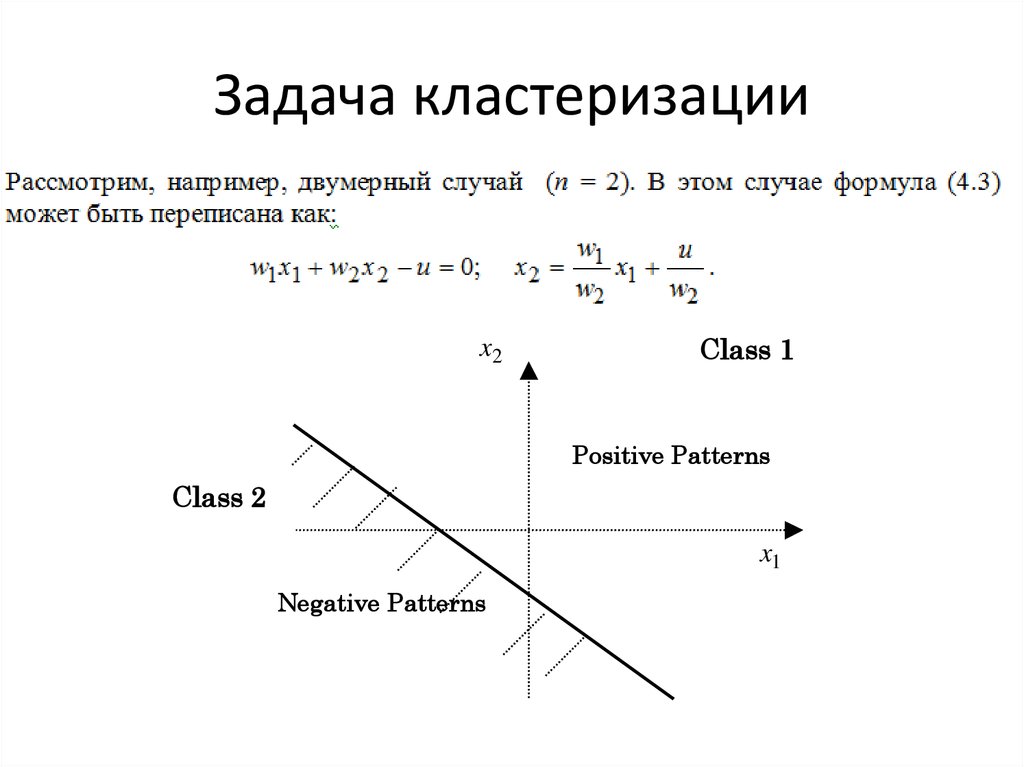

11. Задача кластеризации

x2Class 1

Positive Patterns

Class 2

x1

Negative Patterns

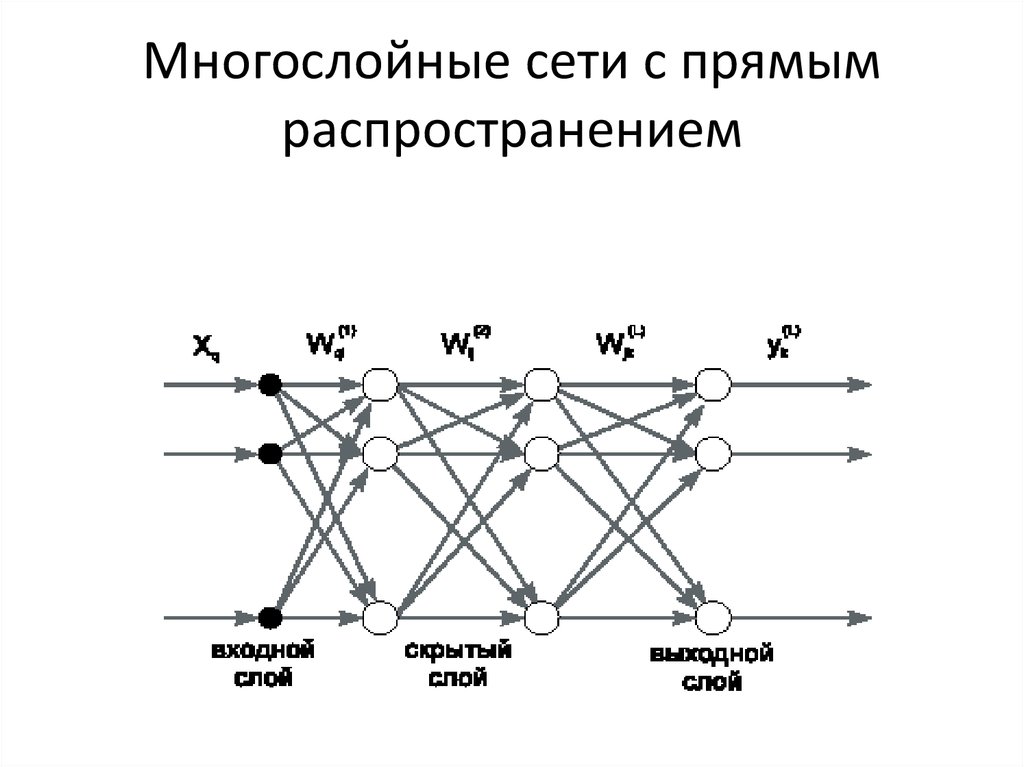

12. Многослойные сети с прямым распространением

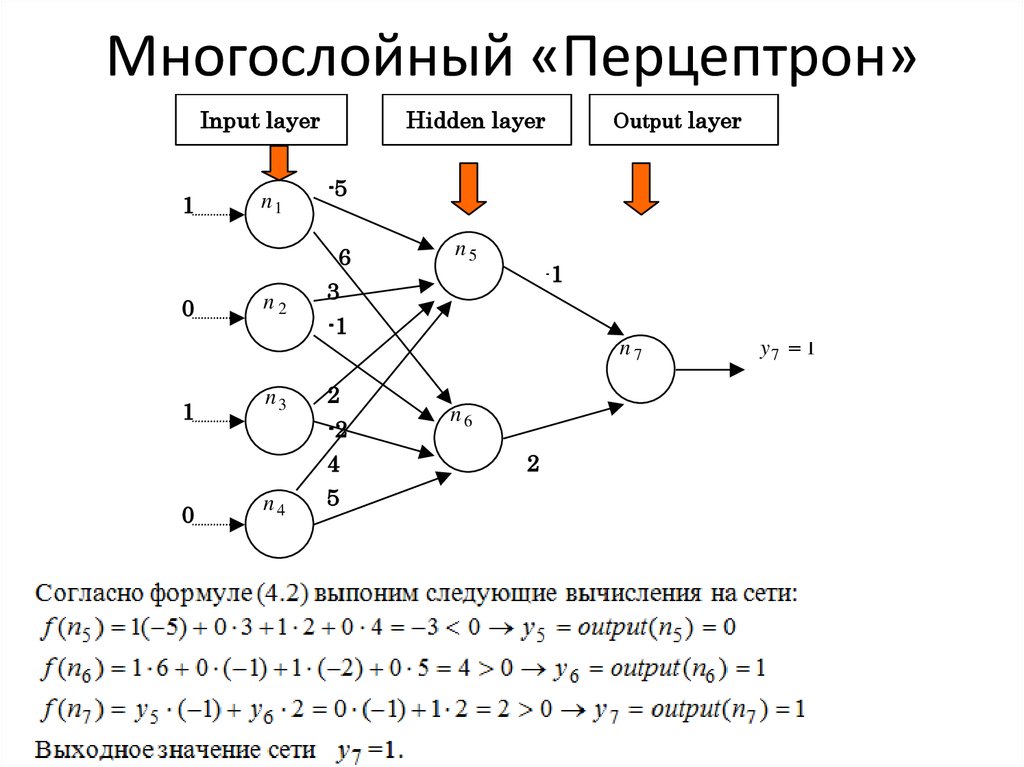

13. Многослойный «Перцептрон»

Input layer1

n1

Hidden layer

-5

6

0

n2

Output layer

n5

-1

3

-1

n7

1

0

n3

2

-2

n4

4

5

n6

2

y7 1

14. Многослойный перцептрон как универсальный аппроксиматор

• Теорема существования (Existence Theorem , Hornik идр,. 1989):

• MLP может аппроксимировать любую непрерывную

функцию с любой заданной степенью точности.

• Доказательство этой фундаментальной теоремы

основывается на теореме Колмогорова (1957), которая

гласит

• Любая непрерывная функция, определенная в nмерном множестве действительных чисел, может

быть представлена в виде суммы функций, имеющих

своим аргументом суммы непрерывных функций с

единственным аргументом.

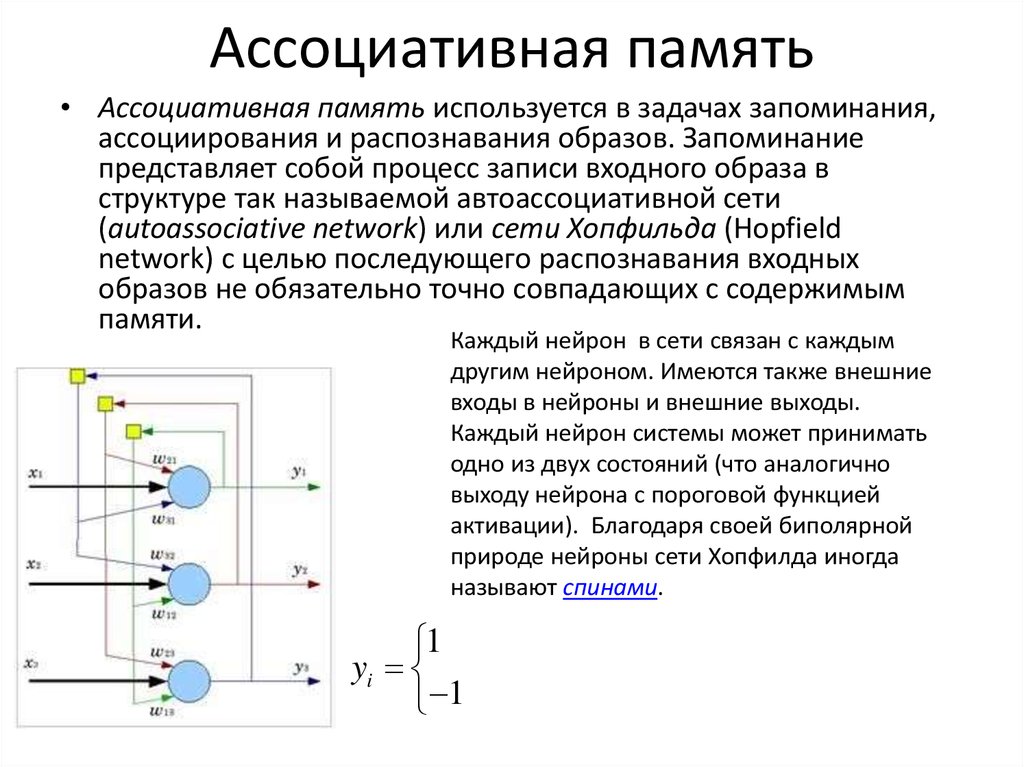

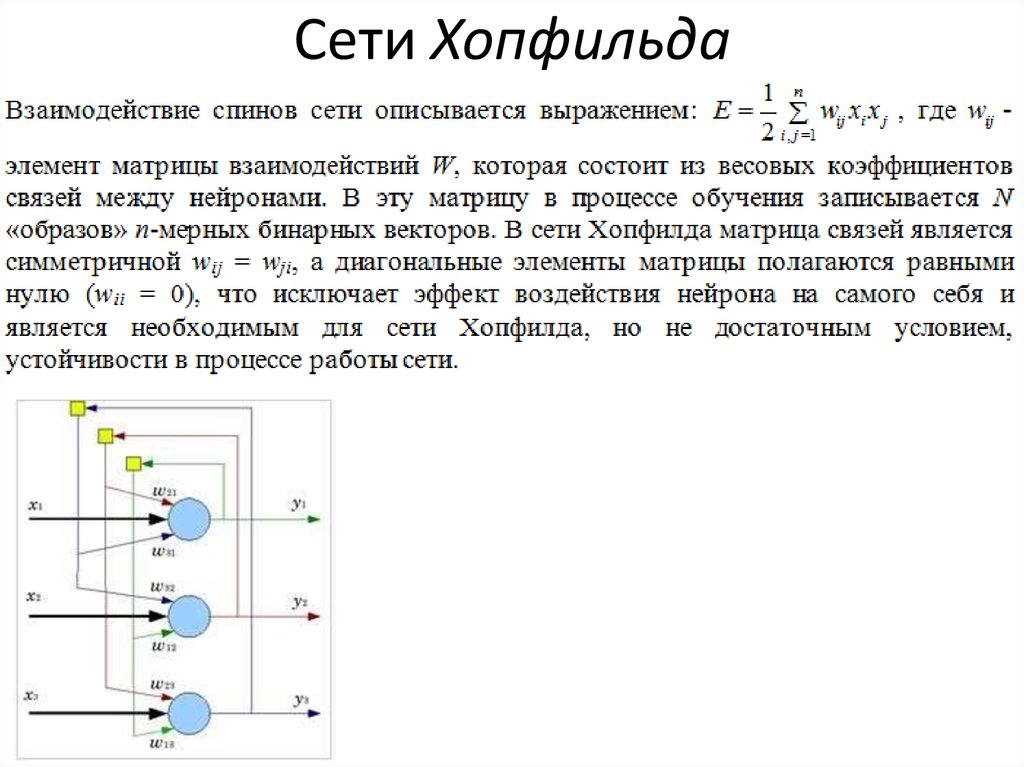

15. Ассоциативная память

• Ассоциативная память используется в задачах запоминания,ассоциирования и распознавания образов. Запоминание

представляет собой процесс записи входного образа в

структуре так называемой автоассоциативной сети

(autoassociative network) или сети Хопфильда (Hopfield

network) с целью последующего распознавания входных

образов не обязательно точно совпадающих с содержимым

памяти.

Каждый нейрон в сети связан с каждым

другим нейроном. Имеются также внешние

входы в нейроны и внешние выходы.

Каждый нейрон системы может принимать

одно из двух состояний (что аналогично

выходу нейрона с пороговой функцией

активации). Благодаря своей биполярной

природе нейроны сети Хопфилда иногда

называют спинами.

1

yi

1

16. Сети Хопфильда

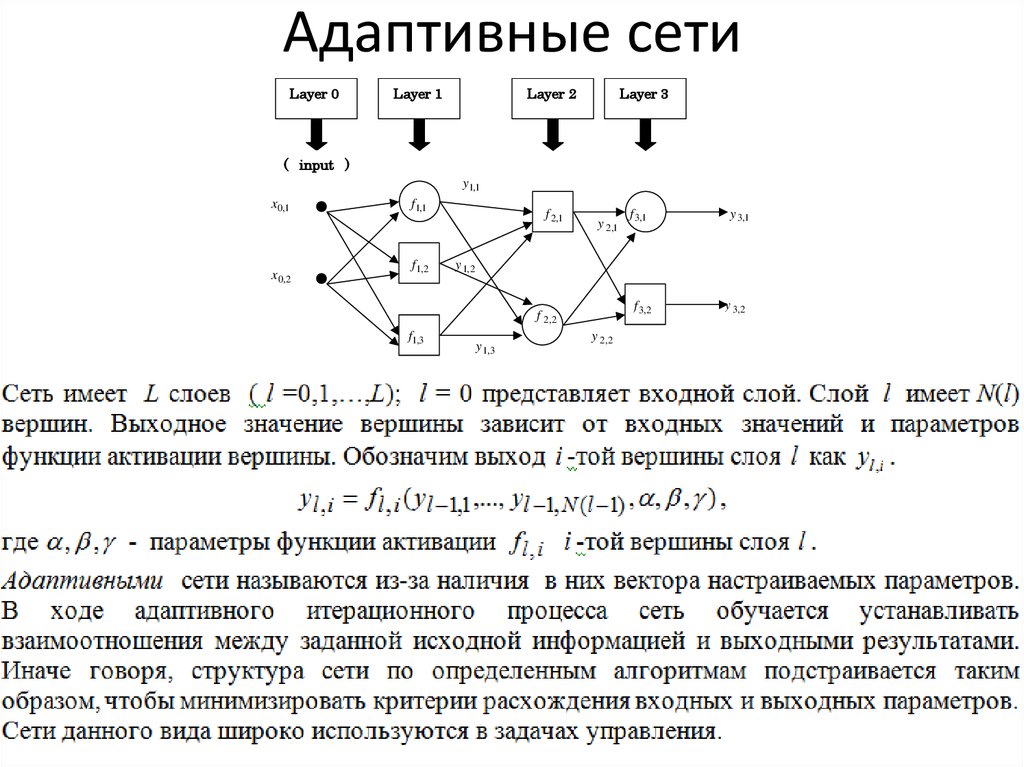

17. Адаптивные сети

Layer 0Layer 1

Layer 2

Layer 3

( input )

y1,1

x0,1

f1,1

f 2,1

y 2,1

f 3,1

y 3,1

x 0, 2

f1, 2

y 1, 2

f 3, 2

f 2, 2

f1,3

y 1,3

y 2, 2

y 3, 2

18. Нечеткие нейронные сети для задач управления

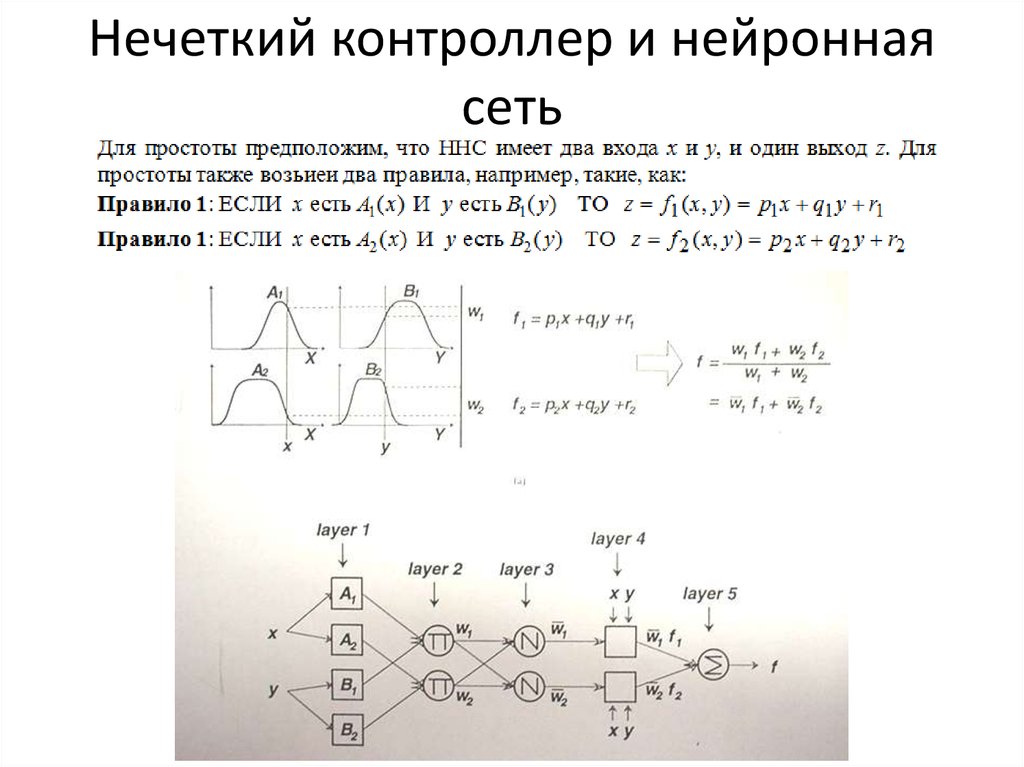

19. Нечеткий контроллер и нейронная сеть

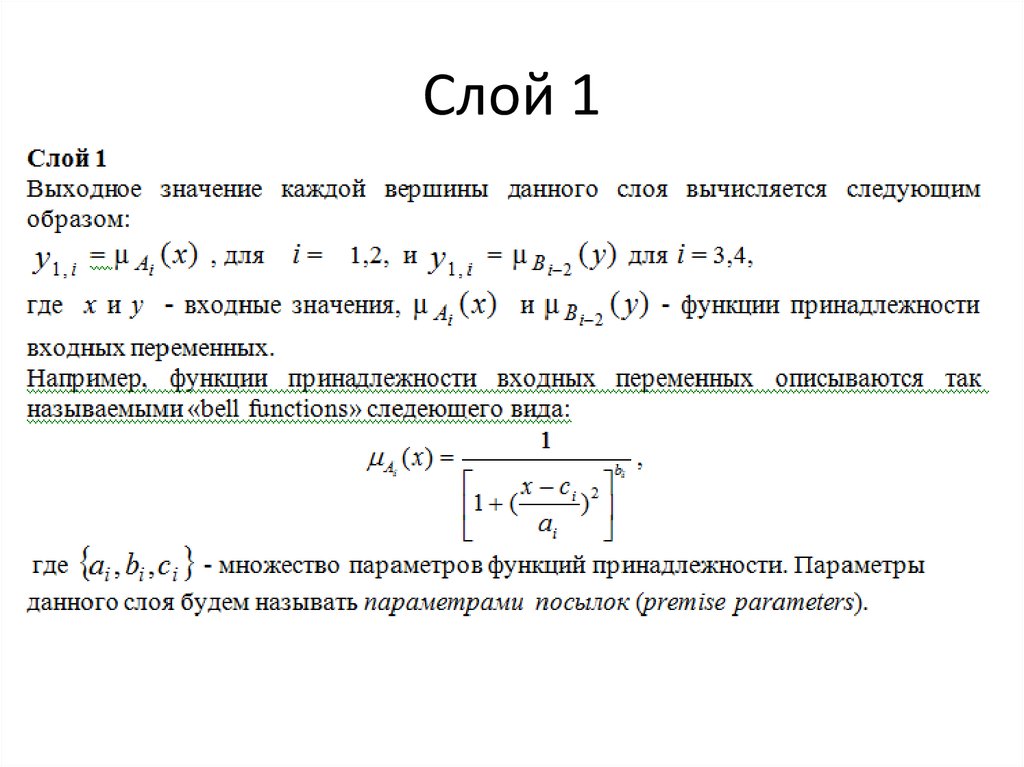

20. Слой 1

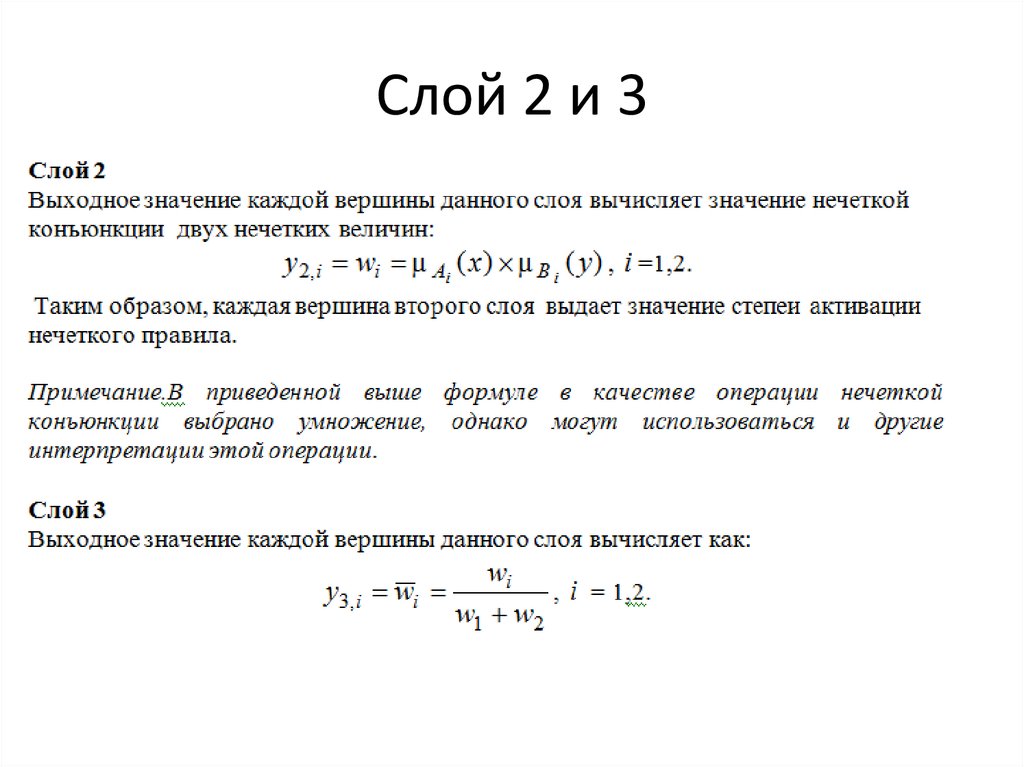

21. Слой 2 и 3

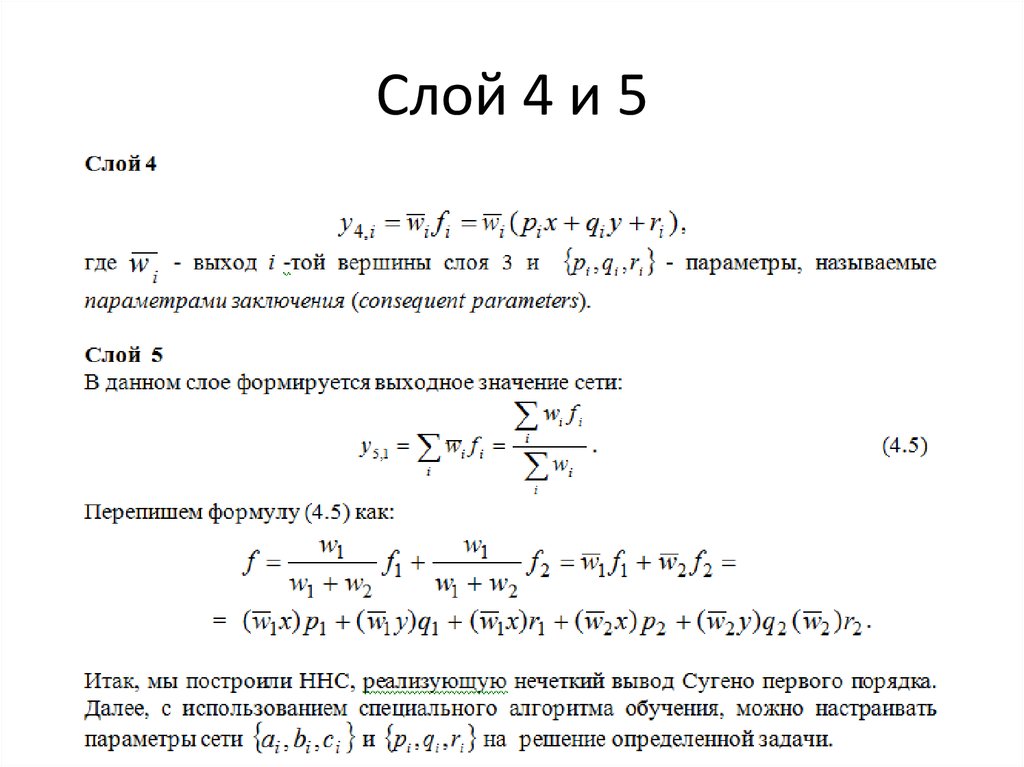

22. Слой 4 и 5

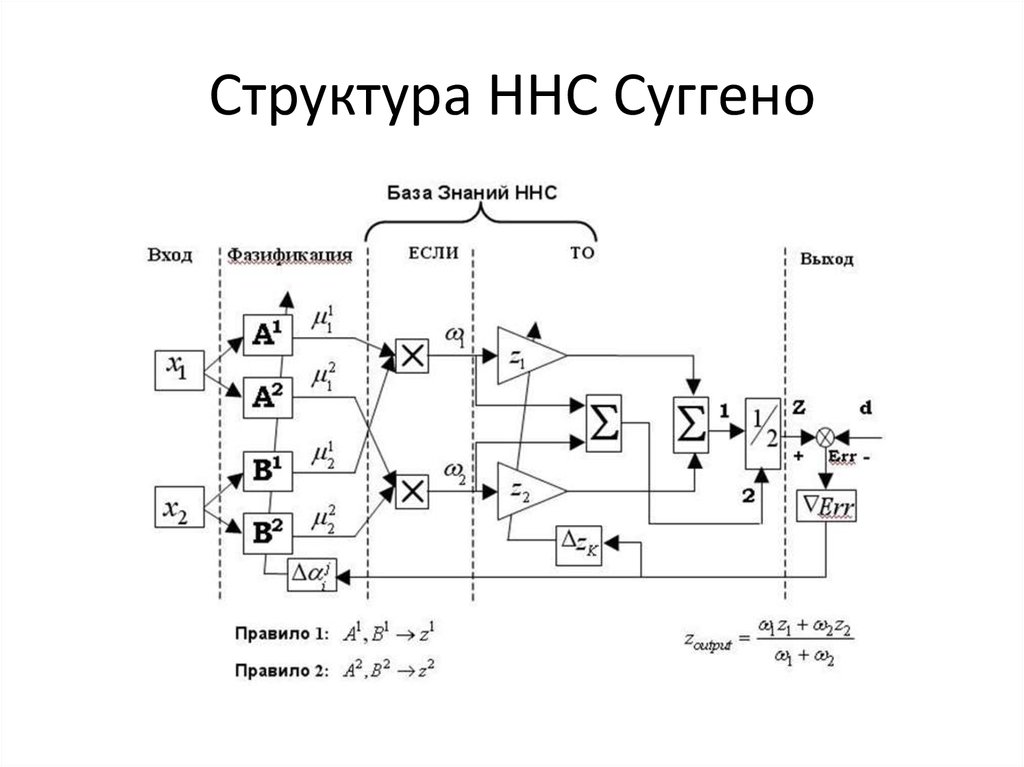

23. Структура ННС Суггено

24. Заключение

25. Заключение

26. Обучение сети

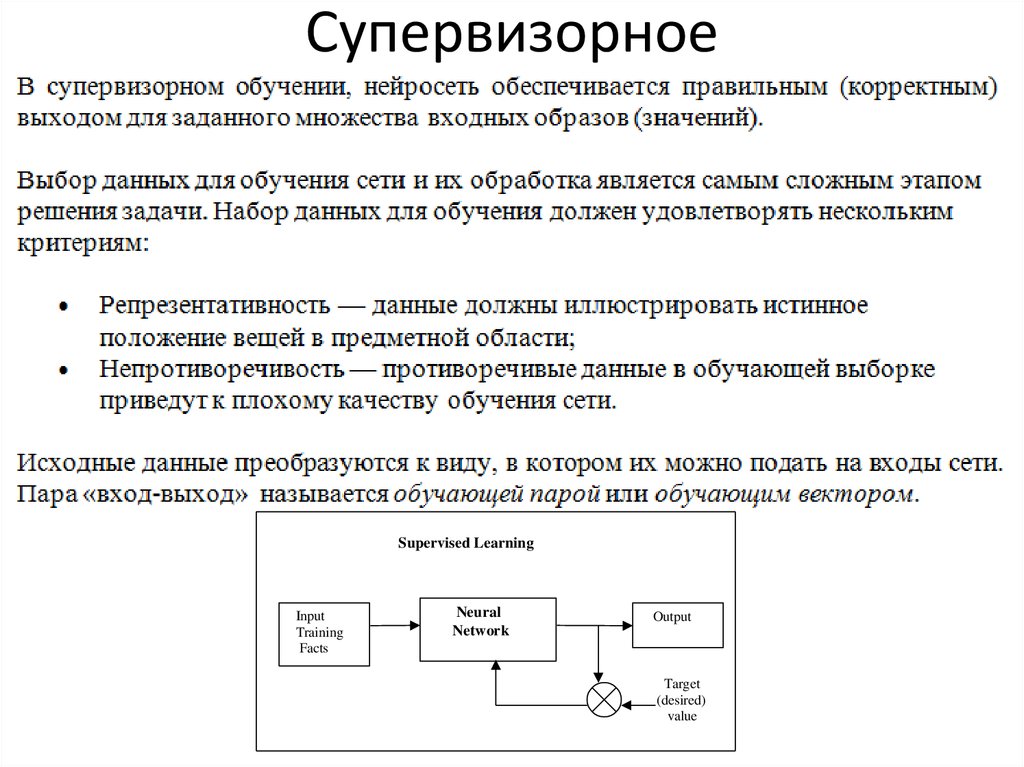

27. Супервизорное

Supervised LearningInput

Training

Facts

Neural

Network

Output

Target

(desired)

value

28. Супервизорное

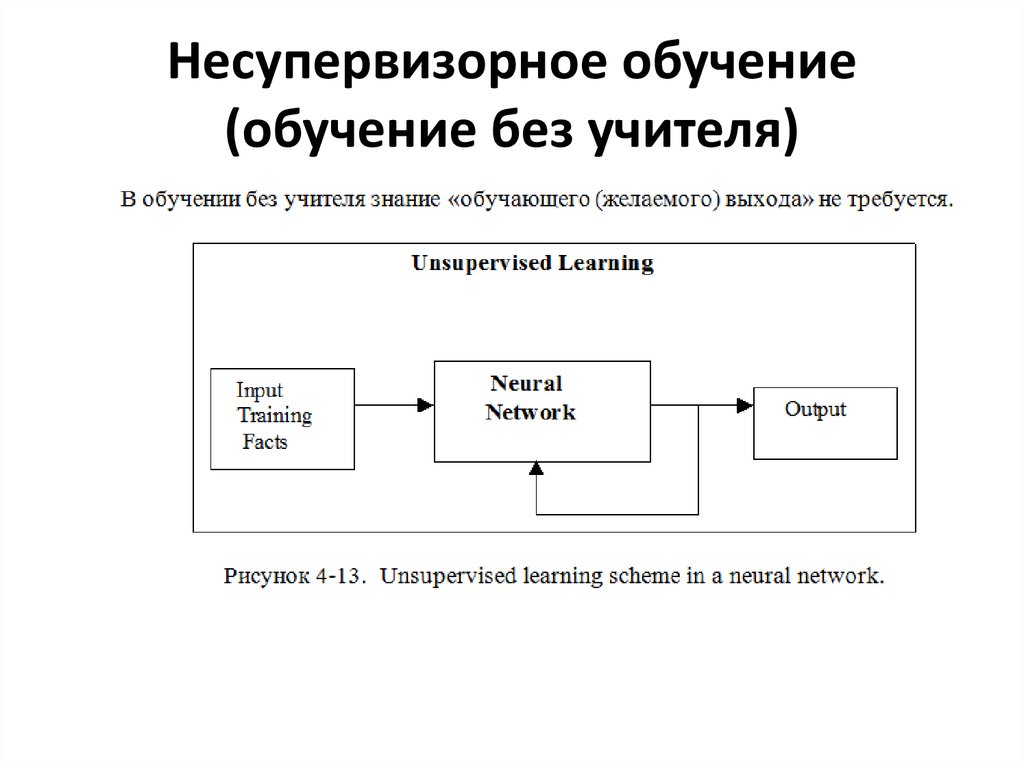

29. Несупервизорное обучение (обучение без учителя)

30. Несупервизорное обучение

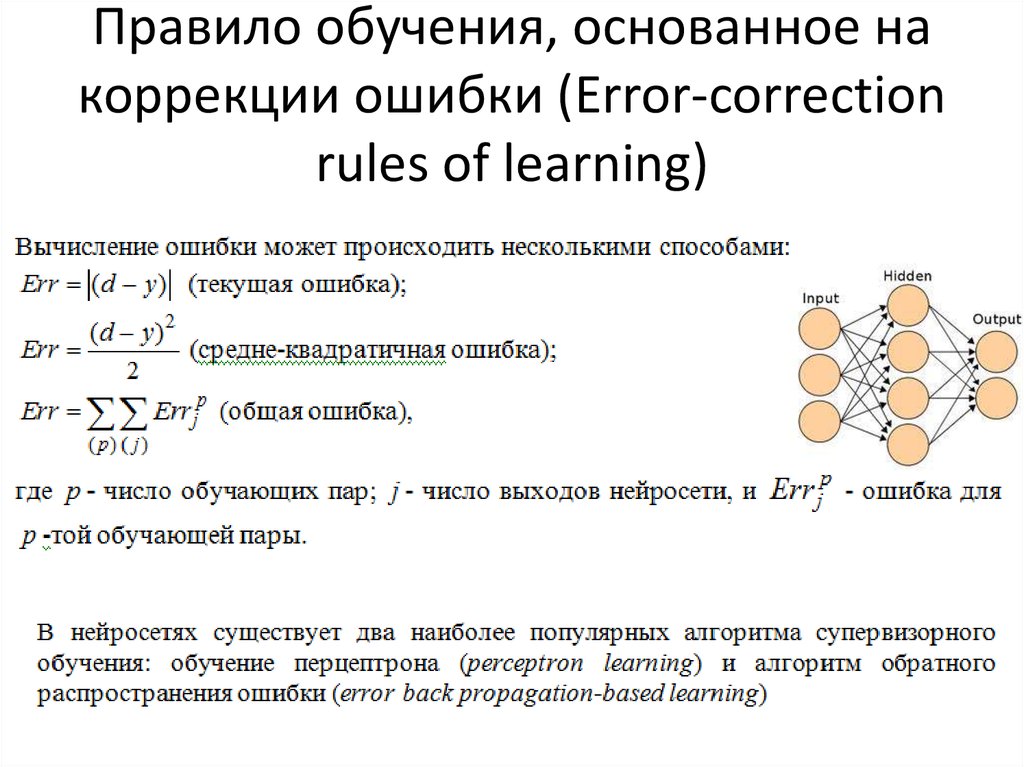

31. Правило обучения, основанное на коррекции ошибки (Error-correction rules of learning)

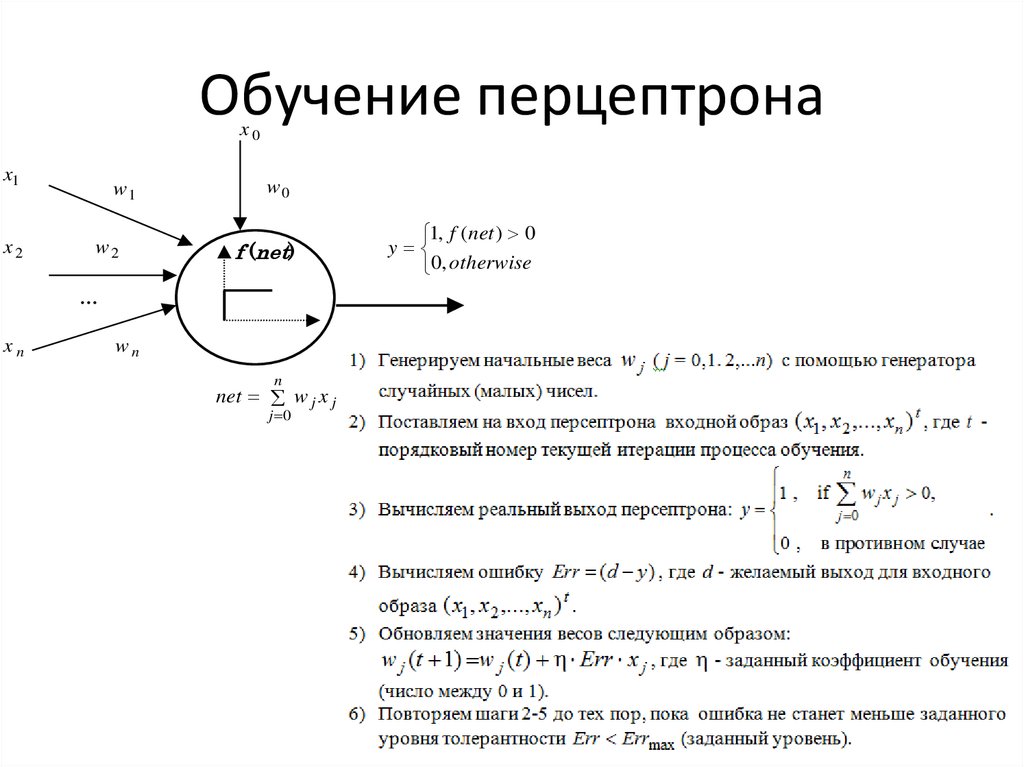

32. Обучение перцептрона

x0x1

x2

w1

w2

w0

f (net)

…

xn

wn

n

net w j x j

j 0

1, f ( net ) 0

y

0, otherwise

33. Теорема сходимости Перцептрона

• Теорема сходимости перцептрона,описанная и доказанная Ф. Розенблаттом

показывает, что элементарный перцептрон,

обучаемый по такому алгоритму,

независимо от начального состояния

весовых коэффициентов и

последовательности появления стимулов

всегда приведет к достижению решения за

конечный промежуток времени.

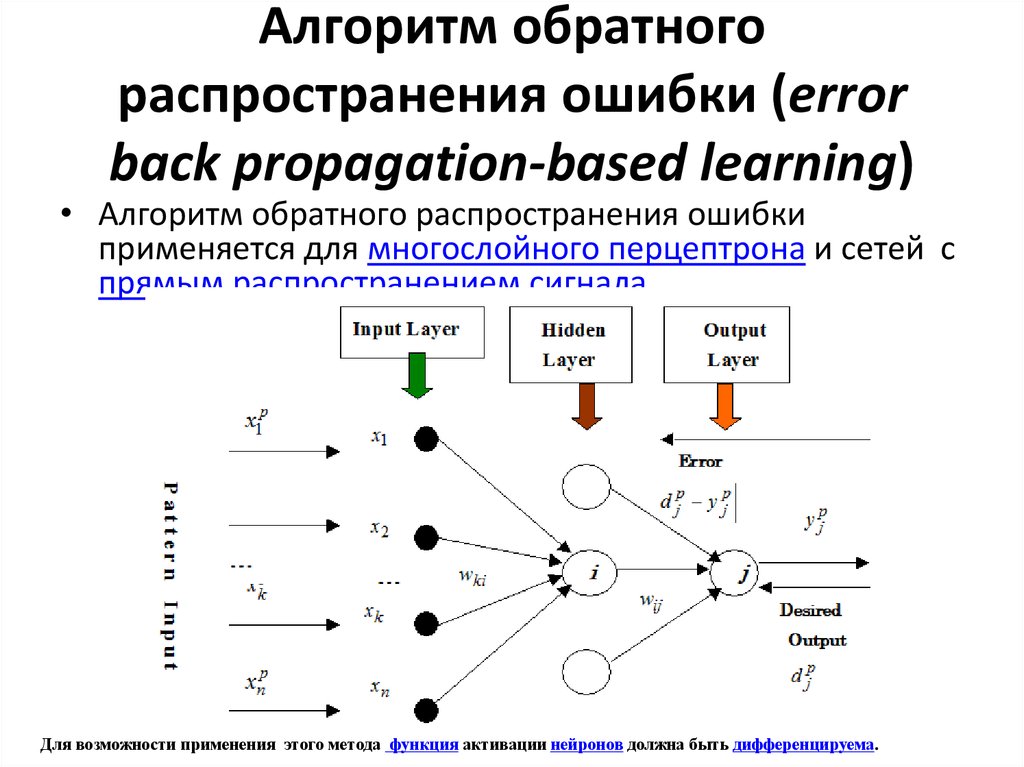

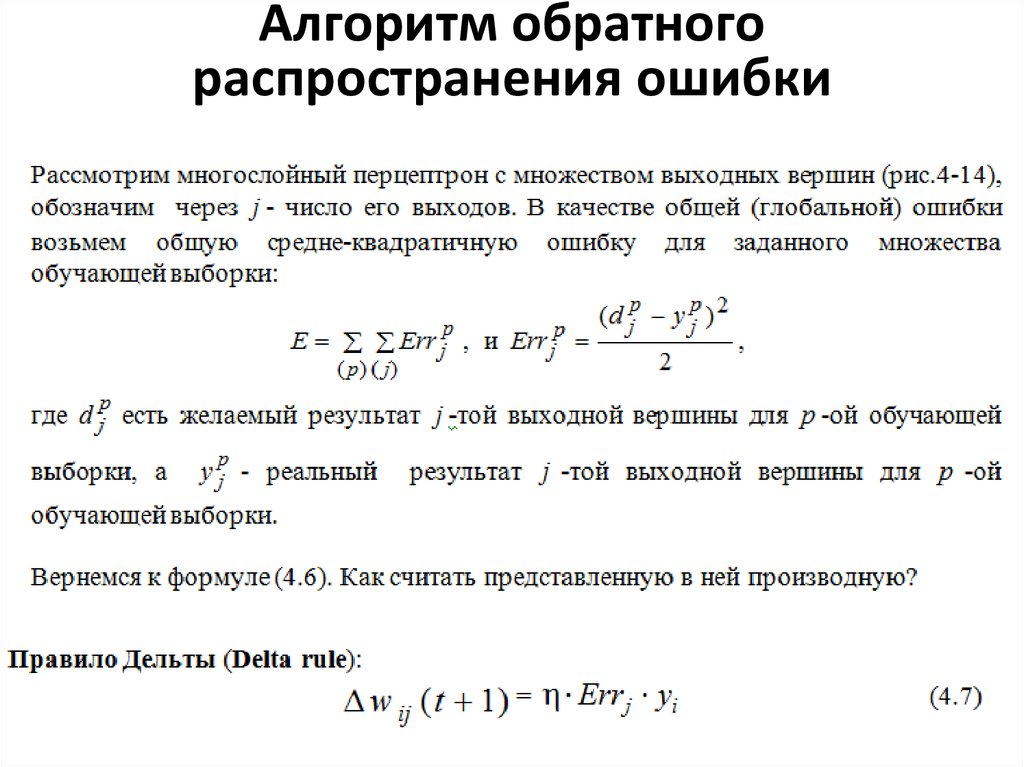

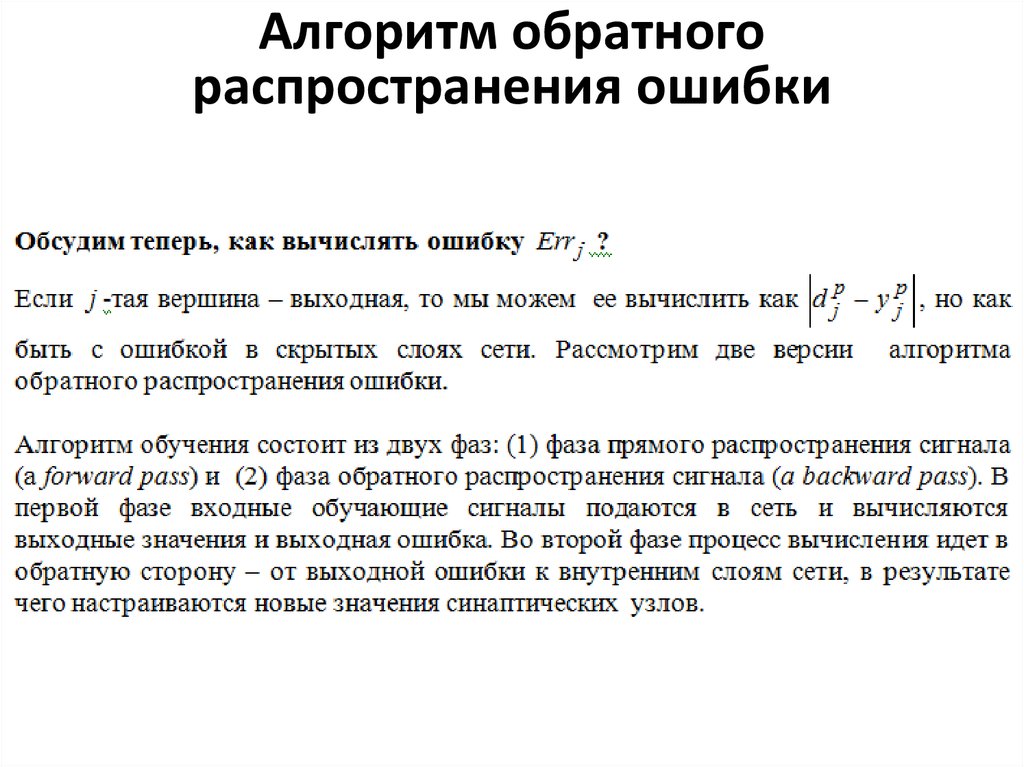

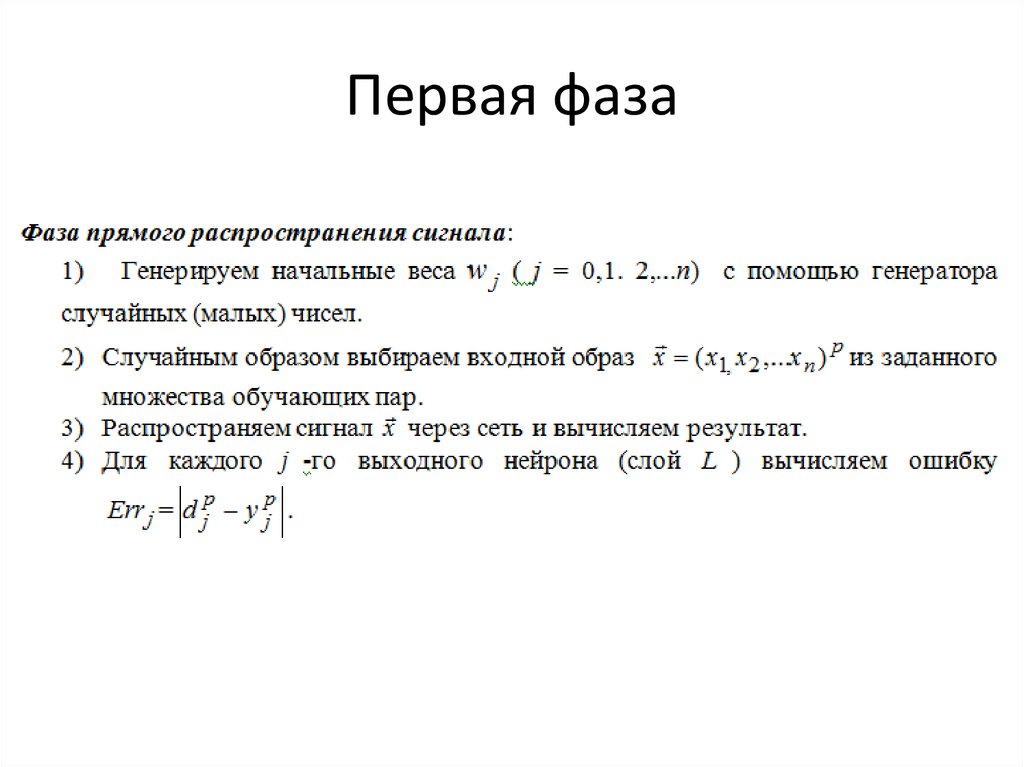

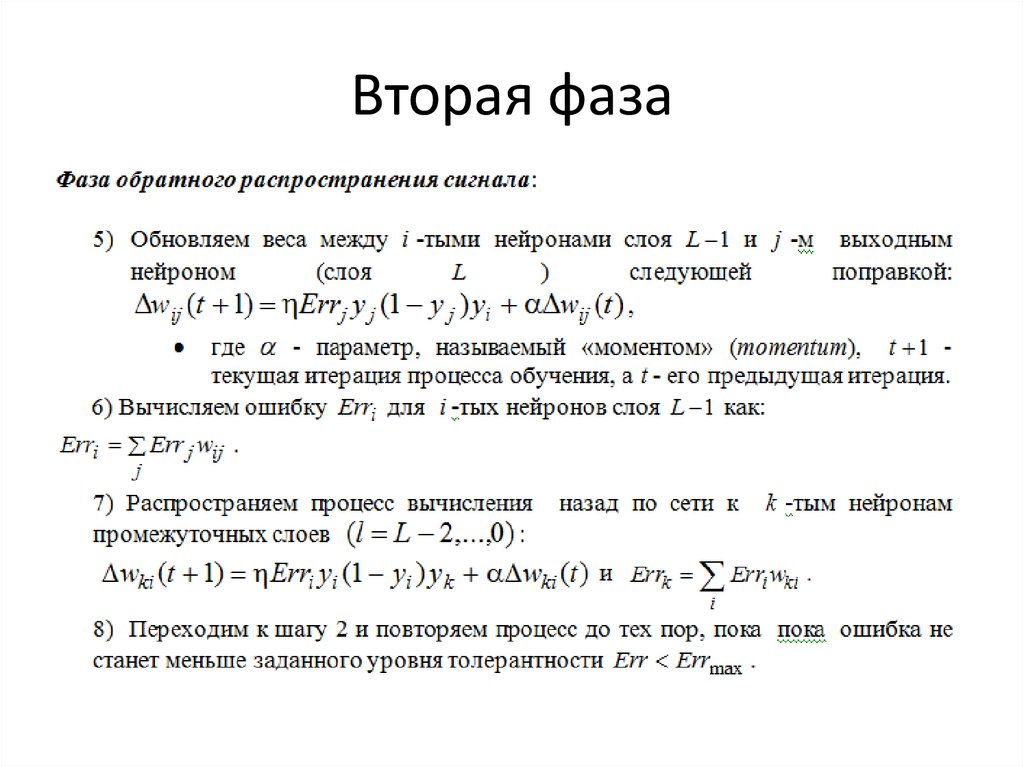

34. Алгоритм обратного распространения ошибки (error back propagation-based learning)

• Алгоритм обратного распространения ошибкиприменяется для многослойного перцептрона и сетей с

прямым распространением сигнала

Для возможности применения этого метода функция активации нейронов должна быть дифференцируема.

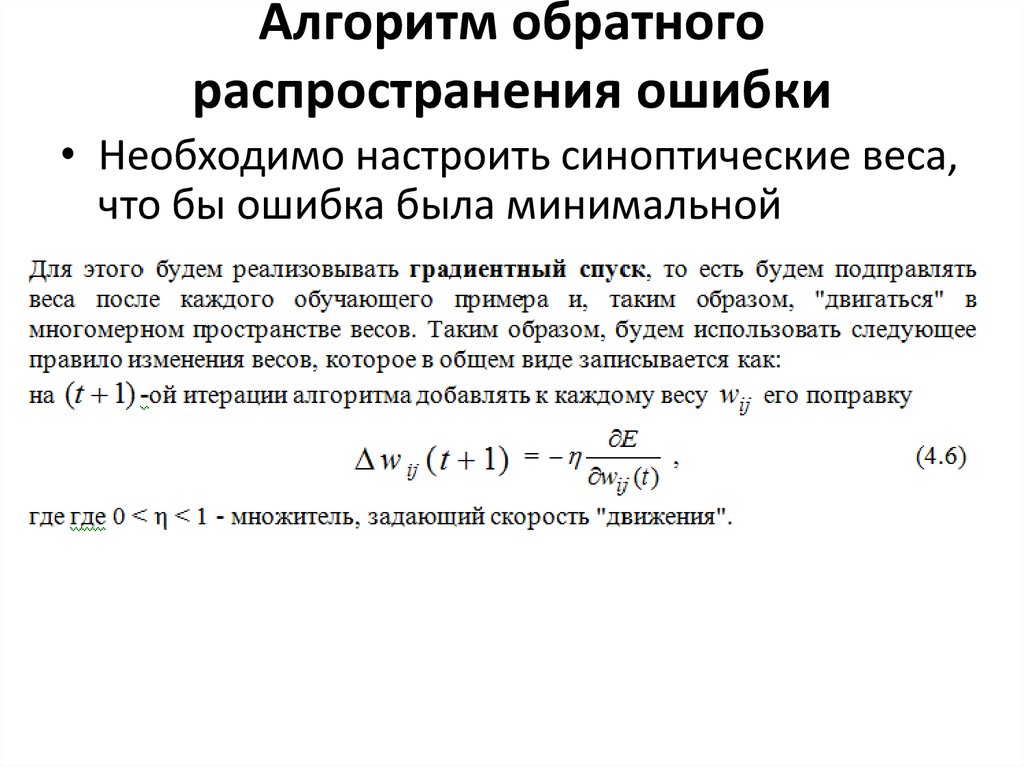

35. Алгоритм обратного распространения ошибки

• Необходимо настроить синоптические веса,что бы ошибка была минимальной

36.

Алгоритм обратногораспространения ошибки

37.

Алгоритм обратногораспространения ошибки

Математика

Математика Биология

Биология