Похожие презентации:

Лингвистика для математиков

1. Лингвистика для математиков

Дистрибутивная семантика2. План на жизнь

На следующей паре тест!Пользоваться можно будет всем кроме соцсетей и соседей

3. Дистрибутивная семантика

Дистрибутивная семантика — это область лингвистики, которая занимаетсявычислением степени семантической близости между лингвистическими

единицами на основании их дистрибуционных признаков в больших

массивах лингвистических данных.

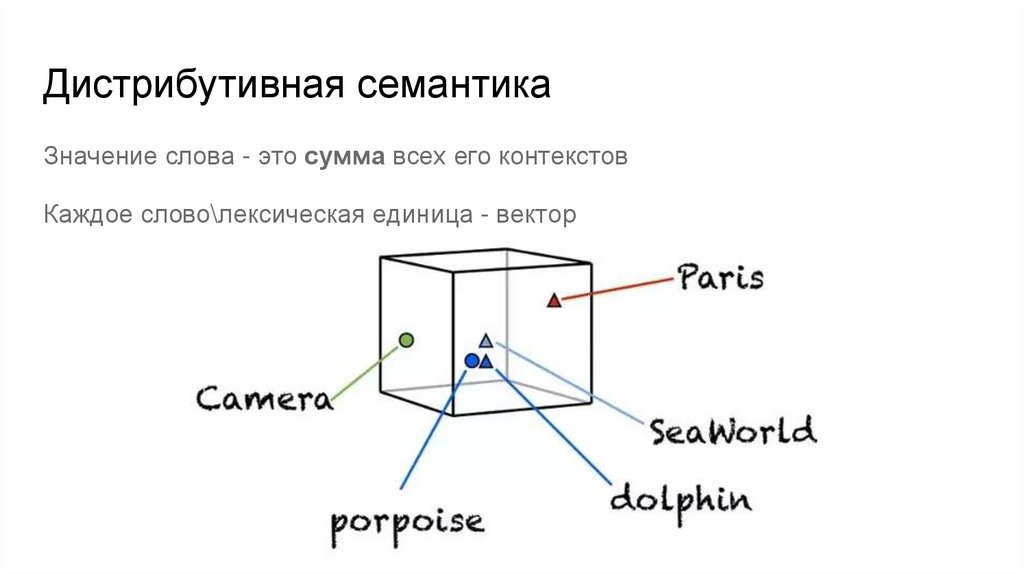

4. Дистрибутивная семантика

Значение слова - это сумма всех его контекстовКаждое слово\лексическая единица - вектор

5. Векторное представление слов

Каждое слово - это векторИначе: word embeddings

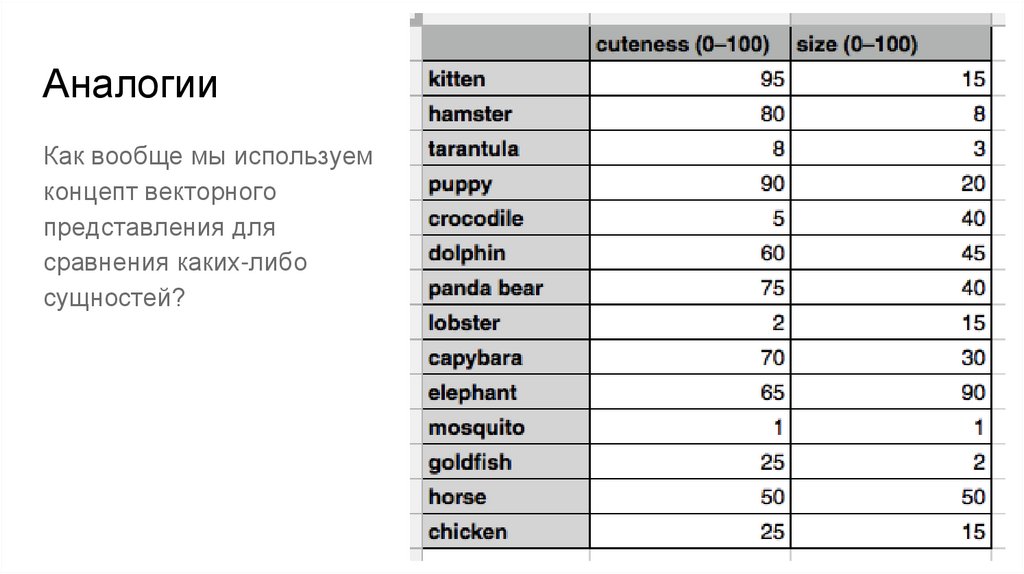

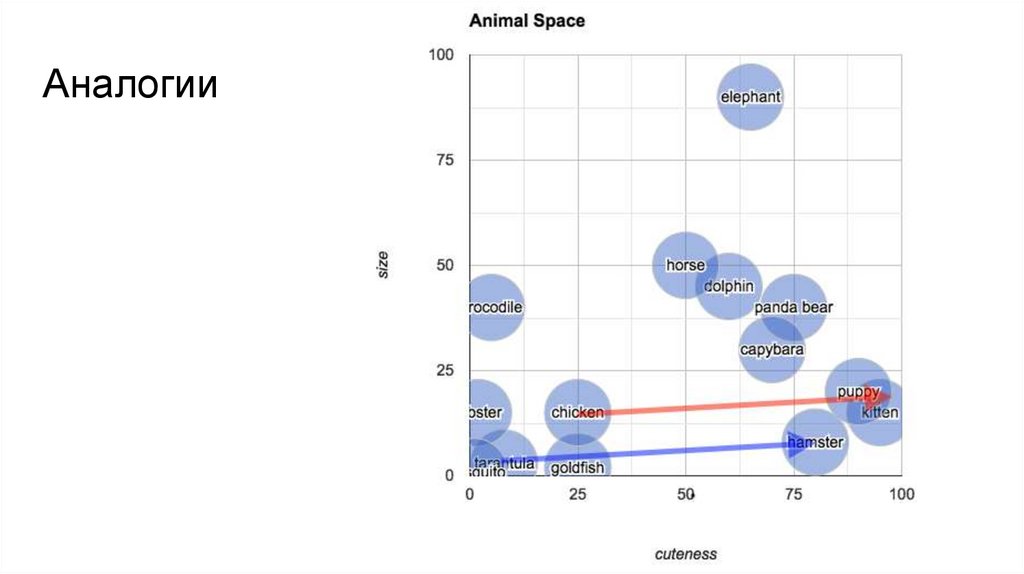

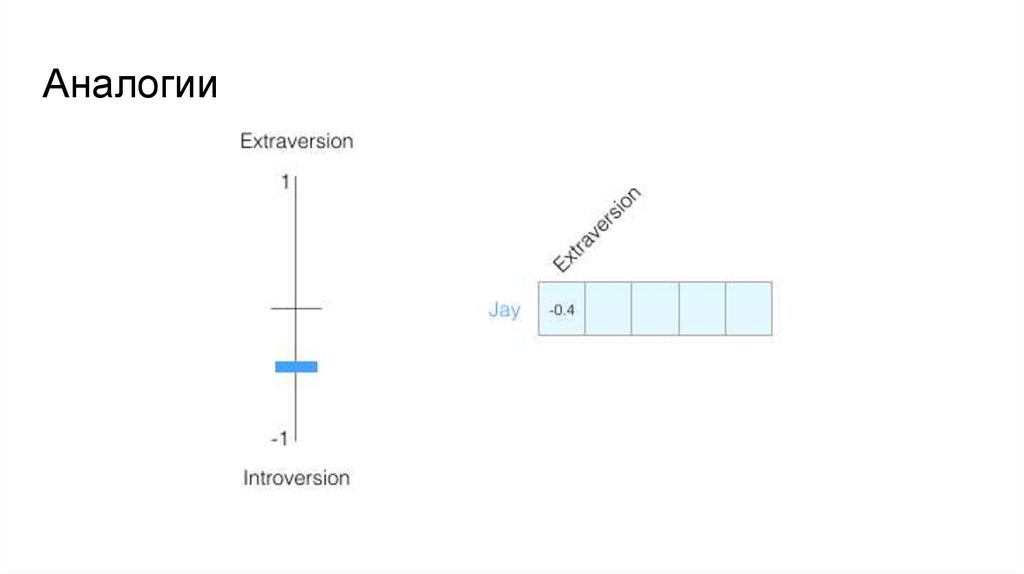

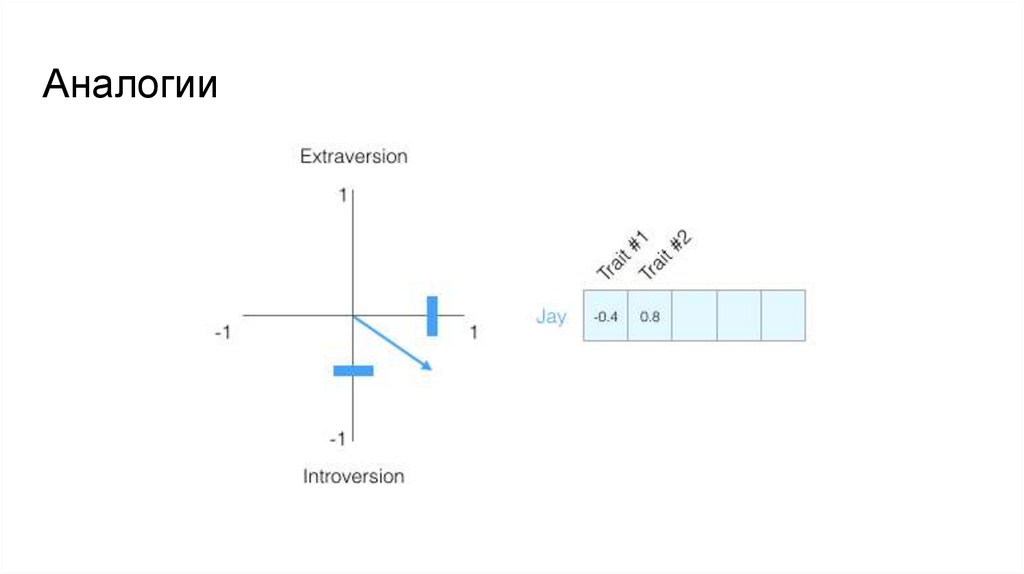

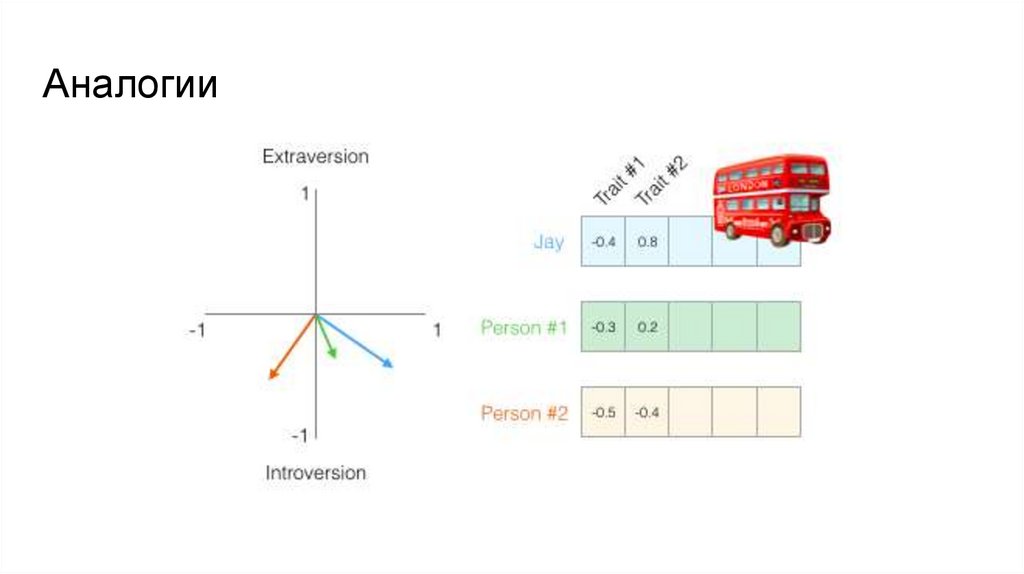

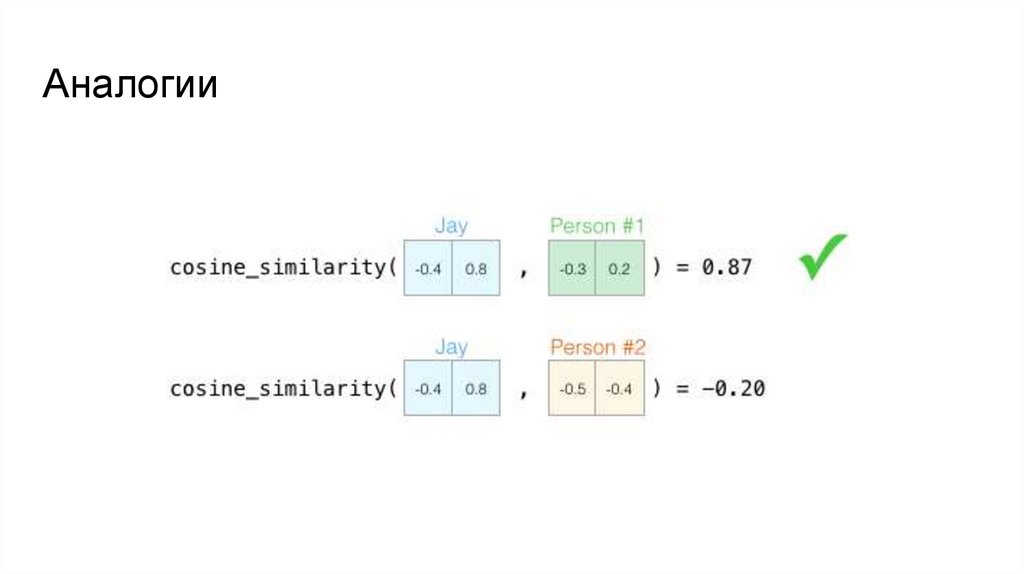

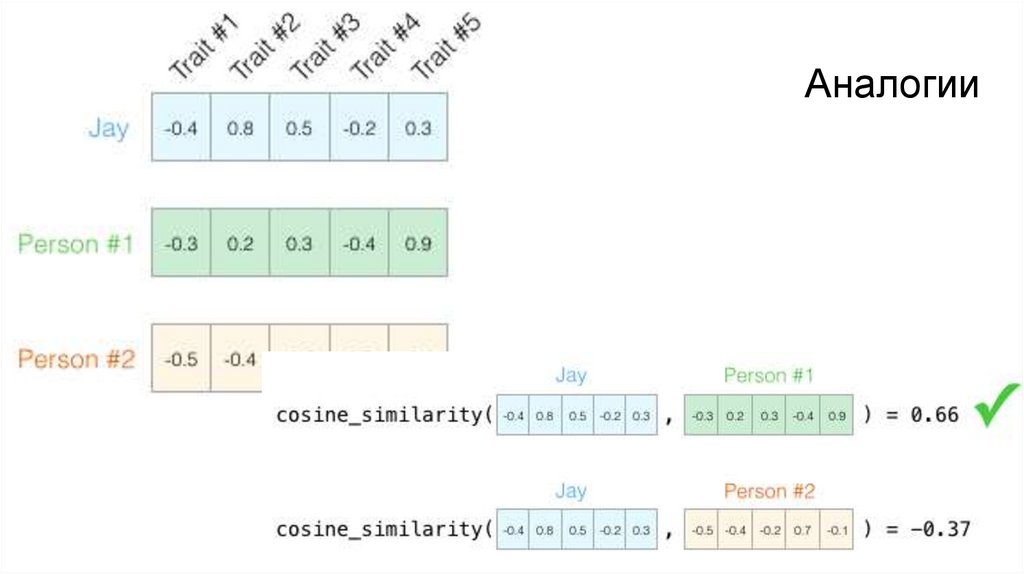

6. Аналогии

Как вообще мы используемконцепт векторного

представления для

сравнения каких-либо

сущностей?

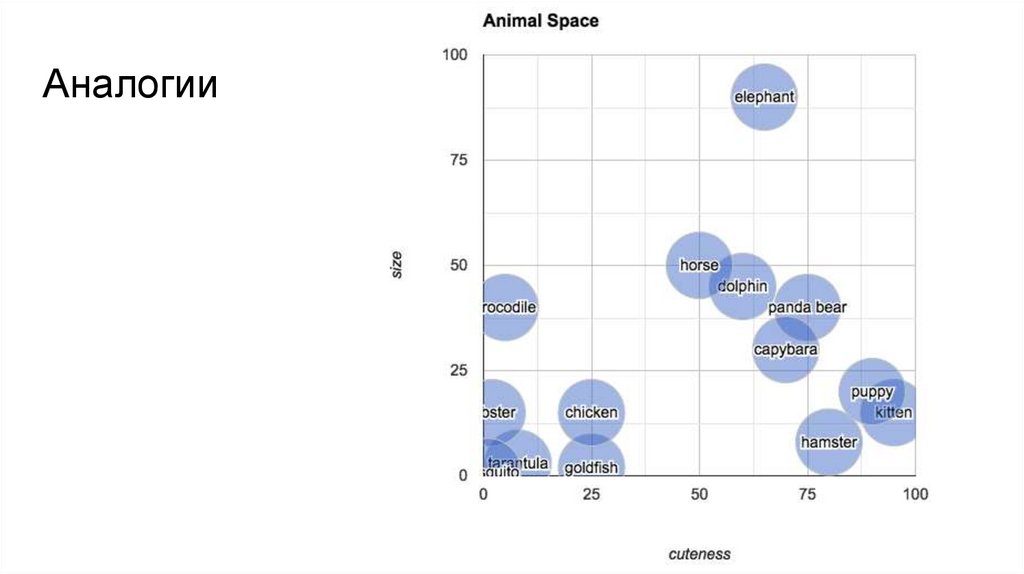

7. Аналогии

8. Аналогии

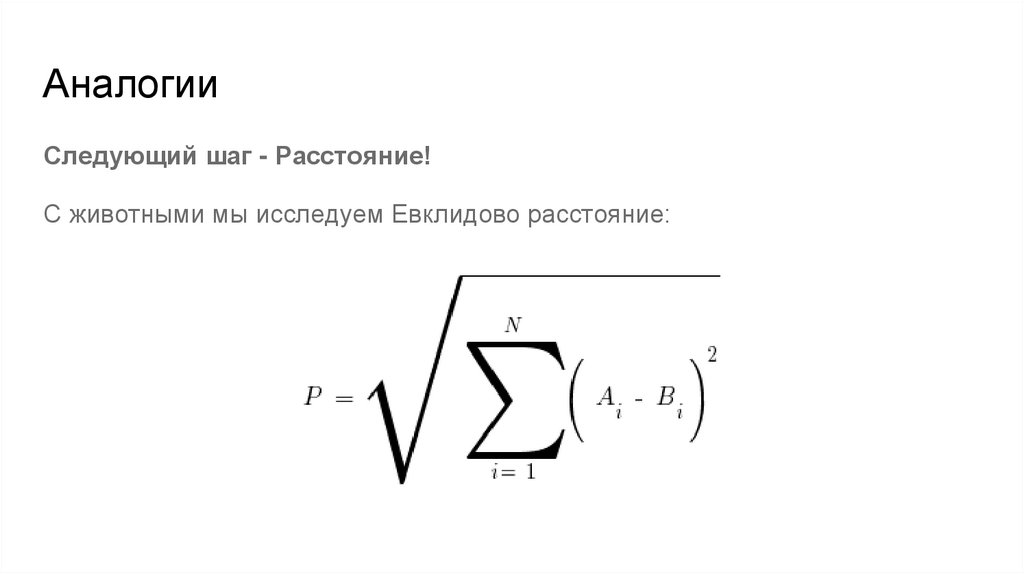

Следующий шаг - Расстояние!С животными мы исследуем Евклидово расстояние:

9. Аналогии

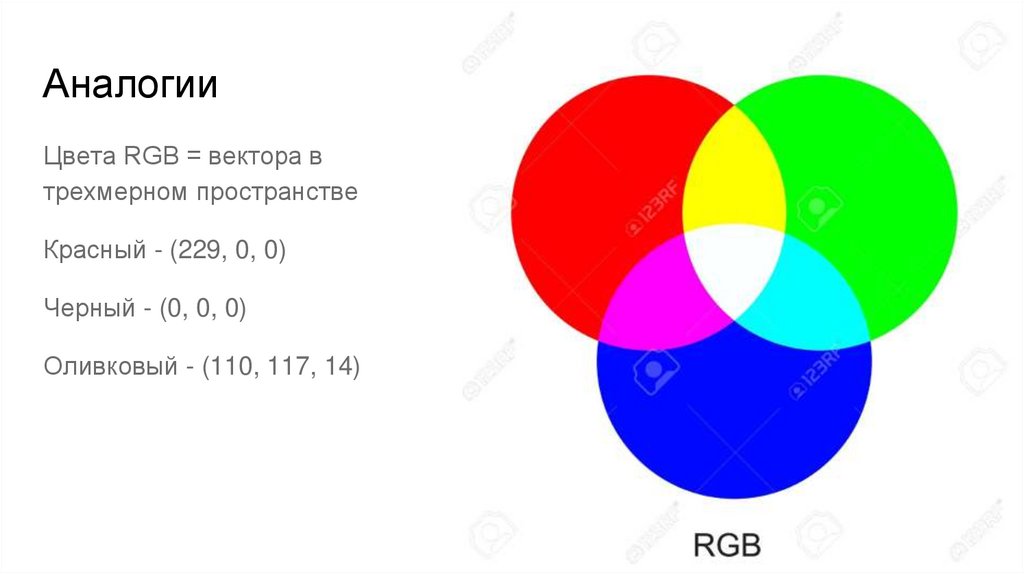

10. Аналогии

Цвета RGB = вектора втрехмерном пространстве

Красный - (229, 0, 0)

Черный - (0, 0, 0)

Оливковый - (110, 117, 14)

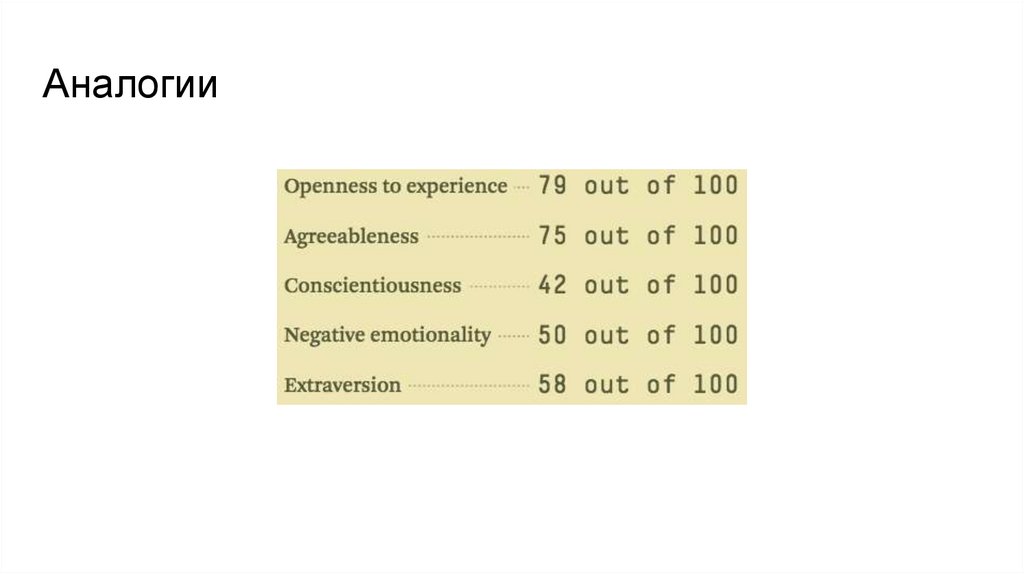

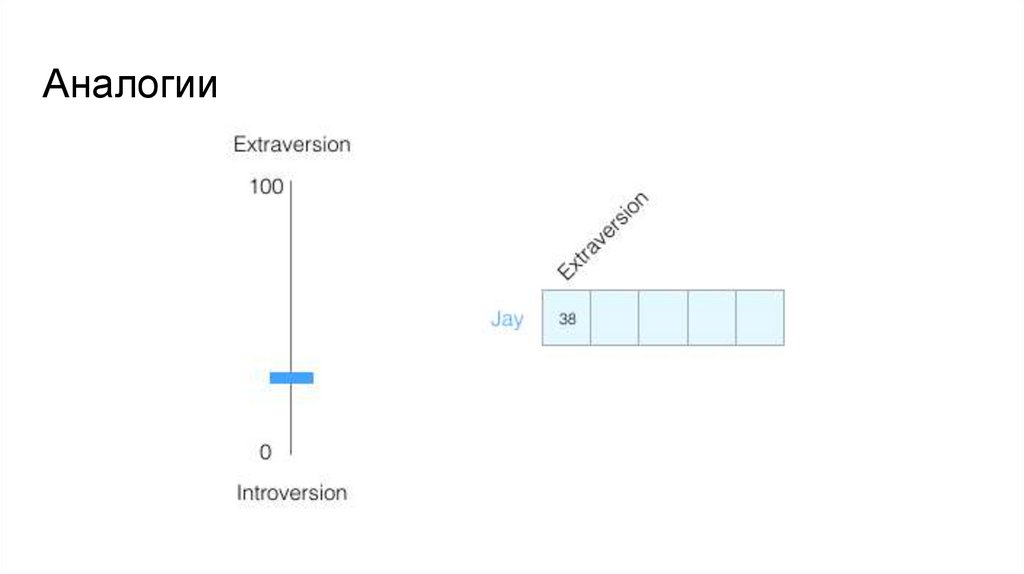

11. Аналогии

12. Аналогии

13. Аналогии

14. Аналогии

15. Аналогии

16. Аналогии

17. Аналогии

18. Наивный подход

19. Наивный подход

Разные виды близости слов: лексическая исемантическая

● петух

● курица

● цыпленок

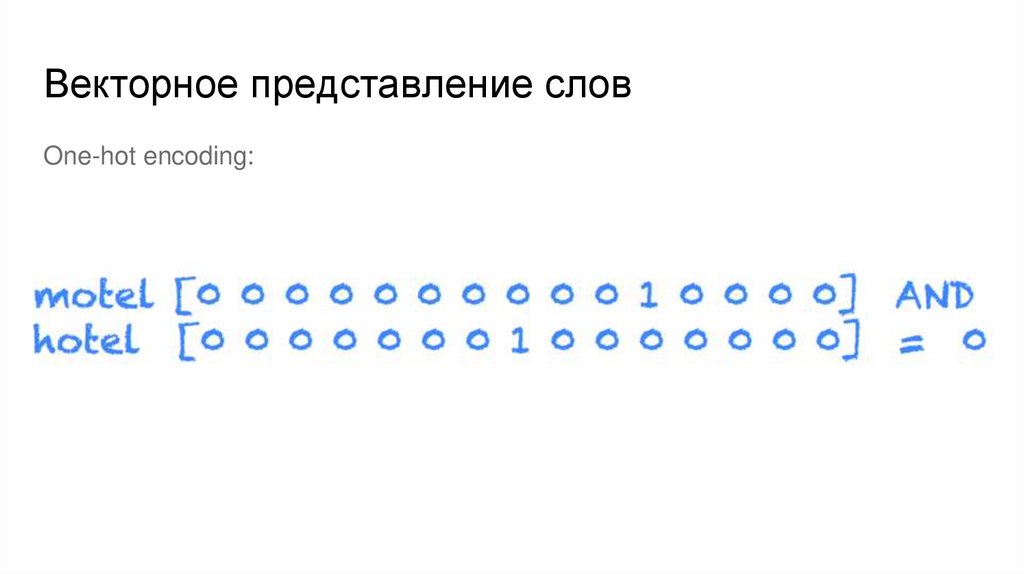

20. Векторное представление слов

One-hot encoding:21. Векторное представление слов

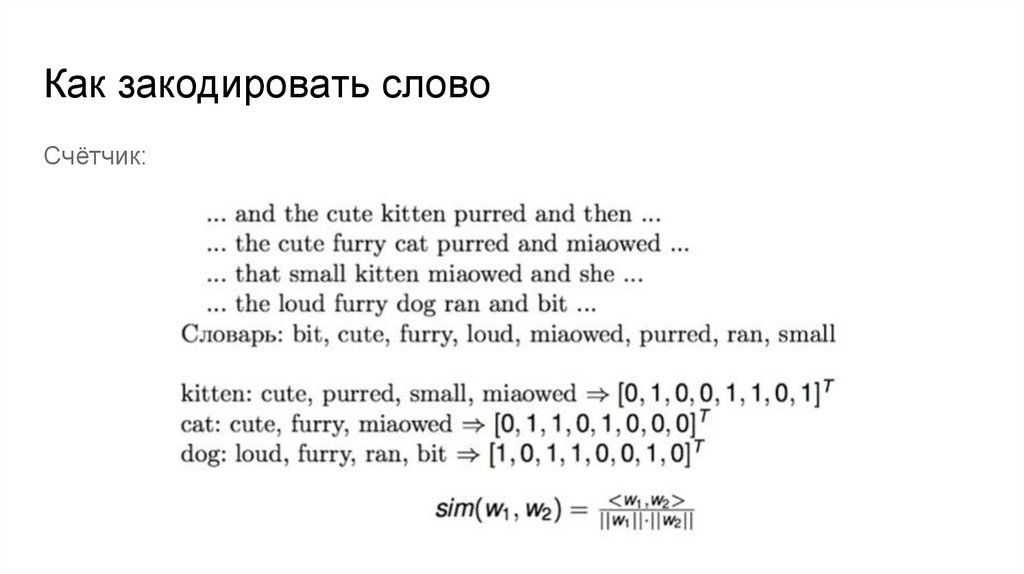

One-hot encoding:22. Как закодировать слово

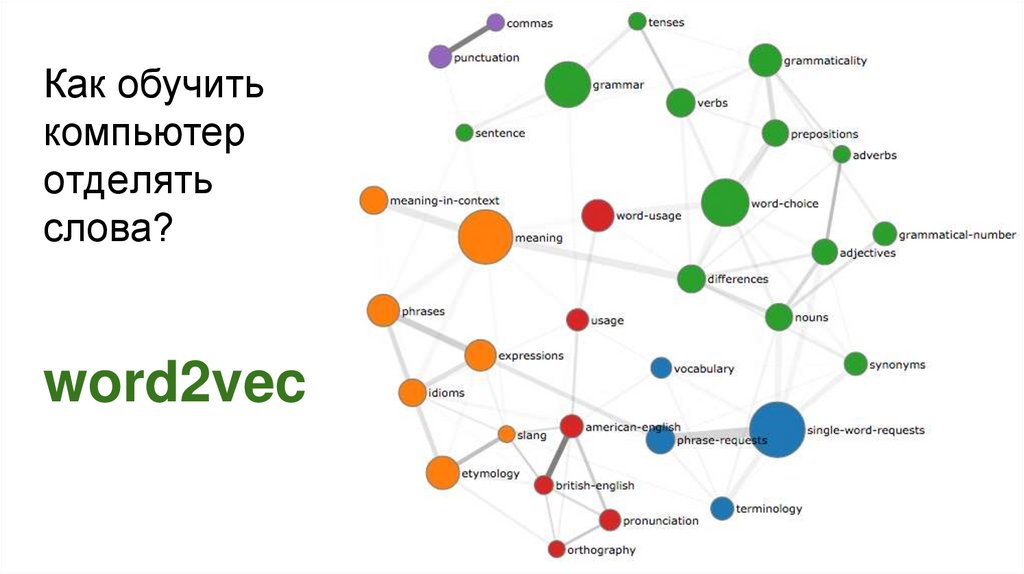

Счётчик:23. Как обучить компьютер отделять слова? word2vec

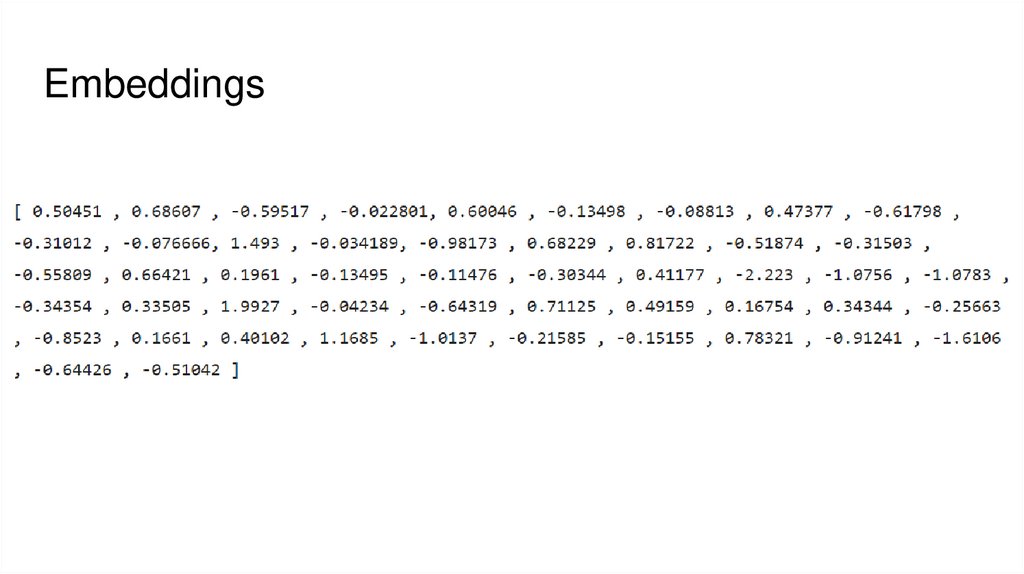

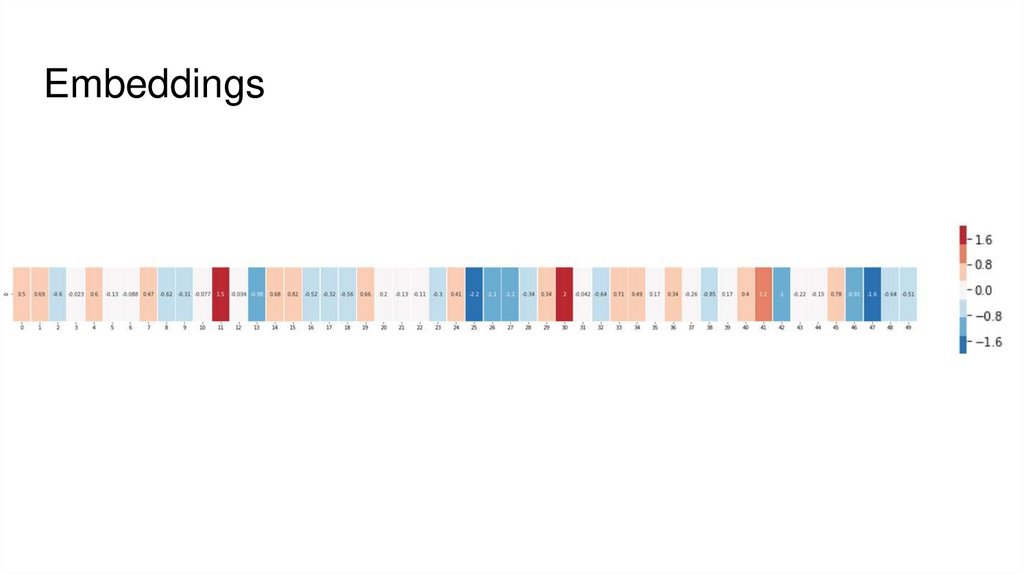

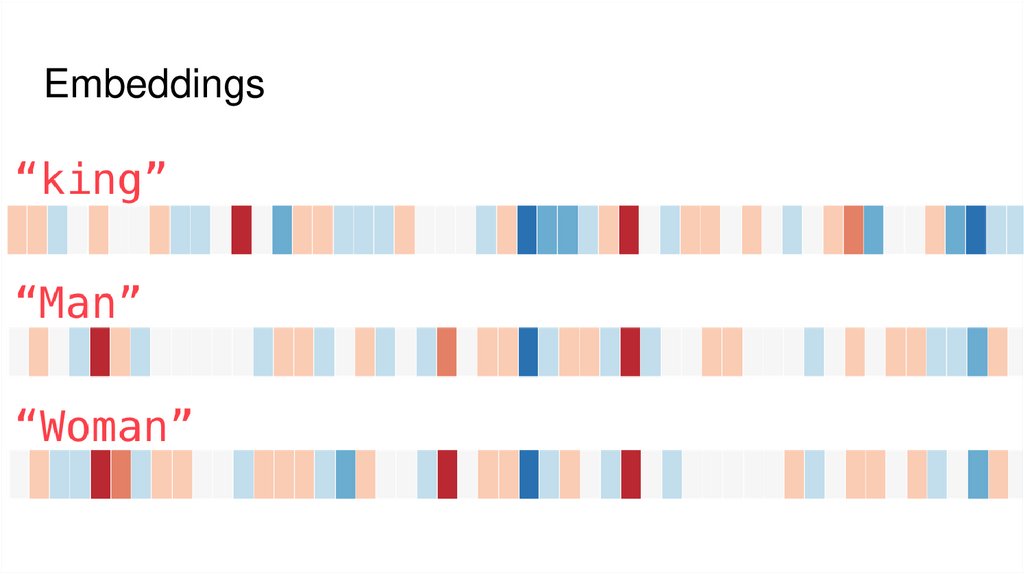

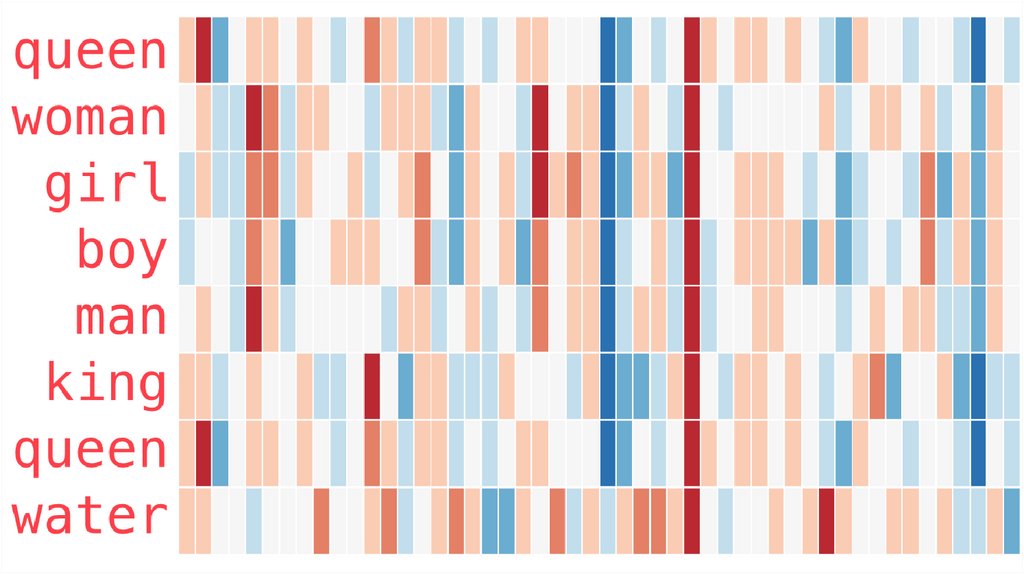

24. Embeddings

25. Embeddings

26. Embeddings

27. Embeddings

28. Embeddings

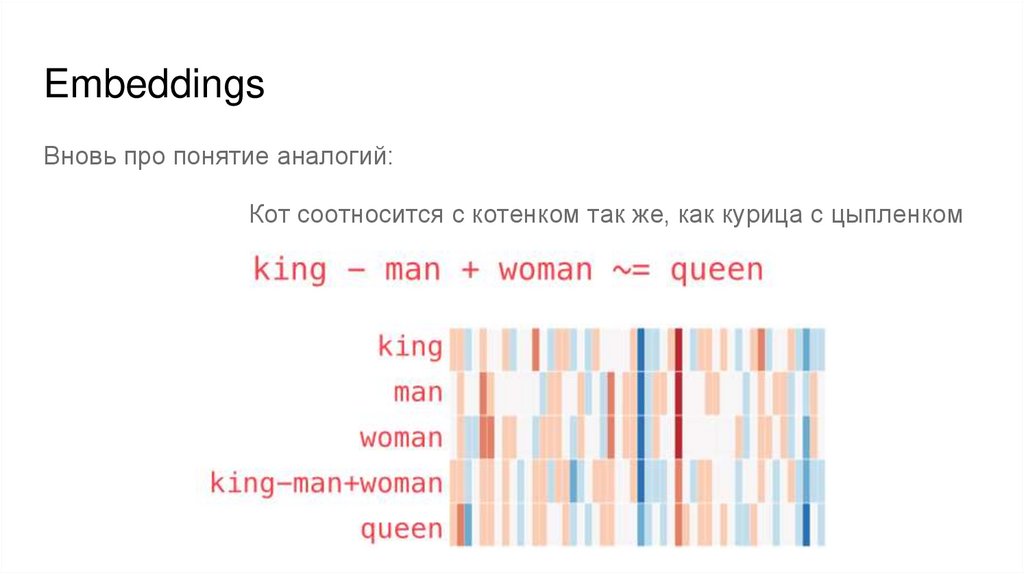

Вновь про понятие аналогий:Кот соотносится с котенком так же, как курица с цыпленком

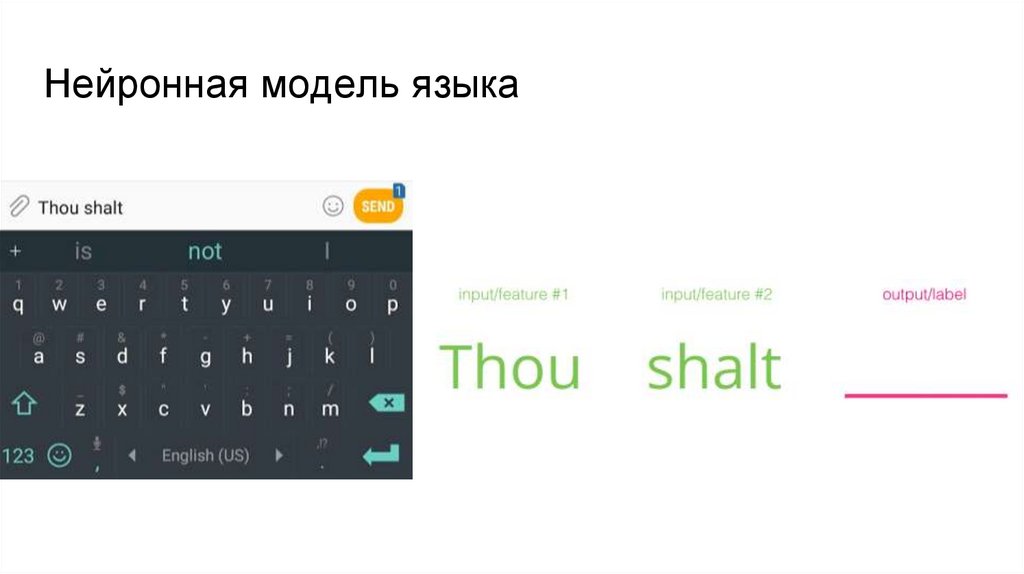

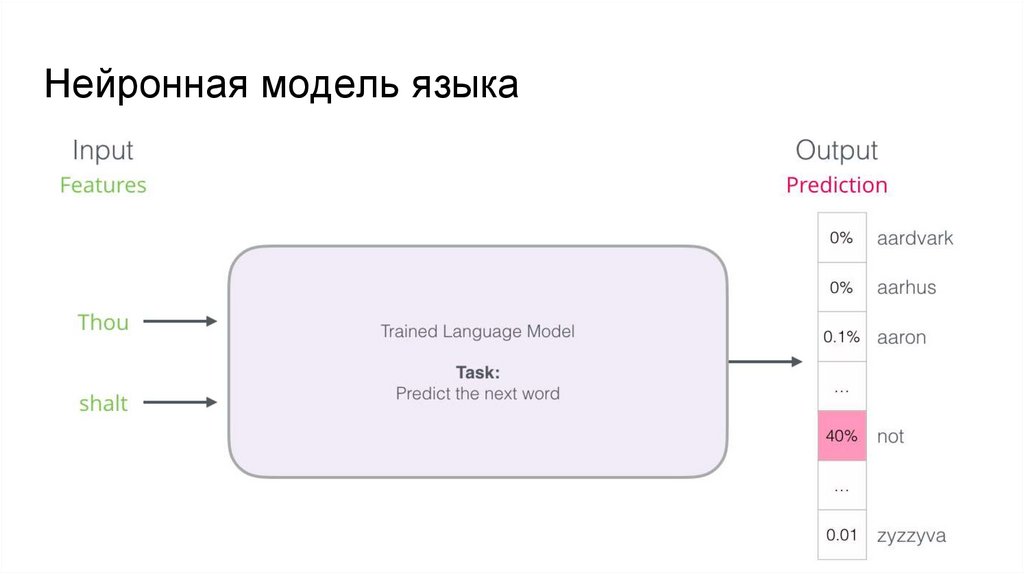

29. Нейронная модель языка

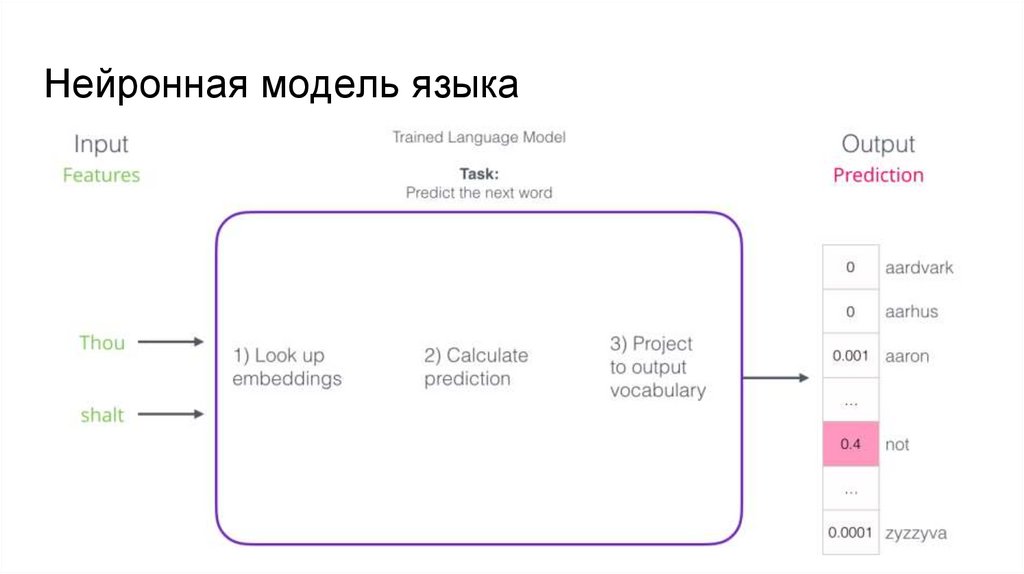

30. Нейронная модель языка

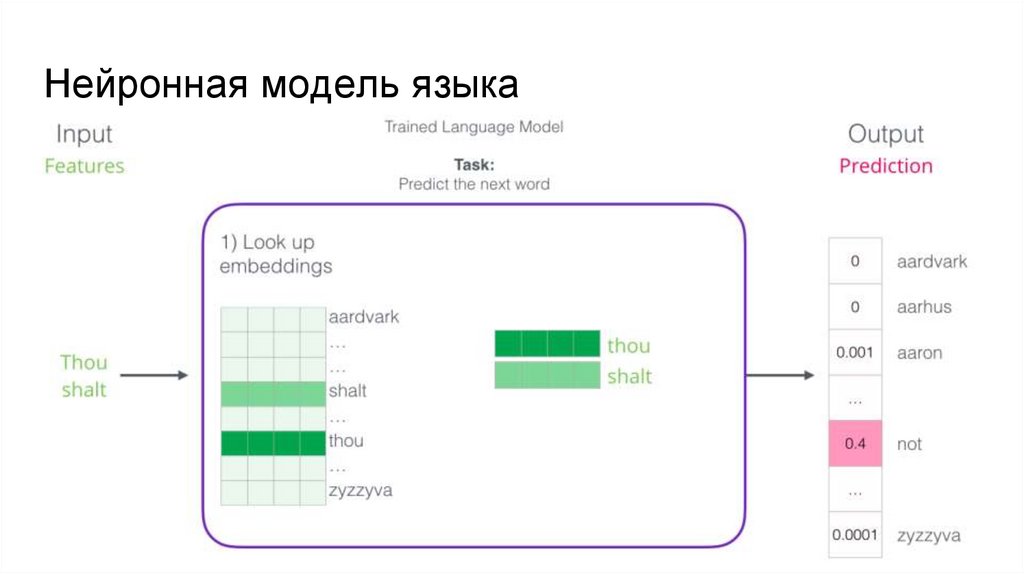

31. Нейронная модель языка

32. Нейронная модель языка

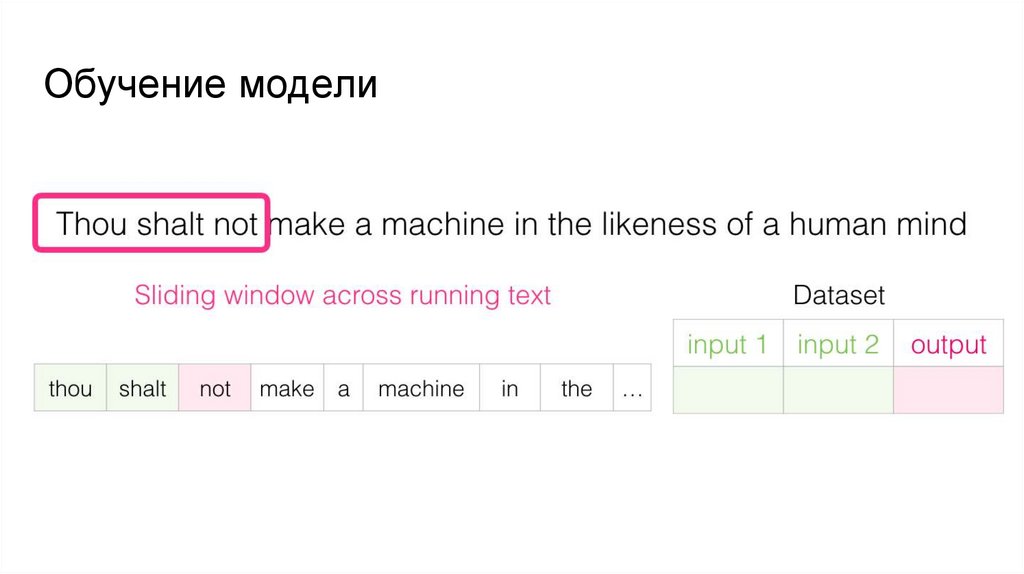

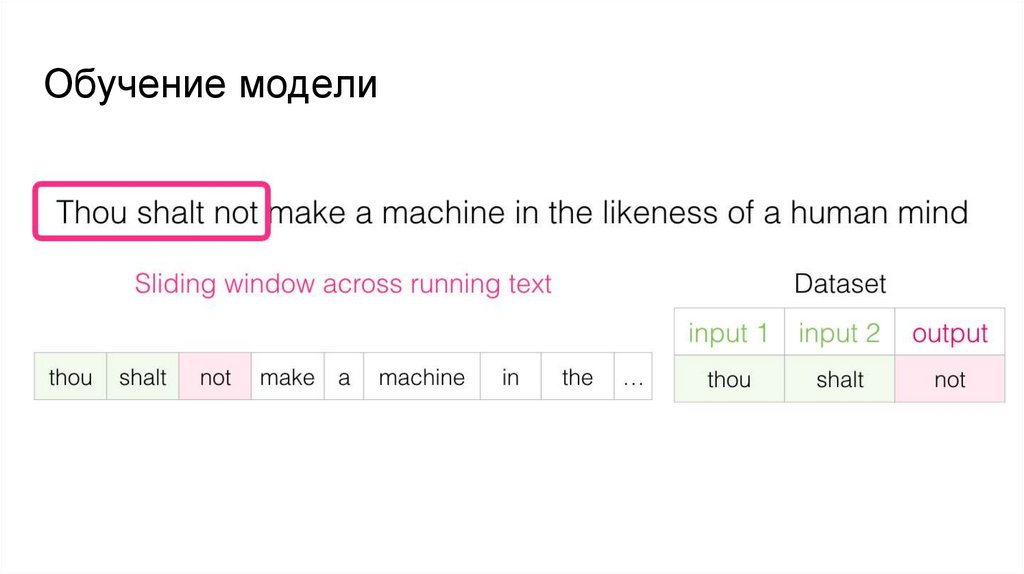

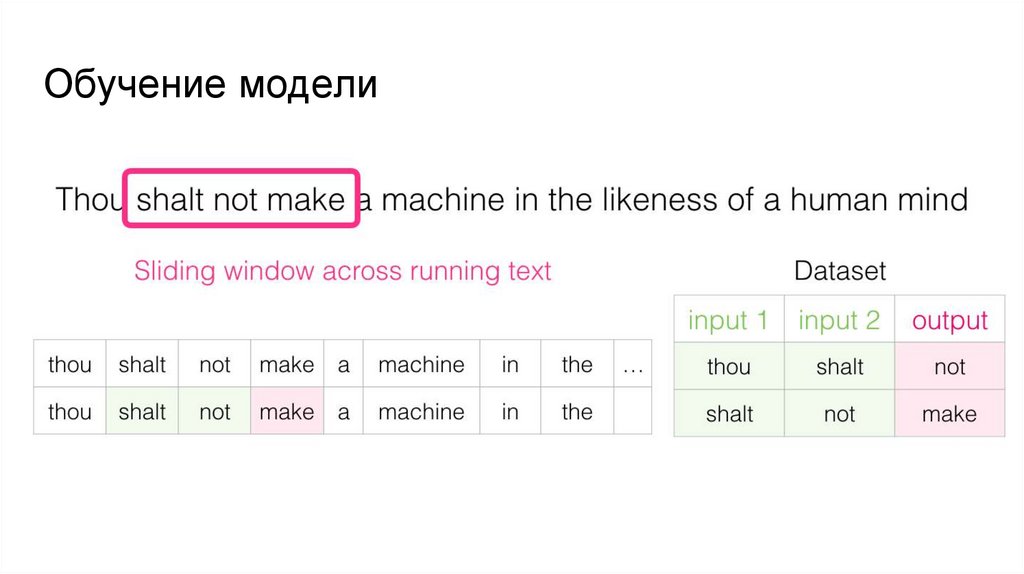

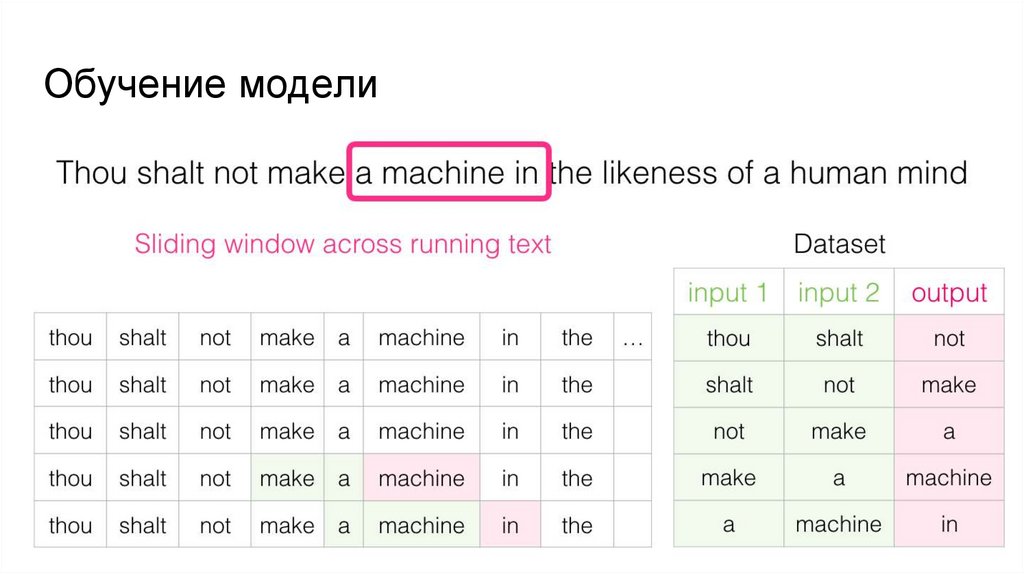

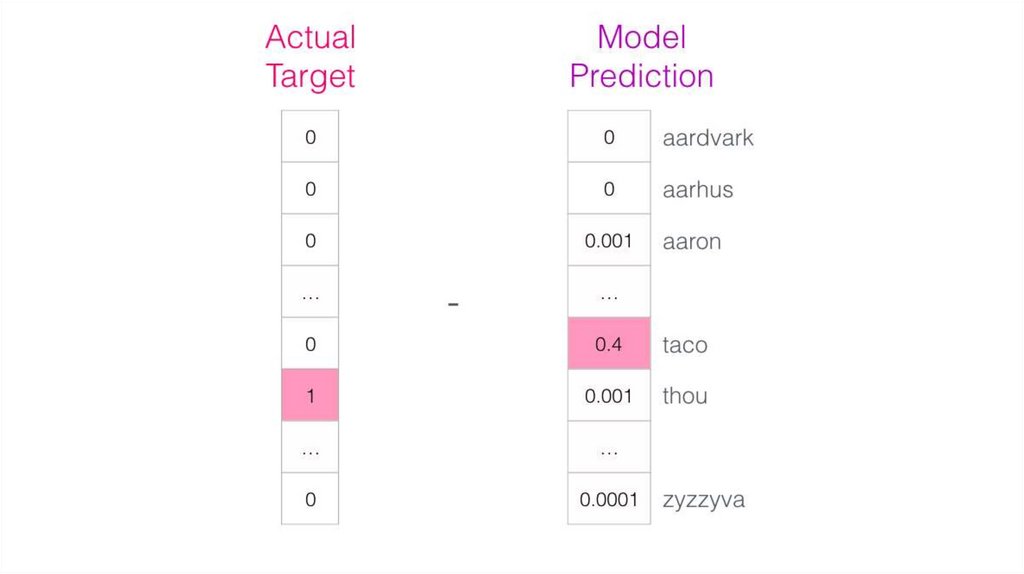

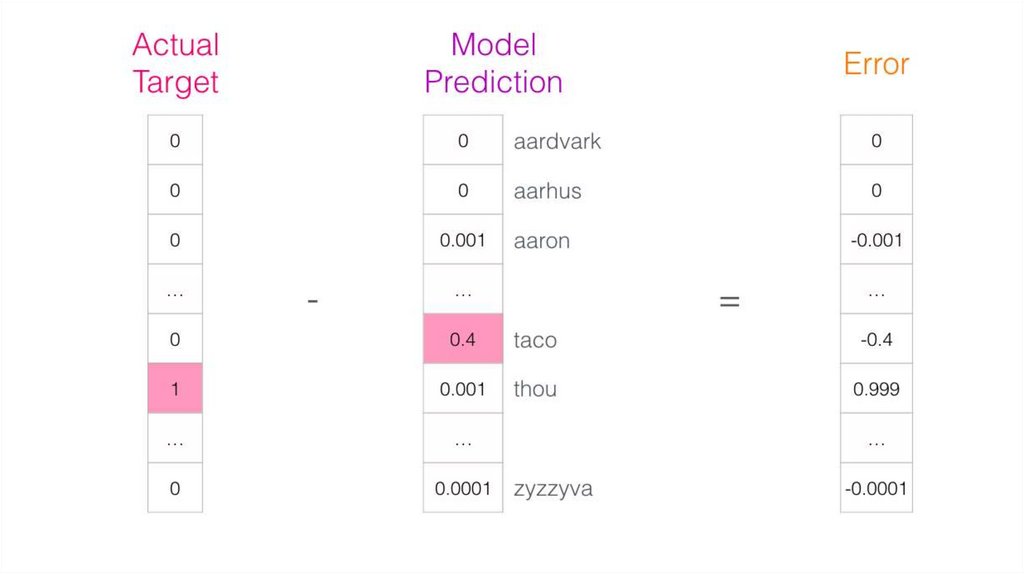

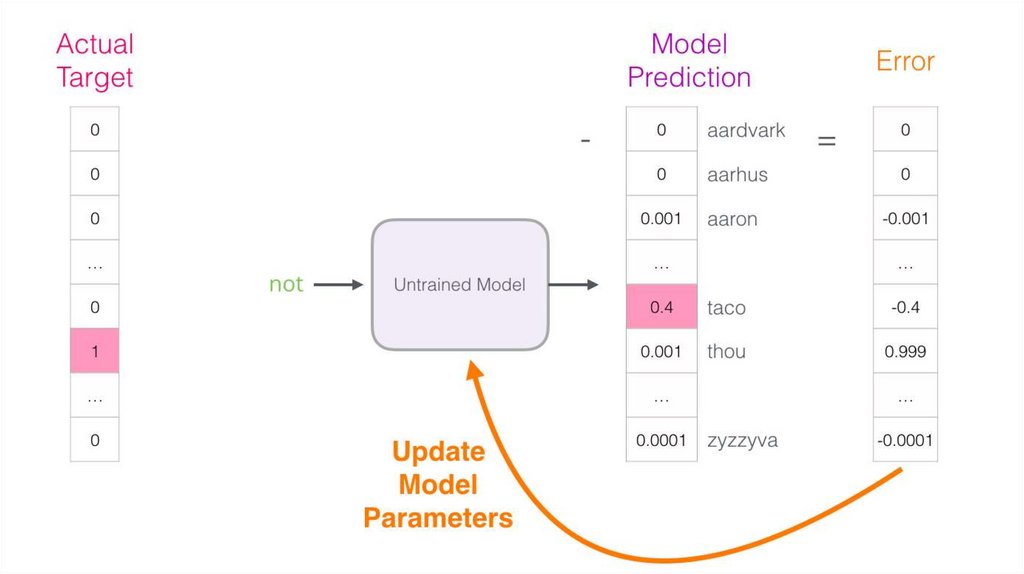

33. Обучение модели

34. Обучение модели

35. Обучение модели

36. Обучение модели

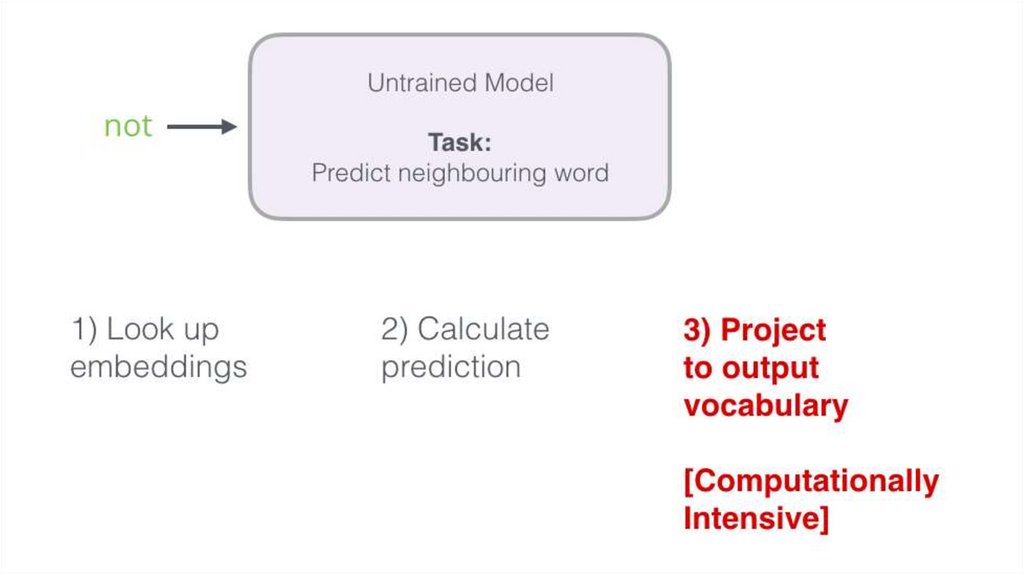

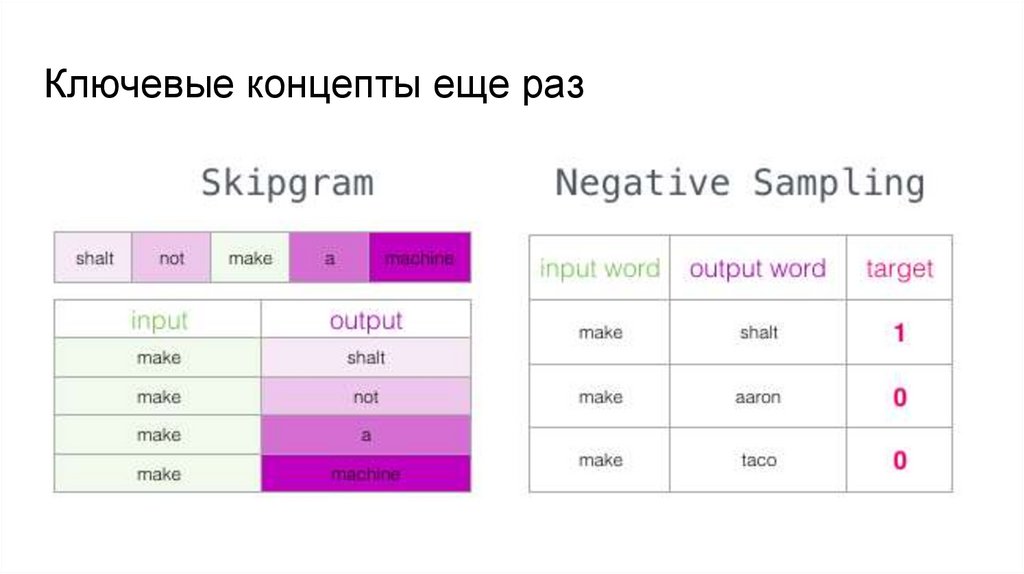

37. Как работает word2vec?

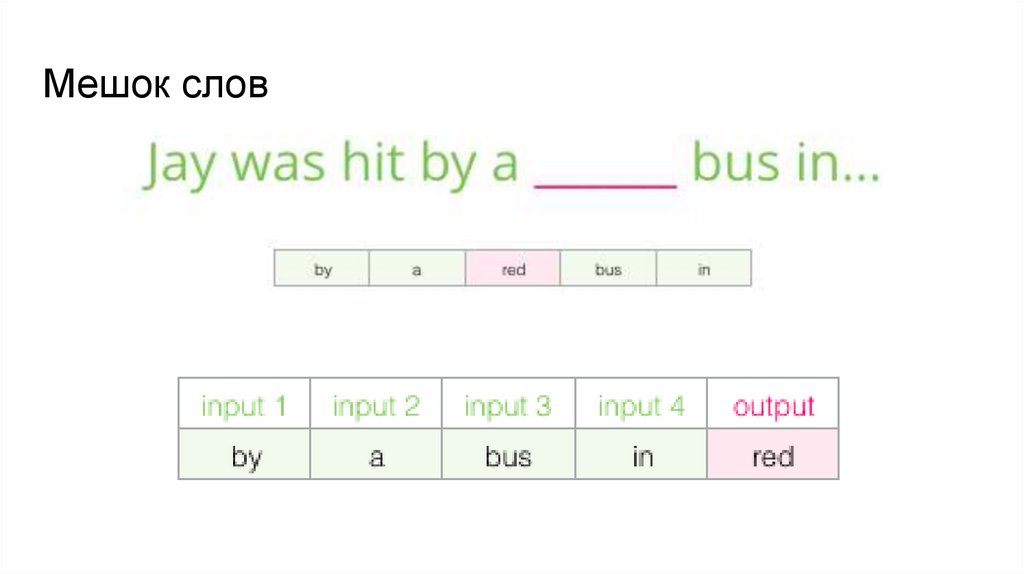

Обучение модели более формально:● CBOW предсказывает текущее слово, исходя из окружающего его

контекста.

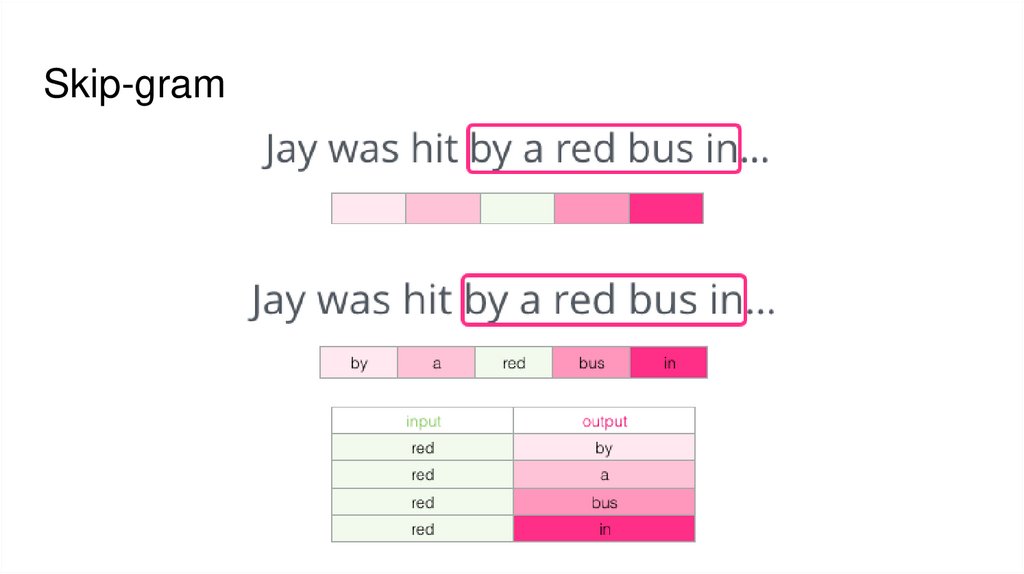

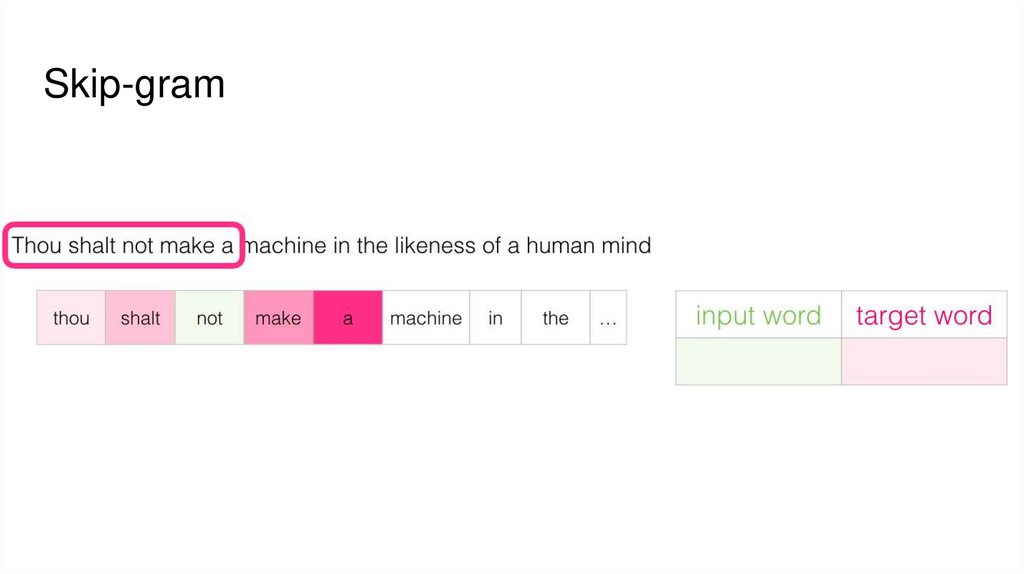

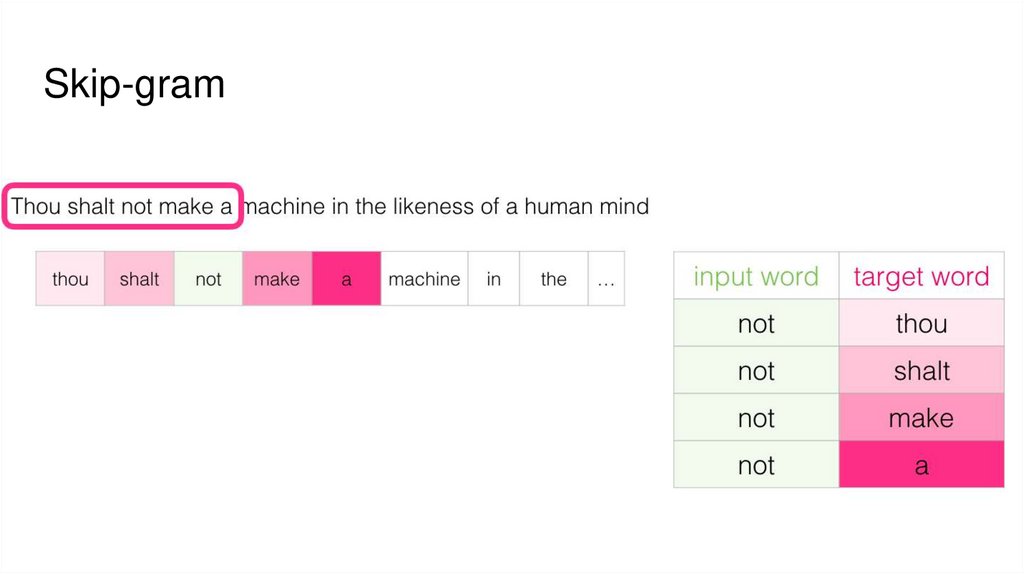

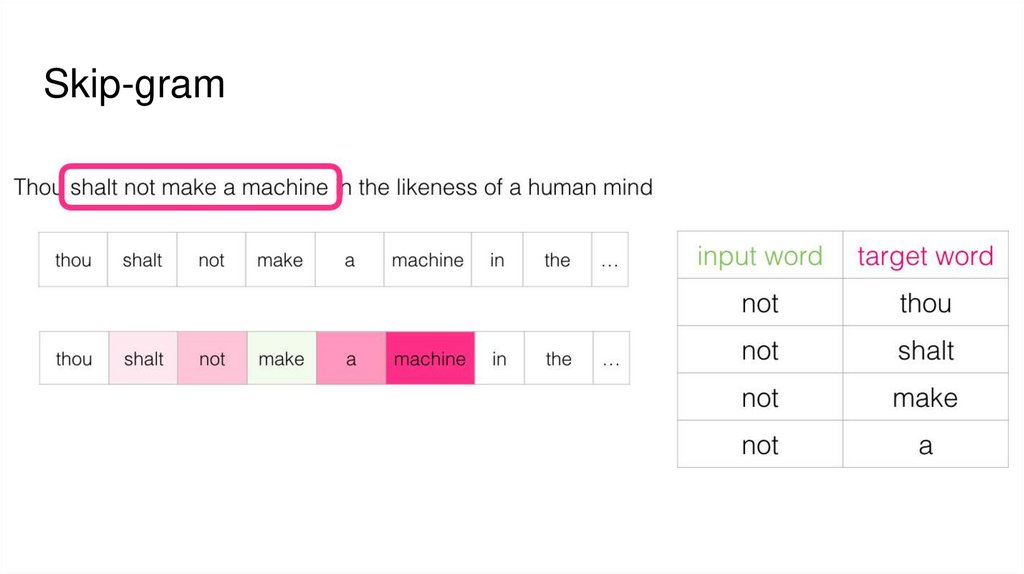

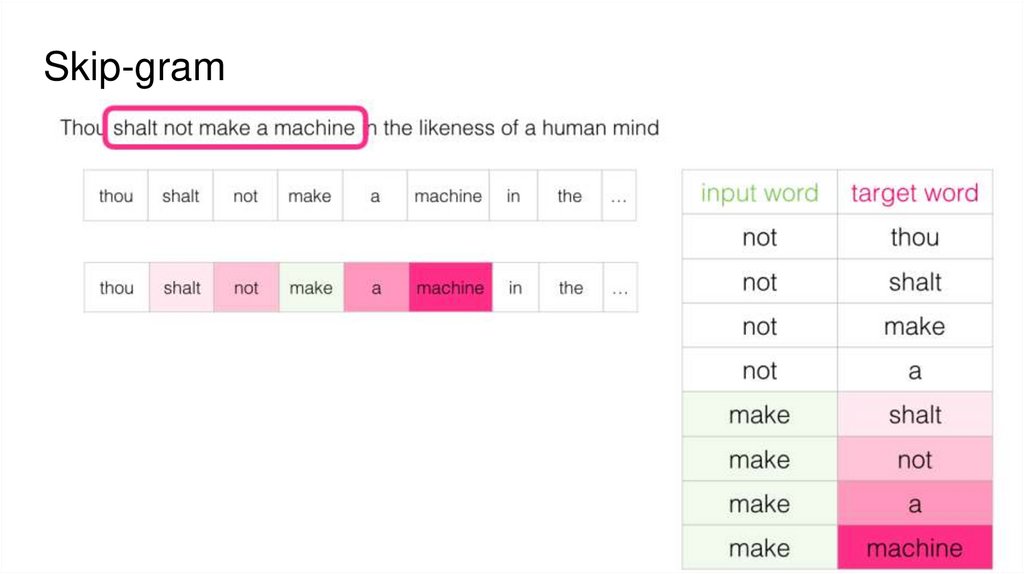

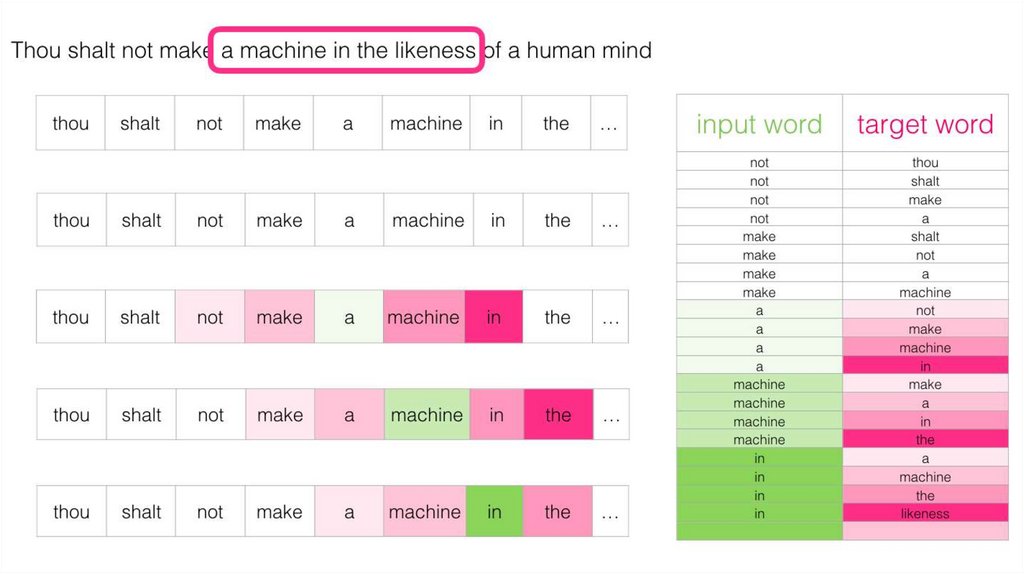

● Skip-gram, наоборот, использует текущее слово, чтобы предугадывать

окружающие его слова.

38. Мешок слов

39. Skip-gram

40. Skip-gram

41. Skip-gram

42. Skip-gram

43. Skip-gram

44. Skip-gram

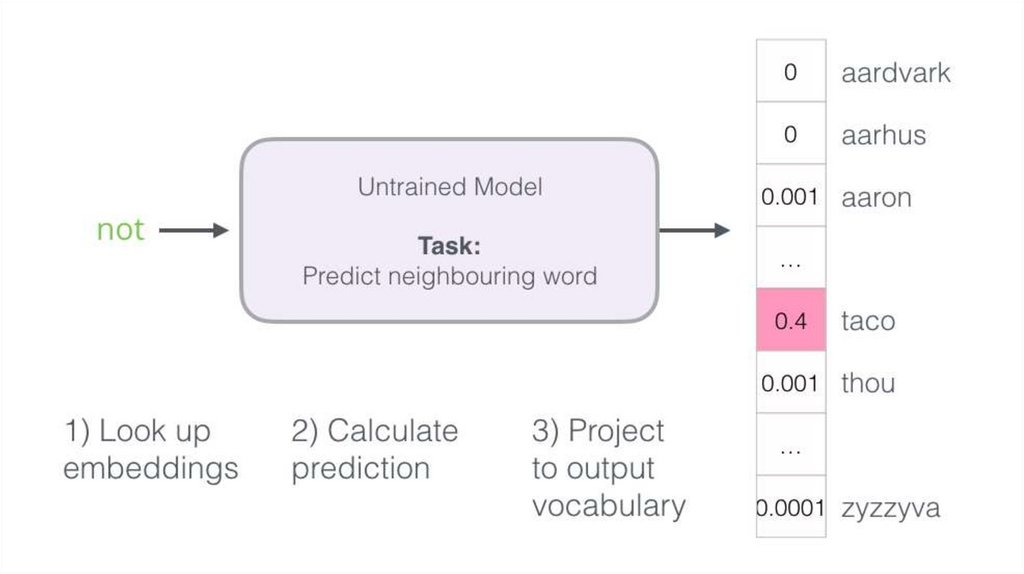

45. Предсказываем слова

46.

47.

48.

49.

50.

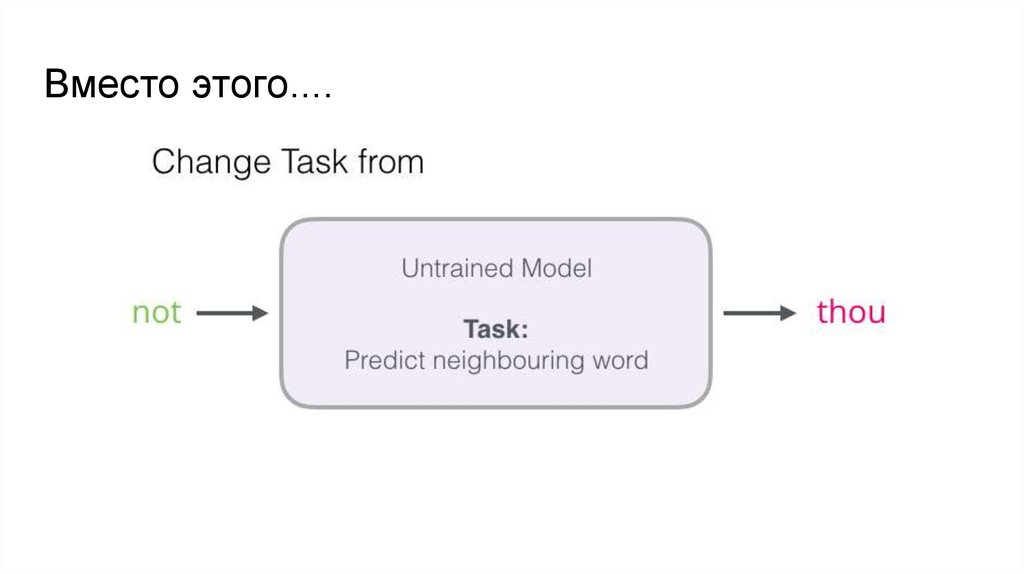

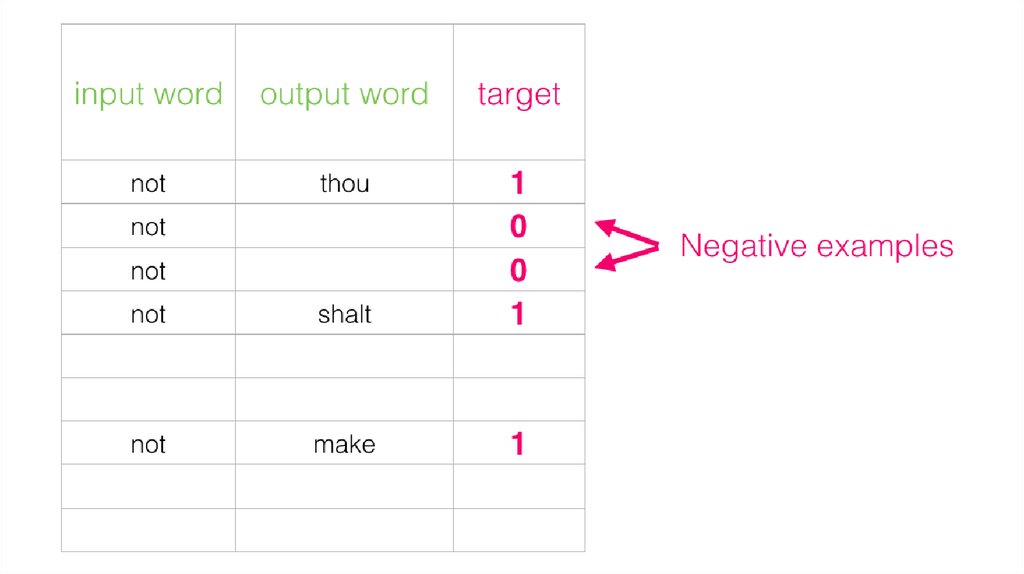

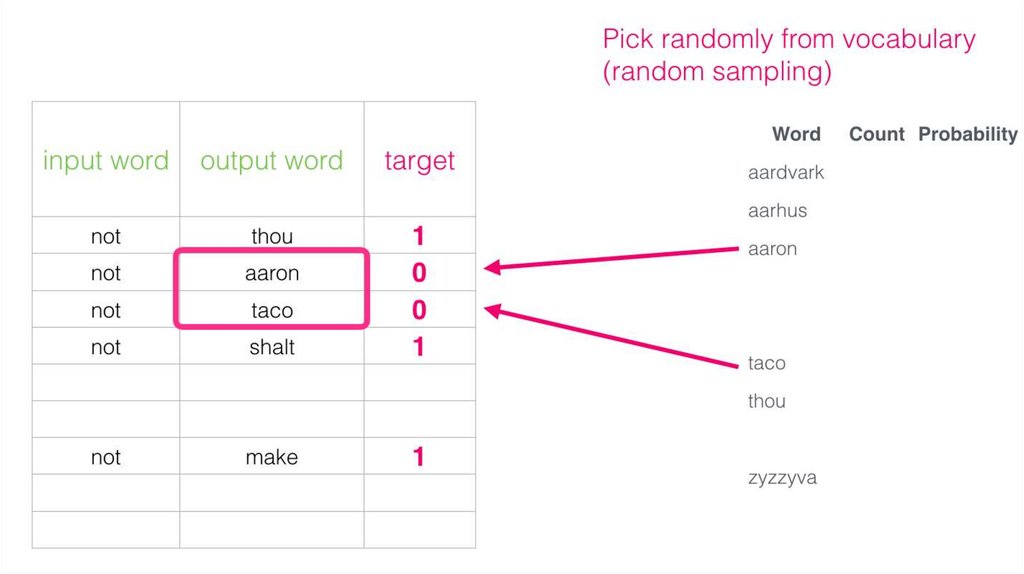

51. Вместо этого....

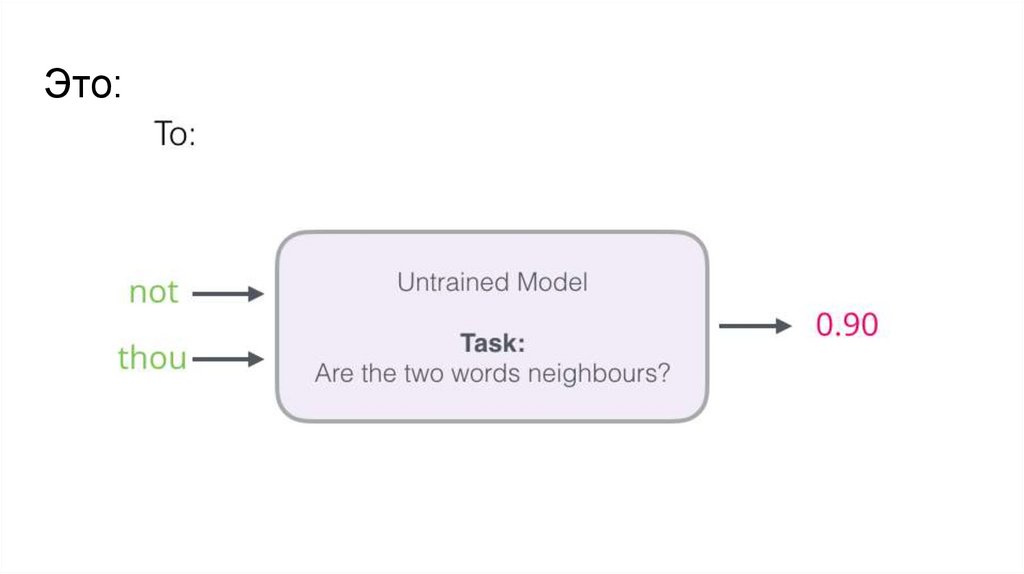

52. Это:

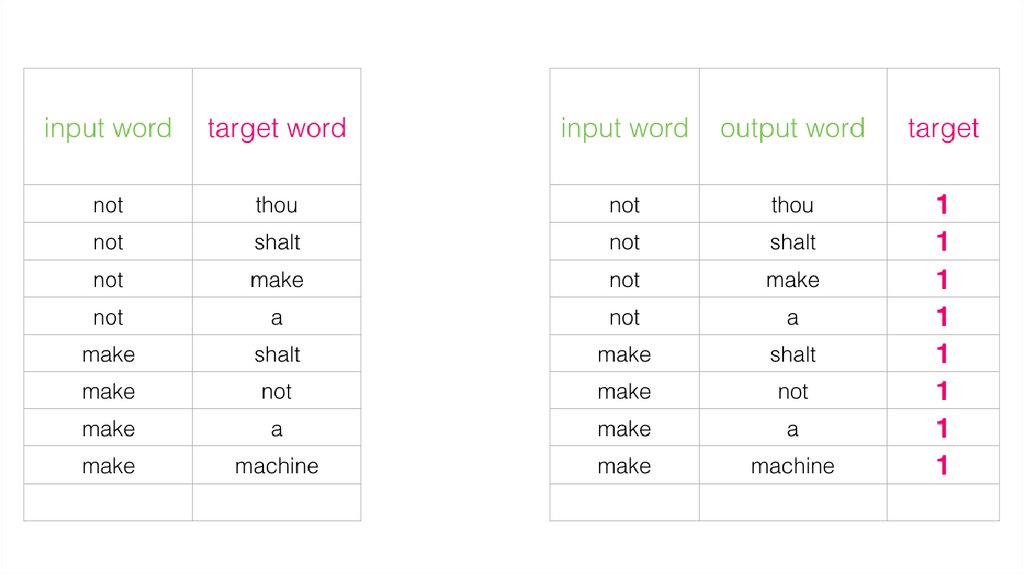

53.

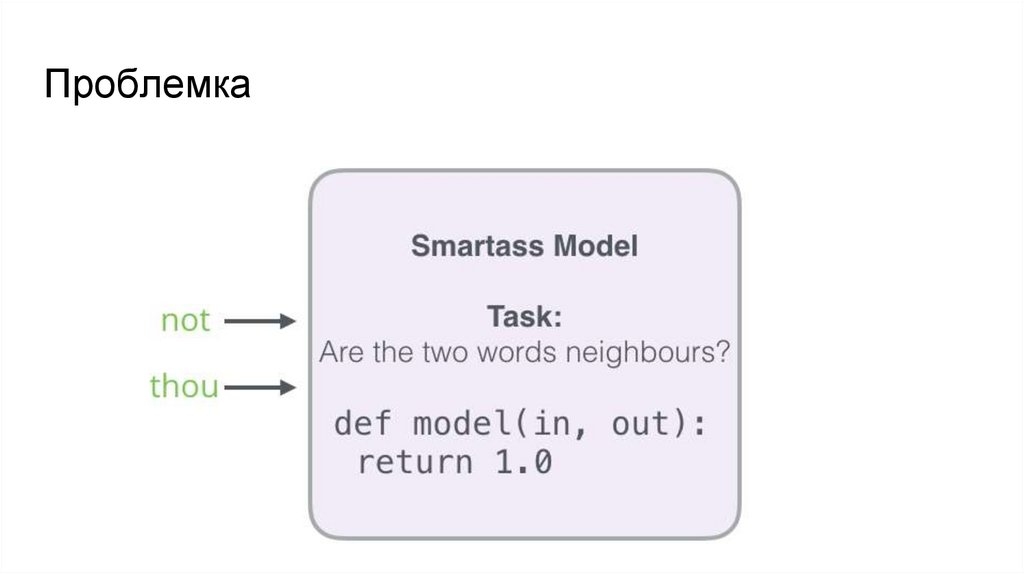

54. Проблемка

55.

56.

57. Ключевые концепты еще раз

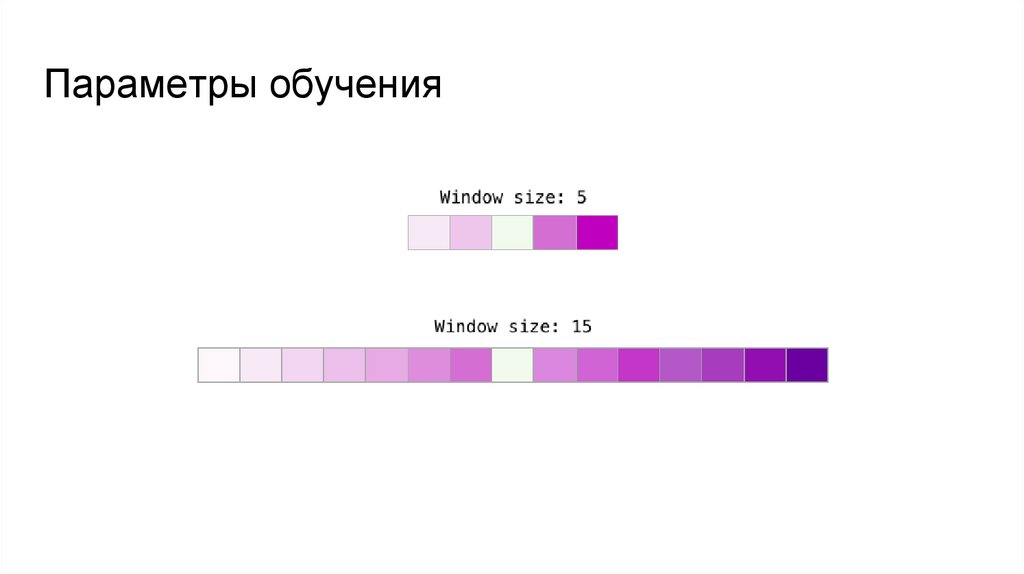

58. Параметры обучения

59. Параметры обучения

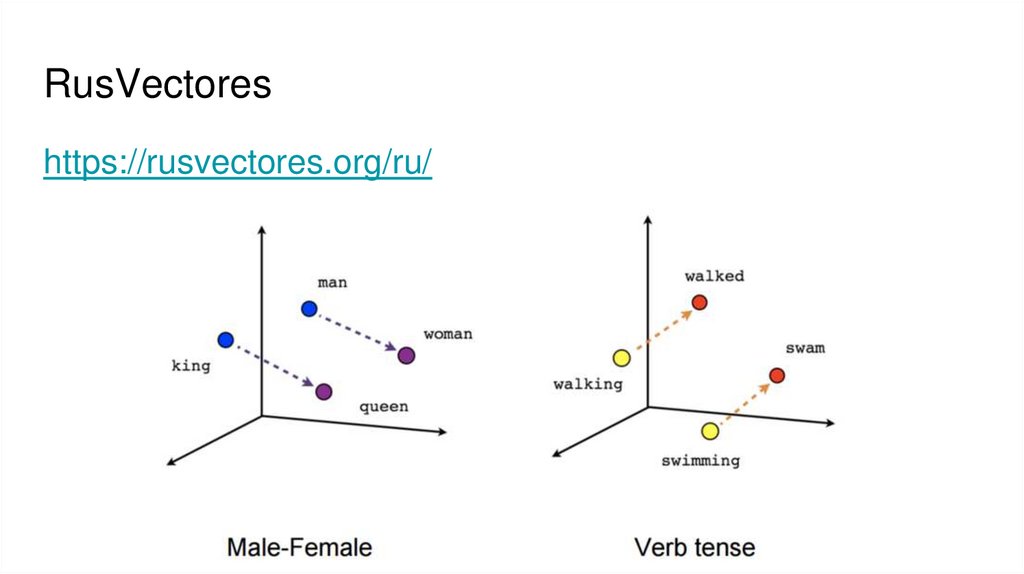

60. RusVectores

https://rusvectores.org/ru/61. Векторные романы

Ещё давайте посмотрим на векторные романыhttps://nevmenandr.github.io/novel2vec/

62. Пирожки в дистрибутивной семантике

https://habr.com/ru/post/275913/

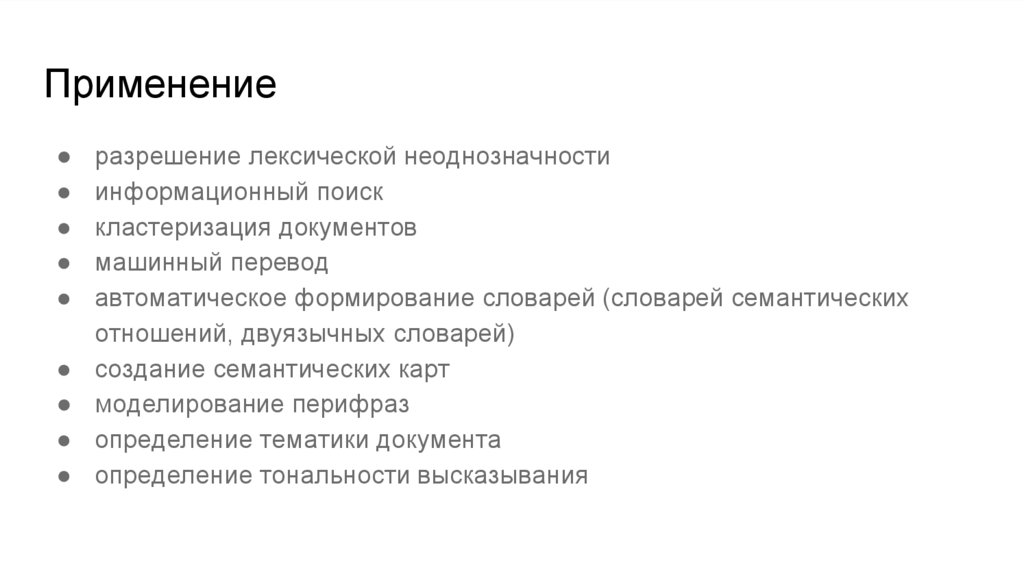

63. Применение

разрешение лексической неоднозначности

информационный поиск

кластеризация документов

машинный перевод

автоматическое формирование словарей (словарей семантических

отношений, двуязычных словарей)

создание семантических карт

моделирование перифраз

определение тематики документа

определение тональности высказывания

Математика

Математика Лингвистика

Лингвистика