Похожие презентации:

Информационные технологии. Информатика (для заочников)

1.

Зырянова СветланаАнатольевна

Кафедра

«Информационные

технологии»

ауд. № 359 (2 корпус)

2. Информатика

Термин "информатика" (франц. informatique)происходит

от

французских

слов

information

(информация) и automatique (автоматика) и дословно

означает "информационная автоматика".

Широко распространён также англоязычный вариант

этого термина — "Сomputer science", что означает

буквально "компьютерная наука".

Инфоpматика — это основанная на использовании

компьютерной

техники

дисциплина,

изучающая

структуру и общие свойства информации, а также

закономерности и методы её создания, хранения,

поиска, преобразования, передачи и применения в

различных сферах человеческой деятельности.

3.

В 1978 году международный научный конгрессофициально закрепил за понятием "информатика"

области, связанные с разработкой, созданием,

использованием

и

материально-техническим

обслуживанием систем обработки информации,

включая

компьютеры

и

их

программное

обеспечение,

а

также

организационные,

коммерческие, административные и социальнополитические

аспекты

компьютеризации

—

массового внедрения компьютерной техники во все

области жизни людей.

4.

Приоритетные направления информатики:1.Разpаботка

вычислительных

систем

и

пpогpаммного

обеспечения;

2.Теоpия инфоpмации, изучающая процессы, связанные с передачей,

приёмом, преобразованием и хранением информации;

3.Математическое моделирование, методы вычислительной и

прикладной математики и их применение к фундаментальным и

прикладным исследованиям в различных областях знаний;

4.Методы искусственного интеллекта, моделирующие методы

логического

и

аналитического

мышления

в

интеллектуальной

деятельности человека (логический вывод, обучение, понимание речи,

визуальное восприятие, игры и др.);

5.Системный анализ, изучающий методологические средства,

используемые для подготовки и обоснования решений по сложным

проблемам различного характера;

6.Биоинформатика, изучающая информационные процессы в

биологических системах;

7.Социальная информатика, изучающая процессы информатизации

общества;

8.Методы машинной графики, анимации, средства мультимедиа;

9.Телекоммуникационные системы и сети

10.Разнообразные

пpиложения,

охватывающие

все

виды

хозяйственной и общественной деятельности.

5. Информация (informatio, лат.) – разъяснение, изложение

• для конкретного человека – интересующиеего сведения об окружающем мире;

• в широком смысле слова – отражение

реального мира, выражаемое в виде

сигналов и знаков;

6. Информация

• в теории связи – сообщения в формезнаков или сигналов, которые хранятся,

обрабатываются и передаются с

помощью технических средств;

• в теории управления – знания,

которые используются в управлении

для сохранения и развития системы;

7.

Измерение информации4 подхода к измерению информации:

1. Объемный подход

2. Алфавитный подход

3. Содержательный подход

4. Вероятностный подход

8.

1. Объемный подход.Это измерение информации с точки зрения объема,

который она занимает в памяти ЭВМ.

Наименьшая единица информации – БИТ (0;1).

1 БАЙТ = 23 БИТ = 8 БИТ

Более крупными единицами измерения

информации являются:

1Кбайт (Килобайт) = 210 байт = 1024 байт

1Мбайт (Мегабайт) = 210 Кбайт = 1024 Кбайт

1Гбайт (Гигабайт) = 210 Мбайт = 1024 Мбайт

1Тбайт (Терабайт) = 210 Гбайт = 1024 Гбайт

1Пбайт (Петабайт) = 210 Тбайт = 1024 Тбайт

9.

Пример 1. Получено сообщение, объёмкоторого равен 45 битам. Определить, чему

равен объём сообщения в Кбайтах.

Решение: V (объем сообщения) = 45 бит.

Переведем биты в Кбайты.

45

V = 45бит байт 5,625байт

8

5,625

Кбайт 0,0055 Кбайт

10

2

10.

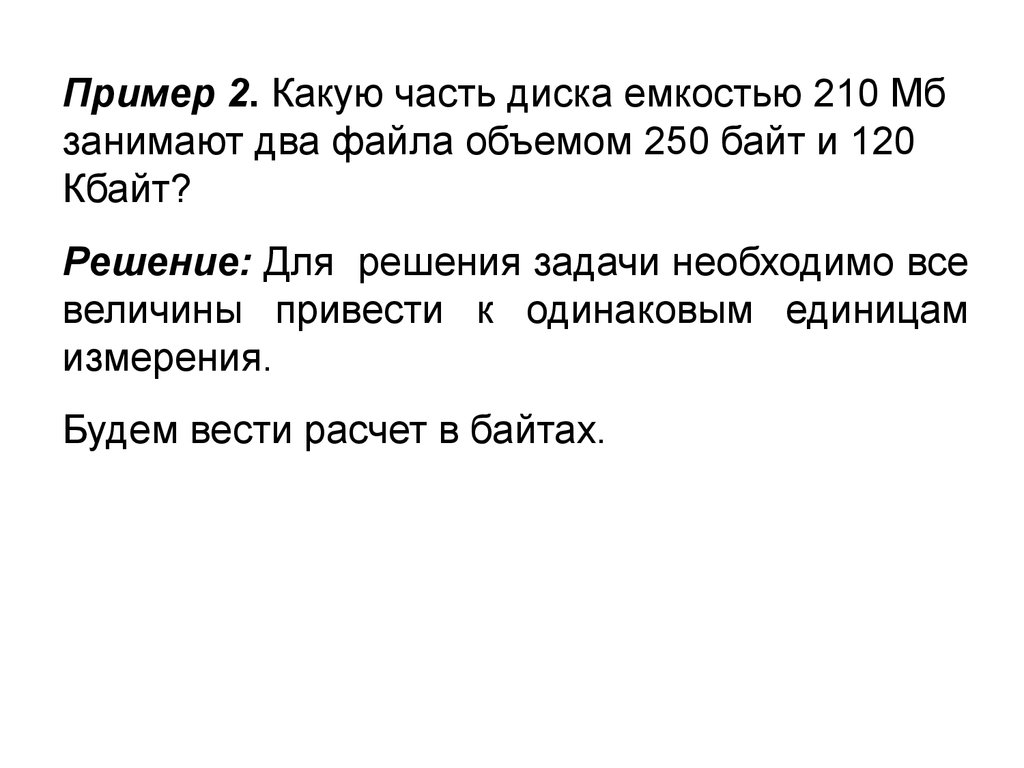

Пример 2. Какую часть диска емкостью 210 Мбзанимают два файла объемом 250 байт и 120

Кбайт?

Решение: Для решения задачи необходимо все

величины привести к одинаковым единицам

измерения.

Будем вести расчет в байтах.

11.

V1 (объем 1-го файла) = 250 байт;V2 (объем 2-го файла) = 120 Кбайт =

120 * 1024 байт = 122 880 байт;

Vдиска = 210 Мбайт = 210 * 1024 Кбайт =

=210 *1024 *1024 байт = 220 200 960 байт

Тогда С (часть диска) = (V1 + V2) / V диска =

(250+122 880)/220 200 960 0.00056 =

0.00056*100% = 0.056%

12.

2. Алфавитный подход к измерениюинформации

Это измерение информации с точки зрения

алфавита, с помощью которого она записана.

Введем обозначения:

N – мощность алфавита

(количество символов в алфавите).

Пример:

Мощность русского алфавита – 33 буквы;

мощность английского алфавита – 26 букв;

мощность компьютерного алфавита – 256

символов.

13.

i – количество информации, котороенесет один символ (бит).

Формула, которая связывает эти две

величины:

N=2i

i = log2N

14.

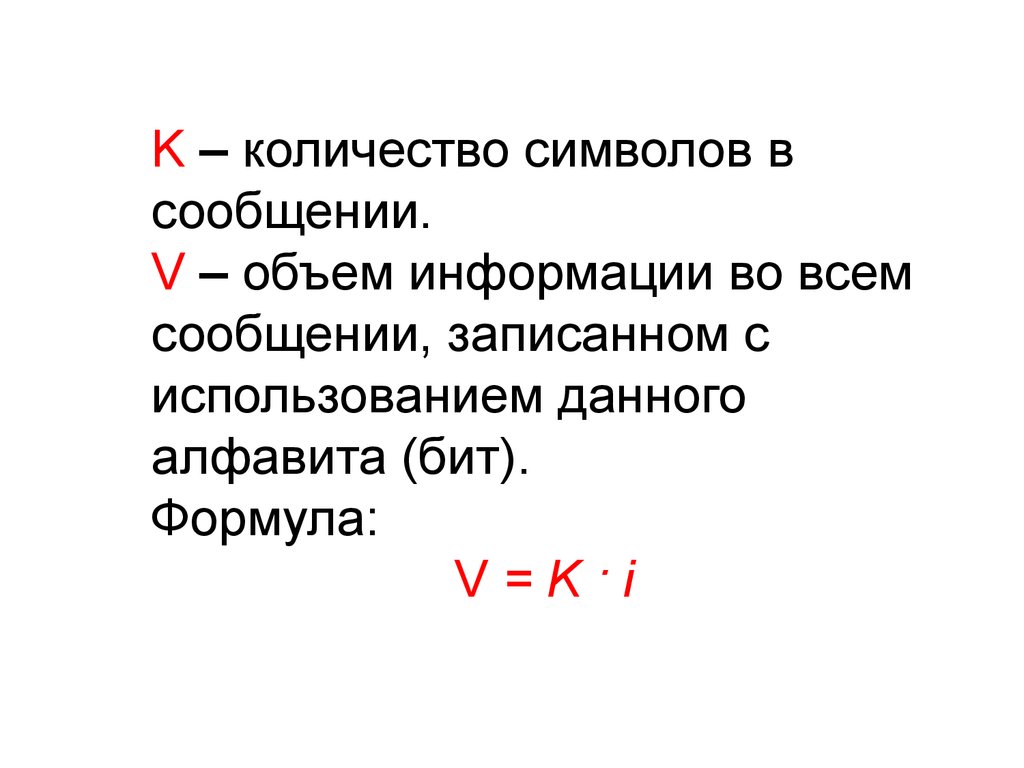

K – количество символов всообщении.

V – объем информации во всем

сообщении, записанном с

использованием данного

алфавита (бит).

Формула:

V=K·i

15.

Пример 1.Сообщение записано 32-х символьным

алфавитом и содержит 30 символов.

Какой объём информации оно несёт?

N = 32

символа

K = 30

символов.

V–?

Ответ: V=150 бит

V=K·i

i = log2N

i = log2N = log232

= 5 (бит)

V = K · i = 30 · 5

= 150 (бит)

16.

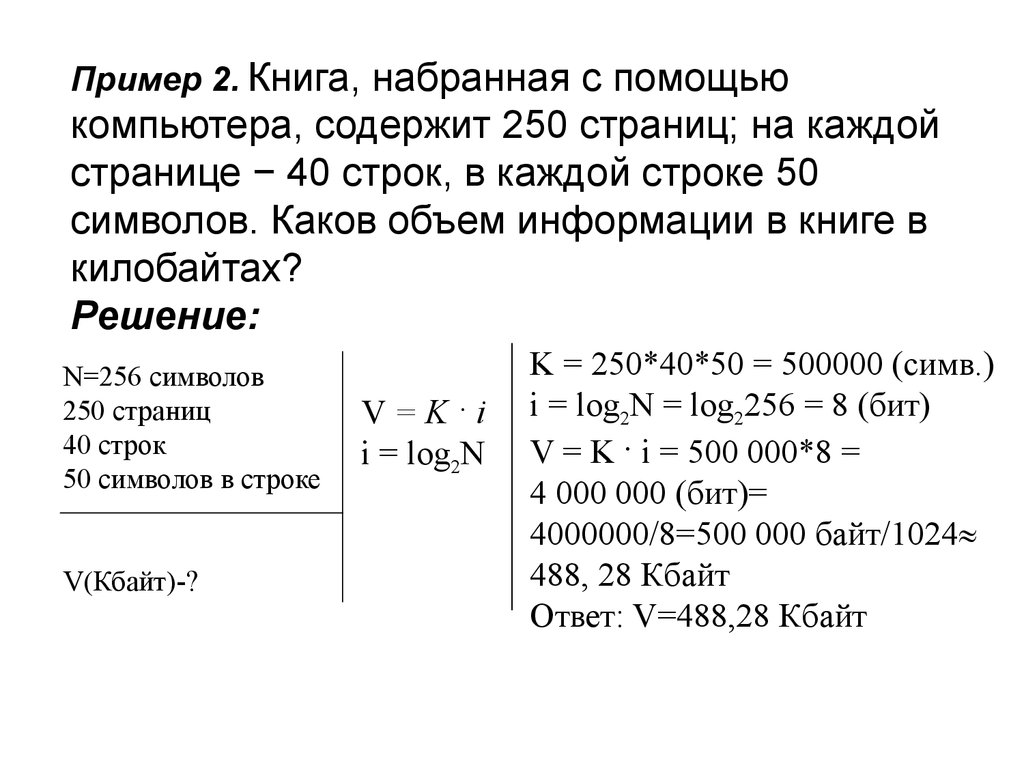

Пример 2. Книга, набранная с помощьюкомпьютера, содержит 250 страниц; на каждой

странице − 40 строк, в каждой строке 50

символов. Каков объем информации в книге в

килобайтах?

Решение:

N=256 символов

250 страниц

40 строк

50 символов в строке

V(Кбайт)-?

V=K·i

i = log2N

K = 250*40*50 = 500000 (симв.)

i = log2N = log2256 = 8 (бит)

V = K · i = 500 000*8 =

4 000 000 (бит)=

4000000/8=500 000 байт/1024

488, 28 Кбайт

Ответ: V=488,28 Кбайт

17.

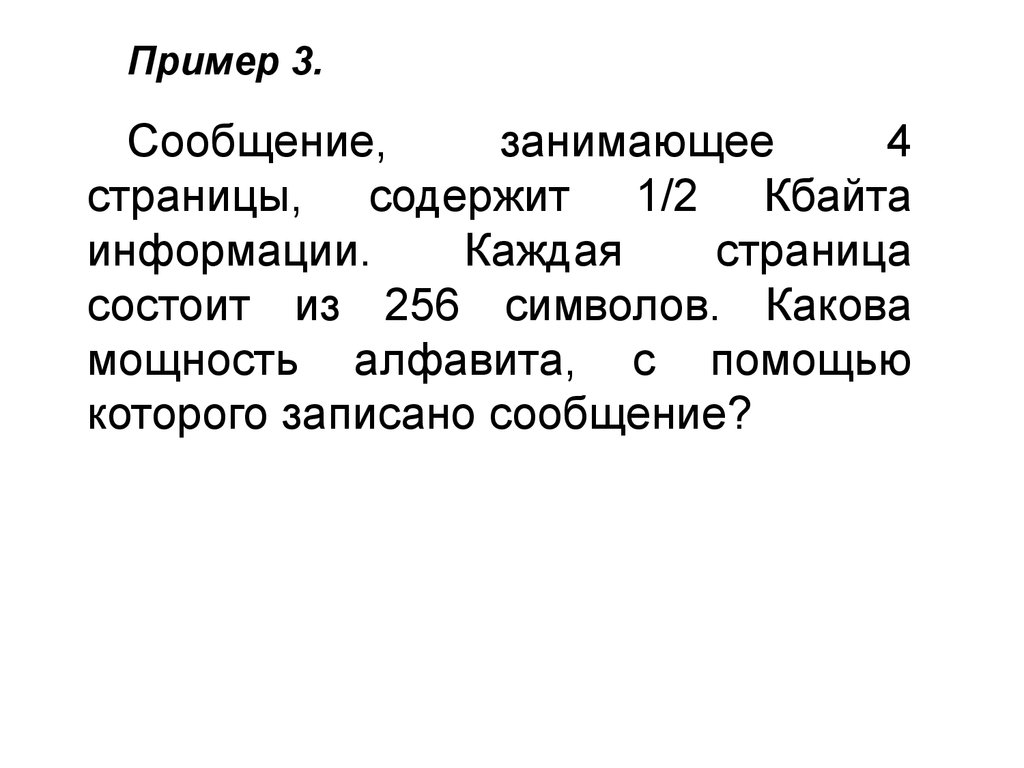

Пример 3.Сообщение,

занимающее

4

страницы, содержит 1/2 Кбайта

информации.

Каждая

страница

состоит из 256 символов. Какова

мощность алфавита, с помощью

которого записано сообщение?

18.

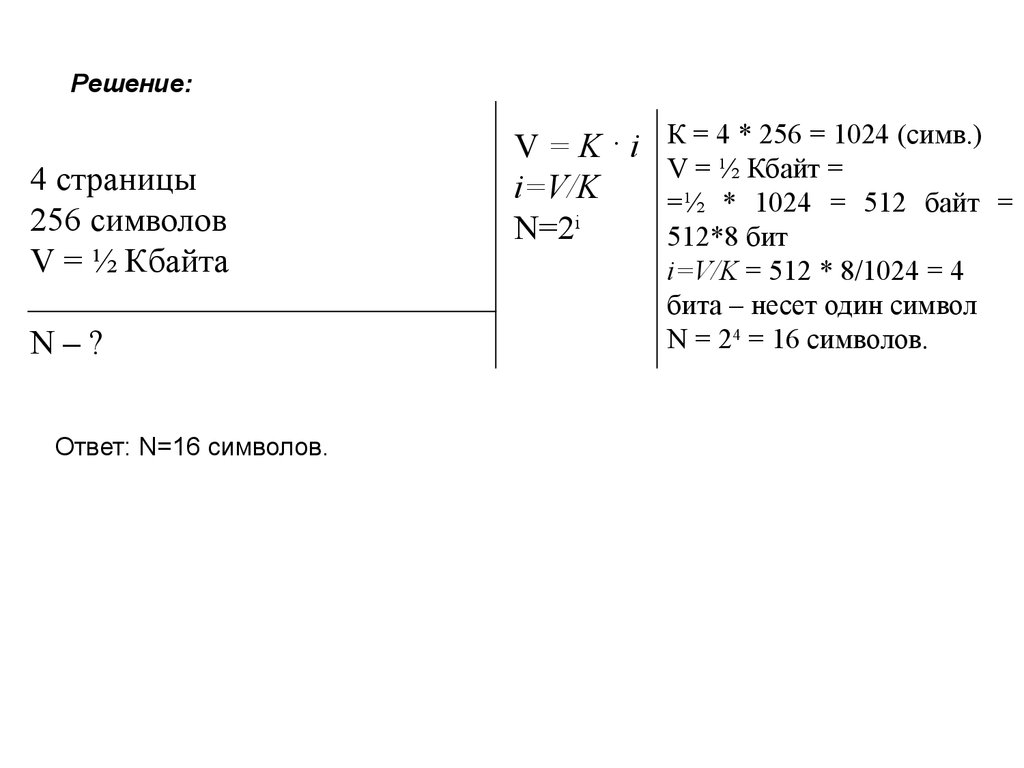

Решение:4 страницы

256 символов

V = ½ Кбайта

N–?

Ответ: N=16 символов.

V=K·i

i=V/K

N=2i

К = 4 * 256 = 1024 (симв.)

V = ½ Кбайт =

=½ * 1024 = 512 байт =

512*8 бит

i=V/K = 512 * 8/1024 = 4

бита – несет один символ

N = 24 = 16 символов.

19.

3. Содержательный подход к измерениюинформации

Это измерение информации с точки зрения

качественной оценки информации: нужности,

важности, интересности и т.д. информации.

Все люди имеющуюся информацию

оценивать по-разному.

Кому-то она важна, кому-то бесполезна;

кому-то интересна, кому-то – нет.

могут

20.

Введем обозначения:N – количество равновероятных событий

(т.е. ни одно событие не имеет

преимуществ перед другим).

х - количество информации в сообщении о

том, что произошло одно из N

равновероятных событий (бит).

Формула, связывающая эти величины:

N=2х

х = log2 N

21.

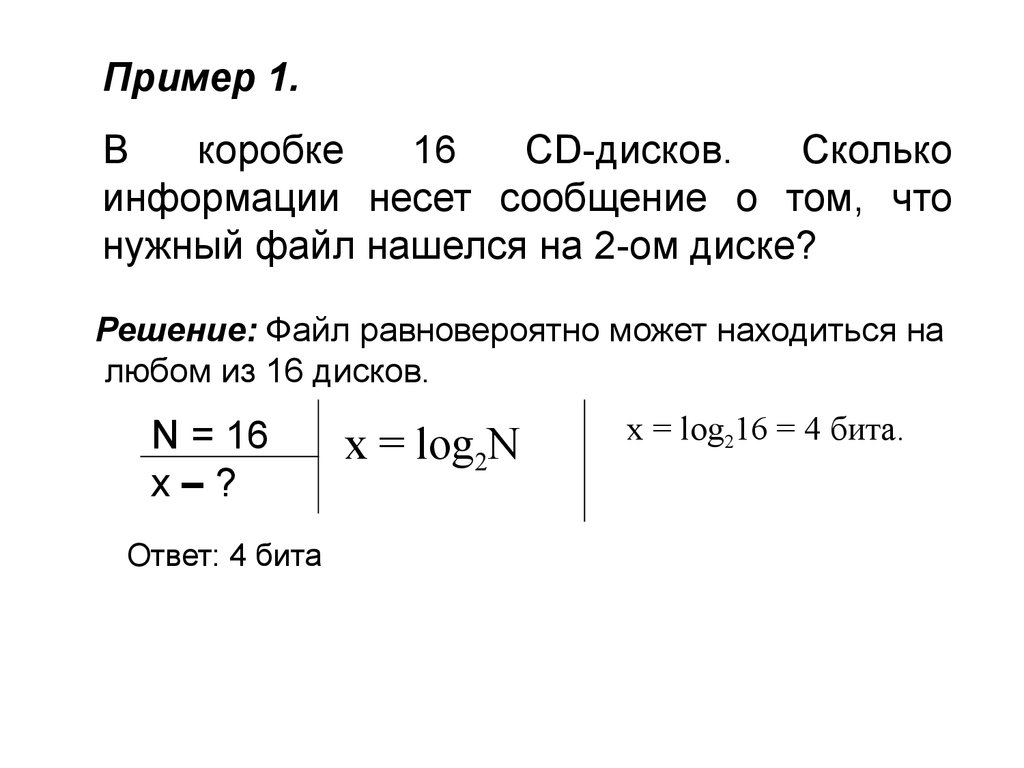

Пример 1.В

коробке

16

CD-дисков.

Сколько

информации несет сообщение о том, что

нужный файл нашелся на 2-ом диске?

Решение: Файл равновероятно может находиться на

любом из 16 дисков.

N = 16

х–?

Ответ: 4 бита

х = log2N

х = log216 = 4 бита.

22.

Пример 2.При угадывании целого числа в диапазоне от 1 до

M было получено 5 бит информации.

Чему равно М?

Решение:

х=5 бит

М-?

Ответ: М = 32

х=log2M

5 = log2М,

отсюда М = 25 = 32.

Т.е. мы угадывали число в диапазоне от 1 до 32.

Поясним подробно, откуда получается эта величина.

Если на вопрос можно ответить только «Да» или «Нет», то это

дает 1 бит информации и снижает неопределенность наших

знаний в 2 раза.

Итак, будем угадывать число из диапазона от 1 до 32.

23.

Допустим, мы загадали число 61 Вопрос: В диапазоне чисел от 1 до 32 ровно 32 числа: 16 чисел в

первой половине (от 1 до 16 включительно) и 16 чисел во второй половине

(от 17 до 32).

Зададим вопрос и ответом на него снизим нашу неопределенность

знаний об угадываемом числе в 2 раза.

Загаданное число больше 16? Ответ: НЕТ (1 бит информации мы

получили).

И теперь точно знаем, что число меньше или равно 16.

2 Вопрос: Аналогично предыдущему случаю: в первой половине (от 1

до 8) 8 чисел и во второй половине (от 9 до 16) тоже 8 чисел.

Загаданное число больше 8? Ответ: НЕТ (еще 1 бит информации мы

получили).

И теперь точно знаем, что число меньше или равно 8.

3 Вопрос: Аналогично предыдущему случаю: в первой половине (от 1

до 4) 4 числа и во второй половине (от 5 до 8) тоже 4 числа.

Загаданное число больше 4? Ответ: ДА (еще 1 бит информации мы

получили).

И теперь точно знаем, что число больше 4.

24.

4 Вопрос: Аналогично предыдущему случаю: впервой половине (от 5 до 6) 2 числа и во второй

половине (от 7 до 8) тоже 2 числа.

Загаданное число больше 6? Ответ: НЕТ (еще 1

бит информации мы получили).

И теперь точно знаем, что загаданное число или 5

или 6.

5 Вопрос:

Загаданное число 5? Ответ: НЕТ (еще 1 бит

информации мы получили).

И мы отгадали однозначно загаданное число – это 6.

Если посчитать сумму полученных бит информации –

получим 5 бит, т.е. для отгадывания числа из диапазона

от 1 до 32 необходимо ровно 5 бит информации.

25.

Пример 3. Сколько информации содержится всообщении о том, что из колоды карт достали

случайным образом даму Пик (колода 36 карт)?

Решение:

х = log 2 36 = 5,16993 бит

P.S. Для нахождения значений log 2 a можно

воспользоваться MS Excel. Для этого в ячейке

используем формулу =log(a; 2) – вычисление

логарифма числа a по основанию 2. Для нашего

примера вычисляем = log (36; 2).

26.

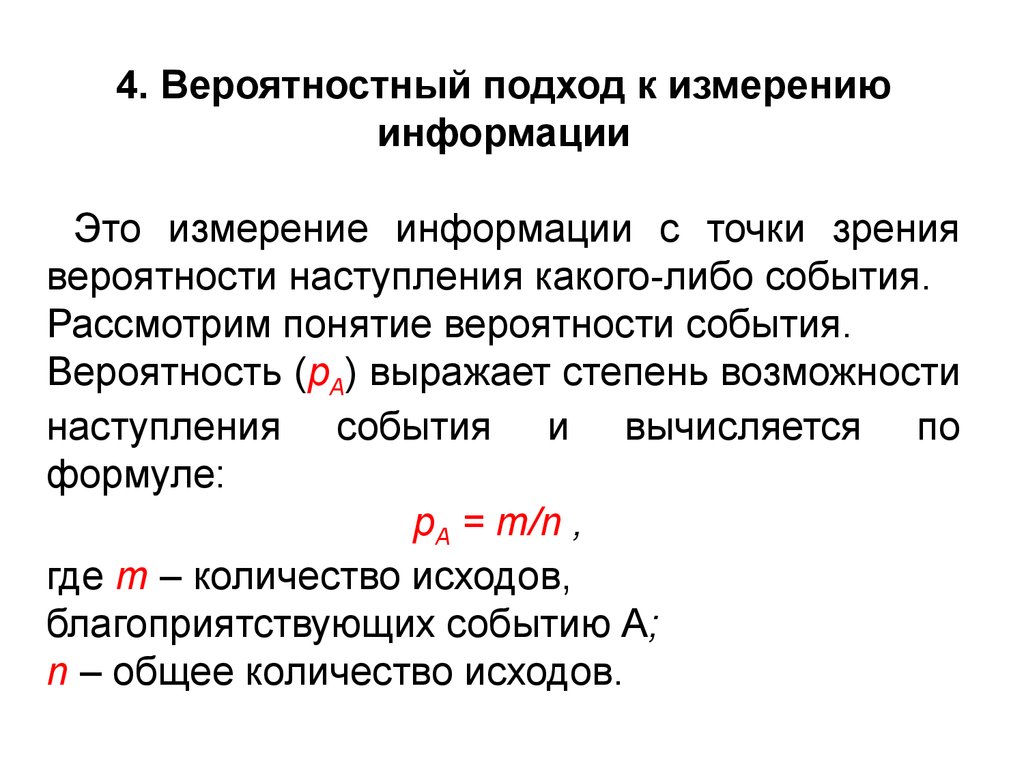

4. Вероятностный подход к измерениюинформации

Это измерение информации с точки зрения

вероятности наступления какого-либо события.

Рассмотрим понятие вероятности события.

Вероятность (pА) выражает степень возможности

наступления события и вычисляется по

формуле:

pА = m/n ,

где m – количество исходов,

благоприятствующих событию А;

n – общее количество исходов.

27.

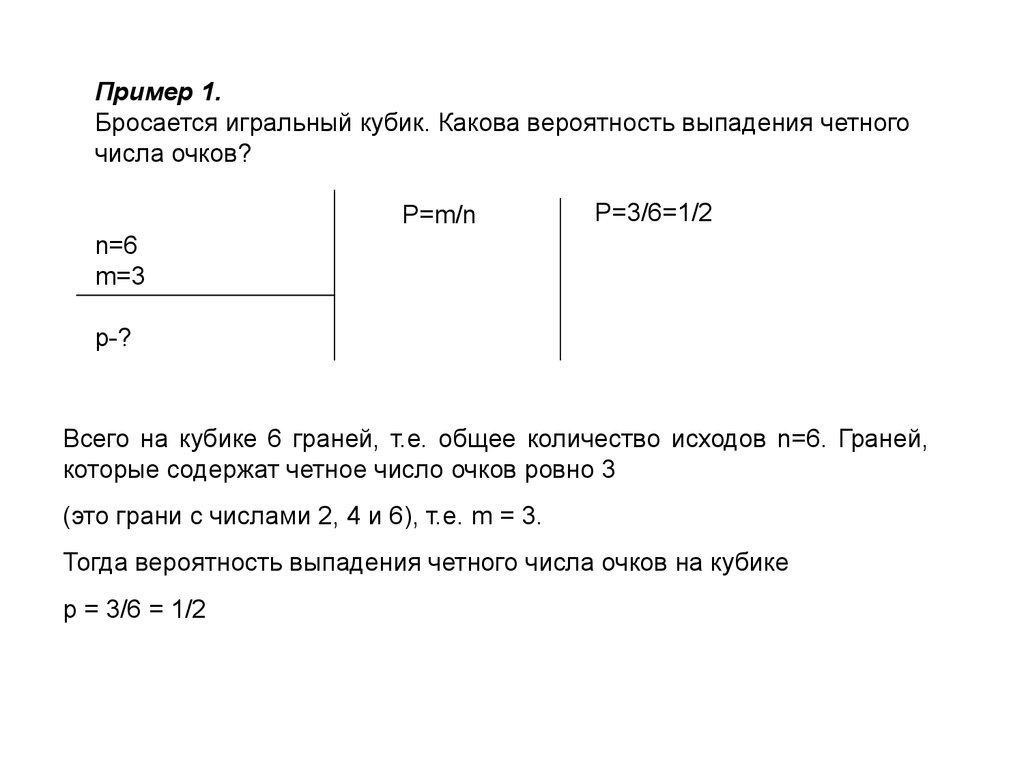

Пример 1.Бросается игральный кубик. Какова вероятность выпадения четного

числа очков?

P=m/n

P=3/6=1/2

n=6

m=3

p-?

Всего на кубике 6 граней, т.е. общее количество исходов n=6. Граней,

которые содержат четное число очков ровно 3

(это грани с числами 2, 4 и 6), т.е. m = 3.

Тогда вероятность выпадения четного числа очков на кубике

p = 3/6 = 1/2

28.

Пример 2.В гараже 15 автомобилей КАМАЗ, 12 автомобилей МАЗ и 3

автомобиля MAN. Найдите вероятности выбора автомобиля каждого

вида.

Решение: Всего в гараже (15 + 12 + 3) = 30 автомобилей, т.е. общее

количество исходов n=30.

Исходов, благоприятствующих выбору автомобиля КАМАЗ:

m1 = 15

Исходов, благоприятствующих выбору автомобиля МАЗ:

m2 = 12

Исходов, благоприятствующих выбору автомобиля MAN:

m3 = 3

Тогда, искомые вероятности:

P1 =m1/n = 15/30 = 1/2

P2 =m2/n = 12/30 =6/15

P3 =m3/n = 3/30 = 1/10

29.

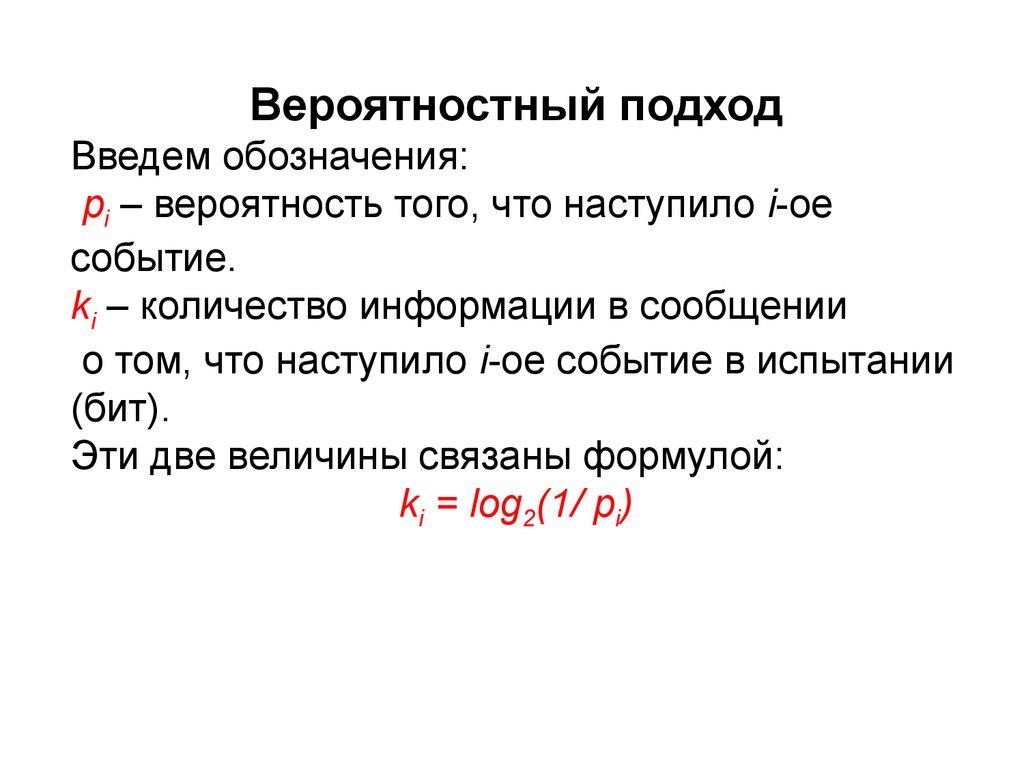

Вероятностный подходВведем обозначения:

pi – вероятность того, что наступило i-ое

событие.

ki – количество информации в сообщении

о том, что наступило i-ое событие в испытании

(бит).

Эти две величины связаны формулой:

ki = log2(1/ pi)

30.

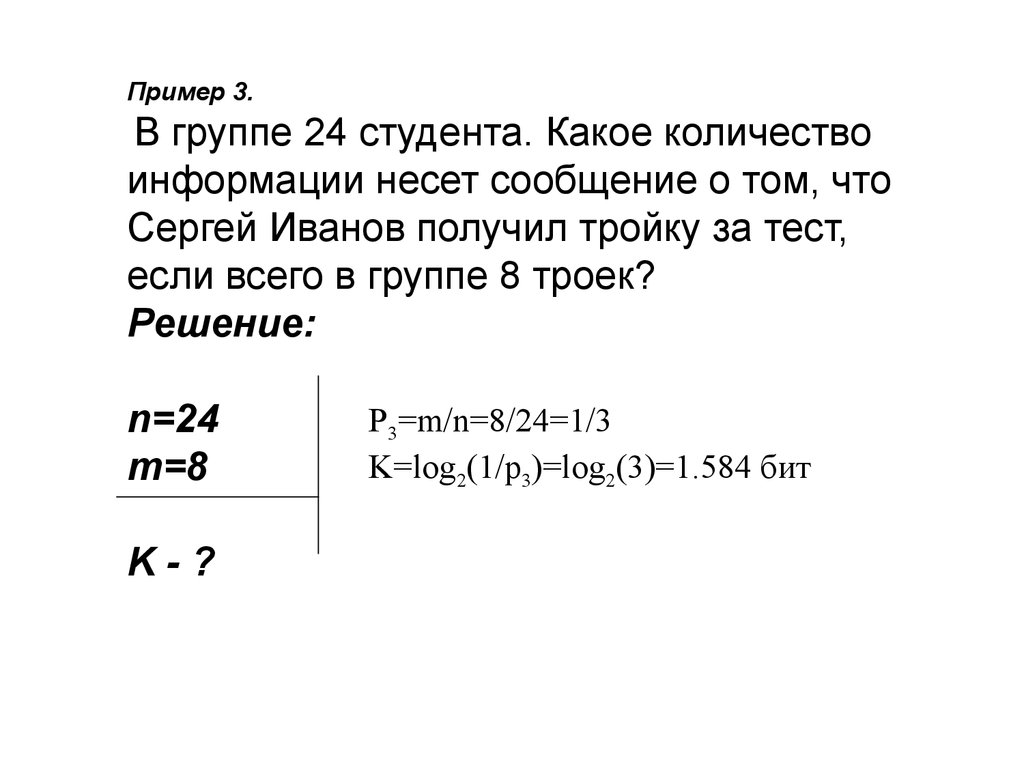

Пример 3.В группе 24 студента. Какое количество

информации несет сообщение о том, что

Сергей Иванов получил тройку за тест,

если всего в группе 8 троек?

Решение:

n=24

m=8

K-?

P3=m/n=8/24=1/3

K=log2(1/p3)=log2(3)=1.584 бит

31.

Пример 4. Студенты в группе за экзамен по информатикеполучили 10 пятерок, 5 четверок, 3 тройки и 2 двойки. Найдите

количество информации в сообщении о получении оценки каждого

вида.

Решение: Обозначим р5 – вероятность получения пятерки;

р4 – вероятность получения четверки;

р3 – вероятность получения 3;

р2 – вероятность получения двойки.

Тогда:

Р5 = 10/(10+5+3+2) =10/20=1/2

P4 = 5/(10+5+3+2) = 5/20 = 1/4

P3 = 3/(10+5+3+2) = 3/20

P2 = 2/(10+5+3+2) = 2/20 = 1/10

k5= log22 = 1 бит

k4= log24 = 2 бита

k3= log2 (20/3) = 2,736966 бит

k2= log2 (10) = 3,321928 бит

32.

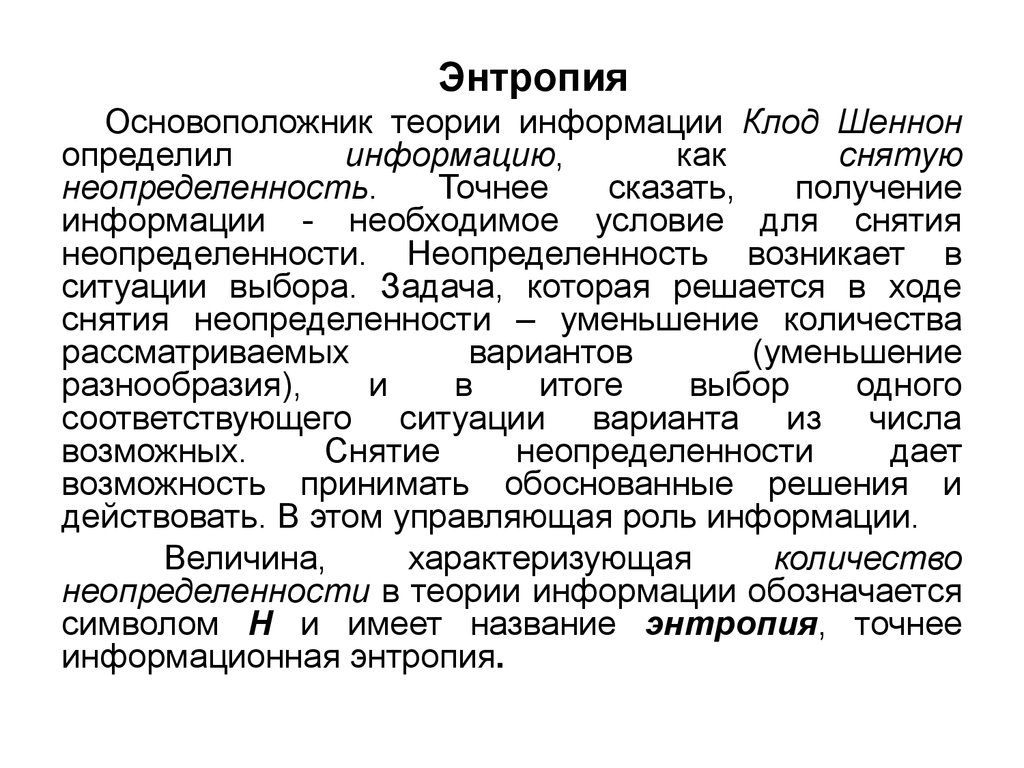

ЭнтропияОсновоположник теории информации Клод Шеннон

определил

информацию,

как

снятую

неопределенность.

Точнее

сказать,

получение

информации - необходимое условие для снятия

неопределенности. Неопределенность возникает в

ситуации выбора. Задача, которая решается в ходе

снятия неопределенности – уменьшение количества

рассматриваемых

вариантов

(уменьшение

разнообразия),

и

в

итоге

выбор

одного

соответствующего ситуации варианта из числа

возможных.

Снятие

неопределенности

дает

возможность принимать обоснованные решения и

действовать. В этом управляющая роль информации.

Величина,

характеризующая

количество

неопределенности в теории информации обозначается

символом H и имеет название энтропия, точнее

информационная энтропия.

33.

Формула ШеннонаВ общем случае, энтропия H и количество получаемой в

результате снятия неопределенности информации I зависят от исходного

количества рассматриваемых вариантов N и вероятностей реализации

каждого из них P: {p1, p2, …pN}, т.е. H=F(N, P). Расчет энтропии в этом

случае производится по формуле Шеннона, предложенной им в 1948 году в

статье "Математическая теория связи".

Введем обозначение:

I – количество информации в сообщении о наступлении одного из N

возможных событий.

Формула Шеннона:

1

. I pi log 2 pi pi log 2

p

i 1

i 1

i

N

N

34.

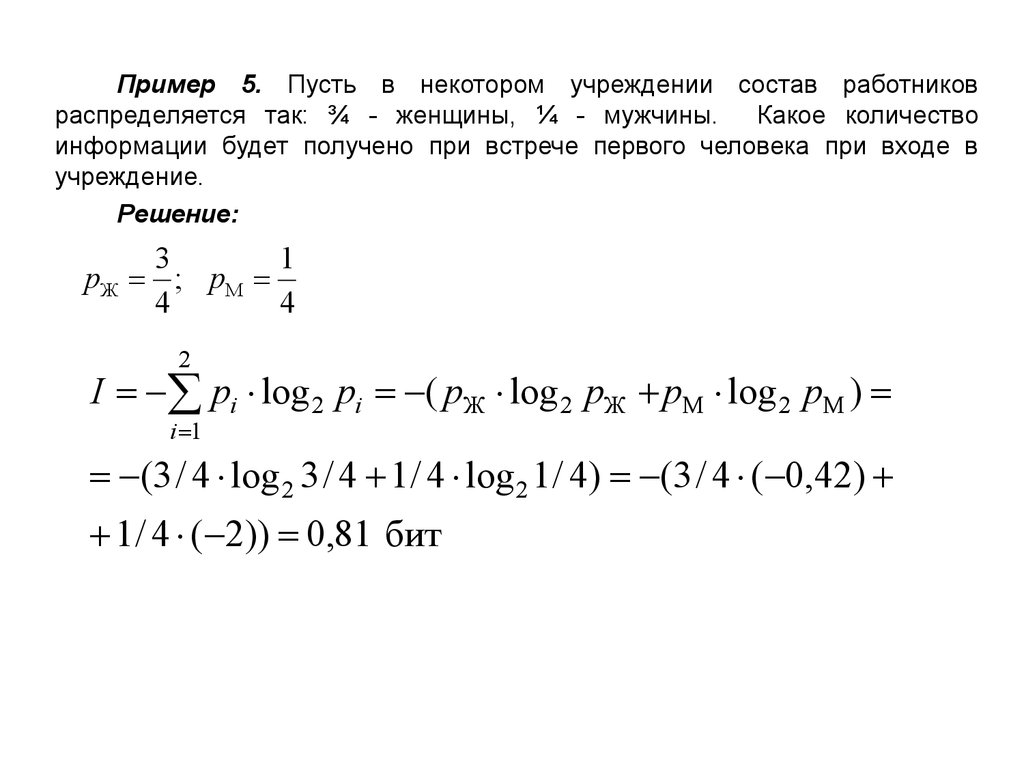

Пример 5. Пусть в некотором учреждении состав работниковраспределяется так: ¾ - женщины, ¼ - мужчины.

Какое количество

информации будет получено при встрече первого человека при входе в

учреждение.

Решение:

3

1

pЖ ; pМ

4

4

2

I pi log 2 pi ( pЖ log 2 pЖ pМ log 2 pМ )

i 1

(3 / 4 log 2 3 / 4 1 / 4 log 2 1 / 4) (3 / 4 ( 0,42)

1 / 4 ( 2)) 0,81 бит

Информатика

Информатика