Похожие презентации:

Основи системного аналіз.у Лекція 9

1. Основи системного аналізу

Лекція 92. Загальні положення

• У розвитку теорії пошуку екстремуму при розробці ідослідження систем при системному аналізі можна

виділити три характерних періоди, котрі можна

назвати періодами детермінізму, стохастичності та

адаптації. У часи детермінізму рівняння, які описують

стан об’єктів системи, що розробляється, і зовнішні

впливи вважались відомими. Така повна визначеність

дозволяла широко використовувати класичний

аналітичний апарат для вирішення проблем пошуку

екстремуму при створенні систем. Найперше це має

відношення до лінійних задач. Однак утруднення

виникли, як тільки виникла необхідність в урахуванні

нелінійних факторів впливу. Але і в цій області були

отримані істотні результати як з аналізу, так і по

синтезу систем.

3.

• Далі наступив період стохастичності, коли в зв’язку знеобхідністю врахування більш реальних умов роботи систем

було встановлено, що зовнішні впливи як задаючи, так і

(особливо) збурюючи, неперервно змінюються в часі і не можуть

бути однозначно виявлені.

• Часто це мало відношення і до коефіцієнтів рівнянь об’єктів, які

впливають на систему чи керовані нею.

• Тому виникла необхідність у використанні підходів, які можуть

враховувати імовірнісний характер зовнішніх впливів і рівнянь.

Ці підходи засновані на тому, що статистичні характеристики

випадкових функцій, можуть вважатися відомими чи якимсь

чином попередньо визначеними і дозволяють використовувати

аналітичні методи

4.

Визначальна особливість методів і результатів цих періодів розвиткутеорії систем складається в можливості їх використання в

автоматичних системах з повною інформацією (тобто відомі

рівняння об’єкту і зовнішні впливи або їх статистичні характеристики.

У теперішній час в сучасних складних системах, які працюють в

різноманітних умовах, не тільки завчасно не відомі рівняння об’єктів і

зовнішні впливи (або їх статистичні характеристики), але по різним

причинам їх неможливо попередньо визначити.

Тобто дослідник стикається з більшою чи меншою початковою

невизначеністю.

5. 5

Все це, як позначив академік Ципкін Я.З., віщує про настаннятретього періоду в теорії систем — періоду адаптивності.

Можливість управління об’єктами при неповній апріорній інформації

або при її відсутності основана на використанні таких методів в

системному аналізі, котрі зменшують початкову невизначеність на

основі використання інформації, яку можна отримати під час

управління системою.

На першій стадії кожного з перелічених періодів основною задачею

була задача аналізу системи і визначення її властивостей.

Далі виникли задачі синтезу систем, які задовольняють певним

вимогам, котрі забезпечують досягнення певної мети.

Істотно, з’явилось бажання, а іноді і необхідність досягнути цю мету

найкращим способом.

6. 6

• При цьому виникли три задачі:• вибір і формулювання мети (екстремум

показника якості),

• врахування обмежуючих умов (обмежені

ресурси, простота, надійність)

• реалізація найкращого шляху досягнення

мети (визначення алгоритму пристрою, що

керує системою і його здійснення).

7. 7

дослідникивизначились

з

адекватним

математичним апаратом для вирішення наявних задач.

На сьогодні вважають, що таким апаратом може бути дисципліна з

назвою «математичне програмування» [Ціпкін]. Воно розроблює теорію

і методи вирішення екстремальних задач і охоплює такі спеціальні розділи:

варіаційне обчислення, принцип максимуму Понтрягіна, динамічне

програмування Беллмана, лінійне та нелінійне програмування та методи

стохастичної апроксимації [Ціпкін].

Математичне програмування не пов’язано з необхідністю

описання умов задачі в аналітичному, формульному вигляді і тому може

охопити ширший круг задач, ніж методи, за допомогою яких намагаються

отримати рішення в аналітичній формі.

Алгоритмічна форма рішення екстремальних задач дає можливість

використати можливості сучасної обчислювальної техніки

Одночасно

8. 7

Поняття навчання, самонавчання і адаптації7

Навчанням будемо вважати процес вироблення в

деякій системі тих або інших властивостей її реакції

на зовнішні впливи шляхом багатократних впливів на

систему і зовнішнього корегування.

• Самонавчання

відрізняється

від

навчання

відсутністю зовнішнього корегування.

• Адаптацією назвемо процес змінення величин

параметрів, структури системи, а можливо, і

управляючих впливів на основі інформації, яку

отримують під час управління, з ціллю досягнення

деякого, звичайно з якоїсь точки зору оптимального,

стану системи при початковій невизначеності і зміні

умов її роботи.

9. 8

• При цьому можна вважати, що при наявностіпочаткової невизначеності, зваженим підходом

буде її усунення при допомозі навчання чи

самонавчання в процесі її моделювання та в

використанні накопиченої інформації для покращення

показників вказаної системи.

• Таким чином, характерна риса адаптації – це

накопичення інформації та її використання для

покращення обраного показника якості.

• Процеси навчання і адаптації будемо трактувати як

процеси послідовних наближень. Важливий метод

послідовних

наближень

для

вирішення

екстремальних задач – це метод стохастичної

апроксимації.

10. 9

Критерії оптимальності9

• Проблема оптимальності є важливою проблемою системного

аналізу. Щоб не робила людина – вона намагається зробити це

якнайкраще. Будь які її дії, наприклад, створені нею системи,

можна розглядати з деякої точки зору як оптимальні, бо їх

обрано з множини систем бо ми вважаємо їх кращими.

• При цьому мають бути вирішені три задачі:

• - вибір і формулювання мети (етап складний, має враховувати

багато умов);

• - узгодження мети та наявних можливостей (урахування

обмежень);

• - вибір способу досягнення мети в умовах обмежень (вибір

методу оптимізації).

11. 10

• Як було сказано вище, будь яка задача оптимізаціїможе бути зведена до вибору кращого в деякому

смислі варіанту з кількох варіантів. Кожен з цих

варіантів характеризується набором чисел (або

функцій). Якість того чи іншого варіанту визначається

деяким показником – кількісною характеристикою, яка

визначає близькість досягнення поставленої мети при

обраному варіанті.

• Найкращий варіант відповідає екстремуму показника

якості (мінімуму або максимуму). Показники якості

звичайно представляють собою функціонали. Ці

функціонали можна розглядати як функції, в яких роль

незалежних

змінних

виграють

вектори,

які

характеризують варіанти. Функціонал, який залежить

від вектора, представляє собою функцію багатьох

змінних

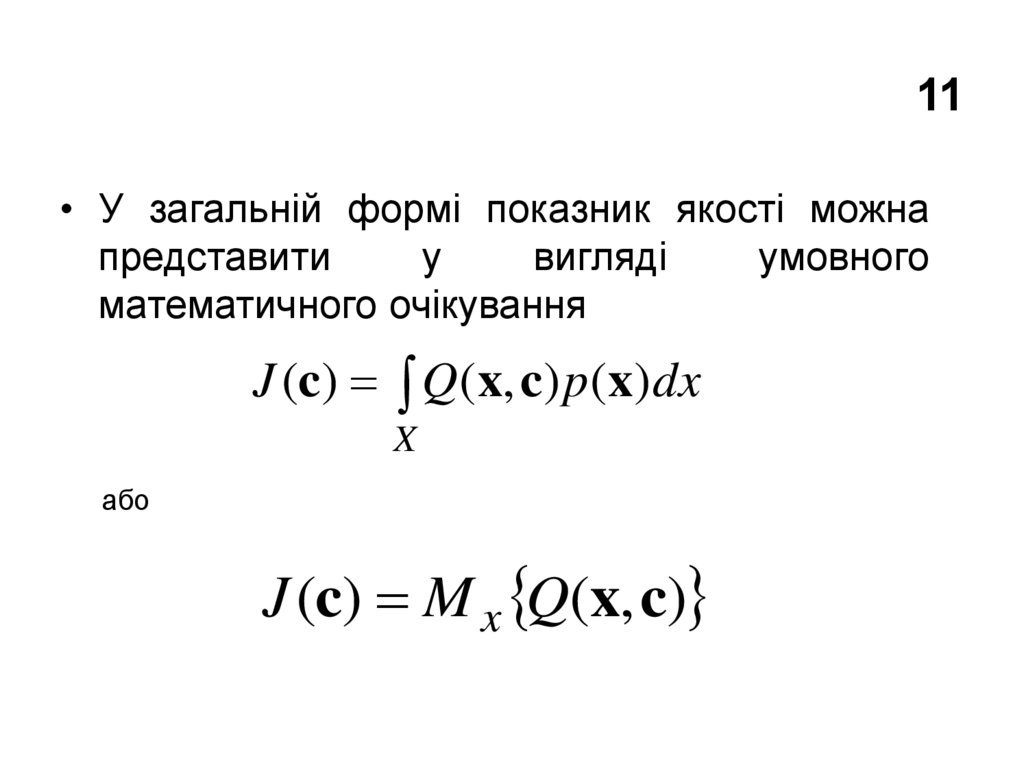

12. 11

• У загальній формі показник якості можнапредставити

у

вигляді

умовного

математичного очікування

J (c) Q(x, c) p (x)dx

X

або

J (c) M x Q(x, c)

13. 12

• де Q(x, c) - функціонал векторуc (c1, , cN ,) який залежитьвід вектору випадкових процесів x ( x1 , , xM ) , щільність

розподілу якого дорівнює p (x) ; X – простір векторів .

• Проблема оптимальності виникає саме тоді, коли виникають

протилежні обмежувальні умови.

• Досягнення оптимальності складається з найкращого

задовільнення цих умов, тобто у виборі такого варіанту, коли

критерій оптимальності досягає екстремуму.

14. 13

• Обмежувальні умови чи обмеження, які виражаютьсярівностями, нерівностями, або логічними умовами, зі всієї

множини варіантів виділяють так звані допустимі варіанти,

серед яких і обирається оптимальний варіант.

• Закони природи, які описують ті чи інші явища, а саме, ті, що

визначають поведінку різних систем, представляють собою

своєрідні обмеження. Цим законам, у формі алгебраїчних,

диференційних, інтегральних рівнянь, підпорядковуються

вектори х і с.

• Конкретний вигляд таких рівнянь залежить від характеру і

особливостей задачі, що розглядається.

• Обмеження цього типу звуть обмеженнями першого роду.

15. 14

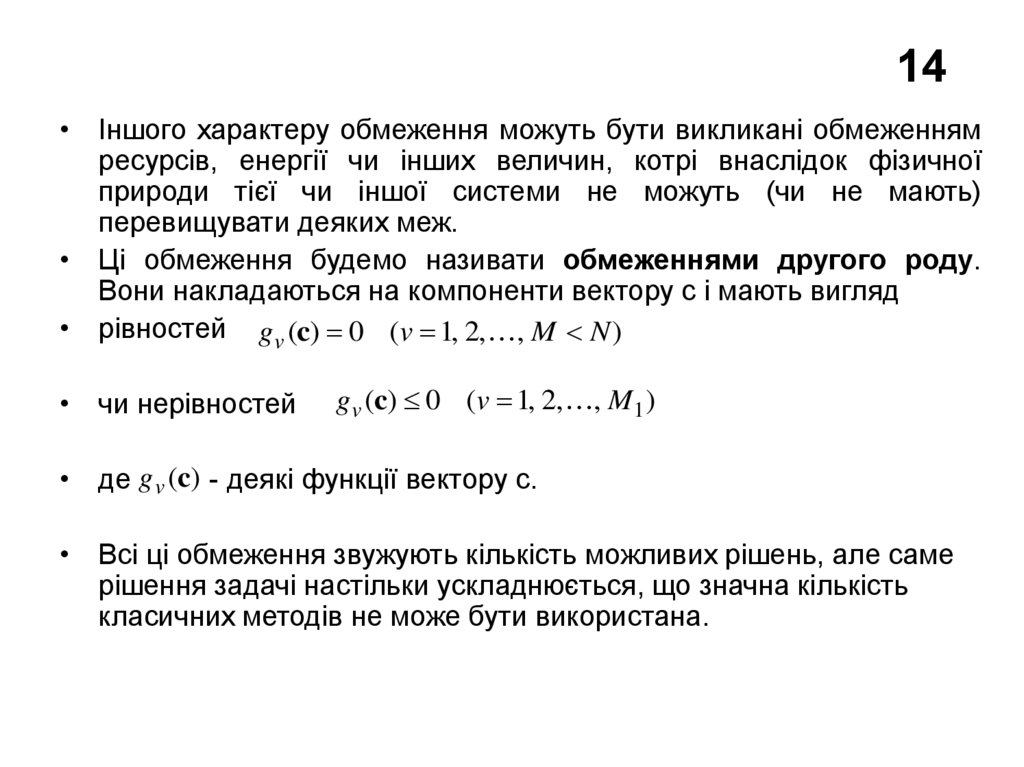

• Іншого характеру обмеження можуть бути викликані обмеженнямресурсів, енергії чи інших величин, котрі внаслідок фізичної

природи тієї чи іншої системи не можуть (чи не мають)

перевищувати деяких меж.

• Ці обмеження будемо називати обмеженнями другого роду.

Вони накладаються на компоненти вектору с і мають вигляд

• рівностей gv (c) 0 (v 1, 2, , M N )

• чи нерівностей

gv (c) 0 (v 1, 2, , M1 )

• де g v (c) - деякі функції вектору с.

• Всі ці обмеження звужують кількість можливих рішень, але саме

рішення задачі настільки ускладнюється, що значна кількість

класичних методів не може бути використана.

16. 15

Апріорна і поточна інформація15

• Апріорна (початкова) інформація – це сукупність завчасно

відомих відомостей про критерії оптимальності та обмеження.

Вона торкається вимог до процесів (чи систем), що

досліджуються, характеру рівнянь процесу, значень параметрів

у цих рівняннях, властивостей зовнішніх впливів і самого

процесу. Ця інформація може бути отримана в результаті

попереднього

теоретичного

чи

експериментального

дослідження.

• Отримання повної апріорної інформації (тобто абсолютно

точних знань про систему) практично неможливе. Якщо ж

брати до уваги наявність завад, які є джерелом

невизначеності, то можна вважати, що всі випадки, з якими

стикається розробник, відповідають неповній апріорній

інформації. Ступінь цієї неповноти зрозуміло може бути різною.

При достатній апріорній інформації наявні відомості про

критерій оптимальності та обмеження, тобто вони можуть бути

виписані в явній формі. При недостатній апріорній інформації

необхідні відомості відносно критерію оптимальності або

обмежень можуть бути відсутні.

17. 16

• Істотна особливість будь-яких апріорних відомостей полягає втому, що вони внаслідок випадкових змін, які завжди наявні в

реальних умовах, втрачають свою достовірність.

• На відміну від апріорної інформації, поточна інформація може

бути отримана внаслідок спостерігання за ходом процесу чи в

результаті експерименту. Таким чином поточна в кожен момент

часу оновлюється та за певної організації експерименту може

використовуватись для накопичення відповідної апріорної

інформації. Але найбільш важлива роль поточної інформації

складається в компенсації недостатнього обсягу апріорної

інформації.

• Тобто апріорна інформація – це основа для формулювання

проблеми оптимальності. Поточна інформація – засіб для

вирішення цієї проблеми.

18. 17

Детерміновані і стохастичні процеси17

• Детерміновані процеси характеризуються тим, що знання їх в

певному інтервалі часу дозволяє повністю визначити поведінку

цих процесів зовні цього інтервалу. Для детермінованого

процесу відомі критерій оптимальності та обмеження першого і

другого роду. Стохастичні процеси характеризуються тим, що

знання їх на певному інтервалі часу дозволяє визначити лише

імовірнісні характеристики поведінки цих процесів зовні цього

інтервалу. Якщо ці імовірнісні характеристики (наприклад,

щільності розподілу) відомі, то і в цьому випадку можна

визначити в явному вигляді критерій оптимальності і обмеження,

які являють собою деякі умовні математичні очікування.

• Детерміновані процеси можна вважати випадком стохастичних

процесів, щільність розподілу яких – це імпульсна функція

Дірака (тобто

функція).

δ

19. 18

• З цього випливає, що стохастичні процеси відрізняються одинвід одного та від детермінованих процесів видом імовірнісних

характеристик – щільностей розподілу.

• Об’єм апріорної інформації для детермінованих процесів

зазвичай більший, ніж для стохастичних, оскільки для

детермінованих процесів щільність розподілу відома, тоді як для

стохастичного процесу її потрібно визначати.

• Тим не менш, коли щільність розподілу відома, існує значна

подібність

у

формулювання

та

вирішення

проблем

оптимальності детермінованого та стохастичного процесів.

20. Пошук екстремуму цільових функцій Умови оптимальності 19

• Алгоритмічні методи, які підлягають розгляду в розділі відносятьсядо рекурентних ітеративних процедур. На протязі розділу

вважається, що в наявності є достатньо апріорної інформації.

• При достатній апріорній інформації критерій оптимальності функціонал J (c) та обмеження визначені в явній формі.

• Якщо функціонал J (c) допускає диференціювання, то він досягає

екстремуму тільки при таких значеннях c (c1, , cN ), для яких N

похідних dJ (c)

(v 1, 2, , N )

dcv

• одночасно обертаються в нуль, чи для яких градієнт функціонала

dJ (c)

dJ (c)

J (c)

, ,

dc

dcv

(2.1)

1

• обертається в нуль.

• При цьому вектори мають задовольняти умові J (c) 0

21. Регулярний ітеративний метод 20

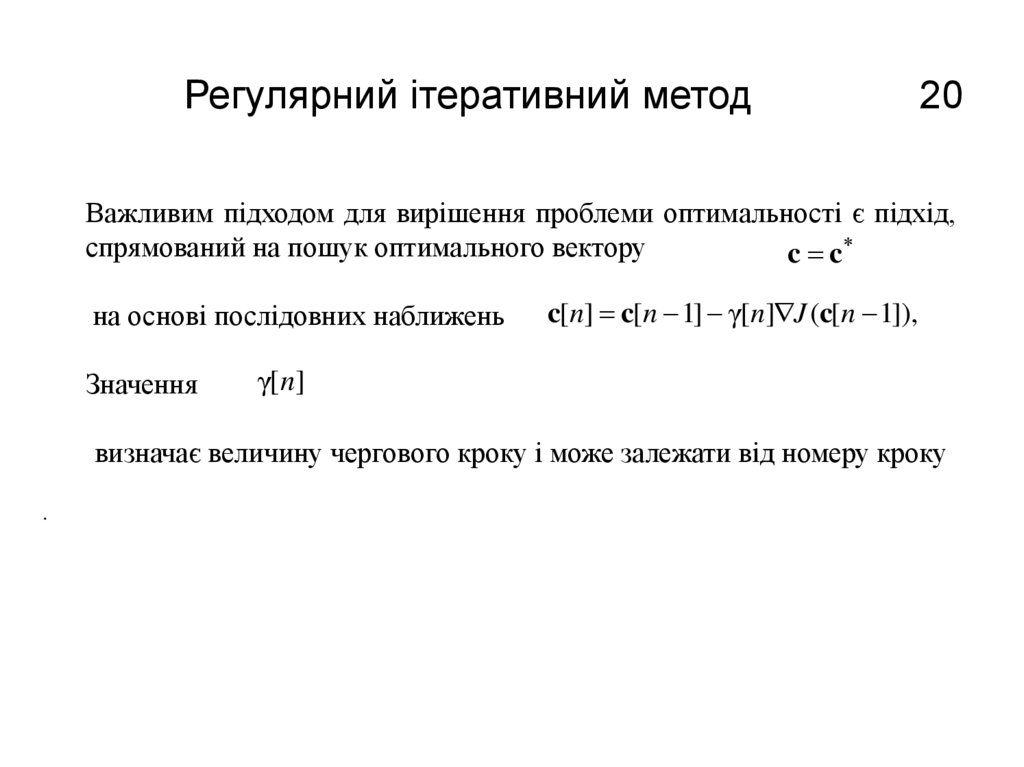

Важливим підходом для вирішення проблеми оптимальності є підхід,спрямований на пошук оптимального вектору

c c

на основі послідовних наближень

Значення

c[n] c[n 1] γ[n] J (c[n 1]),

γ[n]

визначає величину чергового кроку і може залежати від номеру кроку

.

Математика

Математика