Похожие презентации:

Спецификация множественной регрессии

1. Лекция 7 Спецификация множественной регрессии

1. Результаты ошибочного отборафакторов.

2. Отбор факторов в уравнение

множественной регрессии.

3. Выбор формы связи.

2.

1. Результаты ошибочного отборафакторов.

Все предыдущие рассуждения и выводы,

касающиеся классической или обобщенной

модели множественной регрессии, основывались на предположении, что выполнена

правильная спецификация модели.

3.

Как уже отмечалось, под спецификациеймножественной модели понимается отбор

объясняющих переменных в модель и установление формы связи между этими переменными и зависимой переменной.

Факторы, включаемые в модель, должны

удовлетворять следующим требованиям:

1. Факторы должны быть количественно

измеримы. Если необходимо включить качественный фактор, то ему нужно придать количественную определенность, т.е. ввести в

рассмотрение фиктивные переменные.

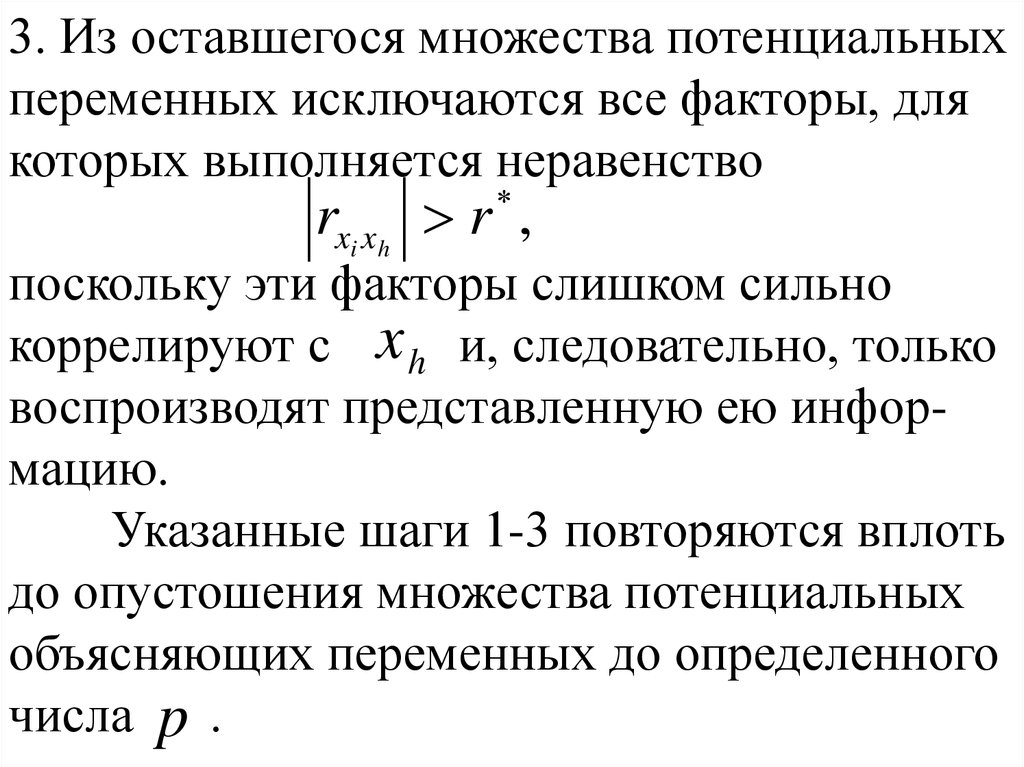

4.

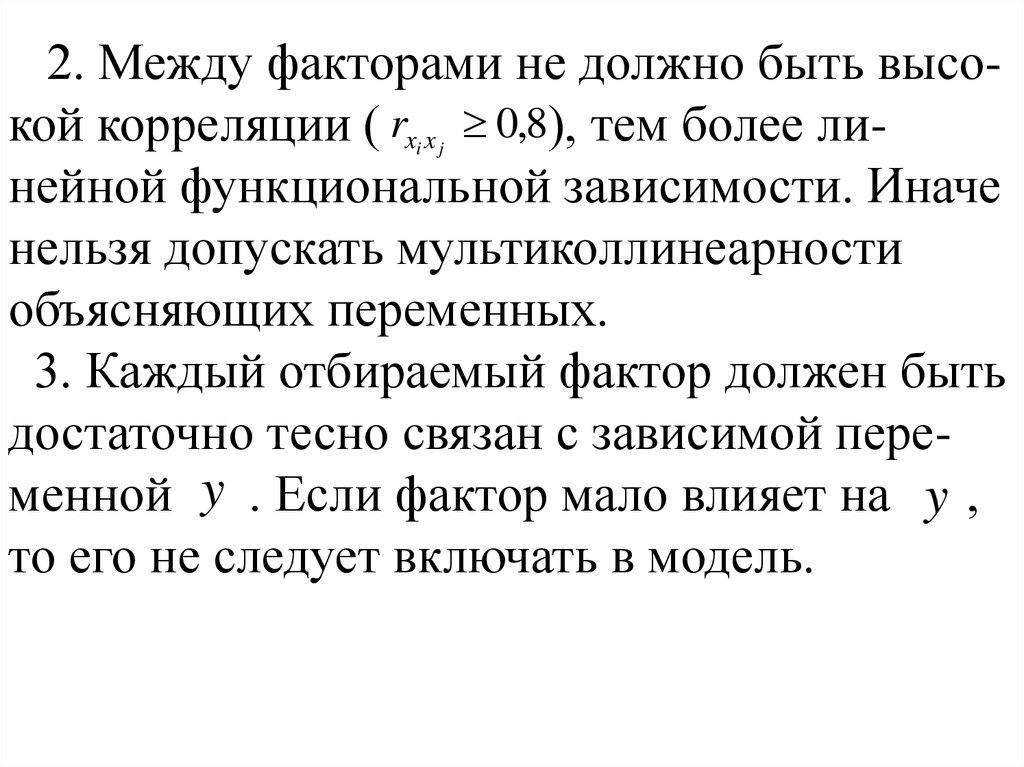

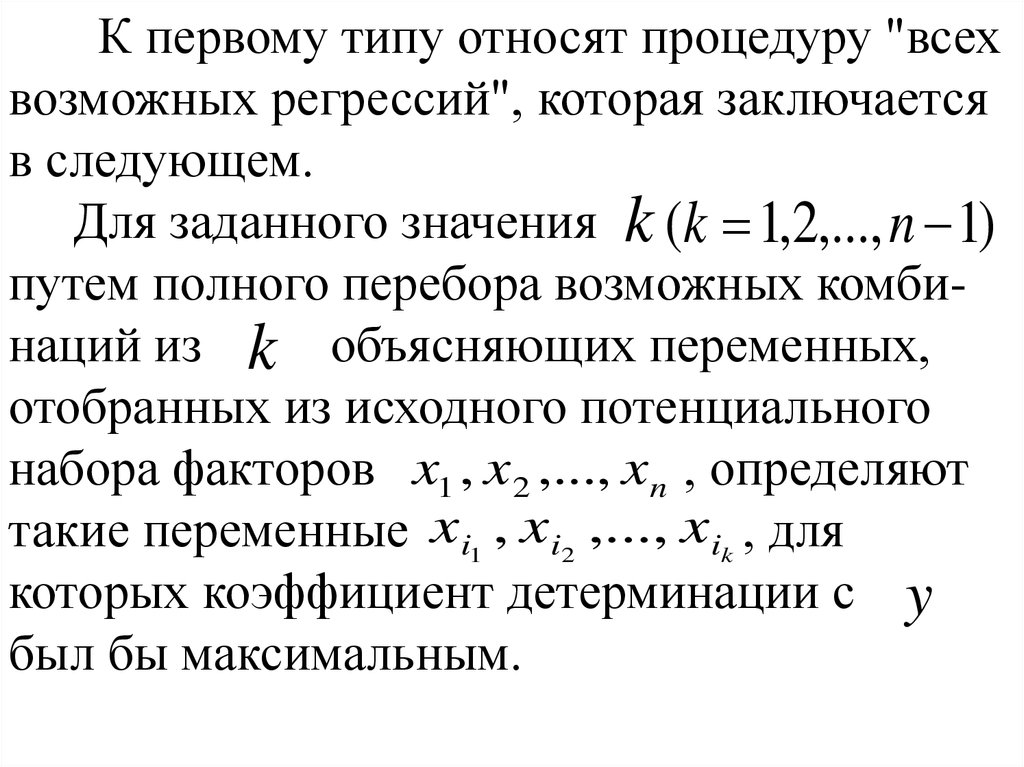

2. Между факторами не должно быть высокой корреляции ( rx x 0,8), тем более линейной функциональной зависимости. Иначенельзя допускать мультиколлинеарности

объясняющих переменных.

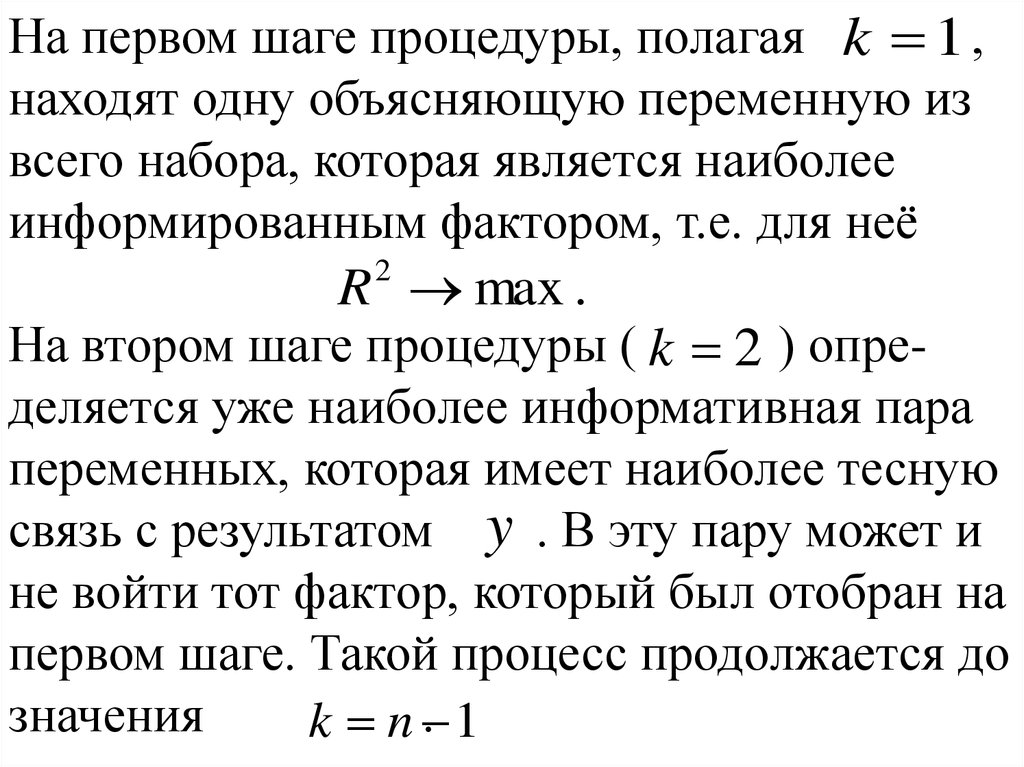

3. Каждый отбираемый фактор должен быть

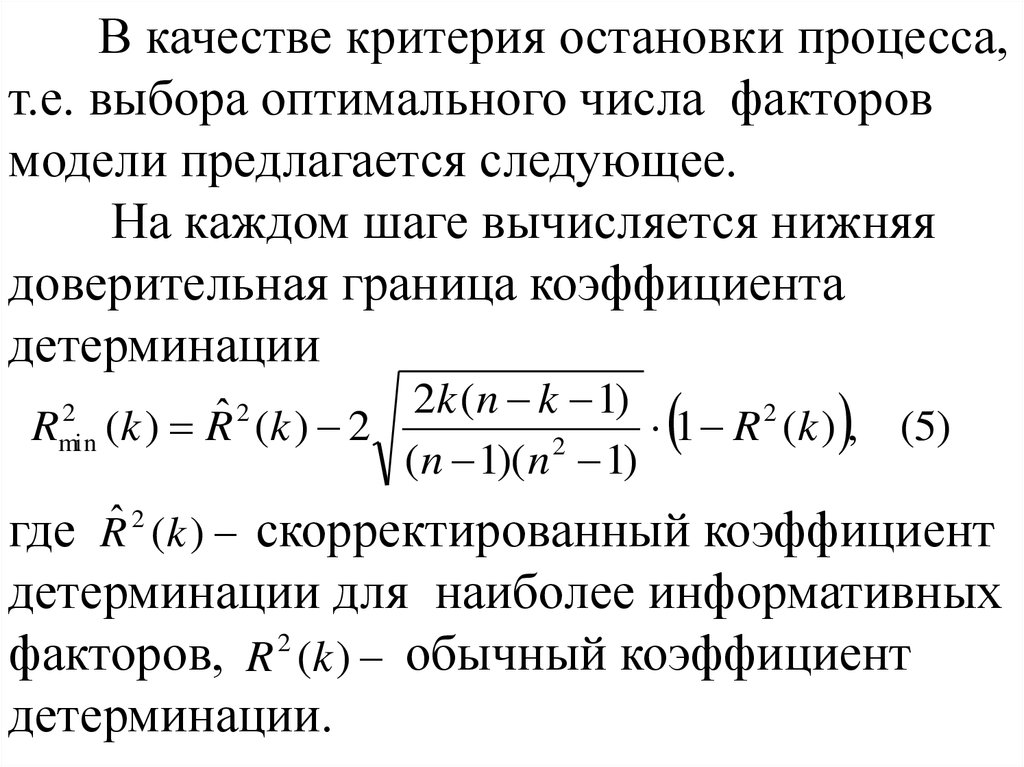

достаточно тесно связан с зависимой переменной y . Если фактор мало влияет на y ,

то его не следует включать в модель.

i j

5.

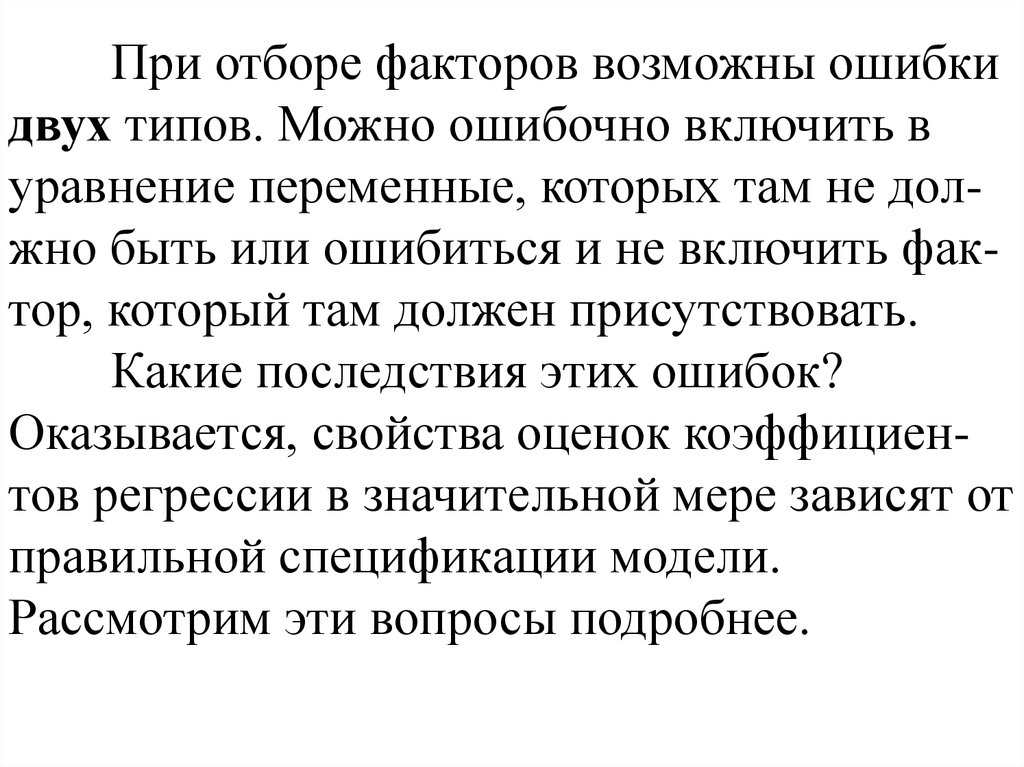

При отборе факторов возможны ошибкидвух типов. Можно ошибочно включить в

уравнение переменные, которых там не должно быть или ошибиться и не включить фактор, который там должен присутствовать.

Какие последствия этих ошибок?

Оказывается, свойства оценок коэффициентов регрессии в значительной мере зависят от

правильной спецификации модели.

Рассмотрим эти вопросы подробнее.

6.

Рассмотрим вначале случай, когда в модели отсутствует существенная переменная.Пусть переменная y зависит от двух

факторов x1 и x 2 в соответствии с соотношением:

y 0 1 x1 2 x2 .

Однако мы не уверены в значимости

фактора x 2 и считаем, что модель должна

выглядеть так:

7.

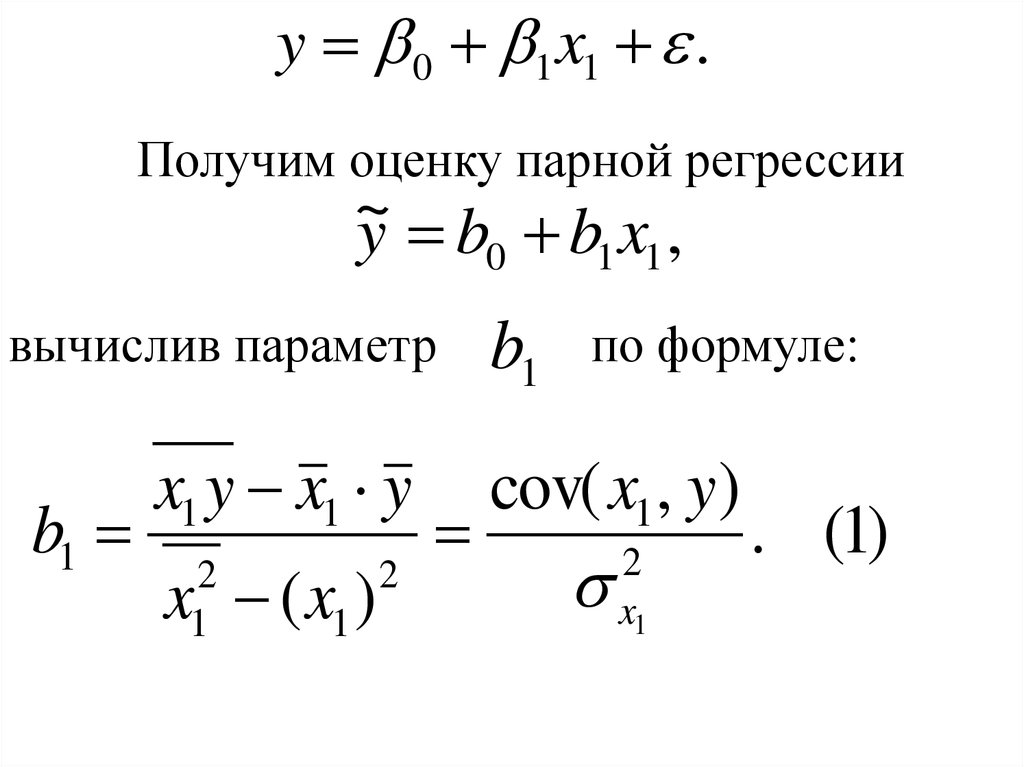

y 0 1 x1 .Получим оценку парной регрессии

~

y b0 b1 x1 ,

вычислив параметр

b1

x1 y x1 y

x ( x1 )

2

1

2

b1

по формуле:

cov( x1 , y)

2

x1

. (1)

8.

Убедимся, что оценка (1) будет смещенной,если 2 0 .

Для этого выполним следующие

преобразования

cov( x1 , y )

b1

1

2

x1

1

2

x1

1

2

x1

cov( x1 , 0 1 x1 2 x 2 )

2

x1

cov( x1 , 0 ) cov( x1 , 1 x1 ) cov( x1 , 2 x2 ) cov( x1 , )

0 1 cov( x1 , x1 ) 2 cov( x1 , x2 ) cov( x1 , )

cov( x1 , x1 )

2

x1

2

cov( x1 , x 2 )

2

x1

cov( x1 , )

2

x1

.

9.

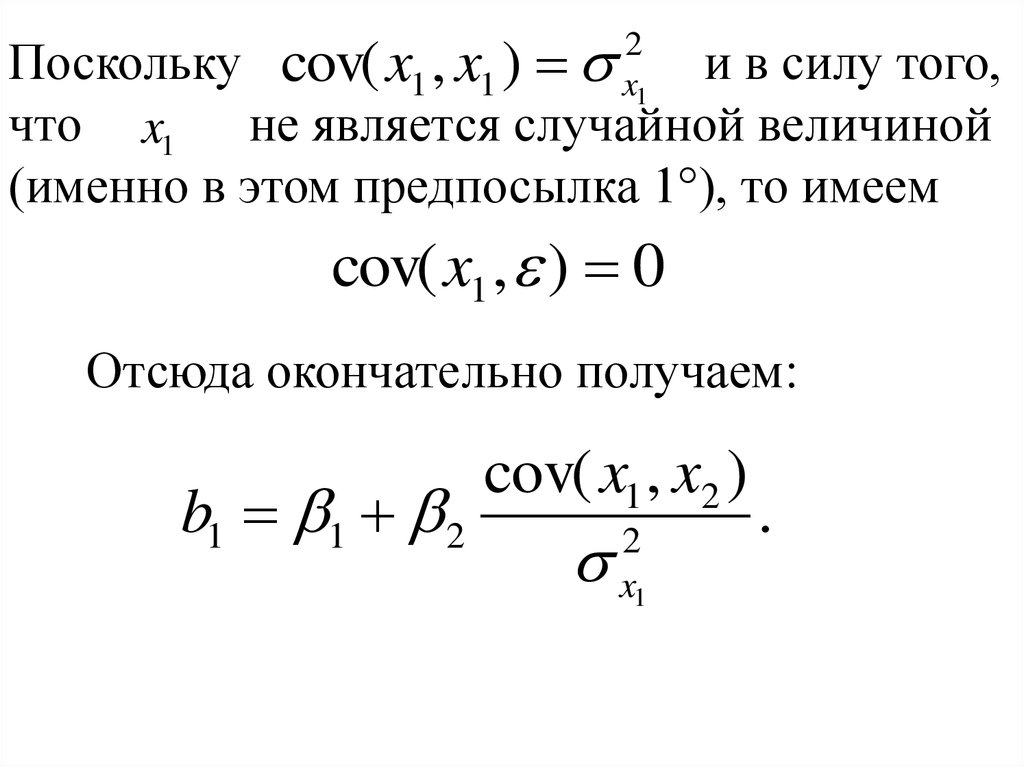

Поскольку cov( x1 , x1 )и в силу того,

что x1 не является случайной величиной

(именно в этом предпосылка 1°), то имеем

2

x1

cov( x1 , ) 0

Отсюда окончательно получаем:

b1 1 2

cov( x1 , x2 )

2

x1

.

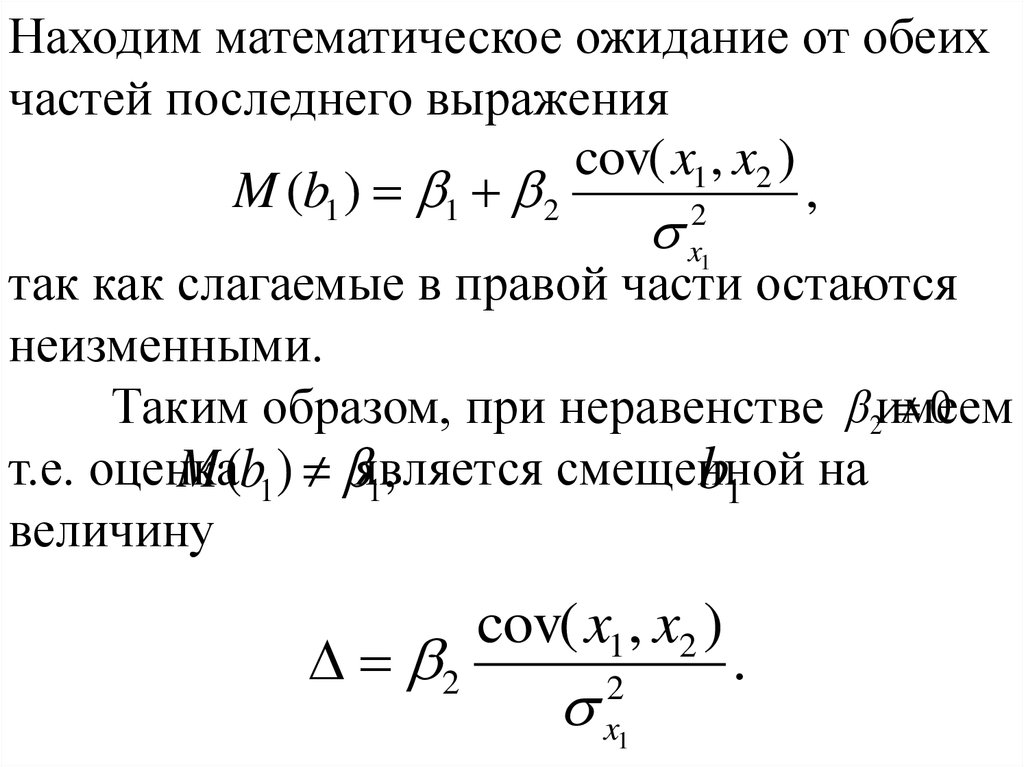

10.

Находим математическое ожидание от обеихчастей последнего выражения

cov( x1 , x2 )

M (b1 ) 1 2

,

2

x

так как слагаемые в правой части остаются

неизменными.

0

Таким образом, при неравенстве 2имеем

т.е. оценка

смещенной

M (b1 ) является

b1 на

1,

величину

1

2

cov( x1 , x2 )

2

x1

.

11.

Направление смещения будет зависеть отзнаков величин 2 и cov( x1 , x2 ) . Если они

будут одного знака (например, больше нуля),

то b1 будет давать в среднем завышенные

оценки коэффициента 1 .

12.

Рассмотрим теперь последствия того случая, когда в модель включена несущественная переменная.Допустим, что истинная модель имеет вид

y 0 1 x1 ,

а мы считаем, что ею является уравнение

y 0 1 x1 2 x2

и рассчитываем оценку b1 по формуле (для

двухфакторной регрессии):

13.

bˆ1cov( x1 , y) cov( x2 , y) cov( x1 , x2 )

2

x1

cov( x1 , x2

2

x1

2

x2

2

(2)

вместо выражения (1).

Оценка bˆ1 будет несмещенной ( M (bˆ1 ) ),

1

но в общем случае она будет неэффективной.

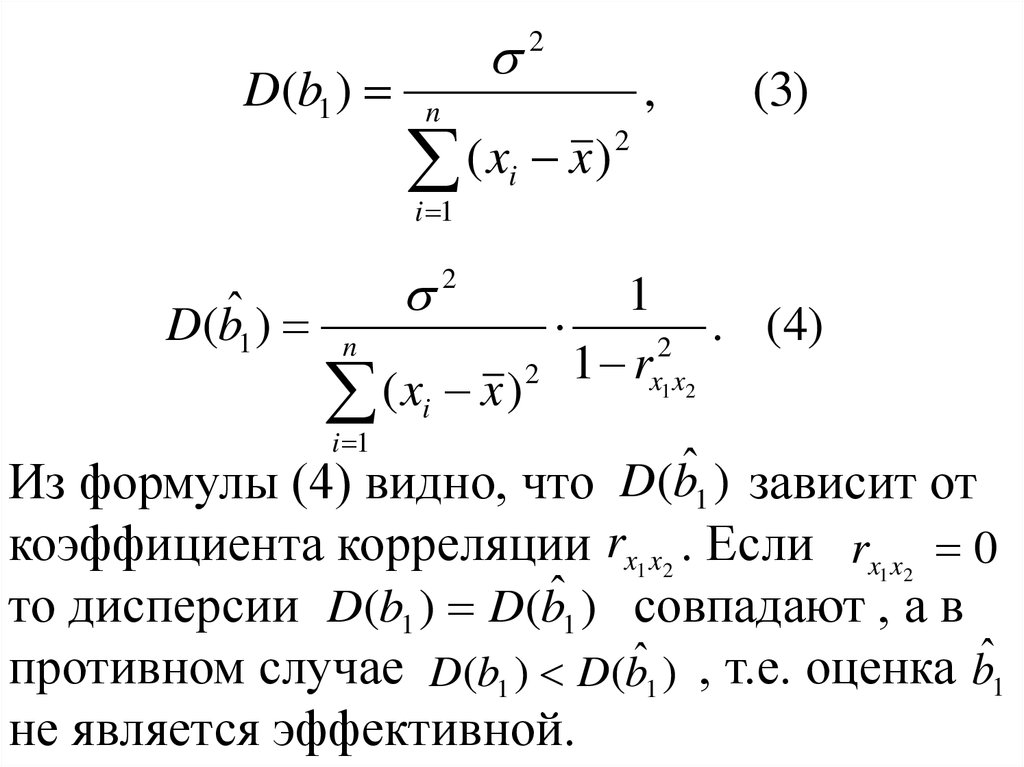

Действительно, можно показать, что дисперсии параметров b1 и bˆ1 вычисляются по

формулам:

14.

D(b1 )(x x)

n

i

(3)

2

i

2

(x x)

i 1

,

n

i 1

D(bˆ1 )

2

1

. (4)

2

2 1 rx1 x2

Из формулы (4) видно, что D(bˆ1 ) зависит от

коэффициента корреляции rx1 x2 . Если rx x 0

то дисперсии D(b1 ) D(bˆ1 ) совпадают , а в

противном случае D(b1 ) D(bˆ1 ) , т.е. оценка bˆ1

не является эффективной.

1 2

15.

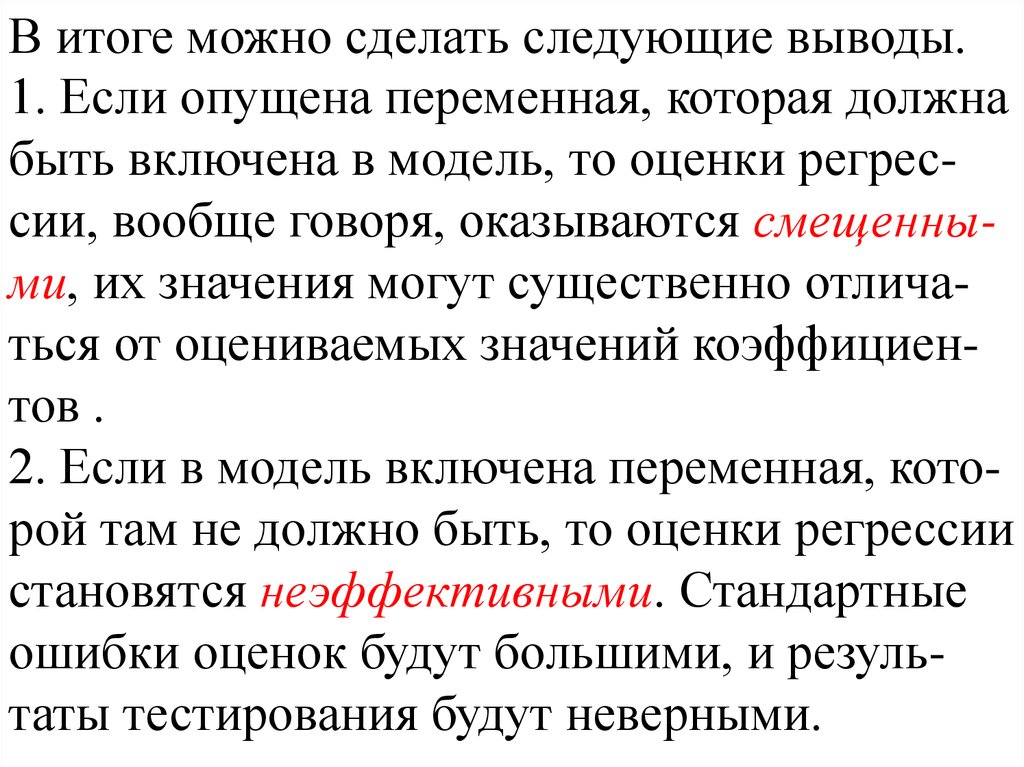

В итоге можно сделать следующие выводы.1. Если опущена переменная, которая должна

быть включена в модель, то оценки регрессии, вообще говоря, оказываются смещенными, их значения могут существенно отличаться от оцениваемых значений коэффициентов .

2. Если в модель включена переменная, которой там не должно быть, то оценки регрессии

становятся неэффективными. Стандартные

ошибки оценок будут большими, и результаты тестирования будут неверными.

16. 2. Отбор факторов в уравнение множественной регрессии.

При отборе факторов для множественнойрегрессии часто используются частные коэффициенты корреляции. С их помощью

можно ранжировать факторы по степени

влияния на результирующий признак и затем

исключить маловлияющие факторы.

Другой подход основан на анализе матрицы коэффициентов корреляции.

17.

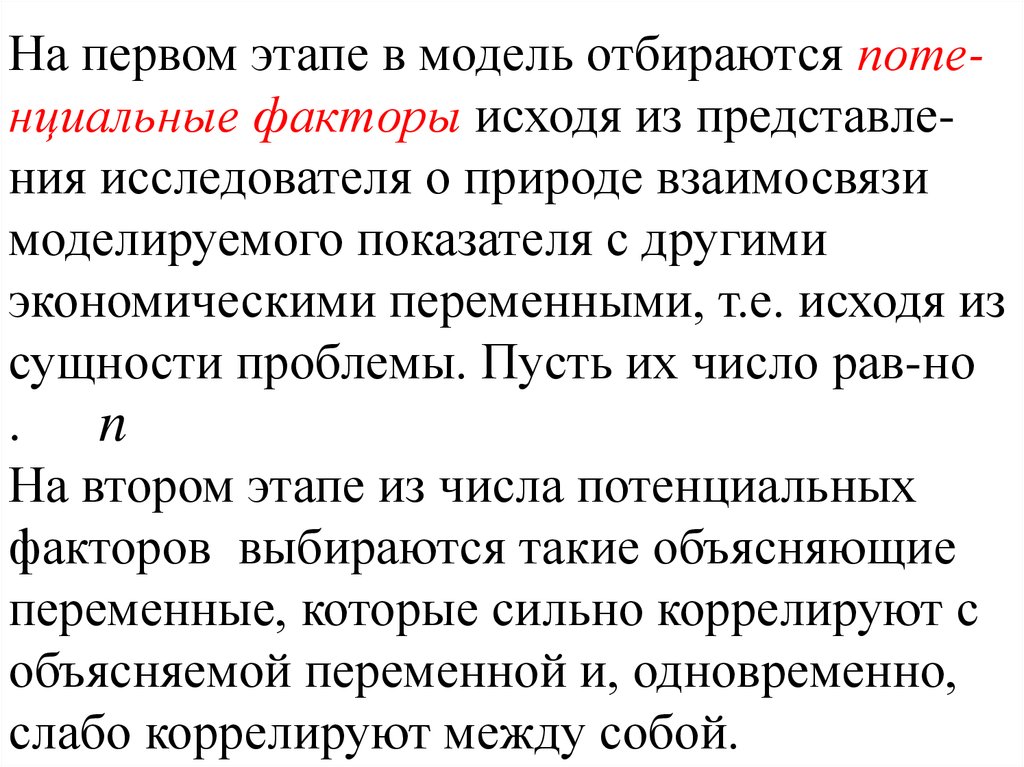

На первом этапе в модель отбираются потенциальные факторы исходя из представления исследователя о природе взаимосвязимоделируемого показателя с другими

экономическими переменными, т.е. исходя из

сущности проблемы. Пусть их число рав-но

.

n

На втором этапе из числа потенциальных

факторов выбираются такие объясняющие

переменные, которые сильно коррелируют с

объясняемой переменной и, одновременно,

слабо коррелируют между собой.

18.

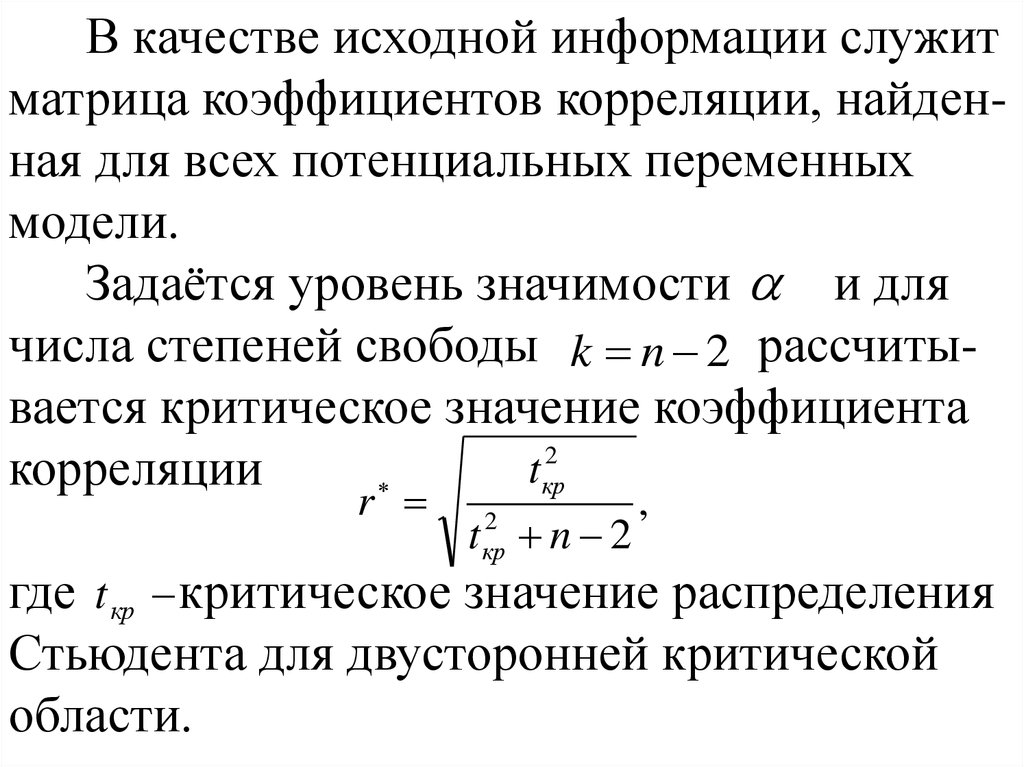

В качестве исходной информации служитматрица коэффициентов корреляции, найденная для всех потенциальных переменных

модели.

Задаётся уровень значимости и для

числа степеней свободы k n 2 рассчитывается критическое значение коэффициента

2

t

корреляции

кр

r

t n 2

2

кр

,

где t кр критическое значение распределения

Стьюдента для двусторонней критической

области.

19.

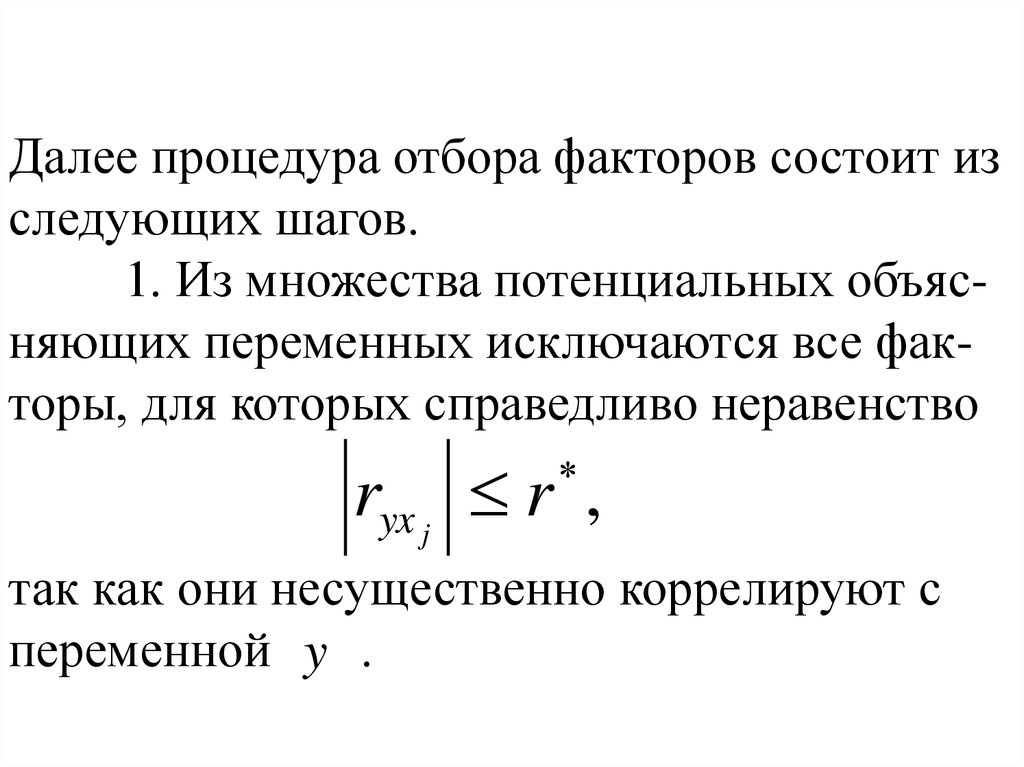

Далее процедура отбора факторов состоит изследующих шагов.

1. Из множества потенциальных объясняющих переменных исключаются все факторы, для которых справедливо неравенство

ryx j r ,

так как они несущественно коррелируют с

переменной y .

20.

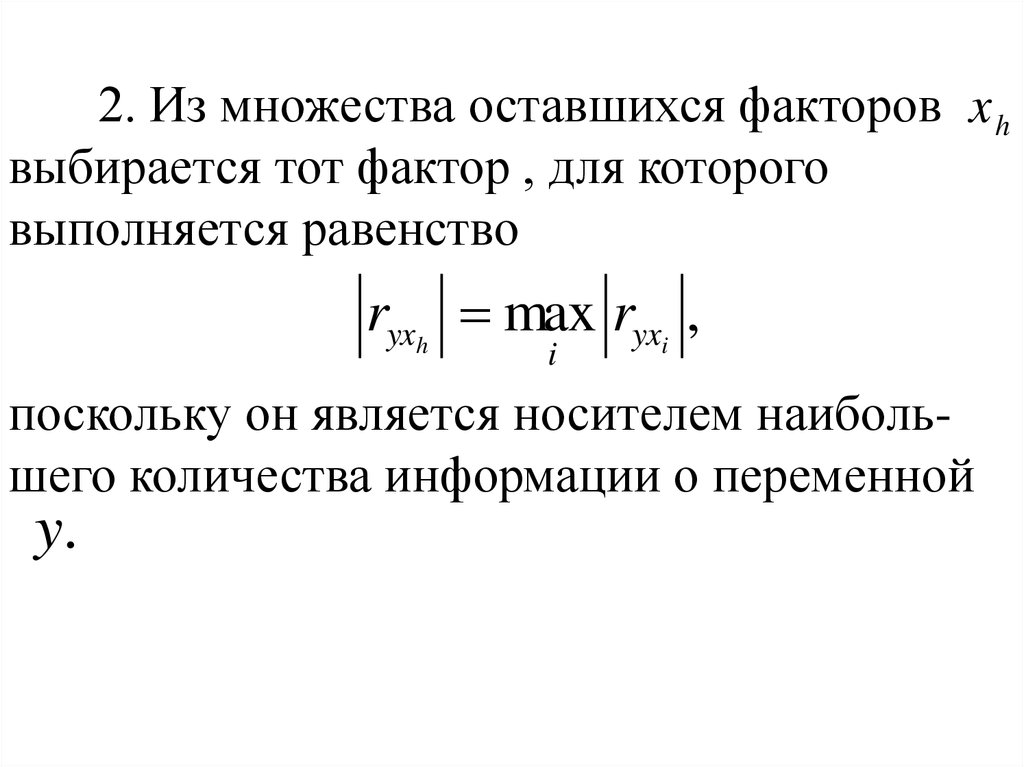

2. Из множества оставшихся факторов x hвыбирается тот фактор , для которого

выполняется равенство

ryxh max ryxi ,

i

поскольку он является носителем наибольшего количества информации о переменной

y.

21.

3. Из оставшегося множества потенциальныхпеременных исключаются все факторы, для

которых выполняется неравенство

rxi xh r ,

поскольку эти факторы слишком сильно

коррелируют с x h и, следовательно, только

воспроизводят представленную ею информацию.

Указанные шаги 1-3 повторяются вплоть

до опустошения множества потенциальных

объясняющих переменных до определенного

числа p .

22.

Для отбора факторов также используюттак называемые процедуры пошагового отбора переменных. В компьютерные пакеты

включены различные эвристические процедуры отбора факторов:

процедура последовательного

присоединения;

процедура последовательного

присоединения-удаления;

процедура последовательного удаления.

23.

К первому типу относят процедуру "всехвозможных регрессий", которая заключается

в следующем.

Для заданного значения k (k 1,2,..., n 1)

путем полного перебора возможных комбинаций из k объясняющих переменных,

отобранных из исходного потенциального

набора факторов x1 , x 2 ,..., x n , определяют

такие переменные xi1 , xi2 ,..., xik , для

которых коэффициент детерминации с y

был бы максимальным.

24.

На первом шаге процедуры, полагая k 1 ,находят одну объясняющую переменную из

всего набора, которая является наиболее

информированным фактором, т.е. для неё

2

R max .

На втором шаге процедуры ( k 2 ) определяется уже наиболее информативная пара

переменных, которая имеет наиболее тесную

связь с результатом y . В эту пару может и

не войти тот фактор, который был отобран на

первом шаге. Такой процесс продолжается до

значения

.1

k n

25.

В качестве критерия остановки процесса,т.е. выбора оптимального числа факторов

модели предлагается следующее.

На каждом шаге вычисляется нижняя

доверительная граница коэффициента

детерминации

2k (n k 1)

2

2

ˆ

R (k ) R (k ) 2

1 R (k ) , (5)

2

(n 1)( n 1)

2

ˆ

где R (k ) скорректированный коэффициент

2

min

детерминации для наиболее информативных

факторов, R 2 (k ) обычный коэффициент

детерминации.

26.

В соответствии с критерием останова следуетвыбрать такое k 0 , при котором величина (5)

достигает своего максимума.

3. Выбор формы связи.

При выборе формы связи между результирующим признаком и факторами начинают

с наиболее простой зависимости – линейной.

27.

Если линейная модель множественнойрегрессии неадекватно отражает исследуемое

явление или процесс, то лучшее приближение могут дать нелинейные уравнения. Они,

в свою очередь, могут быть нелинейными

только по факторам, но линейными по параметрам, либо нелинейными как по параметрам, так и по факторам.

Например, уравнение, нелинейное

только по факторам, имеет вид

2

0,5

2

~

y b0 b1 x1 b2 x2 b3 x3 .

28.

Если ввести в рассмотрение новыепеременные

2

0,5

2

x1 x1 , x2 x2 , x3 x3 ,

то получим уже линейное уравнение с новыми переменными

~

y b0 b1 x1 b2 x2 b3 x3 ,

для получения оценок которого в случае выполнения всех предпосылок используется

обычный МНК.

29.

Модели второго типа, например, функциюспроса

1 2

y 0 x1 x 2

после предварительного логарифмирования

ln y ln 0 1 ln x1 2 ln x2 ln

можно линеаризовать

y 0 1 x1 2 x2 ,

путём введения соответствующих новых

переменных.

30.

Измерение тесноты связи переменной yс факторами для моделей первого типа осуществляется с помощью индекса корреляции

n

R 1

2

~

(

y

y

)

i i

i 1

n

2

(

y

y

)

i

i 1

или индекса детерминации R2 ( R)2 .

При рассмотрении альтернативных нелинейных моделей такого типа с одной функциональной формой зависимой переменной y

процедура выбора модели проста: по значе2

ниям R .

31.

Если же модели второго типа, то такойподход неправомерен. В этом случае

используют остаточную сумму e : чем она

меньше, тем точнее модель.

Однако если модели используют разные

функциональные формы y , то проблема

выбора формы усложняется: нельзя непосредственно сравнивать коэффициенты

2

детерминации R или остаточные суммы

n

i 1

n

e .

i 1

2

i

2

i

32.

Например, если в одной модели в левойчасти уравнения стоит y , а в другой

модели - log y , то такое сравнение

n

2

бессмысленно по суммам ei .

i 1

В этом случае можно использовать

стандартную процедуру, известную под

названием теста Бокса-Кокса (или его

частный случай тест Зарембки), который

заключается в следующем.

33.

1.Вычисляется среднее геометрическое y гв выборке.

2. Пересчитываются наблюдения зависимой переменной по формуле:

yi

y .

yг

i

3. Оценивается регрессия для линейной

модели с использованием y i вместо yi и в

логарифмической модели с заменойn log( yi ) на

2

e

log( yi ). Теперь остаточные суммы i сравi 1

нимы и модель с меньшей суммой является

более точной.

34.

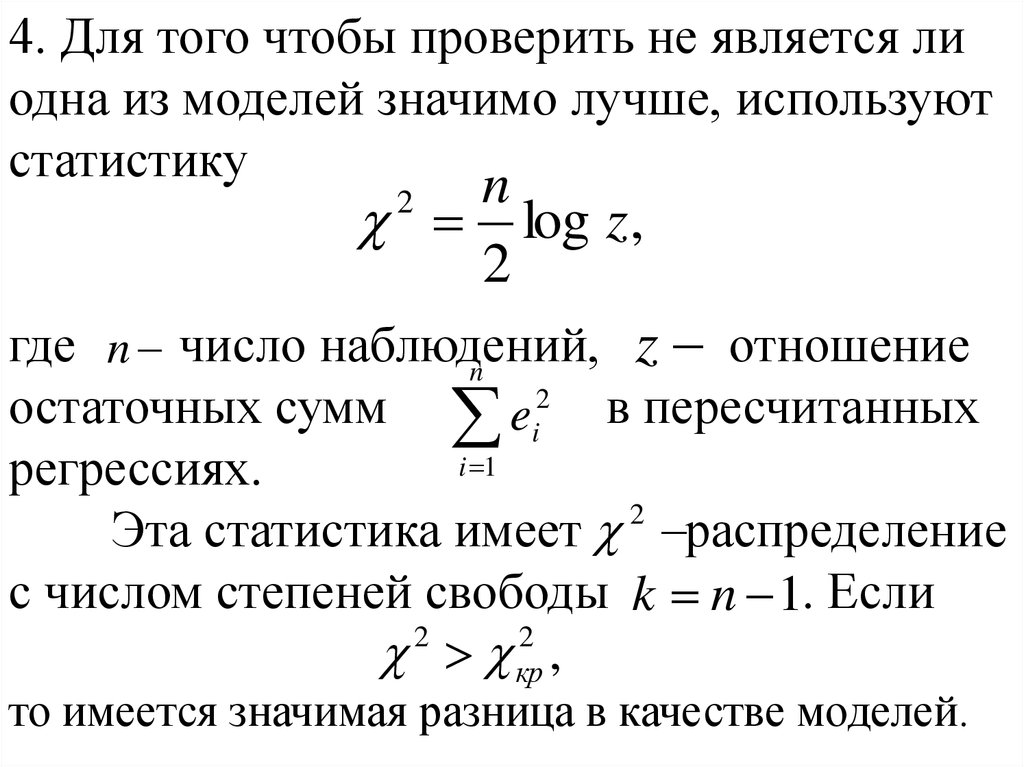

4. Для того чтобы проверить не является лиодна из моделей значимо лучше, используют

статистику

n

log z,

2

где n число наблюдений,

z отношение

n

2

остаточных сумм ei2 в пересчитанных

i 1

регрессиях.

2

распределение

Эта статистика имеет

с числом степеней свободы k n 1. Если

2

2

кр ,

то имеется значимая разница в качестве моделей.

Математика

Математика