Похожие презентации:

Определение количества информации

1.

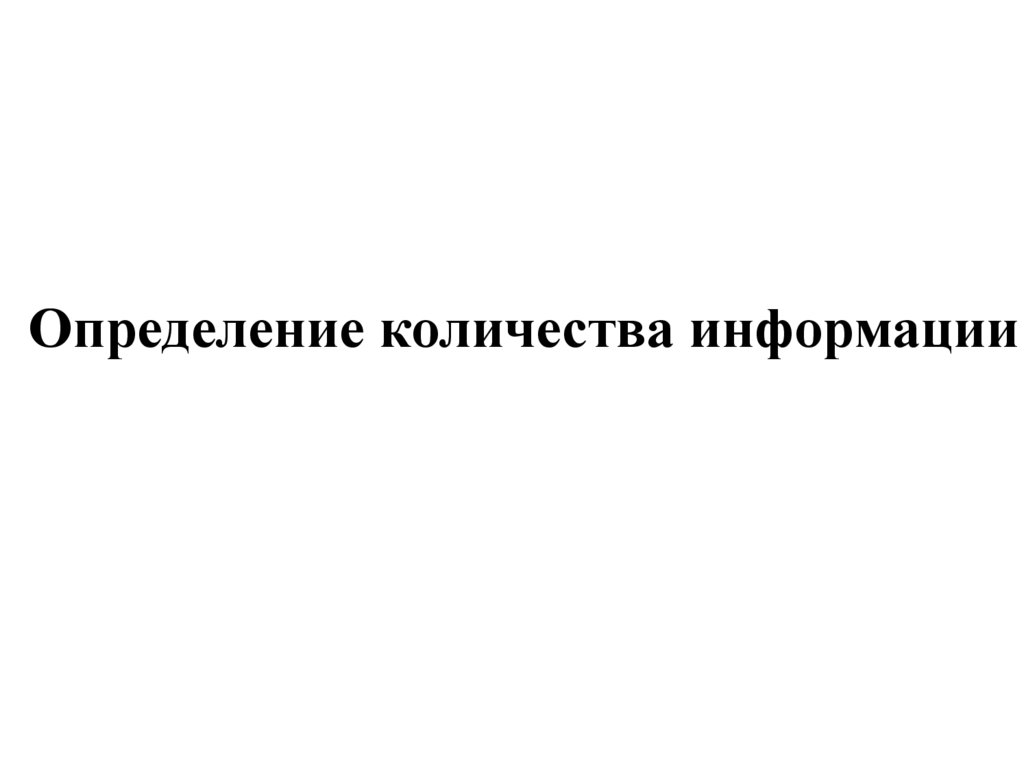

Определение количества информации2. Как измерить информацию?

Вопрос этот очень непростой.Ответ на него зависит от того, что понимать под информацией. Но

поскольку определять информацию можно по-разному, то и способы

измерения тоже могут быть разными.

Измерение

информации

Содержательный

подход

Алфавитный

подход

3.

Содержательный подход к измерению информации.Для человека информация — это знания. Если получение новой информации

приводит к расширению знаний, то можно говорить, что такое сообщение

содержит информацию.

Говорят, что сообщение информативно если оно пополняет знания человека.

Например, прогноз погоды на завтра — информативное сообщение, а сообщение о

вчерашней погоде неинформативно, т.к. нам это уже известно.

Основоположником этого подхода является американский

учёный, математик и электротехник, один из создателей

математической теории информации Клод Элвуд Шеннон

(1916 — 2001).

По

Шеннону,

информация

—

уменьшение

неопределенности наших знаний.

Неопределенность некоторого события — это количество

возможных исходов данного события.

Так, например, если из колоды карт наугад выбирают карту, то

неопределенность равна количеству карт в колоде.

При бросании монеты неопределенность равна 2.

I p log p

N

i 1

i

2

i

- формула Шеннона

4.

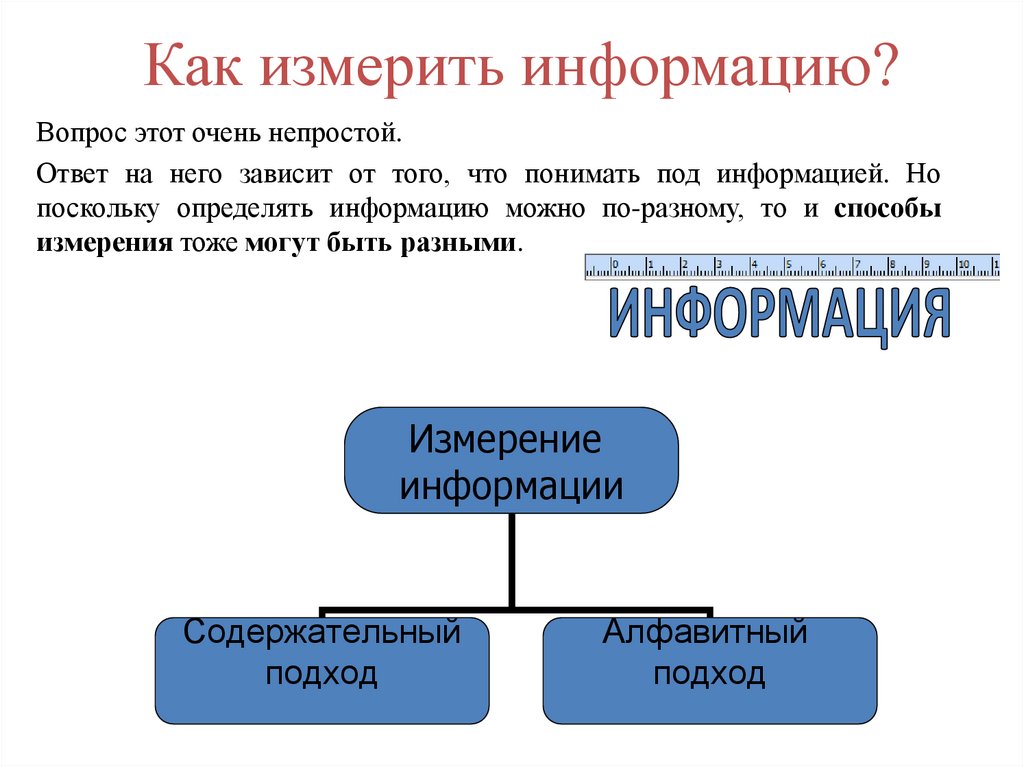

Содержательный подход к измерению информации.Единица измерения информации была определена в науке, которая

называется теорией информации. Эта единица носит название «бит».

Ее определение звучит так:

Сообщение, уменьшающее неопределенность знаний в два раза, несет 1

бит информации.

Неопределенность знаний о некотором событии — это количество

возможных результатов события.

Тогда можно записать формулу:

2i = N

N - количество событий

i - количество информации одного события

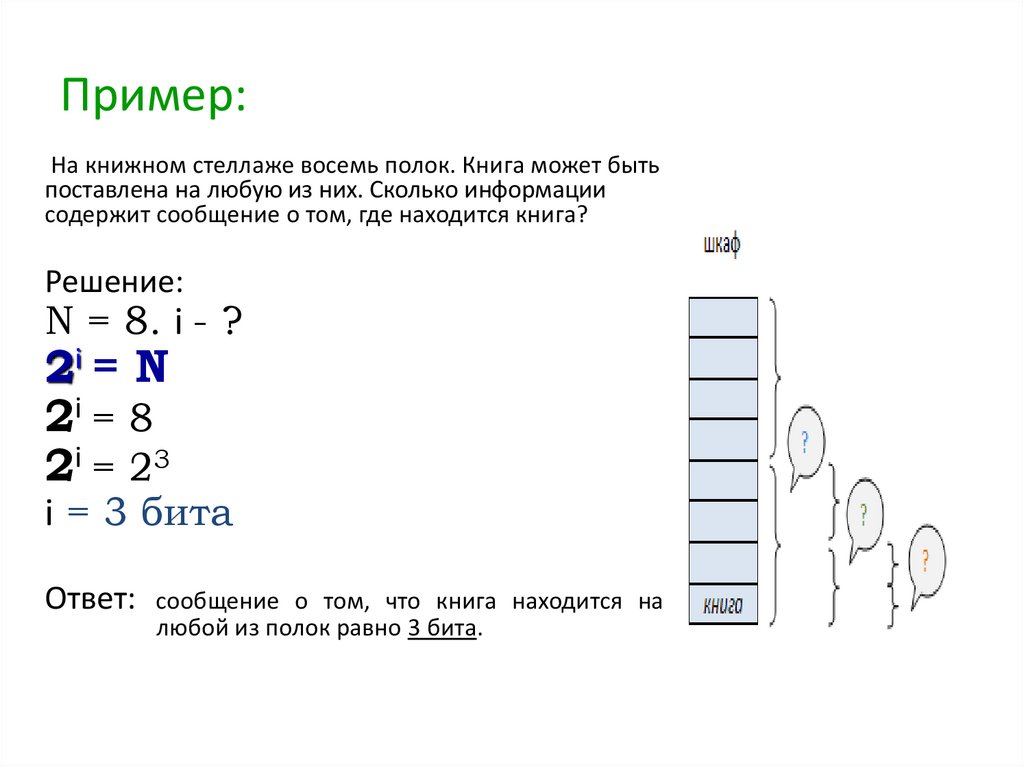

5. Пример:

На книжном стеллаже восемь полок. Книга может бытьпоставлена на любую из них. Сколько информации

содержит сообщение о том, где находится книга?

Решение:

N = 8. i - ?

2i = N

2i = 8

2i = 23

i = 3 бита

Ответ: сообщение о том, что книга находится на

любой из полок равно 3 бита.

6.

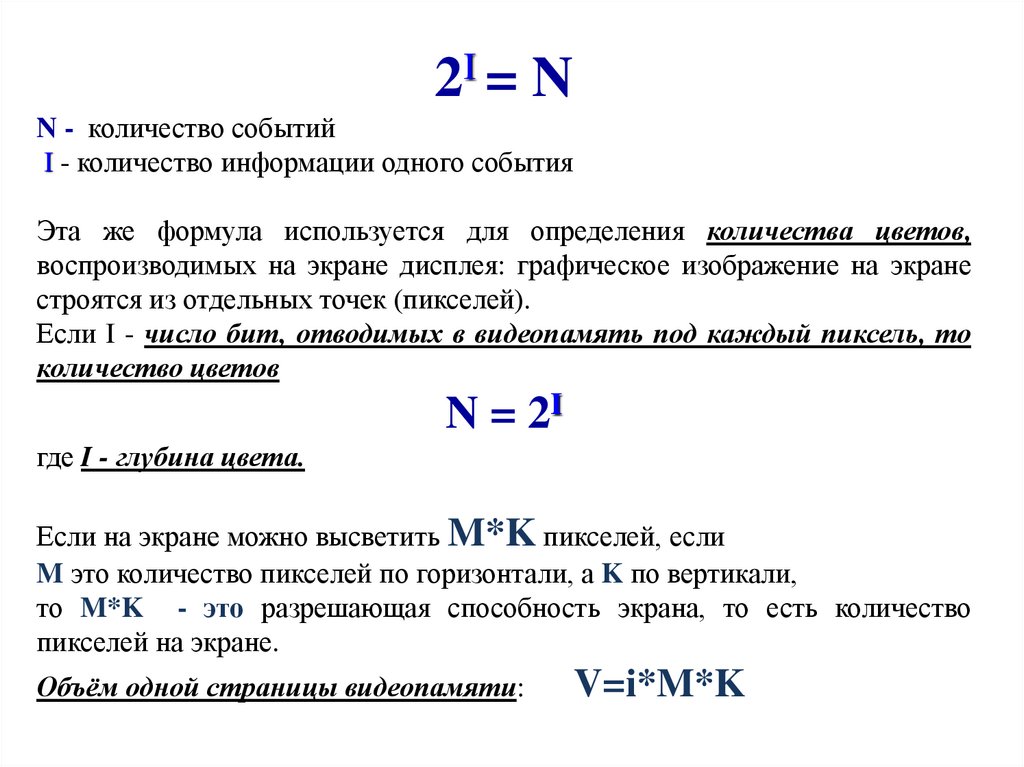

2I = NN - количество событий

I - количество информации одного события

Эта же формула используется для определения количества цветов,

воспроизводимых на экране дисплея: графическое изображение на экране

строятся из отдельных точек (пикселей).

Если I - число бит, отводимых в видеопамять под каждый пиксель, то

количество цветов

N = 2I

где I - глубина цвета.

Если на экране можно высветить M*K пикселей, если

M это количество пикселей по горизонтали, а K по вертикали,

то M*K - это разрешающая способность экрана, то есть количество

пикселей на экране.

Объём одной страницы видеопамяти:

V=i*M*K

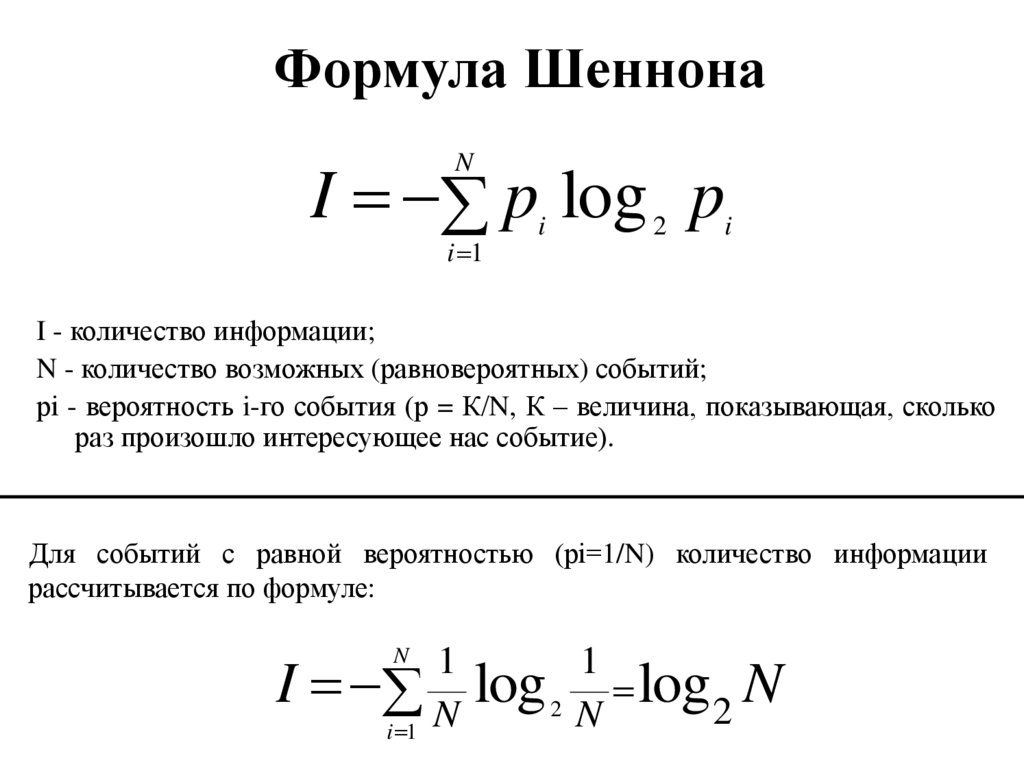

7. Формула Шеннона

I p log pN

i 1

i

2

i

I - количество информации;

N - количество возможных (равновероятных) событий;

рi - вероятность i-го события (р = К/N, К – величина, показывающая, сколько

раз произошло интересующее нас событие).

Для событий с равной вероятностью (рi=1/N) количество информации

рассчитывается по формуле:

1

1

I N log 2 N log 2 N

i 1

N

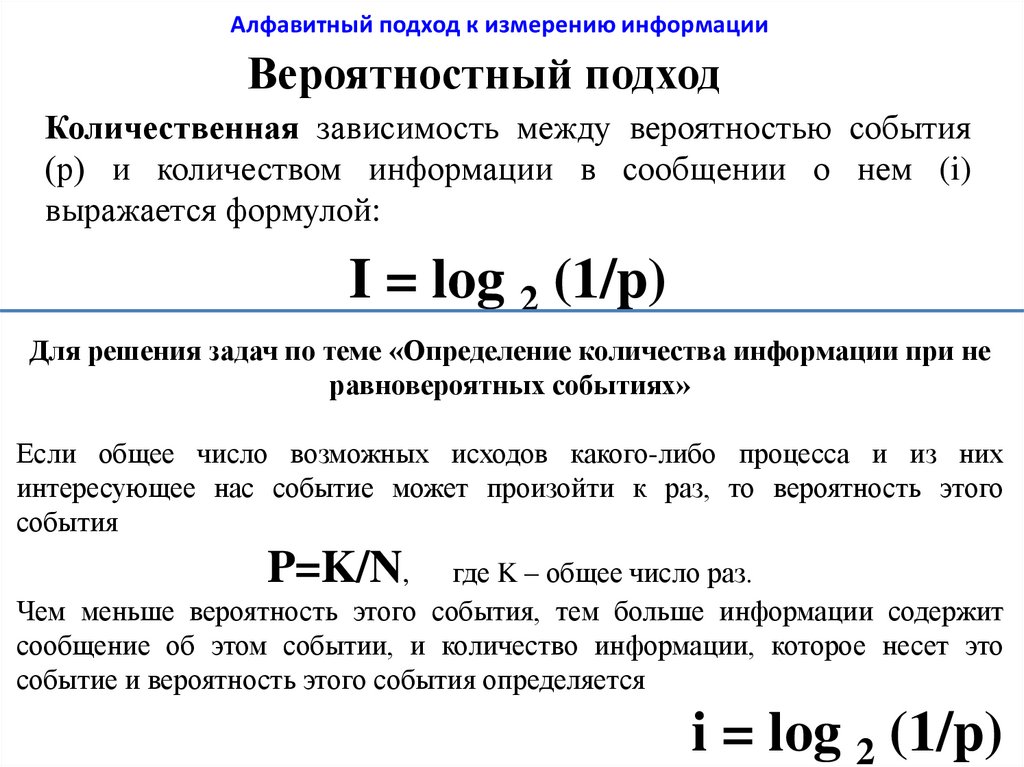

8. Вероятностный подход

Алфавитный подход к измерению информацииВероятностный подход

Количественная зависимость между вероятностью события

(р) и количеством информации в сообщении о нем (i)

выражается формулой:

I = log 2 (1/p)

Для решения задач по теме «Определение количества информации при не

равновероятных событиях»

Если общее число возможных исходов какого-либо процесса и из них

интересующее нас событие может произойти к раз, то вероятность этого

события

P=K/N,

где K – общее число раз.

Чем меньше вероятность этого события, тем больше информации содержит

сообщение об этом событии, и количество информации, которое несет это

событие и вероятность этого события определяется

i = log 2 (1/p)

9.

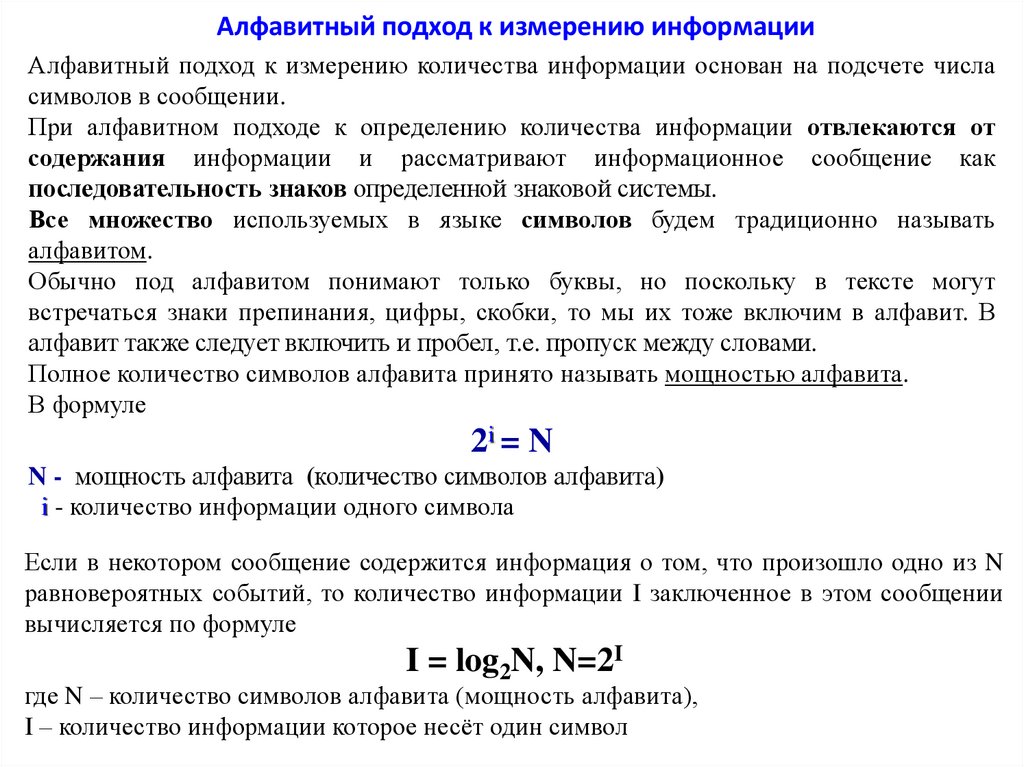

Алфавитный подход к измерению информацииАлфавитный подход к измерению количества информации основан на подсчете числа

символов в сообщении.

При алфавитном подходе к определению количества информации отвлекаются от

содержания информации и рассматривают информационное сообщение как

последовательность знаков определенной знаковой системы.

Все множество используемых в языке символов будем традиционно называть

алфавитом.

Обычно под алфавитом понимают только буквы, но поскольку в тексте могут

встречаться знаки препинания, цифры, скобки, то мы их тоже включим в алфавит. В

алфавит также следует включить и пробел, т.е. пропуск между словами.

Полное количество символов алфавита принято называть мощностью алфавита.

В формуле

2i = N

N - мощность алфавита (количество символов алфавита)

i - количество информации одного символа

Если в некотором сообщение содержится информация о том, что произошло одно из N

равновероятных событий, то количество информации I заключенное в этом сообщении

вычисляется по формуле

I = log2N, N=2I

где N – количество символов алфавита (мощность алфавита),

I – количество информации которое несёт один символ

10.

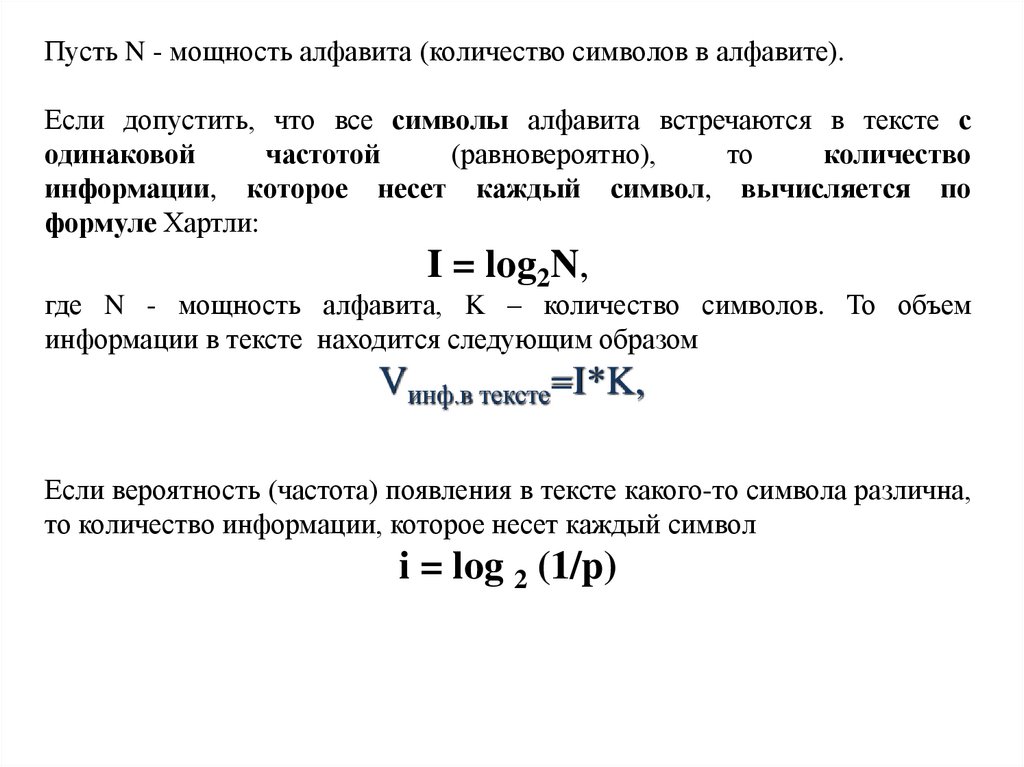

Пусть N - мощность алфавита (количество символов в алфавите).Если допустить, что все символы алфавита встречаются в тексте с

одинаковой

частотой

(равновероятно),

то

количество

информации, которое несет каждый символ, вычисляется по

формуле Хартли:

I = log2N,

где N - мощность алфавита, K – количество символов. То объем

информации в тексте находится следующим образом

Vинф.в тексте=I*K,

Если вероятность (частота) появления в тексте какого-то символа различна,

то количество информации, которое несет каждый символ

i = log 2 (1/p)

11.

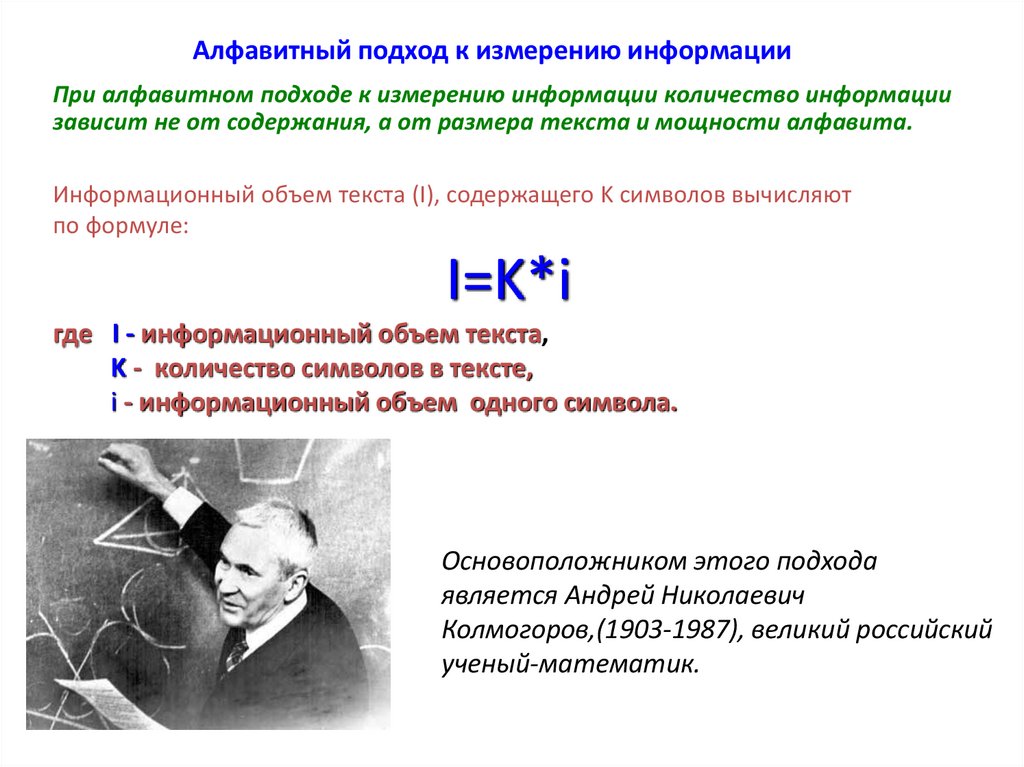

Алфавитный подход к измерению информацииПри алфавитном подходе к измерению информации количество информации

зависит не от содержания, а от размера текста и мощности алфавита.

Информационный объем текста (I), содержащего K символов вычисляют

по формуле:

I=K*i

где I - информационный объем текста,

K - количество символов в тексте,

i - информационный объем одного символа.

Основоположником этого подхода

является Андрей Николаевич

Колмогоров,(1903-1987), великий российский

ученый-математик.

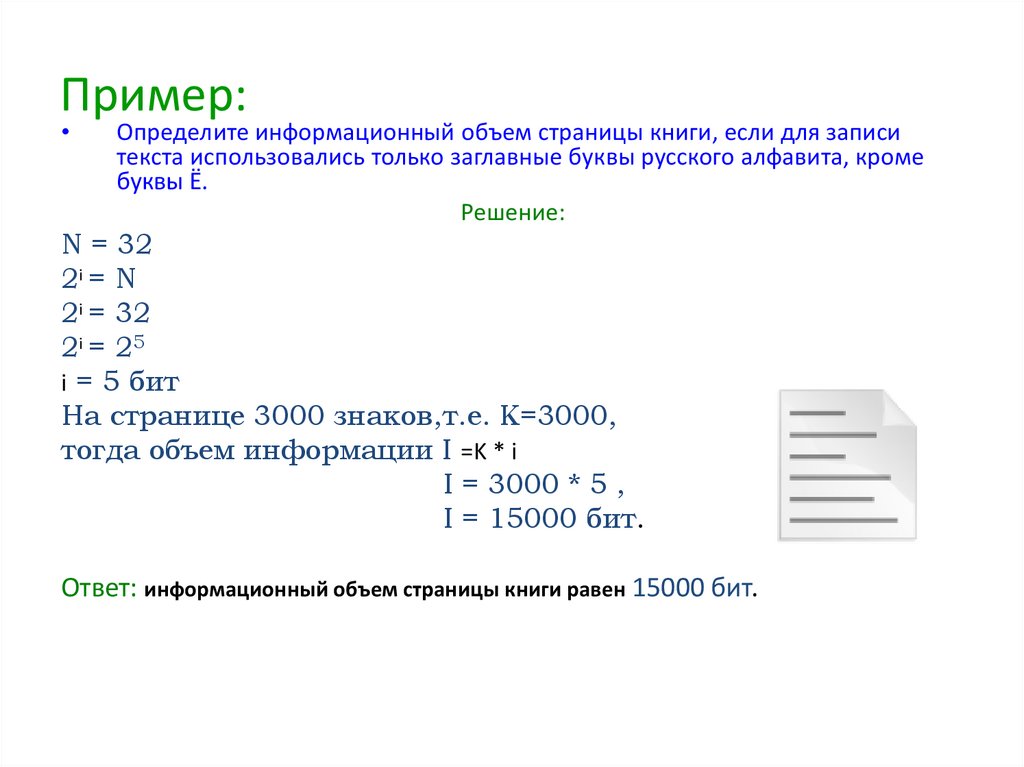

12. Пример:

Определите информационный объем страницы книги, если для записи

текста использовались только заглавные буквы русского алфавита, кроме

буквы Ё.

Решение:

N = 32

2i = N

2i = 32

2i = 25

i = 5 бит

На странице 3000 знаков,т.е. К=3000,

тогда объем информации I =K * i

I = 3000 * 5 ,

I = 15000 бит.

Ответ: информационный объем страницы книги равен 15000 бит.

13.

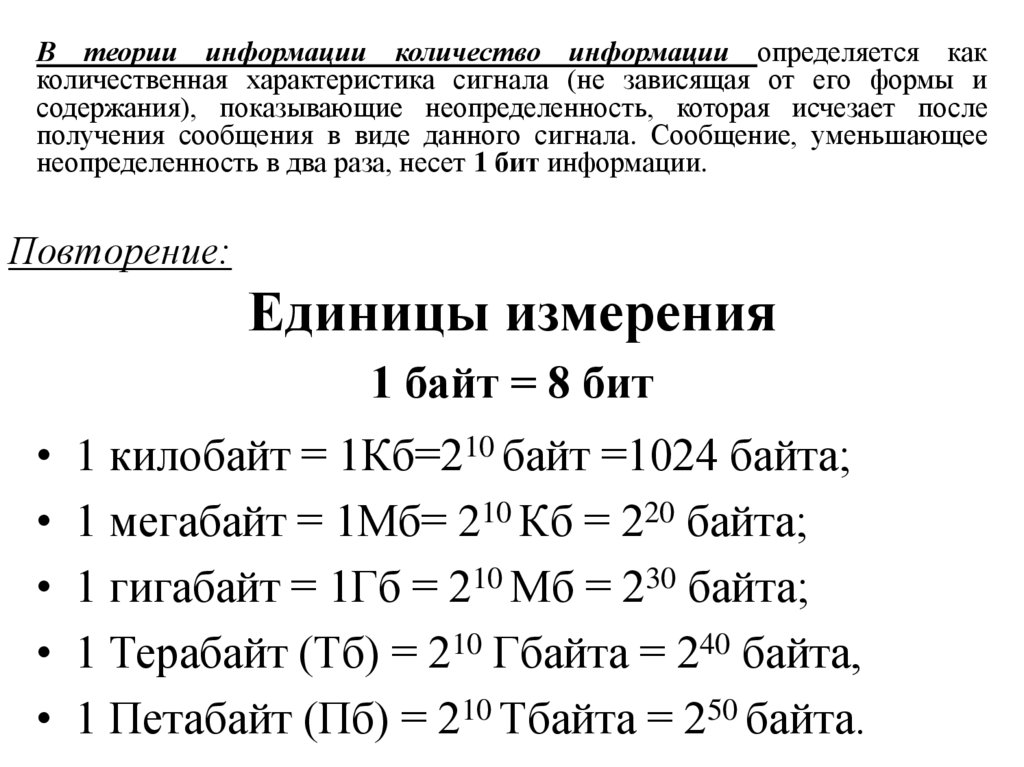

В теории информации количество информации определяется какколичественная характеристика сигнала (не зависящая от его формы и

содержания), показывающие неопределенность, которая исчезает после

получения сообщения в виде данного сигнала. Сообщение, уменьшающее

неопределенность в два раза, несет 1 бит информации.

Повторение:

Единицы измерения

1 байт = 8 бит

• 1 килобайт = 1Кб=210 байт =1024 байта;

• 1 мегабайт = 1Мб= 210 Кб = 220 байта;

• 1 гигабайт = 1Гб = 210 Мб = 230 байта;

• 1 Терабайт (Тб) = 210 Гбайта = 240 байта,

• 1 Петабайт (Пб) = 210 Тбайта = 250 байта.

14.

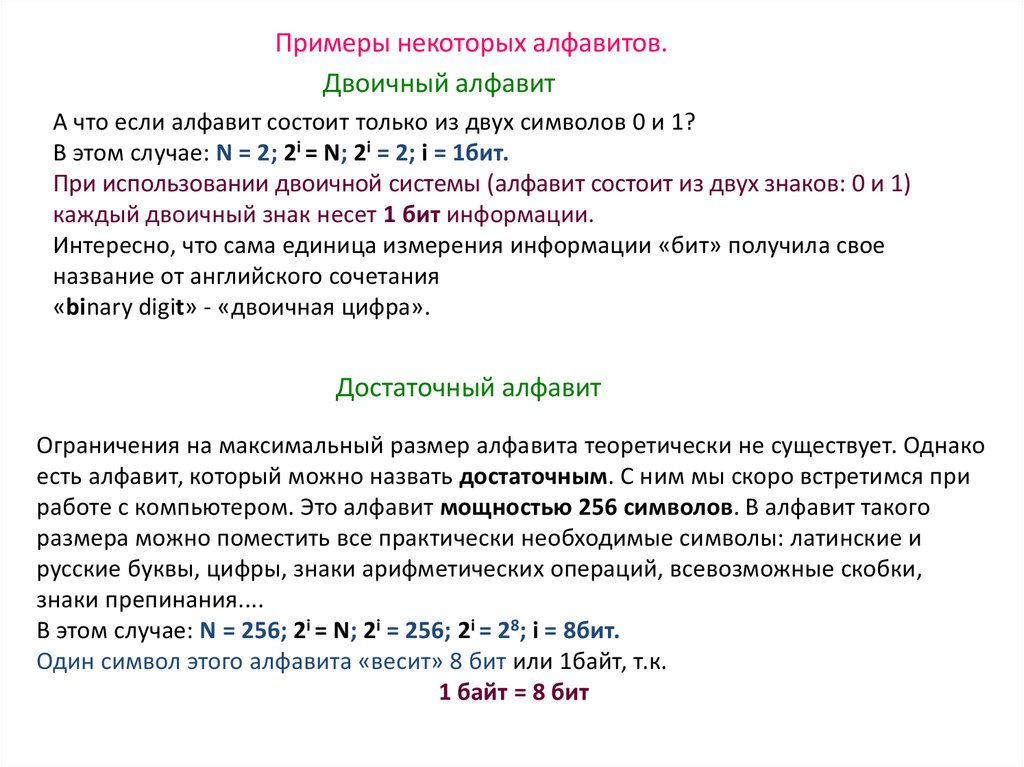

Примеры некоторых алфавитов.Двоичный алфавит

А что если алфавит состоит только из двух символов 0 и 1?

В этом случае: N = 2; 2i = N; 2i = 2; i = 1бит.

При использовании двоичной системы (алфавит состоит из двух знаков: 0 и 1)

каждый двоичный знак несет 1 бит информации.

Интересно, что сама единица измерения информации «бит» получила свое

название от английского сочетания

«binary digit» - «двоичная цифра».

Достаточный алфавит

Ограничения на максимальный размер алфавита теоретически не существует. Однако

есть алфавит, который можно назвать достаточным. С ним мы скоро встретимся при

работе с компьютером. Это алфавит мощностью 256 символов. В алфавит такого

размера можно поместить все практически необходимые символы: латинские и

русские буквы, цифры, знаки арифметических операций, всевозможные скобки,

знаки препинания....

В этом случае: N = 256; 2i = N; 2i = 256; 2i = 28; i = 8бит.

Один символ этого алфавита «весит» 8 бит или 1байт, т.к.

1 байт = 8 бит

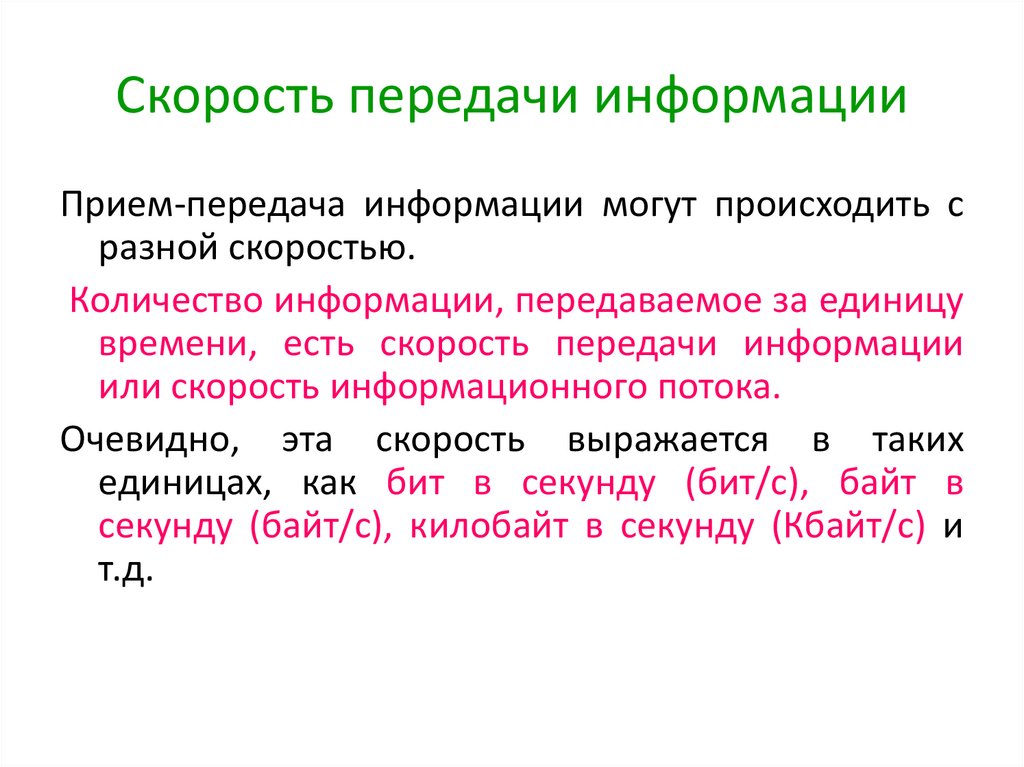

15. Скорость передачи информации

Прием-передача информации могут происходить сразной скоростью.

Количество информации, передаваемое за единицу

времени, есть скорость передачи информации

или скорость информационного потока.

Очевидно, эта скорость выражается в таких

единицах, как бит в секунду (бит/с), байт в

секунду (байт/с), килобайт в секунду (Кбайт/с) и

т.д.

16.

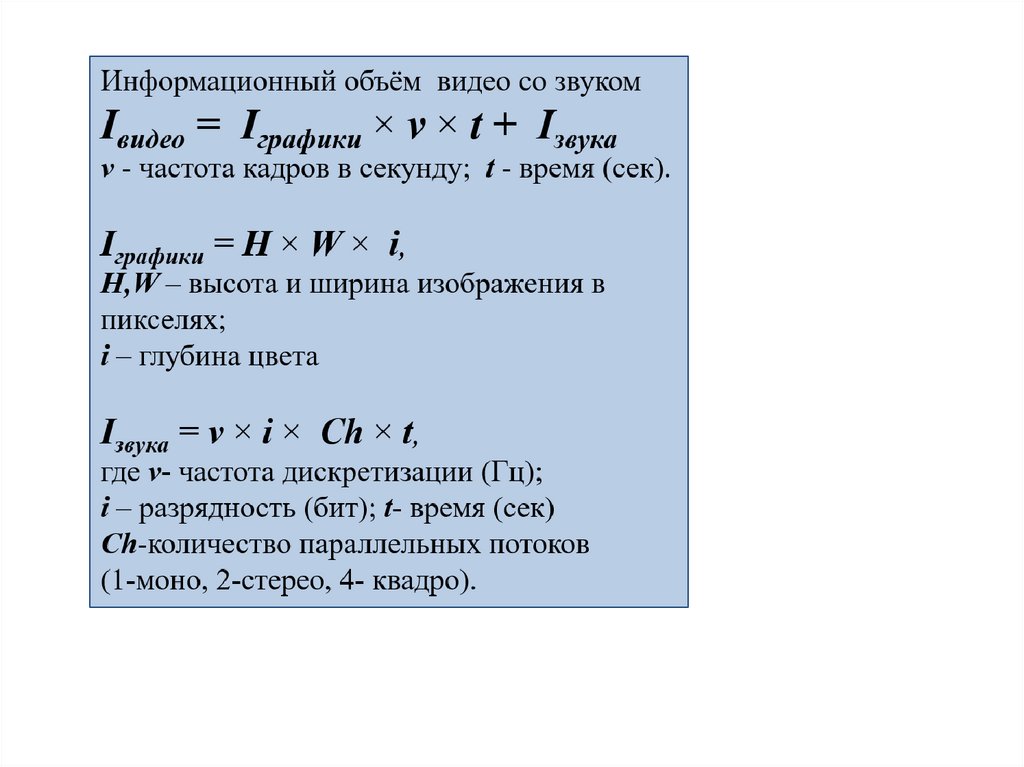

Кодирование и измерение видеоинформацииЕсли

рассматривать

видеоинформацию

как

последовательность

изображений, появляющихся на экране с определенной частотой (частотой

кадров в секунду) то можно понять, что видео может быть закодировано

подобно тому, как кодируются растровые изображения (с той разницей, что

этих

изображений

много).

Такой

способ

используется

в

формате *.AVI (несжатое видео) - высокое качество и огромные размеры

файлов. Существуют способы сжатия видеоинформации путем

преобразования файла в другие форматы.

Информационный объём видео информации

Информатика

Информатика