Похожие презентации:

Разработка модели предсказания подсказок, использованных для генерации изображения

1.

Тема:«Разработка модели предсказания

подсказок, использованных для

генерации изображения»

Научный руководитель:

к.ф.-м.н. Котелина Надежда Олеговна

Выполнил:

студент группы 112-МКо Рочев Игорь Сергеевич

2.

АктуальностьИнженерия подсказок - это дисциплина для разработки и

оптимизации подсказок с целью эффективного использования

языковых моделей для широкого спектра приложений и

исследовательских тем.

Навыки инженерии подсказок помогают лучше понять

возможности и ограничения больших языковых моделей.

Исследователи используют инженерию подсказок для улучшения

возможностей больших языковых моделей.

3.

Цель и задачи работыЦелью работы является создание модели, способной надежно

предсказывать подсказки, которые использовались для

создания изображений.

Задачи:

• Изучение архитектуры нейронных сетей «Transformer» ;

• Изучение языка программирования Python и его библиотек;

• Исследование, сравнение и реализация моделей

нейронных сетей для достижения цели.

4.

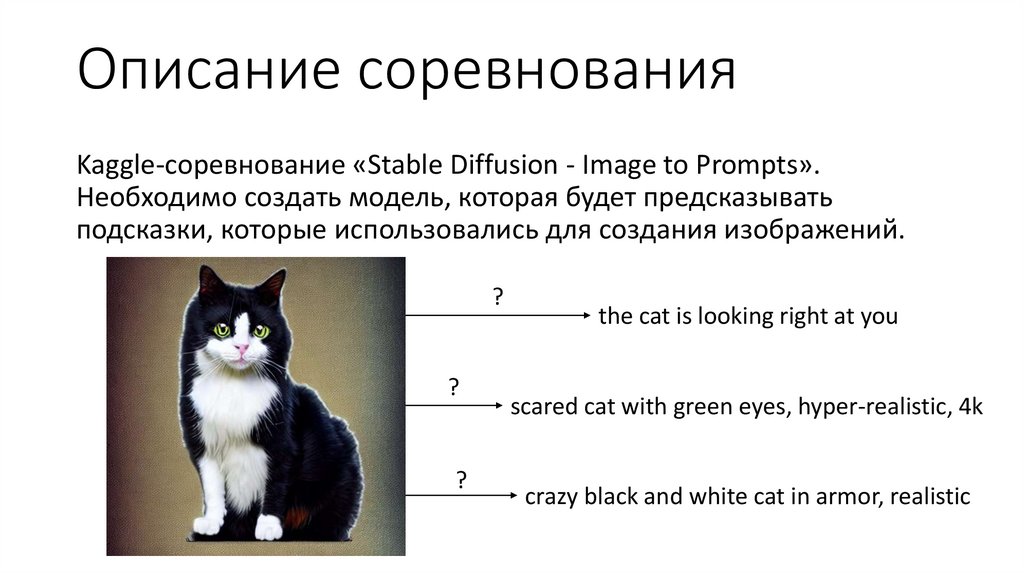

Описание соревнованияKaggle-соревнование «Stable Diffusion - Image to Prompts».

Необходимо создать модель, которая будет предсказывать

подсказки, которые использовались для создания изображений.

?

?

?

the cat is looking right at you

scared cat with green eyes, hyper-realistic, 4k

crazy black and white cat in armor, realistic

5.

Данныеimages/ - изображения, сгенерированные из подсказок; задача - предсказать

подсказку, которая была использована для создания каждого изображения в

этой папке.

6.

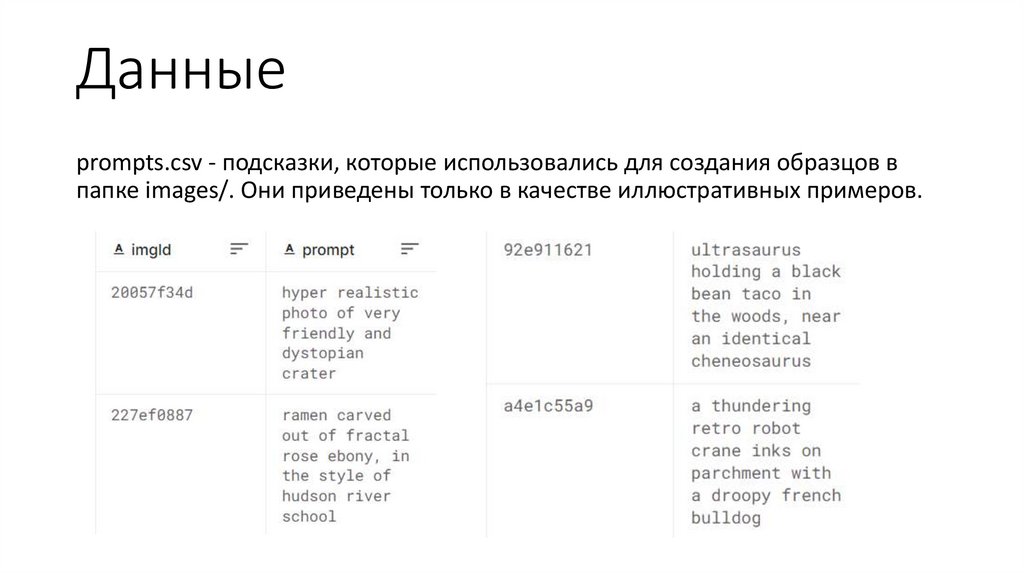

Данныеprompts.csv - подсказки, которые использовались для создания образцов в

папке images/. Они приведены только в качестве иллюстративных примеров.

7.

Данныеsample_submission.csv - образец файла отправки в правильном формате.

8.

Инструментарий• среда разработки Kaggle Notebook;

• язык программирования Python и его библиотеки.

9.

ТрансформерыTransformer – архитектура нейронных сетей, в которой отказались

от рекуррентности, а вместо этого полностью полагаются на

механизм внимания для установления глобальных зависимостей

между входом и выходом.

10.

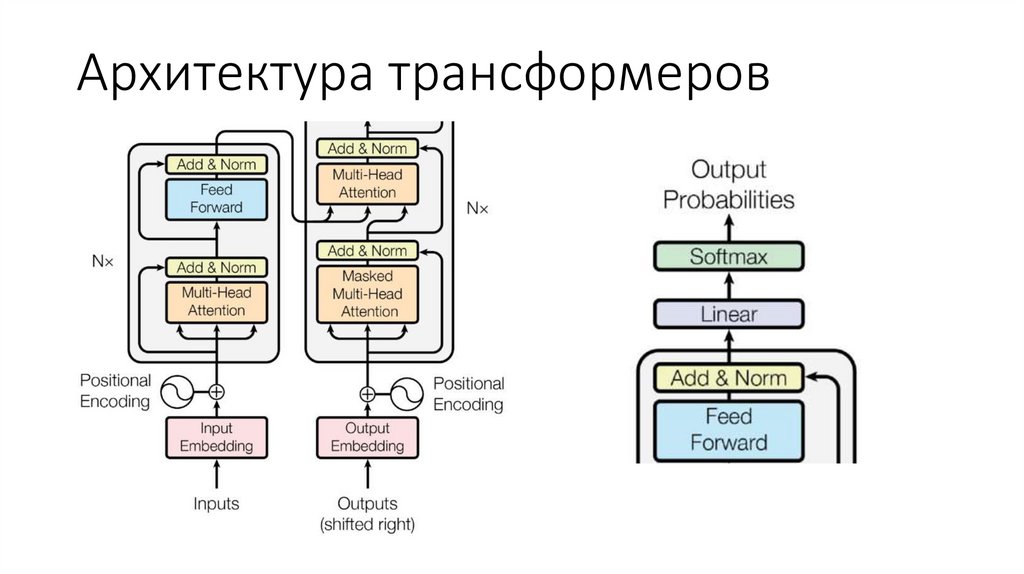

Архитектура трансформеров11.

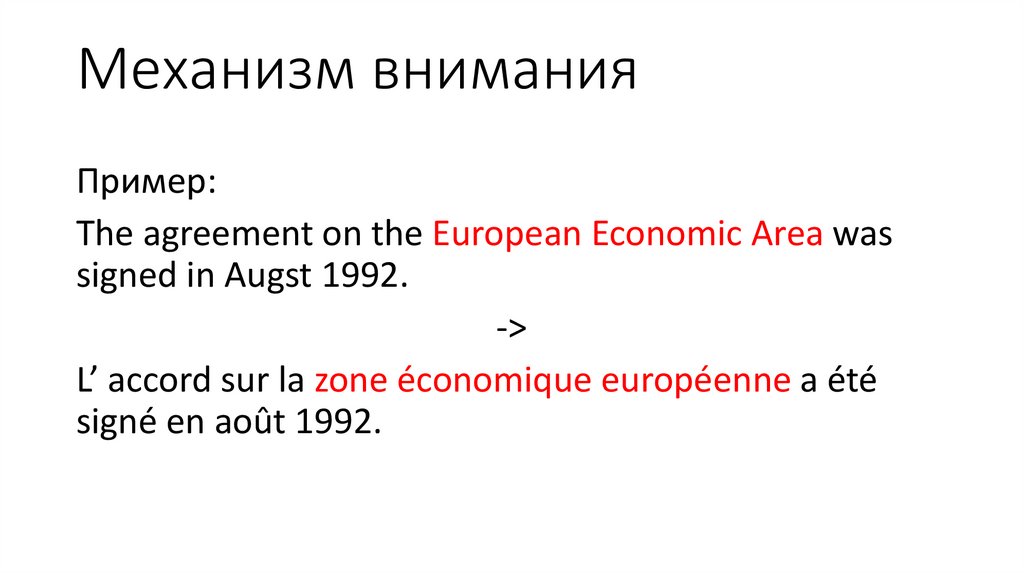

Механизм вниманияМеханизм внимания («attention») позволяет

фокусироваться на релевантных частях входной

последовательности по мере необходимости.

12.

Механизм вниманияПример:

The agreement on the European Economic Area was

signed in Augst 1992.

->

L’ accord sur la zone économique européenne a été

signé en août 1992.

13.

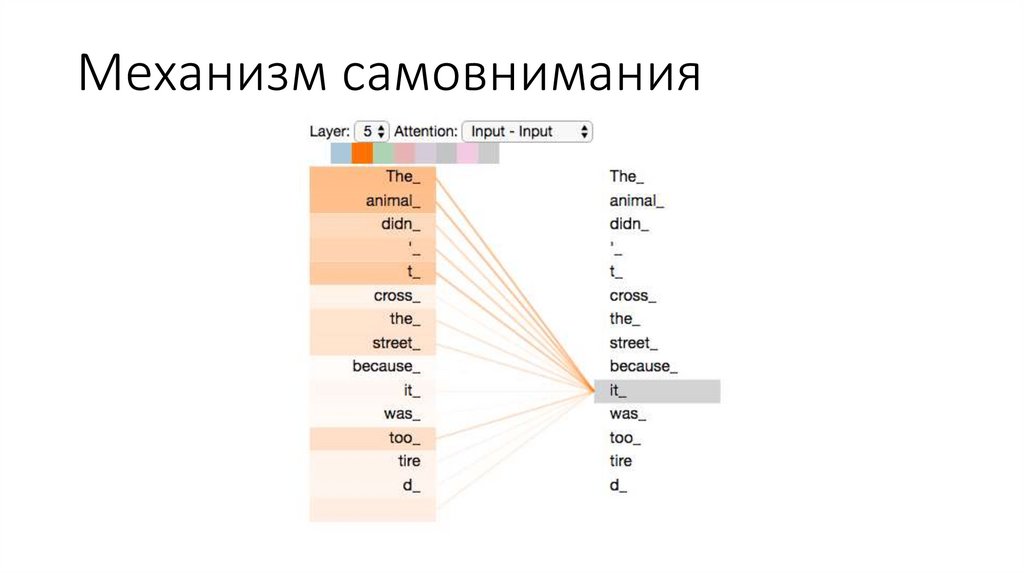

Механизм самовнимания14.

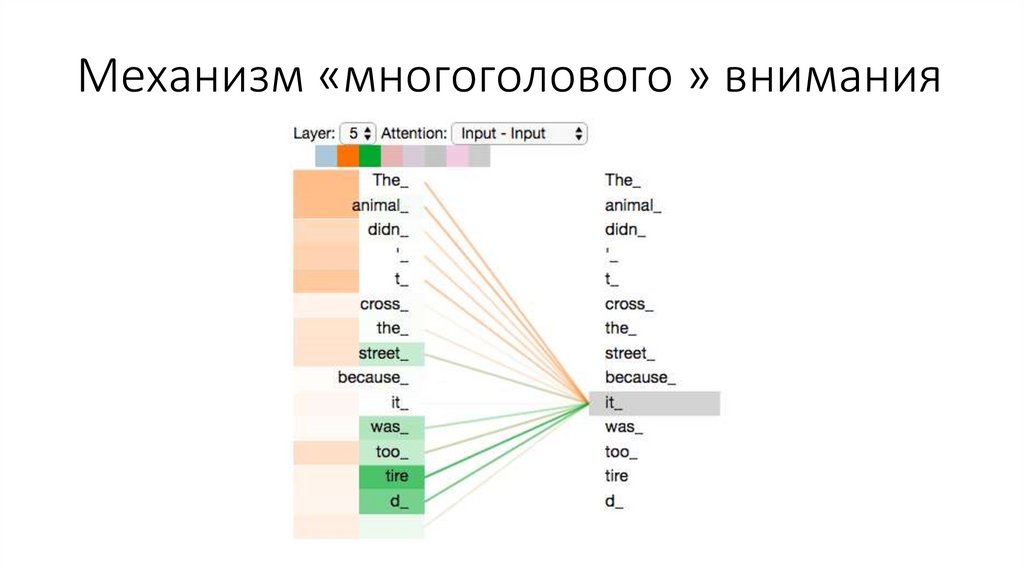

Механизм «многоголового » внимания15.

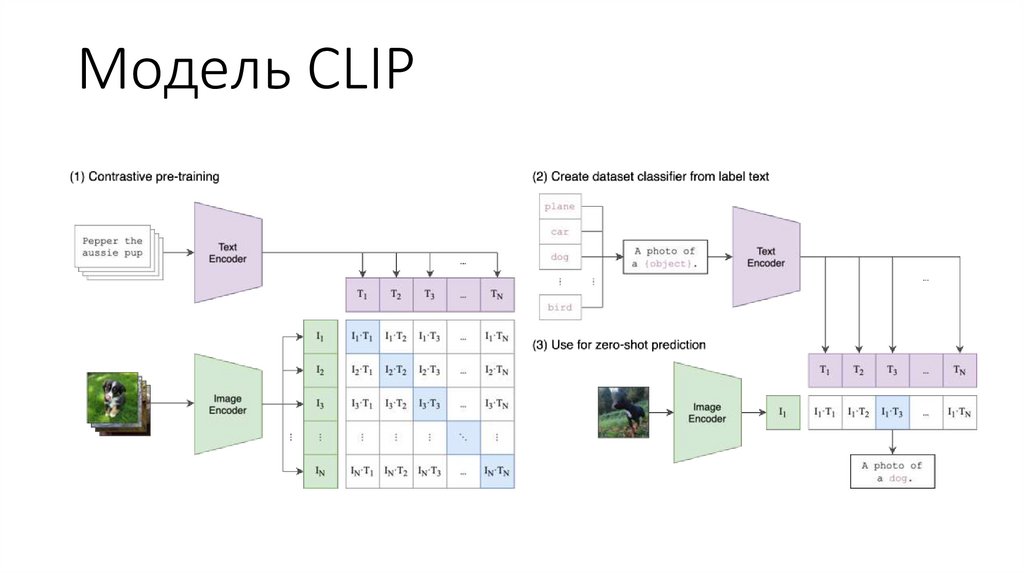

Модель CLIP16.

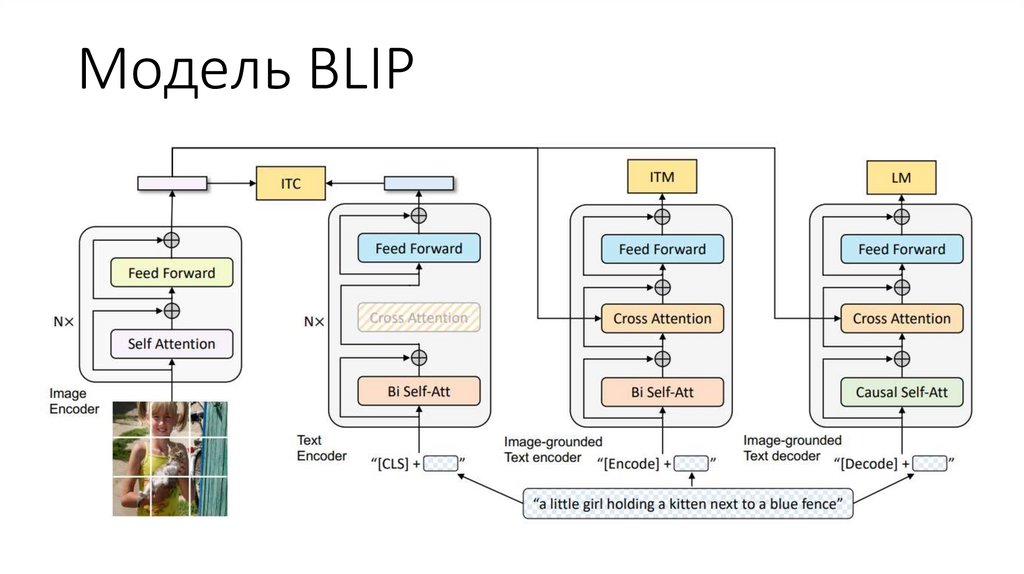

Модель BLIP17.

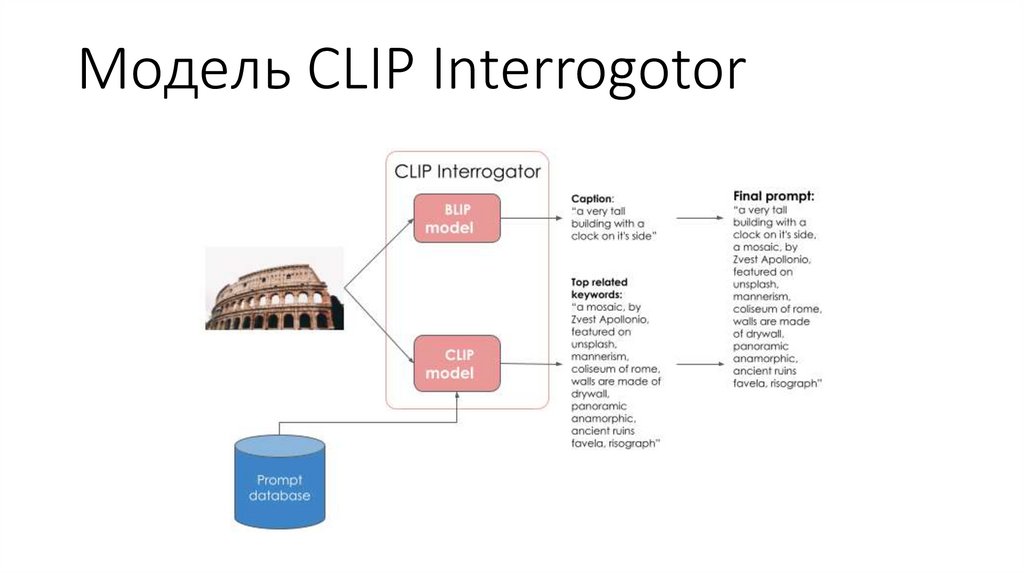

Модель CLIP Interrogotor18.

Список литературы1. Руководство «Prompt Engineering» [Электронный источник]. URL:

https://www.promptingguide.ai/

2. Соревнование «Stable Diffusion – Image to Prompts» [Электронный источник]. URL:

https://www.kaggle.com/competitions/stable-diffusion-image-to-prompts

3. Статья «Attention is All You Need» [Электронный источник]. URL:

https://arxiv.org/pdf/1706.03762.pdf

4. Статья «Visualizing A Neural Machine Translation Model (Mechanics of Seq2seq

Models With Attention)» [Электронный источник]. URL:

https://jalammar.github.io/visualizing-neural-machine-translation-mechanics-ofseq2seq-models-with-attention/

5. Статья «The Illustrated Transformer» [Электронный источник]. URL:

https://jalammar.github.io/illustrated-transformer/

19.

Список литературы6. Документация SentenceTransformers [Электронный источник]. URL:

https://www.sbert.net/

7. Статья «Learning Transferable Visual Models From Natural Language

Supervision» [Электронный источник]. URL:

https://arxiv.org/pdf/2103.00020.pdf

Программирование

Программирование Информатика

Информатика