Похожие презентации:

Эконометрика. Обобщенный метод наименьших квадратов

1. Эконометрика

ОБОБЩЕННЫЙМЕТОД НАИМЕНЬШИХ КВАДРАТОВ

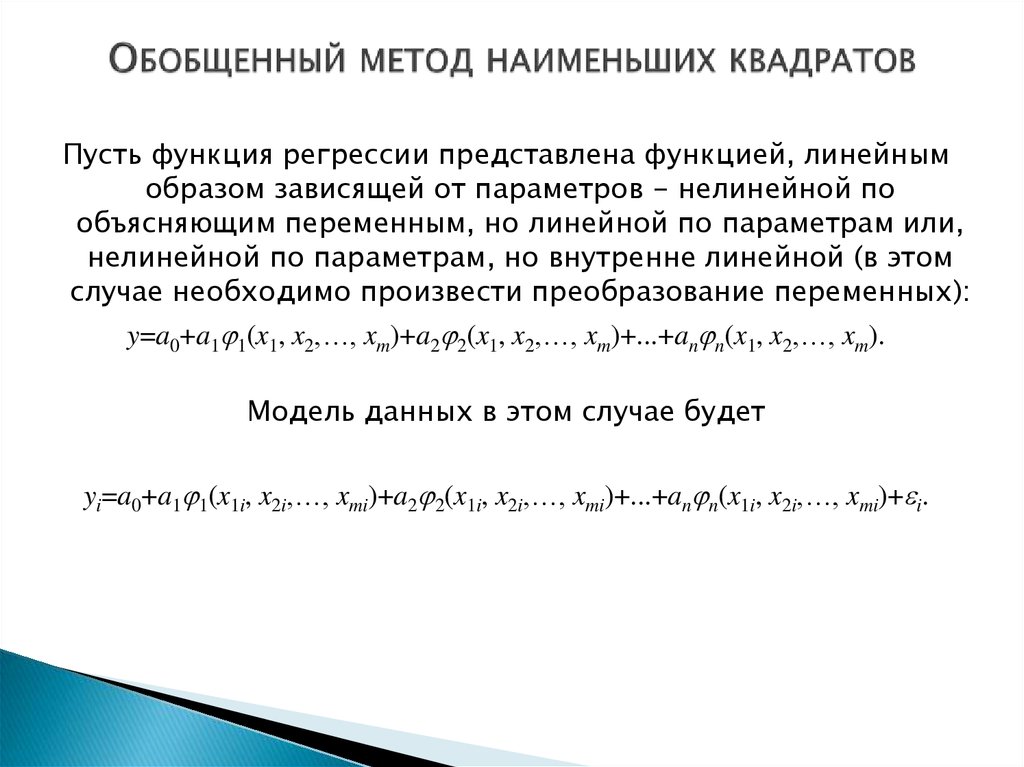

2. Обобщенный метод наименьших квадратов

Пусть функция регрессии представлена функцией, линейнымобразом зависящей от параметров - нелинейной по

объясняющим переменным, но линейной по параметрам или,

нелинейной по параметрам, но внутренне линейной (в этом

случае необходимо произвести преобразование переменных):

y=a0+a1 1(x1, x2,…, xm)+a2 2(x1, x2,…, xm)+...+an n(x1, x2,…, xm).

Модель данных в этом случае будет

yi=a0+a1 1(x1i, x2i,…, xmi)+a2 2(x1i, x2i,…, xmi)+...+an n(x1i, x2i,…, xmi)+ i.

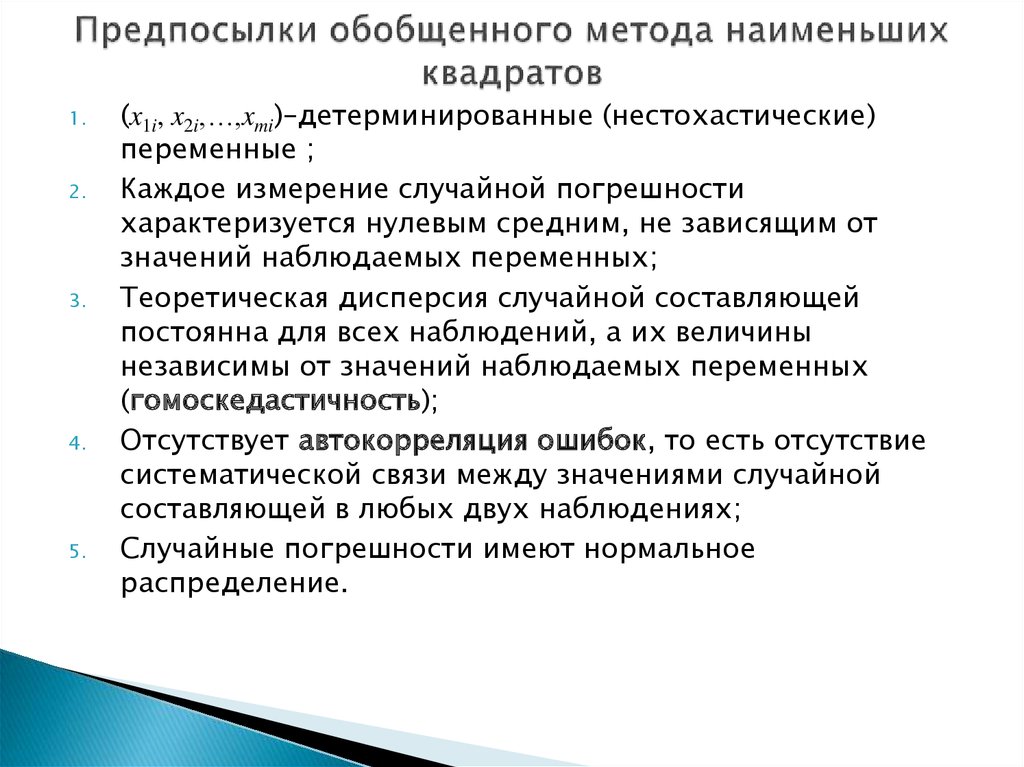

3. Предпосылки обобщенного метода наименьших квадратов

1.2.

3.

4.

5.

(x1i, x2i,…,xmi)–детерминированные (нестохастические)

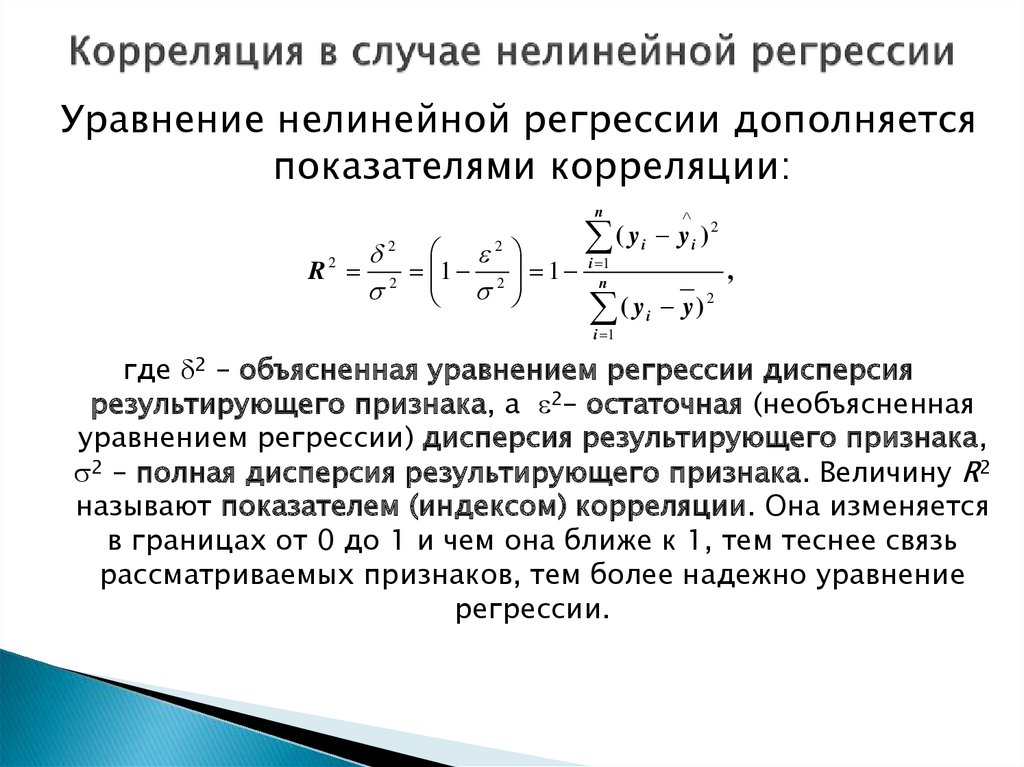

переменные ;

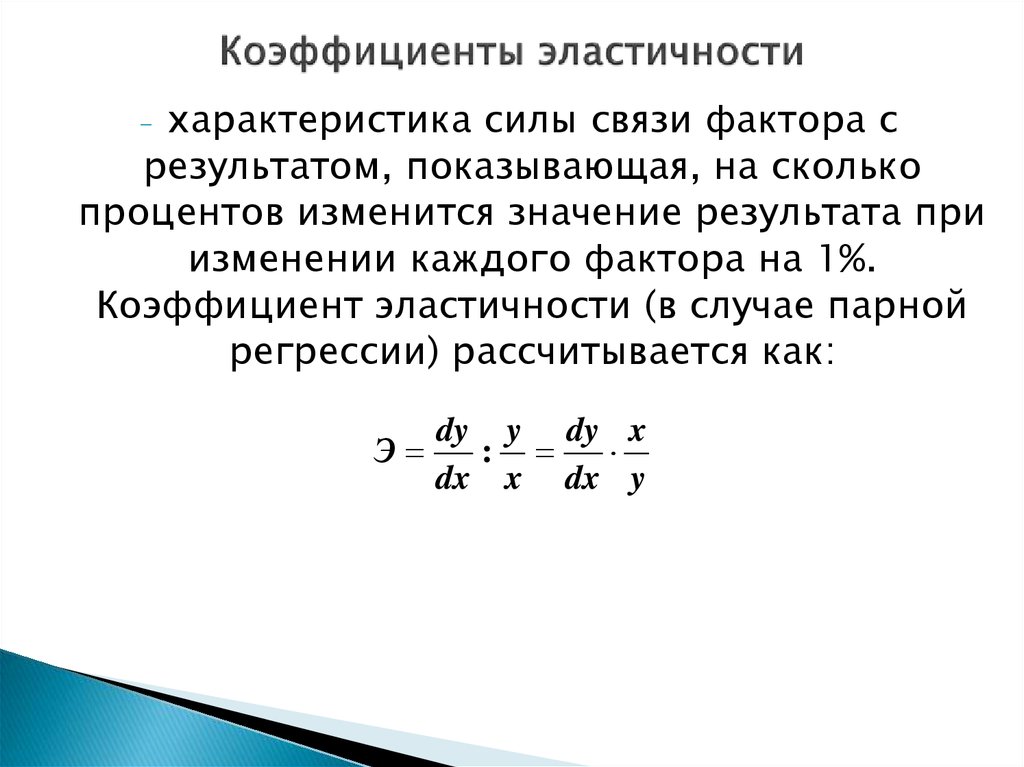

Каждое измерение случайной погрешности

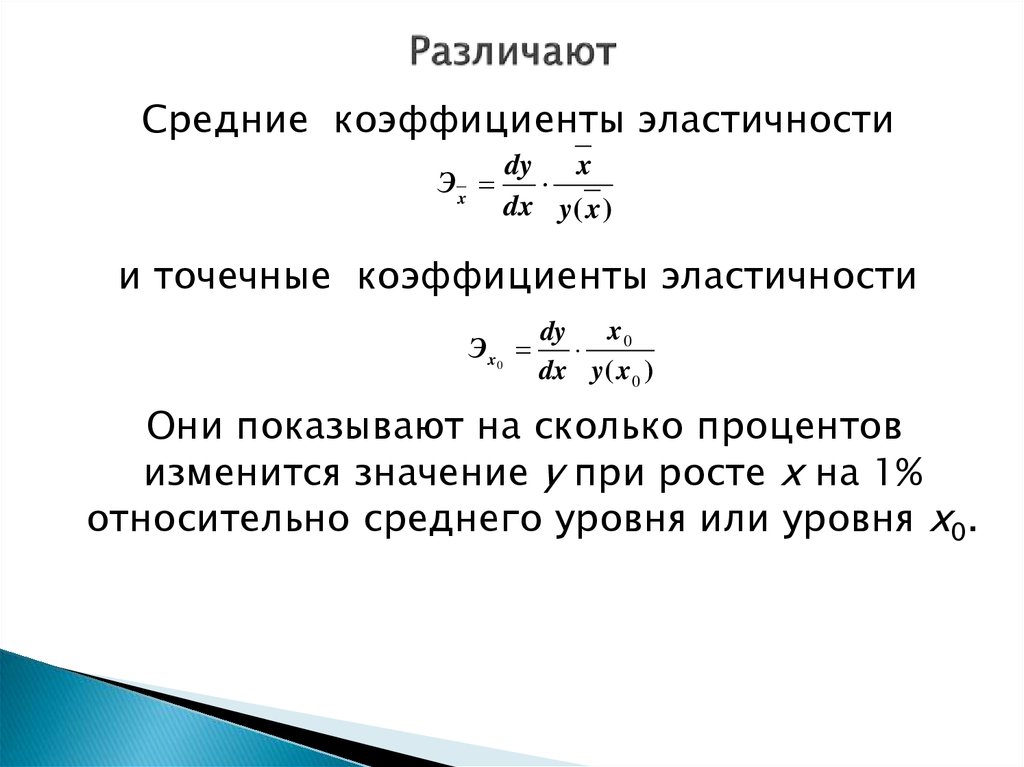

характеризуется нулевым средним, не зависящим от

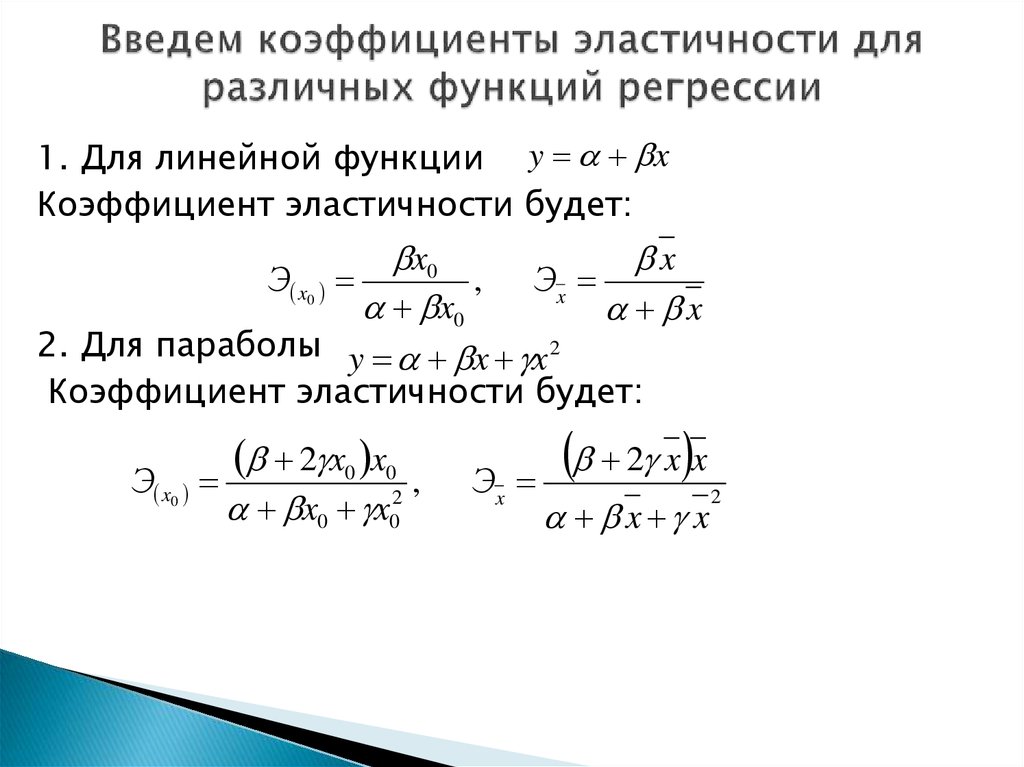

значений наблюдаемых переменных;

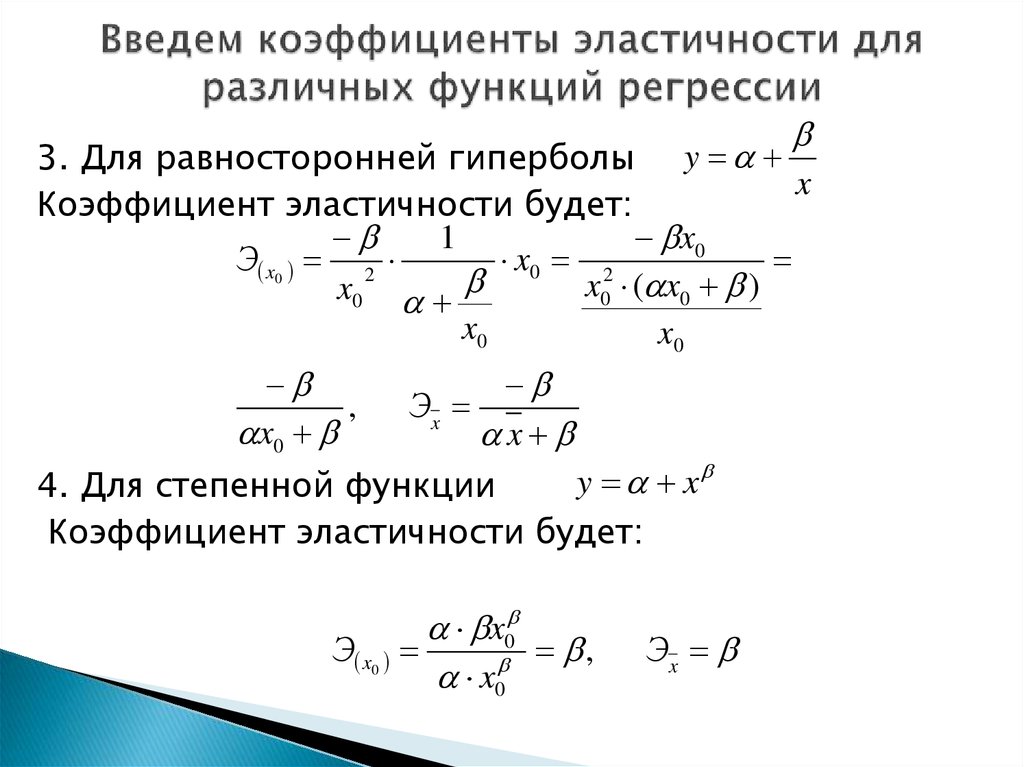

Теоретическая дисперсия случайной составляющей

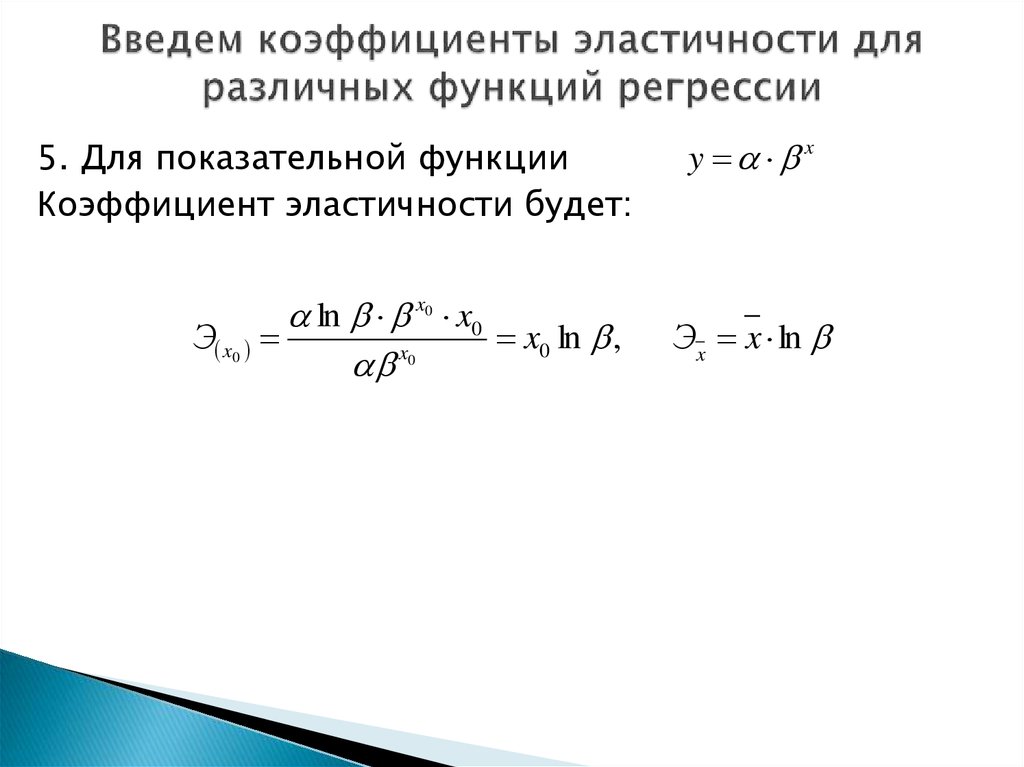

постоянна для всех наблюдений, а их величины

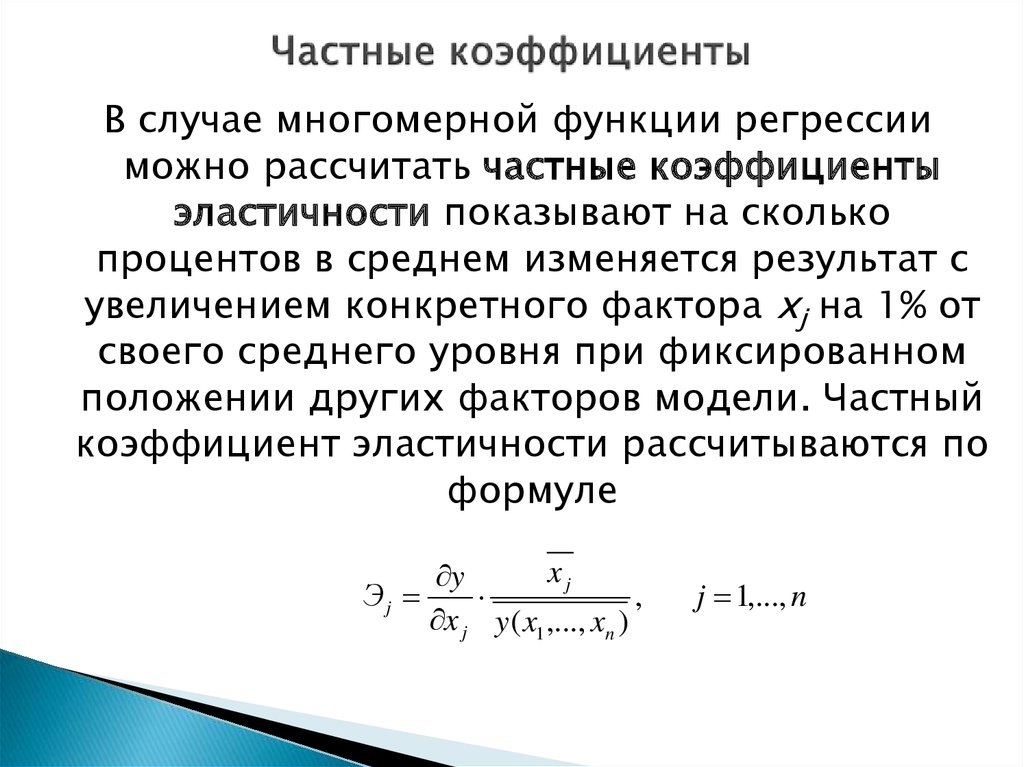

независимы от значений наблюдаемых переменных

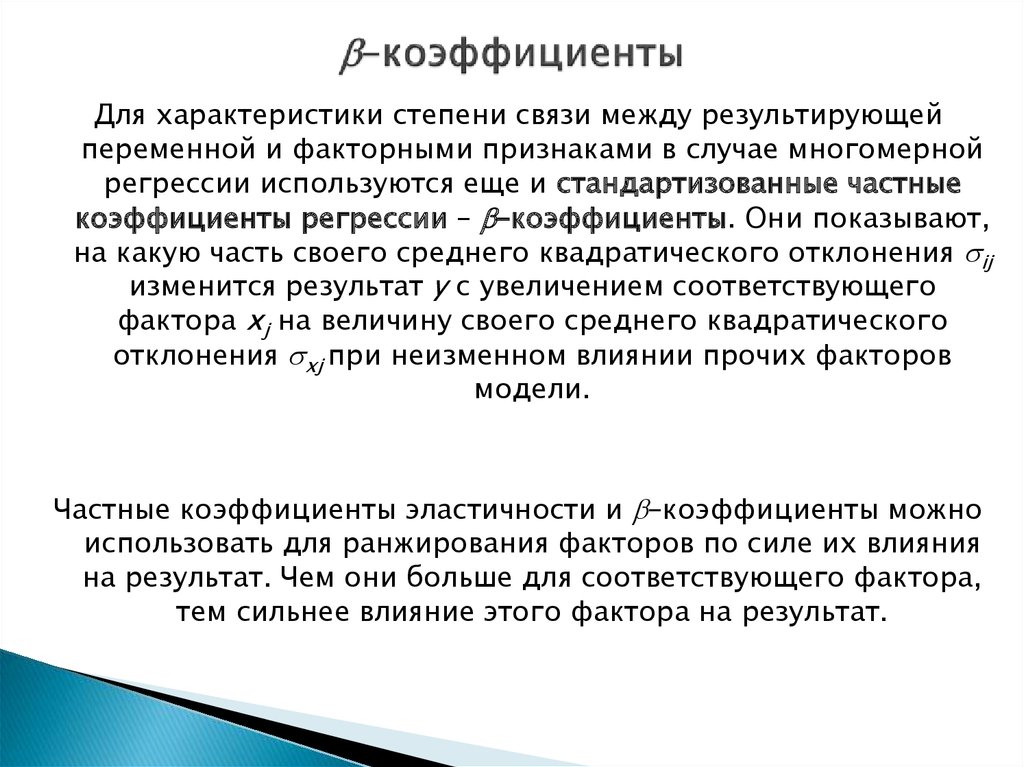

(гомоскедастичность);

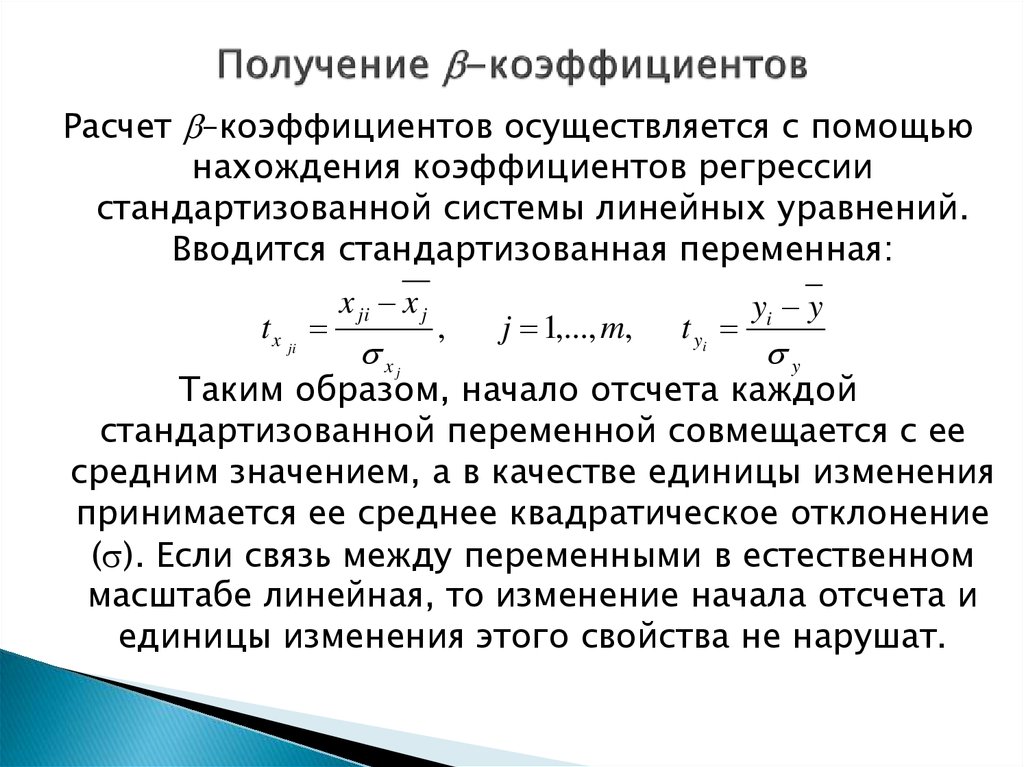

Отсутствует автокорреляция ошибок, то есть отсутствие

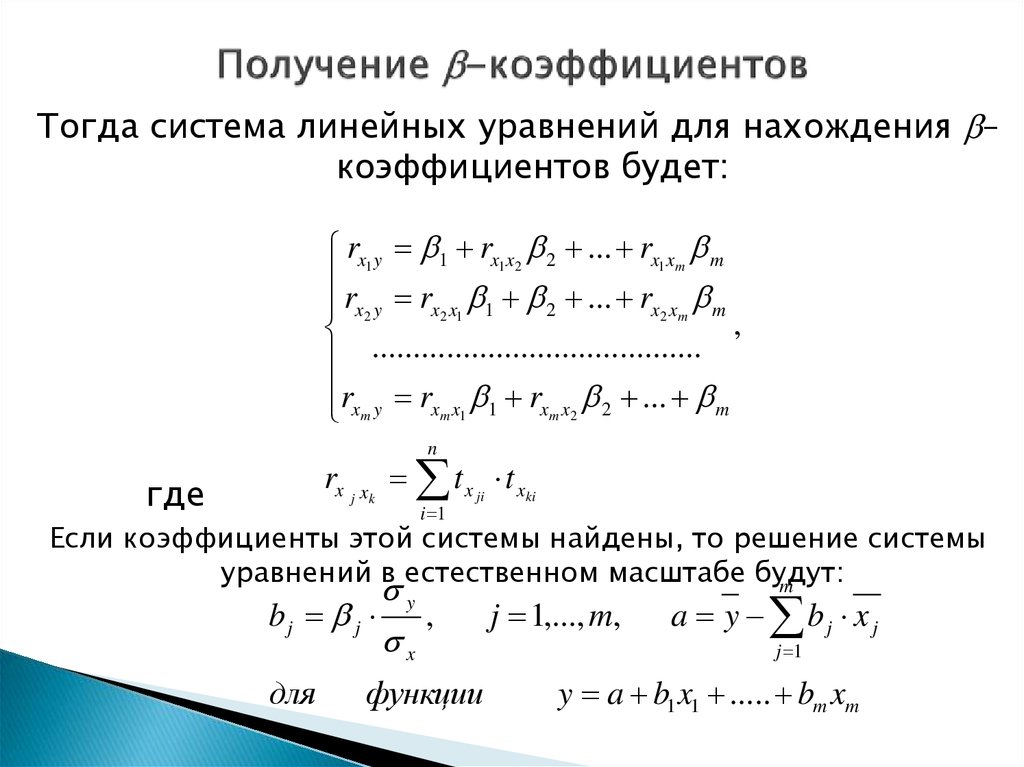

систематической связи между значениями случайной

составляющей в любых двух наблюдениях;

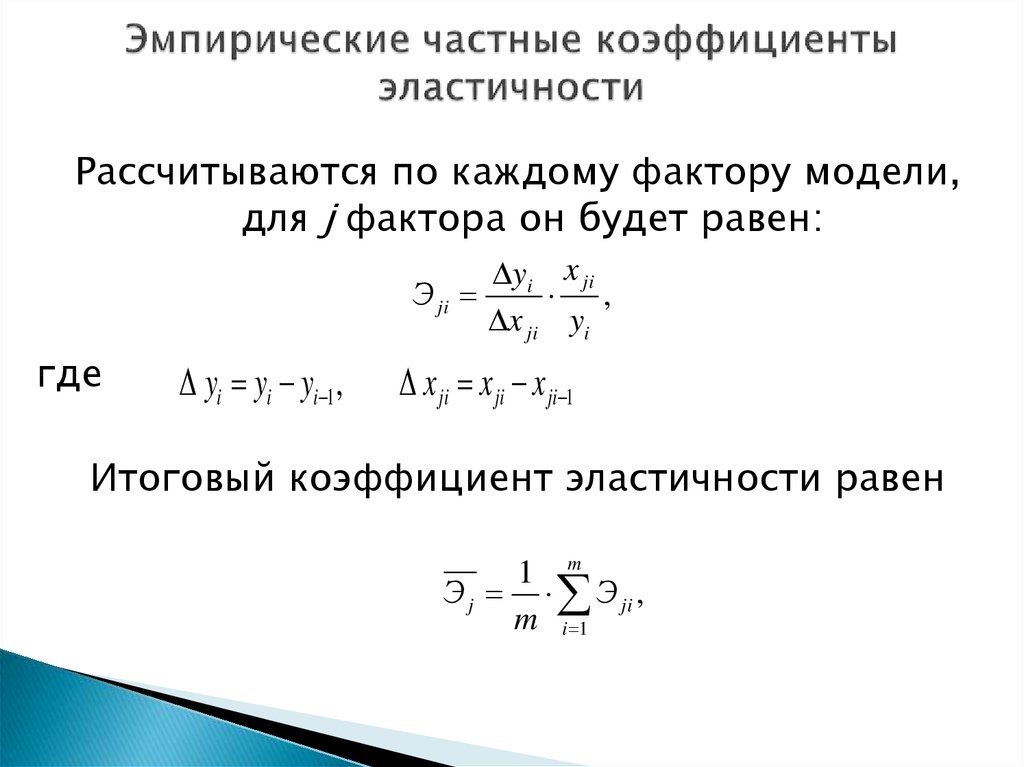

Случайные погрешности имеют нормальное

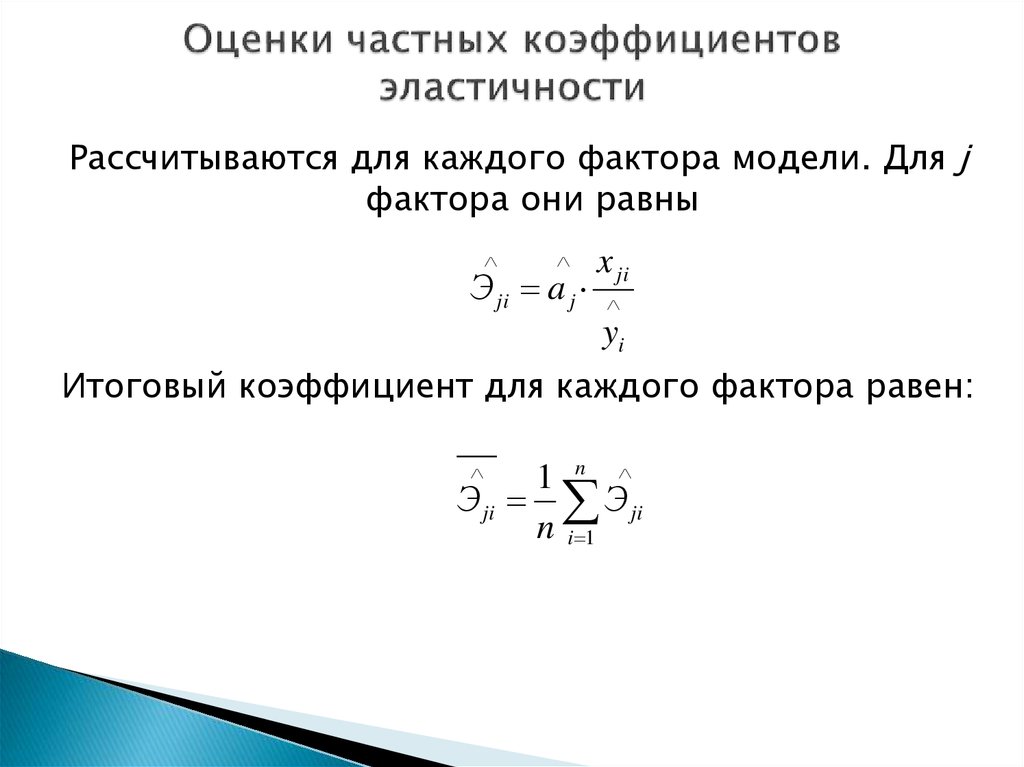

распределение.

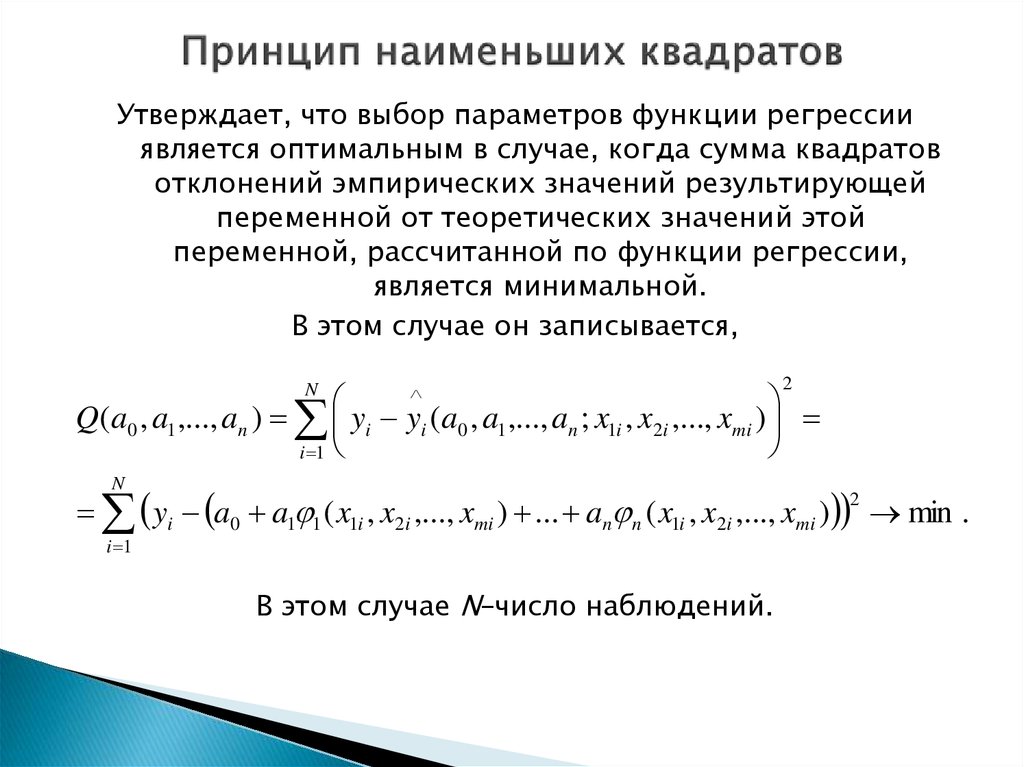

4. Принцип наименьших квадратов

Утверждает, что выбор параметров функции регрессииявляется оптимальным в случае, когда сумма квадратов

отклонений эмпирических значений результирующей

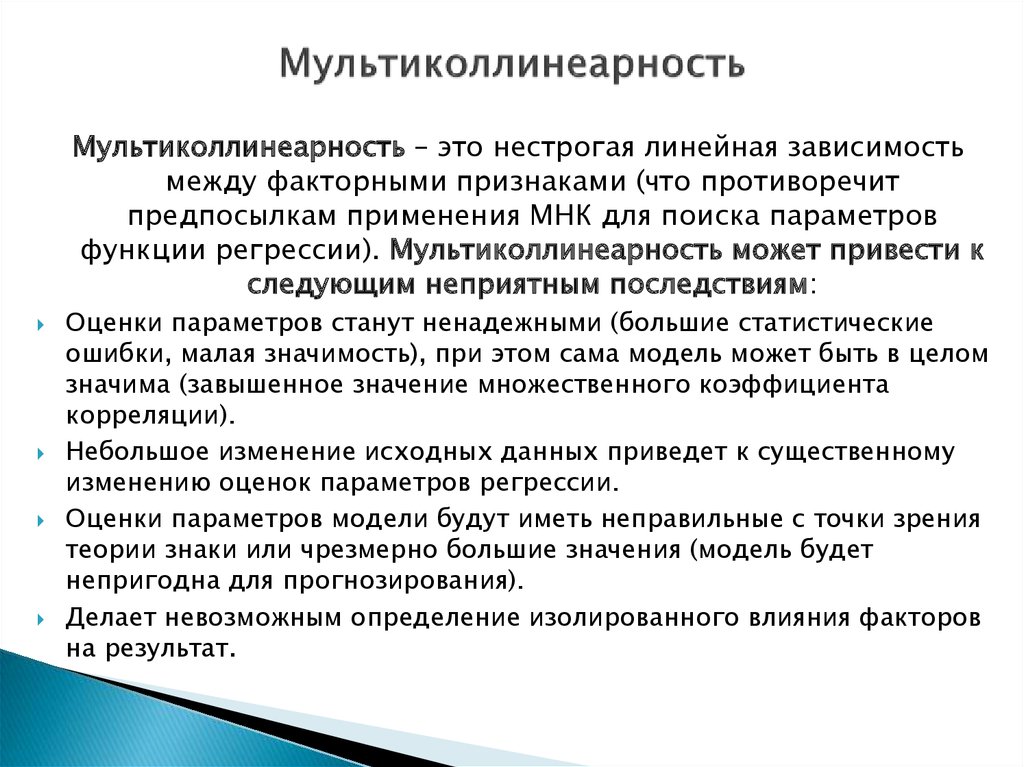

переменной от теоретических значений этой

переменной, рассчитанной по функции регрессии,

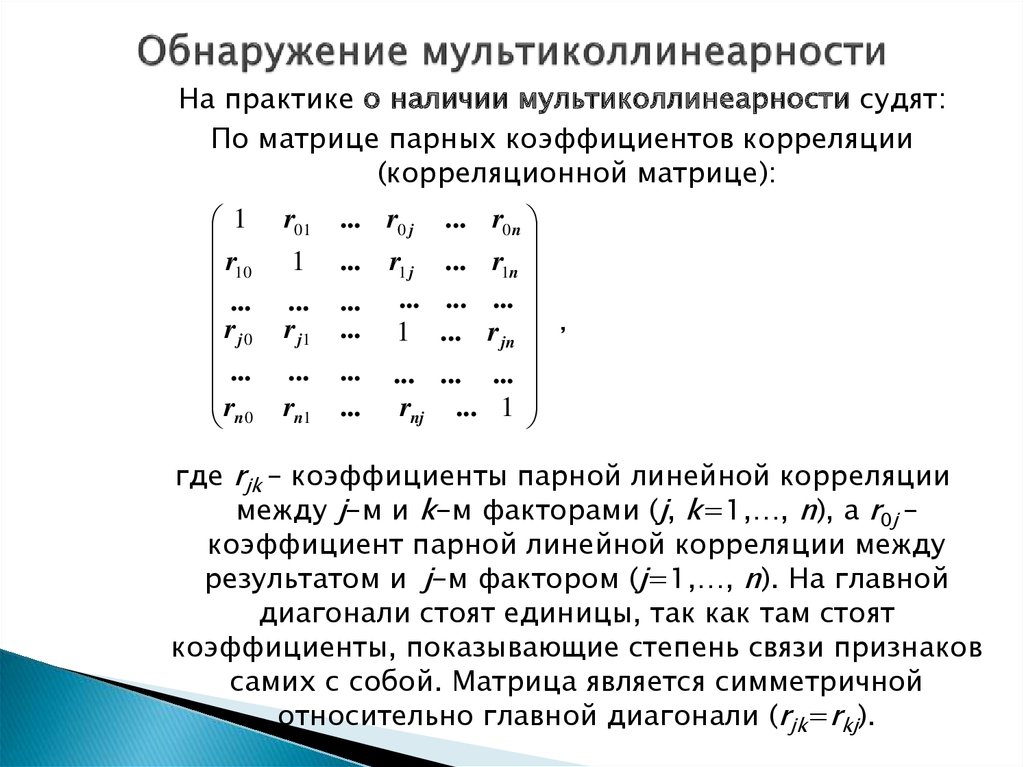

является минимальной.

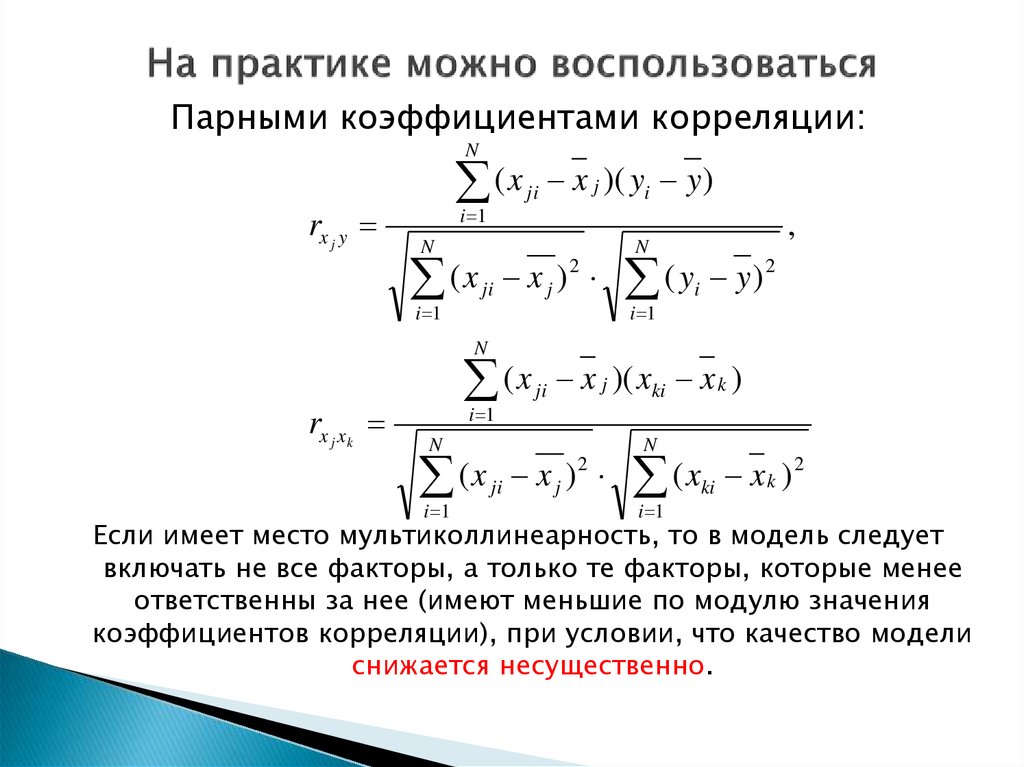

В этом случае он записывается,

2

Q(a0 , a1 ,..., an ) yi yi (a0 , a1 ,..., an ; x1i , x2i ,..., xmi )

i 1

N

N

yi a0 a1 1 ( x1i , x2i ,..., xmi ) ... an n ( x1i , x2i ,..., xmi ) min .

2

i 1

В этом случае N–число наблюдений.

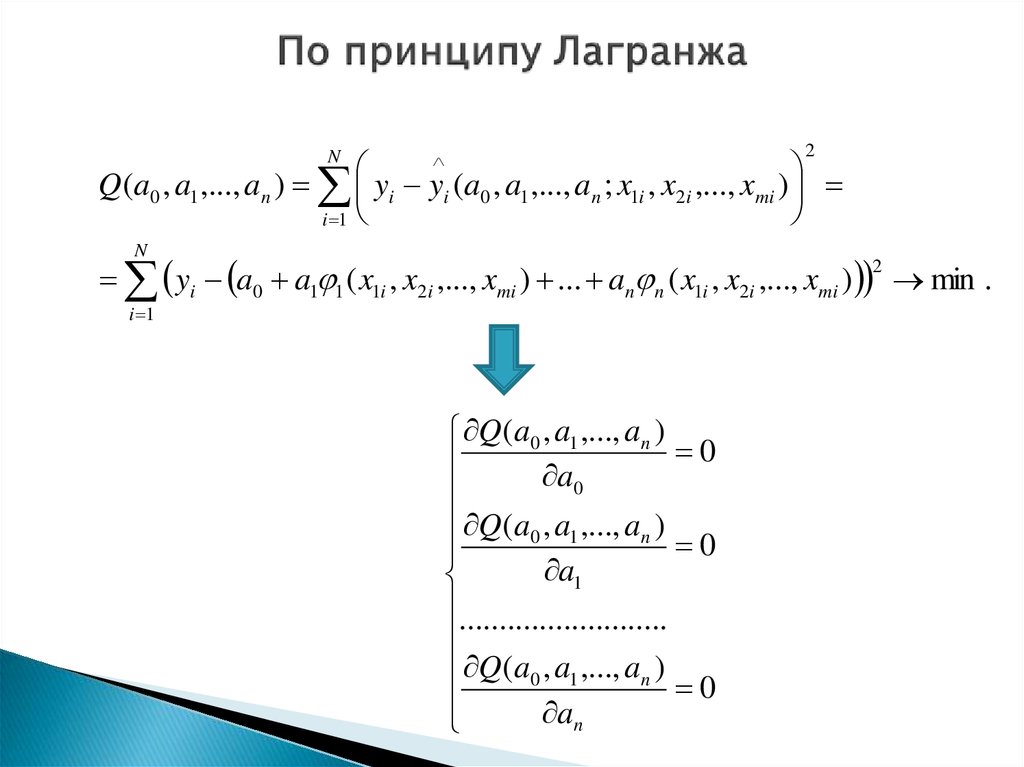

5. По принципу Лагранжа

2Q(a0 , a1 ,..., an ) yi yi (a0 , a1 ,..., an ; x1i , x2i ,..., xmi )

i 1

N

N

yi a0 a1 1 ( x1i , x2i ,..., xmi ) ... an n ( x1i , x2i ,..., xmi ) min .

2

i 1

Q (a0 , a1 ,..., an )

0

a0

Q (a0 , a1 ,..., an )

0

a1

..........................

Q (a0 , a1 ,..., an )

0

an

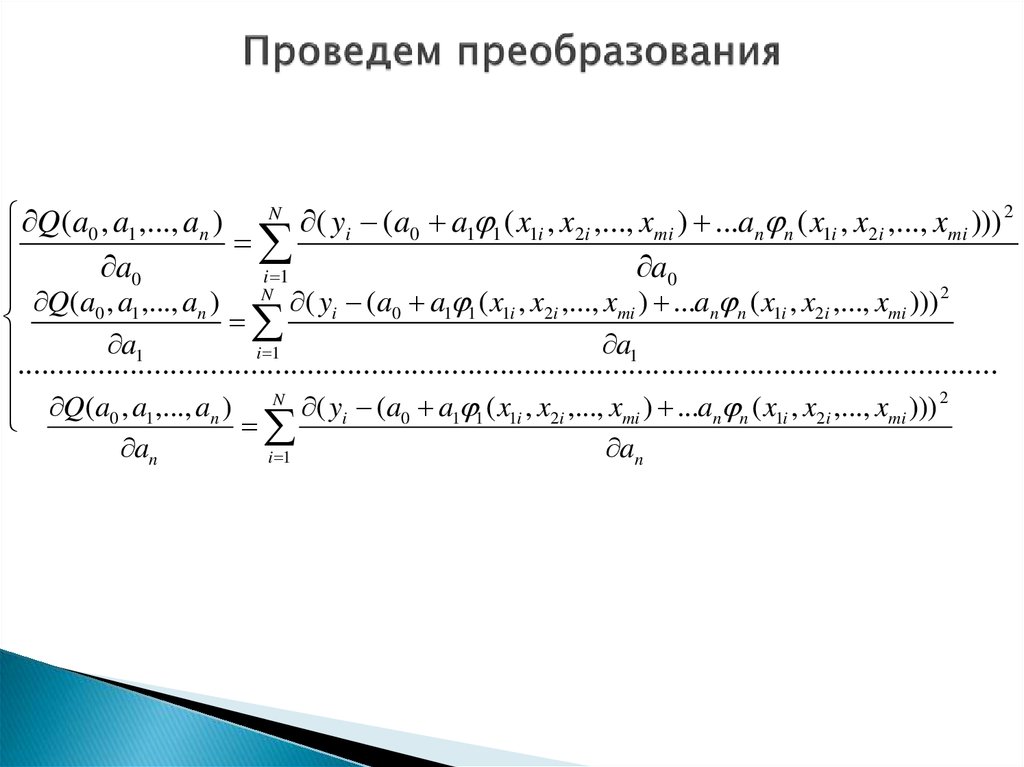

6. Проведем преобразования

Q (a0 , a1 ,..., an ) N ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) 2a0

a0

i 1

Q(a0 , a1 ,..., an ) N ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) 2

a1

a1

1

....................

..........i..........

........................................

..........................................

2

Q(a0 , a1 ,..., an ) N ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi )))

an

i 1

an

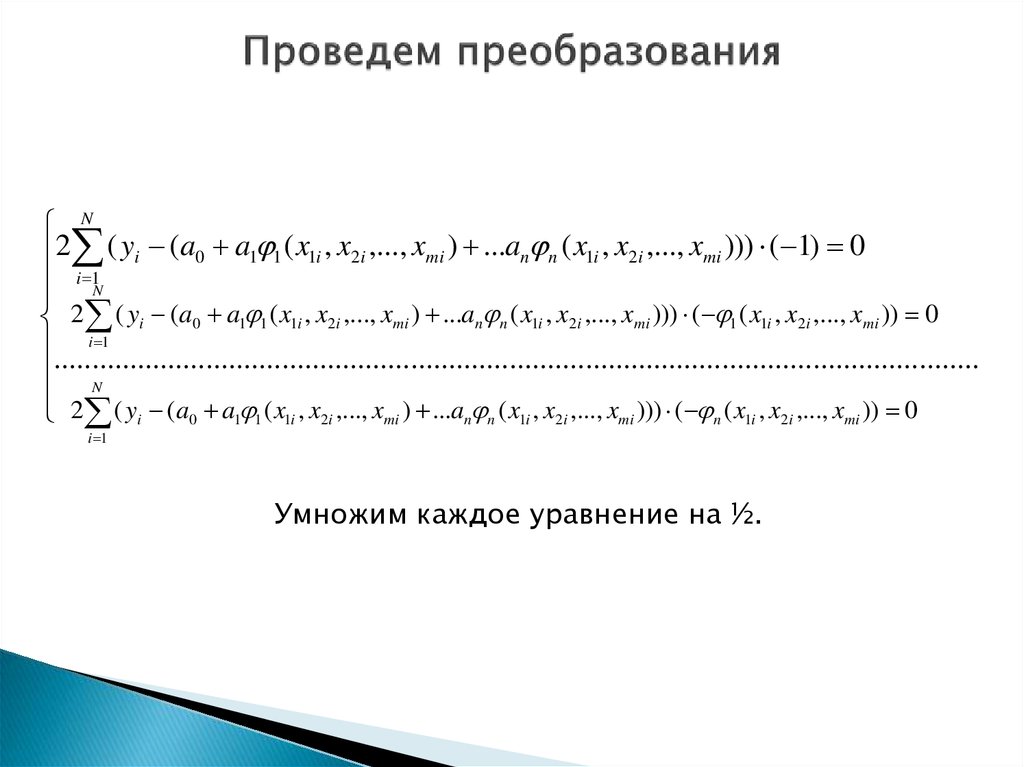

7. Проведем преобразования

N2 ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( 1) 0

i 1N

2 ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( 1 ( x1i , x2i ,..., xmi )) 0

i 1

..........

................................................................................................................

N

2 ( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( n ( x1i , x2i ,..., xmi )) 0

i 1

Умножим каждое уравнение на ½.

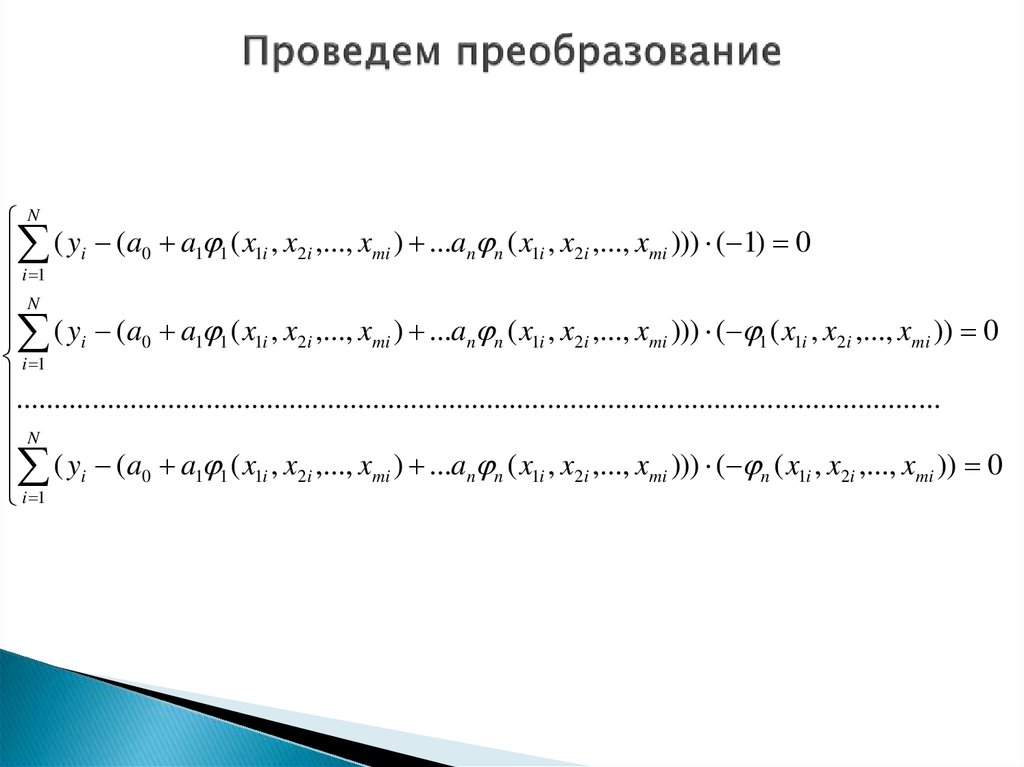

8. Проведем преобразование

N( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( 1) 0

i 1

N

( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( 1 ( x1i , x2i ,..., xmi )) 0

i 1

..........................................................................................................................

N

( yi (a0 a1 1 ( x1i , x2i ,..., xmi ) ...an n ( x1i , x2i ,..., xmi ))) ( n ( x1i , x2i ,..., xmi )) 0

i 1

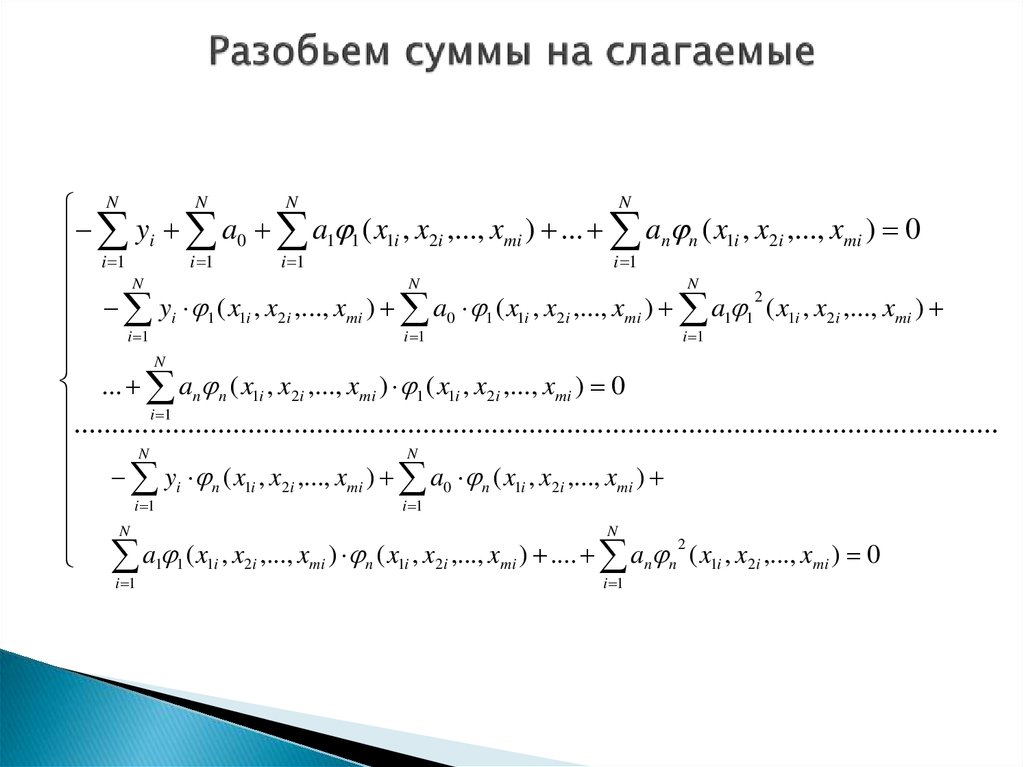

9. Разобьем суммы на слагаемые

NN

N

N

yi a0 a1 1 ( x1i , x2i ,..., xmi ) ... an n ( x1i , x2i ,..., xmi ) 0

i 1

i 1

i 1

i 1 N

N

N

y ( x , x ,..., x ) a ( x , x ,..., x ) a 2 ( x , x ,..., x )

i

1

1i

2i

mi

0

1

1i

2i

mi

1 1

1i

2i

mi

i 1

i 1

i 1

N

... an n ( x1i , x2i ,..., xmi ) 1 ( x1i , x2i ,..., xmi ) 0

i 1

....................

......................................................................................................

N

N

yi n ( x1i , x2i ,..., xmi ) a0 n ( x1i , x2i ,..., xmi )

i 1

i 1

N

N

2

a1 1 ( x1i , x2i ,..., xmi ) n ( x1i , x2i ,..., xmi ) .... an n ( x1i , x2i ,..., xmi ) 0

i 1

i 1

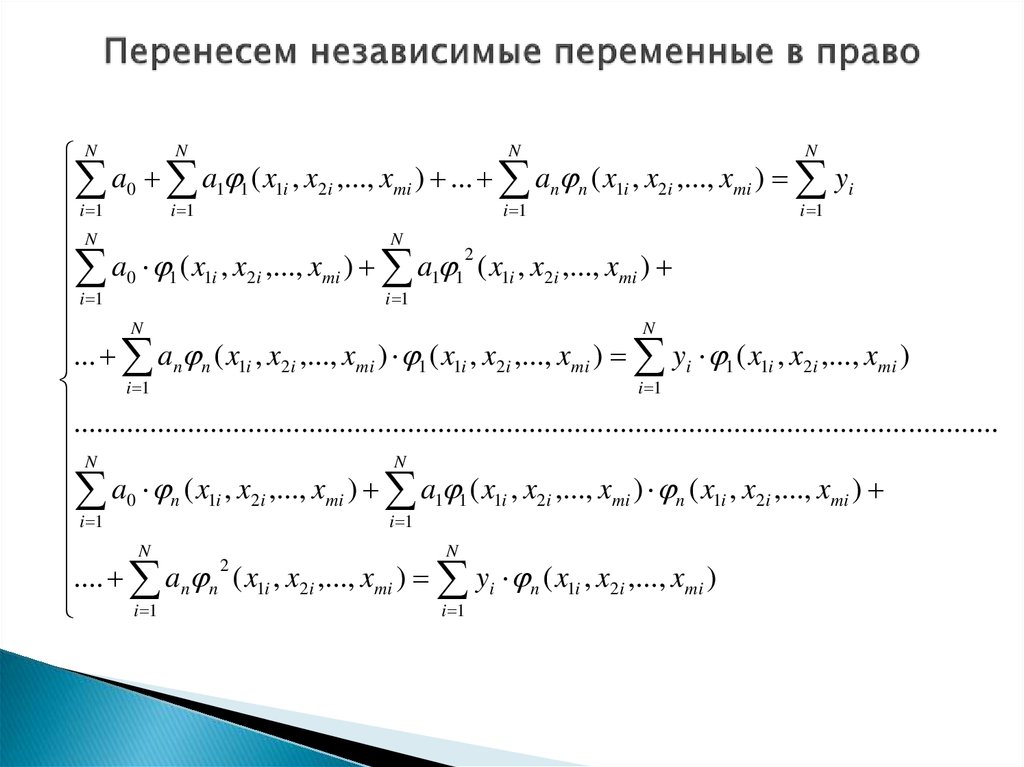

10. Перенесем независимые переменные в право

NN

N

N

a0 a1 1 ( x1i , x2i ,..., xmi ) ... an n ( x1i , x2i ,..., xmi ) yi

i 1

i 1

i 1

i 1

N

N

2

a

(

x

,

x

,...,

x

)

a

mi

1 1 ( x1i , x2 i ,..., xmi )

0 1 1i 2i

i 1

i 1

N

N

... an n ( x1i , x2i ,..., xmi ) 1 ( x1i , x2i ,..., xmi ) yi 1 ( x1i , x2i ,..., xmi )

i 1

i 1

..........................................................................................................................

N

N

a0 n ( x1i , x2i ,..., xmi ) a1 1 ( x1i , x2i ,..., xmi ) n ( x1i , x2i ,..., xmi )

i 1

i 1

N

N

2

.... an n ( x1i , x2i ,..., xmi ) yi n ( x1i , x2i ,..., xmi )

i 1

i 1

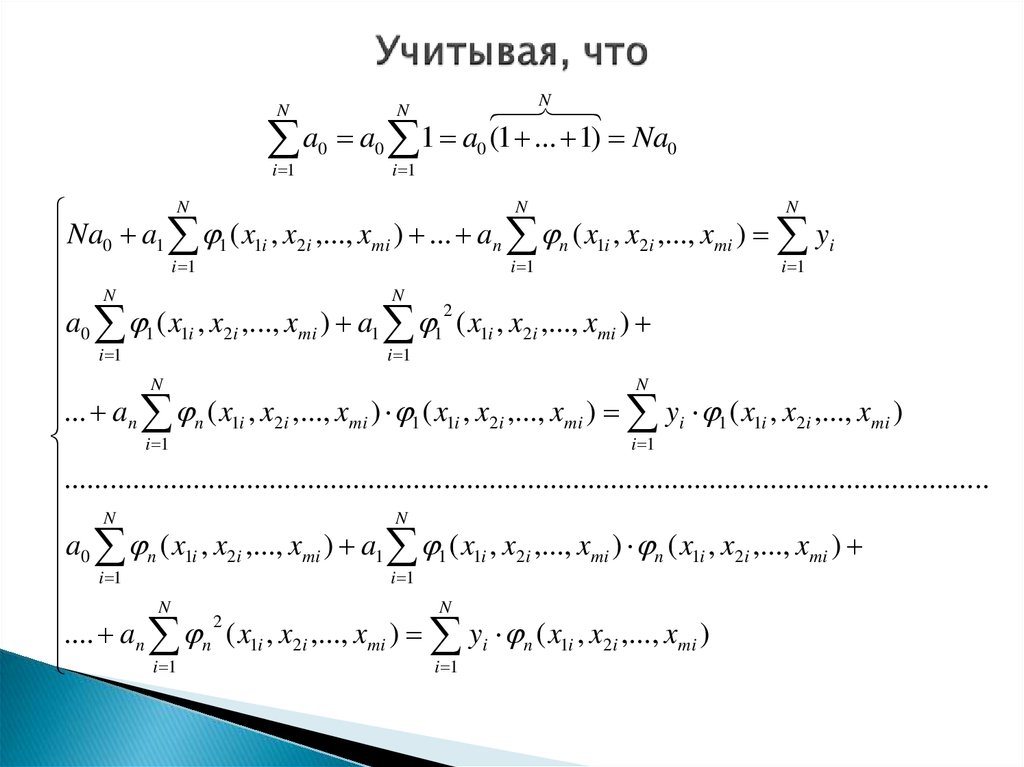

11. Учитывая, что

Na0 a0 1 a0 (1 ... 1) Na0

N

N

i 1

i 1

N

N

N

Na0 a1 1 ( x1i , x2i ,..., xmi ) ... an n ( x1i , x2i ,..., xmi ) yi

i 1

i 1

i 1

N

N

2

a

(

x

,

x

,...,

x

)

a

mi

1 1 ( x1i , x2 i ,..., xmi )

0 1 1i 2i

i 1

i 1

N

N

... an n ( x1i , x2i ,..., xmi ) 1 ( x1i , x2i ,..., xmi ) yi 1 ( x1i , x2i ,..., xmi )

i 1

i 1

..........................................................................................................................

N

N

a0 n ( x1i , x2i ,..., xmi ) a1 1 ( x1i , x2i ,..., xmi ) n ( x1i , x2i ,..., xmi )

i 1

i 1

N

N

2

.... an n ( x1i , x2i ,..., xmi ) yi n ( x1i , x2i ,..., xmi )

i 1

i 1

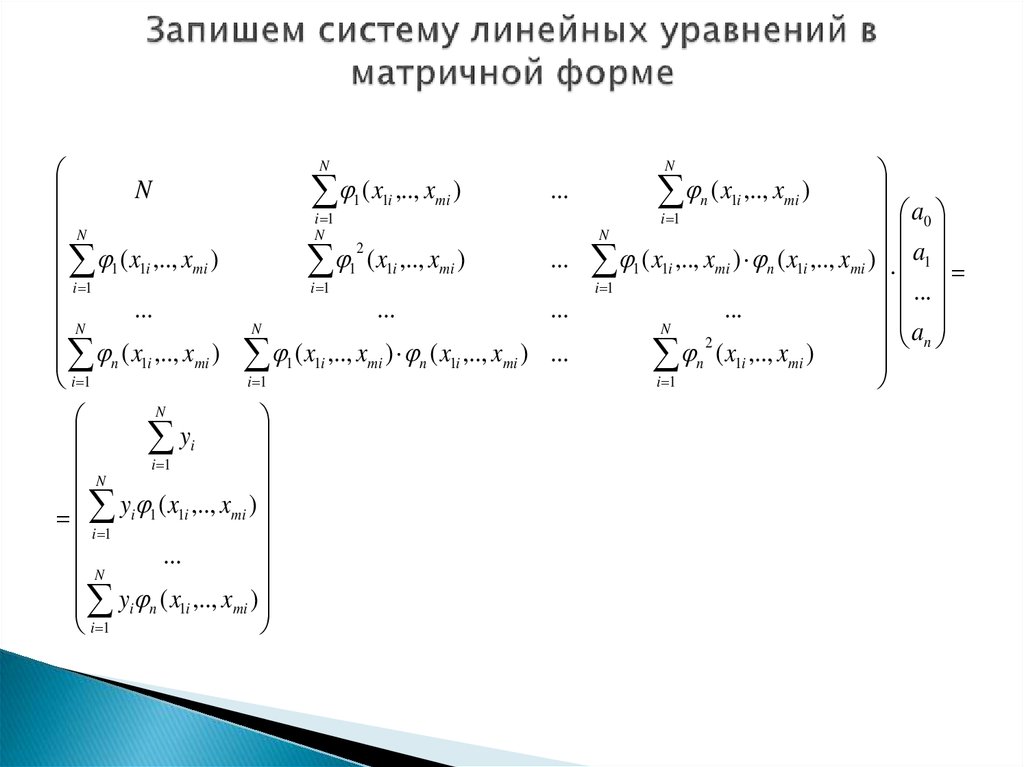

12. Запишем систему линейных уравнений в матричной форме

NN

1 ( x1i ,.., xmi )

i 1

...

N

( x ,.., x )

mi

n 1i

i 1

i 1

i 1

a0

N

N

a

2

1 ( x1i ,.., xmi )

... 1 ( x1i ,.., xmi ) n ( x1i ,.., xmi ) 1

i 1

i 1

...

...

...

...

a

N

N

n

1 ( x1i ,.., xmi ) n ( x1i ,.., xmi ) ...

n 2 ( x1i ,.., xmi )

i 1

i 1

N

y

i

i 1

N

y

(

x

,..,

x

)

i 1 1i

mi

i 1

...

N

y ( x ,.., x )

mi

i n 1i

i 1

N

1 ( x1i ,.., xmi )

N

...

n ( x1i ,.., xmi )

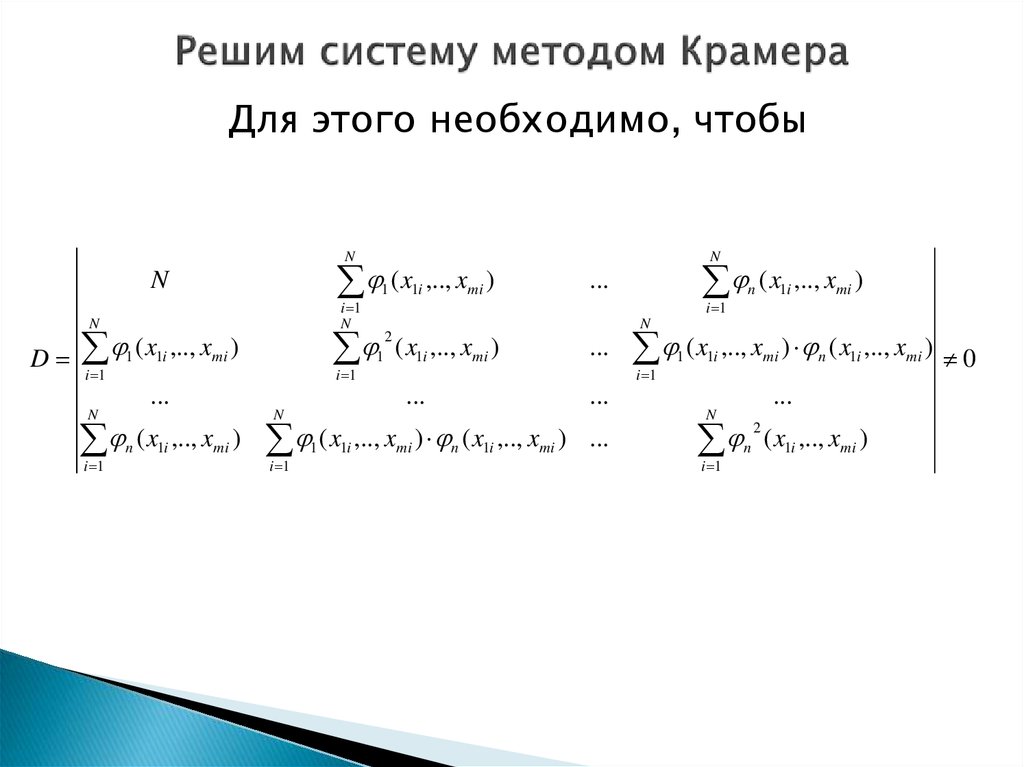

13. Решим систему методом Крамера

Для этого необходимо, чтобыN

(x

N

i 1

N

N

D (x

i 1

1

1i

,.., xmi )

i 1

...

N

i 1

( x1i ,.., xmi )

1

2

1i

,.., xmi )

( x

i 1

1

1i

...

i 1

N

( x1i ,.., xmi )

...

N

n

1

N

...

(x

i 1

1

1i

...

,.., xmi ) n ( x1i ,.., xmi ) ...

n

( x1i ,.., xmi )

,.., xmi ) n ( x1i ,.., xmi ) 0

...

N

i 1

2

n

( x1i ,.., xmi )

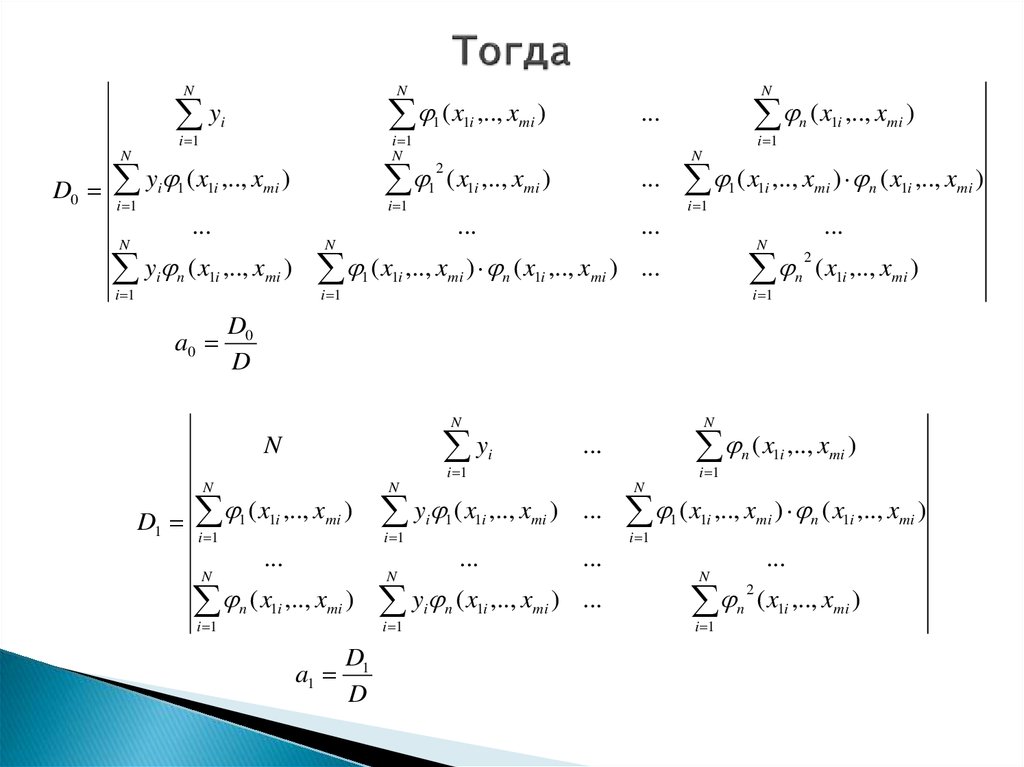

14. Тогда

Ny

i 1

N

( x

i

y (x

i 1

i

1

1

i 1

N

N

D0

1i ,.., xmi )

i 1

i 1

i

2

1

( x1i ,.., xmi )

a0

( x

1

i 1

1i

...

i 1

N

( x1i ,.., xmi )

( x

...

( x1i ,.., xmi )

,.., xmi ) n ( x1i ,.., xmi )

...

N

,.., xmi ) n ( x1i ,.., xmi ) ...

i 1

2

n

( x1i ,.., xmi )

D0

D

y

N

i 1

N

( x

i 1

1

1i

,.., xmi )

i

i 1

N

,.., xmi ) ...

...

...

i 1

i

1

1i

N

n

( x1i ,.., xmi )

a1

D1

D

y

i 1

i

...

y (x

...

N

N

N

i 1

1i

n

...

N

D1

1

i 1

...

N

n

,.., xmi )

1i

...

N

y

N

( x

i 1

1

1i

n

,.., xmi ) n ( x1i ,.., xmi )

...

N

n

( x1i ,.., xmi ) ...

( x1i ,.., xmi )

i 1

2

n

( x1i ,.., xmi )

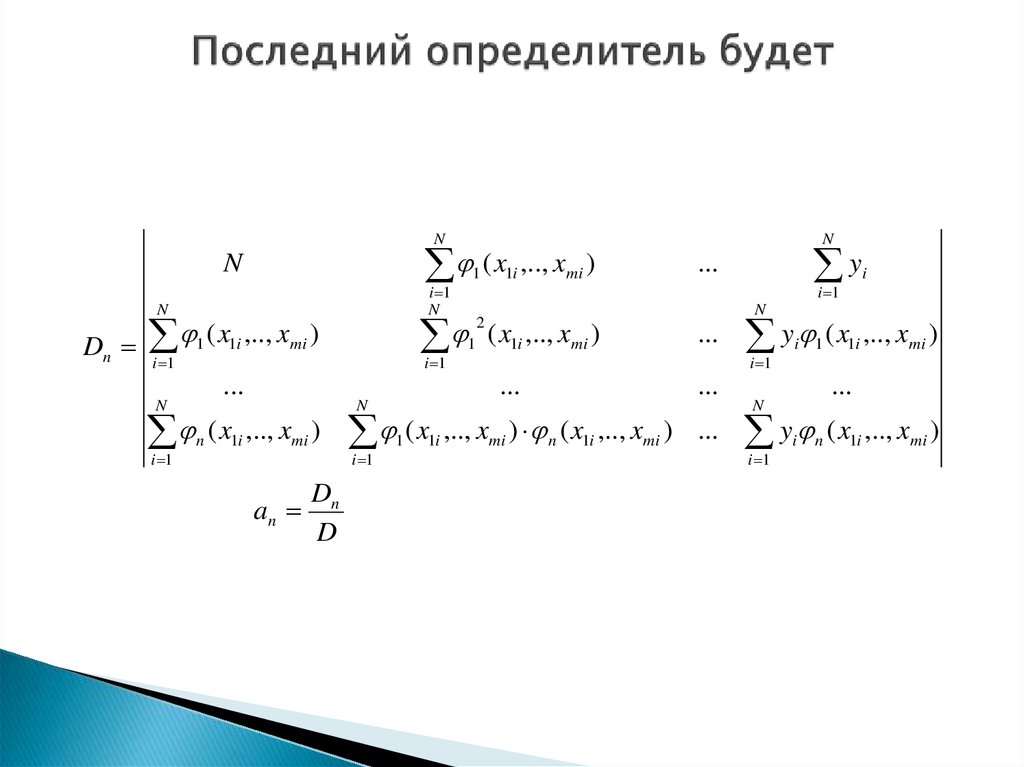

15. Последний определитель будет

N( x

N

i 1

N

N

Dn

( x

i 1

1

1i

,.., xmi )

i 1

...

i 1

N

n

1

2

1i

,.., xmi )

( x1i ,.., xmi )

an

Dn

D

( x

i 1

1

1i

y

...

i 1

i

N

( x1i ,.., xmi )

...

N

1

N

...

y (x

i 1

i

1

...

,.., xmi ) n ( x1i ,.., xmi ) ...

1i

,.., xmi )

...

N

y

i 1

i

n

( x1i ,.., xmi )

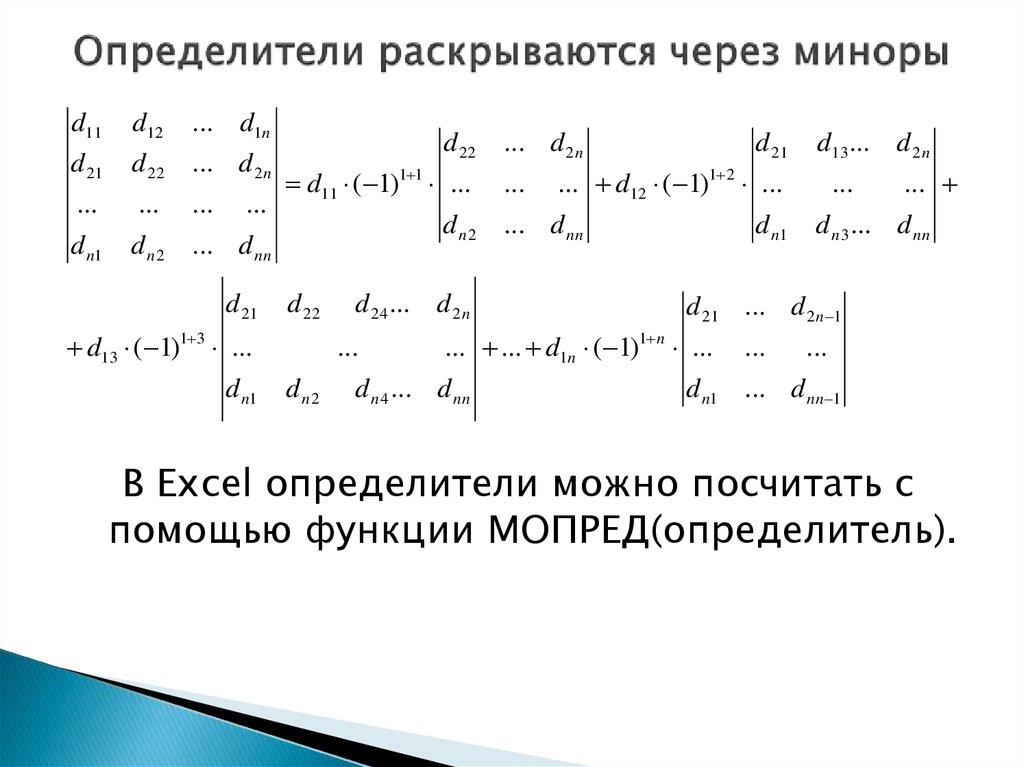

16. Определители раскрываются через миноры

d11d12

... d1n

d 21

d 22

... d 2 n

...

...

...

d n1

dn2

... d nn

...

d 21

d 22

d11 ( 1)1 1 ...

dn2

d 22

d13 ( 1)1 3 ...

d n1

d 24 ... d 2 n

...

dn2

... d 2 n

...

d 21

... d12 ( 1)1 2 ...

... d nn

d n1

...

...

d n 3 ... d nn

d 21 ... d 2 n 1

... ... d1n ( 1)1 n ...

d n 4 ... d nn

d13... d 2 n

...

...

d n1 ... d nn 1

В Excel определители можно посчитать с

помощью функции МОПРЕД(определитель).

17. Эконометрика

КОРРЕЛЯЦИЯ ДЛЯ НЕЛИНЕЙНОЙ РЕГРЕССИИ.КОЭФФИЦИЕНТЫ ЭЛАСТИЧНОСТИ

18. Корреляция в случае нелинейной регрессии

Уравнение нелинейной регрессии дополняетсяпоказателями корреляции:

n

2 2

R 2 1 2 1

2

( y

i 1

n

i

( y

i 1

yi )2

,

i

y)2

где 2 – объясненная уравнением регрессии дисперсия

результирующего признака, а 2– остаточная (необъясненная

уравнением регрессии) дисперсия результирующего признака,

2 – полная дисперсия результирующего признака. Величину R2

называют показателем (индексом) корреляции. Она изменяется

в границах от 0 до 1 и чем она ближе к 1, тем теснее связь

рассматриваемых признаков, тем более надежно уравнение

регрессии.

19. Коэффициенты эластичности

характеристика силы связи фактора срезультатом, показывающая, на сколько

процентов изменится значение результата при

изменении каждого фактора на 1%.

Коэффициент эластичности (в случае парной

регрессии) рассчитывается как:

-

dy y dy x

Э

:

dx x dx y

20. Различают

Средние коэффициенты эластичностиdy

x

Эx

dx y( x )

и точечные коэффициенты эластичности

Э x0

dy x 0

dx y( x 0 )

Они показывают на сколько процентов

изменится значение y при росте x на 1%

относительно среднего уровня или уровня x0.

21. Введем коэффициенты эластичности для различных функций регрессии

1. Для линейной функции y xКоэффициент эластичности будет:

x0

x

Э x

,

Эx

x0

x

2. Для параболы y x x 2

0

Коэффициент эластичности будет:

Э x0

2 x0 x0

x0 x

2

0

,

Эx

2 x x

x x

2

22. Введем коэффициенты эластичности для различных функций регрессии

3. Для равносторонней гиперболы yx

Коэффициент эластичности будет:

x0

1

Э x0 2

x0 2

x0 ( x0 )

x0

x0

x0

,

x0

Эx

x

y

x

4. Для степенной функции

Коэффициент эластичности будет:

x0

Э x

,

x0

0

Эx

23. Введем коэффициенты эластичности для различных функций регрессии

5. Для показательной функцииКоэффициент эластичности будет:

ln x x0

Э x

x0 ln ,

x

0

0

0

y x

Эx x ln

24. Частные коэффициенты

В случае многомерной функции регрессииможно рассчитать частные коэффициенты

эластичности показывают на сколько

процентов в среднем изменяется результат с

увеличением конкретного фактора xj на 1% от

своего среднего уровня при фиксированном

положении других факторов модели. Частный

коэффициент эластичности рассчитываются по

формуле

xj

y

Эj

,

x j y ( x1 ,..., xn )

j 1,..., n

25. –коэффициенты

Для характеристики степени связи между результирующейпеременной и факторными признаками в случае многомерной

регрессии используются еще и стандартизованные частные

коэффициенты регрессии – –коэффициенты. Они показывают,

на какую часть своего среднего квадратического отклонения ij

изменится результат y с увеличением соответствующего

фактора xj на величину своего среднего квадратического

отклонения xj при неизменном влиянии прочих факторов

модели.

Частные коэффициенты эластичности и –коэффициенты можно

использовать для ранжирования факторов по силе их влияния

на результат. Чем они больше для соответствующего фактора,

тем сильнее влияние этого фактора на результат.

26. Получение -коэффициентов

Расчет –коэффициентов осуществляется с помощьюнахождения коэффициентов регрессии

стандартизованной системы линейных уравнений.

Вводится стандартизованная переменная:

t x ji

x ji x j

,

j 1,..., m,

t yi

yi y

x

y

Таким образом, начало отсчета каждой

стандартизованной переменной совмещается с ее

средним значением, а в качестве единицы изменения

принимается ее среднее квадратическое отклонение

( ). Если связь между переменными в естественном

масштабе линейная, то изменение начала отсчета и

единицы изменения этого свойства не нарушат.

j

27. Получение -коэффициентов

Тогда система линейных уравнений для нахождения –коэффициентов будет:

rx1 y 1 rx1x2 2 ... rx1 xm m

r r ... r

x2 y x2 x1 1

2

x2 xm m

,

........................................

rxm y rxm x1 1 rxm x2 2 ... m

n

rx j xk t x ji t xki

где

i 1

Если коэффициенты этой системы найдены, то решение системы

уравнений в естественном масштабе будут:

m

y

bj j ,

x

для

функции

j 1,..., m,

a y bj x j

j 1

y a b1 x1 ..... bm xm

28. Частные коэффициенты эластичности

Эмпирические частные коэффициентыэластичности;

Частные коэффициенты эластичности или

оценки частных коэффициентов эластичности.

29. Эмпирические частные коэффициенты эластичности

Рассчитываются по каждому фактору модели,для j фактора он будет равен:

yi x ji

Э ji

,

x ji yi

где

yi yi yi 1,

x ji x ji x ji 1

Итоговый коэффициент эластичности равен

1 m

Э j Э ji ,

m i 1

30. Оценки частных коэффициентов эластичности

Рассчитываются для каждого фактора модели. Для jфактора они равны

Э ji a j

x ji

yi

Итоговый коэффициент для каждого фактора равен:

1 n

Э ji Э ji

n i 1

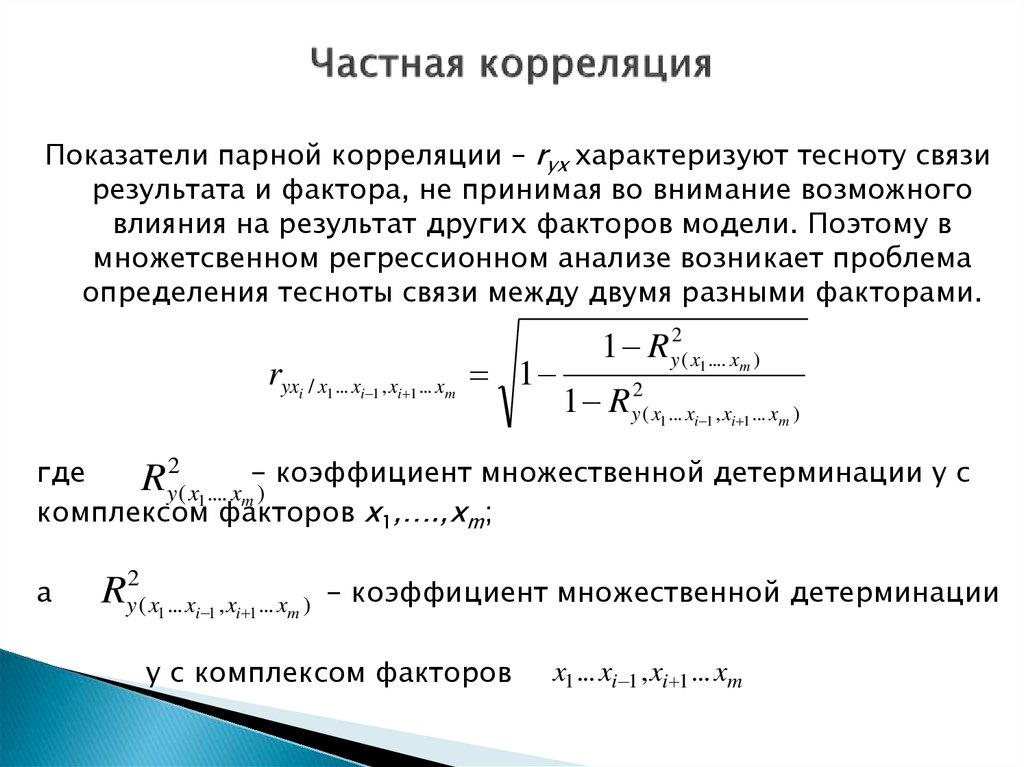

31. Частная корреляция

Показатели парной корреляции – ryx характеризуют тесноту связирезультата и фактора, не принимая во внимание возможного

влияния на результат других факторов модели. Поэтому в

множетсвенном регрессионном анализе возникает проблема

определения тесноты связи между двумя разными факторами.

ryxi / x1 ... xi 1 , xi 1 ... xm 1

1 R y2( x1 .... xm )

1 R y2( x1 ... xi 1 , xi 1 ... xm )

где

Ry2( x1 .... xm-) коэффициент множественной детерминации y с

комплексом факторов x1,….,xm;

а

Ry2( x1... xi 1 , xi 1 ... xm )

- коэффициент множественной детерминации

y c комплексом факторов

x1 ... xi 1 , xi 1 ... xm

32. Частная корреляция

Частные коэффициенты корреляции используются дляранжирования факторов в модели по степени влияния на

результат.

Они изменяются на промежутке от 0 до 1, и чем ближе они к 1,

тем сильнее влияет этот фактор на результат, а чем ближе к 0,

тем слабее.

Их также используют для отсева факторов.

33. Эконометрика

ПРОБЛЕМАМУЛЬТИКОЛЛИНИАРНОСТИ.

ФИКТИВНЫЕ

ПЕРЕМЕННЫЕ

34. Мультиколлинеарность

– это нестрогая линейная зависимостьмежду факторными признаками (что противоречит

предпосылкам применения МНК для поиска параметров

функции регрессии). Мультиколлинеарность может привести к

следующим неприятным последствиям:

Оценки параметров станут ненадежными (большие статистические

ошибки, малая значимость), при этом сама модель может быть в целом

значима (завышенное значение множественного коэффициента

корреляции).

Небольшое изменение исходных данных приведет к существенному

изменению оценок параметров регрессии.

Оценки параметров модели будут иметь неправильные с точки зрения

теории знаки или чрезмерно большие значения (модель будет

непригодна для прогнозирования).

Делает невозможным определение изолированного влияния факторов

на результат.

35. Снижение мультиколлинеарности

Мультиколлинеарность не всегда оказываетнеблагоприятное влияние, если другие условия

благоприятны:

Число наблюдений значительно.

Выборочные дисперсии факторов велики, а

дисперсия случайной составляющей мала.

При условии влияния этих благоприятных факторов,

оценки параметров могут оказаться вполне

приемлемы.

36. Обнаружение мультиколлинеарности

На практике о наличии мультиколлинеарности судят:По матрице парных коэффициентов корреляции

(корреляционной матрице):

1

r10

...

r

j0

...

r

n0

... r0 n

r1 j ... r1n

... ... ...

1 ... r jn ,

... ... ...

rnj ... 1

r01

... r0 j

1

...

r j1

...

...

...

...

rn1

...

...

где rjk – коэффициенты парной линейной корреляции

между j-м и k-м факторами (j, k=1,…, n), а r0j –

коэффициент парной линейной корреляции между

результатом и j-м фактором (j=1,…, n). На главной

диагонали стоят единицы, так как там стоят

коэффициенты, показывающие степень связи признаков

самих с собой. Матрица является симметричной

относительно главной диагонали (rjk=rkj).

37. На практике можно воспользоваться

Парными коэффициентами корреляции:N

rx j y

(x

i 1

ji

x j )( yi y )

N

2

(

x

x

)

ji j

i 1

N

rx j xk

(x

i 1

ji

,

2

(

y

y

)

i

i 1

x j )( xki x k )

N

( x ji x j )

2

i 1

N

N

2

(

x

x

)

k

ki

i 1

Если имеет место мультиколлинеарность, то в модель следует

включать не все факторы, а только те факторы, которые менее

ответственны за нее (имеют меньшие по модулю значения

коэффициентов корреляции), при условии, что качество модели

снижается несущественно.

38. Обнаружение мультиколлинеарности

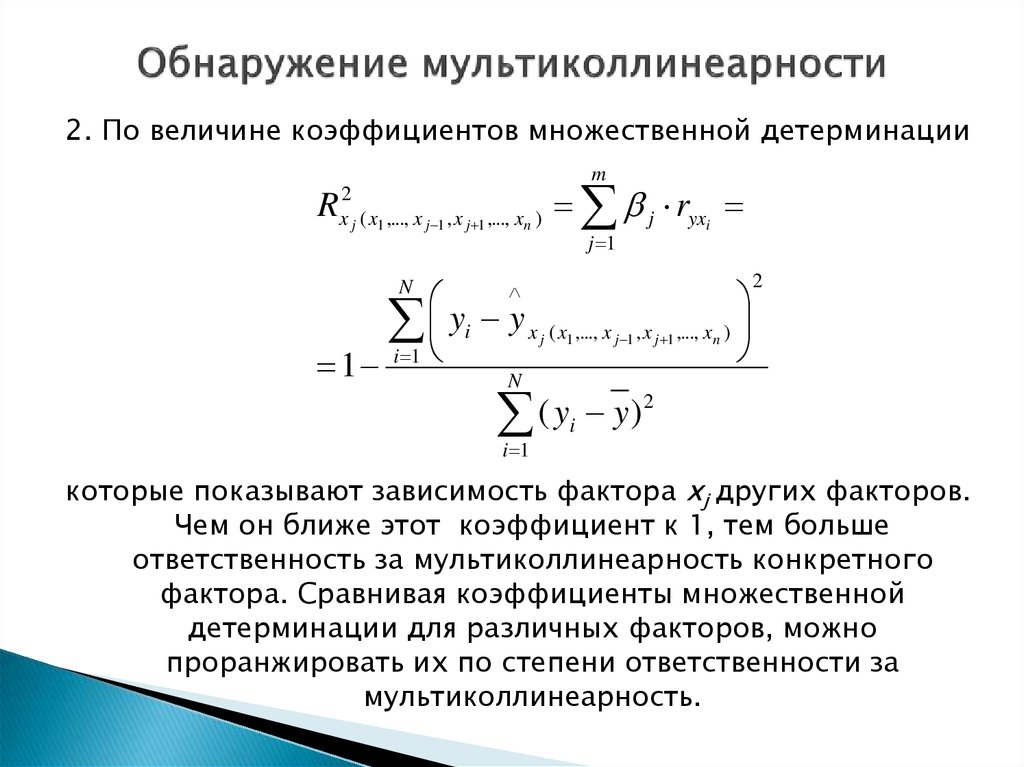

2. По величине коэффициентов множественной детерминацииm

Rx2j ( x1 ,..., x j 1 , x j 1 ,..., xn ) j ryxi

j 1

yi y x j ( x1 ,..., x j 1 , x j 1 ,..., xn )

1 i 1

N

2

N

2

(

y

y

)

i

i 1

которые показывают зависимость фактора xj других факторов.

Чем он ближе этот коэффициент к 1, тем больше

ответственность за мультиколлинеарность конкретного

фактора. Сравнивая коэффициенты множественной

детерминации для различных факторов, можно

проранжировать их по степени ответственности за

мультиколлинеарность.

39. Фиктивные переменные

В некоторых случаях в модель необходимо ввестинекоторую качественную переменную, изменение

которой может существенно влиять на результат.

В данном случае качественная переменная может быть

введена в уравнение в форме фиктивной

переменной. Для этого вводится система цифровых

обозначений и в модель включается фактор,

принимающий одно из значений в рамках заданной

системы.

Например, разный уровень образования работников дает разный прирост

уровня их заработной платы и может быть введен в модель на равне с

возрастом и стажем.

Математика

Математика Экономика

Экономика