Похожие презентации:

Интерпретационные проблемы LLM. Загадки образного языка

1.

ИНТЕРПРЕТАЦИОННЫЕ ПРОБЛЕМЫ LLM:ЗАГАДКИ ОБРАЗНОГО ЯЗЫКА

ХII Международный конгресс по когнитивной лингвистике

Нижний Новгород - 31 мая 2024

К.ф.н.,

доцент

кафедры

иноязычной

коммуникации

и

лингводидактики ВолГУ

Скрынникова И.В.

2.

Актуальность•образный язык – малоизученная область в области обработки

естественного языка (NLP);

•низкая способность LLM интерпретировать небуквальные фразы

•результативность современных языковых моделей далека от

аналогичных способностей человека.

3.

Принцип работы НЛП• 1950-е годы – запрограммированные вручную правила для понимания

языка, большого количества исключений, взаимодействовали

непредсказуемо [Nadkarni 2011: 545];

• 1980-е годы – машинным обучением с использованием обучающих

данных из больших аннотированных текстов, поиск наиболее вероятного

смысла предложения большая гибкость и точность при вводе большего

количества данных;

• современный этап – машинное обучение (распознавание, генерация и

обработка устной и письменной человеческой речи) полагается на

определенные человеком параметры алгоритмов в своих возможностях и

требует обучающих данных.

4.

Причины сложностей интерпретации образного языка.

•неспособность машин мыслить по аналогии [Ильин 2013:22];

•компьютеры не могут гибко и быстро обобщать информацию, которую

получили, и применять ее к новым ситуациям;

•законов логики, статистики и программирования в разработке «правил

поведения» машины для решения новых задач недостаточно.

5.

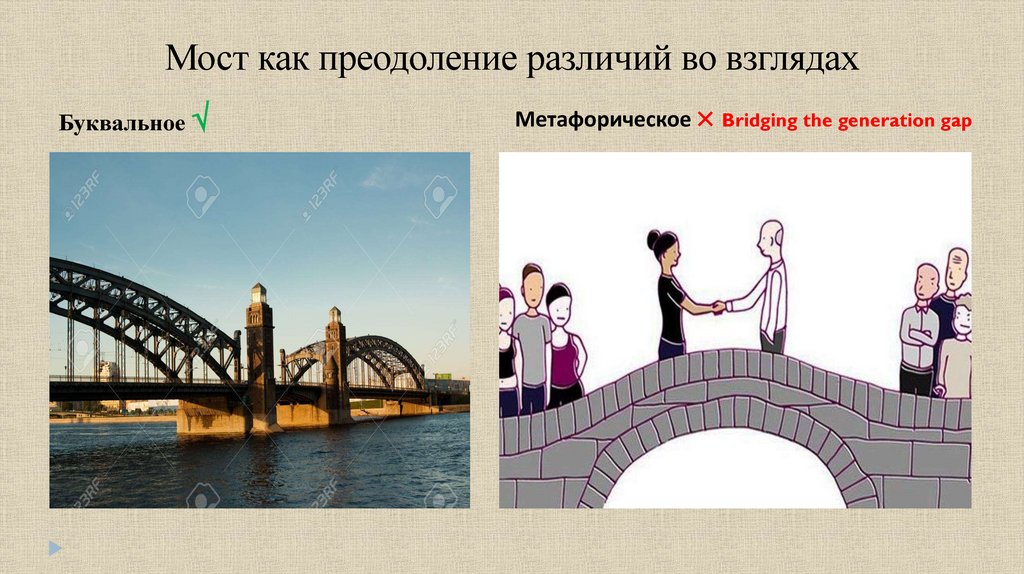

Мост как преодоление различий во взглядахБуквальное

Метафорическое Bridging the generation gap

6.

Научные попыткимеханизм структурного картирования [Falkenhainer, Forbus & Gentner 1989];

системы типа Copycat [Hofstadter, Mitchell 1994];

отсутствуют механизмы аналогических инференций, т.е. механизмы выделения

паттернов высокого уровня;

мешает

нейронным методам эффективно обучаться на основе небольшого

количества данных, понимать и объяснять новые ситуации [Chen et al. 2019];

Большие языковые модели BERT [Delvin et al. 2018] и GPT-3 [Brown et al. 2020

малоэффективны, едва ли понимают аналогии между пропорциями [Ushio et al.

2021], но справляются с конвенциональными метафорами (LIFE is a

JOURNEY,etc.)

Чем меньше LLM, тем хуже их результативность

7.

Новые подходы к пониманию аналогии•мета-обучение, обучение с самоконтролем - «смысловой барьер»;

•глубокое обучение и глубокие нейронные сети

- создания одного большого набора

данных для обучения и тестирования нейронной сети;

•“few-shot learning”, т.е. обучение на небольшом количестве примеров[Mitchell 2021];

•машина не обладает телом (no embodiment), которое наделяет человека этими

базовыми знаниями, на основе которых человеческий мозг способен строить все новые и

новые аналогии;

•ИИ

полностью

интерпретации

полагается

на

заранее

заданные

человеком

алгоритмы

8.

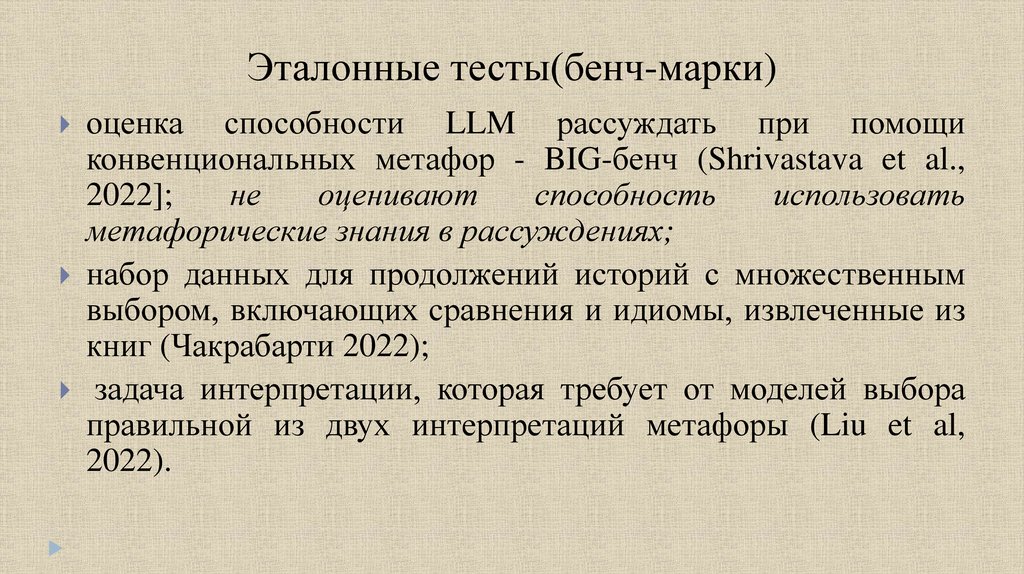

Эталонные тесты(бенч-марки)оценка

способности LLM рассуждать при помощи

конвенциональных метафор - BIG-бенч (Shrivastava et al.,

2022];

не

оценивают

способность

использовать

метафорические знания в рассуждениях;

набор данных для продолжений историй с множественным

выбором, включающих сравнения и идиомы, извлеченные из

книг (Чакрабарти 2022);

задача интерпретации, которая требует от моделей выбора

правильной из двух интерпретаций метафоры (Liu et al,

2022).

9.

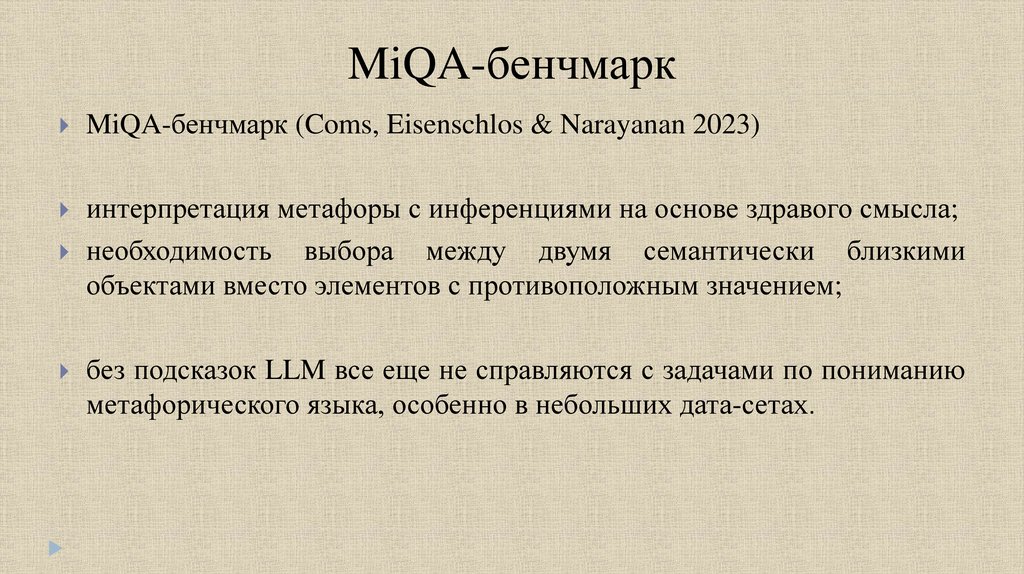

MiQA-бенчмаркMiQA-бенчмарк (Coms, Eisenschlos & Narayanan 2023)

интерпретация метафоры с инференциями на основе здравого смысла;

необходимость выбора между двумя семантически близкими

объектами вместо элементов с противоположным значением;

без подсказок LLM все еще не справляются с задачами по пониманию

метафорического языка, особенно в небольших дата-сетах.

10.

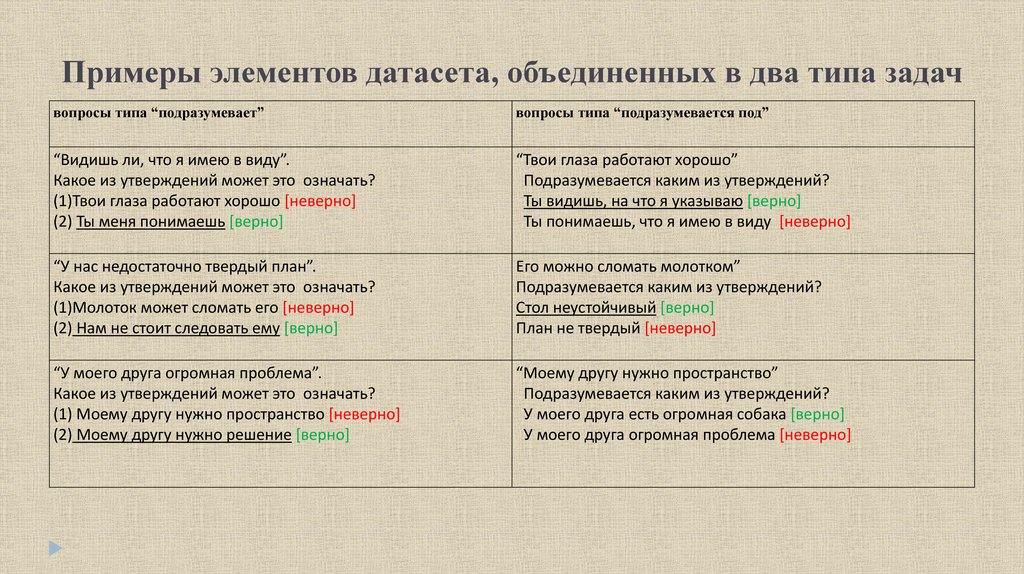

.Примеры элементов датасета, объединенных в два типа задач

вопросы типа “подразумевает”

вопросы типа “подразумевается под”

“Видишь ли, что я имею в виду”.

Какое из утверждений может это означать?

(1)Твои глаза работают хорошо [неверно]

(2) Ты меня понимаешь [верно]

“Твои глаза работают хорошо”

Подразумевается каким из утверждений?

Ты видишь, на что я указываю [верно]

Ты понимаешь, что я имею в виду [неверно]

“У нас недостаточно твердый план”.

Какое из утверждений может это означать?

(1)Молоток может сломать его [неверно]

(2) Нам не стоит следовать ему [верно]

Его можно сломать молотком”

Подразумевается каким из утверждений?

Стол неустойчивый [верно]

План не твердый [неверно]

“У моего друга огромная проблема”.

Какое из утверждений может это означать?

(1) Моему другу нужно пространство [неверно]

(2) Моему другу нужно решение [верно]

“Моему другу нужно пространство”

Подразумевается каким из утверждений?

У моего друга есть огромная собака [верно]

У моего друга огромная проблема [неверно]

11.

Выводыогромная

разница между производительностью малых (работают на

уровне случайности)и крупных (приближаются к человеческому уровню в

условиях небольшого количества подсказок) LLM;

неспособность систем ИИ мыслить по аналогии как следствие отсутствия

у них физического тела;

неумение без помощи человека делать умозаключения, основанные на

здравом смысле;

низкий предиктивный потенциал;

создание ИИ-агентов, способных понимать и генерировать аналогии,

должно быть нацелено на формирование у них разнообразных навыков

понимания отношений между объектами.

12.

Благодарю за вниманиеi.skrynnikova@volsu.ru

Программное обеспечение

Программное обеспечение Лингвистика

Лингвистика