Похожие презентации:

Обучение с учителем. Линейная регрессия

1. Обучение с учителем & Линейная регрессия

Обучение с учителем&

Линейная регрессия

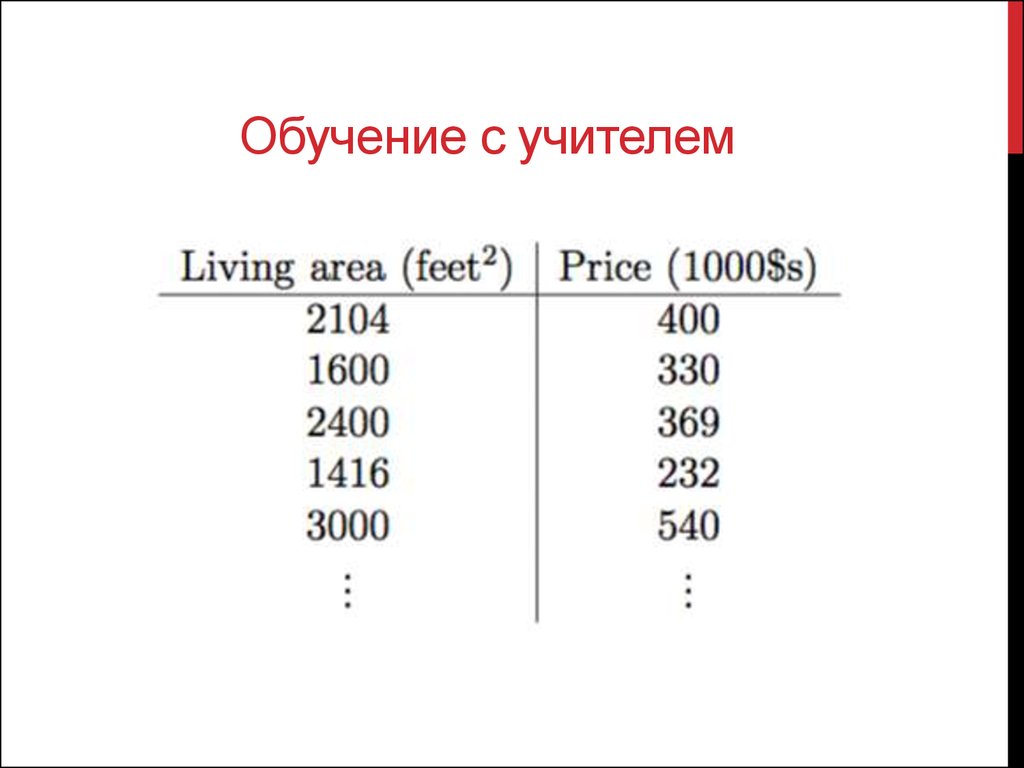

2. Обучение с учителем

3.

4. Немножко формализма

• X – input features• Y – target variable

• (xi ; yi) – training example

• { (xi ; yi) i = 1 … m } – training set

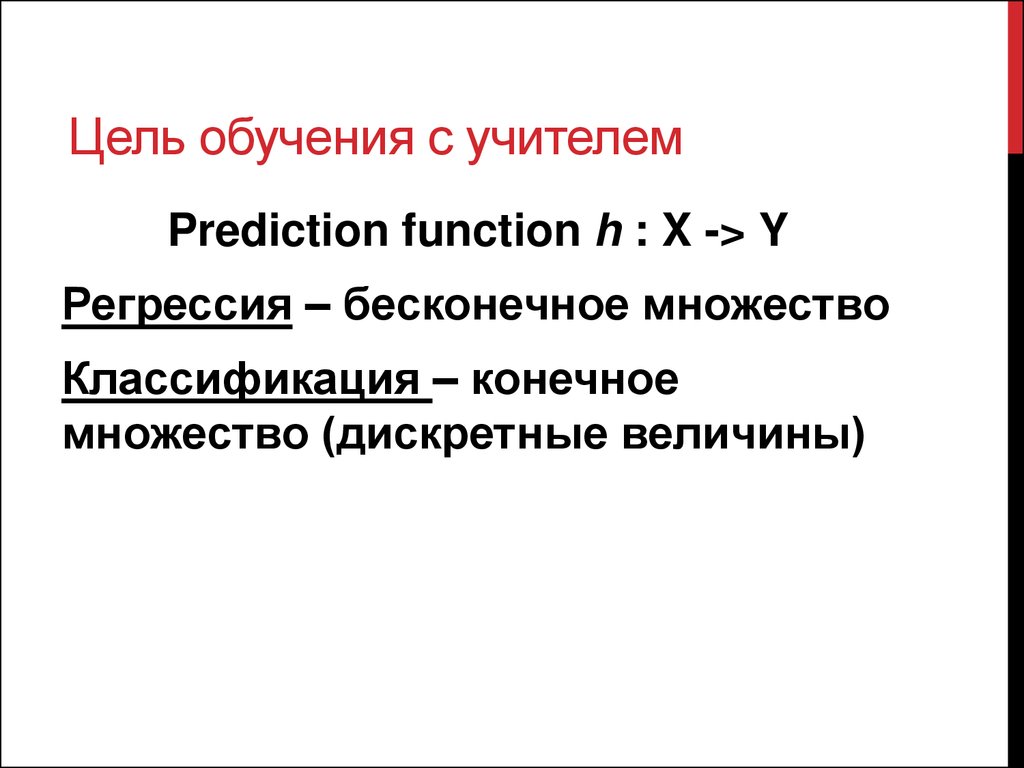

5. Цель обучения с учителем

Prediction function h : X -> YРегрессия – бесконечное множество

Классификация – конечное

множество (дискретные величины)

6. Вспомним пример

7.

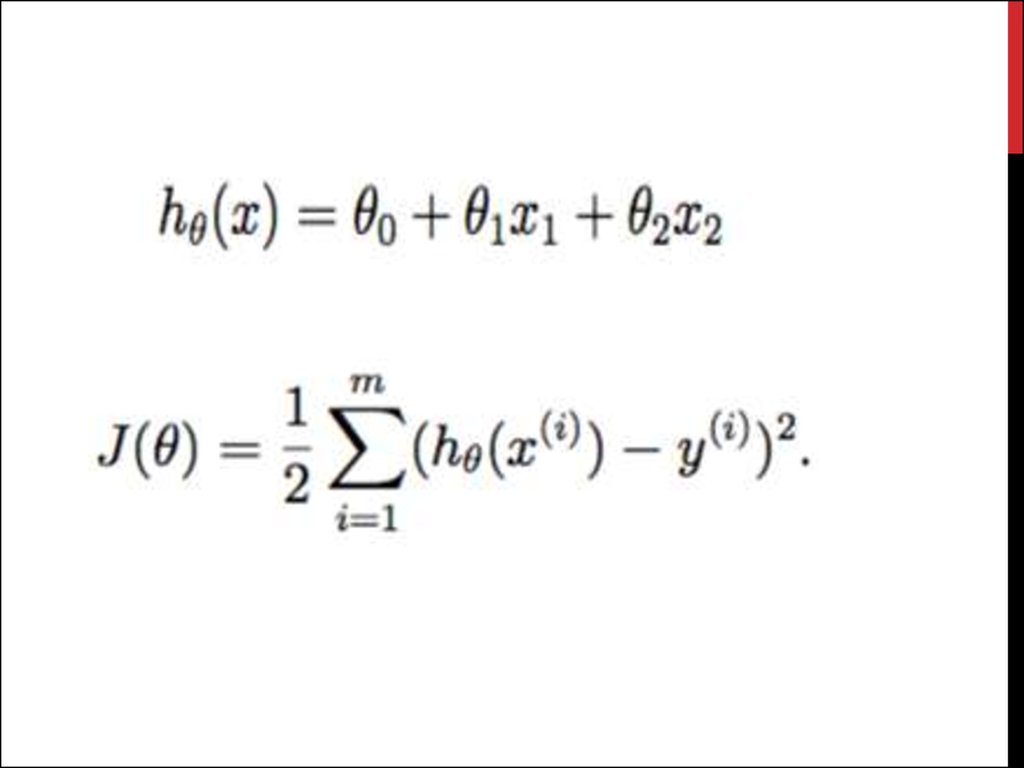

8. Метод Градиентного спуска

Нужно найти такие коэффициенты, чтобыминимизировать функцию стоимости J.

9.

10. ПСЕВДообратная матрица Мура - Пенроуза

• Пусть A – m x n матрица. Матрица C называетсяпсевдообратной к A, если:

1. ACA = A

2. CAC = C

3. (AC)* = AC

4. (CA)* = CA

Обозначение: C = A+

11. Системы линейныХ уравнений и связь с линейной регрессией

Пусть Ax = B – С.Л.УТеорема Мура – Пенроуза:

x = A+B + (En – A+A)y, где y из Rn

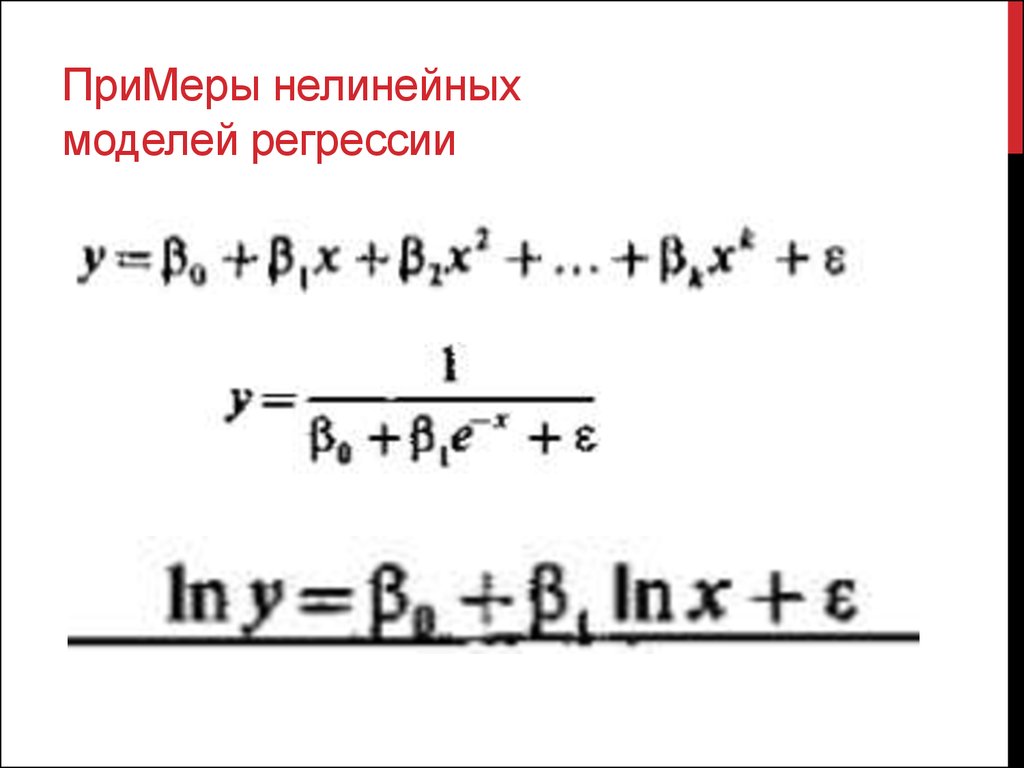

12. ПриМеры нелинейных моделей регрессии

13. Переобучение и регуляризация

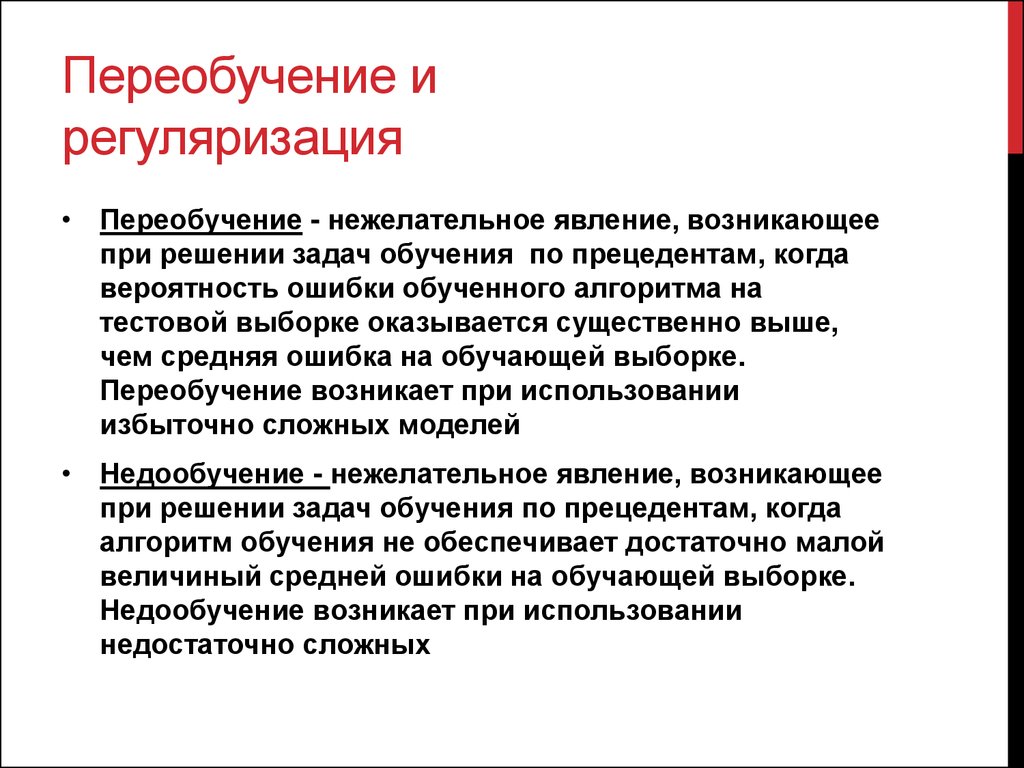

• Переобучение - нежелательное явление, возникающеепри решении задач обучения по прецедентам, когда

вероятность ошибки обученного алгоритма на

тестовой выборке оказывается существенно выше,

чем средняя ошибка на обучающей выборке.

Переобучение возникает при использовании

избыточно сложных моделей

• Недообучение - нежелательное явление, возникающее

при решении задач обучения по прецедентам, когда

алгоритм обучения не обеспечивает достаточно малой

величиный средней ошибки на обучающей выборке.

Недообучение возникает при использовании

недостаточно сложных

14. Разберем пример

Будем апроксимироватьОбучающая выборка

Модель

Алгоритм

Тестовая выборка

Математика

Математика Экономика

Экономика