Похожие презентации:

Измерение информации. Статистическтй подход Шеннона

1. Информация и информационные процессы. Измерение и кодирование информации

6. Измерение информации6.6. Статистическтй подход Шеннона

2. статистический подход Шеннона к измерению количества информации

Xp1 , p2 , , pn

x1 , x 2 , , x n

p1 p2 pn 1

xi

x1

x2

pi

p1

p2

xn

pn

3. статистический подход Шеннона (исходные позиции к измерению количества информации)

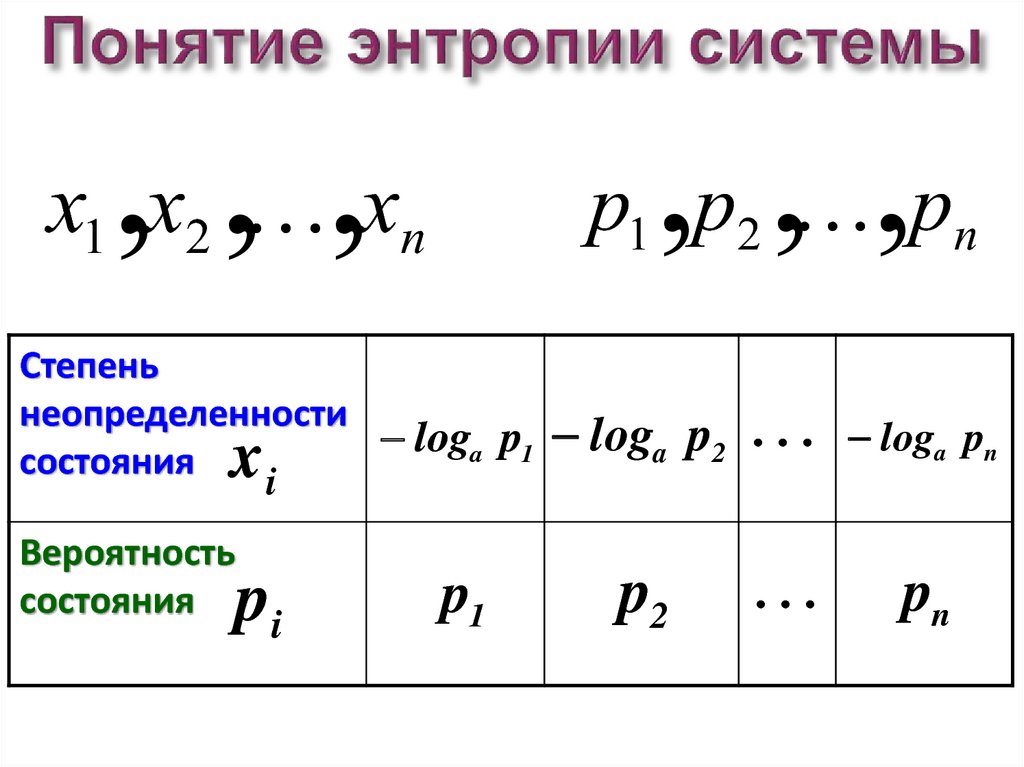

4. Понятие энтропии системы

H i loga pix1 , x2 , , xn

p1 , p2 , , pn

5. Понятие энтропии системы

H i loga piH i 0 , т.к. pi 1 и a 1

;

6. Понятие энтропии системы

x1 , x2 , , xnp1 , p2 , , pn

Степень

неопределенности

loga p1

состояния

i

x

Вероятность

состояния

pi

p1

loga p2

loga pn

p2

pn

7. Понятие энтропии системы

H ( X ) ( p log p p log p p log p )1

a 1

2

a 2

n

a n

n

H ( X ) pi log a pi

i 1

8. Понятие энтропии системы

9. Основные свойства энтропии

Энтропия всегда положительна, т.к.a 1 , 0 pi 1

и логарифмы всегда отрицательны

Энтропия обращается в нуль, когда одно из

состояний системы достоверно, а другие—

невозможны

При увеличении числа состояний системы

энтропия увеличивается

При заданном числе состояний энтропия

обращается в максимум, когда эти состояния

равновероятны

Энтропия обладает свойством аддитивности

10. Связь формулы Шеннона и формулы Хартли

1p

n

n

1

1

1

1

H ( X ) log a n log a log a n

n

n

n

i 1 n

H ( X ) n ( p log a p)

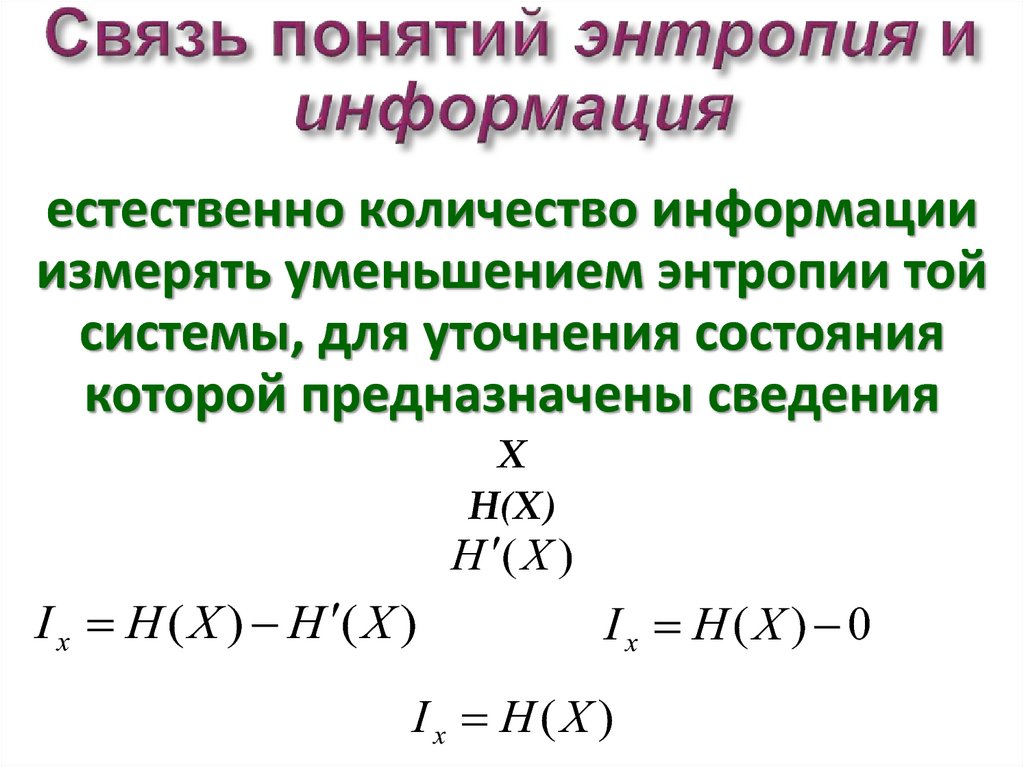

11. Связь понятий энтропия и информация

естественно количество информацииизмерять уменьшением энтропии той

системы, для уточнения состояния

которой предназначены сведения

X

H(X)

H ( X )

I x H ( X ) H ( X )

Ix H(X ) 0

I x H (X )

12. Связь понятий энтропия и информация

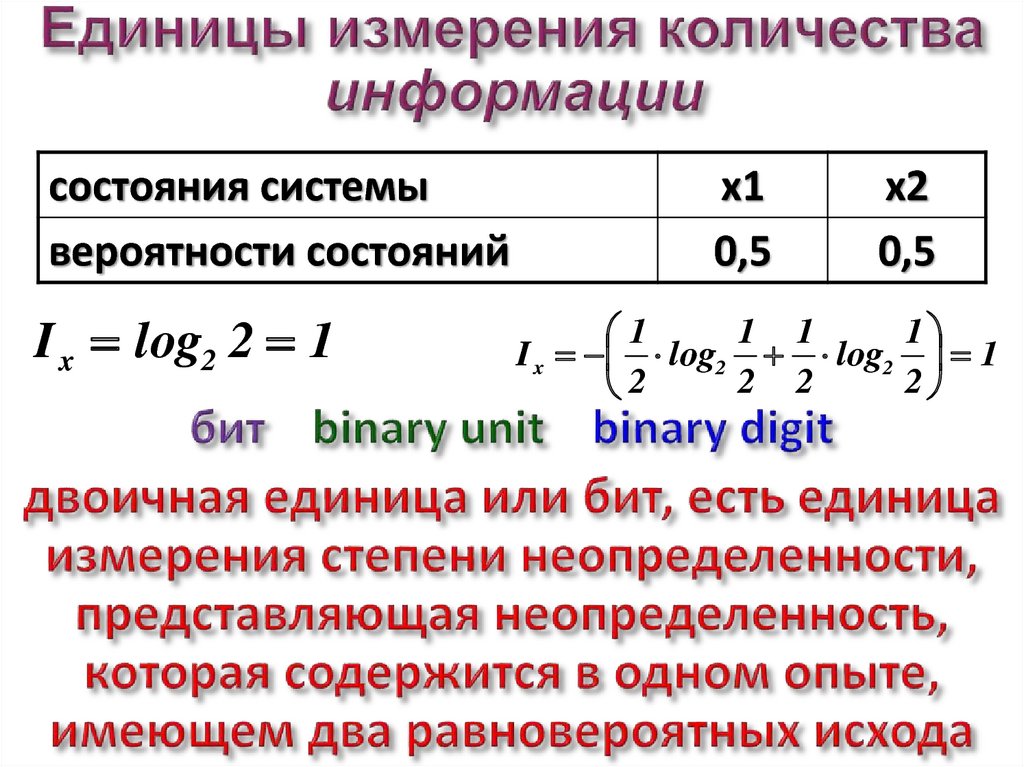

13. Единицы измерения количества информации

состояния системывероятности состояний

I x log2 2 1

x1

0,5

x2

0,5

1 1

1

1

I x log2 log2 1

2 2

2

2

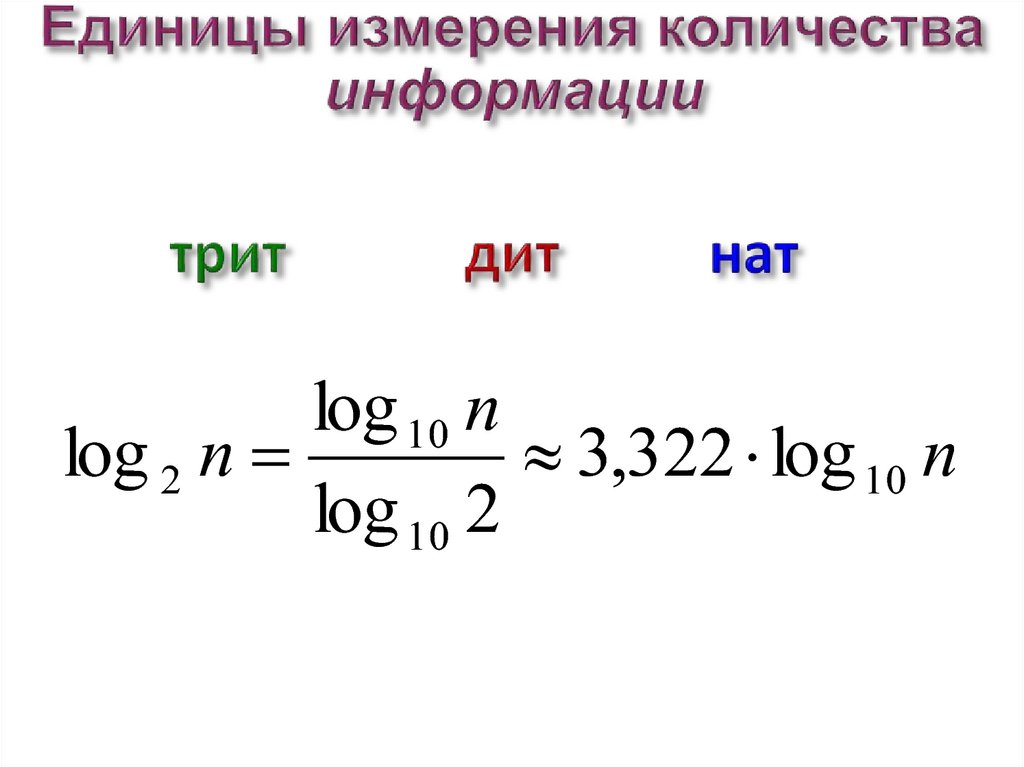

14. Единицы измерения количества информации

log 10 nlog 2 n

3,322 log 10 n

log 10 2

15. Определение количества информации в сообщении

I x H (X )n

H ( X ) pi log a pi

i 1

n

I x pi log a pi ( p1 log a p1 p2 log a p2 pn log a pn )

i 1

log a pi

X xi

I xi

I xi loga pi

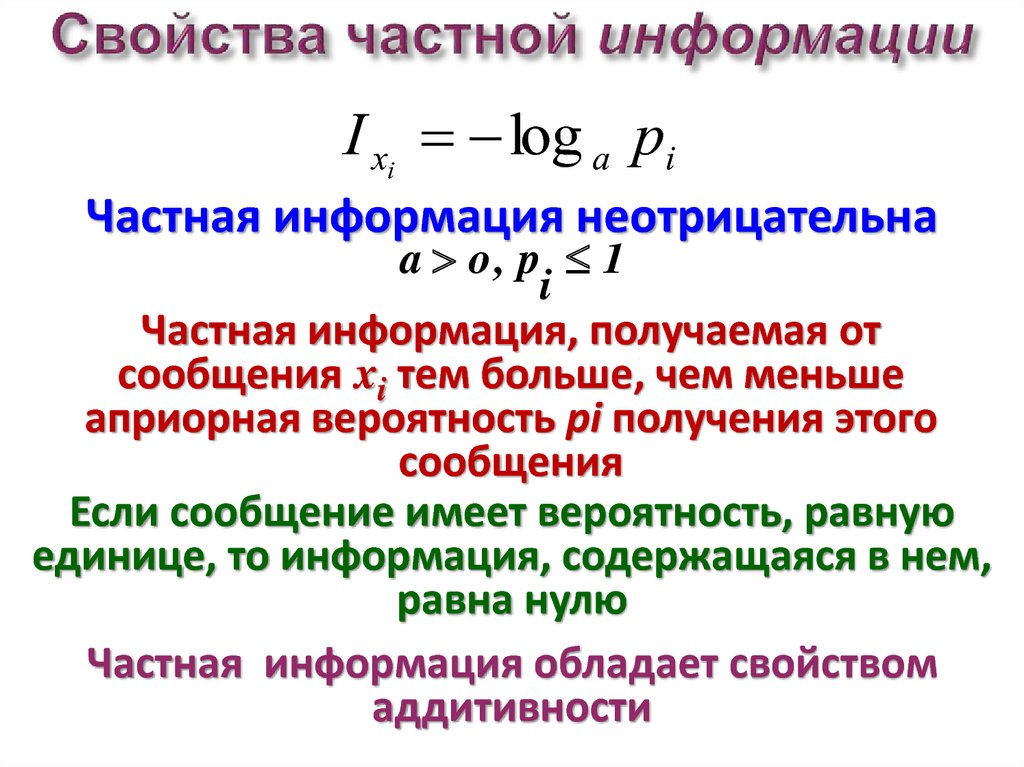

16. Свойства частной информации

I xi log a piЧастная информация неотрицательна

a o, p 1

i

Частная информация, получаемая от

сообщения xi тем больше, чем меньше

априорная вероятность pi получения этого

сообщения

Если сообщение имеет вероятность, равную

единице, то информация, содержащаяся в нем,

равна нулю

Частная информация обладает свойством

аддитивности

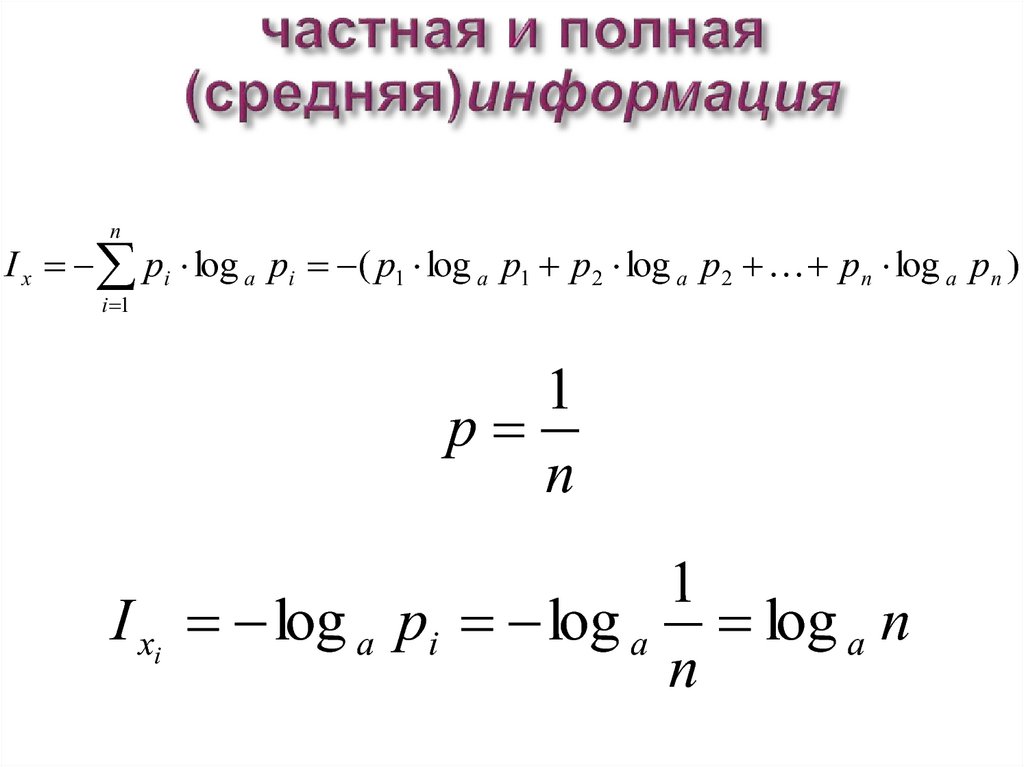

17. частная и полная (средняя)информация

nI x pi log a pi ( p1 log a p1 p2 log a p2 pn log a pn )

i 1

1

p

n

1

I xi log a pi log a log a n

n

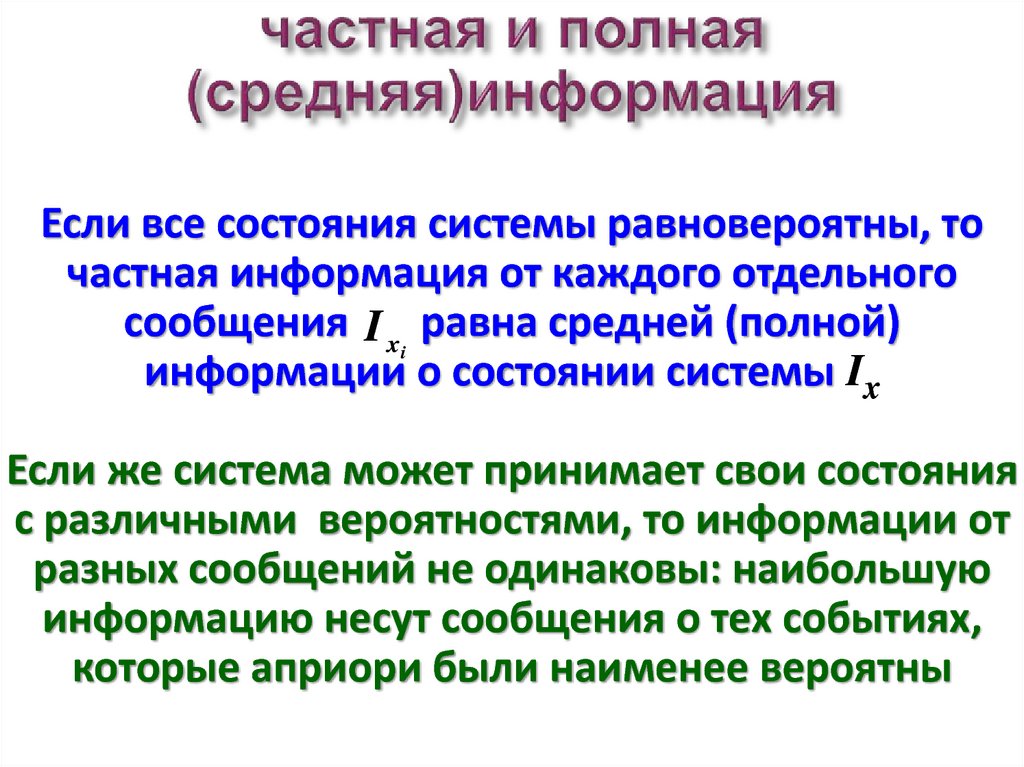

18. частная и полная (средняя)информация

Если все состояния системы равновероятны, точастная информация от каждого отдельного

сообщения I xi равна средней (полной)

информации о состоянии системы Ix

Если же система может принимает свои состояния

с различными вероятностями, то информации от

разных сообщений не одинаковы: наибольшую

информацию несут сообщения о тех событиях,

которые априори были наименее вероятны

19. Вопрос закончен

20. семантический подход к измерению количества информации

Тезаурусная мераЮ.А. Шрейдер

Тезаурус ?

Под тезаурусом (от греческого сокровище)

понимается некий обобщенный справочник,

определяющий уровень знаний получателя

сообщений. Такой справочник включает не

только описание понятий, но и связи между

ними и т.д.

21.

IcT

22.

IcIc макс

T

23.

Р. Карнапом и Бар–Хиллелом разработан подход копределению количество семантической информации на

основе изменения логической вероятности.

Под логической вероятностью понимается степень

подтверждения той или иной гипотезы

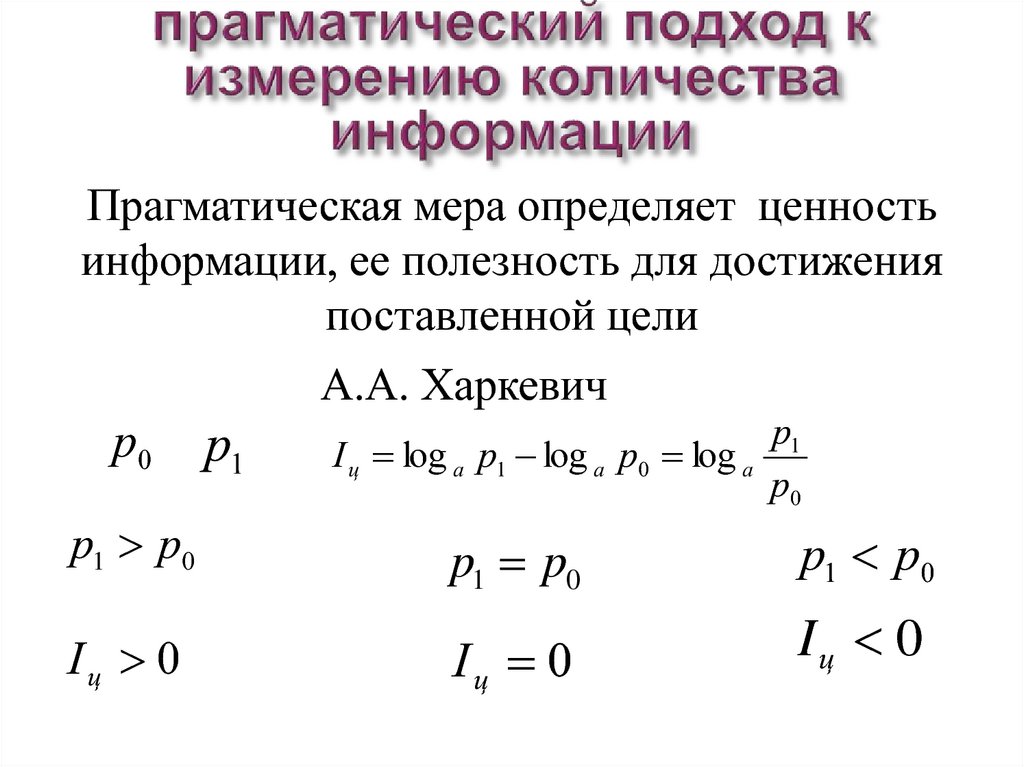

24. прагматический подход к измерению количества информации

Прагматическая мера определяет ценностьинформации, ее полезность для достижения

поставленной цели

А.А. Харкевич

p0

p1

p1

I ц log a p1 log a p0 log a

p0

p1 p0

p1 p0

p1 p0

Iц 0

Iц 0

Iц 0

Информатика

Информатика