Похожие презентации:

Измерение информации: вероятностный подход

1. Измерение информации: вероятностный подход

31.07.2019Измерение

информации:

вероятностный

подход

Урок 9

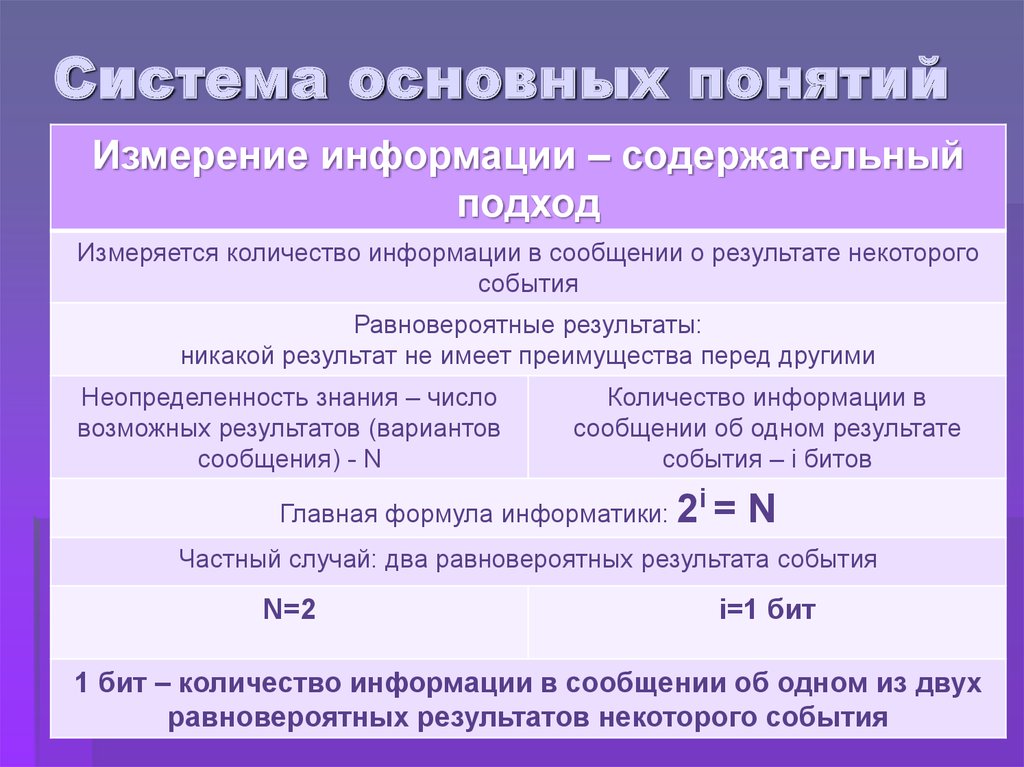

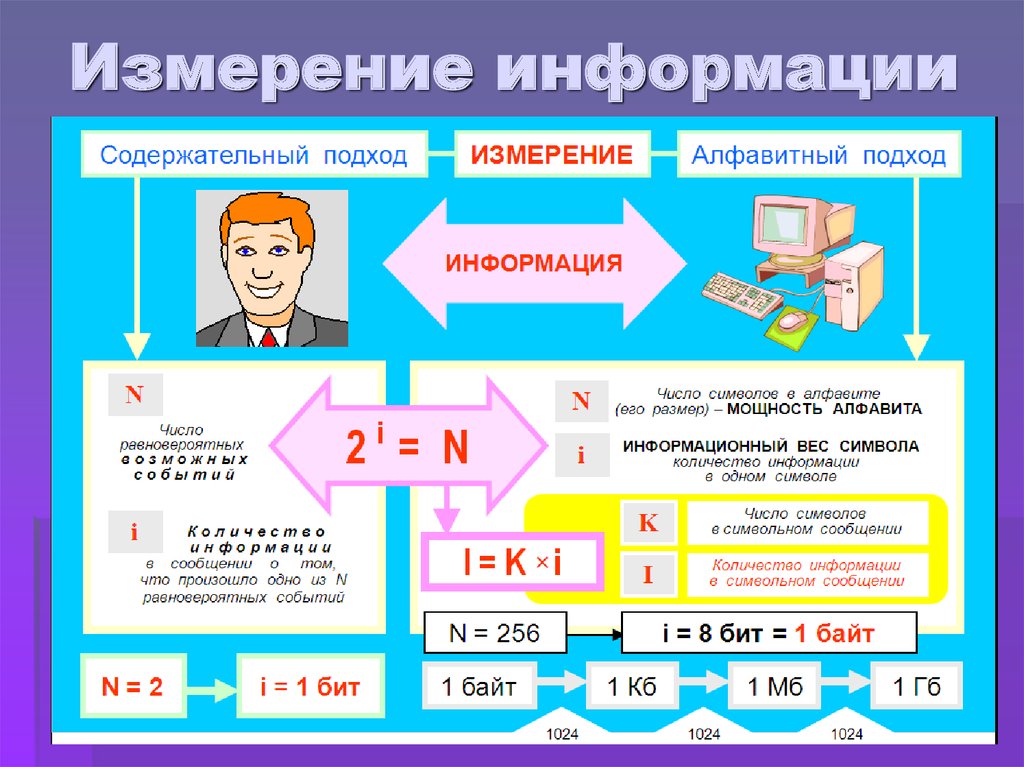

2. Система основных понятий

Измерение информации – содержательныйподход

Измеряется количество информации в сообщении о результате некоторого

события

Равновероятные результаты:

никакой результат не имеет преимущества перед другими

Неопределенность знания – число

возможных результатов (вариантов

сообщения) - N

Количество информации в

сообщении об одном результате

события – i битов

Главная формула информатики: 2

i

=N

Частный случай: два равновероятных результата события

N=2

i=1 бит

1 бит – количество информации в сообщении об одном из двух

равновероятных результатов некоторого события

3. Вопросы для повторения:

1. Что такое неопределенность знания о результатекакого-либо события? Приведите примеры, когда

неопределенность знания можно выразить

количественно.

2. Как определяется единица измерения количества

информации?

3. В каких случаях и по какой формуле можно вычислить

количество информации, содержащейся в сообщении,

используя содержательный подход?

4. Измерение информации

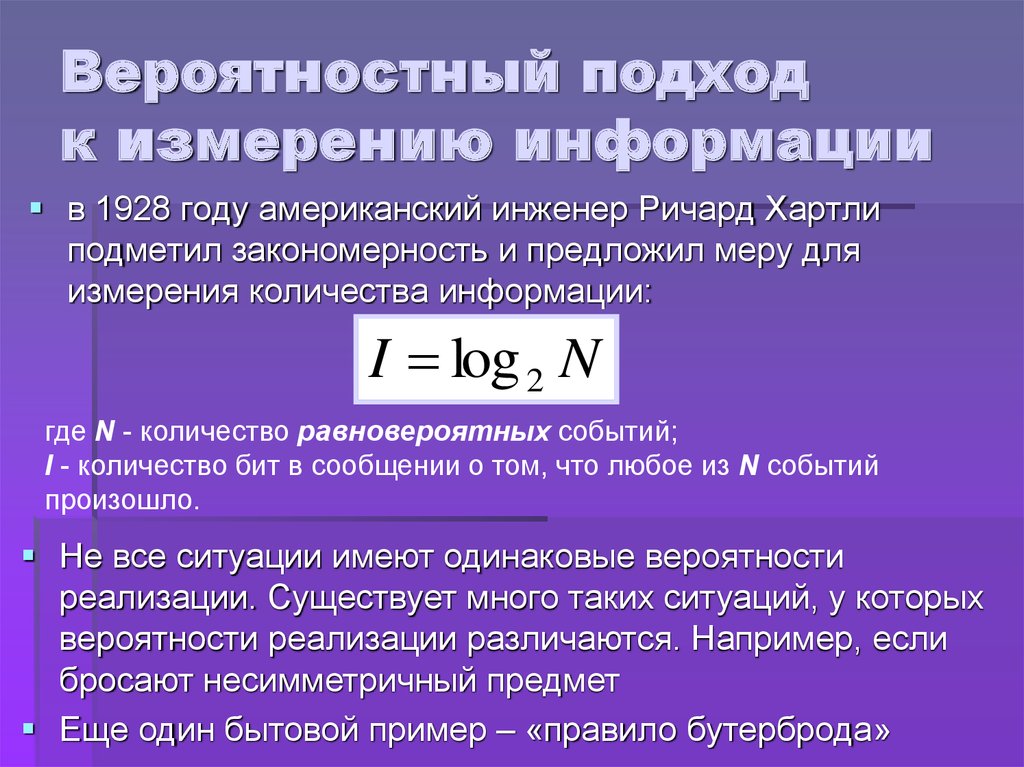

5. Вероятностный подход к измерению информации

в 1928 году американский инженер Ричард Хартлиподметил закономерность и предложил меру для

измерения количества информации:

I log 2 N

где N - количество равновероятных событий;

I - количество бит в сообщении о том, что любое из N событий

произошло.

Не все ситуации имеют одинаковые вероятности

реализации. Существует много таких ситуаций, у которых

вероятности реализации различаются. Например, если

бросают несимметричный предмет

Еще один бытовой пример – «правило бутерброда»

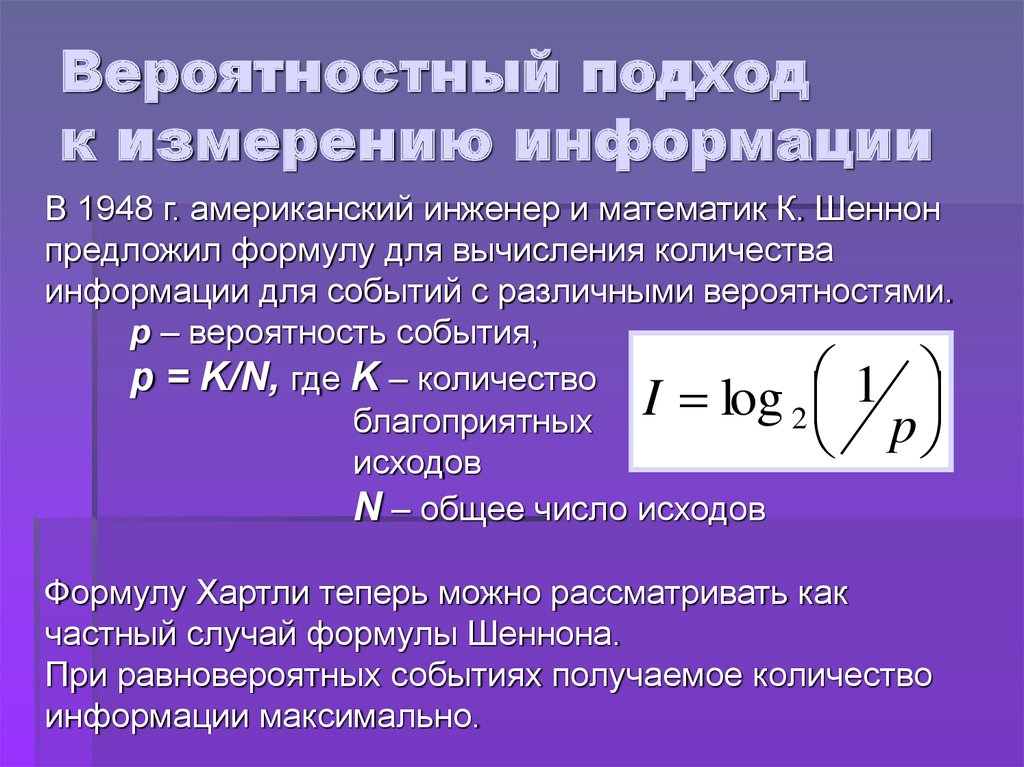

6. Вероятностный подход к измерению информации

В 1948 г. американский инженер и математик К. Шеннонпредложил формулу для вычисления количества

информации для событий с различными вероятностями.

р – вероятность события,

p = K/N, где K – количество

1

I

log

2

благоприятных

p

исходов

N – общее число исходов

Формулу Хартли теперь можно рассматривать как

частный случай формулы Шеннона.

При равновероятных событиях получаемое количество

информации максимально.

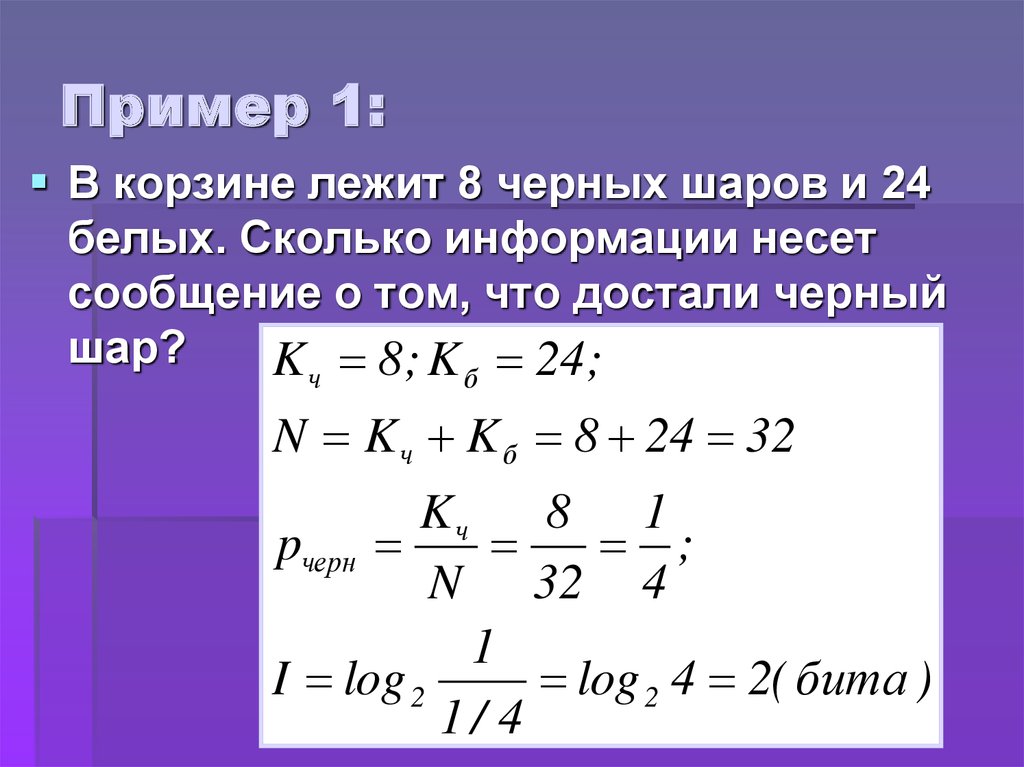

7. Пример 1:

В корзине лежит 8 черных шаров и 24белых. Сколько информации несет

сообщение о том, что достали черный

шар?

K 8 ; K 24 ;

ч

б

N K ч K б 8 24 32

Kч

8 1

pчерн

;

N 32 4

1

I log 2

log 2 4 2( бита )

1/ 4

8. Пример 1:

Для случая равновероятных событий(если все шары разного цвета):

I log 2 N log 2 32 5(бит)

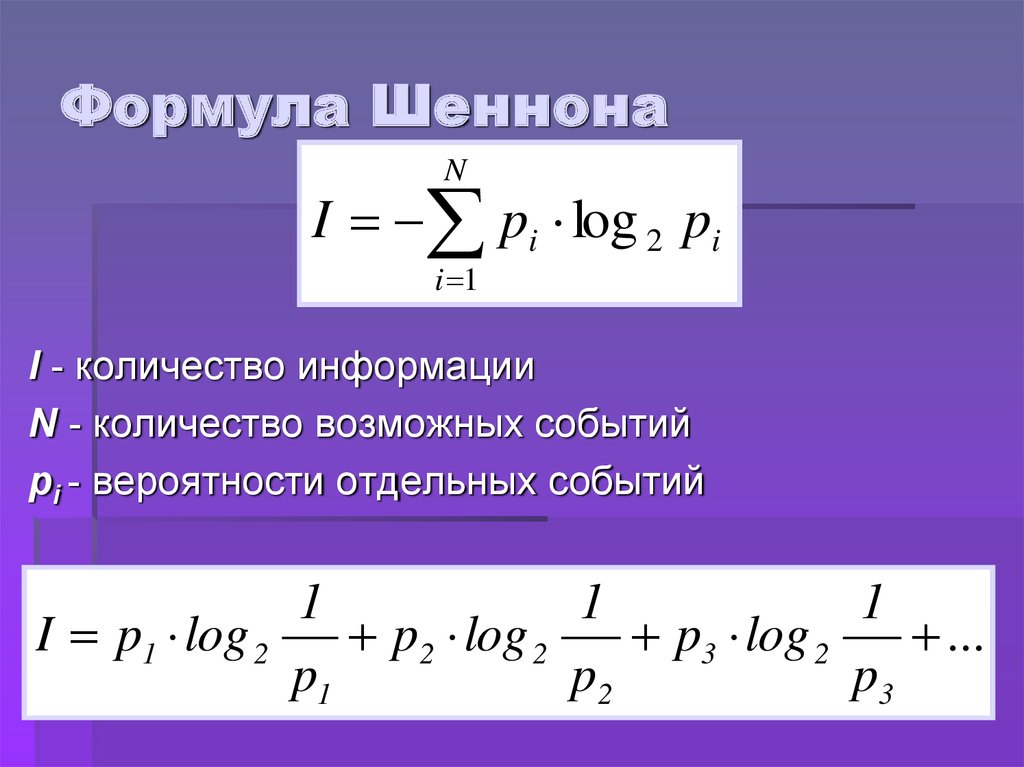

9. Формула Шеннона

NI pi log 2 pi

i 1

I - количество информации

N - количество возможных событий

рi - вероятности отдельных событий

1

1

1

I p1 log 2

p2 log 2

p3 log 2

...

p1

p2

p3

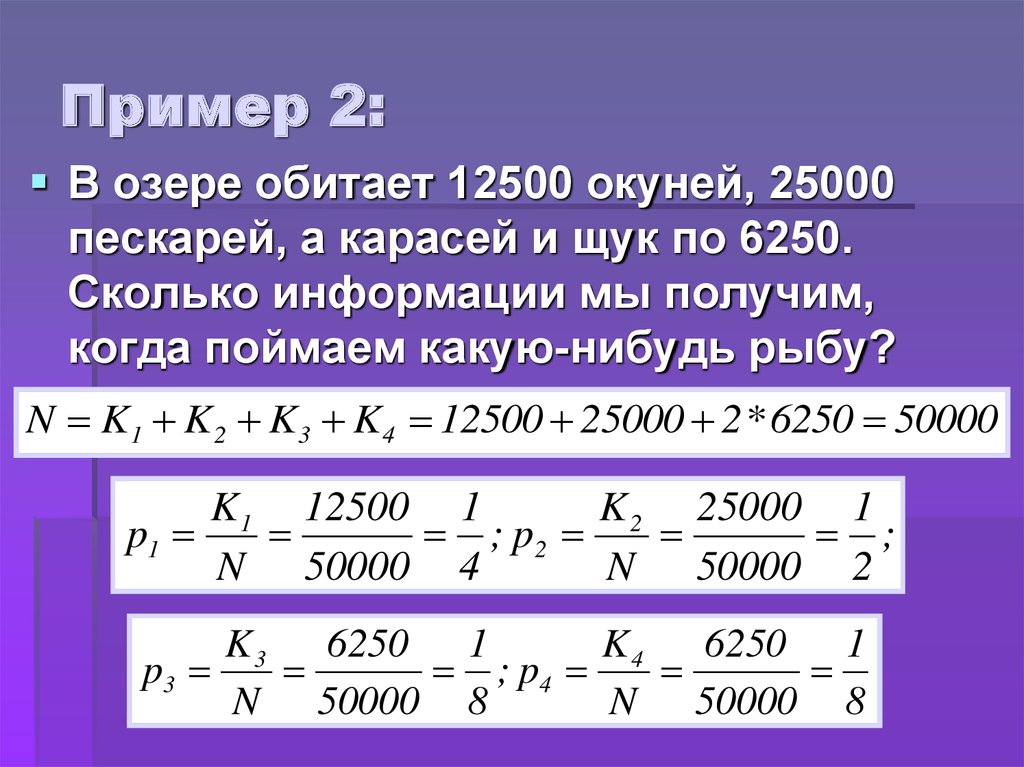

10. Пример 2:

В озере обитает 12500 окуней, 25000пескарей, а карасей и щук по 6250.

Сколько информации мы получим,

когда поймаем какую-нибудь рыбу?

N K1 K 2 K 3 K4 12500 25000 2* 6250 50000

K 1 12500 1

K 2 25000 1

p1

; p2

;

N 50000 4

N 50000 2

K3

K4

6250 1

6250 1

p3

; p4

N 50000 8

N 50000 8

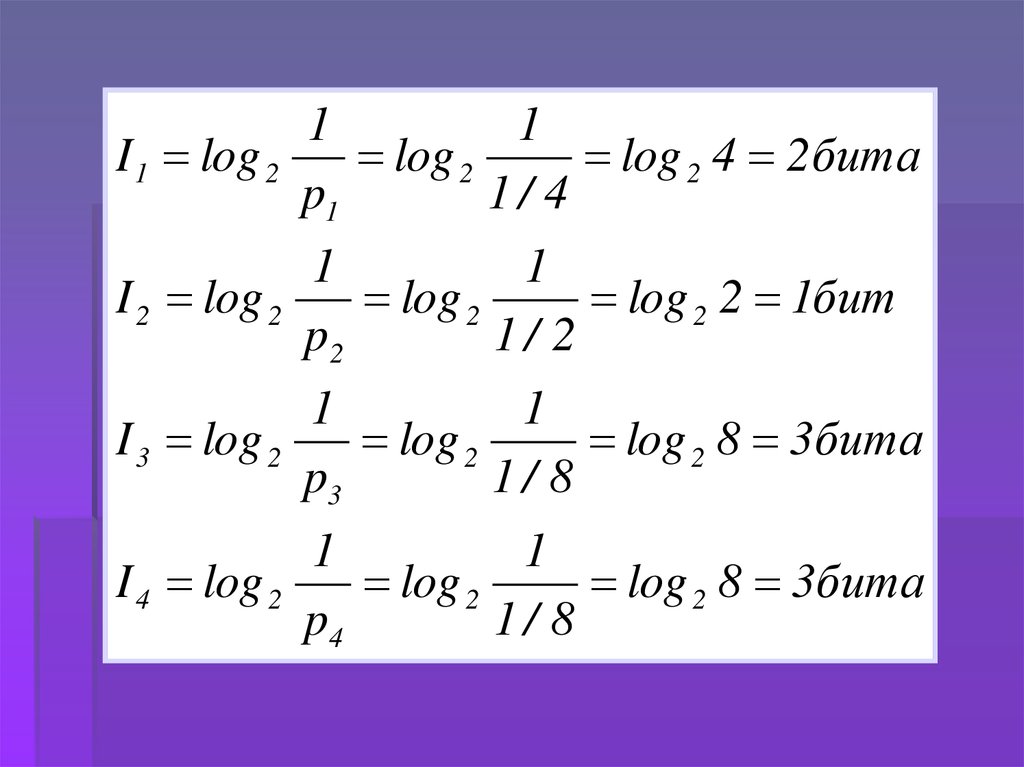

11.

11

I 1 log 2

log 2

log 2 4 2бита

p1

1/ 4

1

1

I 2 log 2

log 2

log 2 2 1бит

p2

1/ 2

1

1

I 3 log 2

log 2

log 2 8 3бита

p3

1/ 8

1

1

I 4 log 2

log 2

log 2 8 3бита

p4

1/ 8

12.

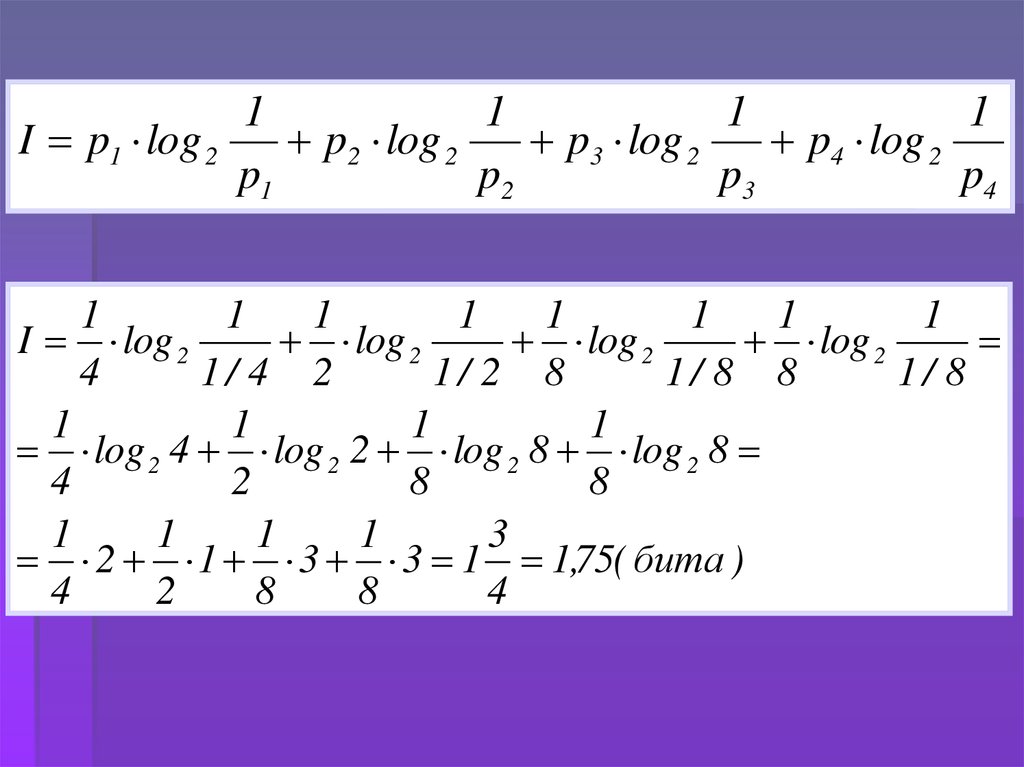

11

1

1

I p1 log 2

p2 log 2

p3 log 2

p4 log 2

p1

p2

p3

p4

1

1

1

1

1

1

1

1

I log 2

log 2

log 2

log 2

4

1/ 4 2

1/ 2 8

1/ 8 8

1/ 8

1

1

1

1

log 2 4 log 2 2 log 2 8 log 2 8

4

2

8

8

1

1

1

1

3

2 1 3 3 1 1,75( бита )

4

2

8

8

4

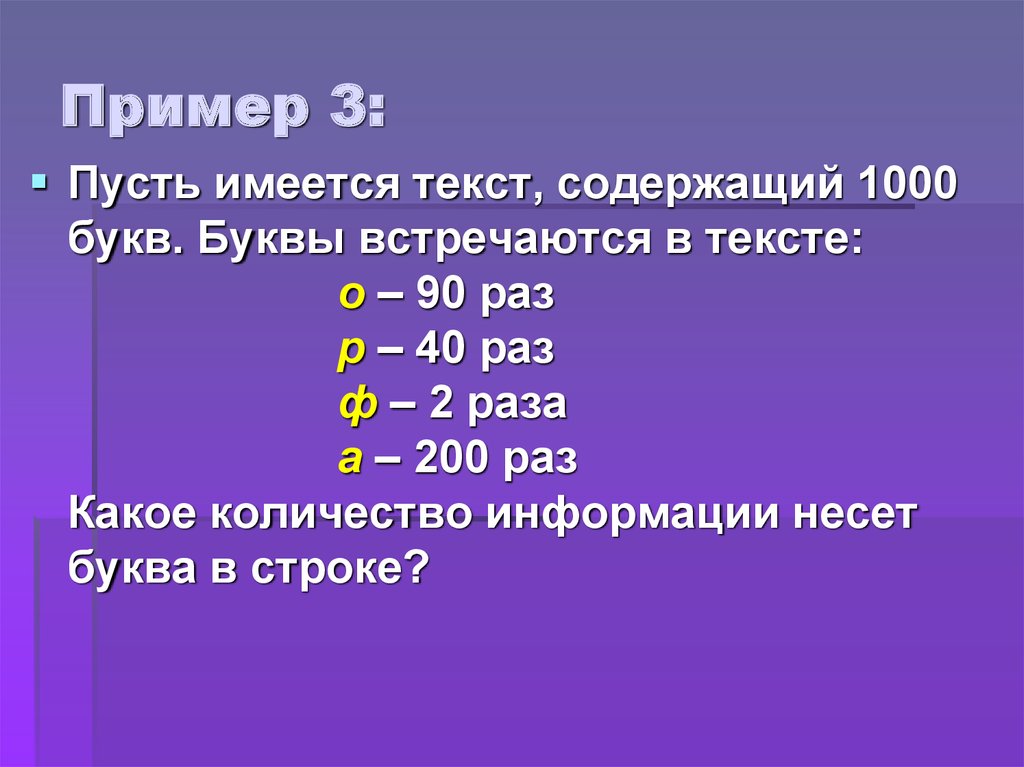

13. Пример 3:

Пусть имеется текст, содержащий 1000букв. Буквы встречаются в тексте:

о – 90 раз

р – 40 раз

ф – 2 раза

а – 200 раз

Какое количество информации несет

буква в строке?

Информатика

Информатика