Похожие презентации:

Методы поиска экстремума

1. Лекция 4

Методы поискаэкстремума

2. Классификация методов математического программирования

3.

В САПР основнымиметодами

оптимизации

являются

поисковые методы.

4.

Поисковые методыоснованы

на пошаговом изменении

управляемых параметров

X k 1 X k X k

5.

В большинстве методовприращение X k

вектора управляемых

параметров вычисляется

по формуле

X k h g X k

Хk - значение вектора управляемых параметров на k-м шаге,

h - шаг,

g(Xk) - направление поиска.

6.

Следовательно, есливыполняются условия

сходимости, то реализуется

пошаговое (итерационное)

приближение к экстремуму.

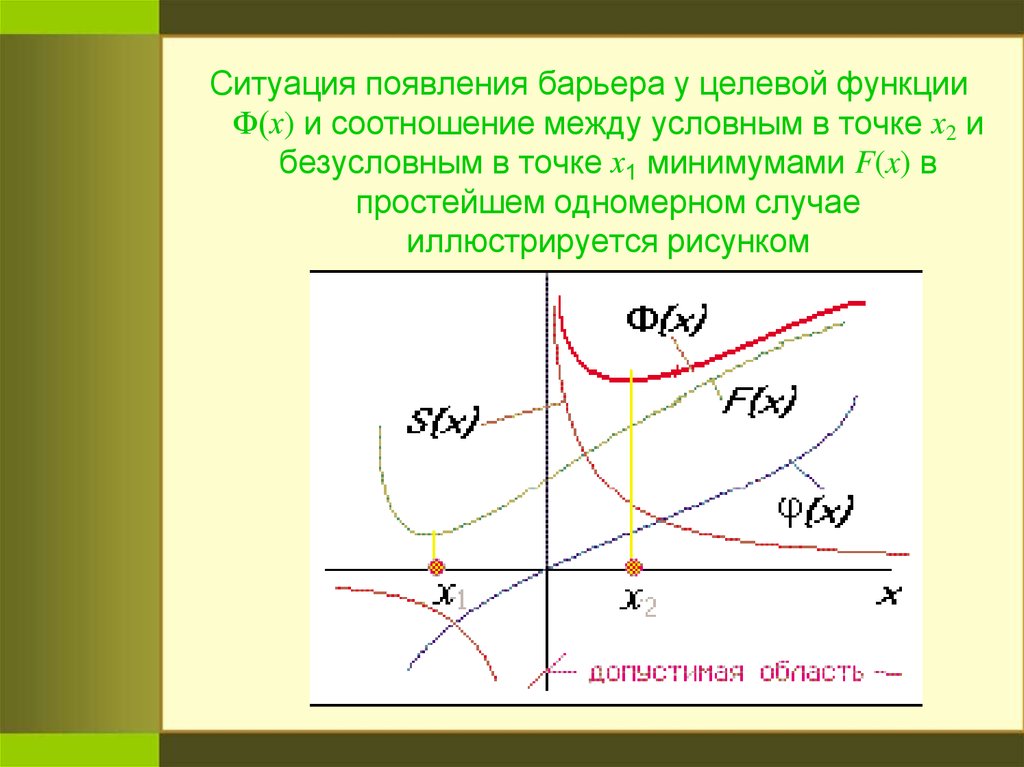

7.

Методы оптимизацииклассифицируют

по ряду признаков:

8.

В зависимости от числа управляемыхпараметров различают методы

одномерной (управляемый

параметр единственный) и

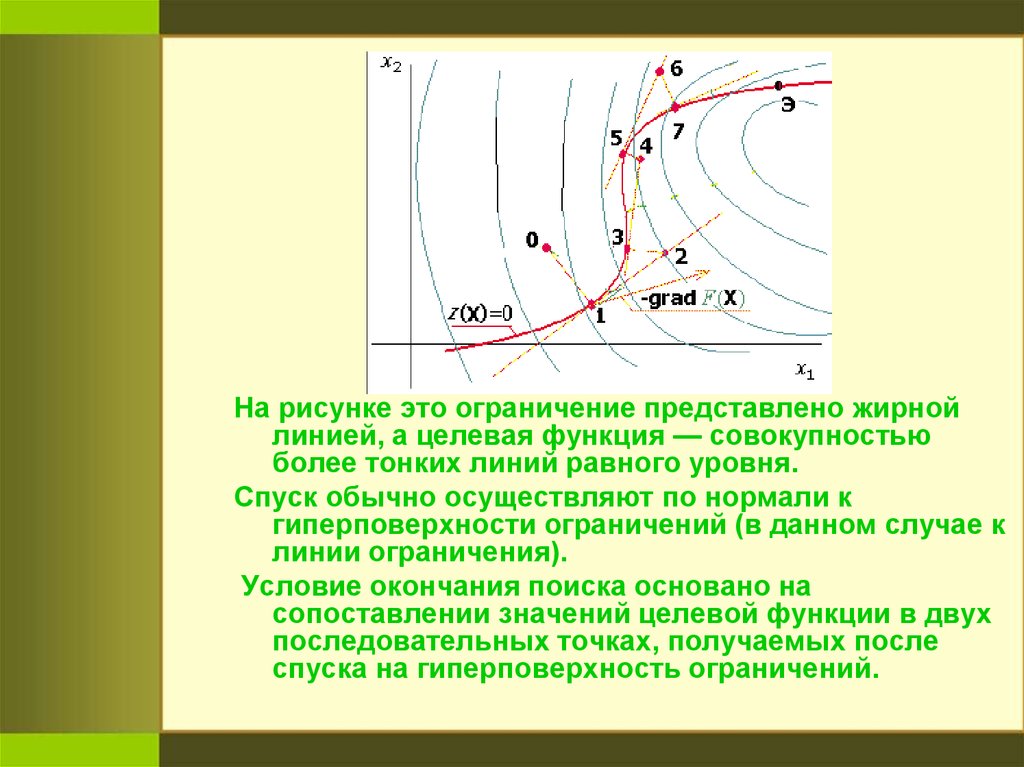

многомерной (размер вектора X не

менее двух) оптимизации.

Реальные задачи в САПР

многомерны,

методы одномерной оптимизации

играют вспомогательную роль на

отдельных этапах многомерного

поиска.

9.

Различают методы условной ибезусловной оптимизации по

наличию или отсутствию

ограничений.

Для реальных задач характерно

наличие ограничений.

Однако задачи условной оптимизации с

помощью специальных методов

могут быть сведены к задачам без

ограничений

(к безусловной оптимизации).

10.

В зависимости от числа экстремумовразличают задачи одно- и

многоэкстремальные.

Локальный метод ориентирован на

определение какого-либо локального

экстремума.

Метод глобального поиска – метод,

результатом которого является

глобальный экстремум.

Удовлетворительные по вычислительной

эффективности методы глобального

поиска для общего случая

отсутствуют и потому на практике в

САПР используют методы поиска

локальных экстремумов.

11.

Методы нескольких порядковразличают по использованию

при поиске производных

целевой функции по

управляемым параметрам.

Если производные не

используются, то имеет место

метод нулевого порядка, если

используются первые или

вторые производные, то

соответственно метод первого

или второго порядка.

12.

Методы первого порядка называюттакже градиентными,

поскольку вектор первых

производных F(X) по N есть

градиент целевой функции

grad F X F x1 , F x2 ,..., F xn

13.

Конкретные методыопределяются следующими

факторами:

1) способом вычисления

направления поиска g(Xk) в

формуле X k h g X k ;

2) способом выбора шага h;

3) способом определения

окончания поиска.

Определяющим фактором

является первый.

14.

Шаг может быть постояннымили выбираться исходя из

одномерной оптимизации —

поиска минимума целевой

функции в выбранном

направлении g(Xk).

В последнем случае шаг будем

называть оптимальным.

15.

Правило окончания поиска:если на протяжении r подряд

идущих шагов траектория

поиска остается в малой

ε-окрестности текущей точки

поиска Xk, то поиск следует

прекратить.

Условие окончания поиска :

X k X k r

16. Необходимые условия экстремума

17.

В задачах безусловнойоптимизации необходимые

условия представляют собой

равенство нулю градиента

целевой функции

grad F X 0

18.

Базовая (общая) задача оптимизацииставится как задача математического

программирования:

extr F X

X D x

D x X X 0, ψ X 0

где F(X) — целевая функция, X — вектор

управляемых (проектных) параметров,

φ(X) и ψ(X) — функции-ограничения,

Dx —допустимая область в пространстве

управляемых параметров.

19.

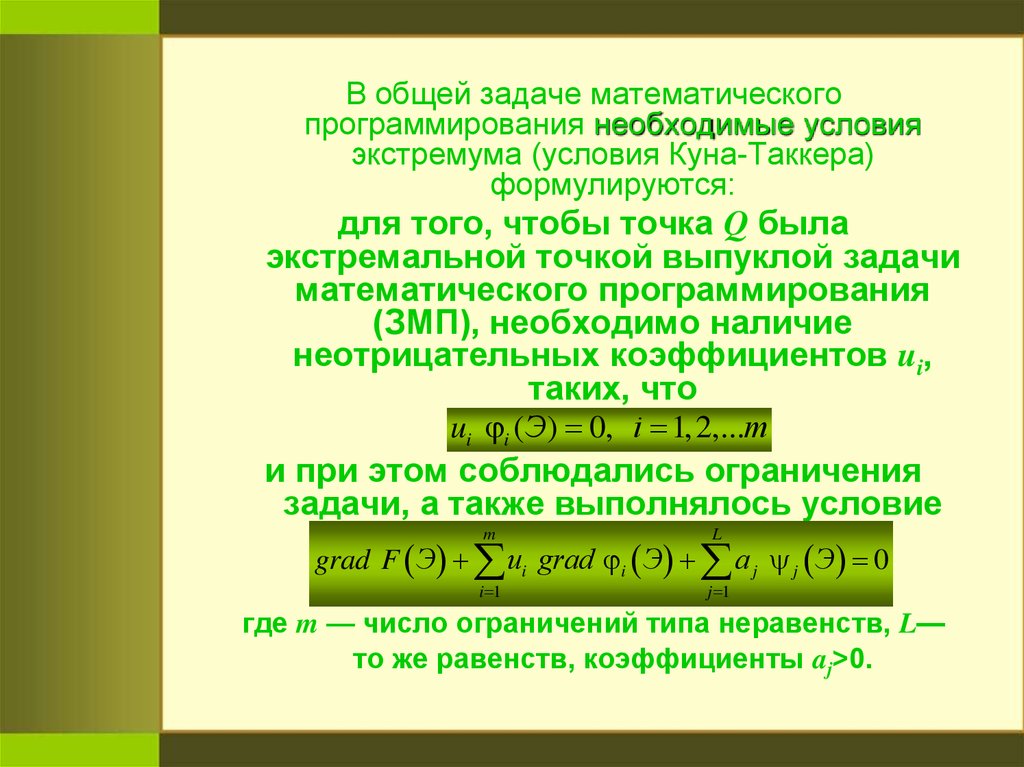

В общей задаче математическогопрограммирования необходимые условия

экстремума (условия Куна-Таккера)

формулируются:

для того, чтобы точка Q была

экстремальной точкой выпуклой задачи

математического программирования

(ЗМП), необходимо наличие

неотрицательных коэффициентов ui,

таких, что

ui i (Э) 0, i 1,2,...m

и при этом соблюдались ограничения

задачи, а также выполнялось условие

m

L

i 1

j 1

grad F Э ui grad i Э a j j Э 0

где m — число ограничений типа неравенств, L—

то же равенств, коэффициенты aj>0.

20.

Абстрактная формулировкаусловий имеет простой

геометрический смысл

21.

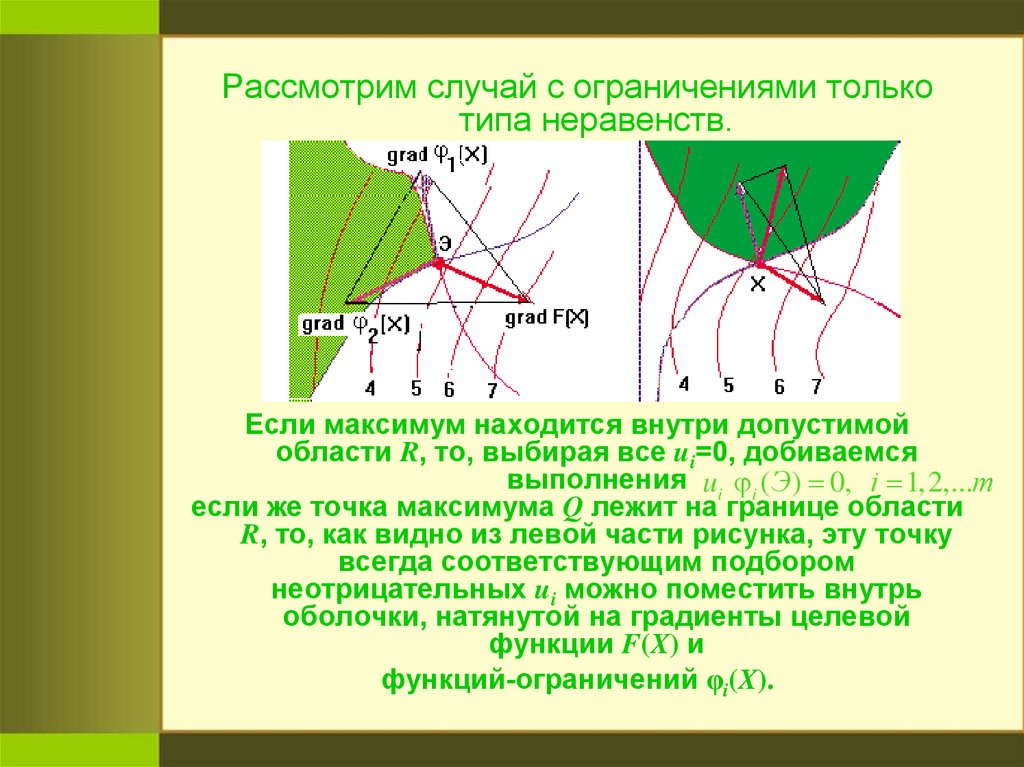

Рассмотрим случай с ограничениями толькотипа неравенств.

Если максимум находится внутри допустимой

области R, то, выбирая все ui=0, добиваемся

выполнения ui i (Э) 0, i 1,2,...m

если же точка максимума Q лежит на границе области

R, то, как видно из левой части рисунка, эту точку

всегда соответствующим подбором

неотрицательных ui можно поместить внутрь

оболочки, натянутой на градиенты целевой

функции F(X) и

функций-ограничений φi(X).

22.

Наоборот, если точка не являетсяэкстремальной, то условие

ui i (Э) 0, i 1,2,...m

нельзя выполнить при любом выборе

положительных коэффициентов ui

(см. правую часть рисунка, где

рассматриваемая точка N лежит вне

выпуклой оболочки, натянутой на

градиенты).

Учет ограничений типа равенств

очевиден, если добавляется сумма

L

a

j 1

j

j Э

23.

Методы поискаусловных

экстремумов

24.

Широко известен методмножителей Лагранжа,

ориентированный на поиск

экстремума при наличии

ограничений типа равенств

ψ(X) = 0,

т.е. на решение задачи

extr F X ,

X R

где R X ψ X 0

25.

Суть метода заключается впреобразовании

задачи условной оптимизации в

задачу безусловной оптимизации

с помощью образования новой

целевой функции

L

X, Λ F X i i X

i 1

где Λ 1 , 2 ,... n - вектор множителей Лагранжа,

L - число ограничений.

26.

Необходимые условия экстремумафункции X :

X, Λ X F X X i i X X 0;

X, Λ Λ ψ X 0.

Система содержит n+L алгебраических уравнений, где

n - размерность пространства управляемых

параметров. Её решение - искомые координаты

экстремальной точки и значения множителей

Лагранжа.

При численном решении системы (алгоритмические

модели) возникают трудности. Поэтому в САПР

основными методами решения ЗМП являются

методы штрафных функций и проекции градиента.

27.

Основная идея методов штрафныхфункций — преобразование задачи

условной оптимизации в задачу

безусловной оптимизации путем

формирования новой целевой функции

Ф(N) введением в исходную целевую

функцию F(X) специальным образом

выбранной функции штрафа S(X):

N F X r S X

где r - множитель, значения которого

можно изменять в процессе

оптимизации.

28.

Среди методов штрафных функцийразличают методы внутренней и

внешней точки.

Согласно методам внутренней точки

(методам барьерных функций)

исходную для поиска точку можно

выбирать только внутри

допустимой области, а для методов

внешней точки как внутри, так и вне

допустимой области (в ней

функции целевая и ограничений

должны быть определены).

29.

Ситуация появления барьера у целевой функцииФ(х) и соотношение между условным в точке х2 и

безусловным в точке х1 минимумами F(x) в

простейшем одномерном случае

иллюстрируется рисунком

30.

1)Примеры штрафных функций:

для метода внутренней точки при

m

ограничениях i X 0

S X 1 i X ,

i 1

2)

где m - число ограничений типа неравенств;

для метода внешней точки при таких же

m

ограничениях

2

S X min 0, i X

i 1

3)

здесь штраф сводится к включению в Ф(N)

суммы квадратов активных (т.е. нарушенных)

ограничений;

в случае ограничений типа равенств i X 0

L

S X i X

i 1

2

31.

Чем больше коэффициент r, темточнее решение задачи, однако при

больших r может ухудшаться ее

обусловленность.

Поэтому в начале поиска обычно

выбирают умеренные значения r,

увеличивая их в окрестностях

экстремума.

32.

Основной вариантметода проекции градиента

ориентирован на задачи

математического

программирования c

ограничениями типа равенств.

33.

Поиск при выполнении ограниченийосуществляется в подпространстве

(n-m) измерений,

где n - число управляемых параметров,

m - число ограничений.

При этом движение осуществляется в

направлении проекции градиента

целевой функции F(X) на

гиперплоскость, касательную к

гиперповерхности ограничений

(точнее к гиперповерхности

пересечения гиперповерхностей

ограничений).

34.

Поиск минимума начинают соспуска из исходной точки на

гиперповерхность ограничений.

Далее выполняют шаг в

указанном выше направлении

(шаг вдоль гиперповерхности

ограничений).

Поскольку этот шаг может

привести к заметному нарушению

ограничений, вновь повторяют

спуск на гиперповерхность

ограничений и т.д.

35.

Идею метода поясним дляслучая поиска в двумерном

пространстве при одном

ограничении ψ(X) = 0.

36.

На рисунке это ограничение представлено жирнойлинией, а целевая функция — совокупностью

более тонких линий равного уровня.

Спуск обычно осуществляют по нормали к

гиперповерхности ограничений (в данном случае к

линии ограничения).

Условие окончания поиска основано на

сопоставлении значений целевой функции в двух

последовательных точках, получаемых после

спуска на гиперповерхность ограничений.

37.

Рассмотрим получениеаналитических выражений для

направлений спуска и

движения вдоль

гиперповерхности

ограничений.

38.

СпускНеобходимо из текущей точки поиска В

попасть в точку А, являющуюся

ближайшей к В точкой на

гиперповерхности ограничений,

т.е. решить задачу:

min |B-A|

при условии ψ(X)=0, которое после

линеаризации в окрестностях точки В

имеет вид

B grad B A B 0

T

39.

Используем метод множителей Лагранжа, обозначаяА-В=U и учитывая, что минимизация расстояния

равнозначна минимизации скалярного

произведения U на U, получаем

A U T U B grad B U

T

A 2U grad B 0

B grad B U 0

T

тогда из второго выражения получаем

U 0,5 grad B

подставляя его в третье выражение, имеем

B 0,5 grad B grad B 0

T

1

откуда 0,5 grad B grad B B

Подставляя λ во второе выражение, находим

T

U grad B grad B grad B B

T

1

40.

Движение вдольгиперповерхности

ограничений

Шаг в гиперплоскости D, касательной к

гиперповерхности ограничений,

следует сделать в направлении

вектора S, на котором целевая

функция уменьшается в наибольшей

мере при заданном шаге h.

41.

Уменьшение целевой функции припереходе из точки А в новую точку С

подсчитывают, используя формулу

линеаризации F(X) в окрестностях

точки А:

F C F A h grad F A S

T

где grad F A S - приращение F(X),

которое нужно минимизировать,

варьируя направления S.

T

42.

min F C min grad F A ST

где вариация S осуществляется в пределах

гиперплоскости D; grad ψ(A) и S —

ортогональные векторы.

Следовательно, минимизацию этого выражения

необходимо выполнять при ограничениях

grad A T S 0

STS 1

Последнее ограничение говорит о том, что при

поиске направления движения, вектор S должен

лишь указывать это направление, т.е. его длина

несущественна (пусть S — единичный вектор).

43.

Для решенияmin F C min gradF A S

T

используем метод множителей Лагранжа.

S, , q grad F A S grad A S q S T S 1

T

T

где λ и q — множители Лагранжа;

S grad F A grad A qS 0

grad F A S 0

T

q S T S - 1 0

Из второго выражения следует, что

S grad F A grad A q

подставляя S в третье выражение, получаем

grad A T grad F A grad A T grad A 0

откуда

44.

grad A grad AT

1

grad A T gradF A ,

S gradF A grad A grad A grad A

T

E grad A grad A grad A

T

1

1

grad A T gradF A q .

Таким образом, матрица

P E grad A grad A grad A

T

q

grad A T gradF A

1

grad A T

представляет собой проектирующую

матрицу, а вектор S, рассчитанный по

верхнему выражению, — проекцию

градиента grad F(A) на гиперповерхность

ограничений.

45.

Частным случаем примененияметода проекции градиента

являются задачи оптимизации с

максиминным критерием. Для

поиска экстремума функции

минимума

max min Z j X

X

j

где Zj — нормированная величина

j-го выходного параметра yj,

удобно применять метод

проекции градиента.

46.

В качестве ограничений задачи в исходнойпостановке фигурируют только прямые

ограничения

x max i xi x min i

Здесь хmaxi и xmini — граничные значения

допустимого диапазона варьирования

параметра хi.

В процессе поиска, если минимальной

является функция Zq(X) и траектория

поиска пересекает гребень

Z q X Z k X 0

то поиск продолжается в направлении

проекции градиента функции Zq(X) на

гиперповерхность этого гребня.

Программирование

Программирование