Похожие презентации:

Некоторые аспекты регрессионного анализа. Тема 4

1. Тема 4. Некоторые аспекты регрессионного анализа

2. Вопросы:

4.1. Спецификация уравнения регрессии иошибки спецификации.

4.2. Мультиколлинеарность: способы

выявления и устранения

4.3. Фиктивные переменные в

регрессионных моделях.

4.4. Гетероскедастичность

4.5. Автокорреляция

3. Модель множественной линейной регрессии в матричном виде

Y X4.

y1Y

y n

5.

xij ,i 1, n;

j 1, k .

6.

1 x11 x1kX

1 xn1 xnk

7.

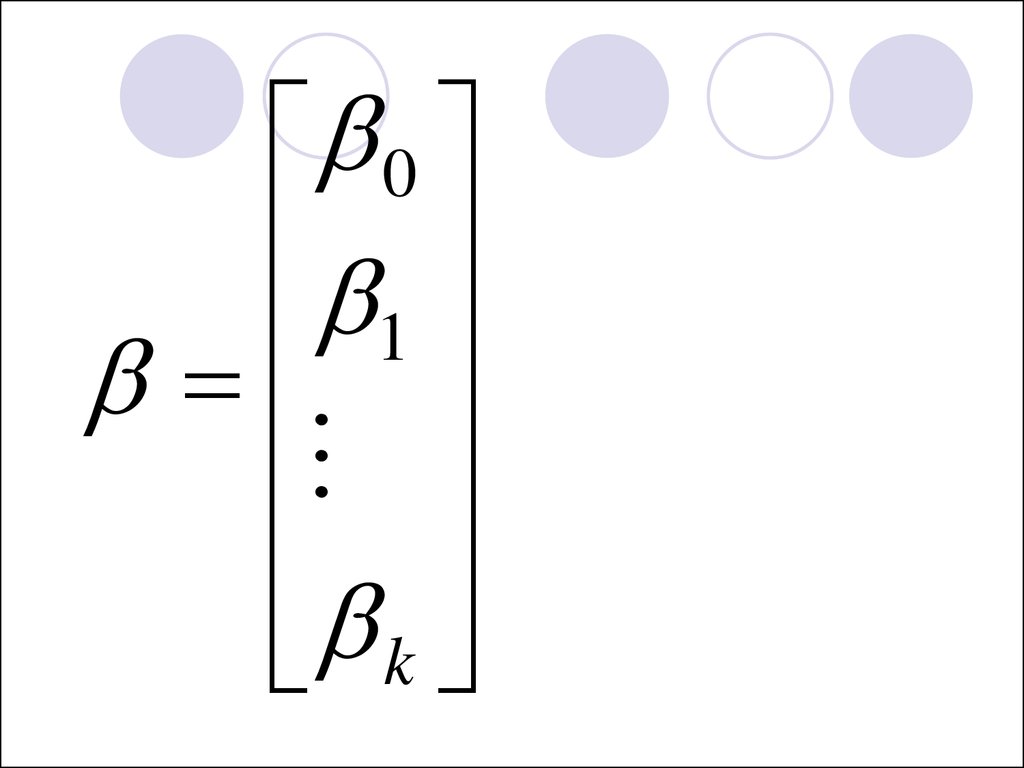

01

k

8.

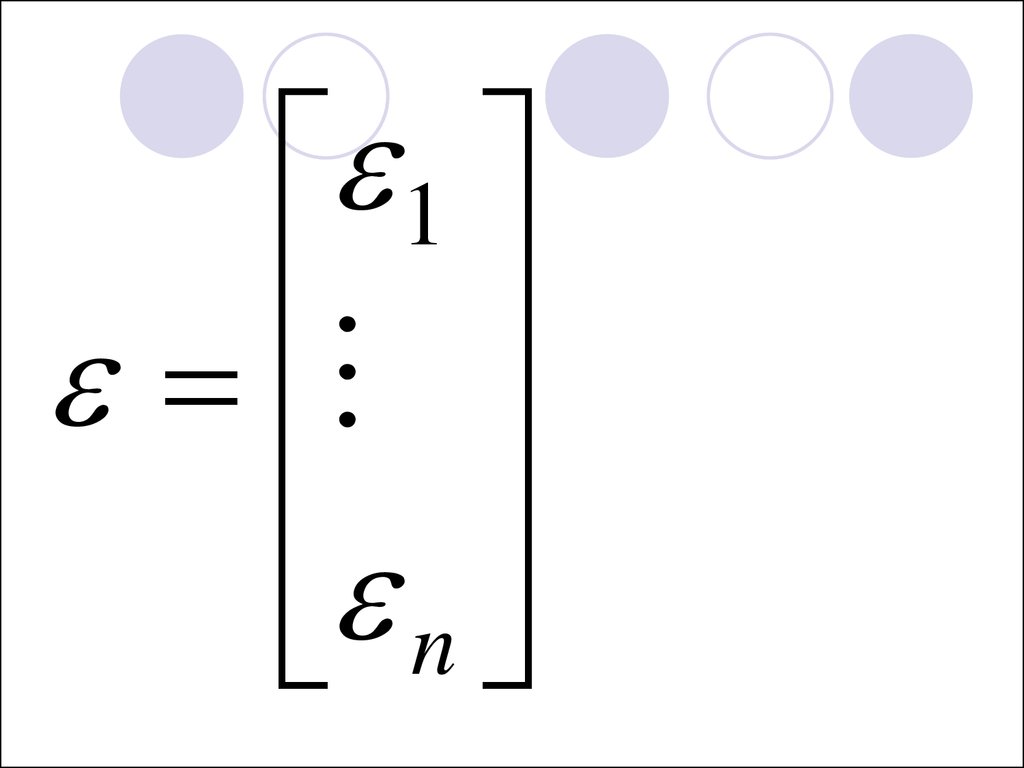

1n

9. Уравнение множественной линейной регрессии в матричном виде

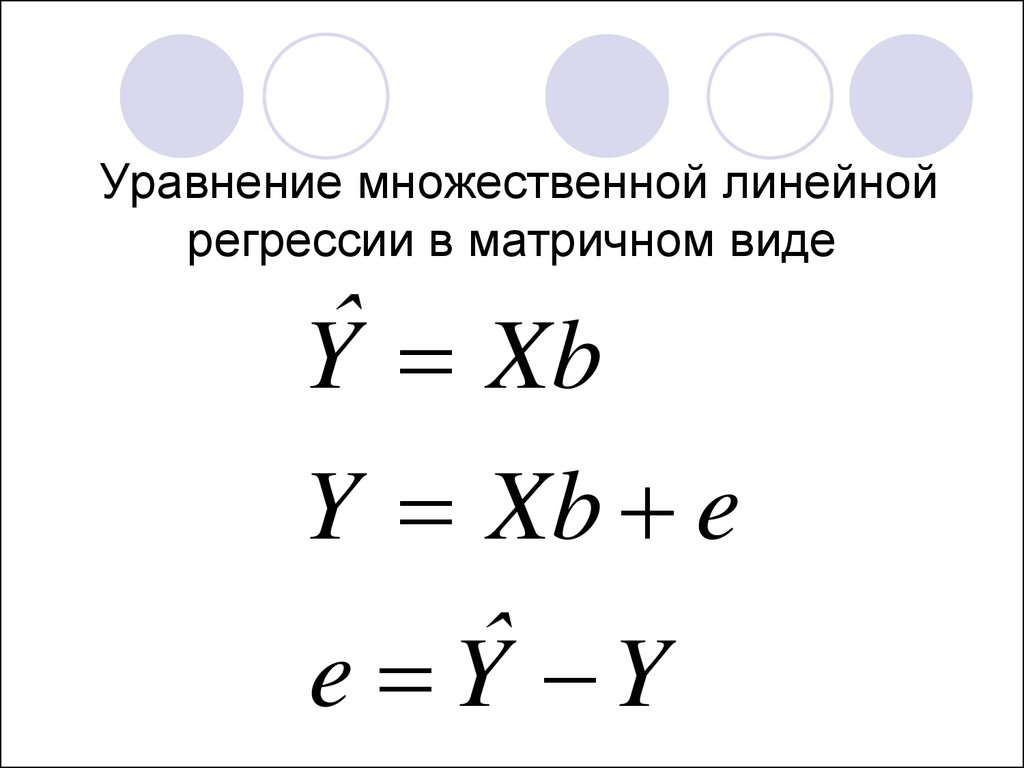

ˆY Xb

Y Xb e

ˆ

e Y Y

10. Метод наименьших квадратов

1b ( X X ) X Y

T

T

11. Условия теоремы Гаусса-Маркова

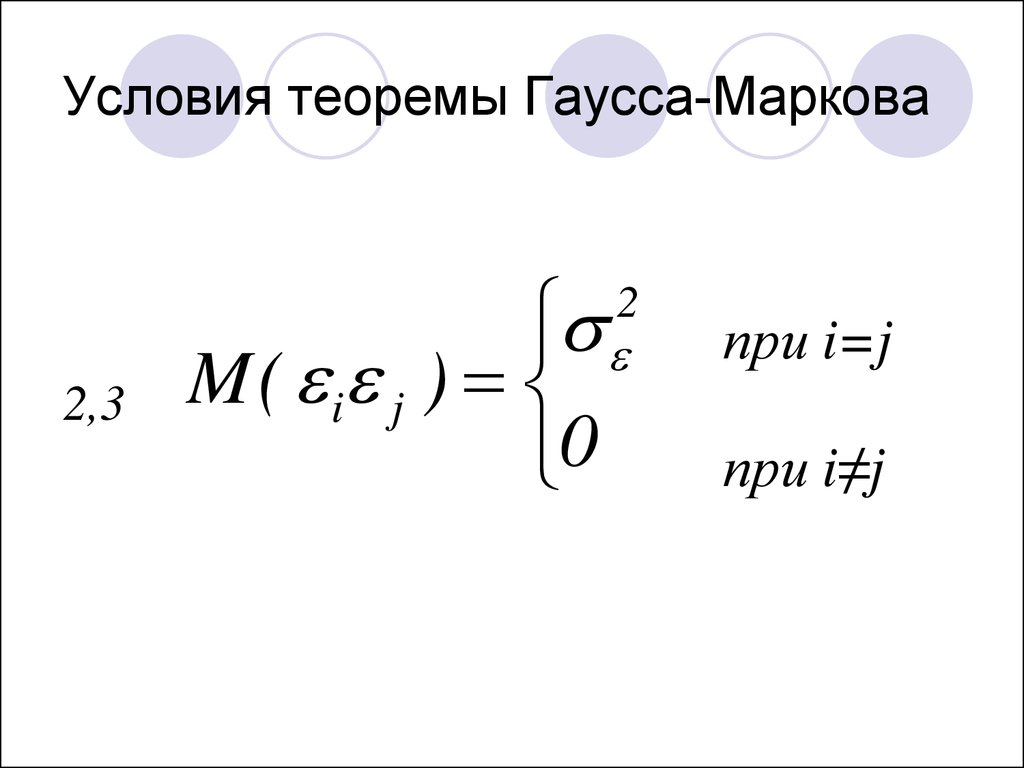

1. M ( i ) 0 ,2

2. M ( i j ) ,

3. M ( i j ) 0 ,

4. M ( xi i ) 0 ,

i=1,…,n

при i=j

при i≠j

i=1,…,n

N ( 0 , )

2

12.

ГомоскедастичностьГетероскедастичность

13. Условия теоремы Гаусса-Маркова

M ( i j )0

2

2,3

при i=j

при i≠j

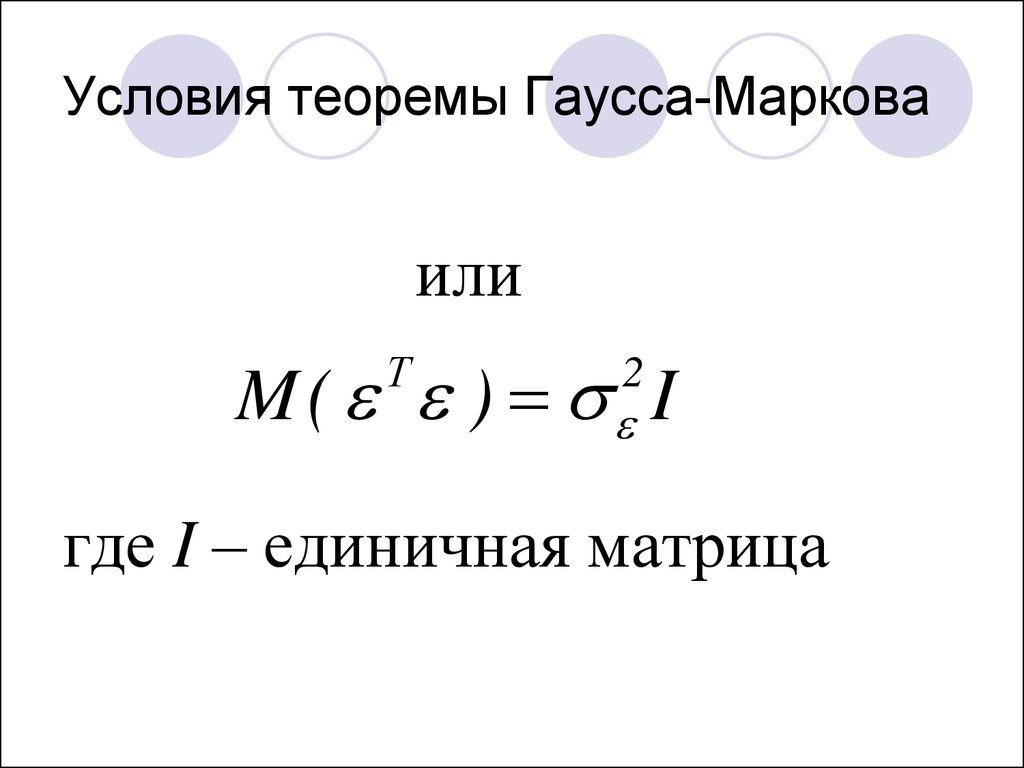

14. Условия теоремы Гаусса-Маркова

илиM ( ) I

Т

2

где I – единичная матрица

15. Мультиколлинеарность

Способы выявления иустранения

16. Признаки наличия мультиколлинеарности

1. Небольшое изменениеисходных данных сильно

изменяет значения оценок

коэффициентов

17. Признаки наличия мультиколлинеарности

2. Стандартные ошибкикоэффициентов очень

велики (коэффициенты

стат. незначимы), а

модель в целом

статистически значима

18. Признаки наличия мультиколлинеарности

3. Значения коэффициентовнеправильны с точки

зрения экономической

теории

19. Способы выявления мультиколлинеарности:

1. Вычисление матрицы парныхкоэффициентов корреляции

для всех объясняющих

переменных.

2. Расчет фактора инфляции

вариации VIF (variance inflation

factor).

20. Матрица парных коэффициентов корреляции

X1X2

X3

X1

1

0,9

0,7

X2

0,9

1

0,3

X3

0,7

0,3

1

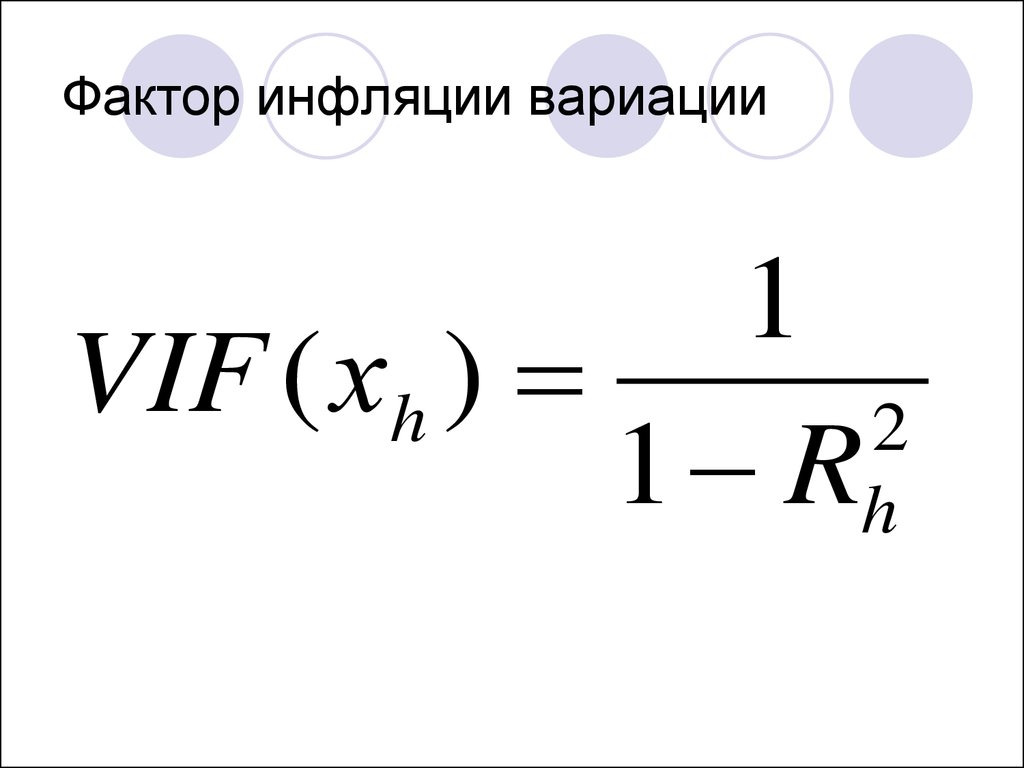

21. Фактор инфляции вариации

1VIF ( хh )

2

1 Rh

22.

VIF0,9

1

R2

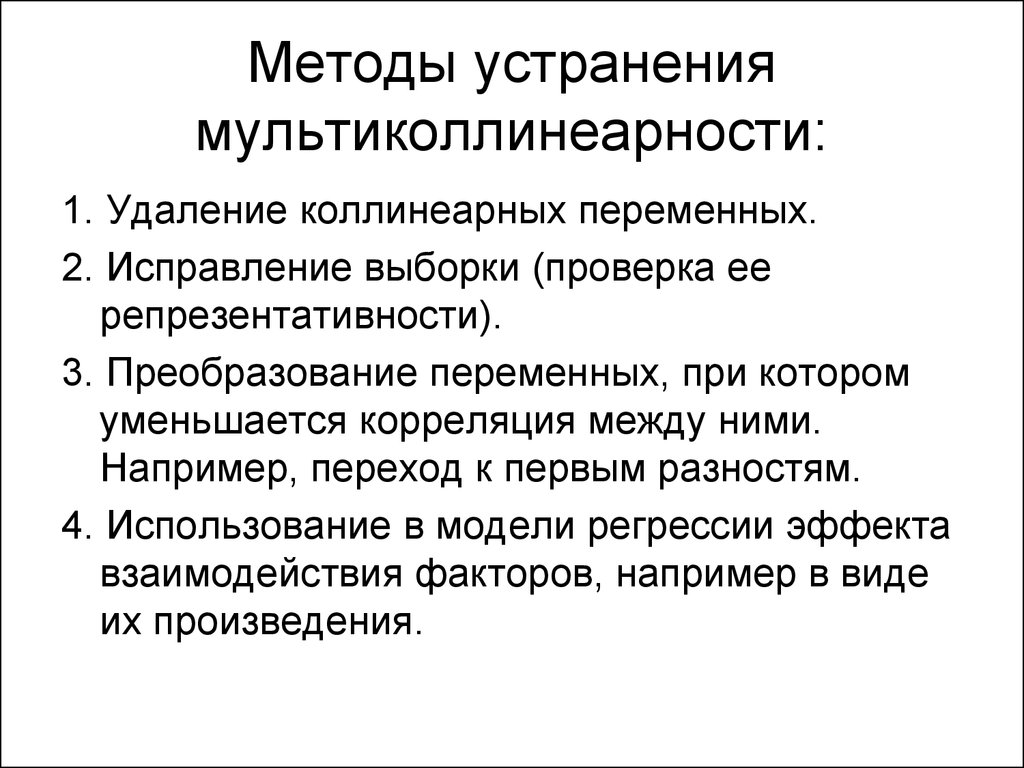

23. Методы устранения мультиколлинеарности:

1. Удаление коллинеарных переменных.2. Исправление выборки (проверка ее

репрезентативности).

3. Преобразование переменных, при котором

уменьшается корреляция между ними.

Например, переход к первым разностям.

4. Использование в модели регрессии эффекта

взаимодействия факторов, например в виде

их произведения.

24. Случай 1. Исключены существенные переменные.

25. Случай 2. Включены несущественные переменные.

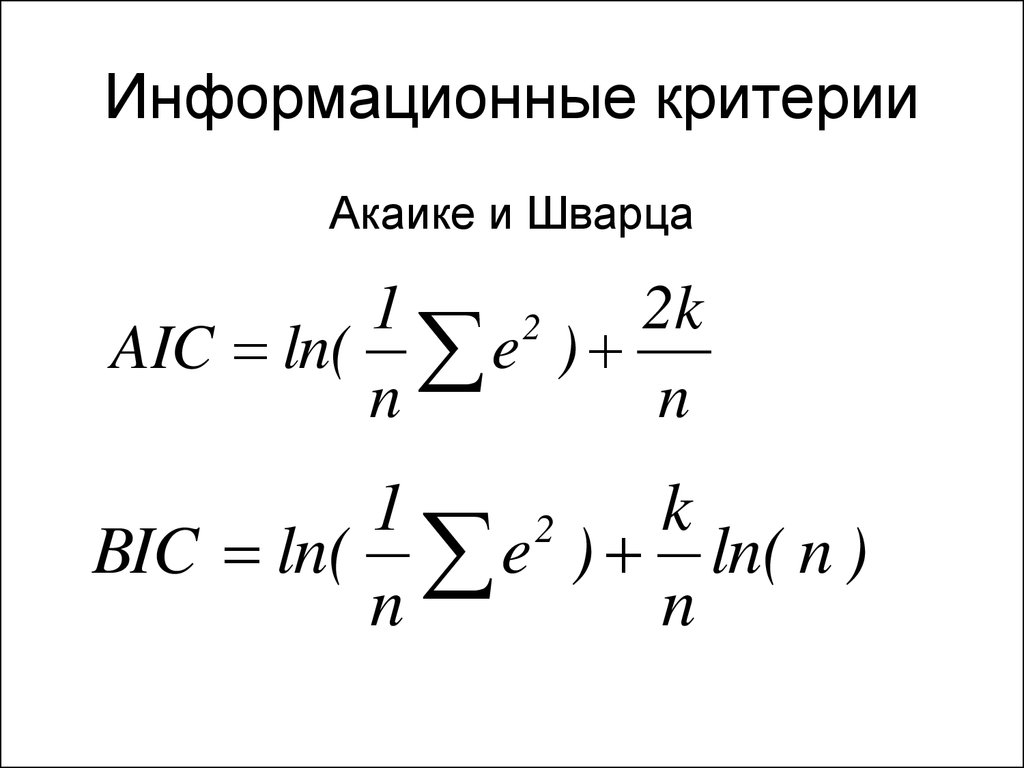

26. Информационные критерии

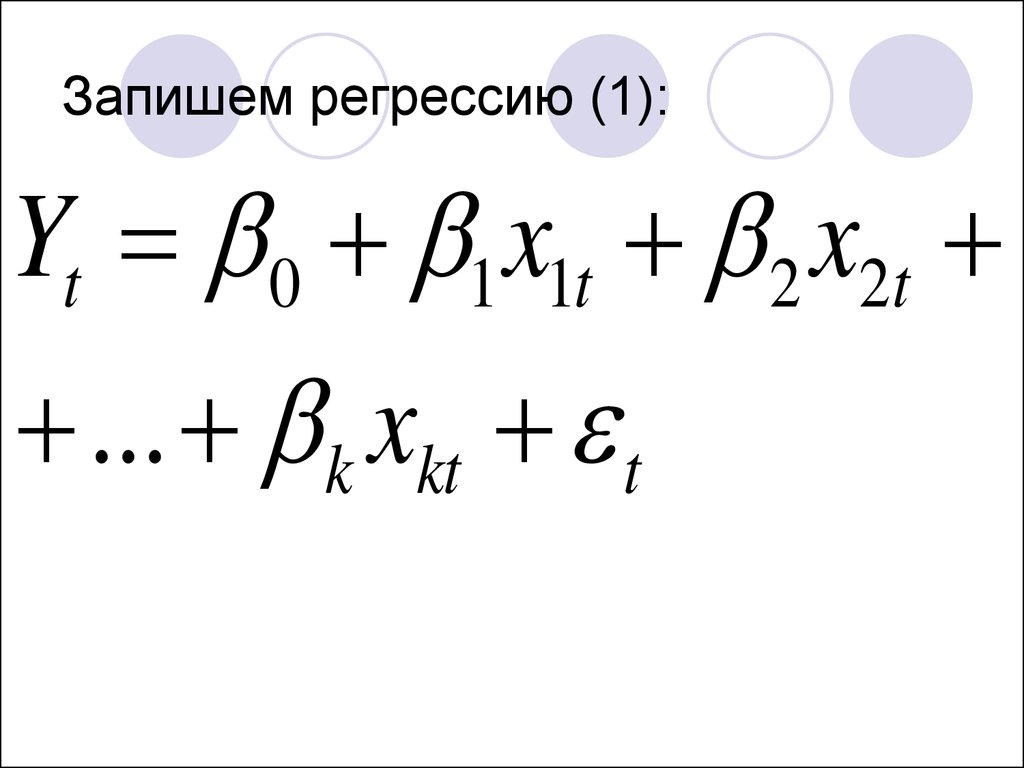

Акаике и Шварца1

2k

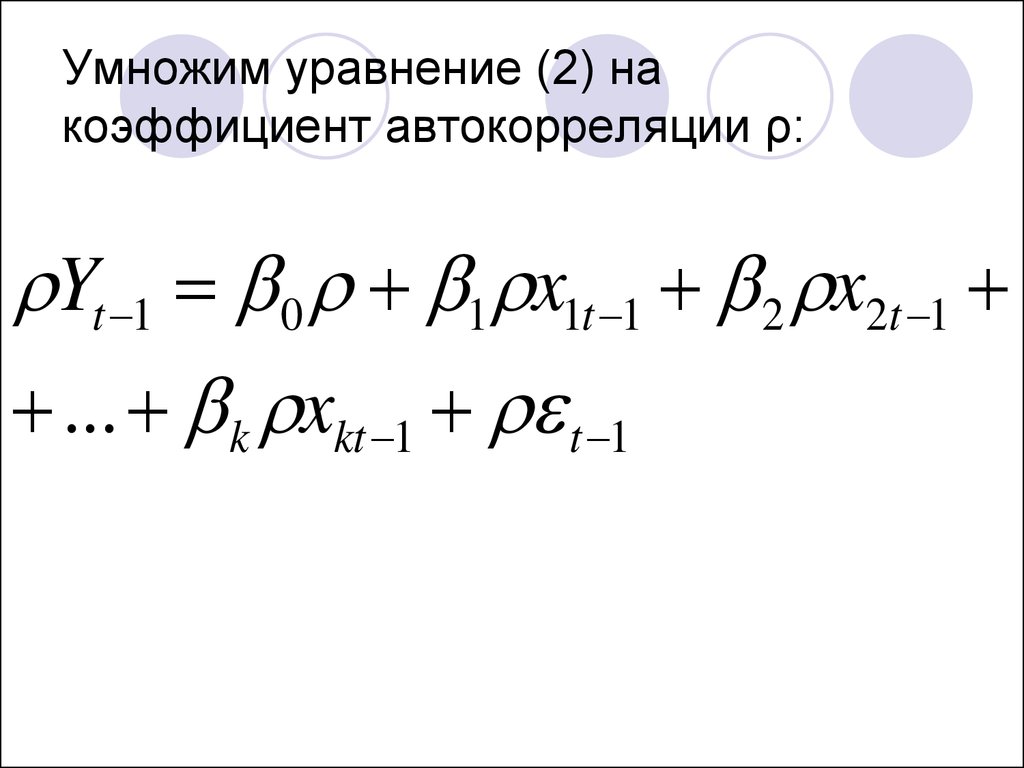

2

AIC ln( e )

n

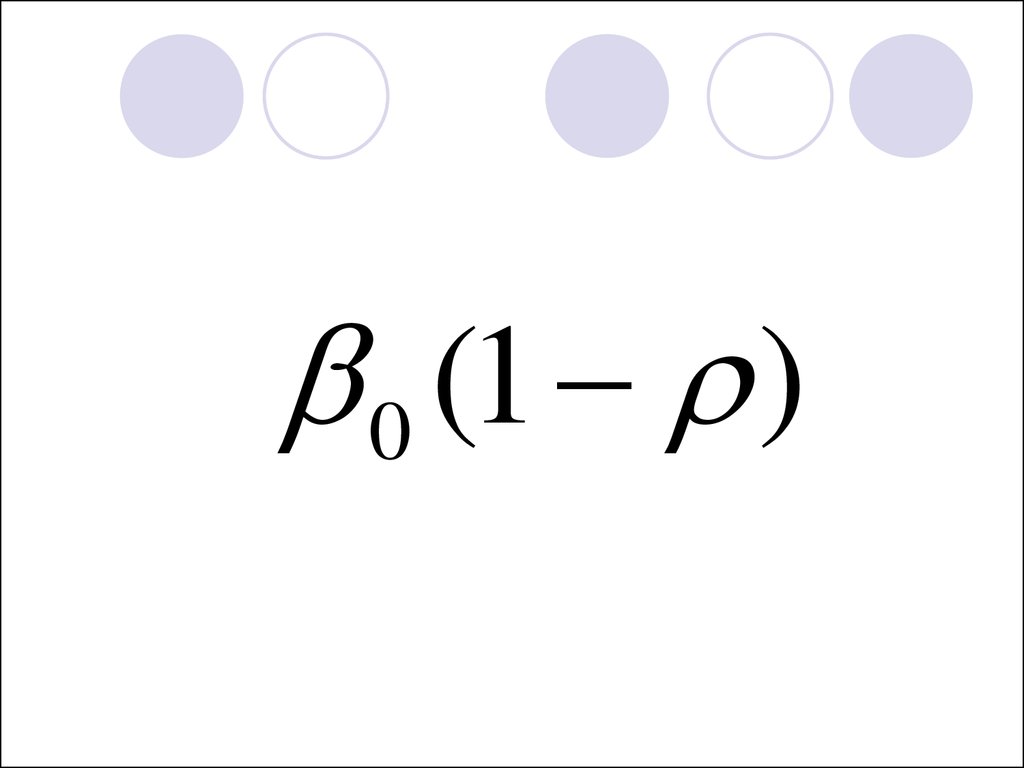

n

1

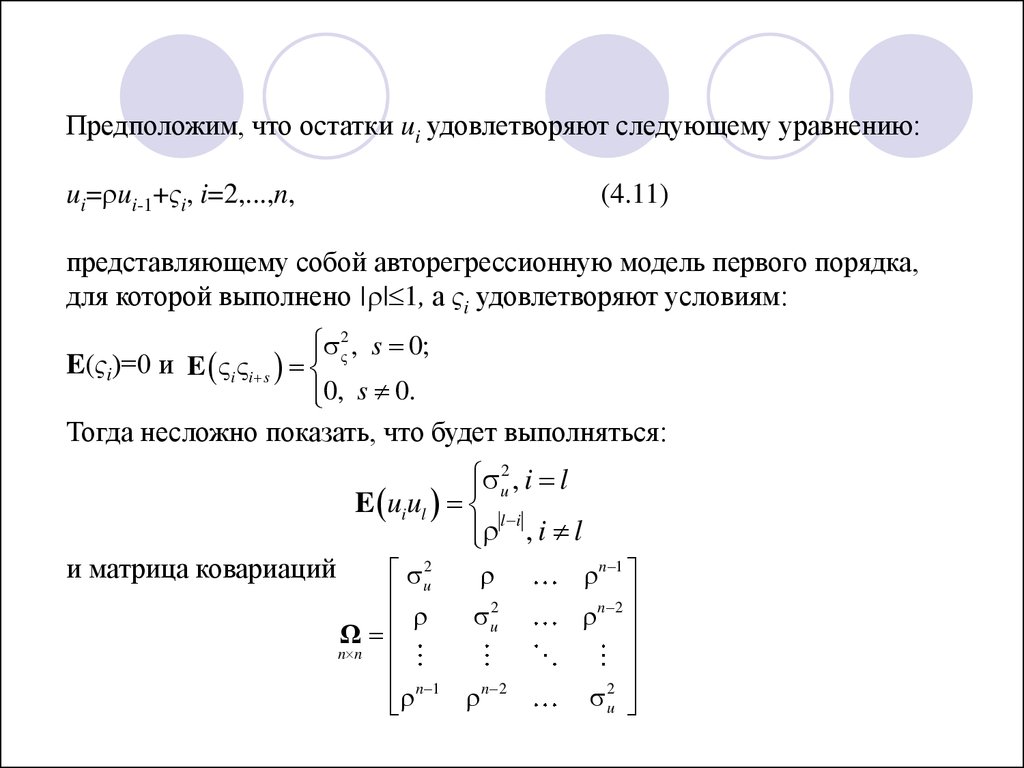

k

2

BIC ln( e ) ln( n )

n

n

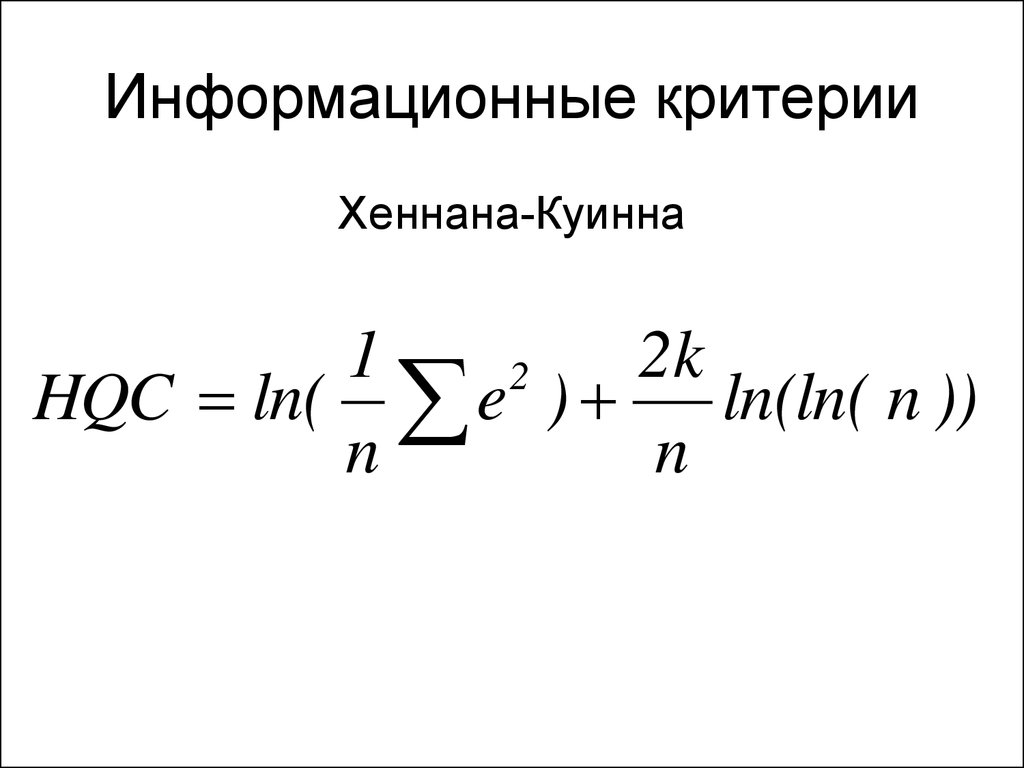

27. Информационные критерии

Хеннана-Куинна1

2k

2

HQC ln( e )

ln(ln( n ))

n

n

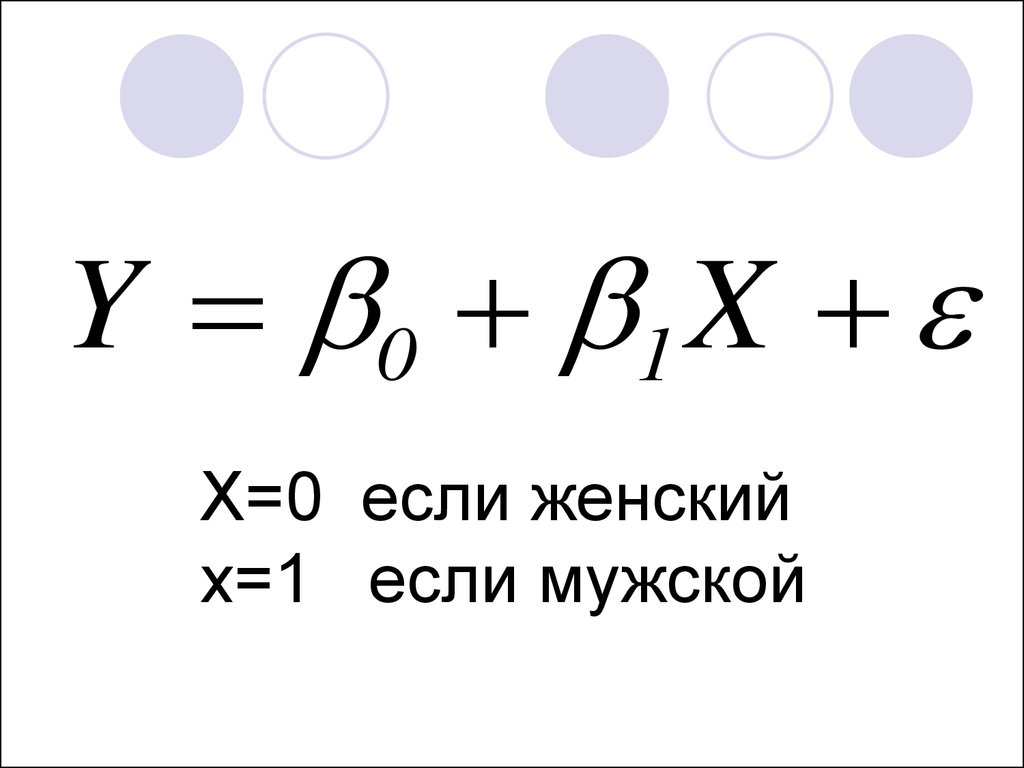

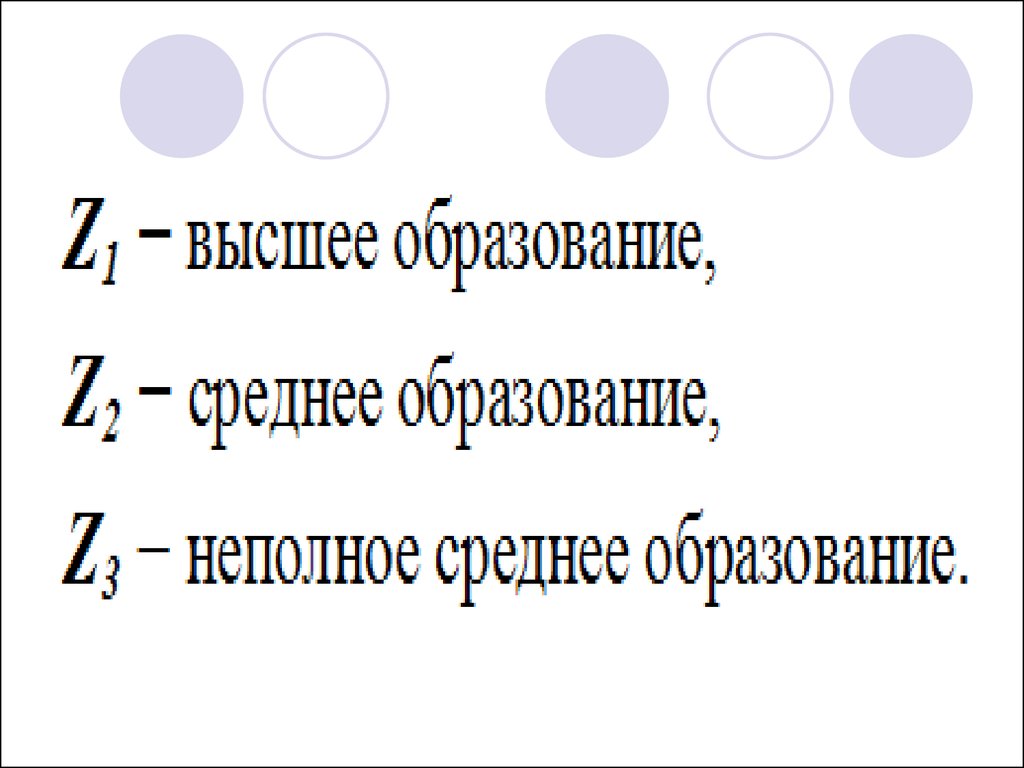

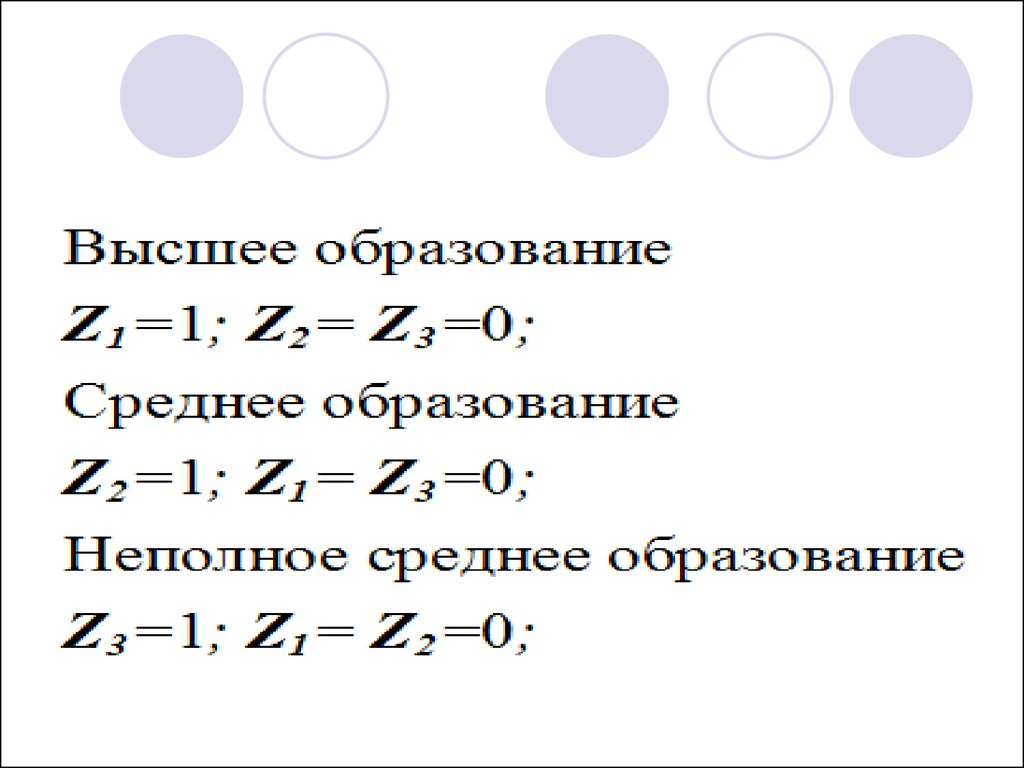

28. Фиктивные переменные в регрессионных моделях

dummy29.

Y 0 1 XX=0 если женский

x=1 если мужской

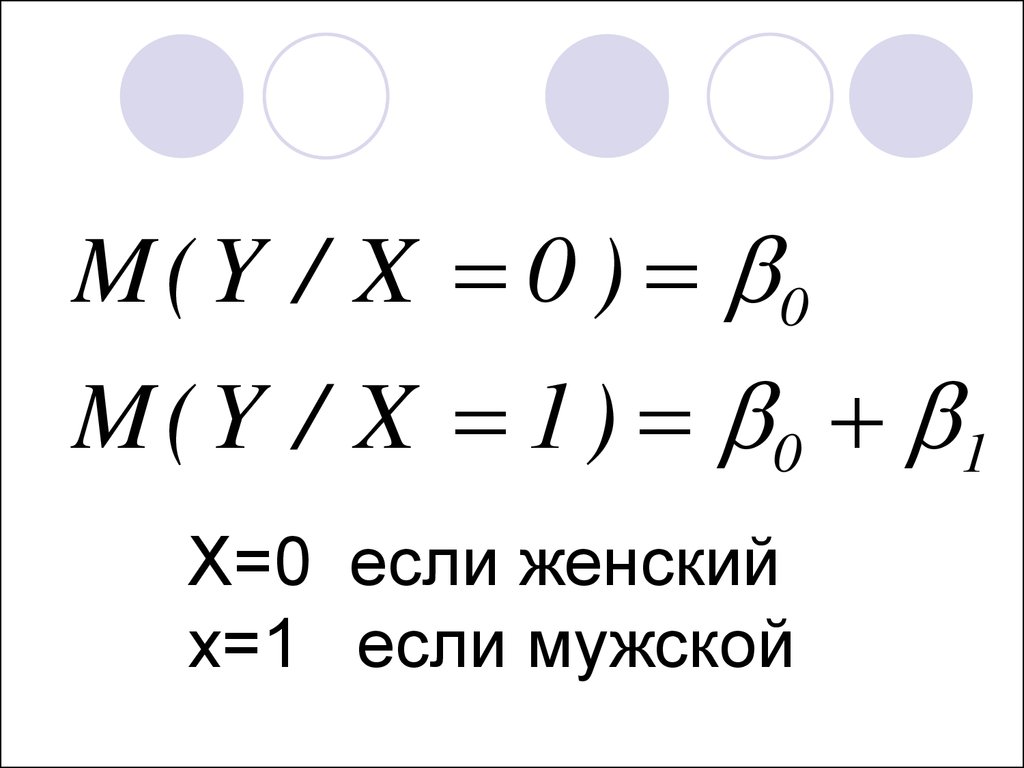

30.

M ( Y / X 0 ) 0M ( Y / X 1 ) 0 1

X=0 если женский

x=1 если мужской

31.

ˆ x 25 5 xy

X=0 если женский

x=1 если мужской

32.

33.

34.

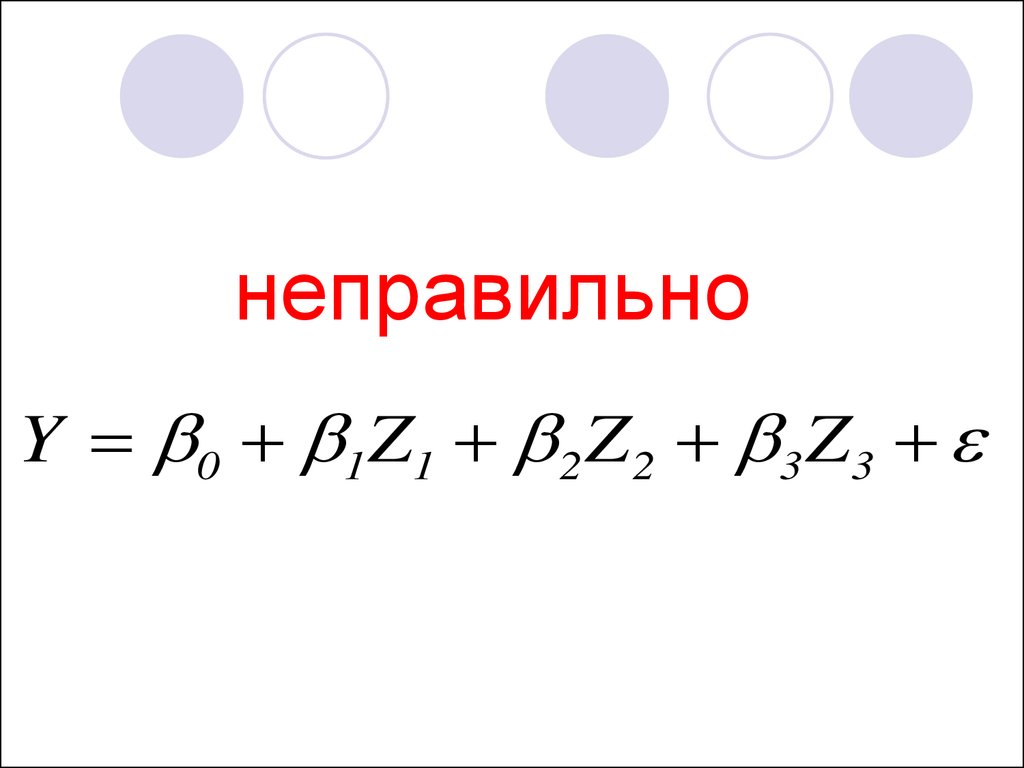

неправильноY 0 1 Z 1 2 Z 2 3 Z 3

35.

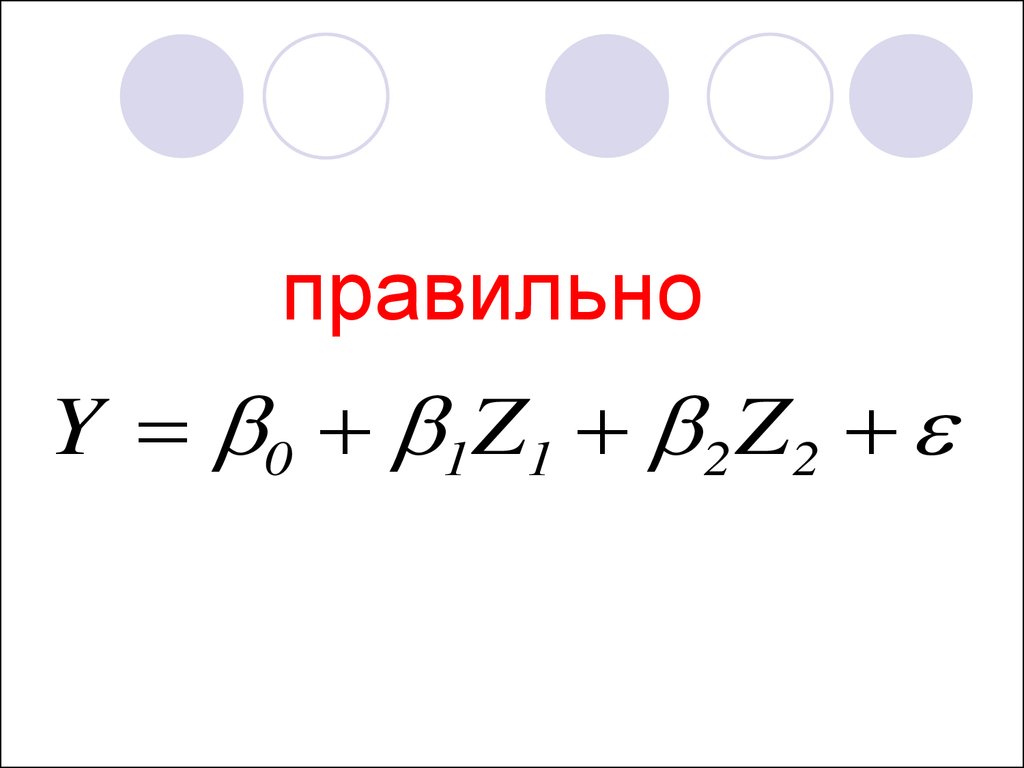

правильноY 0 1 Z 1 2 Z 2

36.

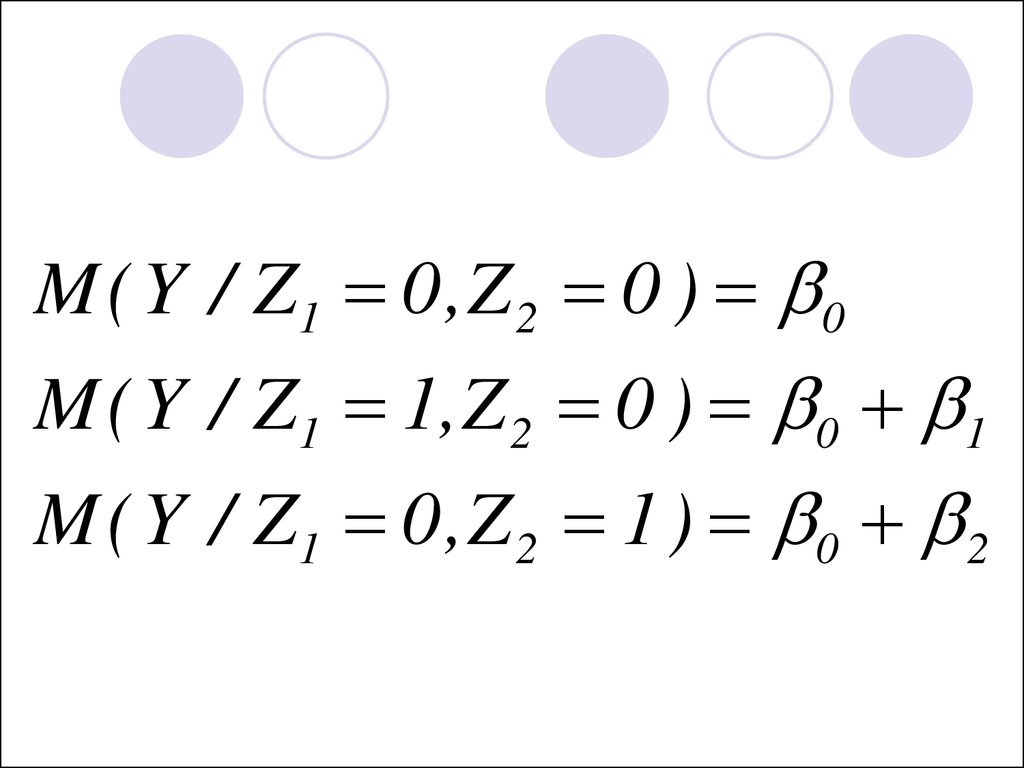

M ( Y / Z1 0 , Z 2 0 ) 0M ( Y / Z1 1, Z 2 0 ) 0 1

M ( Y / Z1 0 , Z 2 1 ) 0 2

37.

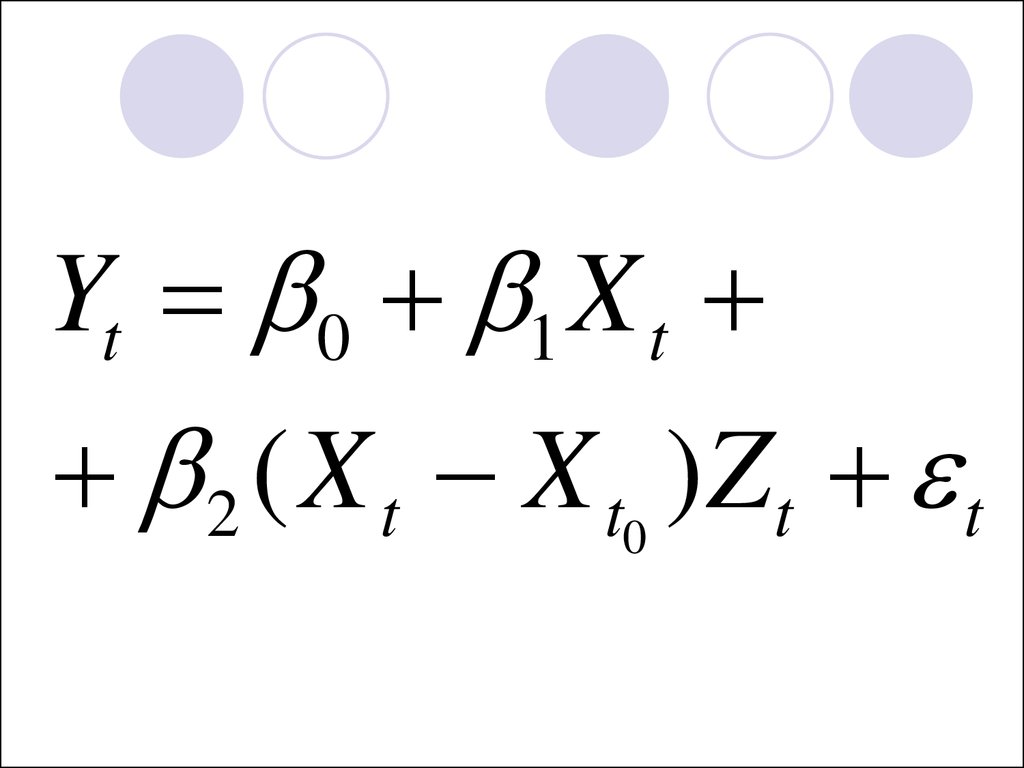

Фиктивные переменные позволяютстроить и оценивать так называемые

кусочно-линейные модели, которые

можно применять для исследования

структурных изменений.

Пусть х и у представлены в виде

временных рядов.

xt – размер ОПФ в период времени t,

уt – объем выпуска продукции в

период времени t.

38.

Пусть в момент времени tо произошли некиеструктурные изменения и линия регрессии будет

отличаться от той, которая была до момента tо.

39.

0, t t0Z

1

,

t

t

0

40.

Yt 0 1 X t2 ( X t X t0 )Zt t

41.

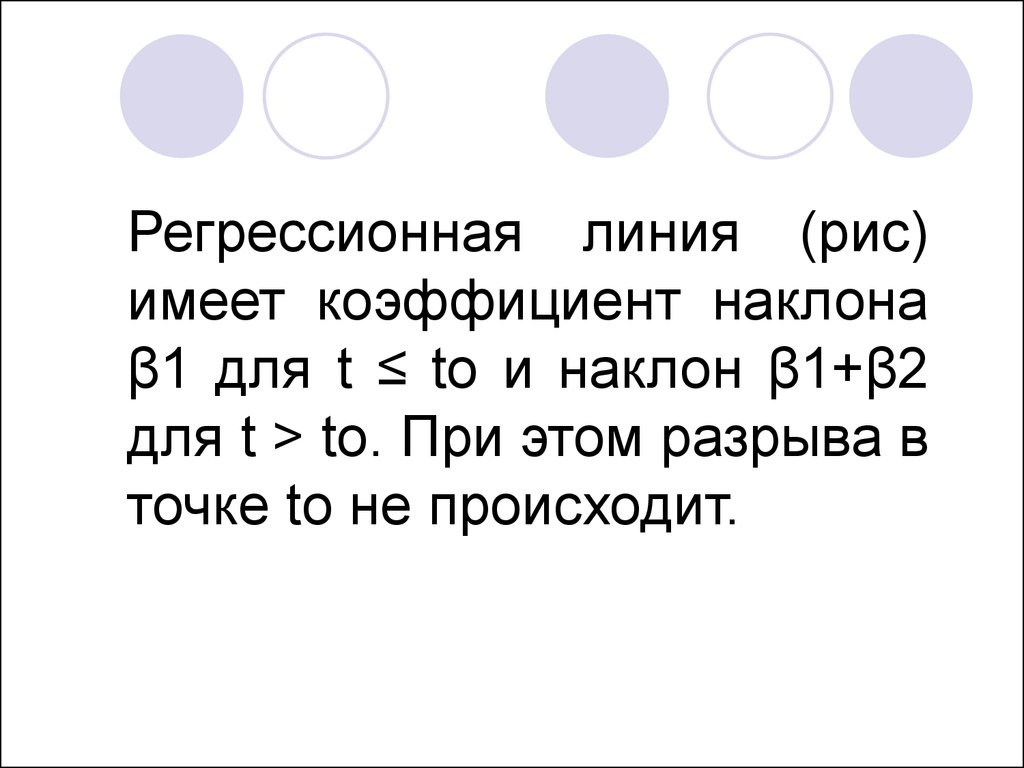

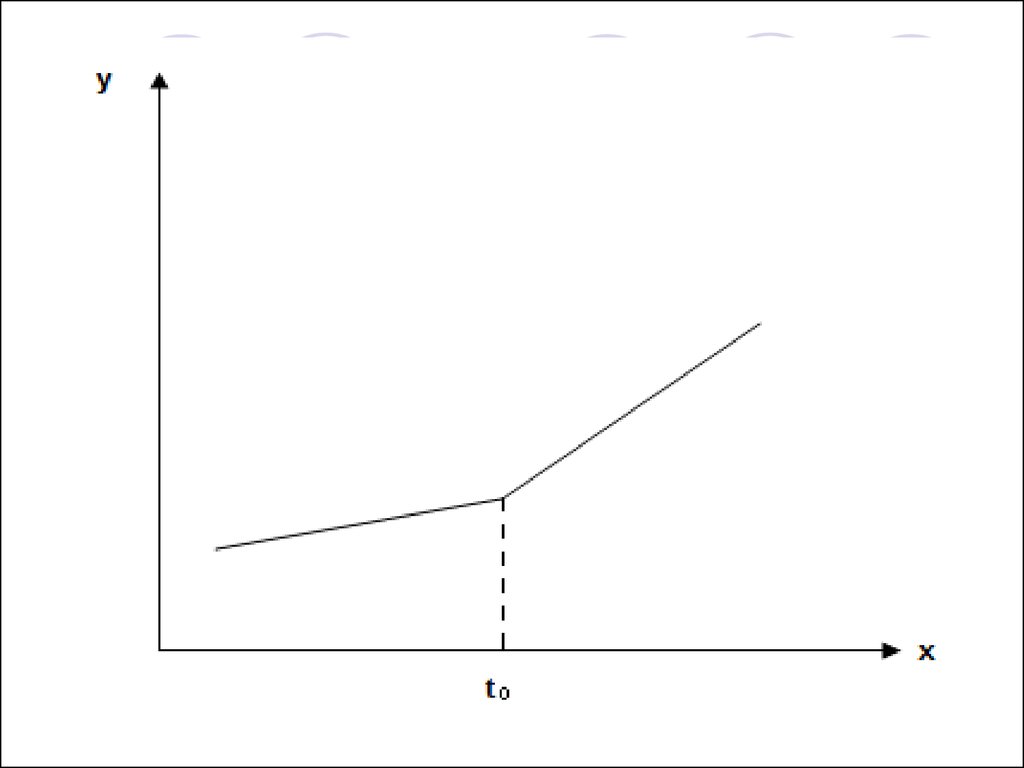

Регрессионная линия (рис)имеет коэффициент наклона

β1 для t ≤ to и наклон β1+β2

для t > to. При этом разрыва в

точке to не происходит.

42.

Тестируя стандартную гипотезуβ2=0

мы

проверяем

предположение о том, что

фактически

структурные

изменения не повлияли на

объем выпуска продукции.

43.

44. ГЕТЕРОСКЕДАСТИЧНОСТЬ ОСТАТКОВ

45. Гомоскедастичность

M ( i j ) const , при i=j2

46. Гетероскедастичность

M ( i j ) const , при i=j2

i

47. Последствия гетероскедастичности

Основное последствиегетероскедастичности заключается в

получении неэффективных оценок

параметров модели регрессии, что

проявляется в завышении стандартных

ошибок коэффициентов регрессии,

занижении t-статистики и, как следствие,

неправильном представлении о

надежности оценок.

48. Способы обнаружения гетероскедастичности

ГрафикиТесты

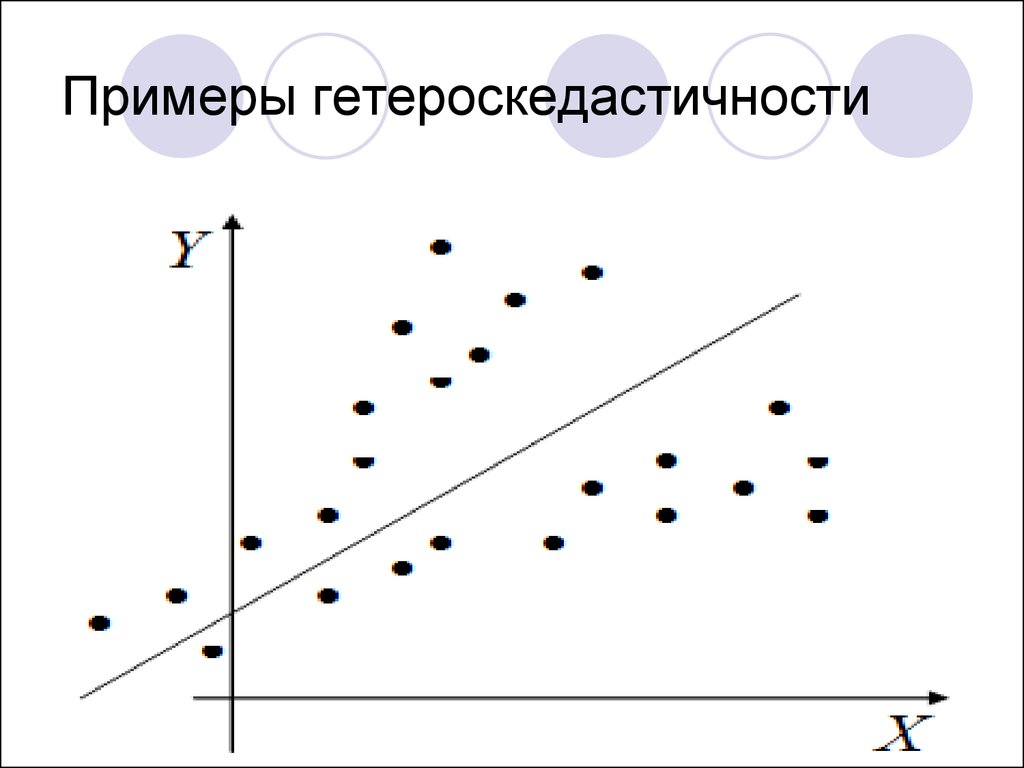

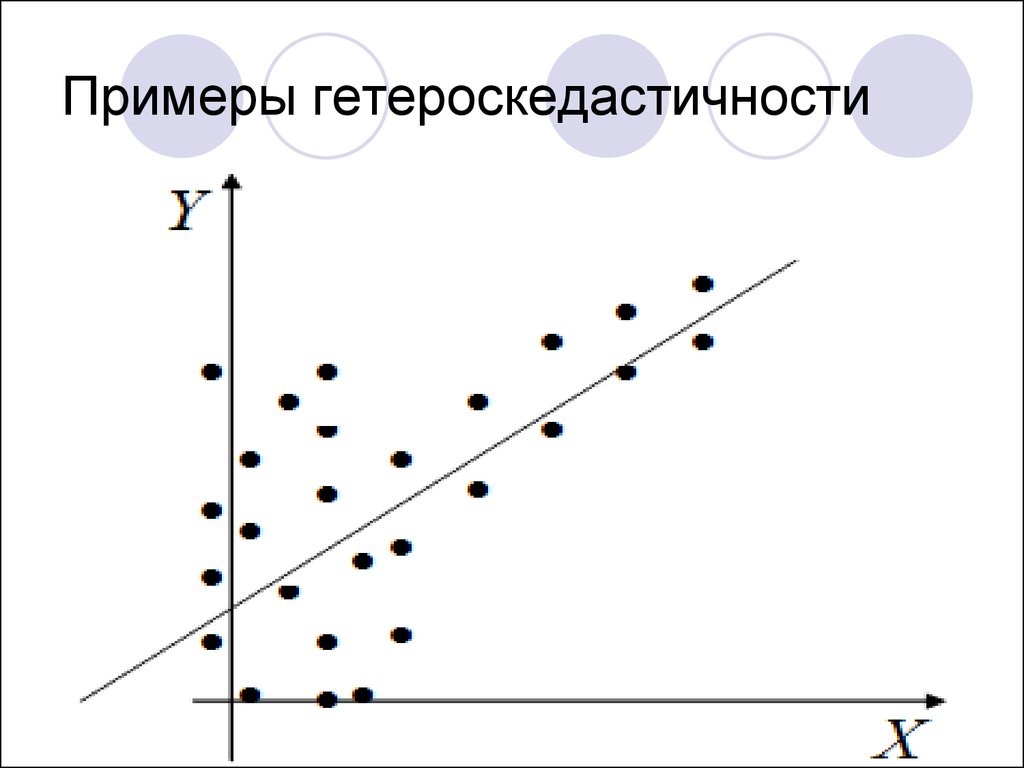

49. Примеры гетероскедастичности

50. Примеры гетероскедастичности

51. Примеры гетероскедастичности

52. Тесты на гетероскедастичность

1. Бартлетта2. Голдфелда-Квандта

3. Уайта

4. Бреуша-Пагана

5. Глейзера

53. Остатки:

ei yi yˆ i54. Вне зависимости от используемых тестов необходимо сформулировать гипотезы:

H 0 : M ( i j ) const , при i=jостатки гомоскедастичны

2

H1 : M ( i j ) i const , при i=j

остатки гетероскедастичны

2

55. Тест Голдфелда-Куандта.

1. Упорядочить наблюденияпо убыванию той

независимой переменной,

относительно которой есть

подозрение на

гетероскедастичность.

56. Тест Голдфелда-Куандта.

2. Опустить v наблюдений,оказавшихся в центре (v

должно быть примерно

равно четверти общего

количества наблюдений n).

57. Тест Голдфелда-Куандта.

3. Оценить отдельнообыкновенным МНК регрессии

на первых (n−v)/2 наблюдениях

и на последних (n−v)/2

наблюдениях при условии, что

(n−v)/2 больше числа

оцениваемых параметров m.

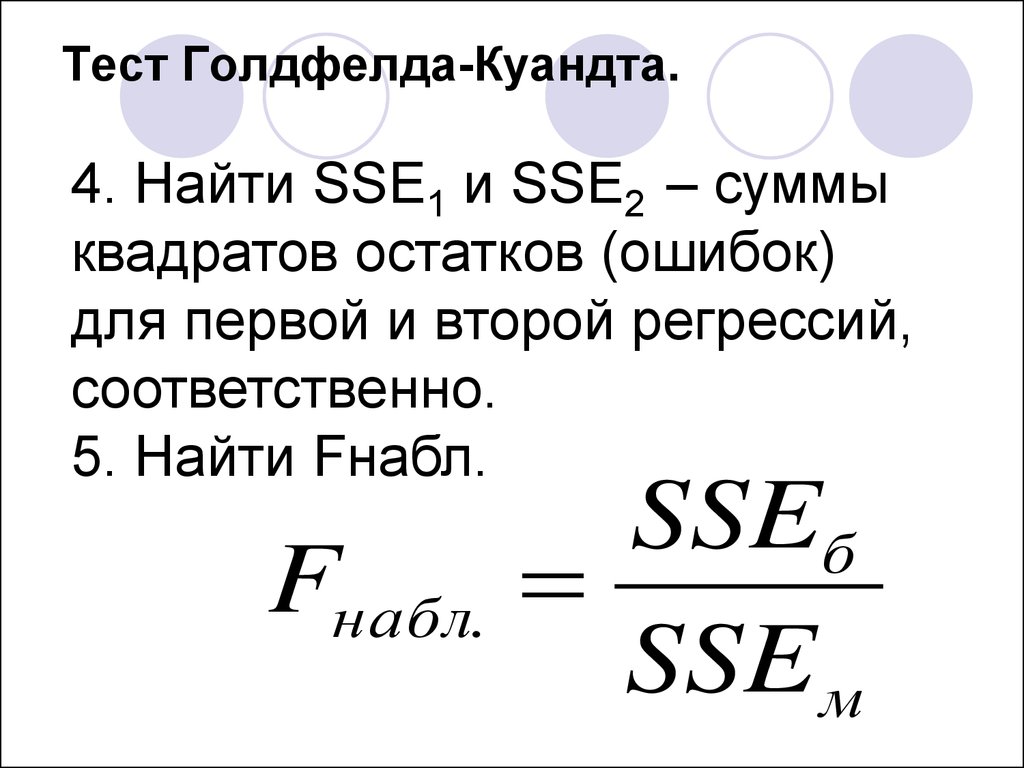

58. Тест Голдфелда-Куандта.

4. Найти SSE1 и SSE2 – суммыквадратов остатков (ошибок)

для первой и второй регрессий,

соответственно.

5. Найти Fнабл.

Fнабл.

SSEб

SSE м

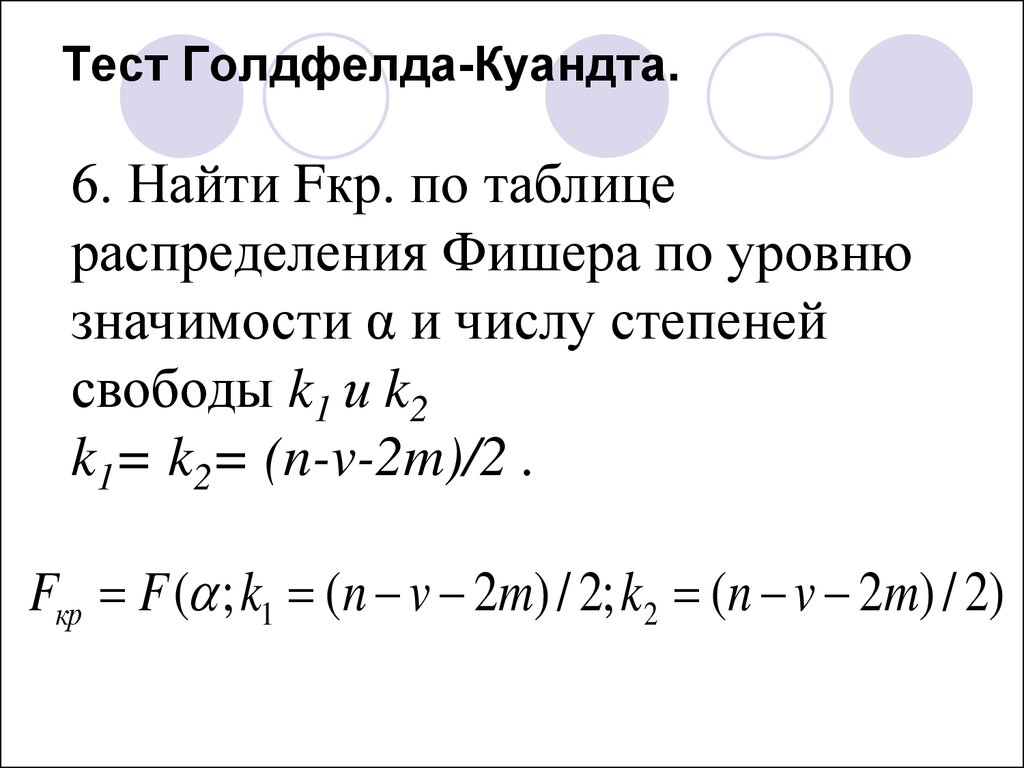

59. Тест Голдфелда-Куандта.

6. Найти Fкр. по таблицераспределения Фишера по уровню

значимости α и числу степеней

свободы k1 и k2

k1= k2= (n-v-2m)/2 .

Fкр F ( ; k1 (n v 2m) / 2; k2 (n v 2m) / 2)

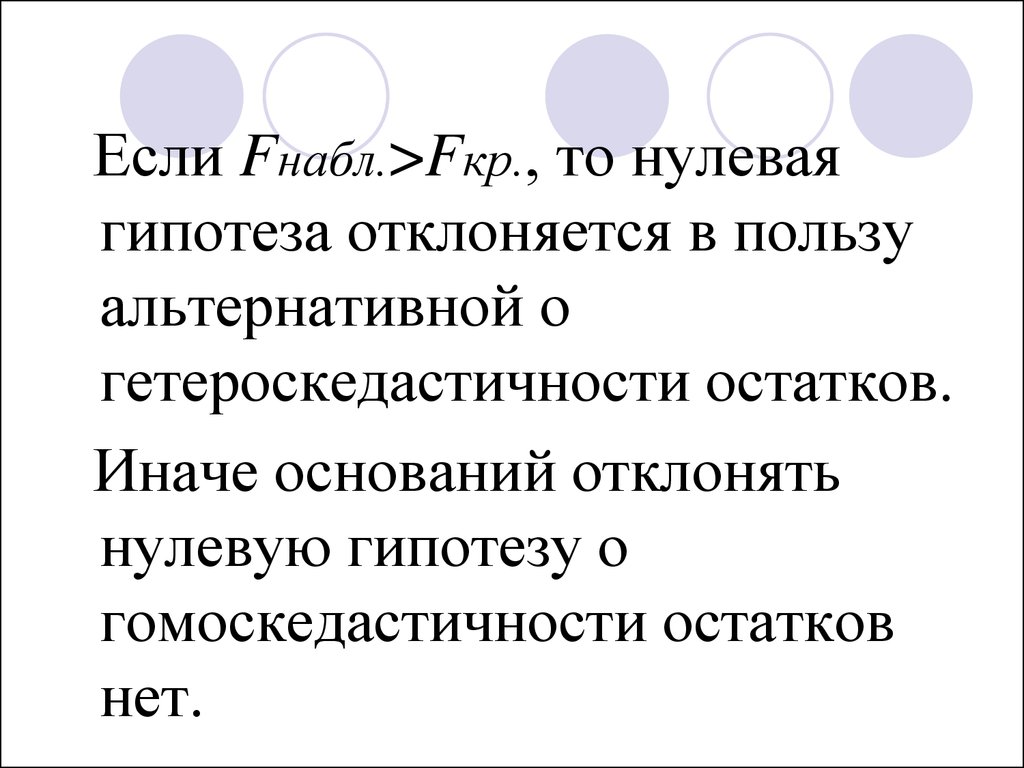

60.

Если Fнабл.>Fкр., то нулеваягипотеза отклоняется в пользу

альтернативной о

гетероскедастичности остатков.

Иначе оснований отклонять

нулевую гипотезу о

гомоскедастичности остатков

нет.

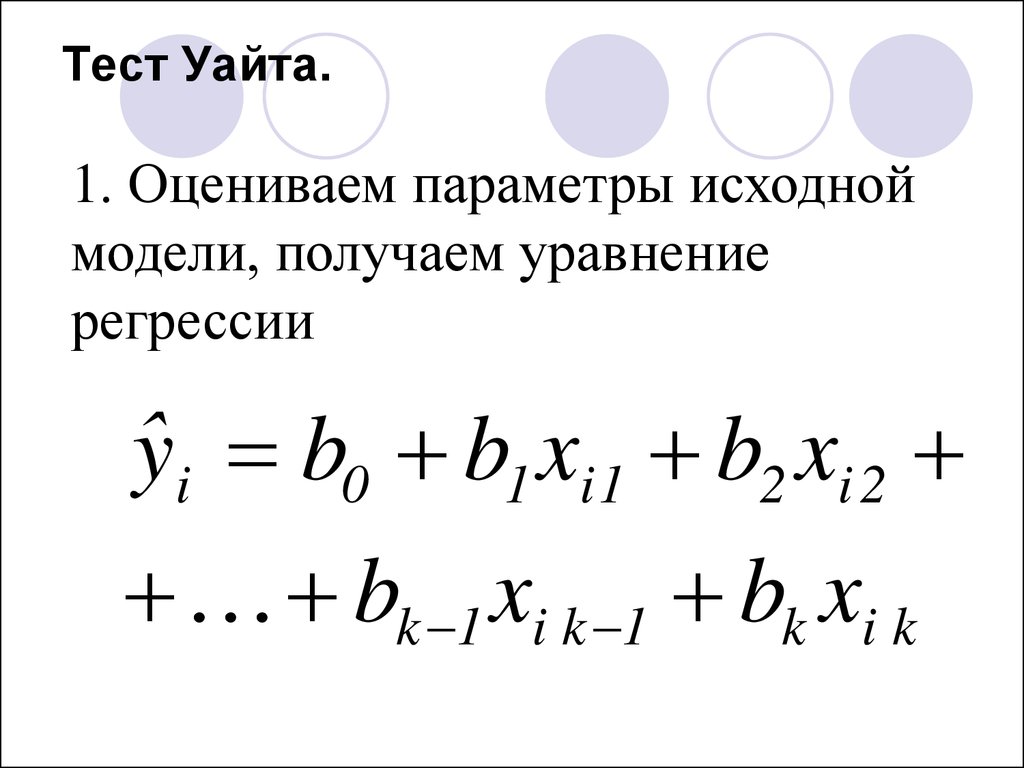

61. Тест Уайта.

1. Оцениваем параметры исходноймодели, получаем уравнение

регрессии

ˆyi b0 b1 xi 1 b2 xi 2

bk 1 xi k 1 bk xi k

62. Тест Уайта.

2. Находим остаткиei yi yˆ i

3. Находим квадраты остатков

2

ei

63. Тест Уайта.

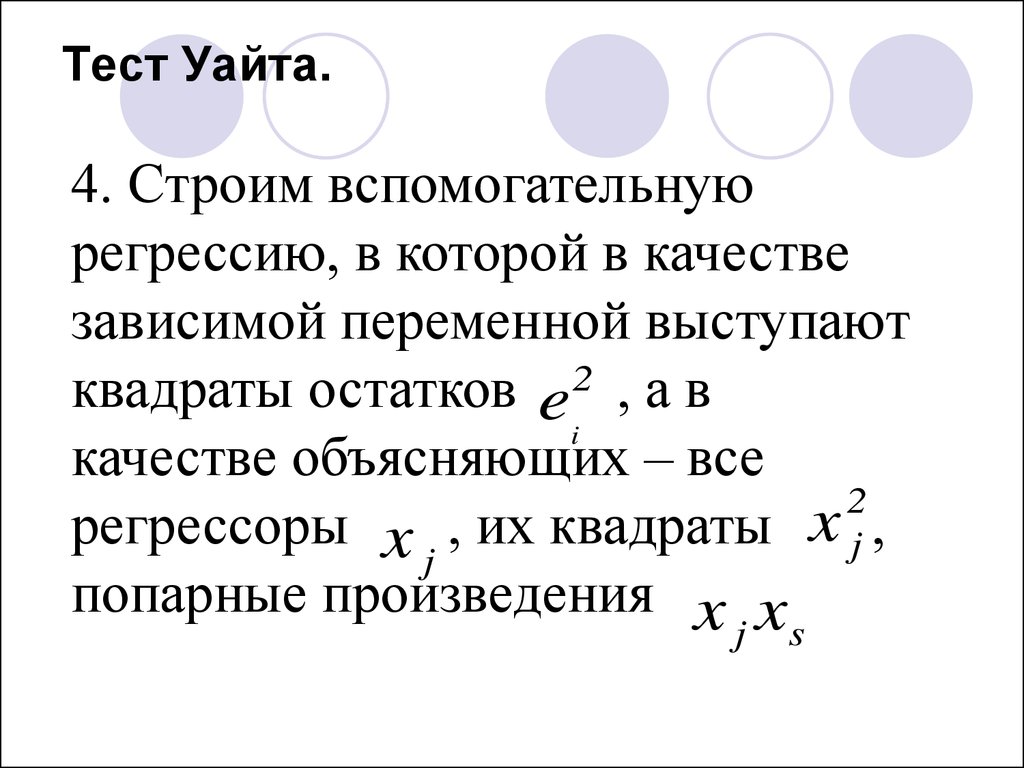

4. Строим вспомогательнуюрегрессию, в которой в качестве

зависимой переменной выступают

квадраты остатков e2 , а в

i

качестве объясняющих – все

2

регрессоры x , их квадраты x j ,

j

попарные произведения x x

j

s

64. Тест Уайта.

Например, для двухфакторноймодели

Y 0 1 X 1 2 X 2

вспомогательная регрессия будет

иметь вид:

e 0 1 x1 2 x2 3 x 1

2

2

4 x 2 5 x1 x2 u

2

65. Тест Уайта.

5. Оцениваем вспомогательнуюрегрессию и находим R2

вспомогательной регрессии.

6. Вычисляем наблюдаемое

значение

2

набл.

nR

2

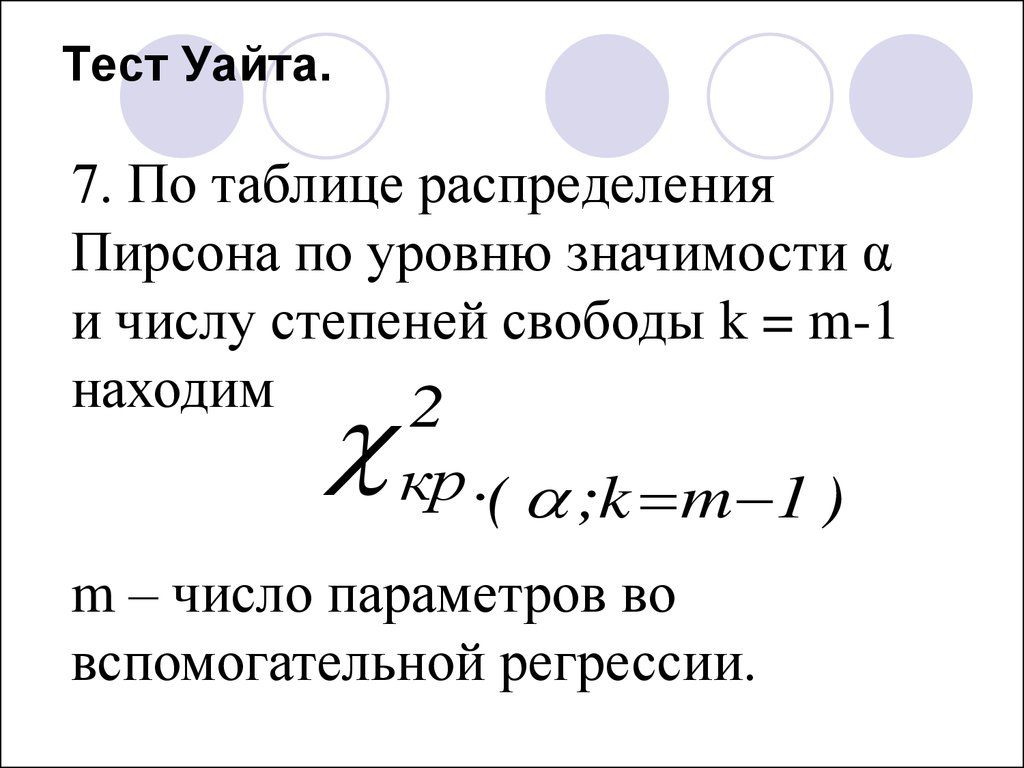

66. Тест Уайта.

7. По таблице распределенияПирсона по уровню значимости α

и числу степеней свободы k = m-1

находим

2

кр .( ;k m 1 )

m – число параметров во

вспомогательной регрессии.

67. Тест Уайта.

8. Сравниваем наблюдаемоеи критическое

2

набл.

2

значения.

кр .

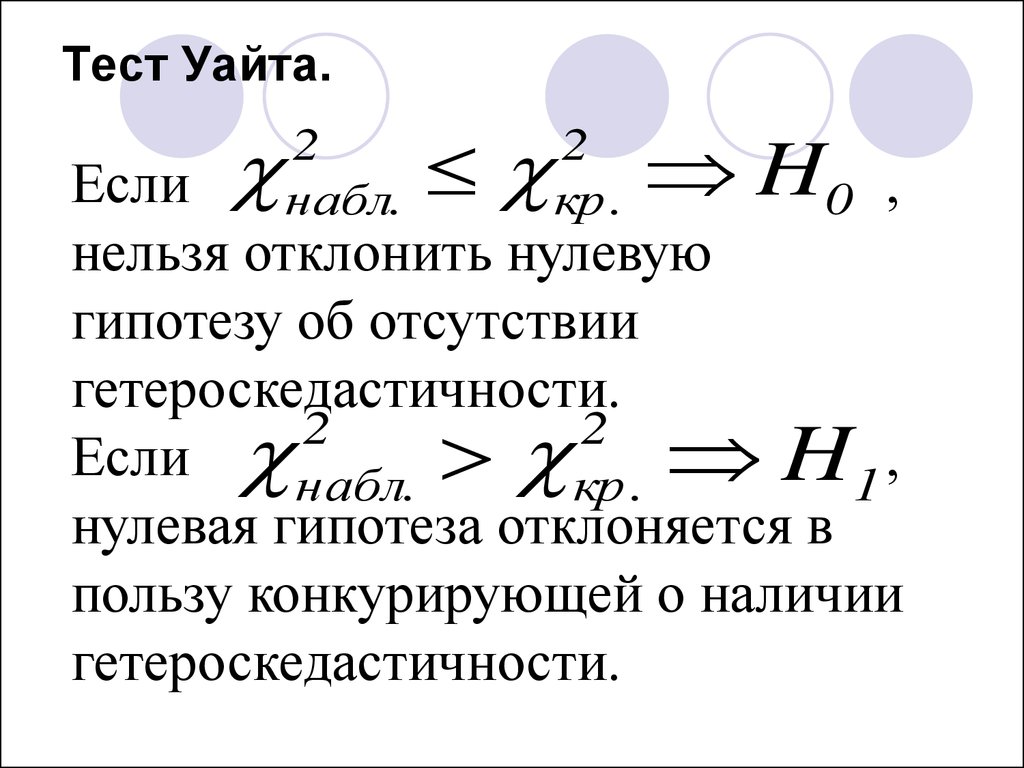

68. Тест Уайта.

H0 ,Если

нельзя отклонить нулевую

гипотезу об отсутствии

гетероскедастичности.

2

2

Если набл. кр . H1 ,

нулевая гипотеза отклоняется в

пользу конкурирующей о наличии

гетероскедастичности.

2

набл.

2

кр .

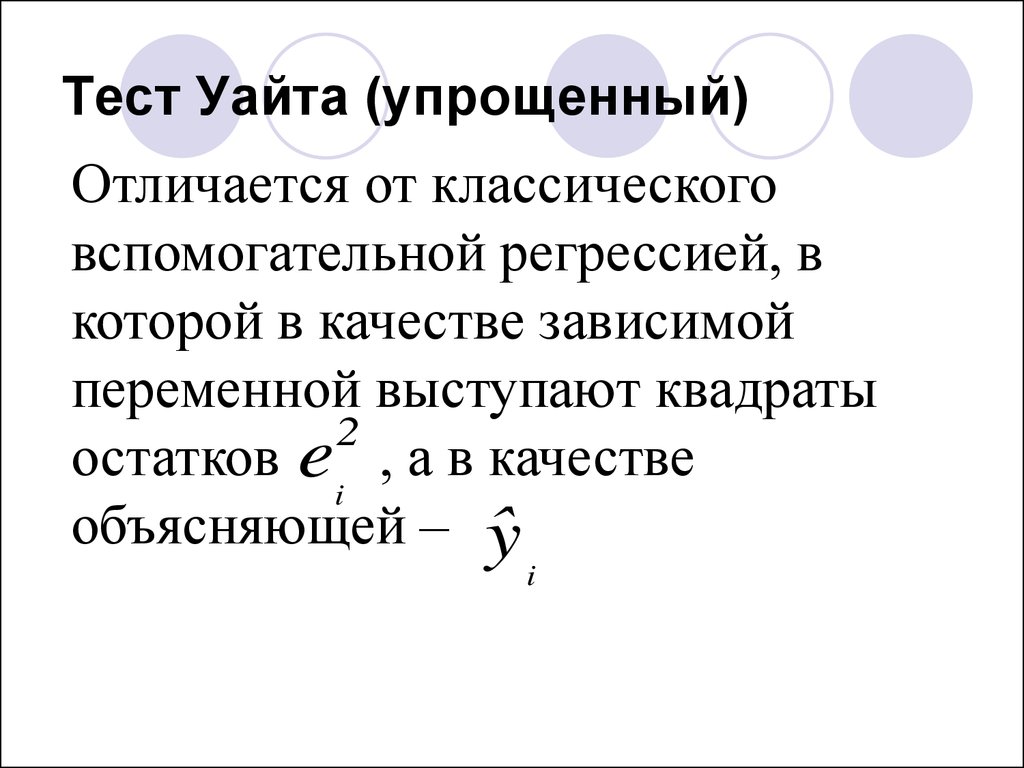

69. Тест Уайта (упрощенный)

Отличается от классическоговспомогательной регрессией, в

которой в качестве зависимой

переменной выступают квадраты

2

остатков e , а в качестве

i

объясняющей – ˆy

i

70. Тест Уайта (упрощенный).

Тогда вспомогательная регрессиябудет иметь вид:

e 0 1 ˆy u

2

71. Тест Уайта (упрощенный).

А число степеней свободы k = 2-1=12

кр .( ;k 2 1 1 )

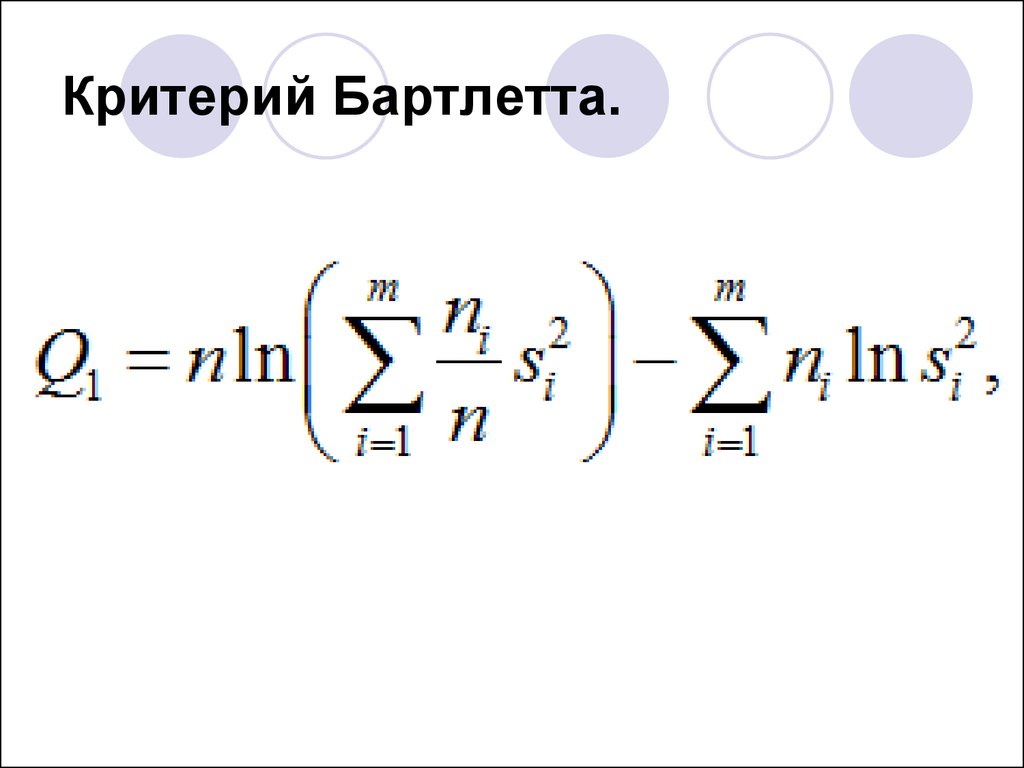

72. Критерий Бартлетта.

73. Критерий Бартлетта.

74.

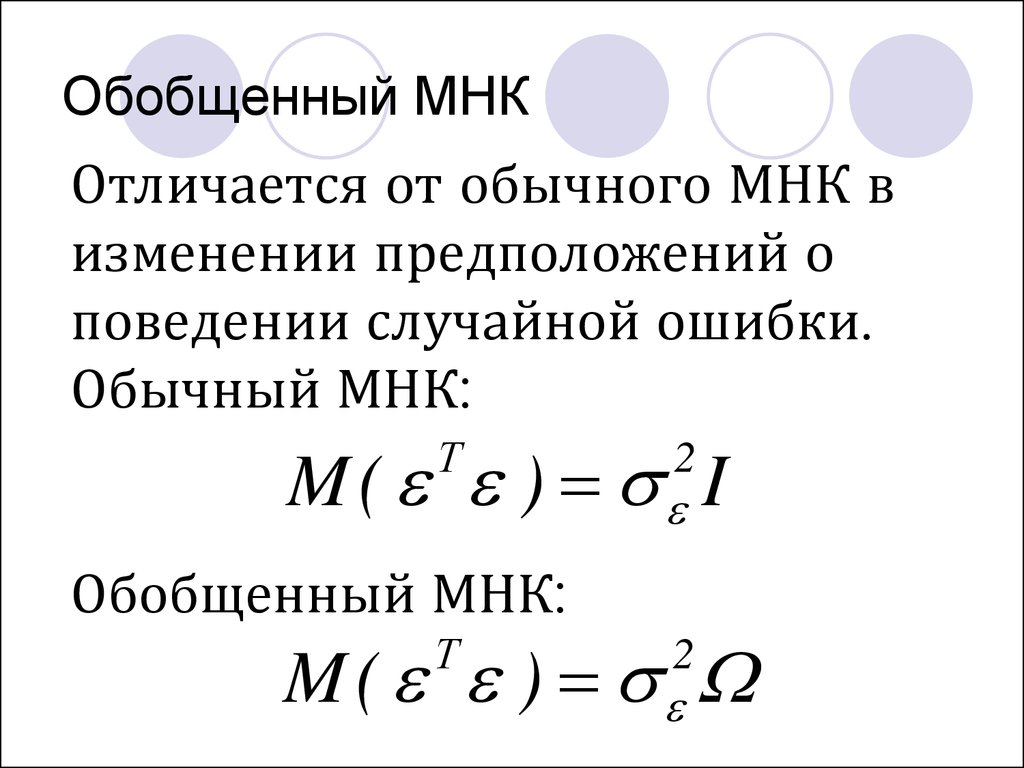

75. Обобщенный МНК

Отличается от обычного МНК визменении предположений о

поведении случайной ошибки.

Обычный МНК:

M ( ) I

Т

2

Обобщенный МНК:

M ( )

Т

2

76. Обобщенный МНК

ИлиОбычный МНК:

i=j

i≠j

M ( i j )

0

2

M ( i j )

Обобщенный МНК:

ij

при

при

2

i

при

77. Обобщенный МНК

Если есть толькогетероскедастичность, то:

Обобщенный МНК:

M ( i j ) const ,

2

i

при i=j

78. Обобщенный МНК

Критерий минимизации суммыквадратов ошибок МНК

заменяется на другой –

минимизация обобщенной

суммы квадратов отклонений (с

учетом ненулевых ковариаций

случайной ошибки для разных

наблюдений и непостоянной

дисперсии ошибки)

79. Обобщенный МНК

Соответственно усложняетсявид системы уравнений для

определения оценок

коэффициентов. ОМНК

позволяет получить линейные

несмещенные оценки

параметров модели регрессии,

которые будут эффективными.

80. Обобщенный МНК

Соответственно усложняетсявид системы уравнений для

определения оценок

коэффициентов. ОМНК

позволяет получить линейные

несмещенные оценки

параметров модели регрессии,

которые будут эффективными.

81. Обобщенный МНК

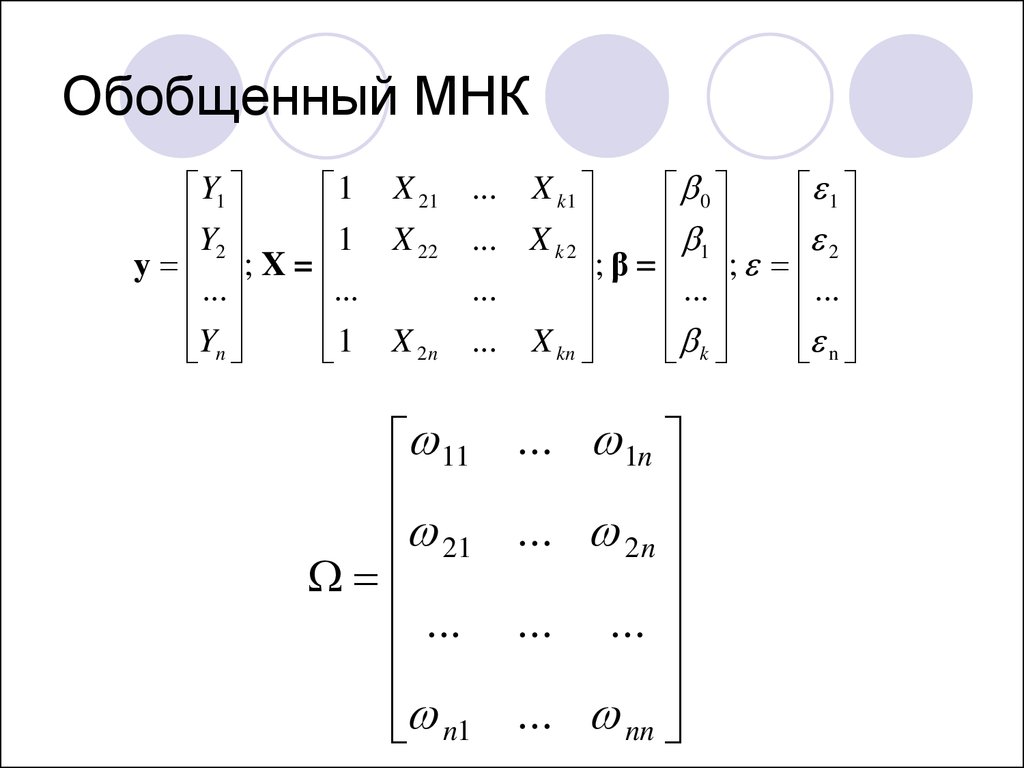

Y11 X 21

Y

1 X

22

y 2 ; X =

...

...

Y

n

1 X 2n

X k1

0

1

... X k 2

; β 1 ; 2

...

...

...

... X kn

n

k

...

11

21

...

n1

... 1n

... 2 n

... ...

... nn

82. Обобщенный МНК

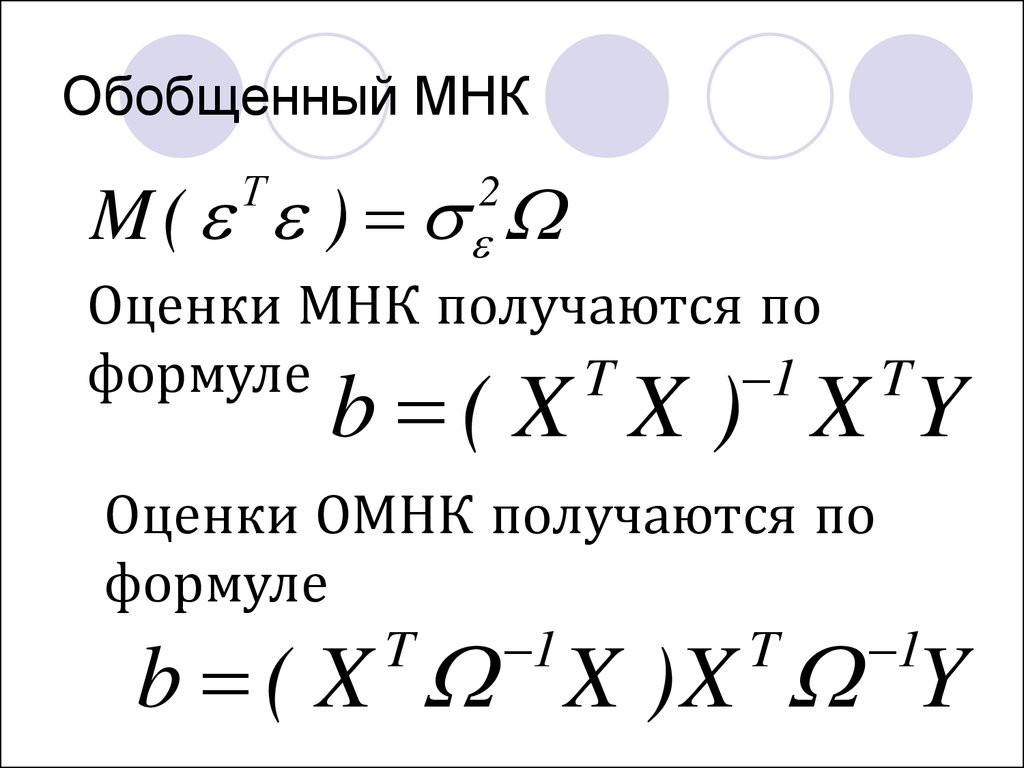

M ( )Т

2

Оценки МНК получаются по

формуле

T

1

b ( X X ) X Y

T

Оценки ОМНК получаются по

формуле

b ( X X )X Y

T

1

T

1

83. Обобщенный МНК

Для применения ОМНКнеобходимо знать элементы

матрицы , что на практике

случается крайне редко.

84. Взвешенный МНК

Предположим, что намизвестны значения величин

,i 1...n.

2

i

Тогда исходную модель

разделим на i:

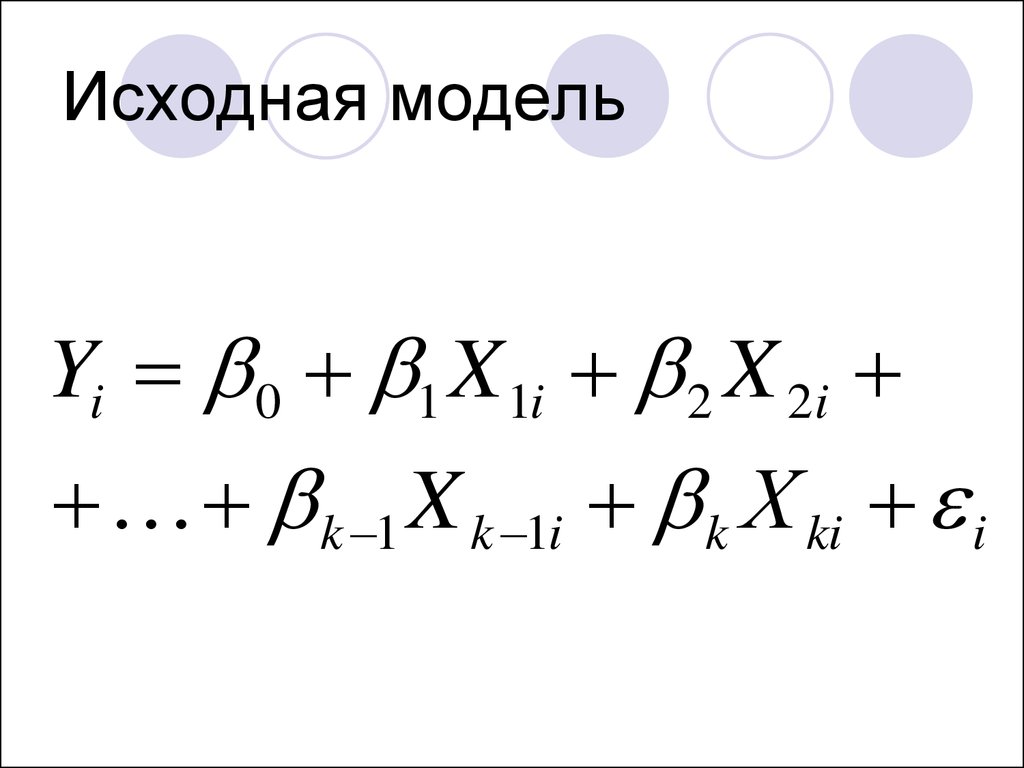

85. Исходная модель

Yi 0 1 X 1i 2 X 2ik 1 X k 1i k Х ki i

86.

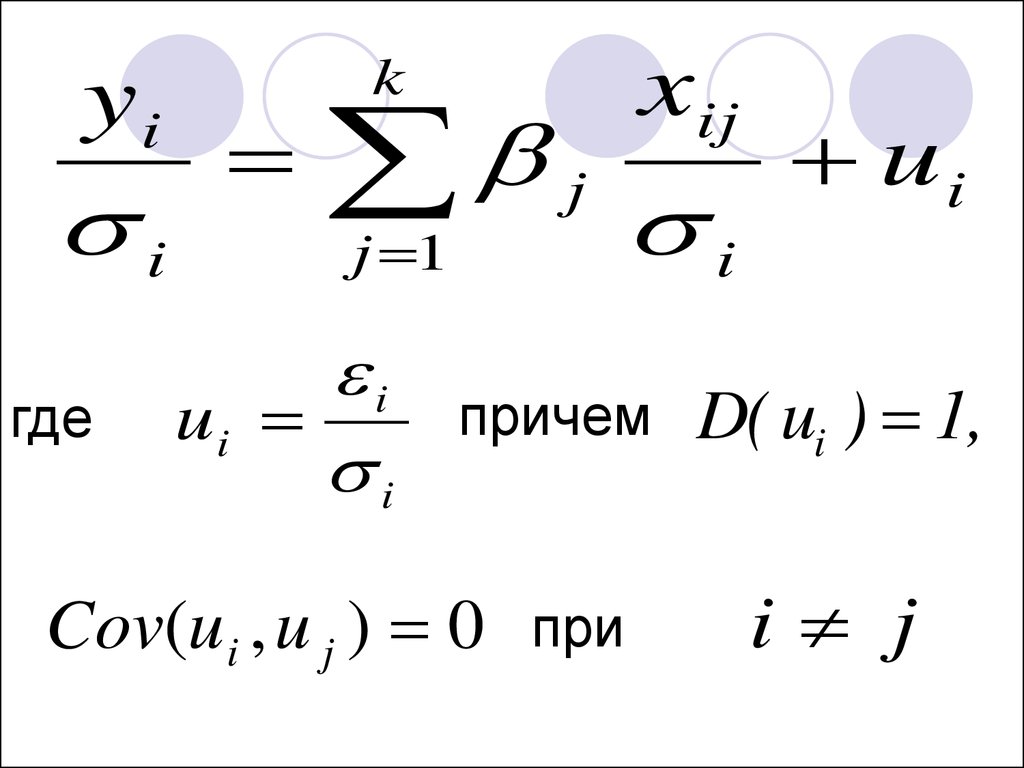

yii

где

xij

k

j

j 1

i

ui

i

i

причем

Cov(u i , u j ) 0 при

ui

D( ui ) 1,

i j

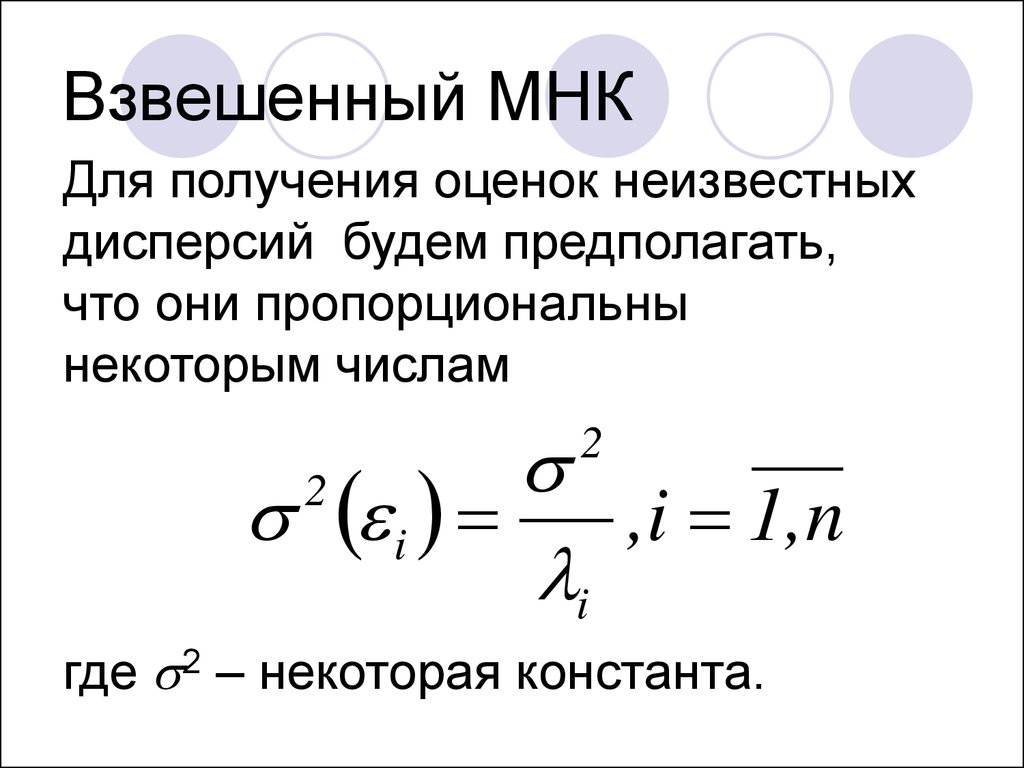

87. Взвешенный МНК

Для получения оценок неизвестныхдисперсий будем предполагать,

что они пропорциональны

некоторым числам

i

,i 1,n

i

2

2

где 2 – некоторая константа.

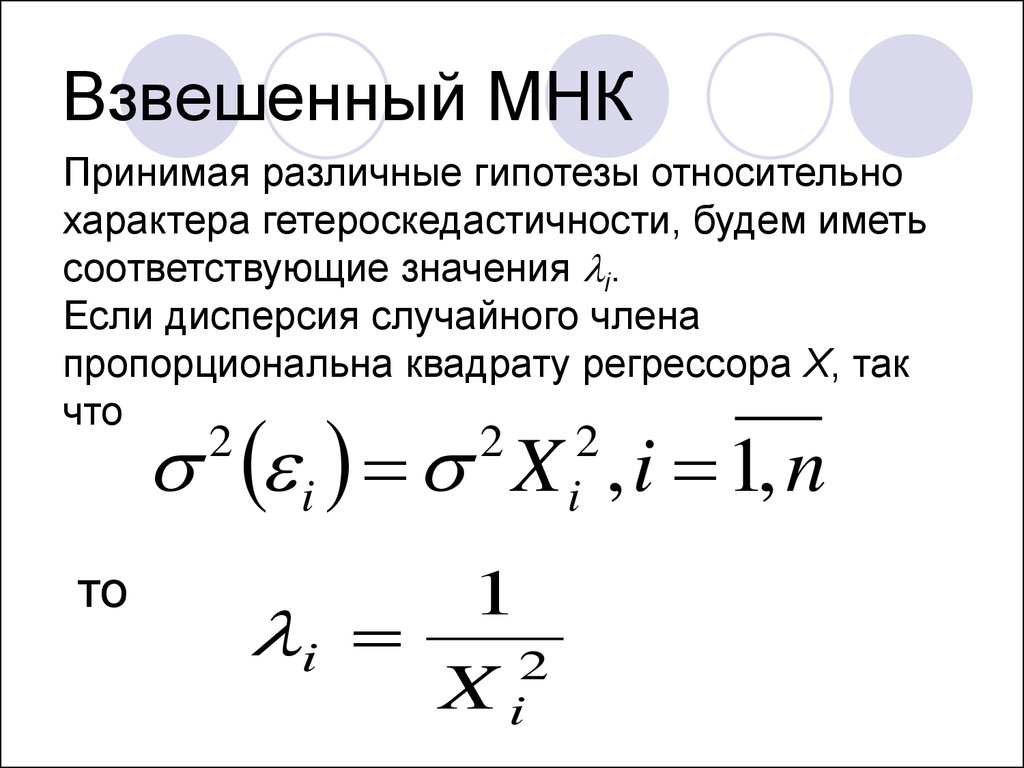

88. Взвешенный МНК

Принимая различные гипотезы относительнохарактера гетероскедастичности, будем иметь

соответствующие значения i.

Если дисперсия случайного члена

пропорциональна квадрату регрессора X, так

что

i X , i 1, n

2

то

2

1

i

2

Xi

2

i

89. Взвешенный МНК

Если дисперсия случайного членапропорциональна X, так что

i X i , i 1, n

2

то

2

1

i

Xi

90. Взвешенный МНК

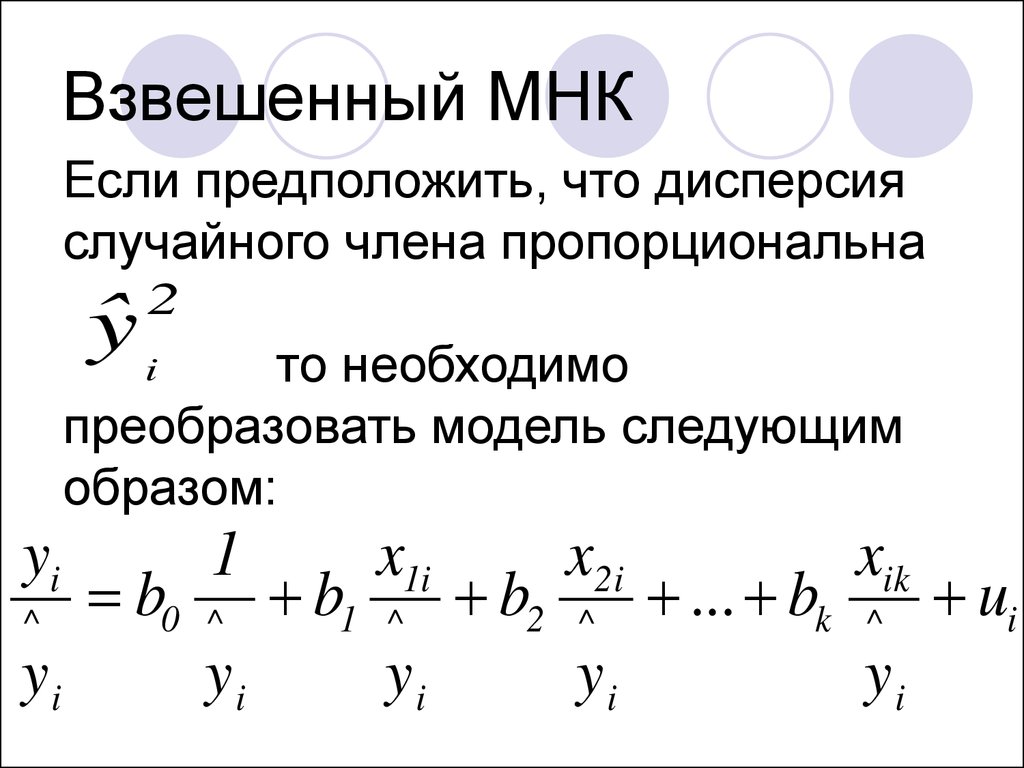

Если предположить, что дисперсияслучайного члена пропорциональна

ˆy i

2

то необходимо

преобразовать модель следующим

образом:

yi

^

yi

b0

1

^

yi

b1

x1i

^

yi

b2

x2 i

^

yi

... bk

xik

^

yi

ui

91.

Существуют также и другие методы коррекции модели нагетероскедастичность, в частности, состоятельное оценивание стандартных

ошибок.

Известны способы коррекции стандартных ошибок Уайта и Ньюи-Веста.

Стандартные ошибки в форме Уайта.

Рассмотрим матрицу XT X. Имеем ij-й элемент матрицы получается по

n

формуле (XT X)ij = xsi s xsj . Обозначим как xTs , s 1,..., n, векторы-строки

2

n

s 1

размерности 1 k матрицы регрессоров X. Тогда XT X = s x s x s . Уайт

2

T

s 1

предложил использовать в качестве состоятельной оценки матрицы

ковариаций оценок коэффициентов величину:

V (β) X X

T

e x x X X

1 n

s 1

2

T

s s s

T

1

Стандартные отклонения, рассчитанные по последней формуле, являются

состоятельными стандартными ошибками при наличии

гетероскедастичности.

92.

Стандартные ошибки в форме Ньюи-Веста.Пусть в матрице ковариаций ненулевые элементы стоят не только на

главной диагонали, как в предыдущем случае Уайта, но и на соседних

диагоналях, отстоящих от главной не более чем на L ( ij 0, i j L ).

Ньюи и Вест показали, что оценка:

n

1 n 2 T 1 L

1

T

T

T

V (β) n X X es x s x s w j et et j xt xt j xt j xt X X

n j 1 t j 1

n s 1

является состоятельной оценкой матрицы ковариаций оценок

коэффициентов регрессии.

Веса wj выбираются либо по Бартлетту: w j 1 j ,

L 1

либо по Парзену:

2

3

T

1

L 1

j

j

6

,1

j

,

1 6

L

1

L

1

2

wj

2

j

L 1

2

1

L 1 , 2 j L.

Стандартные ошибки, рассчитанные по Ньюи и Весту, являются

состоятельными стандартными ошибками при наличии

гетероскедастичности и автокорреляции остатков.

93.

Автокорреляция востатках

94.

пространственные данные –cross-sectional data;

временные ряды данных –

time-series data

95. Условие отсутствия автокорреляции

M ( i j ) 0 ,при i≠j

или

M ( ) I

Т

2

где I – единичная матрица

96.

Причины автокорреляцииСтохастические зависимости между значениями

случайных ошибок – автокорреляция ошибок.

Ее причинами являются:

1) влияние некоторых случайных факторов или

опущенных в уравнении регрессии важных

объясняющих переменных, которое не является

однократным, а действует в разные периоды

времени;

2) случайный член может содержать составляющую,

учитывающую ошибку измерения объясняющей

переменной.

97.

Последствия автокорреляции:1. Выборочные дисперсии полученных оценок коэффициентов будут

больше по сравнению с дисперсиями по альтернативным методам

оценивания, т.е. оценки коэффициентов будут неэффективны.

2. Стандартные ошибки коэффициентов будут оценены неправильно,

чаще всего занижены, иногда настолько, что нет возможности

воспользоваться для проверки гипотез соответствующими точными

критериями – мы будем чаще отвергать гипотезу о незначимости

регрессии, чем это следовало бы делать в действительности.

Автокорреляция означает нарушение условия Гаусса-Маркова, которое

принимает вид:

2 const при i l ,

E uiul

при i l ,

i, l 1,..., n

il

и матрица ковариаций:

2 12

2

21

Ω

n n

n1 n 2

1n

2 n

2

(4.10)

98.

Последствия автокорреляции:Стандартные ошибки

коэффициентов будут оценены

неправильно, т.е. оценки

коэффициентов будут неэффективны.

Выводы о значимости оценок

коэффициентов будут некорректны.

99.

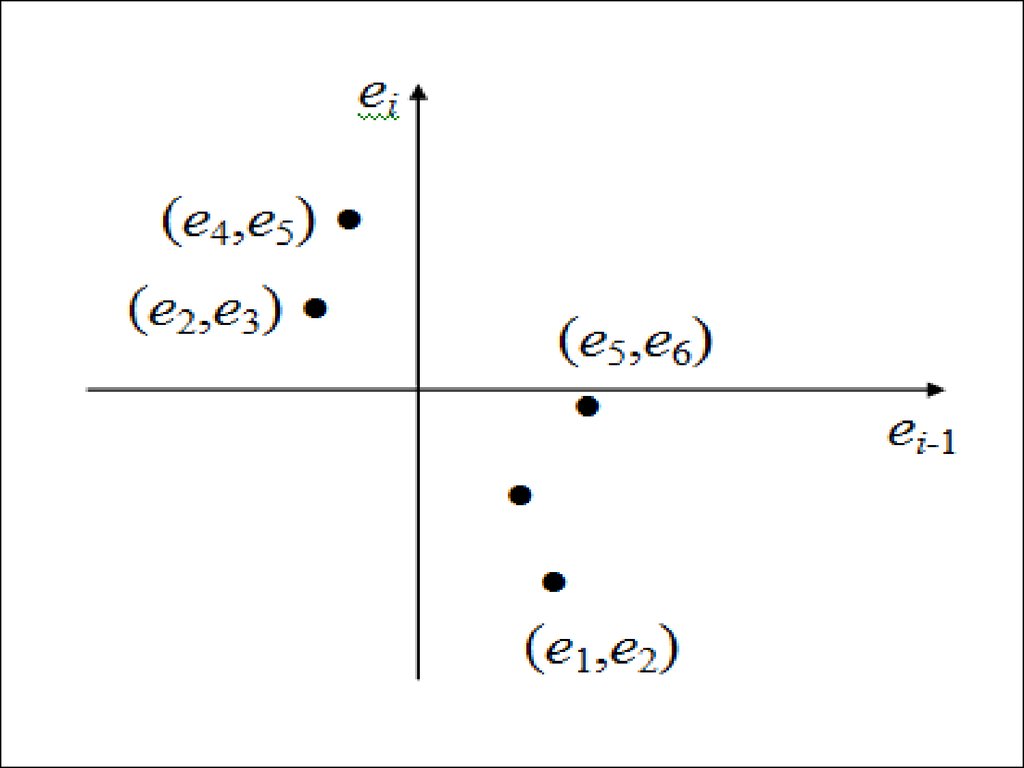

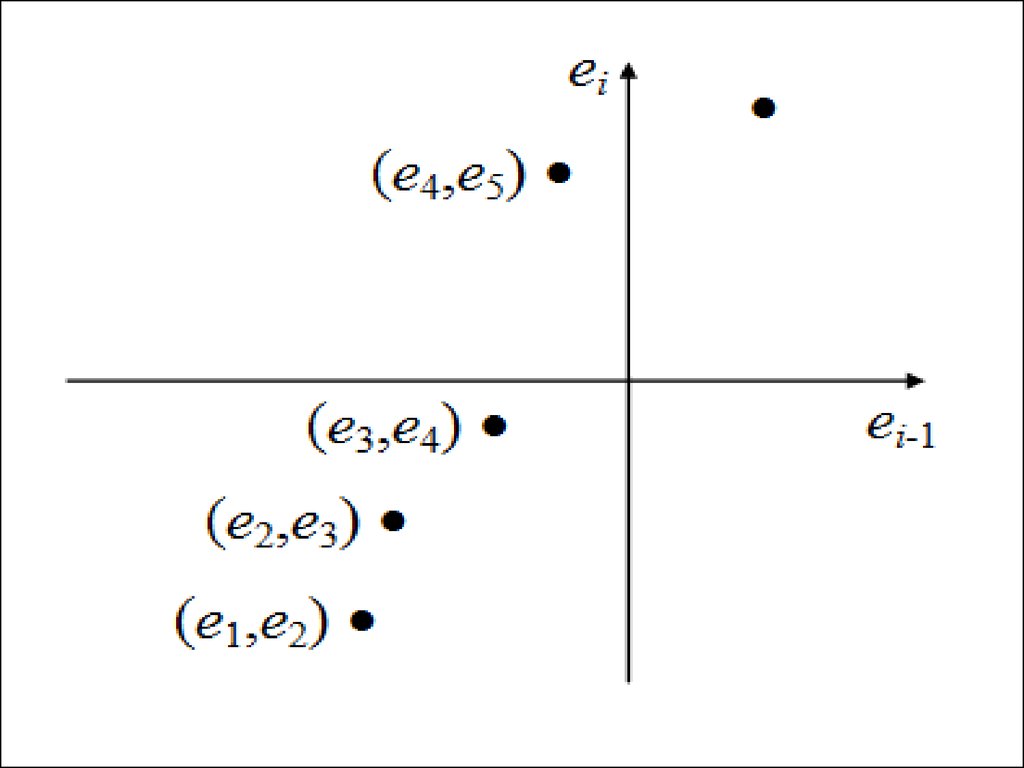

Можнорассматривать

так

называемую

корреляцию сериями (автокорреляцию), когда

зависимость между ошибками, отстоящими на

некоторое количество шагов s, называемое порядком

корреляции (в частности, на один шаг, s=1), остается

одинаковой, что хорошо проявляется визуально на

графике в системе координат (ei; ei-s).

Например, для s=1 показаны отрицательная

(слева) и положительная (справа) автокорреляция

остатков. В экономических исследованиях чаще

всего встречается положительная автокорреляция.

100.

система координат(ei; ei-s)

101.

102.

103.

3et

2

1

t

0

1

-1

-2

-3

et 0,9et 1 t

Пример графика остатков по наблюдениям при положительной

автокорреляции

104.

3et

2

1

0

t

1

-1

-2

-3

et 0,9et 1 t

Пример графика остатков по наблюдениям при отрицательной

автокорреляции

105.

106.

Тестирование на наличие автокорреляции.Для проверки гипотезы о существовании

линейной автокорреляции первого порядка,

которая чаще всего имеет место на практике,

используется критерий Дарбина-Уотсона,

основанный на статистике

n

d

e e

i 2

i 1

i

n

e

i 1

2

i

2

107. Критерий Дарбина-Уотсона.

nd

e

i

i 2

ei 1

n

i 1

2

2

ei

108.

Тестирование на наличие автокорреляции.Критерий Дарбина-Уотсона предназначен для

моделей с детерминированными регрессорами X и

не применим в случаях, когда среди объясняющих

переменных есть лагированные значения

переменной Y.

Для больших выборок

d 2 2

Автокорреляция отсутствует

d 2

Положительная автокорреляция d 0

Отрицательная автокорреляция d 4

109.

d 2( 1 1 )110. Коэффициент автокорреляции первого порядка

n1

( e

i

i 2

n

( e

i 2

i

e1 )( ei 1 e2 )

e1 )

2

n

( e

i 2

i 1

e2 )

2

111.

ne1

e

i

i 2

n 1

n

e2

e

i 2

i 1

n 1

112.

По таблице Дарбина-Уотсонаопределяются две

критические точки: верхняя

dU и нижняя dL.

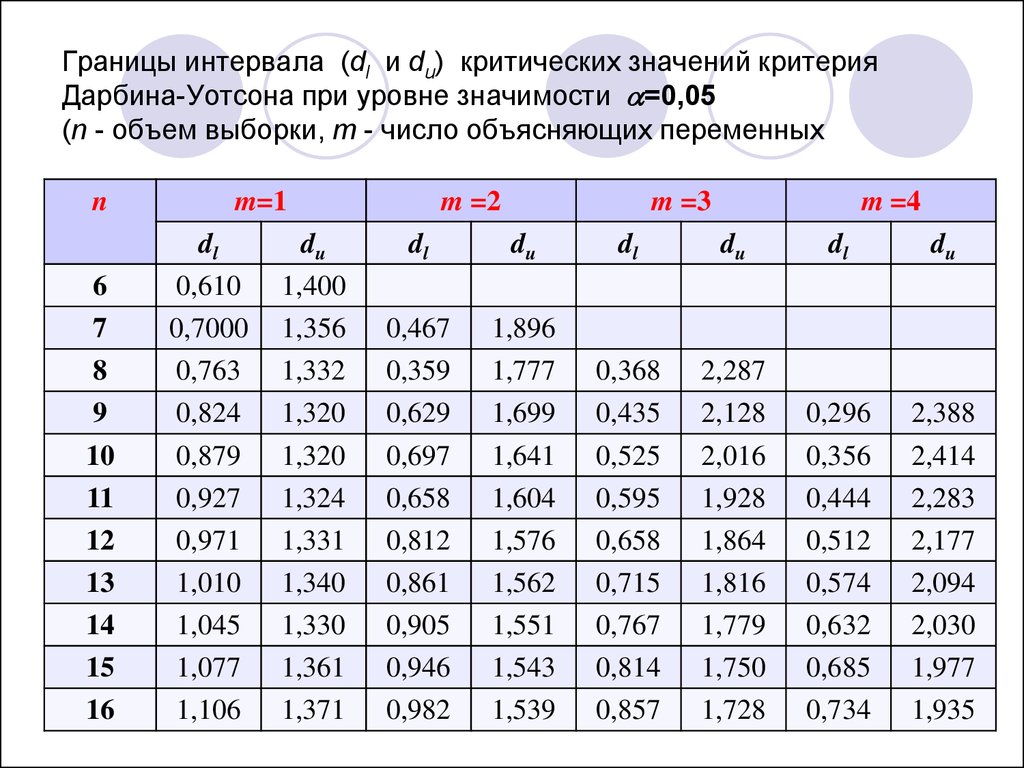

113. Границы интервала (dl и du) критических значений критерия Дарбина-Уотсона при уровне значимости =0,05 (n - объем выборки, m - число объясняющих п

Границы интервала (dl и du) критических значений критерияДарбина-Уотсона при уровне значимости =0,05

(n - объем выборки, m - число объясняющих переменных

n

6

7

8

9

10

11

12

13

14

15

16

m=1

dl

0,610

0,7000

0,763

0,824

0,879

0,927

0,971

1,010

1,045

1,077

1,106

du

1,400

1,356

1,332

1,320

1,320

1,324

1,331

1,340

1,330

1,361

1,371

m =2

m =3

m =4

dl

du

dl

du

dl

du

0,467

0,359

0,629

0,697

0,658

0,812

0,861

0,905

0,946

0,982

1,896

1,777

1,699

1,641

1,604

1,576

1,562

1,551

1,543

1,539

0,368

0,435

0,525

0,595

0,658

0,715

0,767

0,814

0,857

2,287

2,128

2,016

1,928

1,864

1,816

1,779

1,750

1,728

0,296

0,356

0,444

0,512

0,574

0,632

0,685

0,734

2,388

2,414

2,283

2,177

2,094

2,030

1,977

1,935

114.

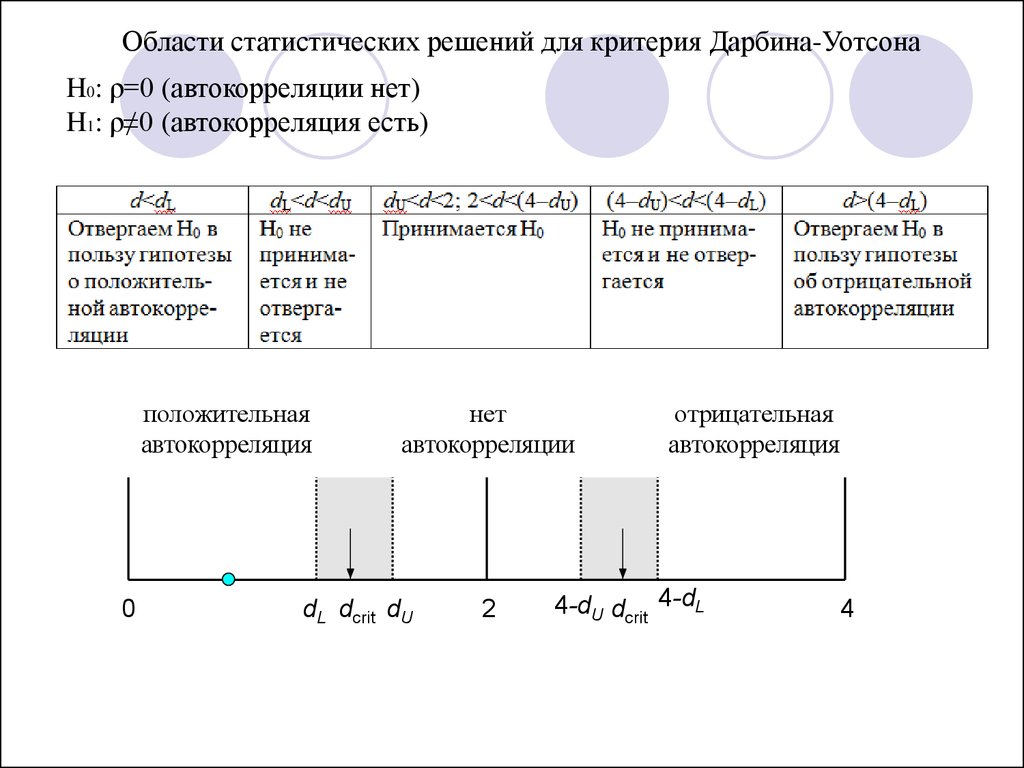

Области статистических решений для критерия Дарбина-УотсонаH0: ρ=0 (автокорреляции нет)

H1: ρ≠0 (автокорреляция есть)

положительная

автокорреляция

0

нет

автокорреляции

dL dcrit dU

2

отрицательная

автокорреляция

4-dU dcrit 4-dL

4

115.

116. Методы устранения автокорреляции

Кохрейна-ОркаттаХилдрета-Лу

Дарбина

117. Запишем регрессию (1):

Yt 0 1 x1t 2 x2t... k xkt t

118. В момент времени t-1 имеем (2):

Yt 1 0 1 x1t 1 2 x2t 1... k xkt 1 t 1

119. Умножим уравнение (2) на коэффициент автокорреляции ρ:

Yt 1 0 1 x1t 1 2 x2t 1... k xkt 1 t 1

120. Вычтем уравнение (2) из уравнения (1)

Yt Yt 1 0 (1 )1 ( x1t x1t 1 )

2 ( x2t x2t 1 )

... k ( xkt xkt 1 ) ut

121.

ut t t 1122.

0 (1 )123.

dr 1

2

124.

Предположим, что остатки ui удовлетворяют следующему уравнению:ui= ui-1+ςi, i=2,...,n,

(4.11)

представляющему собой авторегрессионную модель первого порядка,

для которой выполнено | | 1, а ςi удовлетворяют условиям:

2 , s 0;

E(ςi)=0 и E i i s

0, s 0.

Тогда несложно показать, что будет выполняться:

и матрица ковариаций

u2 , i l

E uiul l i

, i l

u2

2

u

Ω

n n

n 1

n 2

n 1

n 2

2

u

125.

Оценивание регрессии при наличии автокорреляции.Метод 1. Отказавшись от определения величины статистически, можно

положить =0,5; 1 или -1.

Однако даже грубая статистическая оценка будет более эффективной,

поэтому другой способ определения с помощью статистики ДарбинаУотсона 1–0,5d.

Применяя

затем

непосредственно

ОМНК,

получим

оценки

коэффициентов.

Метод 2. Рассмотрим на примере парной регрессии:

Yi 0 1 X i ui ,

ui ui 1 i

Yi 1 0 1 X i 1 ui 1

Yi Yi 1 0 (1 ) 1 X i 1 X i 1 ui ui 1

Yi 0 (1 ) Yi 1 1 X i 1 X i 1 i

Yi Yi Yi 1 , 0 0 1 , X i X i X i 1

Yi 0 1 X i i

(4.12)

причем Y1 1 2 Y1 и X1 1 2 X1 .

Ошибки в (4.12) не автокоррелированы и можно применять МНК.

126.

Метод 3. Итеративная процедура Кохрейна-Оркатта.а) Оценивается регрессия Yi 0 1 X i ui с исходными не

преобразованными данными с помощью обыкновенного МНК.

б) Вычисляются остатки ei.

в) Оценивается регрессия ei= ei-1+ςi, и коэффициент при ei-1 дает оценку

.

г) С учетом полученной оценки уравнение Yi 0 1 X i ui

преобразовывается к виду (4.12), оценивание которого позволяет

получить пересмотренные оценки коэффициентов 0 и 1.

д) Вычисляются остатки регрессии (4.12) и процесс выполняется снова,

начиная с этапа в).

Итерации заканчиваются, когда абсолютные разности последовательных

значений оценок коэффициентов 0, 1 и будут меньше заданного числа

(точности).

Подобная процедура оценивания порождает проблемы, касающиеся

сходимости итерационного процесса и характера найденного минимума:

локальный или глобальный

127.

Метод 4. Метод Хилдрета-Лу.Основан на тех же принципах, что и рассмотренный метод 3, но

использует другой алгоритм вычислений. Здесь регрессия (4.12)

оценивается МНК для каждого значения из диапазона [-1, 1] с

некоторым шагом внутри него. Значение, которое дает минимальную

стандартную ошибку для преобразованного уравнения (4.12),

принимается в качестве оценки , а коэффициенты регрессии

определяются при оценивании уравнения (4.12) с использованием этого

значения.

128.

Метод 5. Метод Дарбина.Получаем оценку ρ как коэффициента при Yi-1 в уравнении

Yi 0 (1 ) Yi 1 1 X i 1 X i 1 i

Вычисляем значения преобразованных переменных

Yi Yi Yi 1 , X i X i X i 1

и применяем к ним обыкновенный МНК. Получаем искомые

оценки коэффициентов регрессии.

Математика

Математика