Похожие презентации:

Регрессионный анализ. Основы

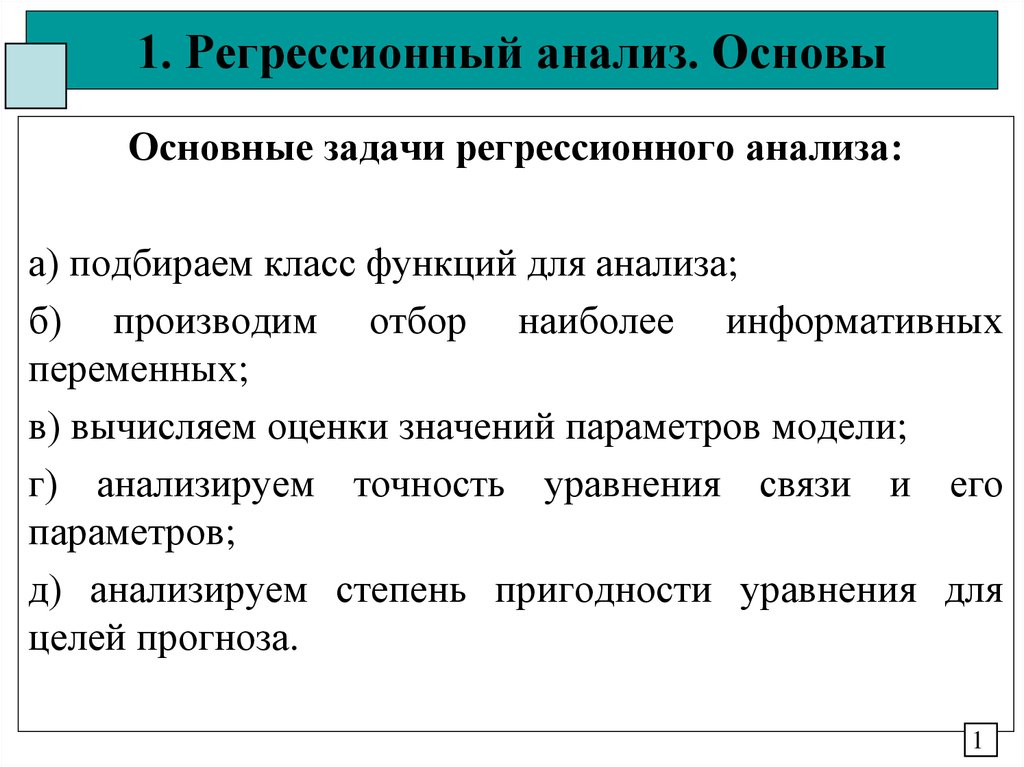

1. 1. Регрессионный анализ. Основы

Основные задачи регрессионного анализа:а) подбираем класс функций для анализа;

б) производим отбор наиболее информативных

переменных;

в) вычисляем оценки значений параметров модели;

г) анализируем точность уравнения связи и его

параметров;

д) анализируем степень пригодности уравнения для

целей прогноза.

1

2. 1. Регрессионный анализ. Основы

Основные варианты статистических взаимосвязеймежду переменными X и Y:

-Не направленная связь, обе переменные равноценны,

наличие и сила взаимосвязи – корреляционный анализ.

-выделяем одну величину как независимую

(объясняющую, факторную, предиктор), а другую как

зависимую (объясняемую, результирующую), изменение

первой может служить причиной для изменения второй

переменной в виде какой либо зависимости –

регрессионный анализ

Количество, качество и неоднозначность связи.

2

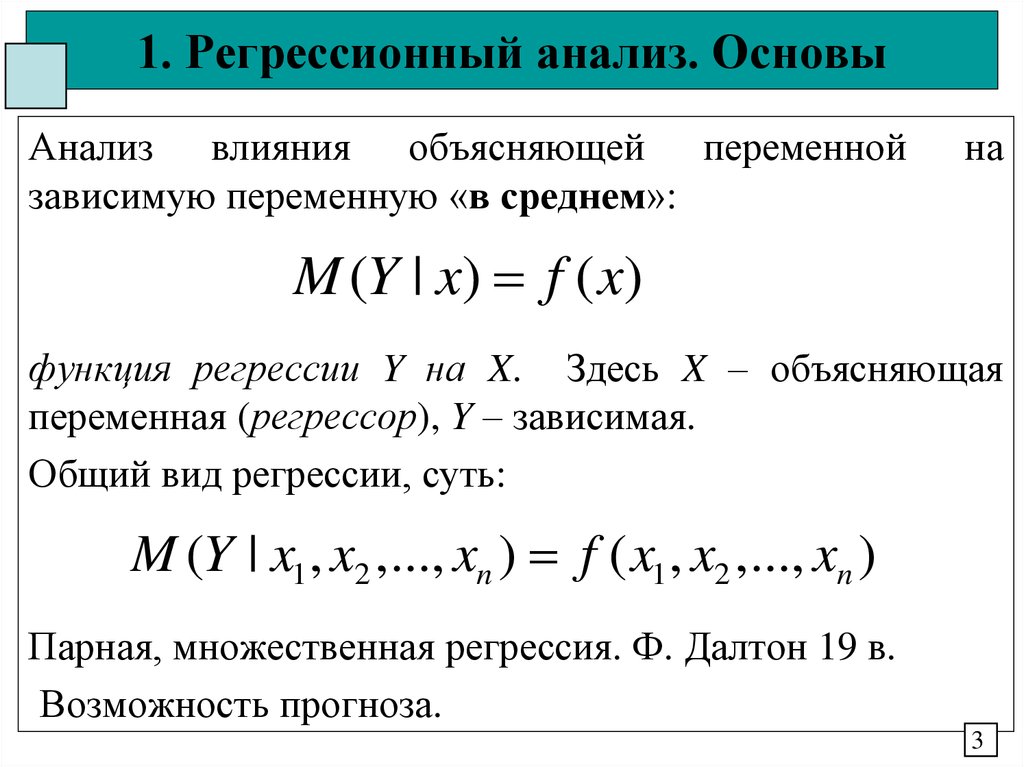

3. 1. Регрессионный анализ. Основы

Анализ влияния объясняющей переменнойзависимую переменную «в среднем»:

на

M (Y | x) f ( x)

функция регрессии Y на X. Здесь X – объясняющая

переменная (регрессор), Y – зависимая.

Общий вид регрессии, суть:

M (Y | x1 , x2 ,..., xn ) f ( x1 , x2 ,..., xn )

Парная, множественная регрессия. Ф. Далтон 19 в.

Возможность прогноза.

3

4. 1. Регрессионный анализ. Основы

Случайность зависимости – не совпадение реальныхзначений зависимой переменной с её условным

математическим ожиданием.

Дополнение случайным слагаемым , отражающим это

несоответствие

Y M (Y | x)

Y M (Y | x1 , x2 ,..., xn )

Регрессионные модели (уравнения). Необходимость

случайного члена.

4

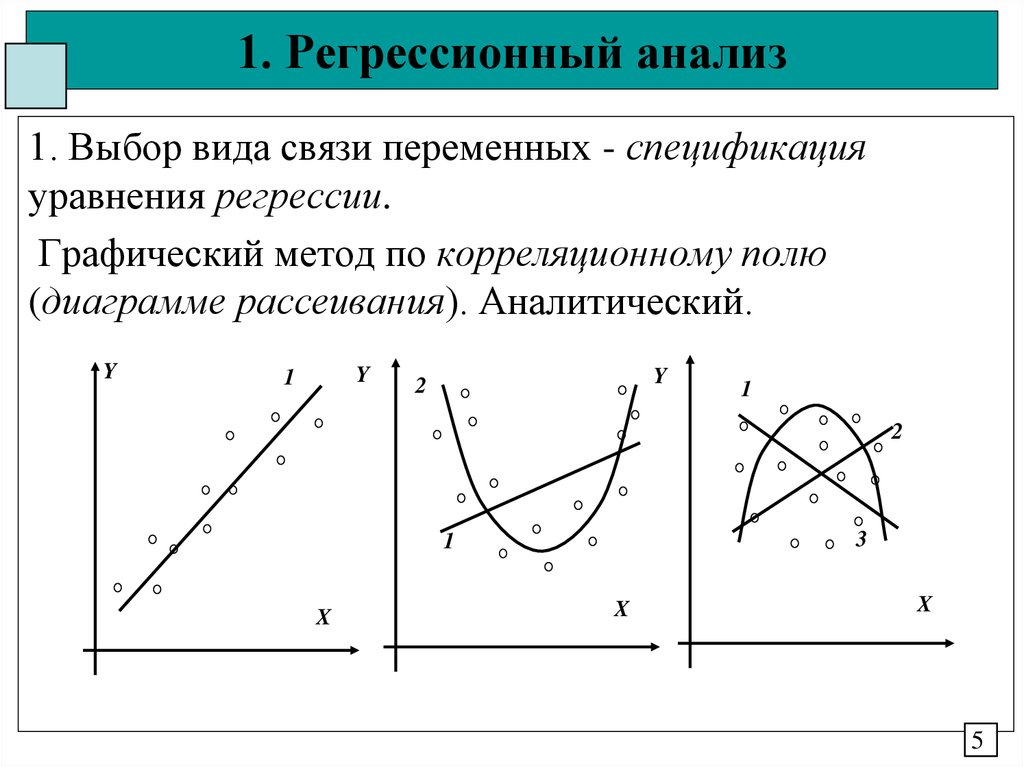

5. 1. Регрессионный анализ

1. Выбор вида связи переменных - спецификацияуравнения регрессии.

Графический метод по корреляционному полю

(диаграмме рассеивания). Аналитический.

Y

Y

1

Y

2

1

2

3

1

X

X

X

5

6. 1. Регрессионный анализ

2. Определение параметров (коэффициентов) модели параметризация.3. Проверка качества регрессии - верификация.

Линейная модель как общая тенденция процесса.

Параметризация линейной модели:

-Метод средних (Метод Маркова, на основе МЗР);

-Метод максимального правдоподобия.

Частный случай ММП при квадратичной целевой

функции – метод наименьших квадратов МНК.

6

7. 1. Регрессионный анализ

Задачи линейного регрессионного анализа длястатистических данных (хi, yi) для переменных Х и Y:

а) получить наилучшие по какому-либо критерию

оценки неизвестных теоретических параметров ai ;

б) проверить статистические гипотезы о параметрах

модели;

в)

проверить

адекватность

модели

данных

наблюдений;

г) выполнить оценку точности результатов вычислени

д) провести анализ полученных данных.

7

8. 1. Парный регрессионный анализ

Задача: подобрать для 2 рядов X и Y оптимальную модель изкласса линейных вида

yi axi b ei

чтобы наилучшим образом линейно выразить Y через Х. С

учетом коррекции имеем

yˆi yi vi axi b

Решение на основе:

- метода наименьших квадратов в натуральных величинах

-метода наименьших квадратов в центрированных величинах

-Байесовского метода (на основе характеристик многомерного

закона распределения)

8

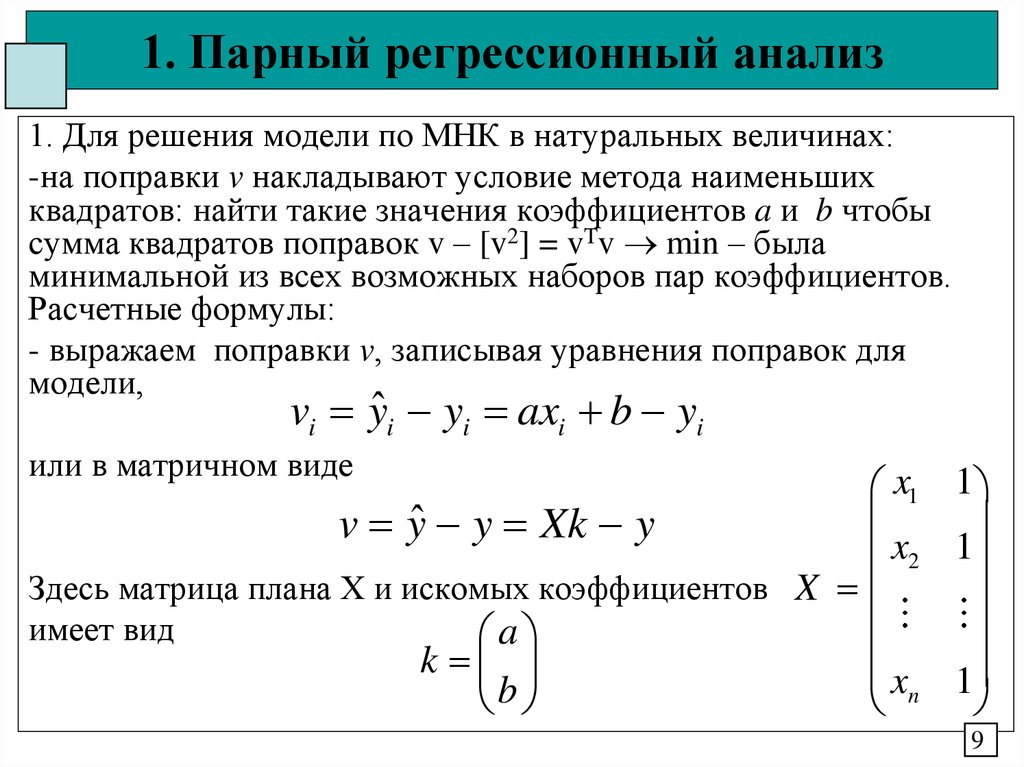

9. 1. Парный регрессионный анализ

1. Для решения модели по МНК в натуральных величинах:-на поправки v накладывают условие метода наименьших

квадратов: найти такие значения коэффициентов a и b чтобы

сумма квадратов поправок v – [v2] = vTv min – была

минимальной из всех возможных наборов пар коэффициентов.

Расчетные формулы:

- выражаем поправки v, записывая уравнения поправок для

модели,

vi yˆi yi axi b yi

или в матричном виде

x1 1

v yˆ y Xk y

x2 1

Здесь матрица плана Х и искомых коэффициентов X

имеет вид

a

k

x 1

b

n

9

10. 1. Парный регрессионный анализ

- составляем целевую функцию качества Ф для МНКФ v 2 vT v (ax b y )2

которая должна быть минимальна

-для минимизации берем частные производные от Ф по k и

полученное выражение приравниваем к нулю

v

2vT X 0

k

v k

с учетом того, что v Xk y

Транспонируя выражение имеем

X v 0

T

- лемма Гаусса.

10

11. 1. Парный регрессионный анализ

Подставим в лемму значение поправкиПолучаем окончательно

v Xk y

X T X k y X T X k X T y 0

матричную систему нормальных уравнений (совместная, 2

уравнения, 2 неизвестных) в свернутом виде

Nk = d,

с элементами

N11

T

N X X

N 21

N12 x 2

=

N 22 x

d1 xy

a

T

, k , d X y

b

d

n

2 y

x

11

12. 1. Парный регрессионный анализ

Систему в матричном виде целесообразно решать черезобращение матрицы N, откуда имеем

a

k N 1 d Q d

b

Здесь матрица Q = N-1 носит название обратная матрица.

Модельные значения в матричном виде будут

yˆ XQX T y X k

Поправки в измерения получим как

v yˆ y ( XQX T E ) y

12

13. 1. Парный регрессионный анализ

2. Решение по МНК в центрированных величинах.Для этого исходная модель

yˆi yi vi axi b

центрируется средним

yˆ yˆ a x x

yˆ y v y a x x

т.к. yˆ yˆ yˆ y

Имеем 1 неизвестное а. Тогда целевая целевая функция Ф будет

2

2

v y a x x y a vx v y

Минимизация Ф дает

2

Ф Ф v

2 avx v y vx 0

a v a

13

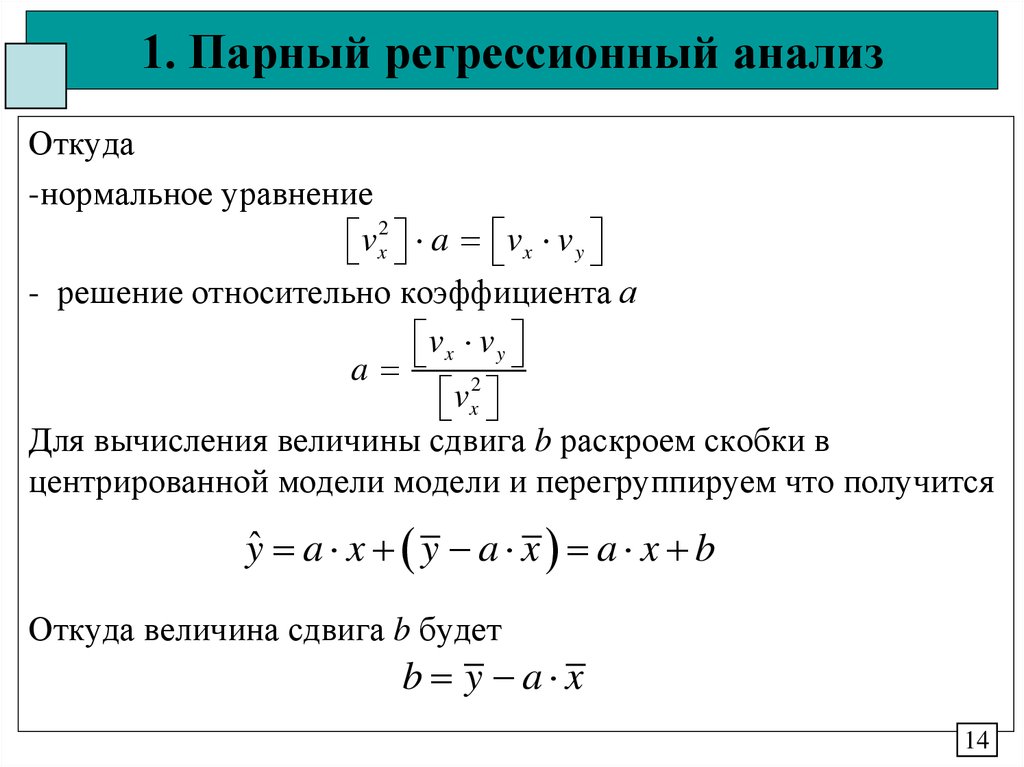

14. 1. Парный регрессионный анализ

Откуда-нормальное уравнение

vx2 a vx v y

- решение относительно коэффициента а

vx v y

a

vx2

Для вычисления величины сдвига b раскроем скобки в

центрированной модели модели и перегруппируем что получится

yˆ a x y a x a x b

Откуда величина сдвига b будет

b y a x

14

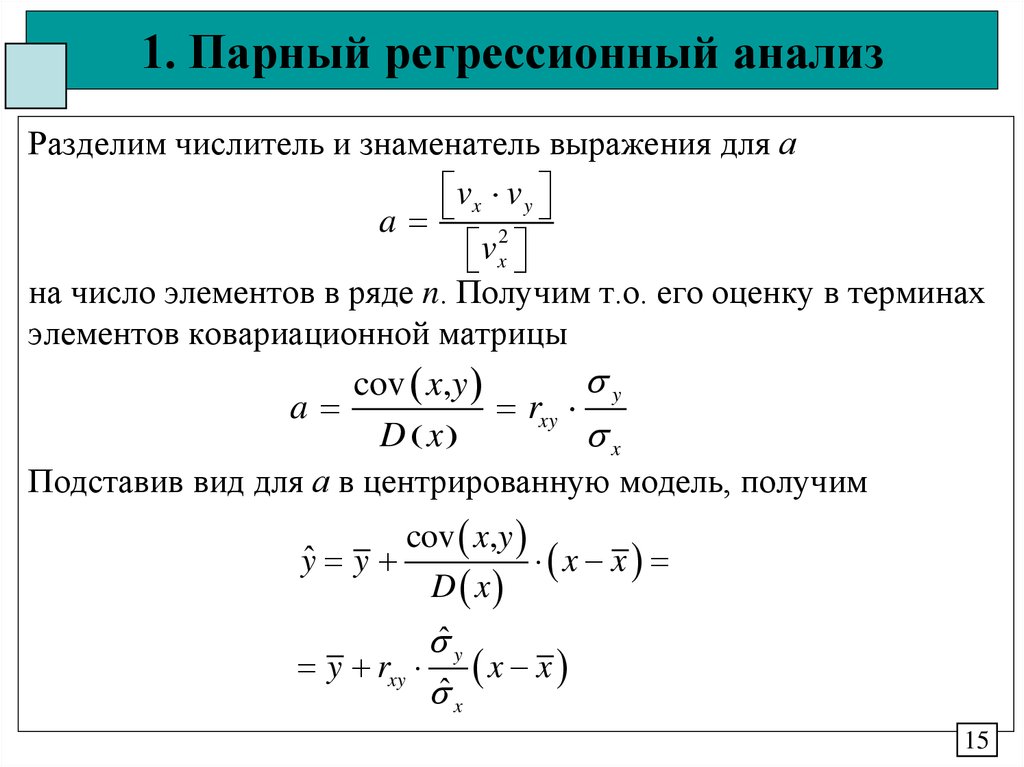

15. 1. Парный регрессионный анализ

Разделим числитель и знаменатель выражения для аvx v y

a

vx2

на число элементов в ряде n. Получим т.о. его оценку в терминах

элементов ковариационной матрицы

y

cov x,y

a

rxy

D x

x

Подставив вид для а в центрированную модель, получим

cov x,y

yˆ y

x x

D x

ˆ y

y rxy x x

ˆ x

15

16. 1. Парный регрессионный анализ

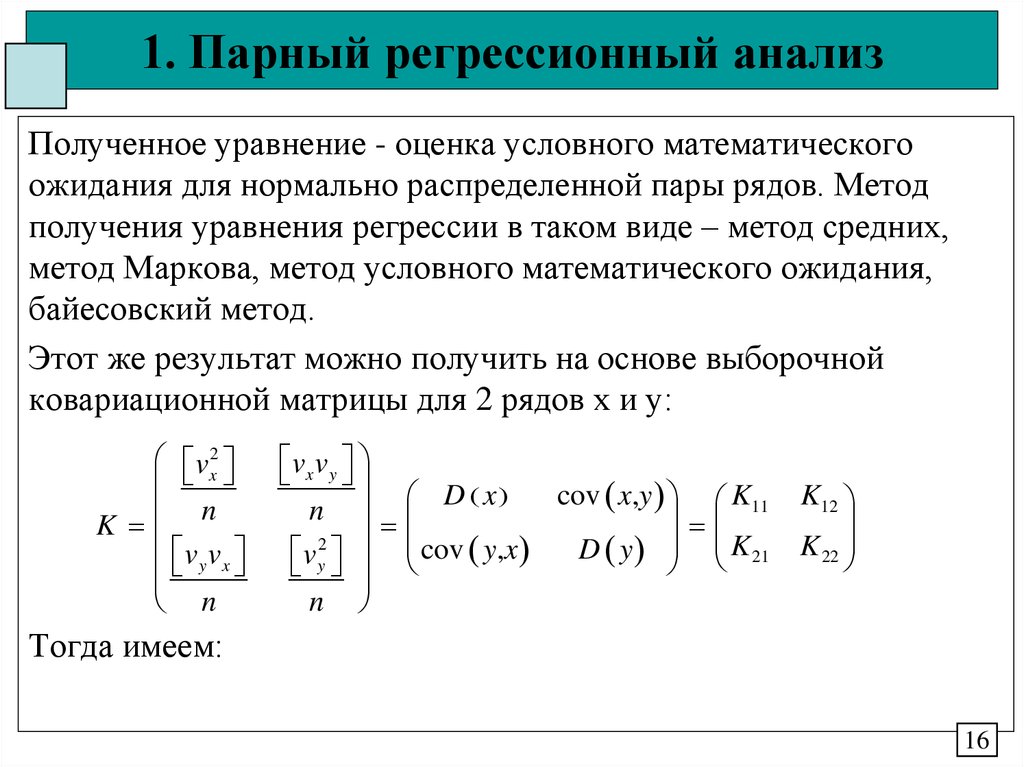

Полученное уравнение - оценка условного математическогоожидания для нормально распределенной пары рядов. Метод

получения уравнения регрессии в таком виде – метод средних,

метод Маркова, метод условного математического ожидания,

байесовский метод.

Этот же результат можно получить на основе выборочной

ковариационной матрицы для 2 рядов х и у:

vx2

n

K

v v

y x

n

vx v y

D x

cov x,y K11

n

2

D y K 21

v y cov y,x

n

K12

K 22

Тогда имеем:

16

17. 1. Парный регрессионный анализ

cov y,x K 21a

D x

K11

b y a x y

K 21

x

K11

cov x,y

yˆ y

x x

D x

y K 21 K11 1 x x

-т.е. все необходимые элементы модели в терминах

ковариационной матрицы (2 мерный случай байесовского метода)

17

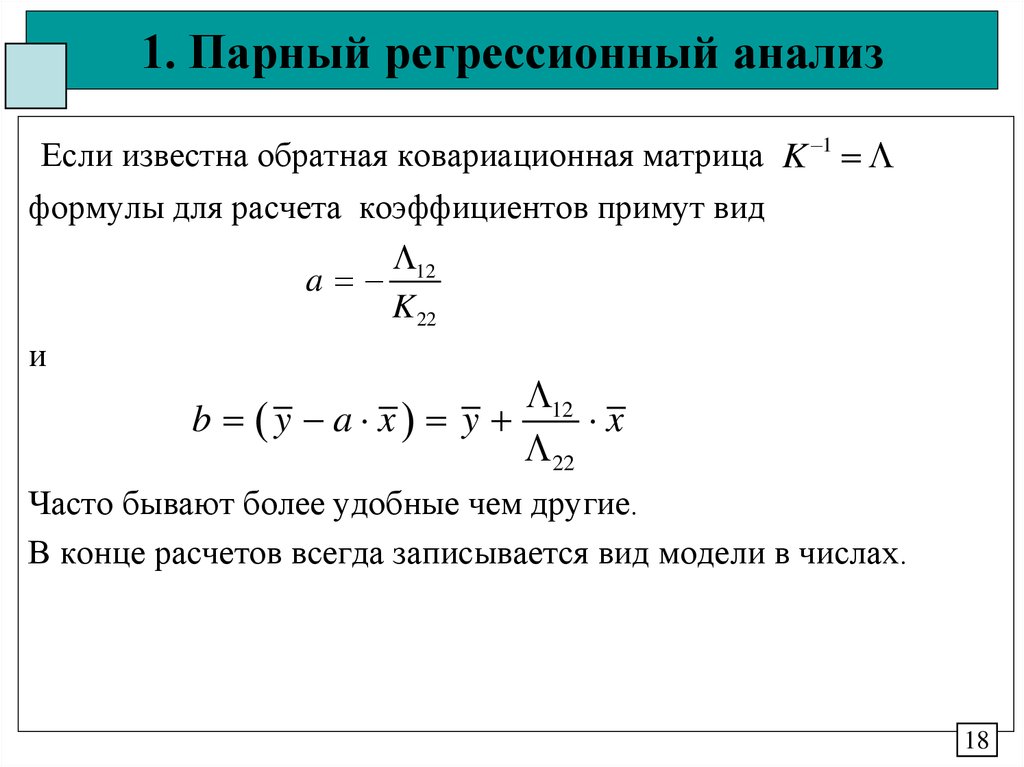

18. 1. Парный регрессионный анализ

Если известна обратная ковариационная матрица K 1формулы для расчета коэффициентов примут вид

12

a

K 22

и

12

b y a x y

x

22

Часто бывают более удобные чем другие.

В конце расчетов всегда записывается вид модели в числах.

18

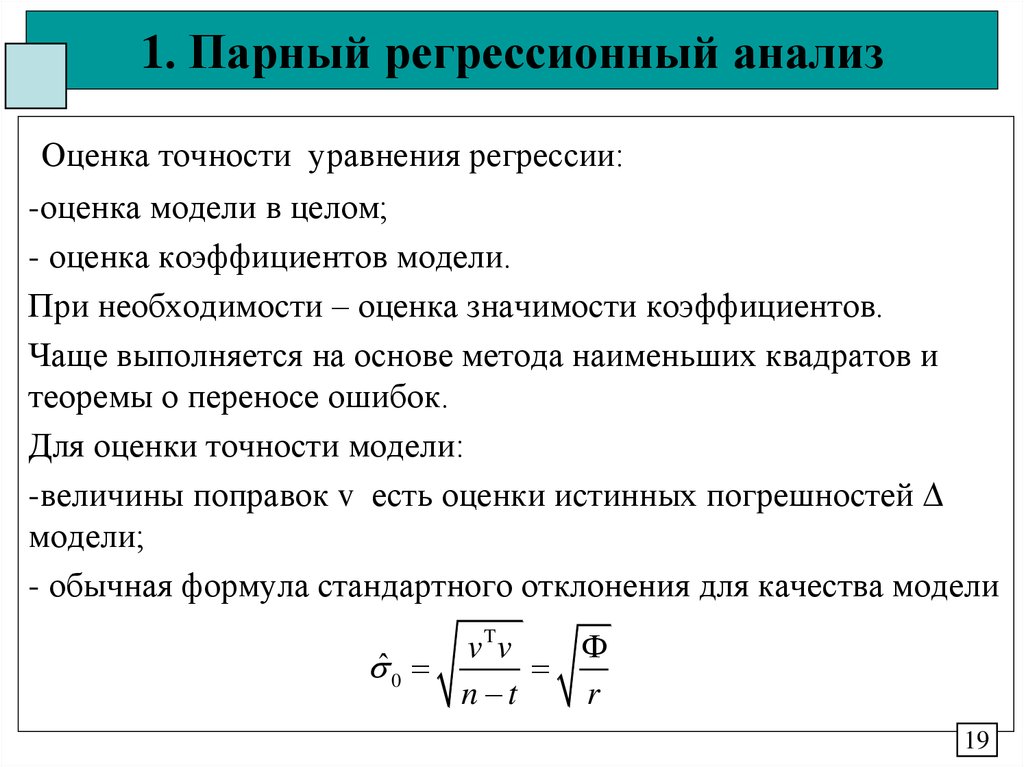

19. 1. Парный регрессионный анализ

Оценка точности уравнения регрессии:-оценка модели в целом;

- оценка коэффициентов модели.

При необходимости – оценка значимости коэффициентов.

Чаще выполняется на основе метода наименьших квадратов и

теоремы о переносе ошибок.

Для оценки точности модели:

-величины поправок v есть оценки истинных погрешностей

модели;

- обычная формула стандартного отклонения для качества модели

vTv

ˆ

0

n t

r

19

20. 1. Парный регрессионный анализ

Получение погрешности модели на основе метода условногоматематического ожидания по условной дисперсии вида

ˆ

2

y|x

ˆ

2

0

K

22

1

11

K 21 K

K12

K122 n

n

K 22

K11 n t

n t

n

D y 1 rxy2

n

t

если используется ковариационная матрица и

ˆ02

1

n

22 n t

Если использовать обратную ковариационную матрицу

20

21. 1. Парный регрессионный анализ

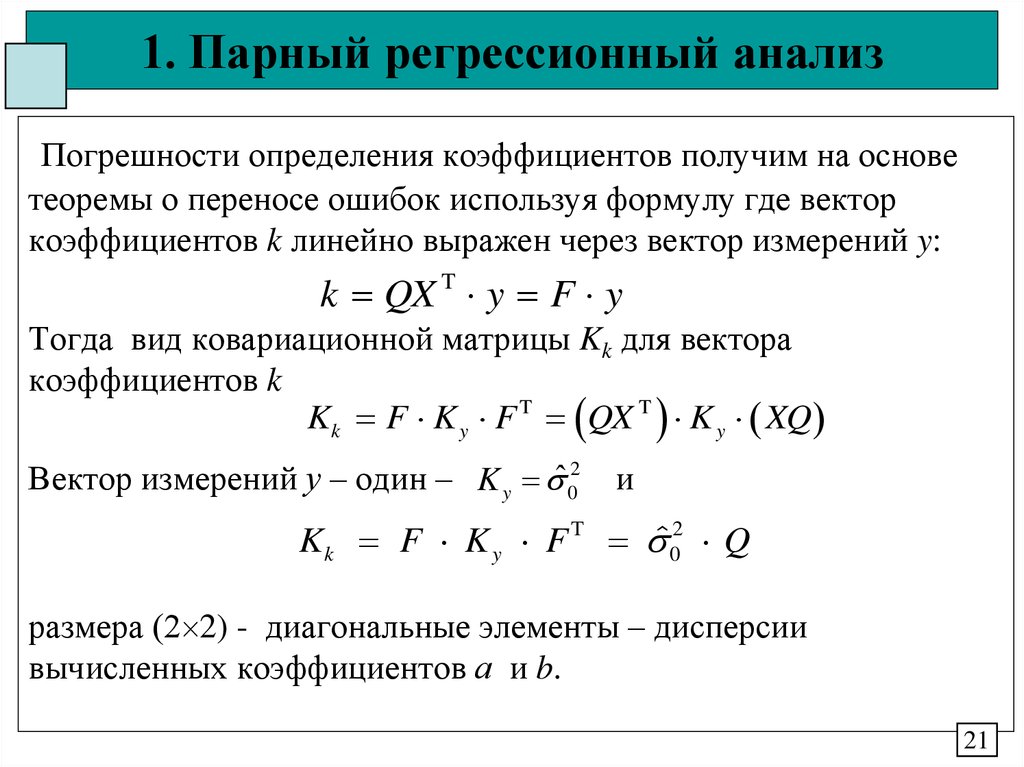

Погрешности определения коэффициентов получим на основетеоремы о переносе ошибок используя формулу где вектор

коэффициентов k линейно выражен через вектор измерений y:

k QX T y F y

Тогда вид ковариационной матрицы Kk для вектора

коэффициентов k

Kk F K y F T QX T K y XQ

Вектор измерений у – один – K y ˆ 02

и

Kk F K y F T ˆ02 Q

размера (2 2) - диагональные элементы – дисперсии

вычисленных коэффициентов а и b.

21

22. 1. Парный регрессионный анализ

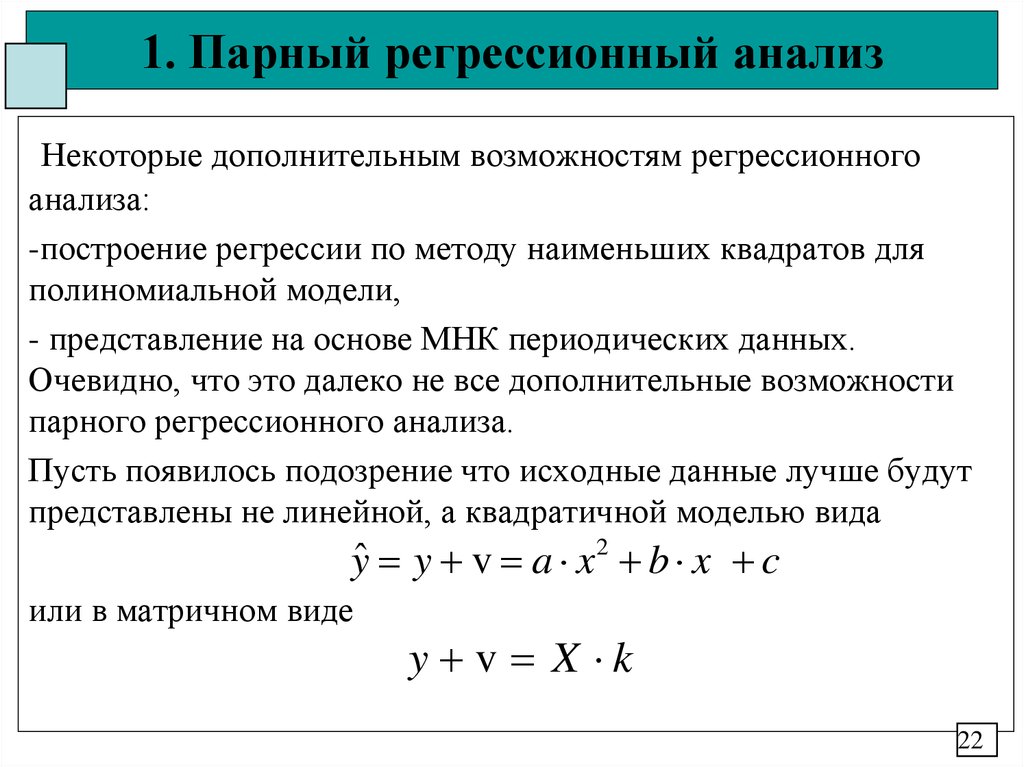

Некоторые дополнительным возможностям регрессионногоанализа:

-построение регрессии по методу наименьших квадратов для

полиномиальной модели,

- представление на основе МНК периодических данных.

Очевидно, что это далеко не все дополнительные возможности

парного регрессионного анализа.

Пусть появилось подозрение что исходные данные лучше будут

представлены не линейной, а квадратичной моделью вида

yˆ y v a x 2 b x c

или в матричном виде

y v X k

22

23. 1. Парный регрессионный анализ

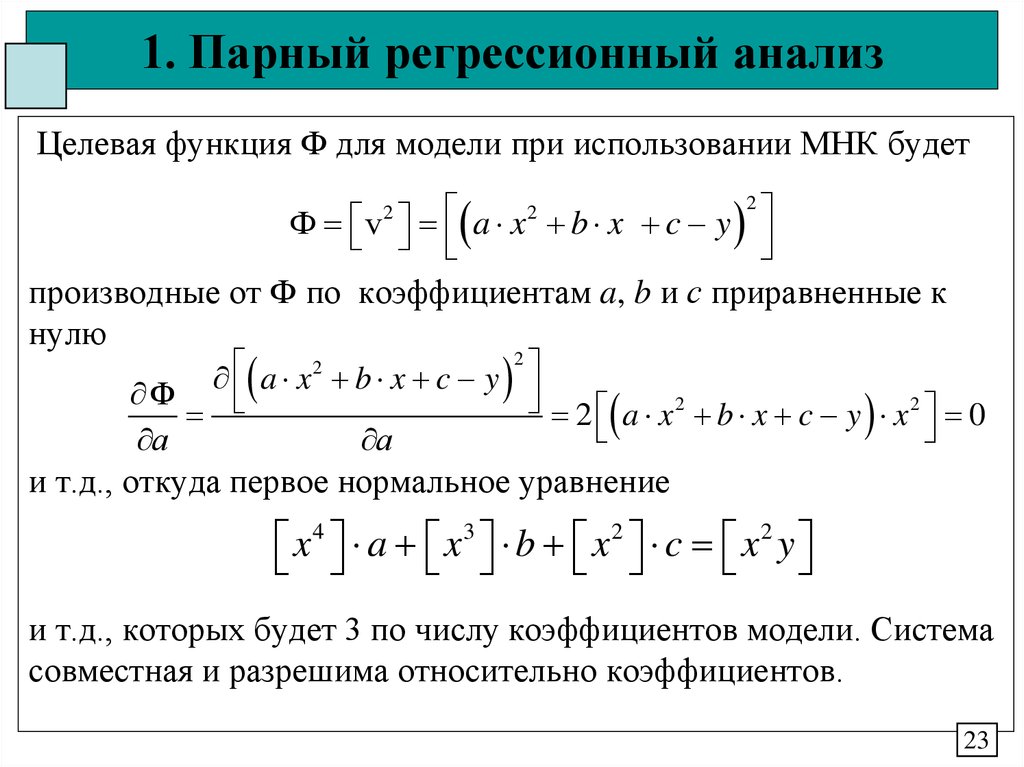

Целевая функция Ф для модели при использовании МНК будет2

2

Ф v a x b x c y

производные от Ф по коэффициентам a, b и с приравненные к

нулю

2

2

a

x

b

x

c

y

Ф

2 a x 2 b x c y x 2 0

а

а

и т.д., откуда первое нормальное уравнение

2

x 4 a x3 b x 2 c x 2 y

и т.д., которых будет 3 по числу коэффициентов модели. Система

совместная и разрешима относительно коэффициентов.

23

24. 1. Парный регрессионный анализ

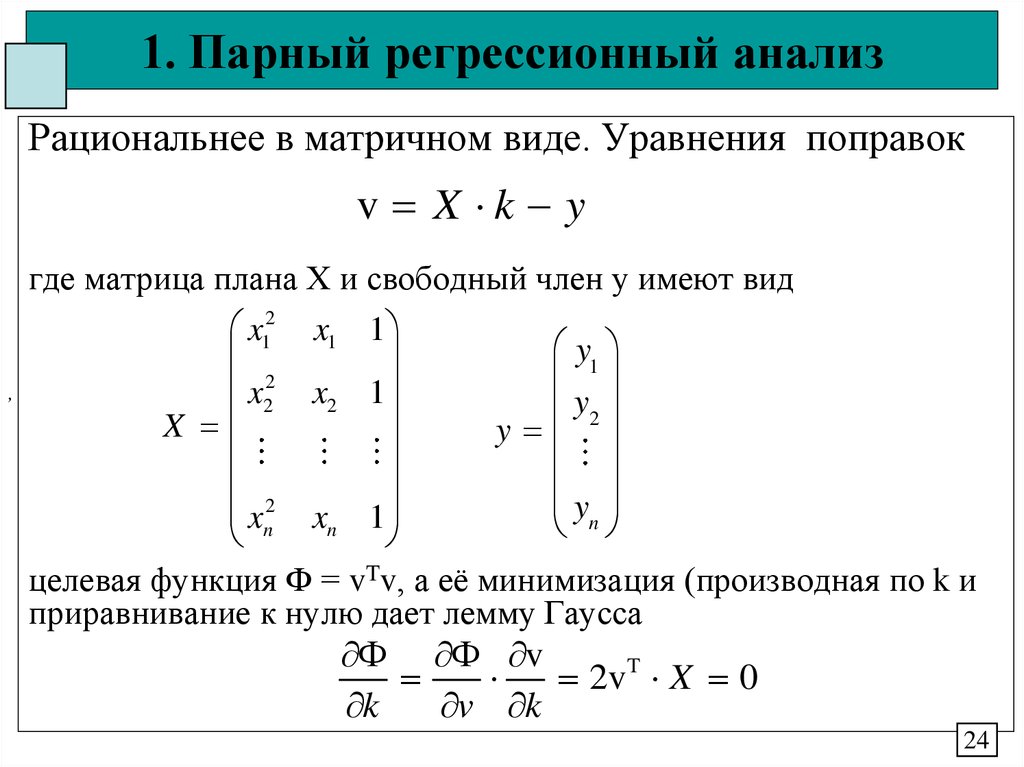

Рациональнее в матричном виде. Уравнения поправокv X k y

,

где матрица плана Х и свободный член у имеют вид

x12 x1 1

y1

2

x2 x2 1

y2

X

y

2

yn

xn xn 1

целевая функция Ф = vTv, а её минимизация (производная по k и

приравнивание к нулю дает лемму Гаусса

v

2vT X 0

k

v k

24

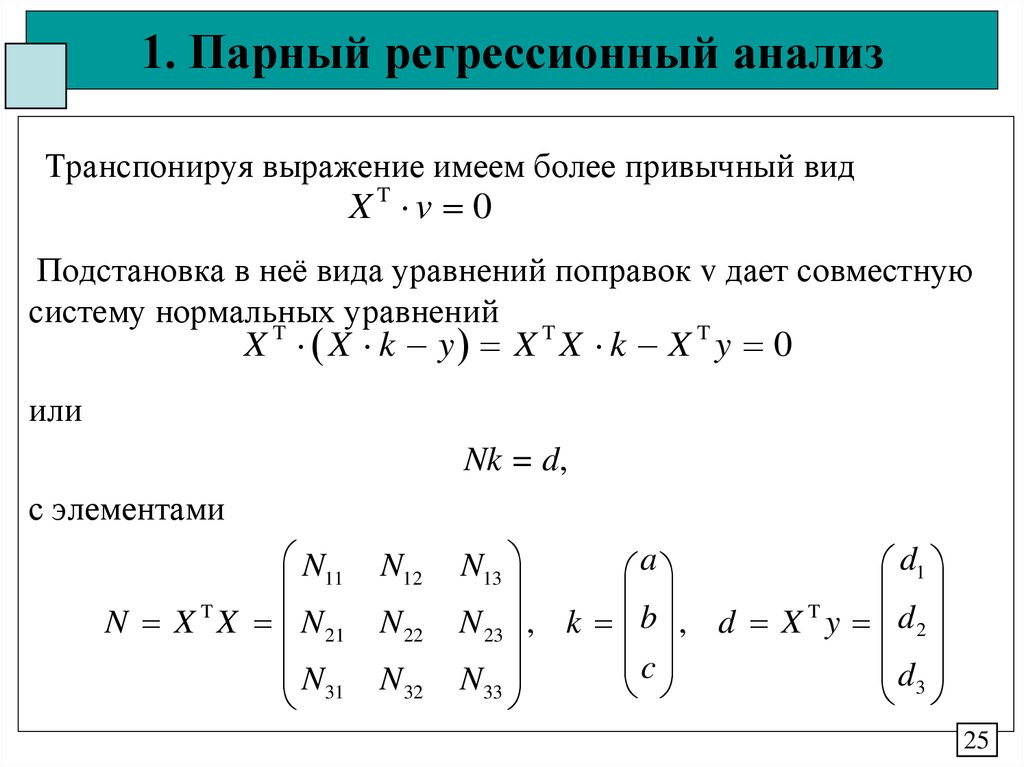

25. 1. Парный регрессионный анализ

Транспонируя выражение имеем более привычный видXT v 0

Подстановка в неё вида уравнений поправок v дает совместную

систему нормальных уравнений

X T X k y X T X k X T y 0

или

Nk = d,

с элементами

N11

T

N X X N 21

N31

N12

N 22

N32

d1

N13

a

b

T

N 23 , k , d X y d 2

d

c

N33

3

25

26. 1. Парный регрессионный анализ

Подход может расширяться на любую степеньполинома, изменяется только состав матрицы Х.

Оценка точности стандартная для МНК:

-погрешность модели,

-погрешности коэффициентов,

-если необходимо, статистический анализ.

По погрешности модели можно сказать о

необходимости усложнения модели.

26

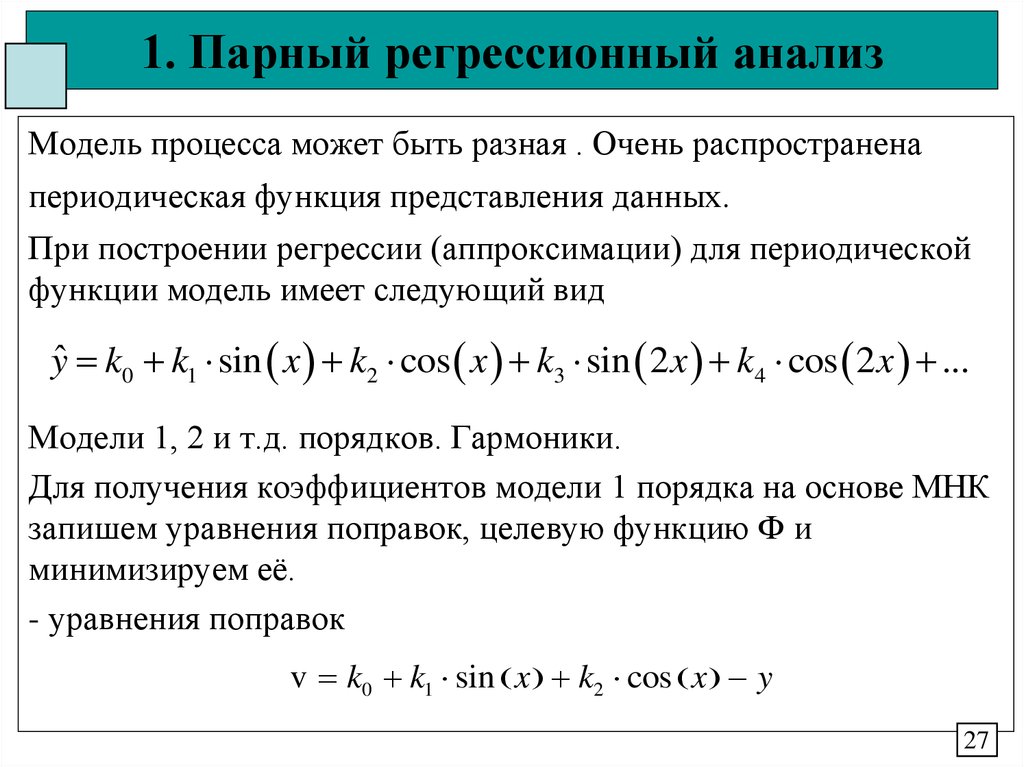

27. 1. Парный регрессионный анализ

Модель процесса может быть разная . Очень распространенапериодическая функция представления данных.

При построении регрессии (аппроксимации) для периодической

функции модель имеет следующий вид

yˆ k0 k1 sin x k2 cos x k3 sin 2 x k4 cos 2 x ...

Модели 1, 2 и т.д. порядков. Гармоники.

Для получения коэффициентов модели 1 порядка на основе МНК

запишем уравнения поправок, целевую функцию Ф и

минимизируем её.

- уравнения поправок

v k0 k1 sin x k2 cos x y

27

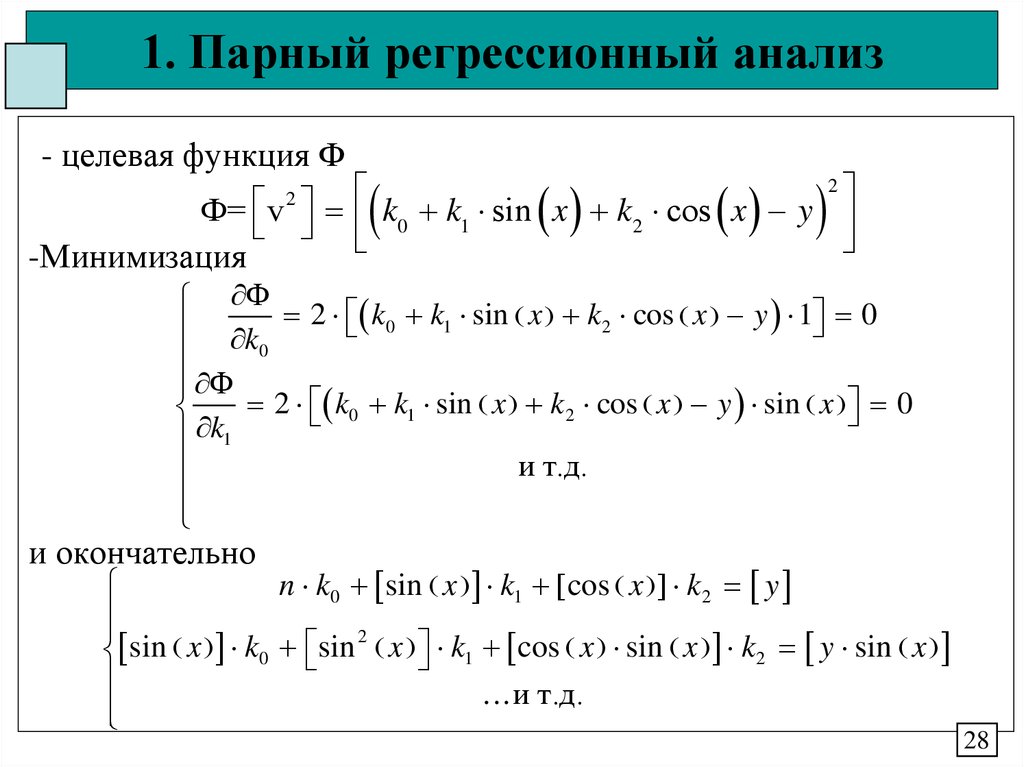

28. 1. Парный регрессионный анализ

- целевая функция Ф2

2

Ф= v k0 k1 sin x k2 cos x y

-Минимизация

Ф 2 k k sin x k cos x y 1 0

1

2

0

k

0

Ф

2 k0 k1 sin x k2 cos x y sin x 0

k1

и т.д.

и окончательно

n k0 sin x k1 cos x k2 y

2

x k1 cos x sin x k 2 y sin x

sin

x

k

sin

0

...и т.д.

28

29. 1. Парный регрессионный анализ

Периодические функции имеют циклы и на основе свойствциклических перестановок имеем

sin x cos x cos x sin x 0,

n

sin 2 x cos 2 x

2

Откуда

n k0 0 k1 0 k2 y

2

0 k0 sin x k1 0 k2 y sin x

...и т.д.

и явное решение

y

k

0

n

2 y sin x

k

1

n

2 y cos x

k

2

n

29

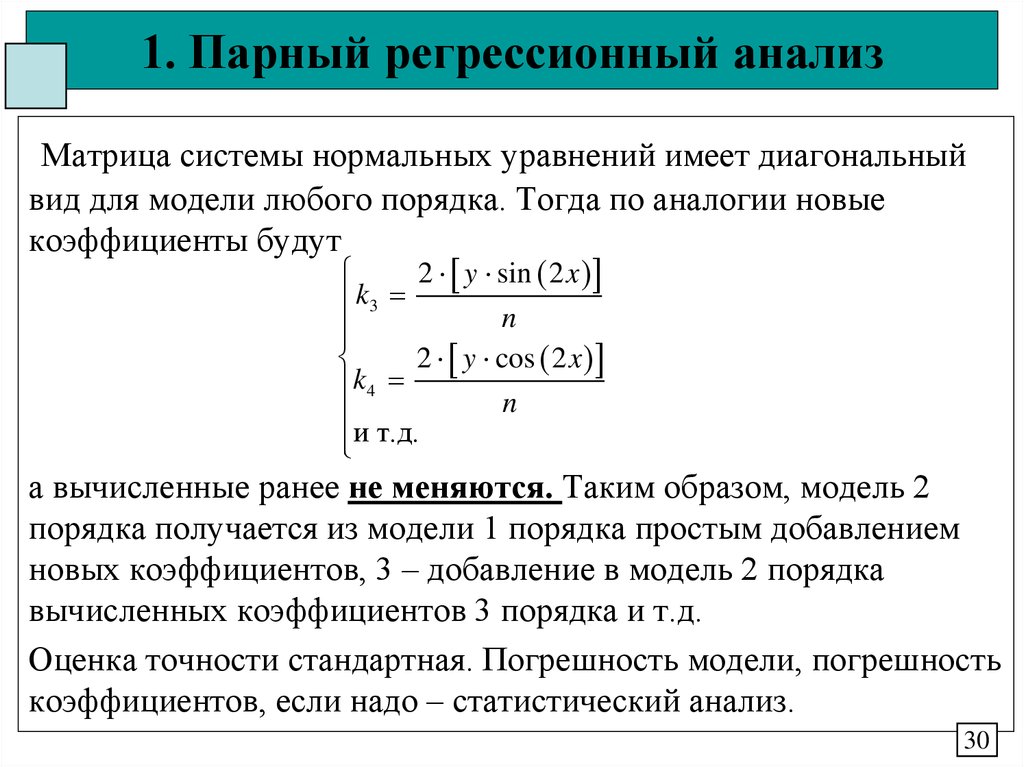

30. 1. Парный регрессионный анализ

Матрица системы нормальных уравнений имеет диагональныйвид для модели любого порядка. Тогда по аналогии новые

коэффициенты будут

2 y sin 2 x

k3

n

2 y cos 2 x

k4

n

и т.д.

а вычисленные ранее не меняются. Таким образом, модель 2

порядка получается из модели 1 порядка простым добавлением

новых коэффициентов, 3 – добавление в модель 2 порядка

вычисленных коэффициентов 3 порядка и т.д.

Оценка точности стандартная. Погрешность модели, погрешность

коэффициентов, если надо – статистический анализ.

30

31. 1. Парный регрессионный анализ

Контрольные вопросы по теории 3 модуля1. Основы общего регрессионного анализа. Основные этапы.

2. Парный линейный регрессионный анализ. Основные

положения.

3. Решение задачи регрессии на основе МНК

4. Решение задачи регрессии на основе условного

математического ожидания (метод средних).

5. Оценка точности и элементы статистического анализа в парной

линейной регрессии.

6. Расширение парной модели регрессии на другие случаи.

31

Математика

Математика