Похожие презентации:

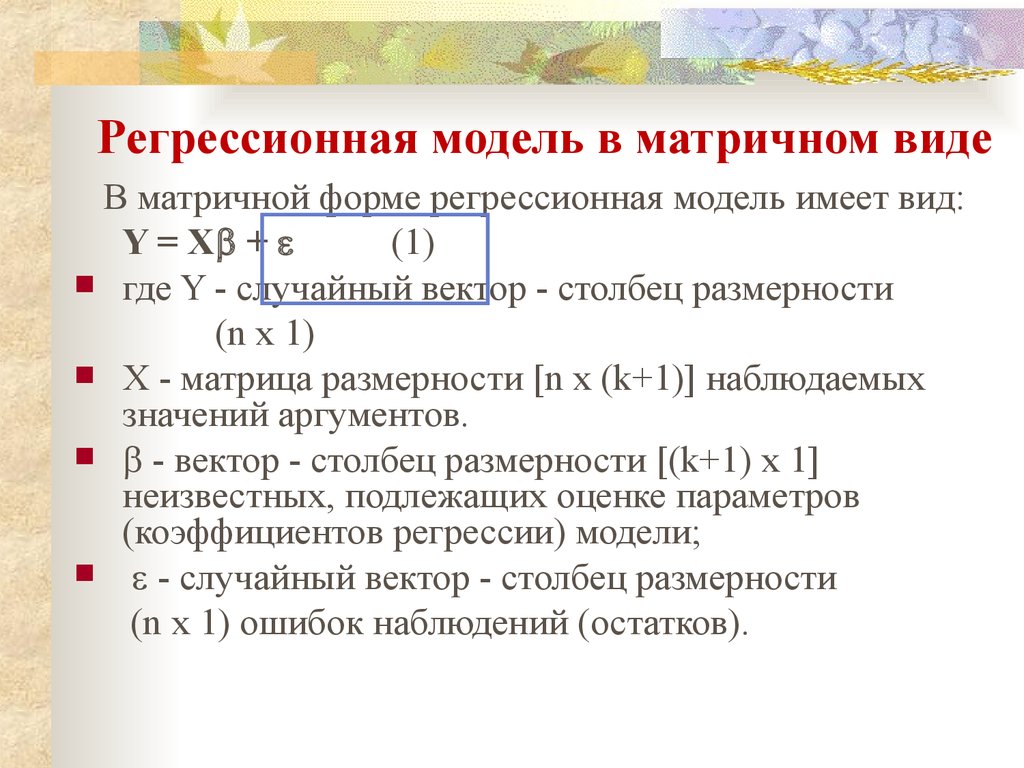

Регрессионная модель в матричном виде

1. Регрессионная модель в матричном виде

В матричной форме регрессионная модель имеет вид:Y = X +

(1)

где Y - случайный вектор - столбец размерности

(n x 1)

X - матрица размерности [n x (k+1)] наблюдаемых

значений аргументов.

- вектор - столбец размерности [(k+1) x 1]

неизвестных, подлежащих оценке параметров

(коэффициентов регрессии) модели;

- случайный вектор - столбец размерности

(n x 1) ошибок наблюдений (остатков).

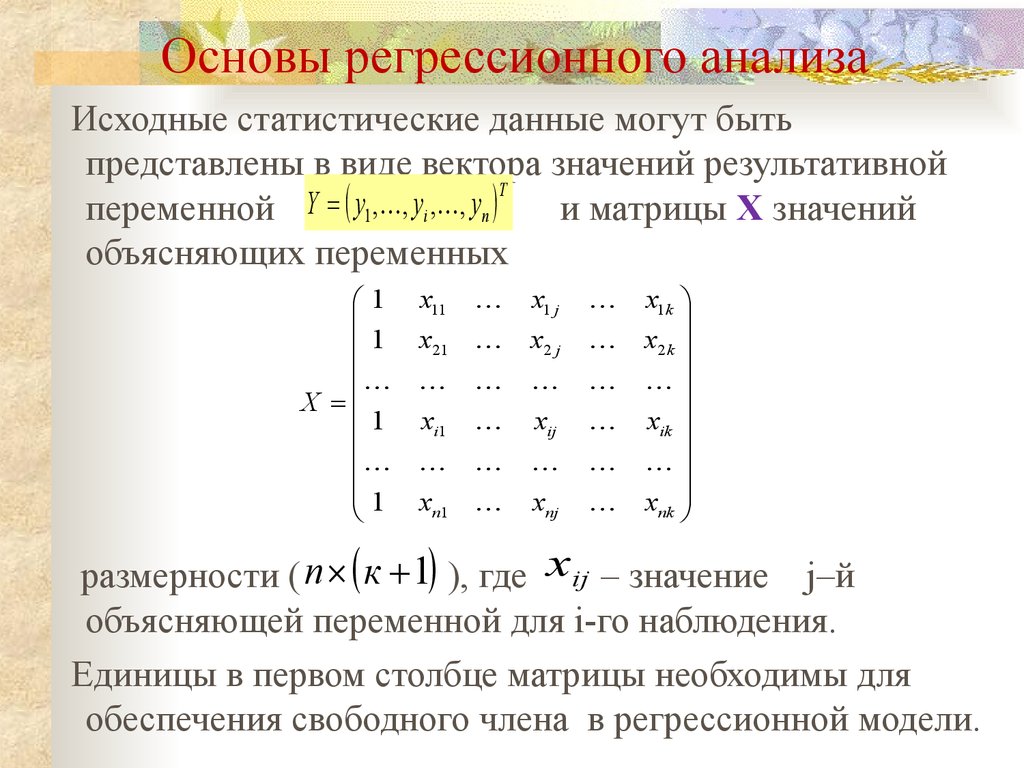

2. Основы регрессионного анализа

Исходные статистические данные могут бытьпредставлены в виде вектора значений результативной

T

Y

y

,

,

y

,

,

y

переменной

и матрицы X значений

1

i

n

объясняющих переменных

1

1

X

1

1

x11

x1 j

x21

xi1

x2 j

xij

xn1

xnj

x1k

x2 k

xik

xnk

размерности ( n к 1 ), где xij – значение j–й

объясняющей переменной для i-го наблюдения.

Единицы в первом столбце матрицы необходимы для

обеспечения свободного члена в регрессионной модели.

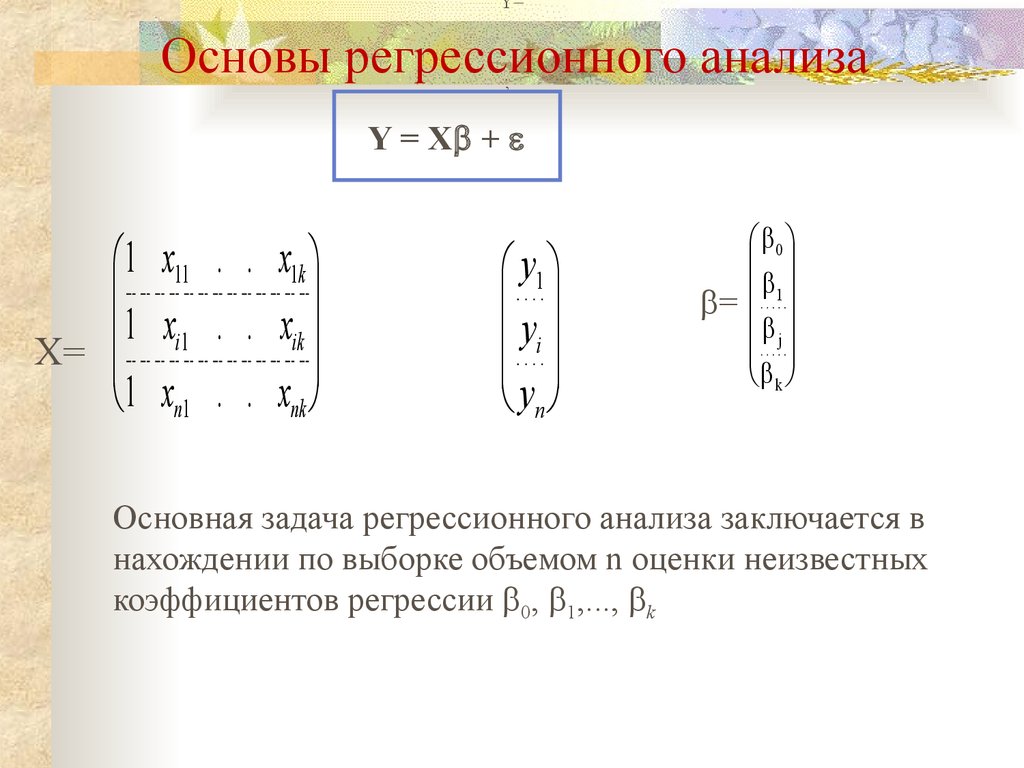

3. Основы регрессионного анализа

Y=Основы регрессионного анализа

;

Y = X +

1 x11 . . x1k

1 xi1 . . xik

X=

1 xn1 . . xnk

y1

yi

yn

0

1

=

j

k

Основная задача регрессионного анализа заключается в

нахождении по выборке объемом n оценки неизвестных

коэффициентов регрессии 0, 1,..., k

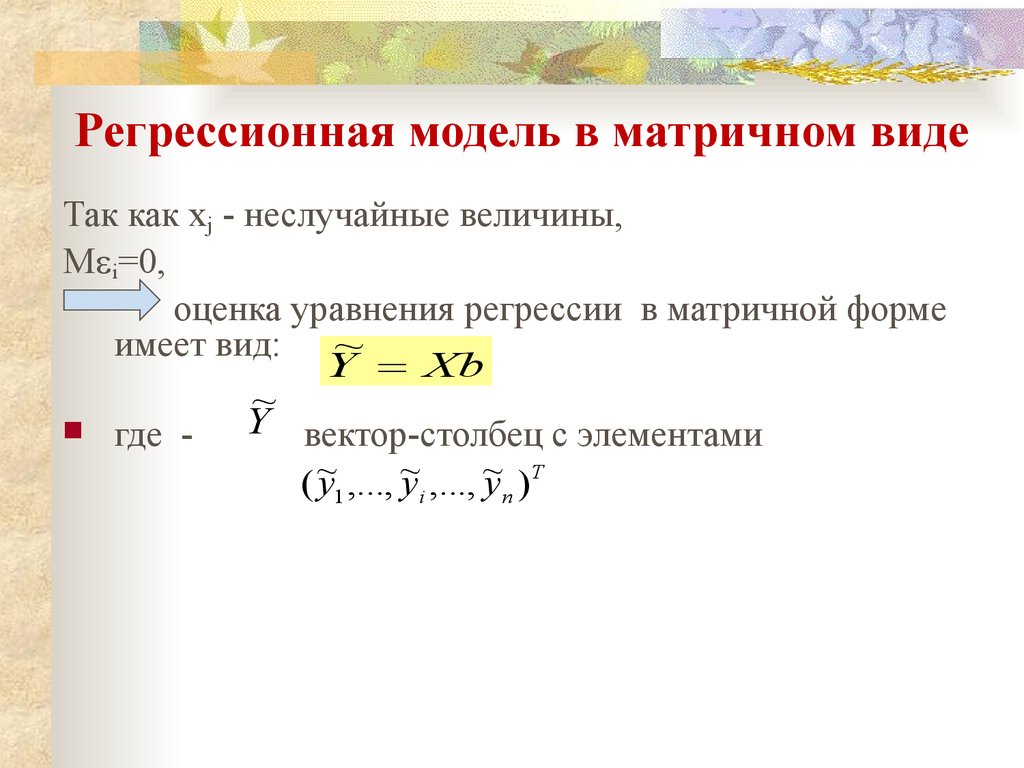

4. Регрессионная модель в матричном виде

Так как xj - неслучайные величины,M i=0,

оценка уравнения регрессии в матричной форме

имеет вид: ~

Y Xb

где -

~

Y вектор-столбец с элементами

(~

y1 ,..., ~

yi ,..., ~

y n )Т

5. Регрессионная модель в матричном виде

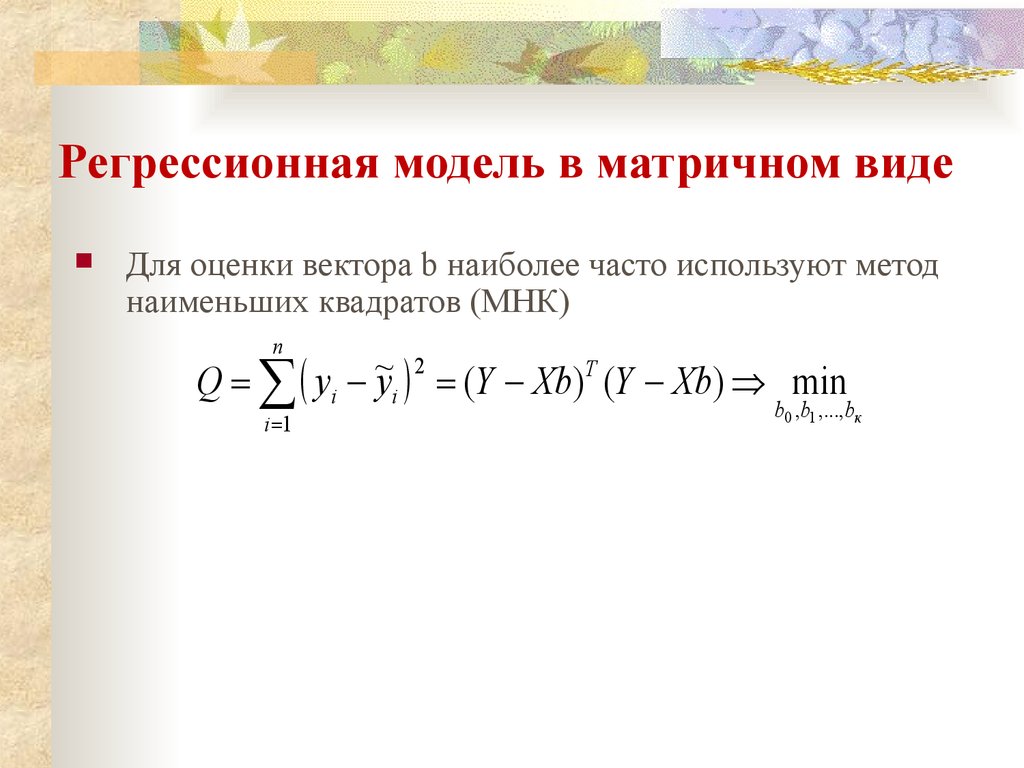

Для оценки вектора b наиболее часто используют методнаименьших квадратов (МНК)

n

2

~

Q yi yi (Y Xb)Т (Y Xb) min

i 1

b0 ,b1 ,...,bк

6. Регрессионная модель в общем виде

Дифференцируя квадратичную форму Q поb0,b1,...,bк и приравнивая производные к нулю,

получим систему нормальных уравнений:

Q

0

b j

j 0,1,..., к

Решая которую, получим вектор оценок b,

где b=(b0 b1...bк)T

1

b ( X X) X Y

T

T

(2)

7. Свойства оценки

Из (2) с учетом (1) будем иметь:b МНК X T X

МНК X T X

1

X T X

1

X T

(4)

M ( X T X ) 1 X T M

М 0

M МНК

Таким образом,

b - несмещенная оценка

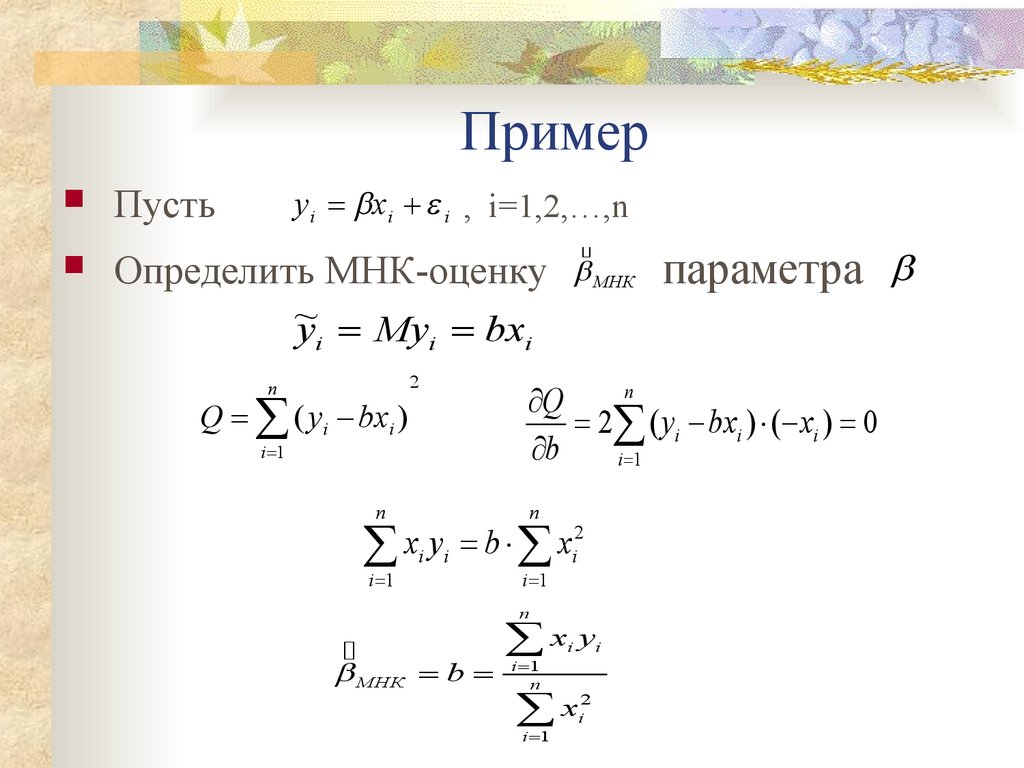

8. Пример

y i xi i , i=1,2,…,nПусть

МНК

Определить МНК-оценку

~

yi Myi bxi

n

Q ( yi bxi )

2

i 1

n

Q

2 ( yi bxi ) ( xi ) 0

b

i 1

n

n

i 1

i 1

2

x

y

b

x

ii i

n

МНК b

параметра

x y

i 1

n

i

x

i 1

2

i

i

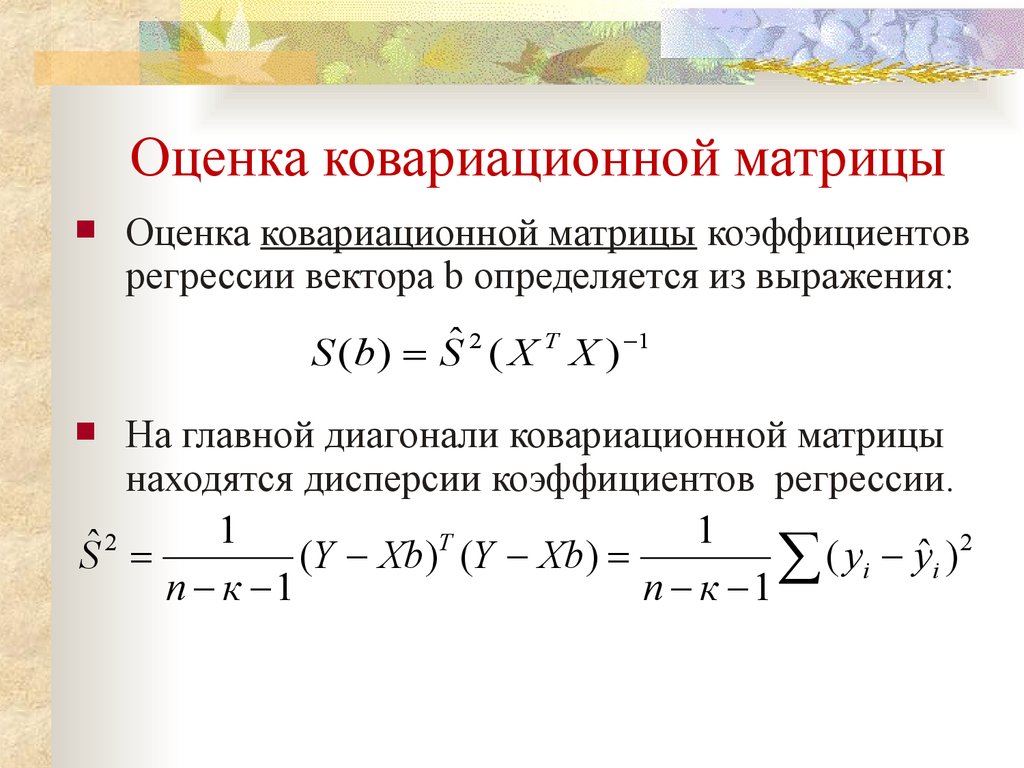

9. Оценка ковариационной матрицы

Оценка ковариационной матрицы коэффициентоврегрессии вектора b определяется из выражения:

S (b) Sˆ 2 ( X T X ) 1

На главной диагонали ковариационной матрицы

находятся дисперсии коэффициентов регрессии.

1

1

2

T

2

ˆ

ˆ

S

(Y Xb) (Y Xb)

(

y

y

)

i

i

n к 1

n к 1

10.

Например, найденоs 2 0,498

0,31 - 0,027

( X X )

0,027 0,0037

T

1

тогда оценка ковариационной матрицы

0,31 - 0,027 0,15 - 0,014

2 T 1

=

S (b) s ( X X ) 0,498

0,027 0,0037 - 0,014 0,0018

2

sb0 0,15

2

sb1 0,0018

sb0 0,39

sb1 0,042

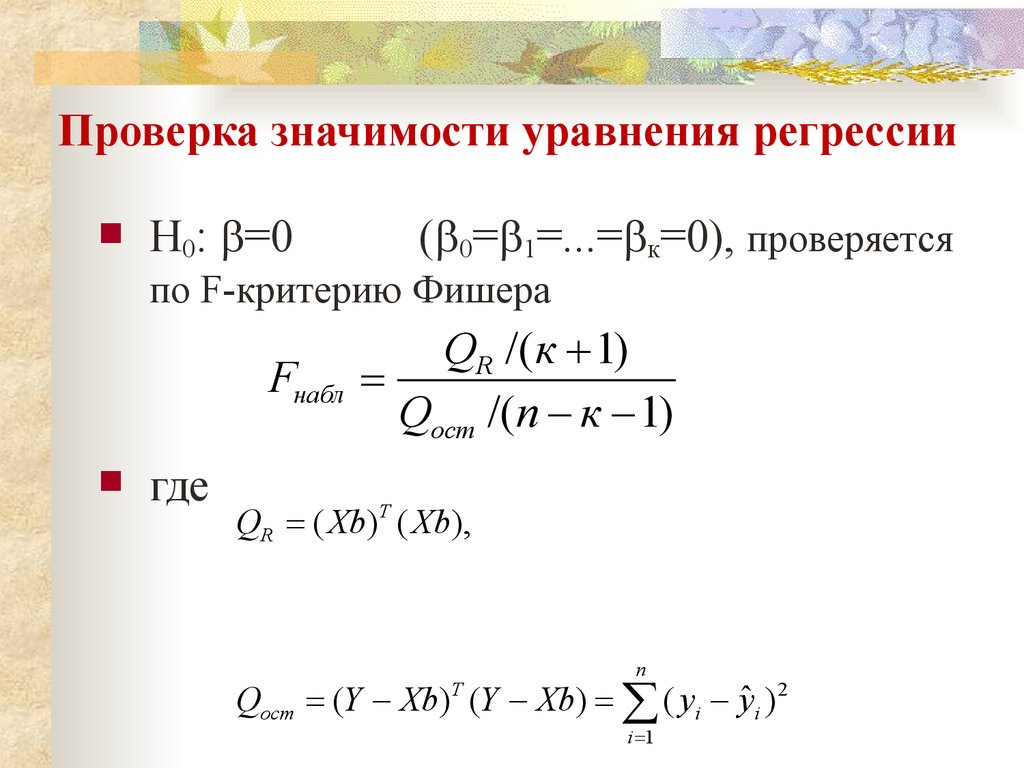

11. Проверка значимости уравнения регрессии

H0: =0( 0= 1=...= к=0), проверяется

по F-критерию Фишера

Fнабл

где

QR /( к 1)

Qост /(n к 1)

QR ( Xb)T ( Xb),

n

Qост (Y Xb)T (Y Xb) ( yi yˆ i ) 2

i 1

12. Проверка значимости уравнения регрессии

2. По таблице F-распределения находят Fкрдля заданных , 1 к , 2 n к

3.

Если Fнабл>Fкр, то гипотеза H0 отклоняется с

вероятностью ошибки .

Из этого следует, что уравнение регрессии

является значимым, т. е. хотя бы один из

коэффициентов регрессии отличен от нуля.

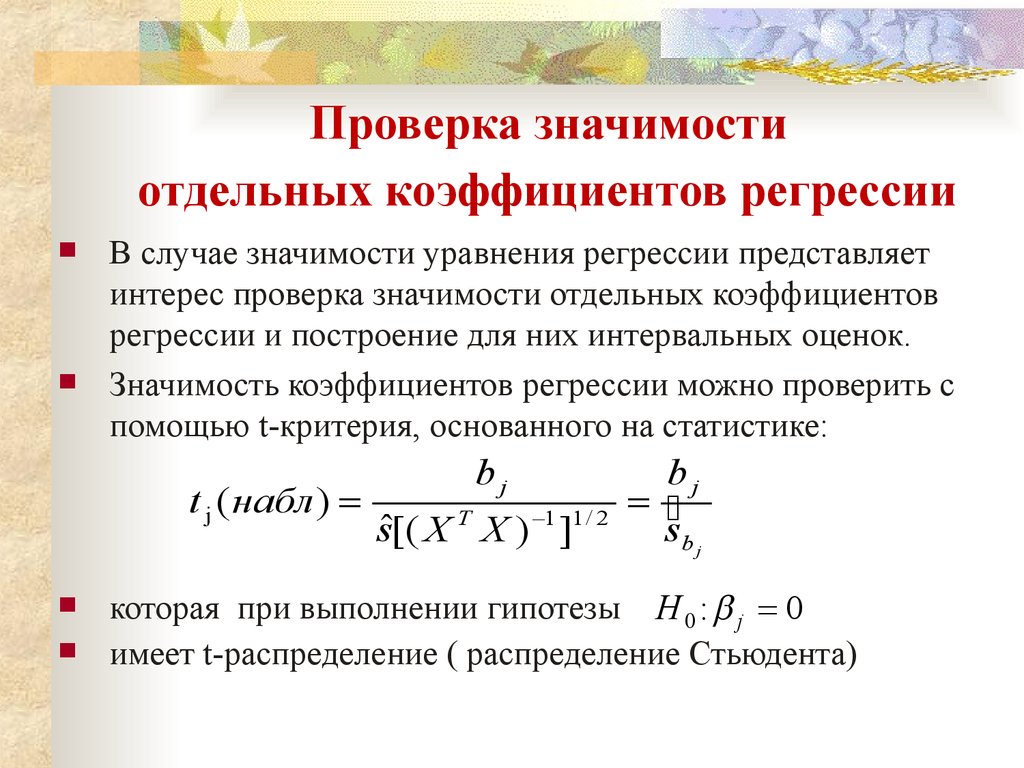

13. Проверка значимости отдельных коэффициентов регрессии

В случае значимости уравнения регрессии представляетинтерес проверка значимости отдельных коэффициентов

регрессии и построение для них интервальных оценок.

Значимость коэффициентов регрессии можно проверить с

помощью t-критерия, основанного на статистике:

t j ( набл )

bj

sˆ[( X T X ) 1 ]1 / 2

bj

sb j

которая при выполнении гипотезы H 0 : j 0

имеет t-распределение ( распределение Стьюдента)

14. Проверка значимости коэффициентов регрессии

2.tкр( , = n-к-1)

3.

Гипотеза H0 отвергается с вероятностью ,

t набл t кр ( , n к 1)

В противном случае коэффициент регрессии

незначим и соответствующая переменная в

модель не включается.

15. Интервальное оценивание коэффициентов регрессии

Интервальная оценка с доверительнойвероятностью для параметра j имеет

вид:

b j t S b j j b j t S b j

где t находят по таблице t-распределения

Стьюдента

при и n к .

16. Явление мультиколлинеарности

Мультиколлинеарность - это негативноеявление, обусловленное тесной взаимосвязью

объясняющих переменных x1 , x2 ,..., xk

1. При наличии мультиколлинеарности матрица

(XTX) становится слабо обусловленной, т.е. ее

определитель близок к нулю.

2. Нахождение обратной матрицы связано с

делением на определитель (т.е. величину близкую

к нулю). Следовательно, все решения становятся

неустойчивыми.

17. Явление мультиколлинеарности

3.вектор b=(b0 b1...bк)T

содержит элементы, знаки которых не поддаются

содержательной интерпретации.

4. Находящиеся на главной диагонали ковариационной

ˆ 2 ( X T X ) 1

S

(

b

)

S

матрицы

2

ˆ

s

дисперсии bj могут оказаться неоправданно

завышенными

5. В этой связи значимые коэффициенты j могут

оказаться статистически незначимыми, т.к.

bj

tj

sˆbj

18. Явление мультиколлинеарности

6.Мультиколлинеарность ведет к неоправданно завышенному

множественному коэффициенту корреляции Ry

ry

1

R

R yy

Наличие мультиколлинеарности можно проверить по

матрице парных коэффициентов корреляции

R=(rjl) j,l=1,2,…,р.

О мультиколлинеарности говорят, если rjl>0,8 (0<85). В

этом случае при построении регрессии в модель необходимо

включить либо xj , либо xl. Избавиться от

мультиколлинеарности позволяют пошаговые алгоритм

регрессионного анализа (метод пошагового включения

переменных).

Математика

Математика