Похожие презентации:

Множественная регрессия в экономике

1. Множественная регрессия

2.

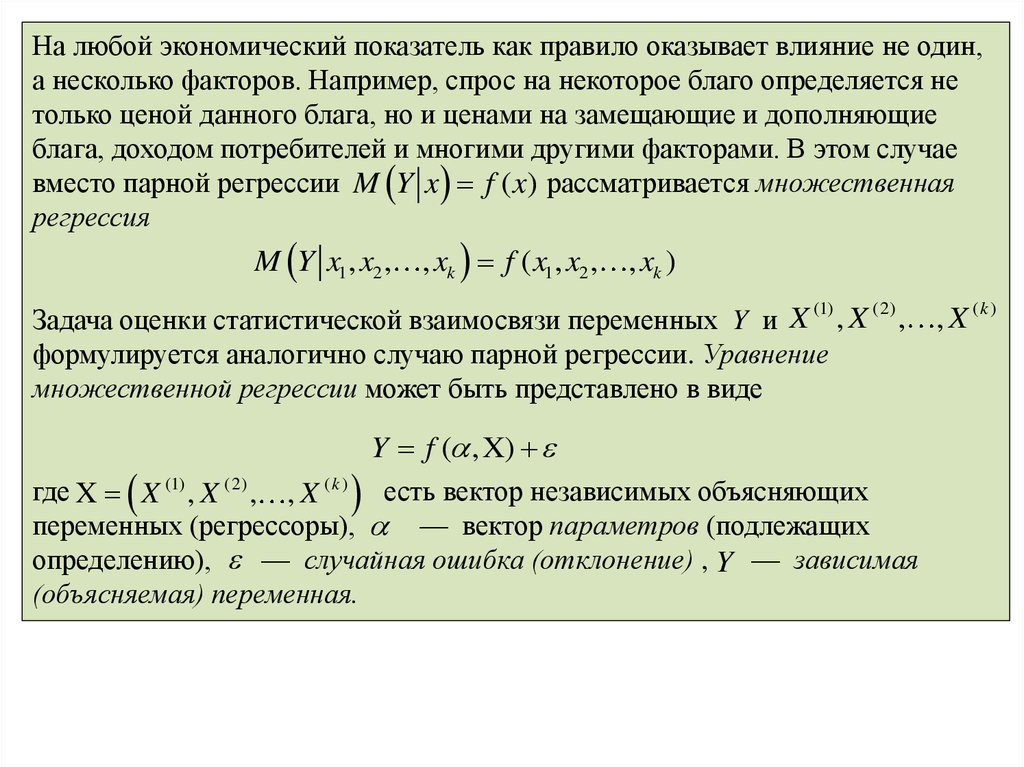

На любой экономический показатель как правило оказывает влияние не один,а несколько факторов. Например, спрос на некоторое благо определяется не

только ценой данного блага, но и ценами на замещающие и дополняющие

блага, доходом потребителей и многими другими факторами. В этом случае

вместо парной регрессии M Y x f ( x) рассматривается множественная

регрессия

M Y x1, x2 , , xk f ( x1, x2 , , xk )

(1)

Задача оценки статистической взаимосвязи переменных Y и X , X

формулируется аналогично случаю парной регрессии. Уравнение

множественной регрессии может быть представлено в виде

(2)

, , X (k )

Y f ( , X)

где X X (1) , X (2) , , X ( k ) есть вектор независимых объясняющих

переменных (регрессоры), — вектор параметров (подлежащих

определению), — случайная ошибка (отклонение) , Y — зависимая

(объясняемая) переменная.

3.

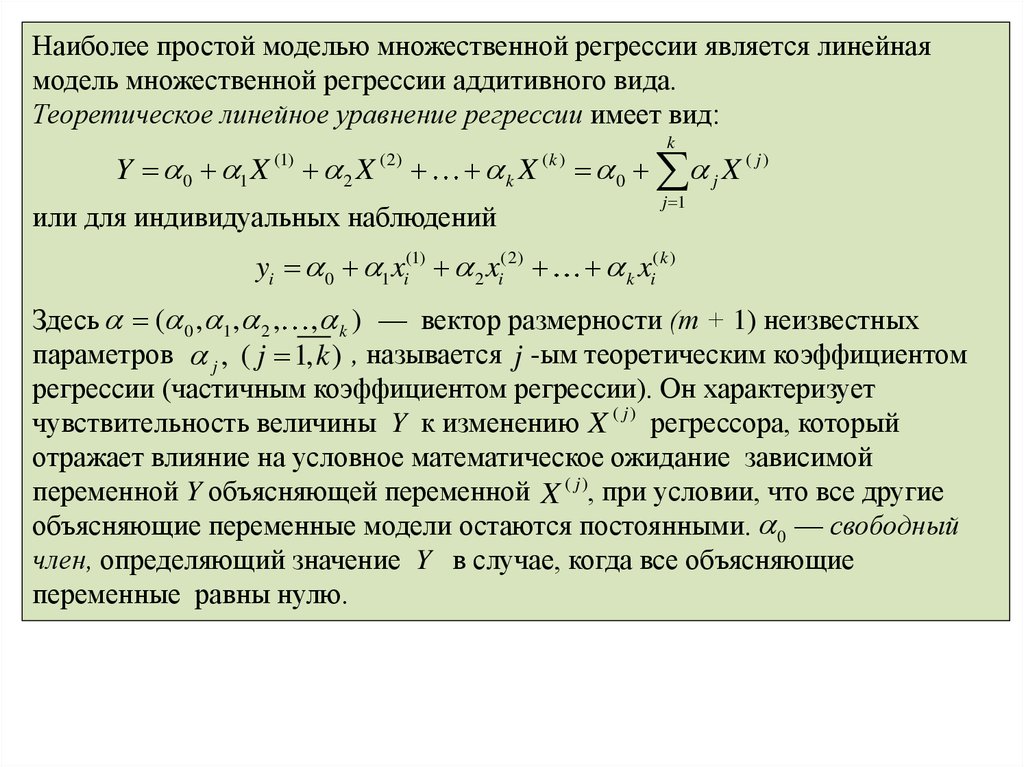

Наиболее простой моделью множественной регрессии является линейнаямодель множественной регрессии аддитивного вида.

Теоретическое линейное уравнение регрессии имеет вид:

Y 0 1 X

(1)

2 X

(2)

k X

k

(k )

или для индивидуальных наблюдений

yi 0 1xi(1) 2 xi(2)

0 j X ( j )

j 1

k xi( k )

Здесь ( 0 , 1 , 2 , , k ) — вектор размерности (т + 1) неизвестных

параметров j , ( j 1, k ) , называется j -ым теоретическим коэффициентом

регрессии (частичным коэффициентом регрессии). Он характеризует

чувствительность величины Y к изменению X ( j ) регрессора, который

отражает влияние на условное математическое ожидание зависимой

переменной Y объясняющей переменной X ( j ), при условии, что все другие

объясняющие переменные модели остаются постоянными. 0 — свободный

член, определяющий значение Y в случае, когда все объясняющие

переменные равны нулю.

4.

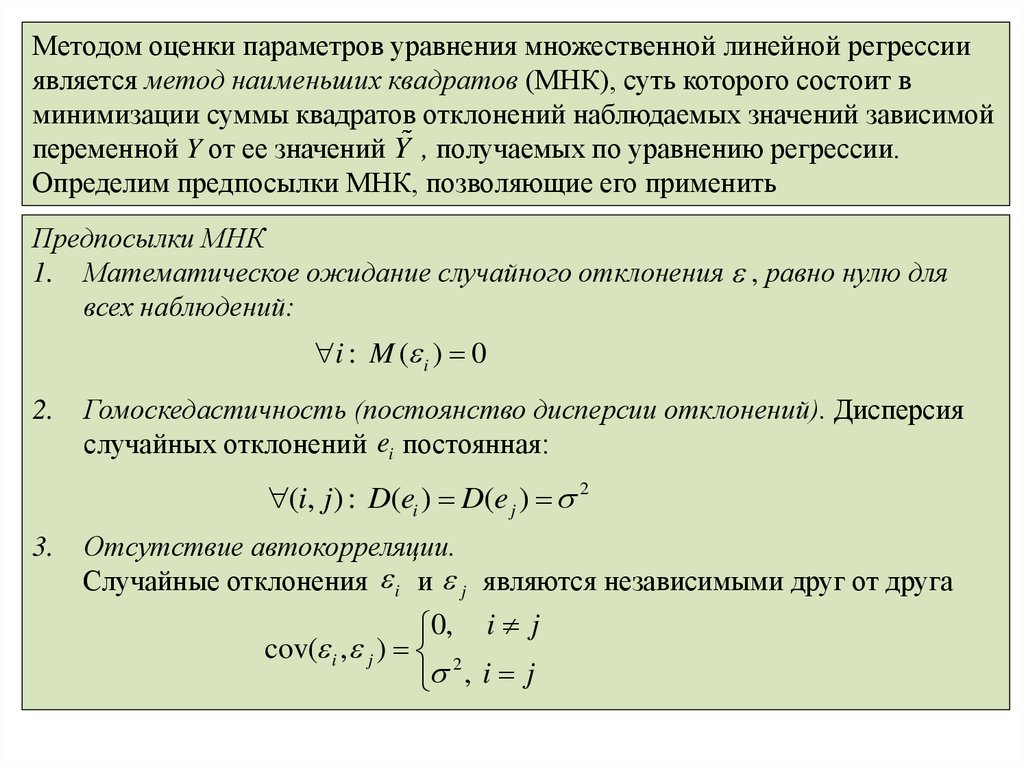

Методом оценки параметров уравнения множественной линейной регрессииявляется метод наименьших квадратов (МНК), суть которого состоит в

минимизации суммы квадратов отклонений наблюдаемых значений зависимой

переменной Y от ее значений Y , получаемых по уравнению регрессии.

Определим предпосылки МНК, позволяющие его применить

Предпосылки МНК

1. Математическое ожидание случайного отклонения , равно нулю для

всех наблюдений:

i : M ( i ) 0

2.

Гомоскедастичность (постоянство дисперсии отклонений). Дисперсия

случайных отклонений ei постоянная:

(i, j ) : D(ei ) D(e j ) 2

3.

Отсутствие автокорреляции.

Случайные отклонения i и j являются независимыми друг от друга

0, i j

cov( i , j ) 2

, i j

5.

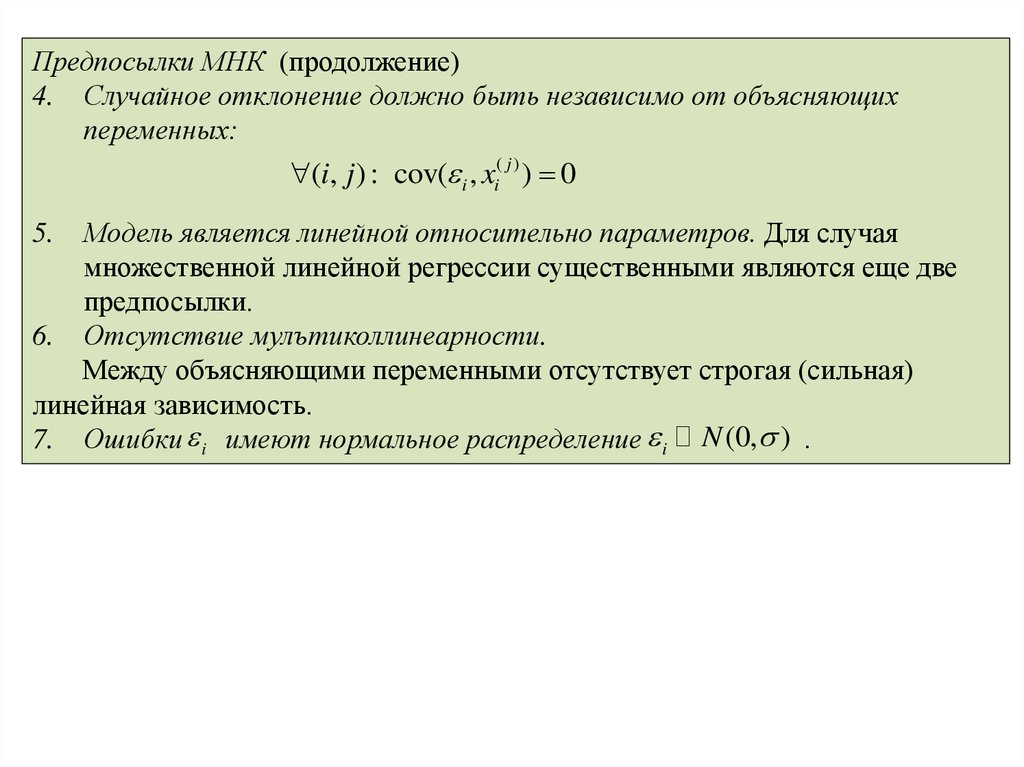

Предпосылки МНК (продолжение)4. Случайное отклонение должно быть независимо от объясняющих

переменных:

(i, j ) : cov( i , xi( j ) ) 0

Модель является линейной относительно параметров. Для случая

множественной линейной регрессии существенными являются еще две

предпосылки.

6. Отсутствие мулътиколлинеарности.

Между объясняющими переменными отсутствует строгая (сильная)

линейная зависимость.

7. Ошибки i имеют нормальное распределение i N (0, ) .

5.

6.

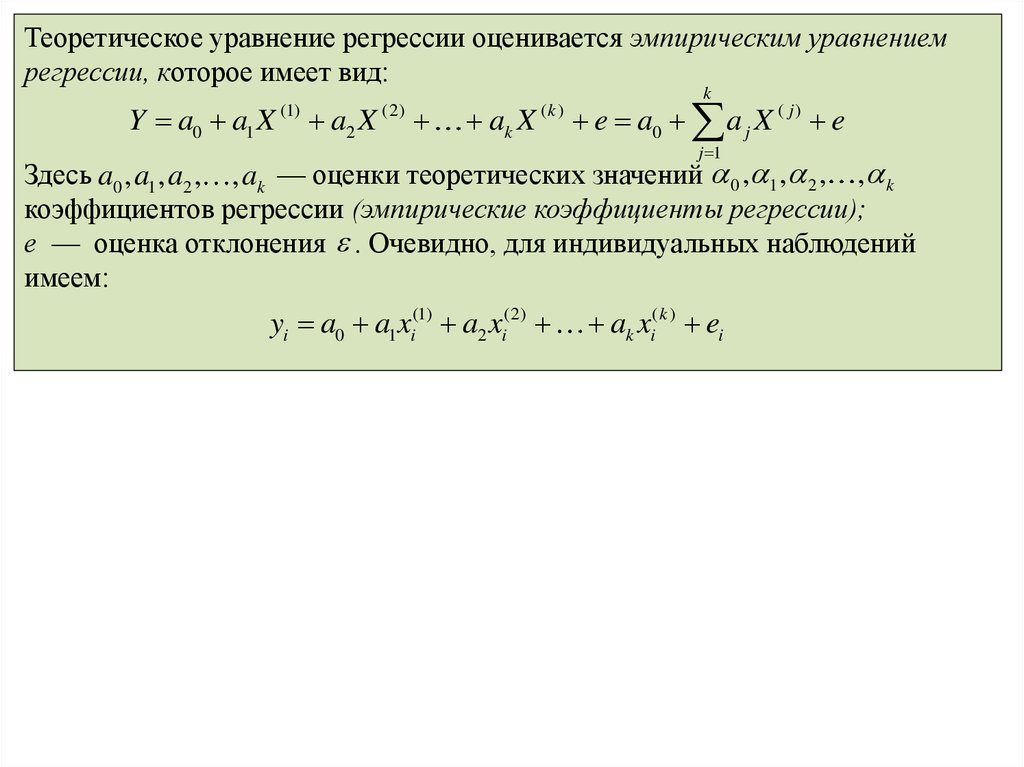

Теоретическое уравнение регрессии оценивается эмпирическим уравнениемрегрессии, которое имеет вид:

Y a0 a1 X

(1)

a2 X

(2)

ak X

k

(k )

e a0 a j X ( j ) e

j 1

Здесь a0 , a1 , a2 , , ak — оценки теоретических значений 0 , 1 , 2 , , k

коэффициентов регрессии (эмпирические коэффициенты регрессии);

е — оценка отклонения . Очевидно, для индивидуальных наблюдений

имеем:

yi a0 a1xi(1) a2 xi(2)

ak xi( k ) ei

Математика

Математика Экономика

Экономика